Un grupo de investigadores de Berkeley lanzó dos videos este año. En uno de ellos, un caballo corre detrás de la cerca. En el segundo, de repente obtiene un patrón de cebra en blanco y negro. El resultado no es perfecto, pero las tiras se ajustan al caballo con tanta claridad, como si el árbol genealógico de estos animales estuviera sumido en el caos. Un truco similar es un indicador de la capacidad evolutiva de los algoritmos de aprendizaje automático para cambiar la realidad.

Algunos otros investigadores utilizaron redes neuronales para

convertir fotos de osos negros en imágenes creíbles de pandas, manzanas en naranjas y gatos en perros. Un usuario de Reddit usó otro algoritmo de aprendizaje automático para editar videos porno e

insertó caras de celebridades allí . Startup Lyrebird

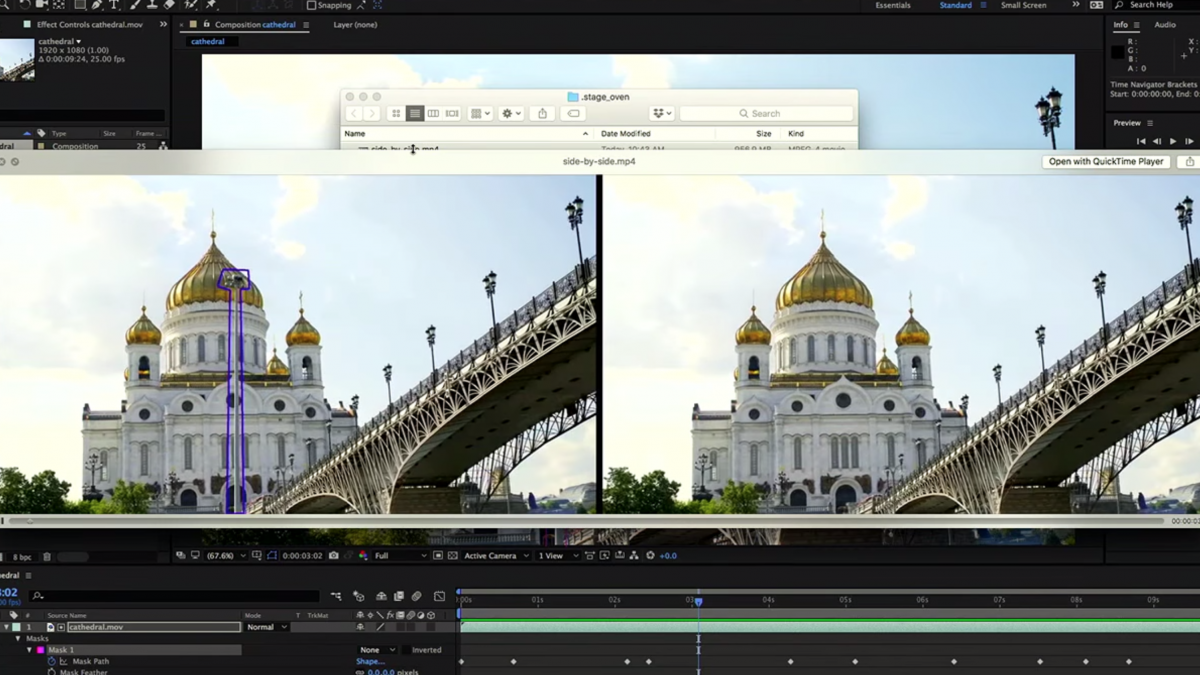

sintetiza un discurso bastante convincente basado en una grabación de un minuto de la voz de una persona. Y los ingenieros de Adobe, que desarrollan la plataforma de inteligencia artificial Sensei, están introduciendo

el aprendizaje automático en herramientas innovadoras para la edición de video, fotos y audio. Estos proyectos son muy diferentes en su origen y objetivos, pero tienen una cosa en común: sintetizan imágenes y sonidos que resultan ser increíblemente similares a los reales. A diferencia de los experimentos anteriores, estas creaciones de IA se ven y suenan realistas.

Las tecnologías subyacentes a estos cambios pronto nos llevarán a nuevas áreas creativas, aumentando las capacidades de los artistas contemporáneos y convirtiendo a los aficionados profesionales en profesionales. Buscaremos nuevas definiciones del concepto de creatividad, que ampliará su horizonte e incluirá las creaciones de máquinas. Pero este auge tendrá un inconveniente. Parte del contenido creado por la inteligencia artificial se utilizará para engañar, generando temor a una avalancha interminable de

noticias falsas . El viejo debate sobre si se cambió la imagen dará paso a una nueva: sobre el origen de todo tipo de contenido, incluido el texto. Comenzará a preguntarse: ¿qué papel desempeñaron las personas (si las hubo) en la creación de este álbum / serie / artículo?

Anteriormente, había dos formas de crear audio o video similares a los reales. El primero es usar cámaras y micrófonos para grabar una escena de producción. El segundo es maximizar el uso del talento humano, a menudo por mucho dinero, para crear una copia exacta. Ahora los algoritmos de aprendizaje automático ofrecen una tercera opción, que permite a cualquier persona con un conocimiento técnico mínimo modificar el contenido existente para crear material nuevo.

El nacimiento de Venus - versión de Deep Dreams

El nacimiento de Venus - versión de Deep DreamsAl principio, el contenido generado por las redes neuronales no estaba orientado hacia el realismo. Deep Dreams de Google, lanzado en 2015, fue un ejemplo temprano del uso del aprendizaje profundo para estampar paisajes psicodélicos y obras de arte grotescas de ojos múltiples. La exitosa aplicación 2016, Prisma, utilizó el aprendizaje profundo para mejorar los filtros de fotos, como el diseño de imágenes con pinturas Mondrian o Munch. Esta técnica se conoce como transferencia de estilo: tome el estilo de una imagen (por ejemplo, "Scream") y aplíquelo al segundo cuadro.

Ahora los algoritmos de transferencia de estilo se mejoran constantemente. Tomemos, por ejemplo, el

trabajo del laboratorio

de Kavita Bala de la Universidad de Cornell. Muestra cómo el aprendizaje profundo puede transferir el estilo de una fotografía (un ambiente nocturno parpadeante) a una imagen de una metrópolis sombría, y engaña a los críticos que pensarán que este lugar es real. Inspirado por el potencial de la inteligencia artificial para reconocer las propiedades estéticas, el profesor Bala cofundó

GrokStyle . Imagine que le gustan las almohadas decorativas en el sofá de un amigo o una manta en una revista. Muestre al algoritmo GrokStyle esta imagen y encontrará imágenes de cosas en el mismo estilo.

El profesor Bala dice: “Lo que me gusta de estas tecnologías es cómo democratizan el diseño y el estilo. Soy tecnólogo: aprecio la belleza y el estilo, pero ni siquiera puedo crearlos cerca. Y este trabajo hace que tales cosas estén disponibles para mí. También me complace poder poner esto a disposición de otros. El hecho de que no estemos dotados en esta área no significa que debamos vivir en un ambiente aburrido ”.

En Adobe, el aprendizaje automático ha sido parte de la creación de productos creativos durante más de una década, pero la compañía recientemente ha dado un gran paso adelante. En octubre, los ingenieros que trabajan en Sensei demostraron una prometedora herramienta de edición de video llamada Adobe Cloak. Permite al usuario eliminar fácilmente, por ejemplo, una farola de un videoclip, una tarea que sería terriblemente dolorosa incluso para un editor experimentado. Otro proyecto, llamado Proyecto Puppetron, aplica un estilo artístico específico al video en tiempo real. Le permite mostrar a una persona en forma de una estatua de bronce animada o un personaje de dibujos animados. "Puedes hacer algo frente a la cámara y convertirlo en animación en tiempo real", dice John Brandt, científico senior y director de Adobe Research.

El aprendizaje automático hace posible estos proyectos porque puede distinguir partes de la cara y ver la diferencia entre los fondos frontal y posterior mejor que los enfoques anteriores de la visión por computadora. Las herramientas Sensei permiten a los artistas trabajar no con materiales, sino con conceptos. "Photoshop hace un gran trabajo al administrar píxeles, pero las personas en realidad están tratando de manipular el contenido que muestran estos píxeles", explica Brandt.

Esta es una buena parte de las noticias. Cuando los artistas ya no necesitan pasar tiempo dibujando puntos individuales en la pantalla, su productividad aumenta. Según Brandt, está muy contento con la posibilidad de la aparición de nuevas formas de arte y está esperando que lleguen.

Demostración de capa de adobe

Demostración de capa de adobePero no es difícil imaginar cómo esta explosión creativa lleva a consecuencias muy malas. Yanshun Yao, graduado de la Universidad de Chicago, vio un video falso creado por AI y decidió comenzar un proyecto que explora los peligros del aprendizaje automático. En el video que vio, el generado Barack Obama pronunció un discurso. ¿Yao quería comprobar si era posible hacer algo similar con el material de texto?

La estructura del texto debe ser casi perfecta, de modo que la mayoría de los lectores estén convencidos de su "origen humano". Yao comenzó con una tarea relativamente simple: generar críticas falsas para Yelp y Amazon. Tal texto puede consistir en solo unas pocas oraciones y los lectores no esperan un alto nivel de dominio del idioma. Él y sus colegas crearon una

red neuronal, creando textos sobre el tema de Yelp con una longitud de 5 oraciones. Las reseñas recibidas incluyeron declaraciones como "¡Este es nuestro lugar favorito!" y "Fui con mi hermano, pedí una pasta vegetariana, muy sabrosa". Además, Yao preguntó a la gente si estos textos eran reales o falsos, y por supuesto, la gente a menudo se equivocaba.

El costo de escribir tales revisiones varía de $ 10 a $ 50, y Yao afirma que es solo cuestión de tiempo antes de que alguien intente automatizar el proceso bajando los precios e inundando el sitio con críticas falsas. También exploró las capacidades de las redes neuronales para proteger Yelp del contenido falso, y logró cierto éxito. Su próximo objetivo es generar artículos de noticias creíbles.

En cuanto al contenido de video, el progreso puede avanzar aún más rápido. Hani Farid, experta en la detección de fotos y videos falsos y profesora en el Dartmouth College, está preocupada por la rapidez con que se propaga el contenido viral y cómo el proceso de reconocer su autenticidad va a la zaga. Admite que en el futuro cercano habrá un video creíble donde Donald Trump da la orden de un ataque nuclear contra Corea del Norte. Se volverá viral y sembrará el pánico, lo mismo que una vez

causó un programa de radio sobre la "Guerra de los Mundos". "No quiero hacer suposiciones histéricas, pero no creo que los temores sean infundados", dice.

Sin embargo, las apariencias generadas por Trump ya están caminando en la Web. Son un producto de Lyrebird, un inicio de sintetizador de voz. Jose Sotelo, cofundador y CEO de la compañía, está convencido de que la existencia de esta tecnología es inevitable, por lo que él y sus colegas continuarán desarrollándola, sin olvidar, por supuesto, la ética. Está seguro de que la mejor defensa para hoy es crear conciencia sobre las posibilidades del aprendizaje automático. Sotelo señala: “Si ves mis fotos en la luna, seguramente decidirás que están hechas en un editor gráfico. Pero si escuchas una grabación de audio donde el mejor amigo está hablando cosas desagradables sobre ti, lo más probable es que estés preocupado. Esta es realmente una nueva tecnología, y presenta a la humanidad con nuevos desafíos ".

Es poco probable que algo pueda detener la ola de contenido de IA generado. Es posible un escenario en el que los estafadores y los políticos deshonestos utilizarán la tecnología para crear información engañosa.

El lado positivo es que el contenido de IA generado también puede proporcionar un gran servicio a la sociedad. Sotelo de Lyrebird sueña que su tecnología podrá recuperar la capacidad de hablar con personas que han perdido la voz debido a la esclerosis lateral amiotrófica o el cáncer. Y el video con caballos y cebras, que se mencionó al principio, fue un subproducto del trabajo para mejorar la visión de los vehículos no tripulados. El software para tales máquinas se entrena primero en un entorno virtual. Pero un mundo como Grand Theft Auto se parece a la realidad de forma remota. El algoritmo de Zebrification se creó para reducir la brecha entre el entorno virtual y el mundo real y, en última instancia, hacer que los vehículos no tripulados sean más seguros.