"Cotizaciones requeridas"

"Cotizaciones requeridas"El genetista y premio Nobel

Oliver Smitis , quien murió en enero de 2017 a la edad de 91 años, fue un inventor modesto y preferido. Era típico para él contar la historia de su mayor fiasco: el trabajo sobre la medición de la presión osmótica, publicado en 1953 [Smithies, O. Biochem. J. 55, 57–67 (1953)], que, como él lo expresó, "tuvo un dudoso logro en forma de falta de referencias a él".

"Nadie se ha referido a él y nadie ha usado este método", dijo a los estudiantes en una reunión en Lindau en Alemania en 2014.

De hecho, el trabajo de Smithies atrajo mucha más atención de la que pensaba: en los diez años transcurridos desde su publicación, nueve obras lo han aludido. Pero el error es comprensible: muchos científicos perciben incorrectamente la no cita de obras, tanto desde el punto de vista de la escala de este fenómeno como de su influencia en el mundo de la ciencia.

Una evaluación repetida con frecuencia, mencionada en un

controvertido artículo publicado en la revista Science en 1990, afirma que más de la mitad de todos los artículos científicos permanecen sin referencia a ellos durante cinco años después de su publicación. Y los científicos están muy preocupados por esto, dice Jevin West, especialista en teoría de la información de la Universidad de Washington en Seattle, que estudia los patrones a gran escala de la literatura de investigación. De hecho, la cita es una medida universalmente reconocida de influencia académica: un marcador del hecho de que el trabajo no solo se leyó, sino que también se consideró útil para estudios posteriores. Los investigadores temen que una gran cantidad de trabajos no citados indiquen el surgimiento de una montaña de investigaciones inútiles o intrascendentes. "Y no cuente cuántas veces la gente me preguntó en la cena:" ¿Qué parte de la literatura queda completamente sin enlaces? "- dice West.

De hecho, la investigación sin referencia a ella no siempre es inútil. Además, hay pocos estudios de este tipo, dice Vincent Larivière, especialista en teoría de la información de la Universidad de Montreal en Canadá.

Para comprender mejor este rincón oscuro y olvidado de las obras publicadas, la revista Nature se

sumó en números con la intención de descubrir cuántas obras quedan sin mencionar. Probablemente sea imposible averiguarlo, ya que las bases de datos de citas están incompletas. Pero está claro que al menos la columna vertebral de 12,000 revistas en Web of Science, una gran base de datos de Clarivate Analytics, funciona sin mencionar que es mucho menos común de lo que comúnmente se cree.

Los registros de la Web of Science indican que menos del 10% de los artículos científicos quedan sin referencia a ellos. Esta cifra debería ser incluso más baja ya que una gran cantidad de trabajos que están marcados en la base de datos como que no tienen referencias son realmente mencionados en alguna parte por alguien.

Esto no significa necesariamente que haya menos artículos de baja calidad: miles de revistas no están indexadas por la base de datos de Web of Science, y la preocupación de que los científicos llenen sus hojas de vida con documentos sin sentido sigue siendo real.

Pero los nuevos números pueden tranquilizar a la gente, asustados por las historias de océanos de trabajo abandonado. Además, al examinar más de cerca algunas de las obras que nadie mencionó, resulta que tienen buenas, y son leídas, a pesar de la aparente indiferencia. "La falta de citas no puede interpretarse como artículos inútiles o sin valor", dijo David Pendlebury, analista jefe de citas de Clarivate.

Sin mencionar mitos

La noción de que la literatura científica está llena de investigaciones sin importancia se remonta a un par de artículos en la revista Science, de

1990 y 1991 [Pendlebury, DA Science 251.1410-1411 (1991)]. Un informe de 1990 informa que el 55% de los artículos publicados de 1981 a 1985 no se mencionaron en ningún lugar dentro de los cinco años posteriores a su publicación. Pero estos análisis son engañosos, principalmente porque tomaron en cuenta tipos de publicaciones como cartas, correcciones, actas de reuniones y otro material editorial, que generalmente no se cita. Si lo elimina todo, dejando solo trabajos de investigación y artículos de revisión, los porcentajes de artículos no mencionados colapsarán. Y si extiende el período de espera durante cinco años, estos porcentajes caerán aún más.

En 2008, Lariviere y sus colegas

analizaron nuevamente Web of Science e informaron no solo que el número de trabajos no citados fue menor de lo estimado, sino también que el porcentaje de trabajos sin referencias había disminuido durante varias décadas. La revista Nature le pidió a Larivier, junto con Cassidy Sugimoto [Cassidy Sugimoto] de la Universidad de Indiana en Bloomington, actualizar su análisis y comentarlo para este artículo.

Las nuevas cifras, que cuentan artículos de investigación y revisiones, indican que en la mayoría de las áreas el número de trabajos que no atraen enlaces se iguala por un período de cinco a diez años después de la publicación, aunque cada región tiene sus propias proporciones. De todos los trabajos sobre biomedicina publicados en 2006, hoy solo se cita el 4%; en química este número es del 8%, y en física está más cerca del 11%. Si elimina los casos de autocitas, estos números aumentan, y en algunas disciplinas una vez y media. En los campos de ingeniería y tecnología, el porcentaje de trabajo sin referencia en 2006 es del 24%, muy superior al de las ciencias naturales. Esto puede deberse a la naturaleza técnica de estos artículos, que resuelven problemas específicos, en lugar de proporcionar a otros científicos una base para continuar su trabajo, dice Lariviere.

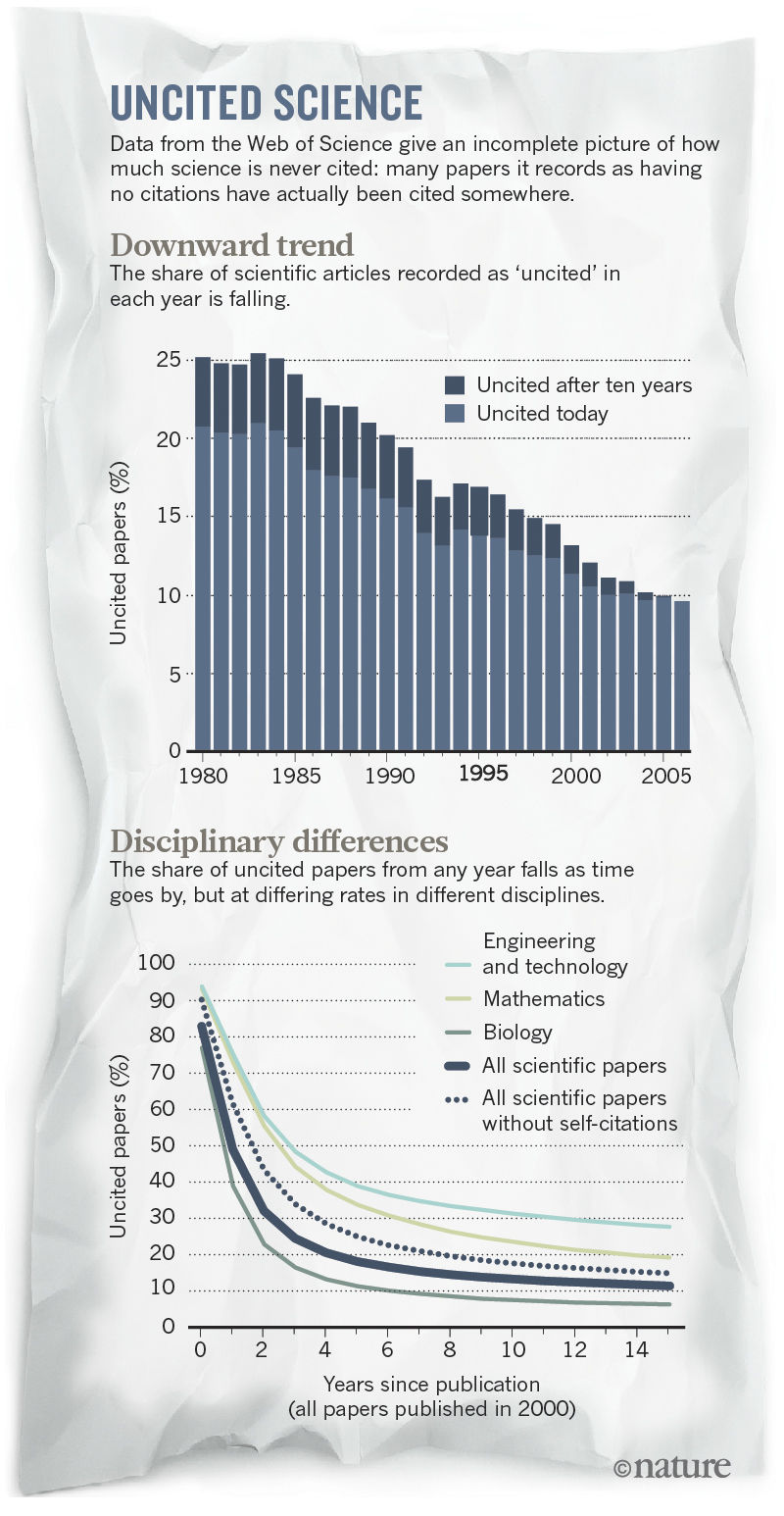

El gráfico superior es la distribución del número de obras sin enlaces por año.

El gráfico superior es la distribución del número de obras sin enlaces por año.

Baja - diferencias en diferentes campos de la ciencia; la línea punteada indica el gráfico general para todas las áreas.Si tomamos todos los artículos en su conjunto (39 millones de artículos de investigación en todas las áreas registradas en la Web of Science desde 1900 hasta finales de 2015), el 21% de ellos quedaron sin mencionar. No es sorprendente que la mayor parte del trabajo sin referencia a ellos apareciera en revistas poco conocidas. Casi todas las obras en revistas famosas se citan posteriormente.

Mediciones imposibles

Estos datos dan solo una parte de la imagen. Pero completar toda la información que falta en la literatura científica es una tarea prácticamente imposible.

Verificar una pequeña cantidad de trabajos ya es una tarea bastante difícil. Por ejemplo, en 2012, Peter Heneberg, biólogo de la Universidad Charles de Praga, decidió revisar los registros de la Web of Science de 13 premios Nobel para verificar las declaraciones de otro artículo que afirman que nadie se refiere a aproximadamente el 10% de los estudios de premios Nobel . Su primer estudio, Web of Science, encontró un número cercano al 1.6%. Pero luego, utilizando el servicio

Google Scholar , Heneberg descubrió que muchos de los trabajos restantes todavía estaban referenciados, pero no se tuvieron en cuenta debido a errores al ingresar datos y errores tipográficos en los trabajos. Además, las revistas y libros que no fueron indexados por Web of Science tenían citas adicionales. Cuando Heneberg detuvo su búsqueda, después de pasar unas 20 horas, había reducido el número de obras sin mencionar otras cinco veces, a 0.3%.

Tales deficiencias también conducen al hecho de que es imposible averiguar el número real de trabajos que nunca se han citado: tomará demasiado tiempo repetir una verificación manual después de Heneberg a gran escala. La Web of Science indica, por ejemplo, que el 65% del trabajo humanitario publicado en 2006 nunca ha sido mencionado por nadie. Y esto es realmente así: gran parte del trabajo humanitario queda sin mencionar, en particular, porque las nuevas investigaciones en esta área no dependen tanto del conocimiento previo acumulado. Pero Web of Science no refleja correctamente la situación en esta área, ya que descuida muchas revistas y libros.

Las mismas razones socavan la fiabilidad de las comparaciones de diferentes naciones. Web of Science muestra que los trabajos escritos por académicos de China, India y Rusia serán más propensos a ser ignorados que los escritos en los Estados Unidos o Europa. Pero la base de datos generalmente no rastrea muchas revistas locales que reducirían esta brecha, dice Lariviere.

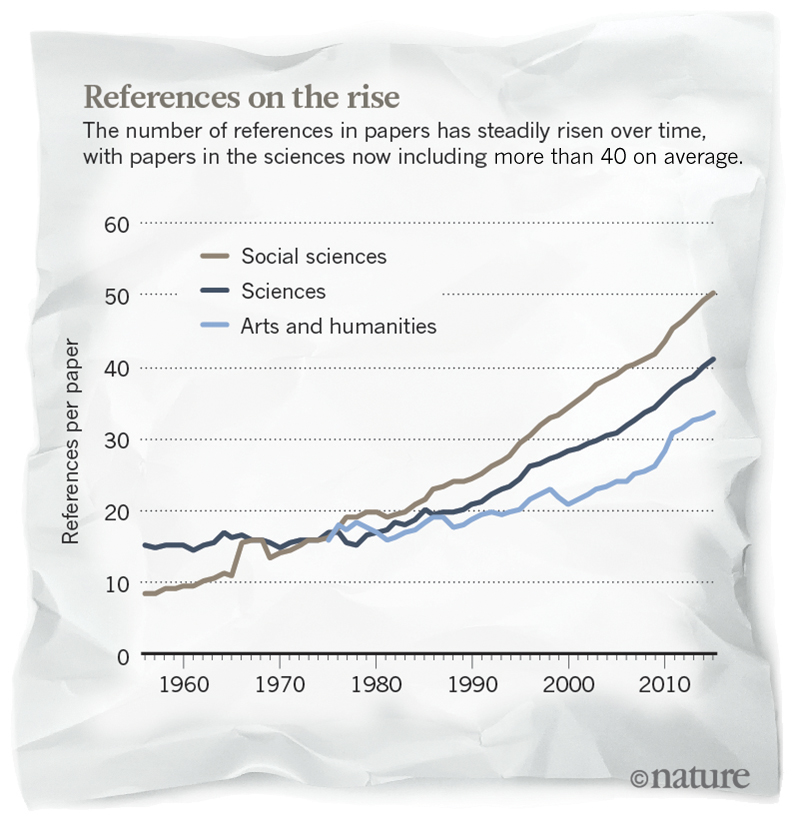

A pesar de los problemas con el número absoluto, la reducción del trabajo sin mencionar en Web of Science se observa estrictamente, dice Larivier. Internet ha facilitado enormemente la tarea de encontrar y citar el trabajo correcto, dice. Es posible que esto también contribuya al deseo de abrir el acceso a los artículos. Pero Lariviere advierte que esta tendencia no debe ser sobreestimada. En su estudio de 2009 [Wallace, ML, Larivière. V. & Gingras, YJ Informetrics 3, 296–303 (2009)] argumenta que el número de trabajos sin citas disminuye porque los científicos publican más y más trabajos y empujan más y más referencias a otros trabajos. Especialista en el campo de la bibliometría [análisis estadístico de literatura científica / aprox. trans.] Ludo Waltman de la Universidad de Leiden en los Países Bajos está de acuerdo. "No interpretaría estas cifras como una garantía de que cada vez más trabajo científico se vuelve útil".

El número de enlaces al trabajo crece gradualmente

El número de enlaces al trabajo crece gradualmenteWaltman dice que muchas obras apenas evitan el destino de los no citados: los cálculos independientes de Waltman y Larivier muestran que la Web of Science tiene más de un trabajo mencionado que los que no tienen ninguna mención. "Y sabemos que muchos enlaces se hacen formalmente, para mostrar", dice. O pueden ser un signo del sistema "usted - para mí, yo - para usted" por parte de los científicos, dice Dahlia Remler, especialista en economía de la salud de la Escuela de Relaciones Públicas e Internacionales. Marx en Nueva York. "Incluso la investigación altamente citada puede ser parte de un juego que los científicos juegan juntos y que no es bueno para nadie", dice ella.

No completamente inútil

Algunos investigadores pueden verse tentados a abandonar el trabajo sin mencionar que no son importantes. Después de todo, si tuvieran al menos algún significado, ¿alguien no se habría referido a ellos?

Probablemente, pero no necesariamente. Los científicos están influenciados por muchos más artículos de los que luego mencionan, dice Michael Macroberts, un botánico de la Universidad de Louisiana en Shreveport. En

un artículo de 2010 sobre la falta de análisis de citas, Macroberts aludió a su propio

trabajo de 1995 sobre el descubrimiento de la Palinhaea cernua en Texas. Esta fue la primera y única vez que alguien se refirió a este trabajo, pero la información mencionada en él entró en atlas de plantas y grandes bases de datos. Las personas que usan estas bases de datos confían en este trabajo y en miles de otros informes botánicos. "Se utiliza la información en estos llamados artículos no citados; simplemente no se citan ", dice.

Además, los artículos que no se citan todavía se leen. En 2010, investigadores del Departamento de Salud e Higiene Psicológica de Nueva York publicaron un estudio que analiza las deficiencias del kit de prueba de saliva para el VIH realizado mediante programas especiales [Egger, JR, Konty, KJ, Borrelli, JM, Cummiskey, J. & Blank, S. PLoS ONE 5, e12231 (2010)]. Unos años antes, el uso del kit se suspendió en las clínicas y luego se reanudó nuevamente. Los autores querían usar la experiencia de las clínicas para estudiar la cuestión de si el software puede analizar la calidad de los conjuntos en caso de problemas.

Su trabajo, publicado en la revista PLoS ONE, nunca ha sido mencionado. Pero ha sido visto más de 1,500 veces y descargado más de 500 veces, dijo Joe Egger, coautor del trabajo, que ahora trabaja en el Instituto Duke para la Salud Mundial en Darham, Carolina del Norte. "El propósito de este artículo es mejorar las prácticas que apoyan la atención médica, en lugar de avanzar en la ciencia", dice.

Otros artículos pueden no mencionarse porque cubren áreas de investigación improductivas, dice Nicklaas Buyurma, químico de la Universidad de Cardiff, Gran Bretaña. En 2003, Buyurma y sus colegas publicaron un

documento sobre la "disputa isocrórica", sobre si sería útil tratar de restringir la expansión o contracción del solvente durante la reacción que ocurre cuando las temperaturas cambian. En teoría, este experimento técnicamente sofisticado podría generar nuevos conocimientos sobre cómo los solventes afectan la velocidad de las reacciones químicas. Pero las pruebas de Buyurma mostraron que los químicos no aprenderían nada nuevo de tales experimentos. "Decidimos probar que algo no vale la pena hacer, y lo demostramos", dice. "Estoy orgulloso de este trabajo, ya que no implica una mención", agrega.

Oliver Smitis, hablando en una reunión en Lindau, dijo que reconoció la importancia del trabajo de 1953, a pesar de que pensaba que no se mencionaba. Le dijo al público que el trabajo realizado lo ayudó a obtener un título y convertirse en un científico de pleno derecho. De hecho, fue el aprendizaje del futuro premio Nobel. "Realmente disfruté haciéndolo", dijo, "y aprendí a hacer ciencia correctamente". Smithies en realidad tiene al menos un trabajo sin ninguna mención: el

artículo de 1976 , que mostró que un gen específico asociado con el sistema inmune

se encuentra en el cromosoma humano . Pero eso fue importante, por otras razones, dijo el genetista Raju Kucherlapati de la Facultad de Medicina de Harvard en Boston, Massachusetts, uno de los autores del trabajo. Él dice que el artículo fue el comienzo de una larga colaboración con el laboratorio Smithies, que culminó en un trabajo sobre genética de ratones que le otorgó a Smithies el Premio Nobel 2007 en fisiología o medicina. "Para mí", dice Kucherlapati, "la importancia de este trabajo fue que reconocí a Oliver".

Historia de obras no citadas.

Larga espera

Para cada investigador que quiera que alguien mencione su trabajo, hay esperanza si tenemos en cuenta la historia de Albert Peck, cuyo

trabajo de 1926, que describe una de las variedades de defectos de vidrio, se citó por primera vez en 2014. En la década de 1950, el trabajo perdió su utilidad cuando los fabricantes descubrieron cómo hacer vidrio liso sin los defectos descritos. Pero en 2014, el investigador de materiales Kevin Knowles de la Universidad de Cambridge en Gran Bretaña se topó con Google para hacer este trabajo al escribir una revisión de esta área: estuvo involucrado en el uso de tales defectos para dispersar la luz. Ahora la ha citado en cuatro artículos. "Me gusta escribir trabajos en los que puedo mencionar artículos poco conocidos".

Ola perdida

En 2016, el estudiante de doctorado Francisco Pina-Martins, de la Universidad de Lisboa, publicó un

documento sobre la interpretación de los datos de secuenciación genética, asegurándose de que nadie lo mencionaría porque la tecnología descrita en ella desarrollada por 454 Life Sciences estaba desactualizada y no se usaba. Subió su software de análisis de datos a GitHub, un sitio donde las personas comparten el código fuente, en 2012, y esto se ha mencionado en varios trabajos. Pero la publicación del estudio en sí tomó cuatro años, porque, según él, está asociado con un problema poco común que los especialistas que estudiaron previamente el artículo simplemente no entendieron.

Callejón sin salida

Muchas historias sobre el trabajo sin mencionar son tristes. En 2010, el neurocientífico Adriano Ceccarelli publicó

un artículo sobre la regulación de los genes en el moco de Dictyostelium en la revista PLoS ONE. Sus solicitudes de becas de investigación quedaron sin respuesta, y el trabajo nunca fue citado. "Bueno, ya sabes lo que sucede con la investigación: resulta que el trabajo ha llevado a un callejón sin salida", dice. - Mis ideas no son valiosas para la financiación. Ahora solo enseño y espero la jubilación. Pero con gusto me pondría a trabajar si recibiera fondos mañana ”.