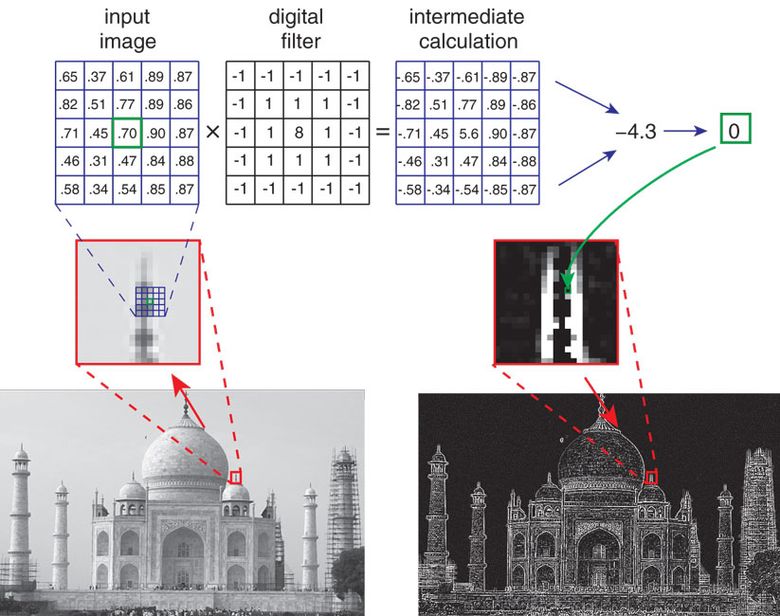

Los nuevos sistemas de imágenes, microscopios y matrices de video generan imágenes digitales basadas en cálculos de computadora en lugar de lentes tradicionales.

Incluso los artesanos medievales pudieron crear lentes de vidrio y espejos curvos para proyectar imágenes. Dichas construcciones se utilizaron para fabricar microscopios, cámaras estenopeicas, telescopios y otros instrumentos que nos permiten ver mejor objetos muy pequeños y grandes ubicados lejos y cerca, en la Tierra y en el cielo. La próxima revolución en la formación de imágenes tuvo lugar a mediados del siglo XIX: se inventó la fotografía. Ahora puede capturar "momentos detenidos", reproducirlos y replicarlos. Hoy, la era de la fotografía química está llegando a su fin, una nueva era está floreciendo: la imagen digital. Sus raíces se encuentran en la tecnología de televisión, pero consideraremos el comienzo de la era de 1975, cuando apareció la primera cámara digital. Hoy en día, miles de millones de cámaras web y cámaras en teléfonos móviles en todo el mundo capturan más de un billón de imágenes al año, y muchas de ellas se cargan de inmediato en Internet. A pesar del crecimiento explosivo en el número, la variedad y las formas de usar los sistemas de imágenes, las tareas de los ingenieros ópticos permanecen en gran medida sin cambios: crear una imagen óptica de alta calidad que transmita con precisión la escena para que "se vea bien".

Sin embargo, en los últimos 10-20 años ha comenzado a surgir un nuevo paradigma: la imagen computacional. Este paradigma puede no suplantar completamente los enfoques tradicionales, pero arrojará dudas sobre ideas centenarias y ayudará a crear métodos alternativos para diseñar sistemas de imágenes. Por ejemplo, ya tenemos disponibles nuevas funciones y formas de sistemas de imágenes, incluidos dispositivos súper miniatura para disparar objetos macroscópicos y microscopios sin lentes.

Como su nombre lo indica, la informática juega un papel clave en la formación de la imagen digital final. Durante mucho tiempo, mejoraron con la ayuda del procesamiento de imágenes digitales: eliminaron el efecto de ojos rojos al disparar con el flash, ajustaron los colores, etc., pero los circuitos ópticos de las lentes nunca se diseñaron teniendo en cuenta estas necesidades. Sin embargo, el procesamiento de señal digital permite, por ejemplo, corregir distorsiones ópticas tales como "almohadas" o distorsiones de gran angular en los bordes de la imagen. Cuando el telescopio orbital Hubble envió las primeras imágenes a la Tierra a fines de la década de 1980, estaban mucho más “jabonosas” de lo esperado. Pronto se hizo evidente que había algunos problemas con la óptica. Los científicos de la NASA determinaron cuál era el problema, y hasta que se reparó el telescopio, corrigieron muchos defectos durante varios años utilizando sofisticados algoritmos de procesamiento digital.

A mediados de la década de 1990, a Wade Thomas Cathey y Edward R. Dowski, Jr., se les ocurrió la idea de diseñar lentes para producir imágenes borrosas, "degradadas", pero degradadas para que Los algoritmos de procesamiento digital hicieron posible que las imágenes no fueran peores, o incluso mejores, tomadas con lentes tradicionales. En particular, Katie y Dowsky recurrieron al rasgo característico de todas las cámaras tradicionales: profundidad de campo limitada. Si enfoca un objeto a una distancia promedio de usted, se verá nítido, pero los objetos más cercanos y más alejados se volverán borrosos. La profundidad de campo se refiere al área dentro de la cual todos los objetos se ven razonablemente nítidos. Entonces, a dos científicos se les ocurrió una nueva lente, que casi borrosa las imágenes ópticas de los objetos a todas las distancias. Y luego un algoritmo especial agudizó toda la imagen, obteniendo una profundidad de campo que es inalcanzable para lentes comunes. Aunque muchos científicos han mejorado aún más la técnica descrita, la idea de Katie y Dowsky avanzó mucho en la disciplina de captura computacional y formación de imágenes.

Otra consecuencia de este trabajo científico fue que ahora se están desarrollando circuitos ópticos para lentes basados en la creación de imágenes para computadoras, no para personas. Es paradójico que en nuestra era de disparos totales, muy pocas personas vieran imágenes ópticas reales formadas por cámaras. Ya pasaron los días en que el fotógrafo, inclinándose hacia la cámara y cubriéndose con una capa ajustada, sacó el obturador y, antes de insertar el cassette con la película, vio en el vidrio esmerilado una imagen "en vivo" formada directamente por la lente. Hoy, vemos en las pantallas el resultado del procesamiento digital de imágenes ópticas que han caído en matrices de silicio.

La siguiente área de aplicación para la combinación de óptica y procesamiento digital ha sido la simplificación del diseño de lentes. En su teléfono inteligente, una lente de cámara puede constar de 7-8 elementos ópticos, y las lentes de cámara profesionales a veces consisten en más de 15 elementos ópticos. Se necesita una gran cantidad de lentes para corregir los defectos de la imagen: aberraciones inherentes a cualquier sistema óptico: cromático (color fantasma alrededor de los objetos) y óptico (distorsión de la forma y proporciones de los objetos). Es decir, se necesitan diseños de lentes complejos para producir imágenes "atractivas". La combinación de óptica y procesamiento digital ayudará a cambiar parte del trabajo para corregir las aberraciones a un componente digital, lo que le permitirá abandonar algunos elementos ópticos sin comprometer la calidad de la imagen digital final. Es decir, los algoritmos de procesamiento desempeñan el papel de elementos ópticos virtuales. Este enfoque permitió crear sistemas ópticos más compactos y más baratos sin pérdida de calidad.

¿En qué medida se desarrollarán estas ideas? ¿Qué proporción de la tarea de imagen se puede transferir de la óptica a un componente digital? ¿Qué tan simple puede ser un circuito óptico para obtener una imagen decente? ¿Es realista deshacerse de lentes y espejos? Esto se ha logrado en los últimos años de tres maneras: las lentes y las imágenes ópticas que forman están completamente excluidas. Los métodos se basan en la difracción, la reconstrucción de fase óptica y la técnica de detección de compresión. Y para obtener la imagen final adecuada para las personas, se utilizan activamente los cálculos por computadora.

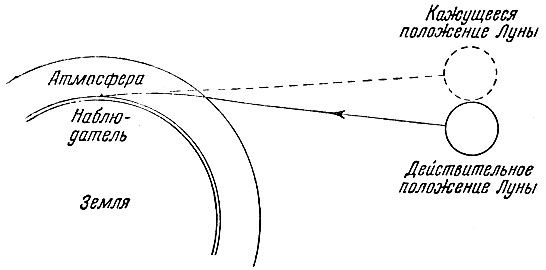

Las lentes tradicionales enfocan un haz de luz mediante refracción : la luz se refracta cuando pasa a través de un límite de medios (vidrio de aire) a diferentes velocidades de luz. Gracias al efecto de refracción, un lápiz sumergido en un vaso de vidrio con agua parece curvarse: la luz reflejada por el lápiz se refracta cuando entra al aire en el camino hacia los ojos. Por lo tanto, la parte subacuática del lápiz que vemos no está donde está realmente.

Por cierto, gracias a la refracción (refracción) en el borde del espacio y la atmósfera de la Tierra, todos los objetos celestes parecen estar ubicados un poco más altos que su ubicación real:

Los espejos curvos como los que se usan en los telescopios grandes forman una imagen diferente: usando la reflexión . Para comprender la diferencia entre refracción y reflexión, imagine la luz en forma de rayos (líneas).

Otros dos fenómenos físicos ayudarán a cambiar la dirección de propagación de la luz y usar su naturaleza de onda (recuerde la dualidad onda-partícula ): difracción e interferencia . Cuando dos ondas de luz coherentes se encuentran, se superponen, aparece la amplitud de onda resultante. Si el máximo de una onda siempre coincide con el máximo de la otra, entonces las ondas se refuerzan entre sí, esto se llama interferencia constructiva . Si el máximo de una onda siempre coincide con el mínimo de la otra, entonces las ondas se cancelan entre sí; esto es una interferencia destructiva , como resultado de la cual la luz puede desaparecer por completo.

Puede controlar la luz a través de la difracción dirigiéndola a la rejilla de difracción, una serie de los mejores trazos (rásteres), sobre una superficie lisa. Como las ondas de diferentes longitudes se reflejan en diferentes direcciones, se produce una tinción de color. Por ejemplo, cuando la luz blanca se refleja desde pequeños surcos en la superficie de un CD o DVD, vemos rayas de arcoíris. Debido a la dependencia de las longitudes de onda del ráster, es imposible crear una rejilla de difracción que simplemente reemplace las lentes. Una imagen óptica formada por una rejilla nunca se verá tan bien como una imagen de una lente bien diseñada. Sin embargo, es bastante posible crear imágenes digitales aceptables usando una combinación de óptica de difracción (usando difracción) y procesamiento de señal coincidente (teniendo en cuenta la óptica).

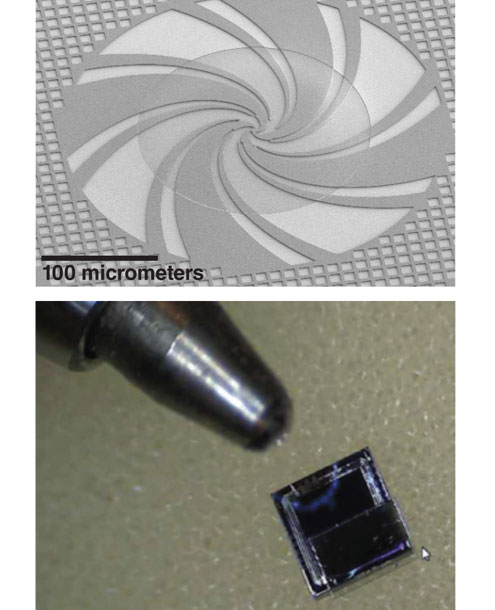

En una de las clases de dispositivos no objetivos para disparos macroscópicos, se utilizan rejillas de difracción en miniatura, ubicadas paso a paso en el grosor de un material transparente (vidrio o silicato) y retrasando una parte de la luz incidente en relación con la otra parte. Las propiedades matemáticas del esquema escalonado son tales que la distribución de la luz en el material depende débilmente de la longitud de onda y, por lo tanto, de una ligera variación en el grosor del vidrio, que ocurre inevitablemente durante la fabricación. Los enrejados están unidos a un sensor fotosensible , como la matriz de las cámaras digitales convencionales. La luz incidente pasa a través de las rejillas y llega a la matriz, que ya se ha descompuesto especialmente en "componentes". No se parece en nada a una imagen ordinaria: una especie de nube borrosa, incomprensible para el ojo humano. Sin embargo, esta nube contiene suficiente información visual (aunque inusualmente distribuida) para recrear la imagen deseada a partir de ella utilizando un proceso computacional llamado convolución de imagen.

El algoritmo de reconstrucción de imagen es ligeramente sensible al ruido visual, por ejemplo, fluctuaciones aleatorias en el número de fotones o ruido eléctrico durante la conversión de la señal del sensor a una representación numérica (el llamado error de cuantificación). Por lo tanto, la imagen puede ser visualmente ruidosa. Aunque esta calidad es suficiente para una serie de tareas simples (por ejemplo, para contar el número de personas en un cuadro), sin embargo, para una imagen más decente, necesita capturar más información sobre la escena que se toma. La solución "en la frente" es tomar varias rejillas de fase en miniatura diseñadas para capturar diversa información sobre la escena. Es decir, cada red forma una imagen digital de componentes, estos componentes pueden procesarse y obtener una mejor imagen.

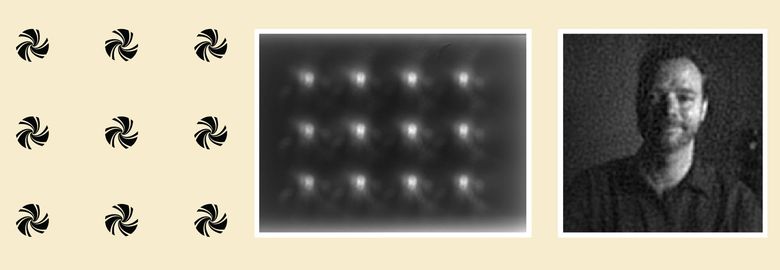

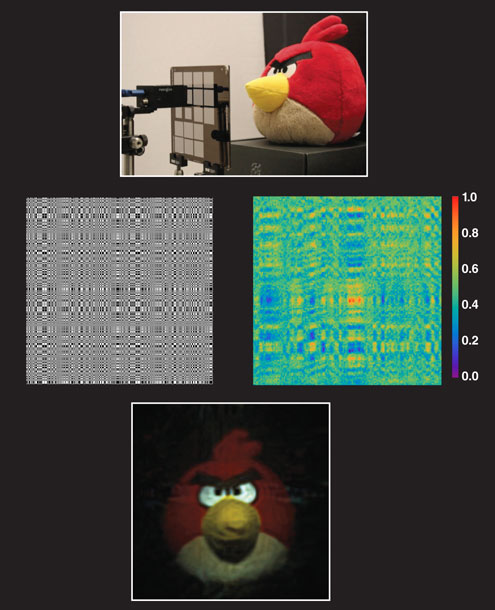

Un tipo de sistema de imágenes sin lente utiliza matrices que dispersan la luz, en lugar de enfocarla como lentes. En el ejemplo anterior, una matriz de 12 microrredes de fase binaria (izquierda) está diseñada para capturar tanta información visual como sea posible sobre la escena. Después de que la luz pasa a través de la matriz, se obtienen 12 puntos borrosos, ninguno de los cuales le permite a una persona comprender lo que se filma aquí (en el centro). Sin embargo, esta imagen óptica contiene suficiente información para obtener un retrato completamente legible (derecha) usando un procesamiento digital llamado "convolución de imagen".

Este enfoque ayudará no solo a formar la imagen de la escena, sino también a analizarla: para determinar las propiedades visuales (por ejemplo, si hay un rostro humano en la foto), la dirección y la velocidad del movimiento general de la escena ( flujo visual, flujo visual), calcular el número de personas en en el interior En tales situaciones, las rejillas de difracción están diseñadas para extraer la información necesaria, y el algoritmo de procesamiento se adapta a una tarea específica. Digamos, si necesitamos leer un código de barras vertical, entonces usamos una rejilla de difracción vertical y un algoritmo que lleva cada píxel de una imagen digital a un valor umbral: la luz se convierte en oscura, la oscura en negra. El resultado es una imagen digital en blanco y negro, y ya puede ser reconocida por el algoritmo de lectura de código de barras.

Microscopía de reconstrucción de fase

El enfoque para crear microscopios sesgados difiere de los métodos para crear cámaras computacionales para macro objetos, aunque el fenómeno de difracción también se usa aquí. Sin embargo, a diferencia de un dispositivo que dispara una escena con iluminación ordinaria creada por el sol o las lámparas, solo se puede seleccionar la radiación láser coherente o la luz monocromática de una o varias fuentes para la iluminación en microscopía. Esto le permite controlar la difracción e interferencia de la luz. Además, los objetos que nos interesan son tan pequeños que la difracción ocurrirá cuando la luz pase a través de los objetos mismos, y no a través de una rejilla de difracción artificial.

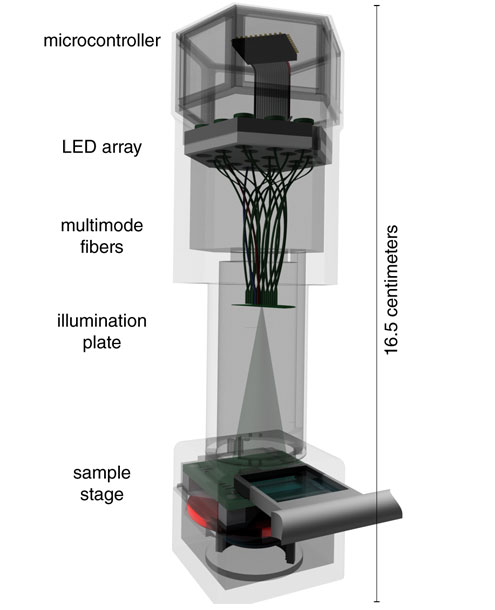

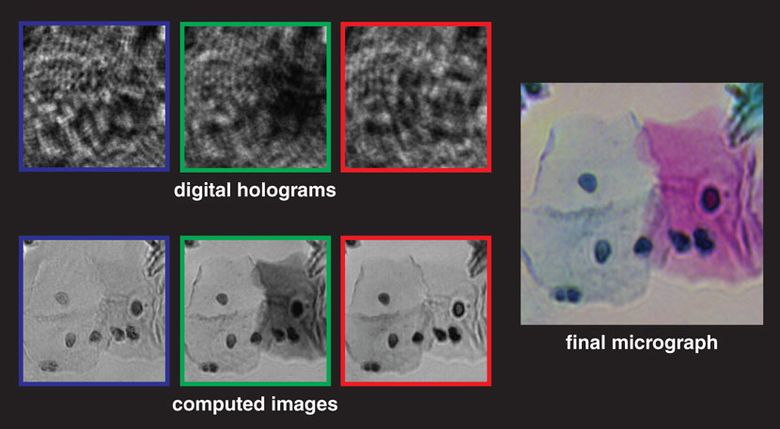

El esquema de tal microscopio implica que la muestra se coloca encima de una matriz fotosensible con una gran cantidad de píxeles pequeños: una matriz de 10 megapíxeles, por ejemplo, que a menudo se encuentra en las cámaras digitales. Este esquema también se llama "microscopio en chip" porque la muestra se coloca directamente en la matriz de formación de imágenes. La luz de un láser o un LED de color espectralmente puro incide en la muestra y se dispersa en los objetos que se disparan. Las ondas de difracción resultantes, que forman el haz del objeto ( haz del objeto), se superponen a la iluminación que atraviesa la muestra sin distorsión, el haz de referencia (haz de referencia). El resultado es un patrón de interferencia complejo registrado por una matriz fotosensible y utilizado en holografía digital en línea. La imagen en bruto se asemeja vagamente a las sombras microscópicas de la muestra, y en algunos casos es suficiente para calcular aproximadamente el número y la ubicación de los objetos. Pero la imagen holográfica en bruto es demasiado turbia, ruidosa, contiene "artefactos de anillo" y no permite determinar la morfología de los objetos. La foto es mala.

El patrón de interferencia pasa por varias etapas de procesamiento digital, la etapa principal es el algoritmo de reconstrucción de fase. En él, utilizando la física de la interferencia óptica, se extraen conclusiones sobre la estructura y ubicación de los objetos en la muestra. En resumen: el algoritmo busca información óptica sobre la fase perdida en el holograma en la matriz (que registra solo el patrón de interferencia y no las fases de los rayos de luz individuales). El algoritmo calcula iterativamente la información de fase en el haz del objeto, lo que probablemente condujo a la aparición de dicho patrón de interferencia óptica. Cuando se determina la información sobre la fase en el haz del objeto, el algoritmo calcula su cambio en el tiempo para construir una imagen de los objetos, formando la imagen digital final.

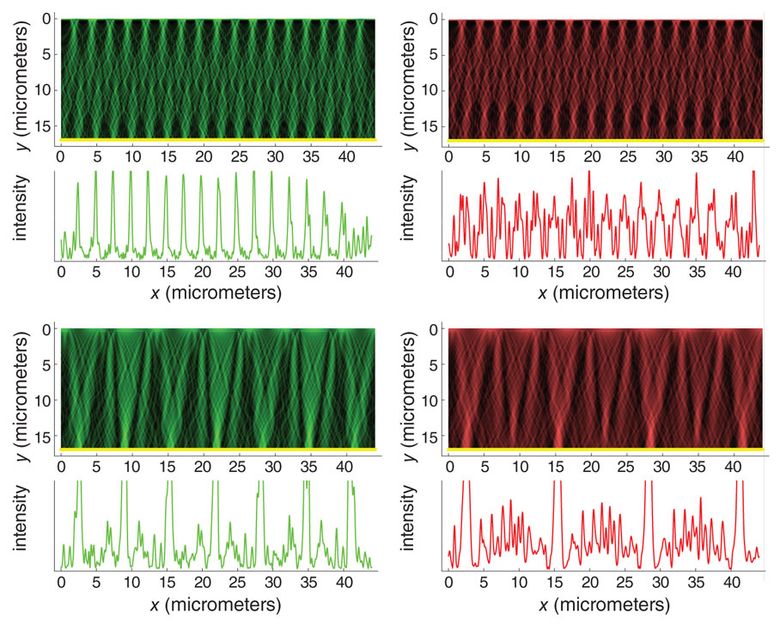

Al igual que con los dispositivos macro, la resolución aumenta al capturar varias imágenes ópticas, cada una de las cuales contiene información ligeramente diferente. Por ejemplo, antes de registrar cada cuadro, puede cambiar ligeramente la fuente de luz, o la muestra en sí, o la matriz. Luego, los marcos se procesan y se combinan para obtener una imagen de interferencia de mayor resolución (que todavía es incomprensible para los humanos), y luego se realizan las fases de restauración de fase y restauración temporal.

Los microscopios objetivos en un chip tienen varias ventajas.

En primer lugar, el área de disparo de la muestra (es decir, el campo de visión) puede ser extremadamente grande, solo está limitada por el tamaño de la matriz fotosensible en la que se coloca la muestra. Las matrices modernas le permiten proporcionar un campo de visión de 20 milímetros cuadrados a 20 centímetros cuadrados.

En segundo lugar, incluso los objetos transparentes (por ejemplo, la mayoría de las bacterias en una capa de agua) pueden estudiarse con microscopios objetivos si cambian la fase de la luz que los atraviesa. Los microscopios ópticos objetivos especiales también permiten el estudio de tales "objetos de fase", aunque con un campo de visión mucho más pequeño y el tamaño total de la muestra.

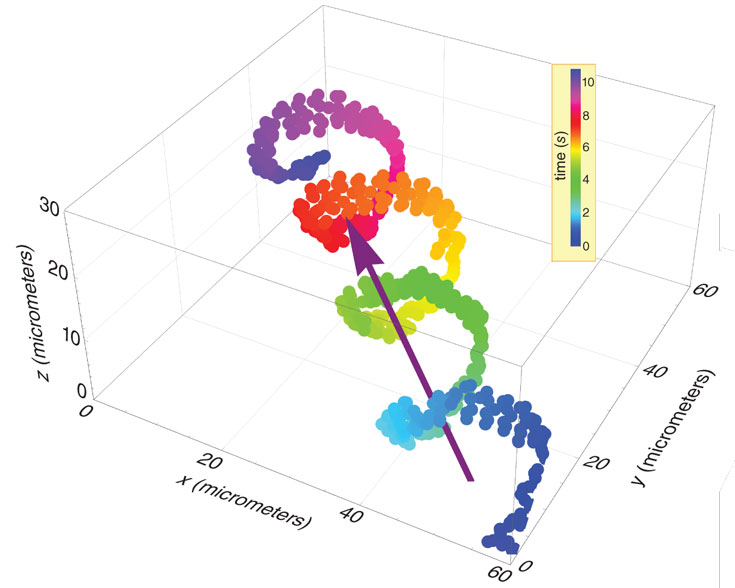

En tercer lugar, el procesamiento digital de la imagen óptica permite aislar diferentes tipos de células (por ejemplo, esperma o células sanguíneas en los capilares) y rastrear sus movimientos. Gracias a esto, los médicos y biólogos pueden obtener datos importantes.

Cuarto, estos microscopios son mucho más baratos y compactos que los tradicionales. Los microscopios sin objetivos pueden conectarse a un teléfono móvil, usarse en áreas rurales, y los datos digitales pueden transferirse a cualquier lugar para un análisis más detallado.

Técnica de detección de compresión

El tercer enfoque para la formación de imágenes sesgadas se basa en los últimos avances en matemáticas y estadísticas de señales: la técnica de detección de compresión . Una imagen óptica en una matriz es una señal compleja, que se presenta en forma de una lista de números y es procesada por diferentes algoritmos. Como una señal de sonido compleja consta de muchos sonidos más simples, cada uno de los cuales se agrega en la proporción correcta, la imagen se forma a partir de una gran cantidad de imágenes más simples. Un conjunto de imágenes simples, o señales, se denomina base . En el ámbito del sonido, la base más común es un conjunto de tonos coseno puros. No importa lo complicado que sea el sonido. Todo, desde la bocina de un automóvil hasta la sinfonía de Beethoven, se puede crear agregando una gran cantidad de ondas de coseno básicas, para cada una de las cuales se seleccionan la intensidad y el cambio de tiempo necesarios.

¿Cuál podría ser una base similar en el campo de las imágenes? Las dos bases visuales más populares y útiles son conjuntos de ondas cosenoidales bidimensionales y patrones wavelet de resolución múltiple. Estos elementos básicos son matemáticamente elegantes y forman la base de los esquemas modernos de compresión de imágenes JPEG y JPEG 2000. En lugar de almacenar y transmitir los valores de cada píxel en una imagen digital, usted opera en un archivo que describe las amplitudes de las diferentes señales base de componentes. Como resultado, el archivo "comprimido" es mucho más pequeño que la imagen misma. Durante décadas, estas bases sirvieron fielmente como una herramienta para procesar imágenes digitales, pero no condujeron a la creación de nuevos métodos para el desarrollo de circuitos ópticos; por lo tanto, ningún elemento óptico facilita la introducción de bases.

Pasemos a la detección de compresión. Teóricamente, las estadísticas muestran que si bien la información sobre la escena es redundante (es decir, la imagen se puede comprimir), no es necesario medir las bases, las mediciones de una muestra aleatoria son suficientes. « », , ( ), compressive sensing. , , .

, (), . . «» , , (). , .

, -. (coded apertures) ( - ) . FlatCam (Ashok Veeraraghavan) . , (. ). — Angry Birds — ( ) . , , , . , . , . compressive sensing «» , .

.

, . , , , . 0,5 0,2 — , . FlatCam , , .

, , , , . , - , . , , .

. , , , , , , . , , , . , , , .

, . , - .