Hace un año,

ensamblé un centro de datos a partir de una pila de Intel NUC . Hubo un sistema de almacenamiento de software que la señora de la limpieza no pudo destruir, un par de veces el clúster colapsó.

Y ahora decidimos ejecutar vSAN en varios servidores en una configuración muy buena para evaluar completamente el rendimiento y la tolerancia a fallas de la solución. Por supuesto, tuvimos una serie de implementaciones exitosas en producción para nuestros clientes, donde vSAN resuelve con éxito las tareas, pero no fue posible realizar pruebas exhaustivas. En realidad, quiero compartir los resultados de la prueba hoy.

Tormentaremos el almacenamiento con una carga, lo soltaremos y probaremos la tolerancia a fallas de todas las formas posibles. Para más detalles, invito a todos a gato.

¿Qué es VMware vSAN en general y por qué nos metimos en él?

Hay un clúster de servidores regular para máquinas virtuales. Tiene un montón de componentes independientes, el hipervisor se ejecuta directamente en el hardware y el almacenamiento se configura por separado según DAS, NAS o SAN. Datos lentos en HDD, datos calientes en SSD. Todo es familiar Pero aquí surge el problema del despliegue y administración de este zoológico. Se vuelve especialmente divertido en situaciones donde los elementos individuales del sistema provienen de diferentes proveedores. En caso de problemas, el atraque de boletos para soporte técnico de diferentes fabricantes tiene su propia atmósfera especial.

Hay piezas de hierro separadas, que desde el punto de vista del servidor parecen discos para grabar.

Y hay sistemas hiperconvergentes. En ellos, se le da una unidad universal que asume todo el dolor de cabeza de la interacción de la red, los discos, los procesadores, la memoria y las máquinas virtuales que giran sobre ellos. Todos los datos fluyen en un panel de control y, si es necesario, simplemente puede agregar un par de unidades más para compensar el aumento de carga. La administración está muy simplificada y estandarizada.

VMware vSAN solo se refiere a las soluciones en base a las cuales se implementa

Infraestructura hiperconvergente. La característica clave del producto es una estrecha integración con la plataforma de virtualización VMware vSphere, que es líder entre las soluciones de virtualización que le permite implementar el almacenamiento de software para máquinas virtuales en servidores de virtualización en minutos. vSAN toma directamente el control de las operaciones de E / S a un nivel bajo, distribuyendo de manera óptima la carga, almacenando en caché las operaciones de lectura / escritura y haciendo mucho más con una carga mínima en la memoria y el procesador. La transparencia del sistema se reduce ligeramente, pero como resultado, todo funciona, como dicen, vSAN se puede configurar automáticamente como un almacenamiento híbrido y en forma de una versión todo flash. Se escala horizontalmente agregando nuevos nodos al clúster y verticalmente, aumentando el número de discos en nodos individuales. Administrar con su propio cliente web vSphere es muy conveniente debido a la estrecha integración con otros productos.

Nos decidimos por una configuración limpia todo flash, que debería ser óptima en términos de precio y rendimiento. Está claro que la capacidad total es ligeramente menor en comparación con la configuración híbrida que utiliza discos magnéticos, pero aquí decidimos comprobar cómo se puede evitar esto parcialmente mediante la codificación de borrado, así como la deduplicación y la compresión sobre la marcha. Como resultado, la eficiencia del almacenamiento se acerca a las soluciones híbridas, pero significativamente más rápido con una sobrecarga mínima.

Cómo probar

Para probar el rendimiento, utilizamos el software

HCIBench v1.6.6 , que automatiza el proceso de creación de muchas máquinas virtuales y luego compila los resultados. La prueba de rendimiento en sí se lleva a cabo utilizando el software Vdbench, uno de los programas de prueba de carga sintética más populares. Iron estaba en las siguientes opciones de configuración:

- All-flash - 2 grupos de discos: SSD 1xNVMe Samsung PM1725 800 GB + 3xSATA

- SSD Toshiba HK4E 1.6 TB.

- Todo flash: 1 grupo de discos: SSD 1xNVMe Samsung PM1725 800 GB + SSD 6xSATA Toshiba HK4E 1.6 TB.

- All-flash - 1 grupo de discos: SSD 1xNVMe Samsung PM1725 800GB + 6xSATA SSD Toshiba HK4E 1.6 TB + Eficiencia espacial (deduplicación y compresión).

- All-flash - 1 grupo de discos: SSD 1xNVMe Samsung PM1725 800GB + 6xSATA SSD Toshiba HK4E 1.6 TB + Codificación de borrado (RAID 5/6).

- All-flash: 1 grupo de discos: SSD 1xNVMe Samsung PM1725 800GB + SSD 6xSATA Toshiba HK4E 1.6 TB + Codificación de borrado (RAID 5/6) + Eficiencia espacial (deduplicación y compresión).

Durante las pruebas, emulamos tres volúmenes diferentes de datos activos utilizados por las aplicaciones: 1 TB (250 GB por servidor), 2 TB (500 GB por servidor) y 4 TB (1 TB cada uno).

Para cada configuración, se realizó el mismo conjunto de pruebas con los siguientes perfiles de carga:

- 0 lectura / 100 escritura, aleatoriamente 50%, tamaño de bloque - 4k.

- 30 lecturas / 70 escrituras, 50% al azar, tamaño de bloque - 4k.

- 70 lecturas / 30 escrituras, 50% al azar, tamaño de bloque - 4k.

- 100 lectura / 0 escritura, aleatoriamente 50%, tamaño de bloque - 4k.

Las opciones primera y cuarta eran necesarias para comprender cómo se comportará el sistema bajo cargas máximas y mínimas. Pero el segundo y el tercero están lo más cerca posible del caso de uso típico real: por ejemplo, 30 lectura / 70 escritura - VDI. Esas cargas que encontré en la producción estaban muy cerca de ellos. En el proceso, probamos la efectividad del mecanismo de gestión de datos vSAN.

En general, el sistema demostró ser muy bueno. Según los resultados de la prueba, nos dimos cuenta de que podemos contar con un rendimiento en la región de 20 mil IOPS por nodo. Para tareas ordinarias y muy cargadas, estos son buenos indicadores que tienen en cuenta retrasos de 5 ms. A continuación di gráficos con los resultados:

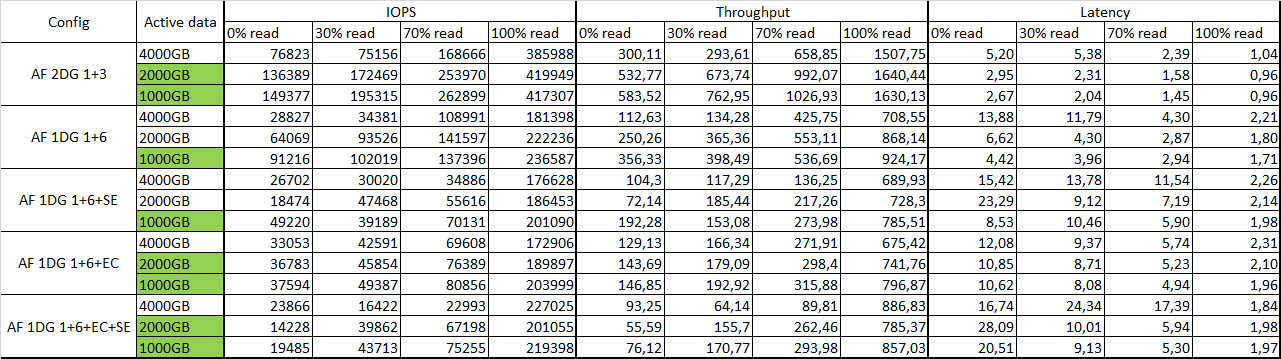

Tabla resumen con resultados de la prueba:

El color verde indica datos activos que están completamente en caché.

Tolerancia a fallos

Corté un nodo tras otro, a pesar de la indignación de la máquina, y observé la reacción del sistema en su conjunto. Después de desconectar el primer nodo, no pasó nada, excepto por una pequeña caída en el rendimiento, en aproximadamente un 10-15%. Apagué el segundo nodo: algunas de las máquinas virtuales se apagaron, pero el resto continuó funcionando con una ligera degradación en el rendimiento. Supervivencia general satisfecha. Reinicié todos los nodos: el sistema lo pensó un poco y se sincronizó nuevamente sin ningún problema, todas las máquinas virtuales se iniciaron sin ningún problema. Como alguna vez en NUC. La integridad de los datos tampoco se ve afectada, lo cual está muy satisfecho.

Impresiones generales

Software Defined Storage Systems (SDS) ya es una tecnología madura.

Hoy, uno de los principales factores de detención que se interponen en el camino de la implementación de vSAN es el costo bastante alto de una licencia en rublos. Si crea la infraestructura desde cero, puede resultar que un sistema de almacenamiento tradicional en una configuración similar costará aproximadamente lo mismo. Pero será menos flexible tanto en términos de administración como de escala. Así que hoy, al elegir una solución para almacenar datos de máquinas virtuales en la plataforma de virtualización vSphere, es muy bueno sopesar todos los pros y los contras de usar soluciones tradicionales e implementar tecnología de almacenamiento definida por software.

Puede crear una solución en el mismo Ceph o GlusterFS, pero cuando trabaja con la infraestructura de VMware, la integración de vSAN con componentes individuales es cautivadora, así como la facilidad de administración, implementación y un rendimiento significativamente mayor, especialmente en un pequeño número de nodos. Por lo tanto, si ya está trabajando en la infraestructura de VMware, será mucho más fácil implementarlo. Realmente haces una docena de clics y obtienes una SDS funcional de la caja.

Otra motivación para implementar vSAN es usarlo para sucursales, lo que le permite duplicar nodos en unidades remotas con un host testigo en el centro de datos. Esta configuración proporciona almacenamiento tolerante a fallas para máquinas virtuales con todas las tecnologías y rendimiento de vSAN en solo dos nodos. Por cierto, para usar vSAN hay un esquema de licencia por separado para la cantidad de máquinas virtuales, que permite reducir los costos en comparación con el esquema de licencia de vSAN tradicional para procesadores.

Arquitectónicamente, la solución requiere 10 Gb Ethernet con dos enlaces por nodo para una distribución de tráfico adecuada cuando se utiliza una solución todo flash. En comparación con los sistemas tradicionales, ahorra espacio en el rack y ahorra en redes SAN al eliminar Fibre Channel en favor del estándar Ethernet más universal. Para garantizar la tolerancia a fallas, se requieren al menos tres nodos; en dos réplicas de objetos con datos se almacenarán, y en el tercero, objetos testigos de estos datos, se resuelve el problema del cerebro dividido.

Ahora algunas preguntas para ti:

- Cuando decide un sistema de almacenamiento, ¿qué criterios son más importantes para usted?

- ¿Qué factores de detención ve en el camino hacia la implementación de sistemas de almacenamiento definidos por software?

- ¿Qué sistemas de almacenamiento definidos por software considera básicamente como una opción para la implementación?

UPD: olvidé por completo escribir la configuración del soporte y cargar los parámetros:

1. Descripción del hierro. Por ejemplo:

Servidores - 4xDellR630, cada uno:

• 2xE5-2680v4

• 128 GB de RAM

• 2x10GbE

• 2x1GbE para gestión / red VM

• Dell HBA330

Configuración de almacenamiento n. ° 1:

2xPM1725 800GB

6xToshiba HK4E 1.6TB

Configuración de almacenamiento n. ° 2:

1xPM1725 800GB

6xToshiba HK4E 1.6TB

2. Descripción de las versiones de software:

vSphere 6.5U1 (7967591) (vSAN 6.6.1), es decir parches después de Meltdown / Spectre

vCenter 6.5U1g

Los últimos controladores compatibles y FW de vSAN y ESXi para todos los componentes

LACP para tráfico vSAN y vMotion (con recursos compartidos / límites / reserva de NIOC habilitados)

Todas las demás configuraciones son predeterminadas

3. Parámetros de carga:

• HCIBench 1.6.6

• Oracle Vdbench - 05/04/06

• 40VM por cluster (10 por nodo)

• 10 vmdk por VM

• Tamaño de 10 GB de vmdk y porcentaje de conjunto de carga de trabajo del 100/50/25%

• Tiempo de calentamiento: 1800 segundos (0,5 horas), tiempo de prueba 3600 (1 hora)

• 1 subprocesos por vmdk