Kubernetes, también conocido como k8s es un sistema de código abierto para automatizar la implementación, el escalado y la administración de aplicaciones en contenedores. En este artículo, le mostraré cómo configurar un clúster de Kubernetes e implementar un clúster Elasticsearch en AWS en él. Esta configuración también funciona en GCE y Azure .

Configurar Kubernetes en AWS

Para comenzar, obtenga acceso administrativo a los siguientes servicios de AWS: S3, EC2, Route53, IAM y VPC .

1. Instalación: mostraré la instalación de la CLI para Linux. Si tiene un sistema operativo diferente, siga los enlaces a continuación para obtener instrucciones de instalación para su sistema operativo.

Primero, configure la AWS CLI para acceder a AWS a través de la CLI. Si ya tiene Python y pip, ejecute el comando:

pip install awscli --upgrade --user

Luego usamos Kops , una herramienta de línea de comandos que nos lleva a través de la configuración del clúster de nivel de producción K8S.

Instale los binarios de Kops directamente desde github.

wget -O kops https://github.com/kubernetes/kops/releases/download/$(curl -s https://api.github.com/repos/kubernetes/kops/releases/latest | grep tag_name | cut -d '"' -f 4)/kops-linux-amd64 chmod +x ./kops sudo mv ./kops /usr/local/bin/

Finalmente, usamos el kubectl - CLI para administrar el clúster K8S (si usó docker, esto es similar a la CLI de docker ). La última versión se instala mediante el comando:

wget -O kubectl https://storage.googleapis.com/kubernetes-release/release/$(curl -s https://storage.googleapis.com/kubernetes-release/release/stable.txt)/bin/linux/amd64/kubectl chmod +x ./kubectl sudo mv ./kubectl /usr/local/bin/kubectl

Nota: puede iniciar el clúster de Kubernetes y seguir las instrucciones de este artículo en una máquina doméstica con minikube .

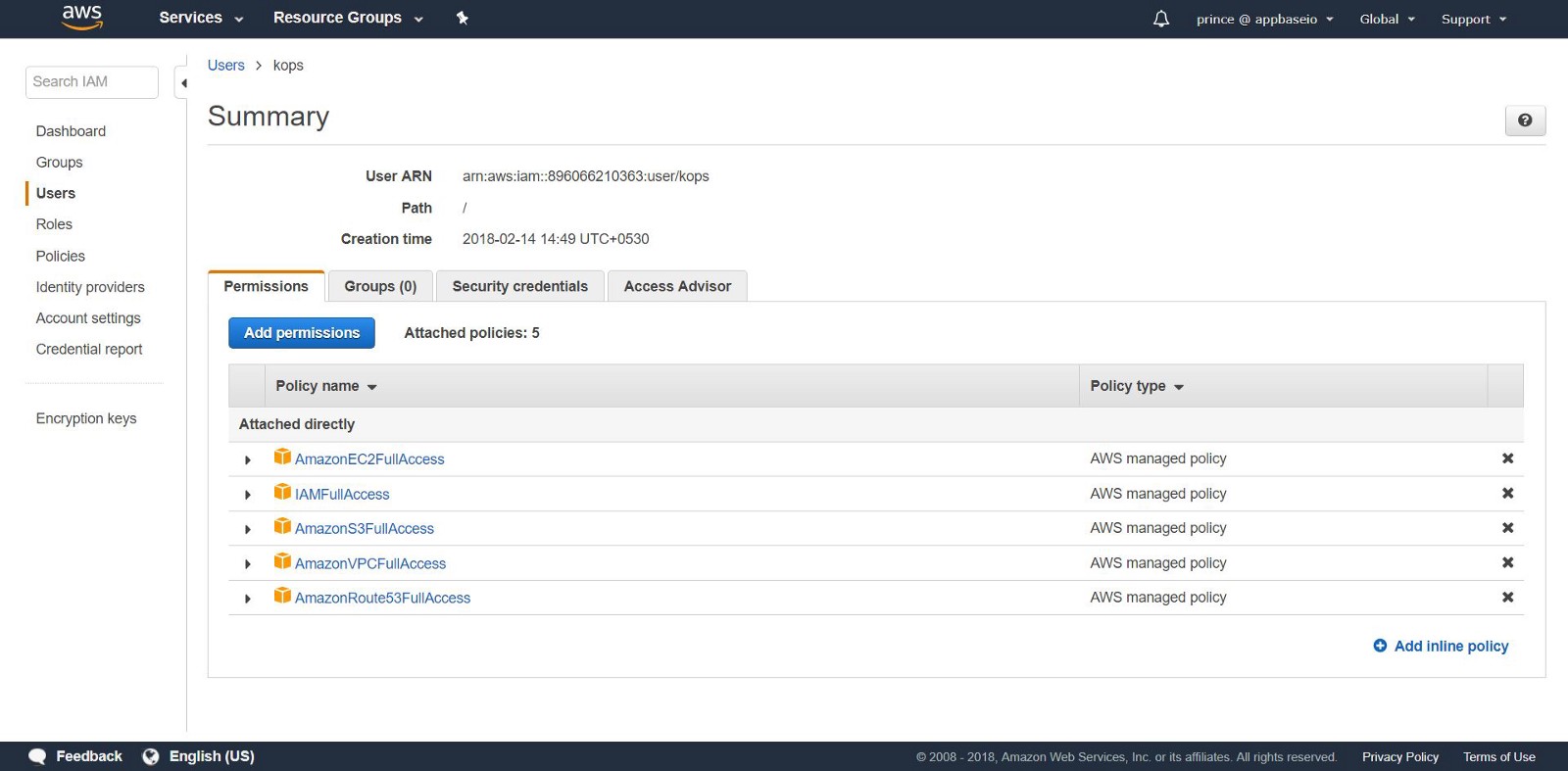

2.Cree usuarios de IAM: para crear clústeres en AWS, crearemos un usuario de IAM separado para kops . Para kops necesitas una cuenta API. Cree un usuario y configure una cuenta a través de la interfaz de usuario de la consola de AWS . El usuario kops necesitará el siguiente permiso de IAM:

- AmazonEC2FullAccess

- AmazonRoute53FullAccess

- AmazonS3FullAccess

- IAMFullAccess

- AmazonVPCFullAccess

Alternativamente, puede hacer lo mismo desde la CLI aplicando los siguientes comandos:

aws iam create-group --group-name kops aws iam attach-group-policy --policy-arn arn:aws:iam::aws:policy/AmazonEC2FullAccess --group-name kops aws iam attach-group-policy --policy-arn arn:aws:iam::aws:policy/AmazonRoute53FullAccess --group-name kops aws iam attach-group-policy --policy-arn arn:aws:iam::aws:policy/AmazonS3FullAccess --group-name kops aws iam attach-group-policy --policy-arn arn:aws:iam::aws:policy/IAMFullAccess --group-name kops aws iam attach-group-policy --policy-arn arn:aws:iam::aws:policy/AmazonVPCFullAccess --group-name kops aws iam create-user --user-name kops aws iam add-user-to-group --user-name kops --group-name kops aws iam create-access-key --user-name kops

Tenga en cuenta las AccessKeyID SecretAccessKey y AccessKeyID en kops .

Configure la AWS CLI para usar su cuenta con aws configure .

Asegúrese de que el usuario que creó esté en la aws iam list-users .

Exportamos la cuenta de AWS como las siguientes variables de entorno para que la CLI kops pueda usarlas.

export AWS_ACCESS_KEY_ID=$(aws configure get aws_access_key_id) export AWS_SECRET_ACCESS_KEY=$(aws configure get aws_secret_access_key)

Si está utilizando Kops 1.6.2 o posterior, la configuración de un DNS es opcional. Puedes crear un grupo de chismes. El único requisito: el nombre del clúster debe terminar en .k8s.local .

Configuración de DNS

Si ya ha alojado su dominio a través de AWS y planea usarlo, no necesita hacer nada. Otra opción: si desea utilizar un subdominio de su dominio, cree una segunda zona de alojamiento público para este subdominio. En este manual, trabajaremos con una zona de alojamiento privada. Establezca la zona bajo cualquier nombre. Use este nombre para crear grupos de Kubernetes. Lea más sobre cómo configurar DNS aquí .

3. Crear un depósito S3: para guardar el estado y la apariencia de nuestro clúster K8S, debe crear un depósito S3 separado para kops . Este depósito se convertirá en una fuente de datos confiables para el clúster de configuración.

aws s3api create-bucket \ --bucket <your-unique-bucket-name> \ --region us-east-1

Nota: si pone su cubo en funcionamiento en un área que no sea us-east-1 , además de establecer - region cambie al área deseada y agregue LocationConstraint a la misma área. A continuación se muestra el comando de construcción de depósito en la región us-west-1 .

aws s3api create-bucket \ --bucket <your-unique-bucket-name> \ --region us-west-1 \ --create-bucket-configuration LocationConstraint=us-west-1

Para configurar el almacenamiento para las versiones de cubo S3 para la recuperación, use el siguiente comando:

aws s3api put-bucket-versioning \ --bucket <your-unique-bucket-name> \ --versioning-configuration Status=Enabled

4. Creando el primer cluster de Kubernetes: ¡ Entonces, estás listo para crear tu primer cluster! Primero, configure las variables de entorno para simplificar el proceso. Si omitió la configuración de DNS (después del paso 2), agregue .k8s.local al valor NAME .

export NAME=myfirstcluster.example.com export KOPS_STATE_STORE=s3://your-bucket-name

No olvide hacer un seguimiento de qué zonas regionales están disponibles para usted. En este ejemplo, implementaremos un clúster en la región us-east-2 .

aws ec2 describe-availability-zones --region us-east-2

Si está utilizando una zona de alojamiento público, cree un clúster con el siguiente comando:

kops create cluster \ --zones us-east-2c \ --node-count 3 \ ${NAME}

Si usa una zona de alojamiento privado, haga lo siguiente:

kops create cluster \ --zones us-east-2c \ --node-count 3 \ --dns private ${NAME}

Este comando le proporcionará el registro de configuración del clúster K8S. El clúster tarda en iniciarse, ya que crea nuevas máquinas EC2 para los nodos maestros minion.

[ec2-user@ip-172-31-35-145 test]$ kops create cluster \ > --dns private \ > --zones us-east-2c \ > --node-count 3 \ > ${NAME} --yes I0306 09:45:29.636834 20628 create_cluster.go:439] Inferred --cloud=aws from zone "us-east-2c" I0306 09:45:29.637030 20628 create_cluster.go:971] Using SSH public key: /home/ec2-user/.ssh/id_rsa.pub I0306 09:45:29.850021 20628 subnets.go:184] Assigned CIDR 172.20.32.0/19 to subnet us-east-2c I0306 09:45:31.118837 20628 dns.go:92] Private DNS: skipping DNS validation I0306 09:45:46.986963 20628 executor.go:91] Tasks: 73 done / 73 total; 0 can run I0306 09:45:46.987101 20628 dns.go:153] Pre-creating DNS records I0306 09:45:47.668392 20628 update_cluster.go:248] Exporting kubecfg for cluster kops has set your kubectl context to k8s.appbase Cluster is starting. It should be ready in a few minutes.

Voila! El clúster K8s ya debería estar funcionando.

5. Verificación de clúster: todas las instancias creadas por kops están en ASG (Grupos de Auto Scaling) . En caso de falla, las instancias ASG son verificadas y reconstruidas automáticamente.

Para cambiar la configuración del clúster, ejecute el siguiente comando:

kops edit cluster ${NAME}

Cada vez que cambie la configuración del clúster, deberá crear un clúster ejecutando el siguiente comando:

kops update cluster ${NAME} --yes

Verás algo como esto.

[ec2-user@ip-172-31-35-145 examples]$ kops update cluster --yes Using cluster from kubectl context: k8s.appbase I0216 05:09:06.074467 2158 dns.go:92] Private DNS: skipping DNS validation I0216 05:09:07.699380 2158 executor.go:91] Tasks: 73 done / 73 total; 0 can run I0216 05:09:07.699486 2158 dns.go:153] Pre-creating DNS records I0216 05:09:07.961703 2158 update_cluster.go:248] Exporting kubecfg for cluster kops has set your kubectl context to k8s.appbase Cluster changes have been applied to the cloud.

Verifica el clúster.

kops validate cluster

Asegúrese de que el clúster esté en funcionamiento.

Using cluster from kubectl context: k8s.appbase Validating cluster k8s.appbase INSTANCE GROUPS NAME ROLE MACHINETYPE MIN MAX SUBNETS master-us-east-2c Master t2.large 1 1 us-east-2c nodes Node t2.medium 3 3 us-east-2c NODE STATUS NAME ROLE READY ip-172-20-44-33.us-east-2.compute.internal master True ip-172-20-52-48.us-east-2.compute.internal node True ip-172-20-62-30.us-east-2.compute.internal node True ip-172-20-64-53.us-east-2.compute.internal node True Your cluster k8s.appbase is ready

¡Mira tus nuevos k8!

Con una simple llamada a la API de Kubernetes, puede verificar si la API está en línea y escuchando. Use kubectl para verificar los nodos.

kubectl get nodes

Esto le dará información sobre sus nodos y su estado actual.

[ec2-user@ip-172-31-35-145 elasticsearch]$ kubectl get nodes NAME STATUS ROLES AGE VERSION ip-172-20-44-33.us-east-2.compute.internal Ready master 1m v1.8.6 ip-172-20-52-48.us-east-2.compute.internal Ready node 3m v1.8.6 ip-172-20-62-30.us-east-2.compute.internal Ready node 2m v1.8.6 ip-172-20-64-53.us-east-2.compute.internal Ready node 4m v1.8.6

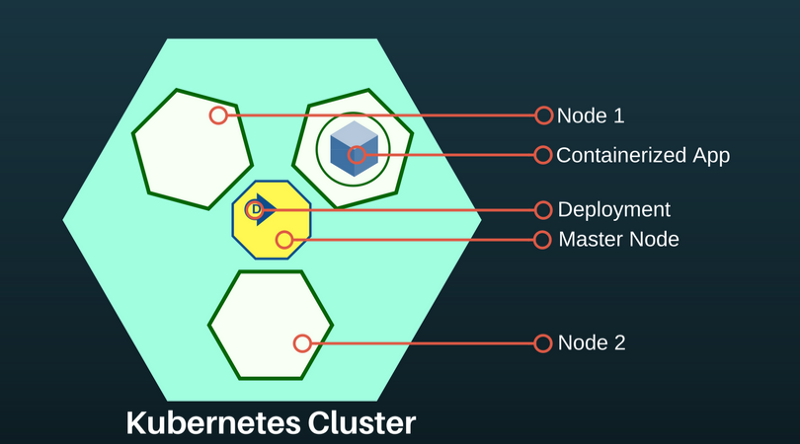

Un sub Kubernetes es una abstracción que representa un grupo de uno o más contenedores de aplicaciones (como Docker) y varios recursos compartidos para estos contenedores. Under se despliega en el nodo. Si necesita escalar la aplicación, agregue nodos al K8S implementado.

Para conocer los pods disponibles:

kubectl get pods

Este comando enumerará los hogares disponibles en el clúster.

[ec2-user@ip-172-31-35-145 ~]$ kubectl get pods NAME READY STATUS RESTARTS AGE es-5967f5d99c-5vcpb 1/1 Running 0 3h es-5967f5d99c-cqk88 1/1 Running 0 3h es-5967f5d99c-lp789 1/1 Running 0 3h

Implementación de Elasticsearch en el clúster K8S

Si no está familiarizado con Kubernetes, le recomiendo la capacitación en línea de k8s .

Por el momento, hemos creado en el clúster K8S: el nodo principal y dos nodos de agente. La función del nodo principal es transferir los comandos de implementación a las aplicaciones que se ejecutan en los pods de los agentes de nodo.

Las implementaciones de aplicaciones K8S son declarativas y se configuran a través de archivos JSON / YAML. Elija un controlador basado en el tipo de aplicación o sistema que está implementando. Como Elasticsearch es una aplicación con estado, utilizaremos el controlador StatefulSet.

6. Implementación a través de StatefulSet. StatefulSet gestiona pods según la especificación de contenedores idénticos. Gestiona el despliegue y la escala del conjunto de hogares y garantiza el orden y la unicidad de estos hogares. El controlador StatefulSet también facilita la asociación de la aplicación con el volumen persistente, lo cual es importante para Elasticsearch.

Cree un archivo llamado es-stateful set. yaml . Contendrá la especificación Elasticsearch. Siéntase libre de cambiar la configuración. Para obtener una lista de variables de entorno que se pueden pasar a su imagen de Elasticsearch, consulte aquí .

7. Servicios: Service Kubernetes: una abstracción que define un conjunto lógico de

LoadBalancer es un tipo especial de servicio que proporciona pods a redes externas y distribuye la carga. Lo usaremos para crear una dirección IP externa a través de la cual cualquiera puede contactar al clúster Elasticsearch. Utilizaremos este servicio para los nodos ES como una forma de descubrirnos.

Cree un archivo llamado es-svc.yaml . Edítelo y especifique el servicio de equilibrador de carga.

apiVersion: v1 #API Version of the resource kind: Service #Type of resource metadata: #Contains metadata of this resource. name: elasticsearch #Name of this resource labels: #Additional identifier to put on pods component: elasticsearch #puts component = elasticsearch spec: #Specifications of this resource type: LoadBalancer #type of service selector: #will distribute load on pods which component: elasticsearch #have label `component = elasticsearch` ports: #Port on which LoadBalancer will listen - name: http #Name given to port port: 9200 #Port number protocol: TCP #Protocol supported - name: transport #Name given to port port: 9300 #Port number protocol: TCP #Protocol supported

8. Crear una aplicación: eso es todo lo que necesitamos. Implemente nuestro clúster Elasticsearch en K8S utilizando los siguientes comandos.

kubectl create -f es-statefulset.yaml kubectl create -f es-svc.yaml

'Crear' es un comando universal para crear cualquier recurso en K8S.

Nuestro clúster Elasticsearch de 3 nodos (¿recuerda replicas = 3 en la configuración StatefulSet?) Se lanzará instantáneamente.

Podemos verificar los pods de Elasticsearch con este comando:

kubectl get pods

[ec2-user@ip-172-31-35-145 test]$ kubectl get pods,svc,deployment NAME READY STATUS RESTARTS AGE es-0 1/1 Running 0 23m es-1 1/1 Running 0 17m es-2 1/1 Running 0 23m

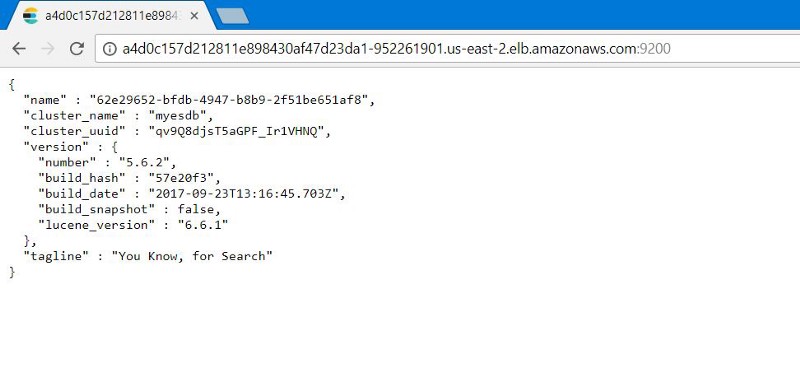

9. Prueba del clúster Elasticsearch: verifique si Elasticsearch está configurado correctamente y funciona. Obtenga la dirección IP externa para conectarse a Elasticsearch. Se ubicará en el servicio LoadBalancer que creamos. Use el siguiente comando para describir LoadBalancer :

kubectl describe service elasticsearch

[ec2-user@ip-172-31-35-145 examples]$ kubectl describe service elasticsearch Name: elasticsearch Namespace: default Labels: component=elasticsearch Annotations: <none> Selector: component=elasticsearch Type: LoadBalancer IP: 100.70.114.146 LoadBalancer Ingress: http://a4d0c157d212811e898430af47d23da1-952261901.us-east-2.elb.amazonaws.com Port: http 9200/TCP TargetPort: 9200/TCP NodePort: http 31358/TCP Endpoints: 100.96.4.28:9200 Port: transport 9300/TCP TargetPort: 9300/TCP NodePort: transport 31767/TCP Endpoints: 100.96.4.28:9300 Session Affinity: None External Traffic Policy: Cluster Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal EnsuringLoadBalancer 1m service-controller Ensuring load balancer Normal EnsuredLoadBalancer 1m service-controller Ensured load balancer [ec2-user@ip-172-31-35-145 examples]$

Tenga en cuenta el valor de LoadBalancer Ingress . Abra un navegador con un URI y número de sufijo del puerto externo Elasticsearch: 9200 . Verás esto:

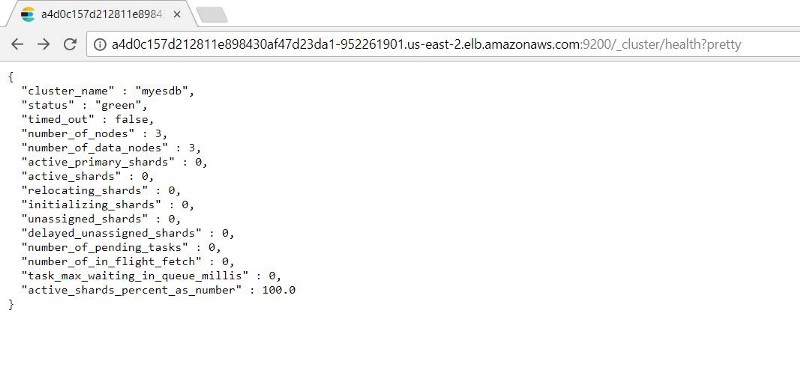

Puede verificar la funcionalidad de los nodos 9200/_cluster /health?pretty agregando: 9200/_cluster /health?pretty a la dirección IP externa.

10. Prueba de curación de Kubernetes: StatefulSets tiene la capacidad de almacenar el número especificado de réplicas. De esa manera, si un sub cae, StatefulSet comenzará un nuevo sub.

Lo probaremos simulando una falla (eliminando todos los pods en los que se ejecutan nuestras instancias de ES) para ver si nuestro clúster de ES puede realizar copias de seguridad automáticamente con datos intactos.

Como StatefulSet ejecuta un hogar a la vez, lleva tiempo restaurar todos los contenedores.

Vemos que después de la recuperación de los hogares, un registro indexado está disponible para nosotros en el estado anterior a la falla de ES.

Próximos pasos recomendados

Antes de usar esta configuración en producción, tenga en cuenta:

- Configurar copias de seguridad. Ayuda a recuperar datos perdidos. Este proceso se automatiza mejor.

- Configuración de autorización. Queremos proteger el clúster Elasticsearch. Configurar la autenticación o autorización básica basada en un token de medios proporcionará seguridad.

- Certificados TLS. Configure LetsEncrypt / otros proveedores TLS de certificados de mapeo de dominios personales para nuestro clúster ES y proteja todas las solicitudes que se le envíen.

Aunque el artículo no trata sobre eso, sepa: Kubernetes puede hacer todo esto.

Original: despliegue Elasticsearch con Kubernetes en AWS en 10 pasos