La histeria que rodea el futuro de la inteligencia artificial (IA) se ha apoderado del mundo. No faltan noticias sensacionales sobre cómo la IA puede

curar enfermedades ,

acelerar la innovación y

mejorar la

creatividad de una persona. Si lees los titulares de los medios, puedes decidir que ya estás viviendo en un futuro en el que la IA ha penetrado en todos los aspectos de la sociedad.

Aunque no se puede negar que la IA ha abierto un

amplio conjunto de oportunidades prometedoras para nosotros , también ha llevado a la aparición del pensamiento, que puede describirse como fe en la omnipotencia de la IA. Según esta filosofía, si hay suficientes datos, los algoritmos de aprendizaje automático

podrán resolver todos los problemas de la humanidad .

Pero esta idea tiene un gran problema. No es compatible con el progreso de la IA, sino que pone en peligro el valor de la inteligencia artificial, descuidando los principios de seguridad importantes y configurando a las personas para expectativas poco realistas sobre las capacidades de IA.

Creencia en la omnipotencia de la IA.

En solo unos pocos años, la creencia en la omnipotencia de la IA pasó de las conversaciones de los evangelistas tecnológicos de Silicon Valley a las mentes de los representantes gubernamentales y legisladores de todo el mundo. El péndulo pasó del concepto antiutópico de

IA que destruía a la

humanidad a la fe utópica en la

llegada de nuestro salvador algorítmico .

Ya vemos cómo los gobiernos brindan apoyo a los programas nacionales de desarrollo de IA y compiten en la

carrera tecnológica y retórica de

armamentos para obtener una ventaja en el sector de aprendizaje automático (MO) en auge. Por ejemplo, el gobierno británico ha

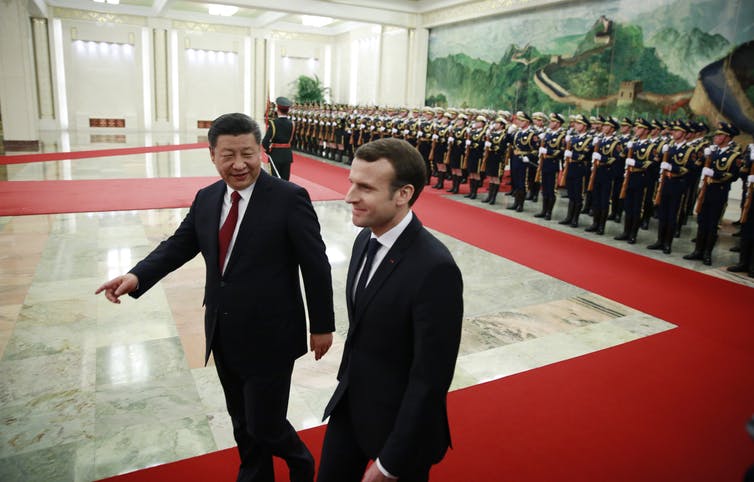

prometido invertir £ 300 millones en investigación de IA para convertirse en un líder en este campo. Fascinado por el potencial transformador de la IA, el presidente francés

Emmanuel Macron decidió

convertir a Francia en un centro internacional de IA . El gobierno chino está aumentando sus capacidades de inteligencia artificial con un

plan gubernamental para crear una industria china de inteligencia artificial de $ 150 mil millones para 2030. La creencia en la omnipotencia de la IA está ganando impulso y no va a rendirse.

Redes neuronales: más fácil decirlo que hacerlo

Si bien muchas declaraciones políticas promocionan los efectos transformadores de la inminente "

revolución de la IA ", generalmente subestiman la complejidad de introducir sistemas avanzados de MO en el mundo real.

Una de las variedades más prometedoras de tecnología de IA son

las redes neuronales . Esta forma de aprendizaje automático se basa en una imitación ejemplar de la estructura neural del cerebro humano, pero en una escala mucho más pequeña. Muchos productos basados en IA utilizan redes neuronales para extraer patrones y reglas de grandes cantidades de datos. Pero muchos políticos no entienden que simplemente agregando una red neuronal al problema, no necesariamente obtenemos su solución de inmediato. Entonces, al agregar una red neuronal a la democracia, no la haremos menos discriminada, más honesta o personalizada al instante.

Burocracia de datos desafiante

Los sistemas de IA requieren una gran cantidad de datos para funcionar, pero en el sector público generalmente no existe

una infraestructura de datos adecuada para soportar sistemas MO avanzados. La mayoría de los datos se almacenan en archivos fuera de línea. Un pequeño número de fuentes de datos digitalizados existentes se está ahogando en la burocracia. Los datos se distribuyen con mayor frecuencia en varios departamentos gubernamentales, cada uno de los cuales requiere un permiso especial para acceder. Entre otras cosas, el sector público generalmente no tiene suficientes talentos equipados con las habilidades técnicas necesarias para cosechar completamente los

beneficios de la IA .

Por estas razones, el

sensacionalismo relacionado con la IA recibe muchas críticas. Stuart Russell, profesor de ciencias de la computación en Berkeley, ha abogado durante mucho tiempo por un enfoque más realista, centrándose en las

aplicaciones más simples y cotidianas de la IA, en lugar de la hipotética toma del mundo por robots superinteligentes. Del mismo modo, el profesor de robótica del MIT,

Rodney Brooks, escribe que "casi todas las innovaciones en robótica e IA requieren mucho, mucho más tiempo para una implementación real de lo que imaginan los especialistas en este campo y todos los demás".

Uno de los muchos desafíos para implementar sistemas MO es que la IA es extremadamente

vulnerable a los ataques . Esto significa que una IA maliciosa puede atacar a otra IA para obligarla a emitir predicciones incorrectas o actuar de cierta manera. Muchos

investigadores han advertido que es imposible implementar AI inmediatamente sin preparar

estándares de seguridad y mecanismos de protección adecuados. Pero hasta ahora, el tema de la seguridad de la IA no ha recibido la debida atención.

El aprendizaje automático no es mágico

Si queremos cosechar los beneficios de la IA y minimizar los riesgos potenciales, debemos comenzar a reflexionar sobre cómo podemos aplicar de manera significativa las E / S a ciertas áreas del gobierno, los negocios y la sociedad. Y esto significa que debemos comenzar a discutir la

ética de la IA y la

desconfianza de muchas personas en MO.

Lo más importante es que necesitamos comprender las limitaciones de la IA y los puntos en los que las personas aún tienen que tomar el control. En lugar de dibujar una imagen poco realista de las capacidades de IA, debe dar un paso atrás y

separar las capacidades tecnológicas reales de AI de la magia.

Durante mucho tiempo,

Facebook creyó que problemas como la propagación de la desinformación y la incitación al odio podrían ser reconocidos algorítmicamente y detenidos. Pero bajo la presión de los legisladores, la compañía rápidamente prometió reemplazar sus algoritmos con un

ejército de 10,000 revisores humanos .

En medicina, también reconocen que la IA no puede considerarse la solución a todos los problemas. El programa

IBM Watson para Oncología fue una IA que se suponía que ayudaría a los médicos a combatir el cáncer. Y aunque fue diseñado para dar las mejores recomendaciones, a los expertos les

resulta difícil confiar en la máquina . Como resultado, el programa se

cerró en la mayoría de los hospitales, donde se llevaron a cabo sus pruebas.

Problemas similares surgen en el campo legislativo cuando

se usaron algoritmos en los tribunales de los Estados Unidos para pronunciar oraciones. Los algoritmos calcularon los valores de riesgo y dieron

recomendaciones a los jueces sobre las oraciones. Pero resultó que el sistema refuerza la discriminación racial estructural, después de lo cual fue abandonado.

Estos ejemplos muestran que no hay soluciones basadas en IA para todo. Usar la IA por la IA en sí misma no siempre es productivo o útil. No todos los problemas se resuelven mejor con la inteligencia artificial. Esta es la lección más importante para todos los que tienen la intención de aumentar las inversiones en programas gubernamentales de desarrollo de IA: todas las decisiones tienen un precio, y no todo lo que se puede automatizar necesita ser automatizado.