A finales de julio, Google celebró un hackathon cerrado en su oficina de Moscú (la que está frente al Kremlin). El tema fue el desarrollo de

acciones para un asistente de voz . Nosotros (

Just AI ) y una docena de otros equipos asistieron a este evento y sacamos no solo mochilas rojas con Google nishtyaks, sino también muchos conocimientos útiles sobre cómo crear interfaces de voz de alta calidad.

Durante un par de días de hackathon, todos intentaron desarrollar una aplicación de voz para un asistente, y alguien incluso publicó sus trabajos en el directorio de Google Actions. En el ejemplo de

nuestra aplicación, hablaremos sobre cómo crear la acción perfecta y la moderación de Google fácilmente.

¿Qué son las acciones en Google?

El Asistente de Google no solo puede ejecutar comandos de voz estándar. Puede crear sus propios complementos para él, lo que agregará funcionalidad al asistente. Google llama a estos complementos Acciones. Y en ruso esto se traduce como una "aplicación". Lea más sobre las acciones en Google

aquí .

¿Por qué crear tu propia acción?

Si está creando algún tipo de aplicación móvil, o si tiene un sitio web que ofrece a sus clientes algunos servicios útiles, entonces Google Assistant es otro canal genial para interactuar con su consumidor. ¡Después de todo, el asistente de voz está instalado en más de 500 millones de dispositivos! Y estos no son solo teléfonos inteligentes, sino también altavoces inteligentes, automóviles, relojes, televisores. Por lo tanto, si complementa su sitio web o aplicación con la habilidad de asistente de voz, es probable que encuentre nuevos clientes y usuarios, porque ya están hablando con el asistente en todos estos dispositivos. Y es más probable que les cuenten a sus amigos y conocidos sobre su servicio.

Cómo hacer la acción correctamente

Pero no piense que la aplicación para el asistente de voz es la misma que la del sitio. Esta es una experiencia de usuario (UX) fundamentalmente diferente, que ya tiene sus propias

pautas . El usuario habla con el asistente, por lo que su aplicación de asistente debe hablar al usuario en un lenguaje natural.

En el hackathon, utilizamos nuestro propio

diseñador de interfaz de conversación Aimylogic , en el que implementamos

nuestra primera aplicación para Google Assistant. Y en su ejemplo, ahora hablaremos sobre las lecciones más valiosas que aprendimos durante este tiempo.

Así es como se ve nuestra Acción final en el constructor Aimylogic.

Así es como se ve nuestra Acción final en el constructor Aimylogic.Lección número 1. La acción es voz

Asistente es una interfaz de voz. Los usuarios hablan con un asistente cuando es más conveniente decir, en lugar de abrir una aplicación o sitio.

Es absolutamente necesario comprender claramente por qué esta o aquella función de su servicio puede ser útil para el usuario a través de la interfaz de voz.

La voz es cuando necesitas hacerlo rápidamente, y a veces sin mirar la pantalla. La voz es cuando tanto la pregunta como la respuesta son cortas y claras la primera vez. Y si, por el bien de esto, el usuario no necesita hacer cinco clics, entonces seguramente aprovechará esta oportunidad.

En nuestra aplicación "Yoga para los ojos" existe tal función. Estos son en realidad ejercicios para la visión. La pantalla no debe distraer al usuario durante las clases. Por eso usamos la interfaz de voz.Lección número 2. La acción debería ser realmente útil

El asistente resuelve las tareas del usuario y no solo abre el navegador

No haga una aplicación auxiliar que no haga nada útil para el usuario. La acción puede ser muy simple y realizar solo una función de su servicio, pero debería ser completamente útil. De lo contrario, no tiene sentido.

El “Yoga para los ojos” es útil porque el usuario no necesita memorizar los ejercicios y su orden en diferentes complejos. Simplemente llama a una Acción, que lee el ejercicio uno por uno, y el usuario los ejecuta.Para hacer esto, seleccionamos varios complejos diferentes y colocamos los ejercicios en una hoja de cálculo regular de Google en diferentes hojas. Nuestra aplicación

utiliza esta tabla como una base de datos , selecciona una lista de ejercicios de la hoja deseada utilizando una

solicitud HTTP y luego los lee al usuario en un ciclo. Tan pronto como el usuario termina el siguiente ejercicio, dice "Vamos", y Action lee lo siguiente.

Lección número 3. La acción debe ser clara y predecible.

El asistente siempre explica lo que espera del usuario. Y el usuario siempre sabe lo que hará el asistente ahora.

La acción es un diálogo entre un asistente y un usuario. Cuando Action espera la próxima réplica, el usuario debe comprender lo que puede decir ahora y cómo responderá el asistente. De lo contrario, el asistente le parecerá al usuario inadecuado e incomprensible. Y no querrás usarlo.

La aplicación "Yoga para los ojos" explica breve pero claramente al usuario que debe decir "Vamos" cada vez que complete el próximo ejercicio. Después de eso, el asistente lee el siguiente ejercicio y espera nuevamente. Entonces el usuario entiende lo que debe hacer y lo que el asistente espera de él. El diálogo es simple pero sorprendentemente efectivo.En

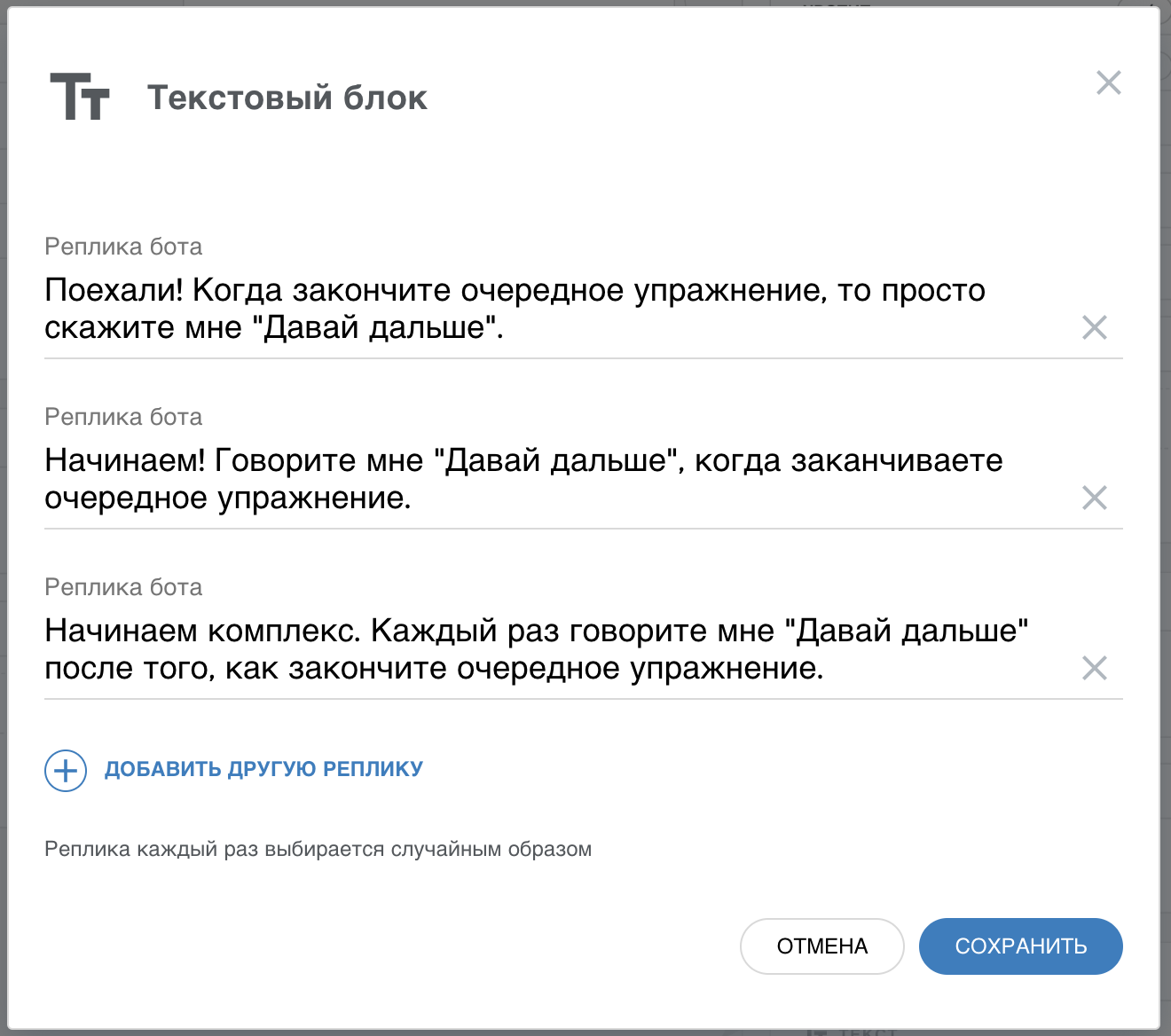

la sección Frases, agregamos sinónimos para la frase

"Vamos", para que el asistente responda adecuadamente a otras formulaciones. Y también agregamos botones con sugerencias, para que el usuario entienda por primera vez cómo funciona nuestra aplicación. También usamos variabilidad en las respuestas para no repetir la misma frase cada vez que el usuario comienza la lección.

Lección número 4. La acción debe hablar brevemente, pero naturalmente

Escuchar un texto largo de un robot es difícil. Y si el texto no suena natural, será aún peor.

Un asistente es un robot que quiere ser como un humano. En la práctica, esto se traduce en el hecho de que todas las réplicas del asistente deberían ser comprensibles, pero no deberían ser demasiado robóticas.

La síntesis de voz es una cosa complicada. El texto es un poco más largo y el usuario no lo escucha hasta el final. Y si el asistente es como un robot encriptará el mensaje en pocas palabras, entonces el usuario no lo entenderá en absoluto. Bueno, o necesitará más esfuerzo para entender lo que se requiere de él.

Así que

trabaje en sus respuestas . Hágalos cortos por un lado, y agrégueles un discurso conversacional por el otro.

Cuando seleccionamos conjuntos de ejercicios para ver desde Internet, vimos que son adecuados para el sitio y no para la interfaz interactiva. Por lo tanto, reelaboramos cada ejercicio para hacerlo más corto y más comprensible al mismo tiempo. Por ejemplo, en un sitio con ejercicios había dicho texto“Cierra los ojos. Luego frota tus palmas y únelas a tus ojos. Permanezca en esta posición hasta que sus manos emitan calor. Luego, sin abrir los ojos, frote las palmas hacia atrás y vuelva a colocarlas en sus ojos. Realiza el ejercicio tres veces ".

Lo cambiamos así“Cierra los ojos. Frota tus palmas con fuerza, llévalas a tus ojos y siéntate así por un minuto.

Y se rompió en dos líneas. Cuando el usuario dice

"Adelante", el asistente responderá,

"Ahora repita esto dos veces más" .

No puede simplemente copiar texto del sitio y usarlo para el asistente de voz . Necesitamos trabajar en los textos para que sean entendibles de oído.

Lección número 5. La acción debe interactuar con el usuario.

El asistente es un asistente personal. Debería ayudar al usuario a obtener el resultado, y no solo esperar las acciones de él.

En el sitio web o en la aplicación móvil, hacemos una interfaz con botones, listas, imágenes, etc. El asistente de voz también puede hacer todo esto, pero la principal diferencia es que habla y permite al usuario decir cualquier frase. Y esto cambia el enfoque de la interfaz de usuario.

Es posible que el usuario no escuche lo que le dijo el asistente. O no entiendo la primera vez. El asistente siempre debe estar listo para repetir si se le solicita. O reformule su respuesta si el usuario no la comprende. Ponte en la piel de un asistente. Estás hablando con otra persona y es importante que te entiendas, y no necesariamente la primera vez. No solo le muestra al interlocutor una hoja de papel con elementos del menú, sino que le ayuda a tomar una decisión.

En "Yoga para los ojos", lo hicimos para que el asistente siempre pueda repetir el ejercicio si el usuario lo solicita. Además, no solo muestre el texto del ejercicio nuevamente, sino que de manera coloquial, ofrezca hacer el ejercicio una vez más. Para hacer esto, usamos varias variaciones de la frase "Repetir" en el bloque Frases y establecemos otra burbuja con el texto antes de repetir el texto del ejercicio.

Lección número 6. La acción no tiene derecho a romper

El asistente debe responder adecuadamente incluso a frases de usuario incomprensibles

El asistente no tiene una "pantalla azul" o una ventana de error y un botón Aceptar. Y el usuario, a su vez, puede decir cualquier cosa, y nada de lo que se entrena su Acción. En este caso, la aplicación no debe "culpar" al usuario por "no decirlo". Es necesario responder de alguna manera a un comando incomprensible y una vez más explicarle al usuario lo que se espera de él.

Solo decir

"Oh, no te entiendo" no es suficiente. Esto es lo mismo que mostrar

la ventana

favorita de todos con un error. "¿Y qué debo hacer a continuación?" - preguntará el usuario.

"Yoga para los ojos" reacciona a frases incomprensibles de manera muy simple: aclara con el usuario si completó el ejercicio actual. Y si en este caso responde algo incomprensible, le preguntará si quiere terminar sus estudios. Para hacer esto, utilizamos la rama "Cualquier otra frase" en el bloque Frases para responder a comandos incomprensibles. Dio la casualidad de que si el usuario no está configurado para continuar la lección, el asistente de manera relajada lo invita a terminar. Presta más atención a las frases incomprensibles

Presta más atención a las frases incomprensibles . Después de todo, esta es la "función más utilizada" de su Acción.

Lección número 7. La acción debe reconocer al usuario

Un asistente es un asistente que conoce a su usuario y cambia su comportamiento con el tiempo.

Si el usuario lanzó su Acción por primera vez, entonces la aplicación debería hablar sobre para qué sirve y cómo usarla. Pero si el usuario llama a la aplicación todos los días, entonces no tiene sentido cargarla con la misma ayuda cada vez. Debe cambiar el comportamiento de la aplicación, como lo hace el asistente, que cada día conoce mejor a su usuario.

Aimylogic tiene información sobre cuánto tiempo hace que un usuario accedió a la aplicación la última vez. Yoga for the Eyes usa esto para saludar al usuario de manera diferente al inicio. Y dado que la carga debe realizarse todos los días, nuestra aplicación le recuerda esto si el usuario no ha iniciado la aplicación durante mucho tiempo. Para hacer esto, utilizamos el bloque de Condiciones, en el que verificamos cuánto tiempo hace que recibimos la solicitud anterior. Dependiendo de esto, la Acción pasa por diferentes ramas del diálogo.

Lección número 8. La acción debe terminar

Debe desconectarse del micrófono cuando la aplicación finalice su trabajo.

Si esto no se hace,

Google rechazará su solicitud cuando publique en el directorio. Por lo tanto, su aplicación debe tener al menos una rama del diálogo, lo que conduce a la salida de la aplicación. En este caso, debe "cerrar" el micrófono.

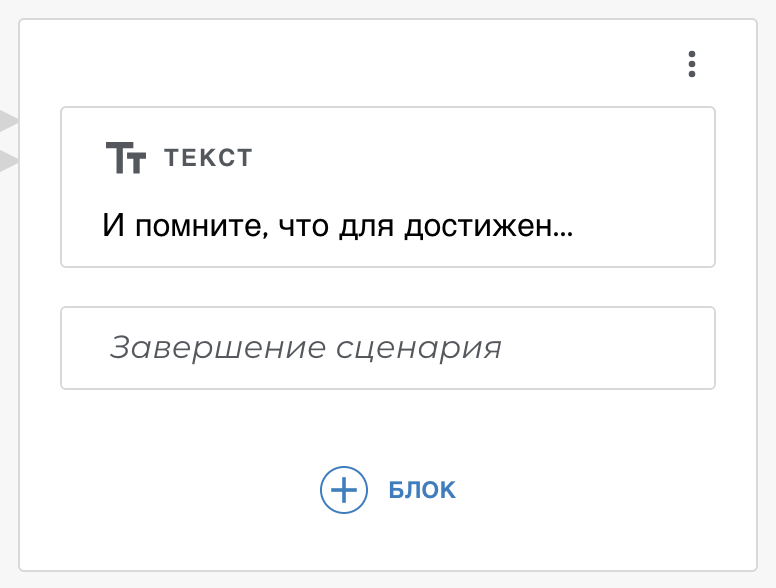

En "Yoga para los ojos", el usuario siempre puede decir "Suficiente" o "Estoy cansado" para completar las clases. Aimylogic tiene un bloque de finalización de script : lo usamos en nuestro cuadro de diálogo para despedirnos del usuario y completar nuestra Acción.

Y algunos consejos más de nosotros

No intente insertar todas las funciones de su servicio en la aplicación de voz para el asistente. El diálogo se trata de simplicidad, no de multifuncionalidad. Su acción solo puede realizar una función, pero es tan conveniente hacerlo que el usuario accederá a su aplicación exactamente todos los días.

No haga otra IVR de un asistente . El asistente no debe enumerar las posibles respuestas; esto no es natural. Cuando llegas al menú de voz, es una miseria. No es necesario que hagas lo mismo con un asistente. Él puede reconocer el habla, así que trabaja en tu guión para que sea natural. En el mismo Aimylogic hay todas las herramientas para esto, y al mismo tiempo, no tiene que escribir ningún código.

Los botones son pistas, no el elemento principal de la interfaz de usuario de voz . El asistente no es una interfaz de botón, sino una interfaz de voz. Por lo tanto, los botones solo deben usarse como pistas. Su diálogo debe ser tal que el usuario se las arregle sin botones.

Escriba una breve política de privacidad e incluya el nombre de su aplicación en ella. Sin esto, su aplicación no será moderada por Google. Mira

nuestra versión final , para no cometer los mismos errores que nosotros :)

En conclusión

El Asistente de Google recientemente comenzó a entender el ruso. Y todavía no hay mucho de lo que hay en Occidente (voz genial, altavoz inteligente, etc.). Pero todo esto es cuestión de tiempo. Pero ahora puede intentar desarrollar este nuevo canal para sus servicios, utilizando la experiencia existente compartida por Google y otros desarrolladores.

PS . Un poco más tarde publicaremos en nuestros tutoriales instrucciones paso a paso sobre cómo hacer Yoga para los ojos en Aimylogic. Ven a nuestro chat de Telegram para que los desarrolladores no se pierdan la publicación.

PS . Un poco más tarde publicaremos en nuestros tutoriales instrucciones paso a paso sobre cómo hacer Yoga para los ojos en Aimylogic. Ven a nuestro chat de Telegram para que los desarrolladores no se pierdan la publicación.