Hace unos meses, mientras trabajaban en el próximo proyecto, los muchachos de nuestro laboratorio de investigación estudiaron los discos NVMe y las soluciones de software para encontrar la mejor opción para ensamblar una matriz de software.

Los resultados de la prueba fueron sorprendentemente desalentadores: el enorme potencial de velocidad de los discos NVMe no se correlacionaba en absoluto con el rendimiento demostrado de los productos de software existentes.

A nuestros desarrolladores no les gustó. Y decidieron escribir su producto ... Un producto que a los vendedores posteriormente se les ocurrió alegremente el nombre RAIDIX ERA.

Hoy, más de una docena de compañías producen servidores adaptados para usar discos NVMe. El mercado de productos que respaldan y desarrollan esta tecnología tiene un enorme potencial. En el informe analítico de G2M, se presentan cifras bastante convincentes de que este protocolo de transferencia de datos dominará en un futuro próximo.

Gráfico del informe G2M

Gráfico del informe G2MActualmente, uno de los líderes en la producción de componentes NVMe es Intel. Fue en su equipo que realizamos pruebas para evaluar las capacidades de los productos de software existentes para administrar un hardware tan "innovador".

Junto con nuestro socio, Promobit (un fabricante de servidores y sistemas de almacenamiento de datos bajo la marca comercial BITBLAZE), organizamos las pruebas de las unidades NVMe de Intel y el software común para administrar dichos dispositivos. Las pruebas se llevaron a cabo según el método SNIA.

En este artículo compartiremos los números obtenidos durante las pruebas del sistema de hardware Intel NVMe, las matrices de software de MDRAID, Zvol sobre ZFS RAIDZ2 y, de hecho, nuestro nuevo desarrollo.

Configuración de hardware

Para la base de la plataforma de prueba, tomamos el sistema de servidor Intel Server System R2224WFTZS. Tiene 2 zócalos para instalar procesadores escalables Intel Xeon y 12 canales de memoria (24 DIMM en total) DDR 4 con una frecuencia de hasta 2666 MHz.

Puede encontrar más información sobre la plataforma del servidor

en el sitio web del fabricante .

Todas las unidades NVMe conectadas a través de 3

placas posteriores

F2U8X25S3PHS .

En total, tenemos 12 unidades NVMe INTEL SSDPD2MD800G4 con firmware CVEK6256004E1P0BGN en el sistema.

La plataforma del servidor estaba equipada con dos procesadores Intel® Xeon® Gold 6130 a 2,10 GHz con Hyper-Threading habilitado, lo que permite lanzar dos subprocesos desde cada núcleo. Por lo tanto, en la salida recibimos 64 hilos informáticos.

Preparación de la prueba

Todas las pruebas en este artículo se realizaron de acuerdo con la especificación de la metodología SNIA SSS PTSe v 1.1. Incluso, se realizó una preparación preliminar del almacenamiento para obtener un resultado estable y honesto.

SNIA permite al usuario establecer los parámetros para el número de subprocesos y la profundidad de la cola, por lo que configuramos 64/32, que tiene 64 subprocesos informáticos en 32 núcleos.

Cada prueba se realizó en 16 rondas para llevar el sistema a un nivel estable de indicadores y excluir valores aleatorios.

Antes de comenzar las pruebas, hicimos una preparación preliminar del sistema:

- Instalación de la versión del kernel 4.11 en CentOS 7.4.

- Apague C-STATES y P-STATES.

- Ejecute la utilidad tuned-adm y establezca el perfil de rendimiento de latencia.

Las pruebas de cada producto y artículo se llevaron a cabo en las siguientes etapas:

Preparación de dispositivos según la especificación SNIA (dependiente e independiente del tipo de carga).

- Prueba IOps en bloques de 4k, 8k, 16k, 32k, 64k, 128k, 1m con variaciones de combinaciones de lectura / escritura 0/100, 5/95, 35/65, 50/50, 65/35, 95/5, 100/0 .

- Pruebas de latencia con bloques de 4k, 8k, 16k con variaciones de combinaciones de lectura / escritura 0/100, 65/35 y 100/0. El número de hilos y la profundidad de la cola es 1-1. Los resultados se registran como los retrasos promedio y máximo.

- Prueba de rendimiento con bloques de 128k y 1M, en 64 líneas de 8 equipos.

Comenzamos probando el rendimiento, la latencia y el rendimiento de la plataforma de hardware. Esto nos permitió evaluar el potencial del equipo propuesto y compararlo con las capacidades de las soluciones de software aplicadas.

Prueba 1. Pruebas de hardware

Para empezar, decidimos ver de qué es capaz una unidad Intel DCM D3700 NVMe.

En la especificación, el fabricante declara los siguientes parámetros de rendimiento:

Lectura aleatoria (100% de alcance) 450,000 IOPS

Escritura aleatoria (alcance 100%) 88000 IOPS

Prueba 1.1 Una unidad NVMe. Prueba de IOPS

Resultado de rendimiento (IOps) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 84017.8 | 91393.8 | 117271,6 | 133059,4 | 175086.8 | 281131.2 | 390969.2 |

| 8k | 42602.6 | 45735.8 | 58980.2 | 67321.4 | 101357.2 | 171316.8 | 216551,4 |

| 16k | 21618.8 | 22834.8 | 29703,6 | 33821,2 | 52552,6 | 89731,2 | 108347 |

| 32k | 10929,4 | 11322 | 14787 | 16811 | 26577,6 | 47185,2 | 50670.8 |

| 64k | 5494,4 | 5671,6 | 7342,6 | 8285.8 | 13130.2 | 23884 | 27249.2 |

| 128k | 2748,4 | 2805,2 | 3617,8 | 4295,2 | 6506,6 | 11997,6 | 13631 |

| 1m | 351,6 | 354,8 | 451,2 | 684,8 | 830,2 | 1574,4 | 1702,8 |

Resultado de rendimiento (IOps) en forma gráfica. Lectura / Escritura Mix%.

En esta etapa, obtuvimos resultados que no llegan a los de fábrica. Lo más probable es que NUMA (el esquema de implementación de memoria de la computadora utilizado en sistemas multiprocesador, cuando el tiempo de acceso a la memoria está determinado por su ubicación en relación con el procesador) jugó su papel, pero por ahora no le prestaremos atención.

Prueba 1.2 Una unidad NVMe. Pruebas de retraso

Tiempo de respuesta promedio (ms) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,02719 | 0,072134 | 0,099402 |

| 8k | 0,029864 | 0,093092 | 0.121582 |

| 16k | 0,046726 | 0.137016 | 0.16405 |

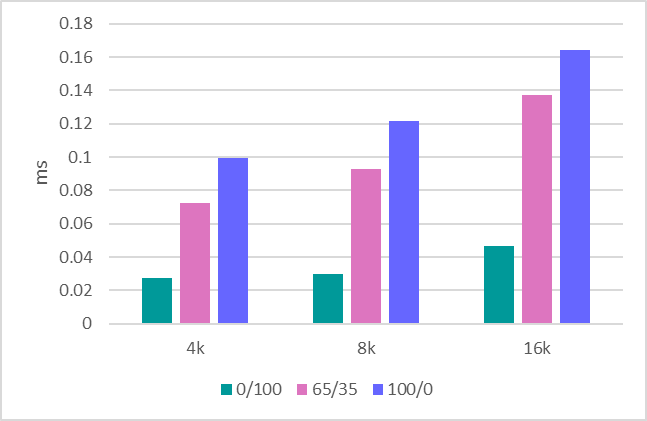

Tiempo de respuesta promedio (ms) en forma gráfica. Lectura / Escritura Mix%.

Tiempo máximo de respuesta

Tiempo máximo de respuesta (ms) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6,9856 | 4.7147 | 1.5098 |

| 8k | 7,0004 | 4.3118 | 1.4086 |

| 16k | 7.0068 | 4.6445 | 1.1064 |

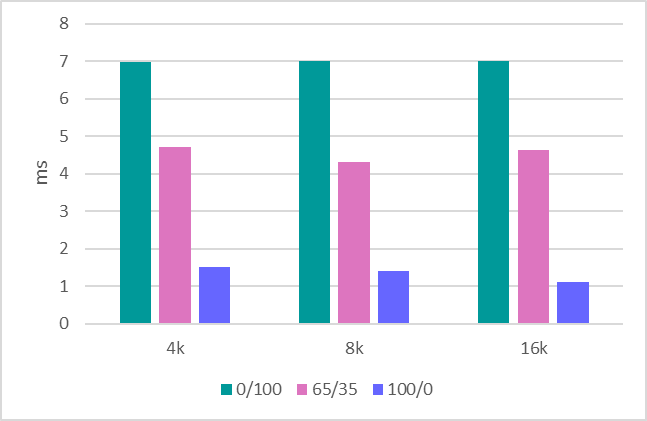

Tiempo máximo de respuesta (ms) en forma gráfica. Lectura / Escritura Mix%.

Prueba 1.3 Rendimiento

El último paso es evaluar el rendimiento. Aquí están los siguientes indicadores:

Grabación secuencial de 1 MB: 634 MBps.

Lectura secuencial de 1 MB: 1707 MBps.

Grabación secuencial de 128 Kb - 620 MBps.

Lectura secuencial de 128 Kb - 1704 MBps.

Después de tratar con una unidad, procedemos a evaluar toda la plataforma, que consta de 12 unidades.

Prueba 1.4 Sistema en 12 unidades. Prueba de IOPS

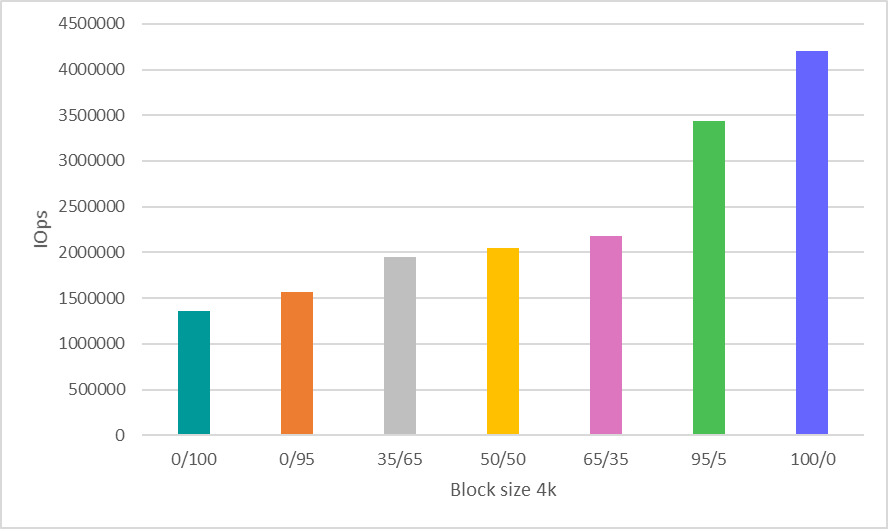

Aquí, se tomó una decisión decidida para ahorrar tiempo y mostrar resultados solo para trabajar con el bloque 4k, que es, con mucho, el escenario más común e indicativo para evaluar el rendimiento.

Resultado de rendimiento (IOps) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 1363078.6 | 1562345 | 1944105 | 2047612 | 2176476 | 3441311 | 4202364 |

Resultado de rendimiento (IOps) en forma gráfica. Lectura / Escritura Mix%.

Prueba del sistema 1.5 en 12 unidades. Pruebas de ancho de banda

Grabación secuencial de 1 MB: 8612 MBps.

Lectura secuencial de 1 MB: 20481 MBps.

Grabación secuencial de 128 Kb - 7500 MBps.

Lectura secuencial de 128 Kb - 20400 MBps.

Examinaremos nuevamente los indicadores de rendimiento de hardware obtenidos al final del artículo, comparándolos con los números del software probado en él.

Prueba 2: Prueba de MDRAID

Cuando hablamos de una matriz de software, MDRAID viene a la mente primero. Recuerde que este es el RAID de software base para Linux, que se distribuye de forma gratuita.

Veamos cómo MDRAID maneja el sistema de 12 discos propuesto con un nivel de matriz RAID 0. Todos entendemos que construir RAID 0 en 12 unidades requiere un coraje especial, pero ahora necesitamos este nivel de matriz para demostrar las capacidades máximas de esta solución.

Prueba 2.1 MDRAID. RAID 0. Prueba IOPS

Resultado de rendimiento (IOps) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 1010396 | 1049306.6 | 1312401.4 | 1459698.6 | 1932776.8 | 2692752.8 | 2963943.6 |

| 8k | 513627.8 | 527230.4 | 678140 | 771887.8 | 1146340.6 | 1894547.8 | 2526853,2 |

| 16k | 261087.4 | 263638.8 | 343679.2 | 392655.2 | 613912.8 | 1034843.2 | 1288299.6 |

| 32k | 131198.6 | 130947.4 | 170846.6 | 216039.4 | 309028.2 | 527920.6 | 644774.6 |

| 64k | 65083.4 | 65099.2 | 85257.2 | 131005.6 | 154839.8 | 268425 | 322739 |

| 128k | 32550.2 | 32718,2 | 43378,6 | 66999.8 | 78935.8 | 136869.8 | 161015.4 |

| 1m | 3802 | 3718,4 | 3233,4 | 3467,2 | 3546 | 6150.8 | 8193.2 |

Resultado de rendimiento (IOps) en forma gráfica. Lectura / Escritura Mix%.

Prueba 2.2 MDRAID. RAID 0. Pruebas de retraso

Tiempo de respuesta promedio (ms) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,03015 | 0,067541 | 0.102942 |

| 8k | 0,03281 | 0,082132 | 0.126008 |

| 16k | 0,050058 | 0.114278 | 0.170798 |

Tiempo de respuesta promedio (ms) en forma gráfica. Lectura / Escritura Mix%.

Tiempo máximo de respuesta

Tiempo máximo de respuesta (ms) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6.7042 | 3.7257 | 0,8568 |

| 8k | 6.5918 | 2.2601 | 0.9004 |

| 16k | 6.3466 | 2.7741 | 2.5678 |

Tiempo máximo de respuesta (ms) en forma gráfica. Lectura / Escritura Mix%.

Prueba 2.3 MDRAID. RAID 0. Pruebas de ancho de banda

Escritura secuencial de 1 MB: 7820 MBPS.

Lectura secuencial de 1 MB - 20418 MBPS.

Escritura secuencial de 128 Kb - 7622 MBPS.

Lectura secuencial de 128 Kb - 20,380 MBPS.

Prueba 2.4 MDRAID. RAID 6. Prueba IOPS

Veamos ahora qué tiene este sistema en el nivel RAID 6.

Opciones de creación de matriz

mdadm --create --verbose --chunk 16K / dev / md0 --level = 6 --raid-devices = 12 / dev / nvme0n1 / dev / nvme1n1 / dev / nvme2n1 / dev / nvme3n1 / dev / nvme4n1 / dev / nvme5n1 / dev / nvme8n1 / dev / nvme9n1 / dev / nvme10n1 / dev / nvme11n1 / dev / nvme6n1 / dev / nvme7n1

El volumen total de la matriz fue de

7450.87 GiB.

Comenzamos la prueba después de la inicialización preliminar de la matriz RAID.

Resultado de rendimiento (IOps) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 39907,6 | 42849 | 61609.8 | 78167.6 | 108594,6 | 641950.4 | 1902561.6 |

| 8k | 19474,4 | 20701,6 | 30316,4 | 39737.8 | 57051.6 | 394072.2 | 1875791.4 |

| 16k | 10371,4 | 10979,2 | 16022 | 20992.8 | 29955,6 | 225157,4 | 1267495.6 |

| 32k | 8505,6 | 8824.8 | 12896 | 16657.8 | 23823 | 173261.8 | 596857.8 |

| 64k | 5679,4 | 5931 | 8576,2 | 11137,2 | 15906,4 | 109469.6 | 320874.6 |

| 128k | 3976,8 | 4170,2 | 5974,2 | 7716.6 | 10996 | 68124.4 | 160453.2 |

| 1m | 768,8 | 811,2 | 1177,8 | 1515 | 2149,6 | 4880,4 | 5499 |

Resultado de rendimiento (IOps) en forma gráfica. Lectura / Escritura Mix%.

Prueba 2.5 MDRAID. RAID 6. Pruebas de retraso

Tiempo de respuesta promedio (ms) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0.193702 | 0.145565 | 0.10558 |

| 8k | 0.266582 | 0.186618 | 0.127142 |

| 16k | 0.426294 | 0.281667 | 0.169504 |

Tiempo de respuesta promedio (ms) en forma gráfica. Lectura / Escritura Mix%.

Tiempo máximo de respuesta

Tiempo máximo de respuesta (ms) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6.1306 | 4.5416 | 4.2322 |

| 8k | 6.2474 | 4.5197 | 3.5898 |

| 16k | 5.4074 | 5.5861 | 4.1404 |

Tiempo máximo de respuesta (ms) en forma gráfica. Lectura / Escritura Mix%.

Vale la pena señalar que aquí MDRAID mostró un muy buen nivel de demoras.

Prueba 2.6 MDRAID. RAID 6. Pruebas de ancho de banda

Escritura secuencial de 1 MB: 890 MBPS.

Lectura secuencial de 1 MB: 18800 MBPS.

Escritura secuencial de 128 Kb - 870 MBPS.

Lectura secuencial de 128 Kb - 10400 MBPS.

Prueba 3. Zvol sobre ZFS RAIDZ2

ZFS tiene una función de creación de RAID incorporada y un administrador de volumen incorporado que crea dispositivos de bloque virtual, que es utilizado por muchos fabricantes de almacenamiento. También aprovecharemos estas características creando un grupo con protección RAIDZ2 (análogo a RAID 6) y un volumen de bloque virtual encima.

Se compiló la versión 0.79 (ZFS). Opciones de creación de matriz y volumen:

ashift = 12 / compresión - off / dedup - off / recordsize = 1M / atime = off / cachefile = none / Type RAID = RAIDZ2

ZFS muestra muy buenos resultados con el grupo creado recientemente. Sin embargo, con el doblaje repetido, el rendimiento se reduce significativamente.

El enfoque SNIA es bueno porque le permite ver resultados reales al probar sistemas de archivos similares (el basado en ZFS) después de sobrescribirlos repetidamente.

Prueba 3.1 ZVOL (ZFS). RAIDZ2. Prueba de IOps

Resultado de rendimiento (IOps) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 15719,6 | 15147,2 | 14190,2 | 15592,4 | 17965,6 | 44832,2 | 76314.8 |

| 8k | 15536,2 | 14929,4 | 15140.8 | 16551 | 17898.8 | 44553,4 | 76187.4 |

| 16k | 16696,6 | 15937,2 | 15982.6 | 17350 | 18546,2 | 44895,4 | 75549,4 |

| 32k | 11859,6 | 10915 | 9698,2 | 10235,4 | 11265 | 26741.8 | 38167.2 |

| 64k | 7444 | 6440,2 | 6313,2 | 6578,2 | 7465,6 | 14145.8 | 19099 |

| 128k | 4425,4 | 3785,6 | 4059,8 | 3859,4 | 4246,4 | 7143,4 | 10052,6 |

| 1m | 772 | 730,2 | 779,6 | 784 | 824,4 | 995,8 | 1514,2 |

Resultado de rendimiento (IOps) en forma gráfica. Lectura / Escritura Mix%.

Las cifras de rendimiento son completamente impresionantes. Al mismo tiempo, el zvol puro (antes de reescribir) da resultados significativamente mejores (5-6 veces más). Aquí, la prueba mostró que después del primer doblaje, el rendimiento cae.

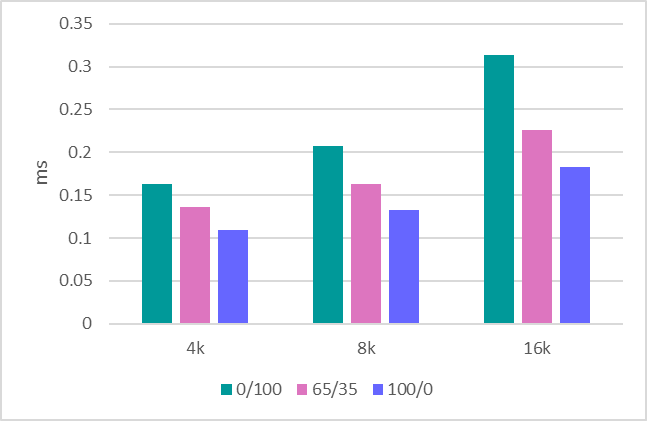

Prueba 3.2 ZVOL (ZFS). RAIDZ2. Pruebas de retraso

Tiempo de respuesta promedio (ms) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0.332824 | 0.255225 | 0.218354 |

| 8k | 0.3299 | 0.259013 | 0.225514 |

| 16k | 0.139738 | 0.180467 | 0.233332 |

Tiempo de respuesta promedio (ms) en forma gráfica. Lectura / Escritura Mix%.

Tiempo máximo de respuesta

Tiempo máximo de respuesta (ms) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 90,55 | 69,9718 | 84,4018 |

| 8k | 91,6214 | 86.6109 | 104.7368 |

| 16k | 108.2192 | 86.2194 | 105,658 |

Tiempo máximo de respuesta (ms) en forma gráfica. Lectura / Escritura Mix%.

Prueba 3.3 ZVOL (ZFS). RAIDZ2. Pruebas de ancho de banda

Escritura secuencial de 1 MB: 1150 MBPS.

Lectura secuencial de 1 MB: 5500 MBPS.

Escritura secuencial de 128 Kb - 1100 MBPS.

Lectura secuencial de 128 Kb - 5300 MBPS.

Prueba 4: RAIDIX ERA

Veamos ahora las pruebas de nuestro nuevo producto: RAIDIX ERA.

Creamos RAID6. Tamaño de la raya: 16kb. Una vez completada la inicialización, ejecute la prueba.

Resultado de rendimiento (IOps) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 354887 | 363830 | 486865.6 | 619349.4 | 921403.6 | 2202384.8 | 4073187.8 |

| 8k | 180914.8 | 185371 | 249927.2 | 320438.8 | 520188.4 | 1413096.4 | 2510729 |

| 16k | 92115.8 | 96327.2 | 130661.2 | 169247,4 | 275446,6 | 763307.4 | 1278465 |

| 32k | 59994.2 | 61765.2 | 83512.8 | 116562.2 | 167028.8 | 420216.4 | 640418.8 |

| 64k | 27660,4 | 28229.8 | 38687,6 | 56603.8 | 76976 | 214958.8 | 299137.8 |

| 128k | 14475.8 | 14730 | 20674,2 | 30358.8 | 40259 | 109258,2 | 160141.8 |

| 1m | 2892,8 | 3031,8 | 4032,8 | 6331,6 | 7514.8 | 15871 | 19078 |

Resultado de rendimiento (IOps) en forma gráfica. Lectura / Escritura Mix%.

Prueba 4.2 RAIDIX ERA. RAID 6. Pruebas de retraso

Tiempo de respuesta promedio (ms) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0.16334 | 0.136397 | 0,10958 |

| 8k | 0.207056 | 0.163325 | 0.132586 |

| 16k | 0.313774 | 0.225767 | 0.182928 |

Tiempo de respuesta promedio (ms) en forma gráfica. Lectura / Escritura Mix%.

Tiempo máximo de respuesta

Tiempo máximo de respuesta (ms) en forma de tabla. Lectura / Escritura Mix%.

| Tamaño del bloque | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 5.371 | 3.4244 | 3.5438 |

| 8k | 5.243 | 3.7415 | 3.5414 |

| 16k | 7.628 | 4.2891 | 4.0562 |

Tiempo máximo de respuesta (ms) en forma gráfica. Lectura / Escritura Mix%.

Los retrasos son similares a los que produce MDRAID. Pero para obtener conclusiones más precisas, se debe realizar una estimación de los retrasos bajo una carga más grave.

Prueba 4.3 RAIDIX ERA. RAID 6. Pruebas de ancho de banda

Escritura secuencial de 1 MB: 8160 MBPS.

Lectura secuencial de 1 MB - 19700 MBPS.

Escritura secuencial de 128 Kb - 6200 MBPS.

Lectura secuencial de 128 Kb - 19700 MBPS.

Conclusión

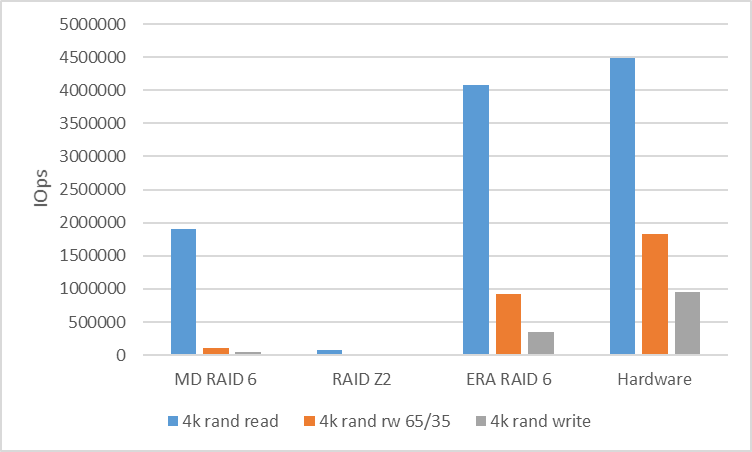

Como resultado de las pruebas, vale la pena comparar los números obtenidos de las soluciones de software con lo que nos proporciona la plataforma de hardware.

Para analizar el rendimiento de la carga aleatoria, compararemos la velocidad de RAID 6 (RAIDZ2) cuando trabaje con un bloque en 4k.

| MD RAID 6 | RAIDZ2 | RAIDIX ERA RAID 6 | Hardware |

|---|

| 4k R100% / W0% | 1902561 | 76314 | 4073187 | 4,494,142 |

| 4k R65% / W35% | 108594 | 17965 | 921403 | 1823432 |

| 4k R0% / W100% | 39907 | 15719 | 354887 | 958054 |

Para analizar el rendimiento de la carga en serie, analizaremos RAID 6 (RAIDZ2) con un bloque de 128k. Entre subprocesos, utilizamos un cambio de 10 GB para eliminar el impacto de caché y mostrar un rendimiento real.

| MD RAID 6 | RAIDZ2 | RAIDIX ERA RAID 6 | Hardware |

|---|

| Lectura de 128k seq | 10400 | 5300 | 19700 | 20,400 |

| 128k seq escribir | 870 | 1100 | 6200 | 7500 |

Cual es el resultado?

Las matrices RAID de software populares y asequibles para trabajar con dispositivos NVMe no pueden mostrar el rendimiento inherente al potencial del hardware.

Aquí hay una necesidad muy obvia de un software de control que pueda agitar la situación y mostrar que la simbiosis de control de programa con unidades NVMe puede ser muy productiva y flexible.

Al comprender esta solicitud, nuestra empresa creó un producto RAIDIX ERA, cuyo desarrollo se centró en resolver los siguientes problemas:

- Alto rendimiento de lectura y escritura (varios millones de IOps) en matrices con paridad en modo mixto.

- Rendimiento de transmisión de 30 GBps, incluso durante la conmutación por error y la recuperación.

- Soporte para niveles RAID 5, 6, 7.3.

- Inicialización y reconstrucción de fondo.

- Configuraciones flexibles para diferentes tipos de carga (lado del usuario).

Hoy, podemos decir que estas tareas se han completado y que el producto está listo para usar.

Al mismo tiempo, entendiendo el interés de muchas partes interesadas en tales tecnologías, nos preparamos para el lanzamiento no solo de una licencia paga, sino también

gratuita , que se puede utilizar por completo para resolver problemas tanto en unidades NVMe como SSD.

Lea más sobre RAIDIX ERA

en nuestro sitio web .

UPD Pruebas de ZFS reducidas con el tamaño de registro y volblocksize 8k

Tabla de opciones de ZFS

| Nombre | Propiedad | VALOR | FUENTE |

|---|

| tanque | registrar | 8K | local |

| tanque | compresión | fuera | por defecto |

| tanque | deducir | fuera | por defecto |

| tanque | suma de comprobación | fuera | local |

| tanque | volblocksize | - | - |

| tanque / incursión | registrar | - | - |

| tanque / incursión | compresión | fuera | local |

| tanque / incursión | deducir | fuera | por defecto |

| tanque / incursión | suma de comprobación | fuera | local |

| tanque / incursión | volblocksize | 8k | por defecto |

La grabación ha empeorado, la lectura es mejor.

Pero de todos modos, todos los resultados son significativamente peores que otras soluciones

| Tamaño del bloque | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 13703.8 | 14399,8 | 20903.8 | 25669 | 31610 | 66955.2 | 140849.8 |

| 8k | 15126 | 16227,2 | 22393,6 | 27720,2 | 34274.8 | 67008 | 139480.8 |

| 16k | 11111.2 | 11412.4 | 16980,8 | 20812.8 | 24680,2 | 48803,6 | 83710.4 |