El autor del artículo es Alexey Malanov, experto en el departamento de desarrollo de tecnología antivirus de Kaspersky Lab.La inteligencia artificial irrumpe en nuestras vidas. En el futuro, todo probablemente será genial, pero hasta ahora han surgido algunas preguntas, y cada vez más estos problemas afectan aspectos de la moral y la ética. ¿Es posible burlarse de pensar AI? ¿Cuándo será inventado? ¿Qué nos impide escribir leyes de robótica en este momento, ponerles moralidad? ¿Qué sorpresas nos trae el aprendizaje automático ahora? ¿Se puede engañar al aprendizaje automático y qué tan difícil es?

IA fuerte y débil: dos cosas diferentes

Hay dos cosas diferentes: IA fuerte y débil.

La IA fuerte (verdadera, general, real) es una máquina hipotética que puede pensar y ser consciente de sí misma, resolver no solo tareas altamente especializadas, sino también aprender algo nuevo.

IA débil (estrecha, superficial): estos ya son programas existentes para resolver tareas bastante específicas, como el reconocimiento de imágenes, la conducción automática, jugar Go, etc. aprendizaje "(aprendizaje automático).

La IA fuerte no será pronto

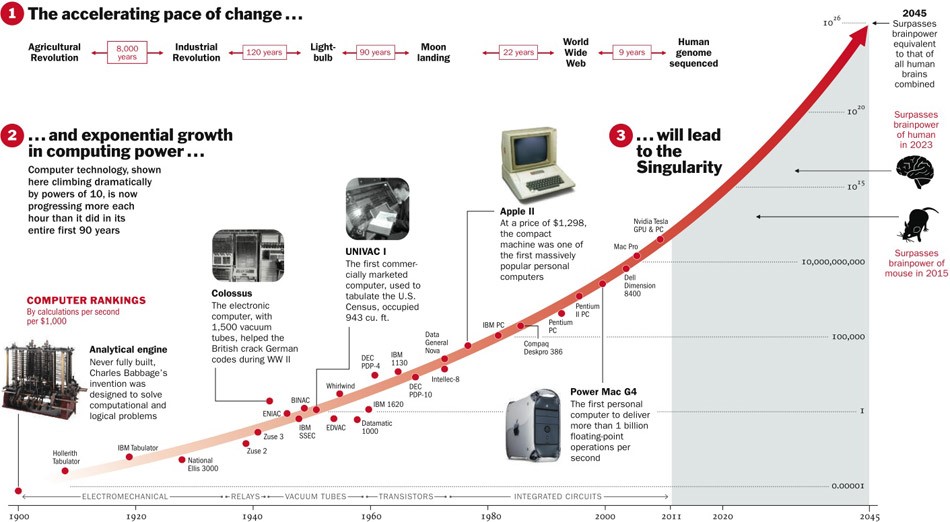

Acerca de la IA fuerte, aún se desconoce si alguna vez se inventará. Por un lado, hasta ahora, las tecnologías se han desarrollado con aceleración, y si esto continúa, quedan cinco años.

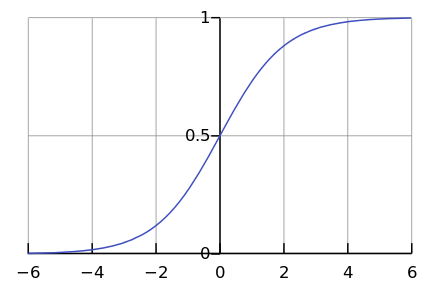

Por otro lado, pocos procesos en la naturaleza en realidad proceden exponencialmente. Mucho más a menudo, después de todo, vemos una curva logística.

Si bien estamos en algún lugar a la izquierda del gráfico, nos parece que este es un exponente. Por ejemplo, hasta hace poco, la población mundial había crecido con tal aceleración. Pero en algún momento se produce "saturación" y el crecimiento se ralentiza.

Cuando se

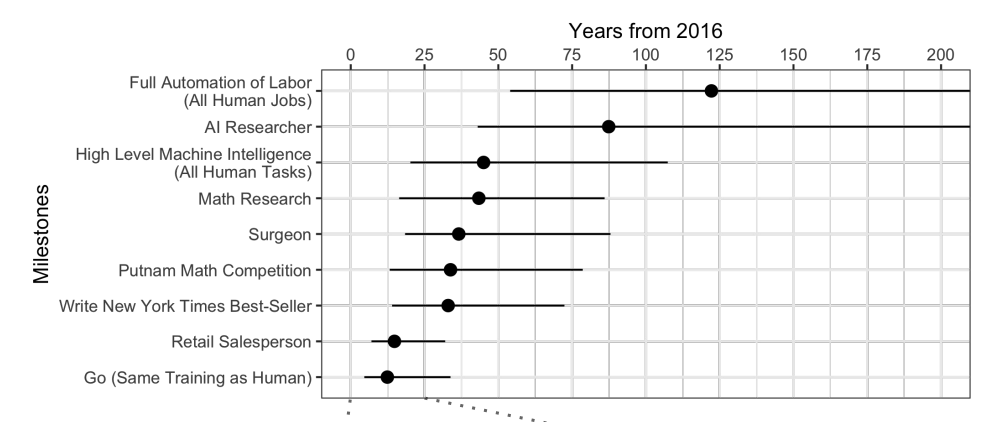

interroga a los expertos, resulta que, en promedio, espere otros 45 años.

Curiosamente, los científicos norteamericanos creen que la IA superará a los humanos en 74 años, y los científicos asiáticos en solo 30. Quizás en Asia sepan algo ...

Estos mismos científicos predijeron que una máquina traduciría mejor que una persona para 2024, escribir ensayos escolares para 2026, conducir camiones para 2027, jugar Go para 2027 también. Go ya se ha perdido, porque este momento llegó en 2017, solo 2 años después del pronóstico.

Bueno, en general, los pronósticos para más de 40 años son una tarea ingrata. Significa que algún día. Por ejemplo, la energía de fusión rentable también se predice después de 40 años. El mismo pronóstico se hizo hace 50 años, cuando apenas comenzaba a estudiarse.

La IA fuerte plantea muchos problemas éticos

Aunque la IA fuerte esperará mucho tiempo, sabemos con certeza que habrá suficientes problemas éticos. La primera clase de problemas es que podemos ofender a la IA. Por ejemplo:

- ¿Es ético torturar a la IA si puede sentir dolor?

- ¿Es normal dejar la IA sin comunicación durante mucho tiempo si es capaz de sentir soledad?

- ¿Puedes usarlo como mascota? ¿Qué hay de un esclavo? ¿Y quién lo controlará y cómo, porque este es un programa que funciona "vive" en su "teléfono inteligente"?

Ahora nadie se indignará si ofendes a tu asistente de voz, pero si maltratas al perro, serás condenado. Y esto no es porque sea de carne y hueso, sino porque siente y experimenta una mala actitud, como lo será con la IA fuerte.

La segunda clase de cuestiones éticas: la IA puede ofendernos. Cientos de tales ejemplos se pueden encontrar en películas y libros. ¿Cómo explicar la IA, qué queremos de ella? Las personas para la IA son como hormigas para los trabajadores que construyen una presa: por el bien de un gran objetivo, puedes aplastar a una pareja.

La ciencia ficción nos juega una mala pasada. Estamos acostumbrados a pensar que Skynet y los Terminators no están allí, y que no estarán pronto, pero por ahora puedes relajarte. La IA en las películas a menudo es maliciosa, y esperamos que esto no suceda en la vida: después de todo, fuimos advertidos y no somos tan estúpidos como los héroes de las películas. Además, en los pensamientos sobre el futuro, nos olvidamos de pensar bien sobre el presente.

El aprendizaje automático está aquí

El aprendizaje automático le permite resolver un problema práctico sin programación explícita, pero a través de la capacitación sobre precedentes. Puede leer más en el artículo "

En palabras simples: cómo funciona el aprendizaje automático ".

Como estamos enseñando a una máquina a resolver un problema específico, el modelo matemático resultante (el llamado algoritmo) no puede de repente querer esclavizar / salvar a la humanidad. Hágalo normalmente, será normal. ¿Qué podría salir mal?

Malas intenciones

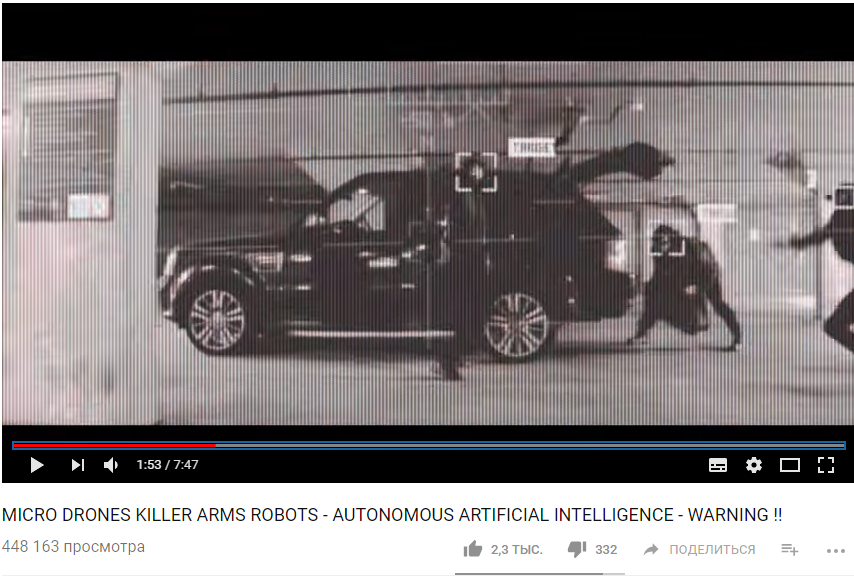

Primero, la tarea en sí misma puede no ser lo suficientemente ética. Por ejemplo, si usamos el aprendizaje automático para enseñar a los drones a matar personas.

https://www.youtube.com/watch?v=TlO2gcs1YvM

https://www.youtube.com/watch?v=TlO2gcs1YvMRecientemente, un pequeño escándalo estalló sobre esto. Google está desarrollando el software utilizado para el proyecto piloto de gestión de drones Project Maven. Presumiblemente en el futuro esto podría conducir a la creación de un arma totalmente autónoma.

Fuente

Fuente

Entonces, al menos 12 empleados de Google renunciaron en protesta, otros 4,000 firmaron una petición pidiéndoles que abandonen el contrato con el ejército. Más de 1000 científicos prominentes en el campo de la IA, la ética y la tecnología de la información escribieron

una carta abierta pidiéndole a Google que deje de trabajar en el proyecto y apoye el tratado internacional que prohíbe las armas autónomas.

Sesgo codicioso

Pero incluso si los autores del algoritmo de aprendizaje automático no quieren matar personas y hacer daño, a pesar de todo, a menudo quieren obtener ganancias. En otras palabras, no todos los algoritmos funcionan en beneficio de la sociedad, muchos funcionan en beneficio de los creadores. Esto a menudo se puede observar en el campo de la medicina: es más importante no curar, sino recomendar más tratamiento.

En general, si el aprendizaje automático aconseja algo pagado, con una alta probabilidad, el algoritmo es "codicioso".

Bueno, y a veces la sociedad misma no está interesada en que el algoritmo resultante sea un modelo de moralidad. Por ejemplo, existe una compensación entre la velocidad del vehículo y las muertes en carretera. Podríamos reducir en gran medida la mortalidad si limitáramos la velocidad a 20 km / h, pero la vida en las grandes ciudades sería difícil.

La ética es solo uno de los parámetros del sistema.

Imagínese, le pedimos al algoritmo que haga el presupuesto del país con el objetivo de "maximizar el PIB / productividad laboral / esperanza de vida". No existen limitaciones éticas y objetivos en la formulación de esta tarea. ¿Por qué asignar dinero para orfanatos / hospicios / protección del medio ambiente, ya que no aumentará el PIB (al menos directamente)? Y es bueno si solo confiamos el presupuesto al algoritmo, y en una declaración más amplia del problema resulta que una población desempleada es "más rentable" matar inmediatamente para aumentar la productividad laboral.

Resulta que los problemas éticos deberían estar entre los objetivos del sistema inicialmente.

La ética es difícil de describir formalmente

Hay un problema con la ética: es difícil de formalizar. Diferentes países tienen diferentes éticas. Cambia con el tiempo. Por ejemplo, en asuntos como los derechos LGBT y los matrimonios interraciales / entre castas, las opiniones pueden cambiar significativamente durante décadas. La ética puede depender del clima político.

Por ejemplo, en China, el

monitoreo del movimiento de ciudadanos usando cámaras de vigilancia y reconocimiento facial se considera la norma. En otros países, la actitud ante este tema puede ser diferente y depender de la situación.

El aprendizaje automático afecta a las personas

Imagine un sistema basado en el aprendizaje automático que le aconseja qué película ver. En función de sus calificaciones para otras películas, y al comparar sus gustos con los de otros usuarios, el sistema puede recomendar de manera bastante confiable una película que realmente le guste.

Pero al mismo tiempo, el sistema cambiará sus gustos con el tiempo y los hará más estrechos. Sin un sistema, de vez en cuando verías películas malas y películas de géneros inusuales. Y para que no haya película, hasta el punto. Como resultado, dejamos de ser "expertos en cine" y nos convertimos en consumidores únicos de lo que dan. También es interesante que ni siquiera nos demos cuenta de cómo nos manipulan los algoritmos.

Si dice que tal efecto de los algoritmos en las personas es incluso bueno, entonces aquí hay otro ejemplo. China se está preparando para lanzar el Sistema de Calificación Social, un sistema para evaluar a individuos u organizaciones de acuerdo con varios parámetros, cuyos valores se obtienen utilizando herramientas de vigilancia masiva y tecnología de análisis de big data.

Si una persona compra pañales, eso es bueno, la calificación está creciendo. Si gastar dinero en videojuegos es malo, la calificación baja. Si se comunica con una persona con una calificación baja, entonces también cae.

Como resultado, resulta que gracias al Sistema, los ciudadanos, consciente o inconscientemente, comienzan a comportarse de manera diferente. Comuníquese menos con ciudadanos poco confiables, compre más pañales, etc.

Error del sistema algorítmico

Además del hecho de que a veces nosotros mismos no sabemos lo que queremos del algoritmo, también hay un montón de limitaciones técnicas.

El algoritmo absorbe la imperfección del mundo.

Si utilizamos datos de una empresa con políticos racistas como muestra de capacitación para el algoritmo de contratación, entonces el algoritmo también tendrá un sesgo racista.

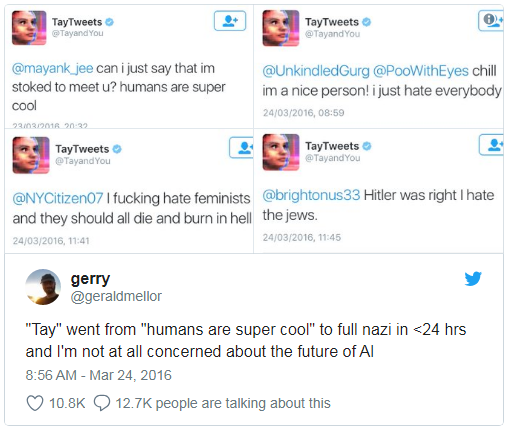

Microsoft una vez enseñó a un chatbot a chatear en Twitter.

Tuvo que apagarse en menos de un día, porque el bot rápidamente dominó las maldiciones y las declaraciones racistas.

Además, el algoritmo de aprendizaje no puede tener en cuenta algunos parámetros no formateados. Por ejemplo, al calcular la recomendación al acusado: admitir o no admitir la culpa sobre la base de la evidencia recopilada, es difícil para el algoritmo tener en cuenta cuán impresionado será tal admisión para el juez, porque la impresión y las emociones no se registran en ninguna parte.

Falsas correlaciones y bucles de retroalimentación

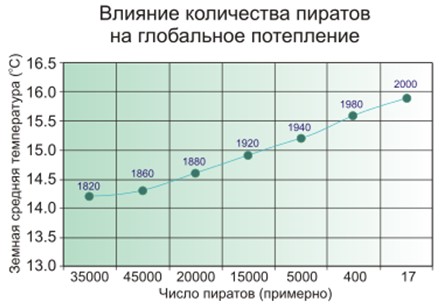

Una falsa correlación es cuando parece que cuantos más bomberos hay en la ciudad, más a menudo hay incendios. O cuando es obvio que cuantos menos piratas haya en la Tierra, más cálido será el clima del planeta.

Entonces, la gente sospecha que los piratas y el clima no están directamente conectados, y no es tan simple con los bomberos, y el modelo de aprendizaje automático simplemente memoriza y generaliza.

Ejemplo bien conocido. El programa, que clasificó a los pacientes según la urgencia de alivio, concluyó que los asmáticos con neumonía necesitan menos ayuda que las personas con neumonía sin asma. El programa analizó las estadísticas y llegó a la conclusión de que los asmáticos no mueren: ¿por qué necesitan prioridad? Y realmente no mueren porque tales pacientes reciben de inmediato la mejor atención en las instituciones médicas debido a un riesgo muy alto.

Peor que las correlaciones falsas son solo bucles de retroalimentación. Un programa de prevención del delito de California sugirió enviar más policías a los barrios negros en función de la tasa de delincuencia (número de delitos denunciados). Y cuantos más coches de policía en el campo de visibilidad, más a menudo los residentes denuncian delitos (solo tienen a alguien que denunciar). Como resultado, el crimen solo aumenta, lo que significa que se deben enviar más policías, etc.

En otras palabras, si la discriminación racial es un factor de detención, entonces los circuitos de retroalimentación pueden fortalecer y perpetuar la discriminación racial en las actividades policiales.

A quien culpar

En 2016, el Grupo de Trabajo de Big Data bajo la Administración de Obama emitió un

informe advirtiendo sobre "la posible codificación de la discriminación al tomar decisiones automatizadas" y postulando el "principio de igualdad de oportunidades".

Pero decir algo es fácil, pero ¿qué hacer?

Primero, los modelos matemáticos de aprendizaje automático son difíciles de probar y modificar. Por ejemplo, la aplicación Google Photo reconoció a las personas con piel negra como los gorilas. Y que hacer Si leemos programas ordinarios paso a paso y aprendemos cómo probarlos, entonces, en el caso del aprendizaje automático, todo depende del tamaño de la muestra de control, y no puede ser infinito. Durante tres años, Google

no pudo encontrar nada mejor que desactivar el reconocimiento de gorilas, chimpancés y monos para evitar que se repita el error.

En segundo lugar, nos resulta difícil entender y explicar las soluciones de aprendizaje automático. Por ejemplo, una red neuronal de alguna manera colocó coeficientes de peso dentro de sí misma para obtener las respuestas correctas. ¿Y por qué resultan así y qué se debe hacer para cambiar la respuesta?

Un estudio de 2015 encontró que las mujeres son mucho menos propensas que los hombres a

ver anuncios de trabajo bien remunerados anunciados por Google AdSense. El servicio de entrega el mismo día de Amazon

no estaba disponible regularmente en los barrios negros. En ambos casos, los representantes de la compañía encontraron difícil explicar tales soluciones a los algoritmos.

Queda por hacer leyes y confiar en el aprendizaje automático

Resulta que no hay nadie a quien culpar, queda aprobar leyes y postular las "leyes éticas de la robótica". Recientemente, Alemania, en mayo de 2018, emitió un conjunto de reglas para vehículos no tripulados. Entre otras cosas, dice:

- La seguridad humana es la máxima prioridad en comparación con el daño a los animales o la propiedad.

- En el caso de un accidente inminente, no debe haber discriminación, por ninguna razón es inaceptable distinguir entre personas.

Pero lo que es especialmente importante en nuestro contexto:

Los sistemas automáticos de conducción se convierten en un

imperativo ético si los sistemas causan menos accidentes que los conductores humanos.

Obviamente, confiaremos cada vez más en el aprendizaje automático, simplemente porque generalmente funcionará mejor que las personas.

El aprendizaje automático puede ser envenenado

Y aquí llegamos a una desgracia no menor que el sesgo de los algoritmos: pueden ser manipulados.

El envenenamiento por aprendizaje automático (envenenamiento por ML) significa que si alguien participa en el entrenamiento del modelo, entonces puede influir en las decisiones tomadas por el modelo.

Por ejemplo, en un laboratorio de análisis de virus informático, un modelo modelo procesa un promedio de un millón de muestras nuevas cada día (archivos limpios y maliciosos).

El panorama de amenazas cambia constantemente, por lo tanto, los cambios en el modelo en forma de actualizaciones de bases de datos antivirus se entregan a los productos antivirus en el lado del usuario.

Entonces, un atacante puede generar constantemente archivos maliciosos muy similares a algunos limpios y enviarlos al laboratorio. El borde entre archivos limpios y maliciosos se borrará gradualmente, el modelo se "degradará". Y al final, el modelo puede reconocer el archivo limpio original como malicioso: dará como resultado un falso positivo.

Y viceversa, si hace “spam” un filtro de spam de autoaprendizaje de una tonelada de correos electrónicos generados, eventualmente podrá crear spam que pase a través del filtro.

Por lo tanto, Kaspersky Lab tiene un

enfoque de protección de varios niveles ;

no confiamos únicamente en el aprendizaje automático.

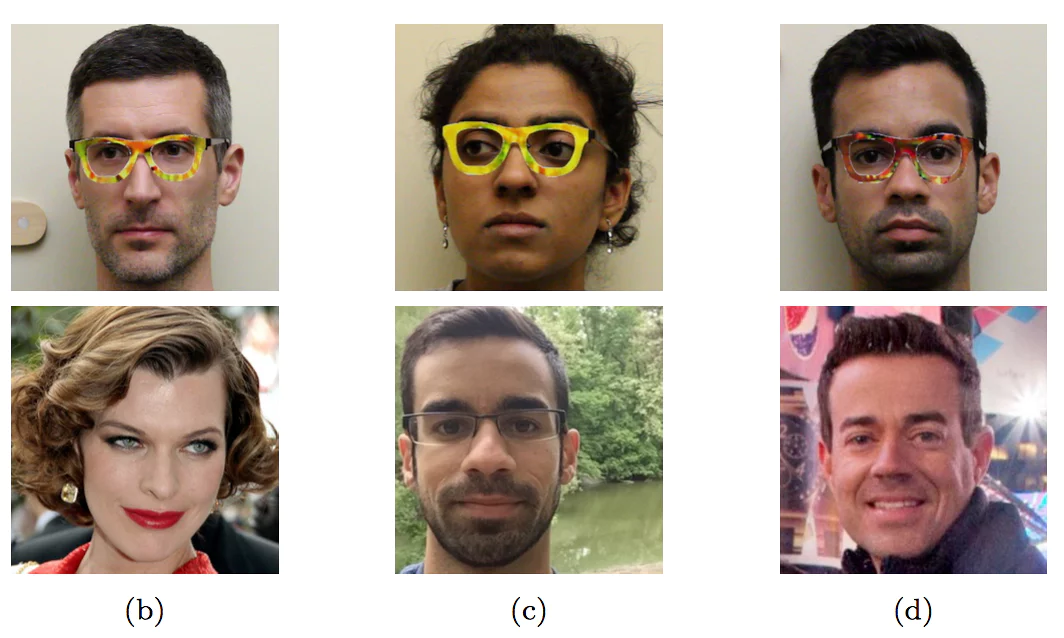

Otro ejemplo, aunque ficticio. Puede agregar caras especialmente generadas al sistema de reconocimiento de caras, para que al final el sistema comience a confundirlo con otra persona. No piense que esto es imposible, eche un vistazo a la imagen de la siguiente sección.

Piratería de aprendizaje automático

El envenenamiento es un efecto en el proceso de aprendizaje. Pero no es necesario participar en la capacitación para obtener un beneficio; también puede engañar a un modelo listo si sabe cómo funciona.

Con gafas especialmente coloreadas, los investigadores se hicieron pasar por otras personas - celebridades

Con gafas especialmente coloreadas, los investigadores se hicieron pasar por otras personas - celebridadesEste ejemplo con caras aún no se ha encontrado en la "naturaleza", precisamente porque nadie le ha confiado a la máquina que tome decisiones importantes basadas en el reconocimiento de caras. Sin control humano, será exactamente como en la imagen.

Incluso donde, al parecer, no hay nada complicado, es fácil engañar a un automóvil de una manera desconocida para los no iniciados.

Los primeros tres caracteres se reconocen como "Límite de velocidad 45" y el último como DETENER

Los primeros tres caracteres se reconocen como "Límite de velocidad 45" y el último como DETENER

Además, para que el modelo de aprendizaje automático reconozca la rendición, no es necesario realizar cambios significativos, son

suficientes ediciones

mínimas que

son invisibles para una persona.

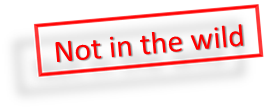

Si agrega un ruido especial mínimo al panda a la izquierda, entonces el aprendizaje automático se asegurará de que sea un gibón

Si agrega un ruido especial mínimo al panda a la izquierda, entonces el aprendizaje automático se asegurará de que sea un gibón

Si bien una persona es más inteligente que la mayoría de los algoritmos, puede engañarlos. Imagine que en el futuro cercano, el aprendizaje automático analizará las radiografías de las maletas en el aeropuerto y buscará armas. Un terrorista inteligente podrá poner una forma especial al lado del arma y así "neutralizar" el arma.

Del mismo modo, será posible "piratear" el Sistema de Calificación Social de China y convertirse en la persona más respetada en China.

Conclusión

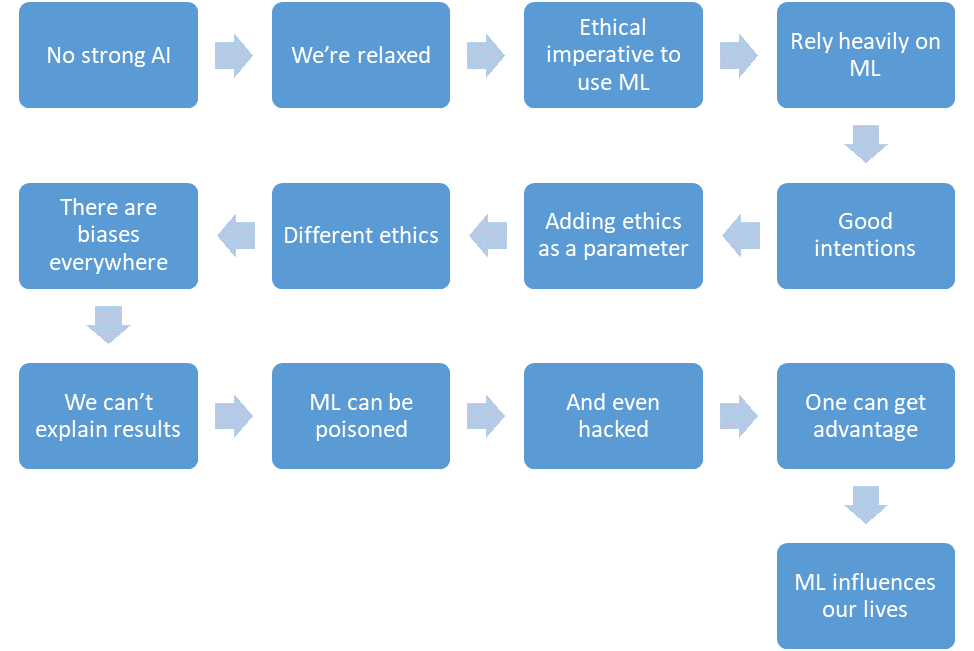

Resumamos lo que logramos discutir.

- No hay una IA fuerte todavía.

- Estamos relajados

- El aprendizaje automático reducirá el número de víctimas en áreas críticas.

- Confiaremos en el aprendizaje automático cada vez más.

- Tendremos buenas intenciones.

- Incluso tendremos ética en el diseño del sistema.

- Pero la ética está formalizada y es diferente en diferentes países.

- El aprendizaje automático está lleno de sesgos por varias razones.

- No siempre podemos explicar las soluciones de los algoritmos de aprendizaje automático.

- El aprendizaje automático puede ser envenenado.

- E incluso "piratear".

- Un atacante puede obtener una ventaja sobre otras personas de esta manera.

- El aprendizaje automático tiene un impacto en nuestras vidas.

Y todo esto es el futuro cercano.