En junio, un equipo de científicos de la Universidad de California en San Francisco

publicó un estudio que arroja luz sobre cómo las personas cambian su tono en su discurso.

Los resultados de este estudio pueden ser útiles para crear sintetizadores de voz que suenen naturales, con emociones y varias entonaciones.

Sobre el estudio, en nuestro artículo de hoy.

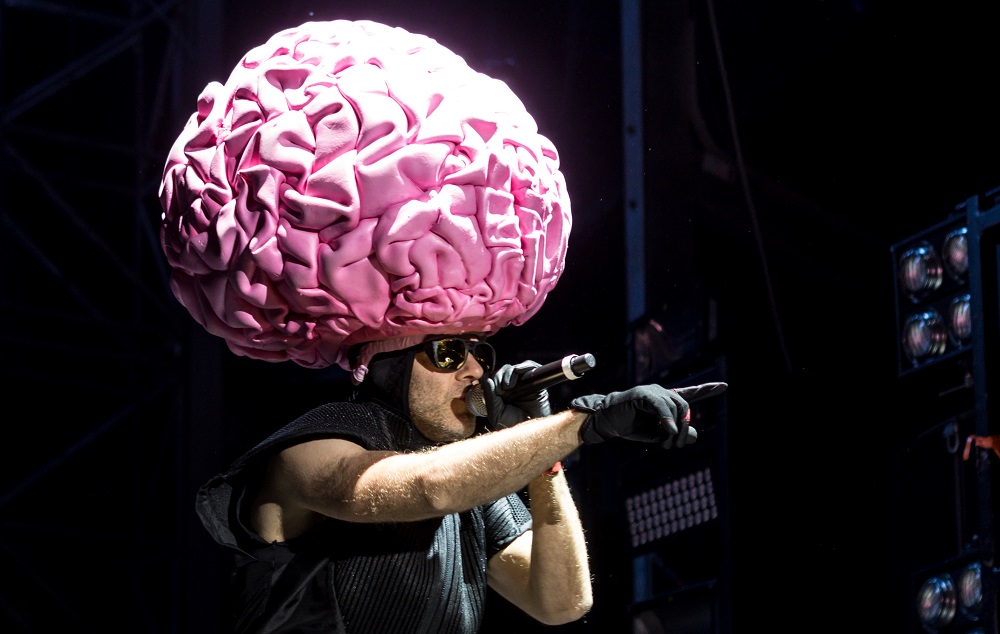

Foto Florian Koppe / CC

Foto Florian Koppe / CCComo fue el estudio

Un equipo de científicos de la Universidad de California ha realizado recientemente una serie de experimentos. Ella estudia la relación entre diferentes partes del cerebro y los órganos del habla. Los investigadores están tratando de descubrir qué sucede en el cerebro durante una conversación.

El trabajo en cuestión en el artículo se centra en el área que controla la laringe, incluso al momento de cambiar el tono.

El especialista líder en el estudio fue el neurocirujano Edward Chang (Edward Chang). Trabaja con pacientes con epilepsia: realiza operaciones que evitan las convulsiones. Chang monitorea la actividad cerebral de algunos de sus pacientes con la ayuda de un equipo especial.

El equipo reclutó voluntarios para su investigación de este grupo particular de pacientes. Los sensores conectados le permiten controlar su actividad neuronal durante los experimentos. Este método, conocido como

electrocorticografía , ayudó a los científicos a encontrar el área del cerebro responsable de los cambios de tono.

Se pidió a los participantes del estudio que repitieran la misma oración en voz alta, pero que enfatizaran cada vez en palabras diferentes. A partir de esto, el significado de la frase cambió. Al mismo tiempo, la frecuencia del tono fundamental también cambió: la frecuencia de las oscilaciones de las cuerdas vocales.

El equipo descubrió que las neuronas en un área del cerebro se activaron cuando el paciente elevó el tono. Esta área en la zona motora de la corteza es responsable de los músculos de la laringe. Los investigadores estimularon la electricidad a las neuronas en esta área, a lo que los músculos de la laringe respondieron con tensión, y algunos pacientes al mismo tiempo emitieron sonidos involuntarios.

Los participantes en el estudio también incluyeron una grabación de sus propios votos. Esto causó una respuesta de las neuronas. A partir de esto, los miembros del equipo concluyeron que esta área del cerebro participa no solo en cambiar la frecuencia del tono fundamental, sino también en la percepción del habla. Esto puede dar una idea de cómo el cerebro participa en la imitación del discurso de otra persona: le permite cambiar el tono y otras características para parodiar al interlocutor.

Útil en el desarrollo de sintetizadores de voz.

La periodista Robbie González de Wired

cree que los resultados del estudio pueden ser útiles en prótesis de la laringe y permitir que los pacientes sin voz "hablen" de manera más realista. Esto lo confirman los propios científicos.

Los sintetizadores del habla humana, por ejemplo, el

utilizado por Stephen Hawking, aún pueden reproducir palabras e interpretar la actividad neuronal. Sin embargo, no pueden enfatizar, como lo haría una persona con un aparato de habla saludable. Debido a esto, el discurso no suena natural, y no siempre está claro si el interlocutor hace una pregunta o hace una declaración.

Los científicos continúan explorando el área del cerebro que es responsable de cambiar la frecuencia del tono fundamental. Se supone que en el futuro, los sintetizadores de voz podrán analizar la actividad neuronal en esta área y, basándose en los datos obtenidos, construir oraciones de manera natural: enfatizar las palabras correctas con el tono, formular preguntas y declaraciones entonacionalmente dependiendo de lo que la persona quiera decir.

Otros estudios de modelos de habla

No hace mucho tiempo,

se realizó otro

estudio en el laboratorio de Edward Chang, que puede ayudar en el desarrollo de dispositivos formadores de voz. Los participantes leyeron cientos de oraciones, en cuyo sonido se utilizaron casi todas las construcciones fonéticas posibles del inglés americano. Y los científicos siguieron la actividad neuronal de los sujetos.

Foto PxHere / PD

Foto PxHere / PDEsta vez, la coarticulación se convirtió en un objeto de interés: cómo funcionan los órganos del tracto vocal (por ejemplo, labios y lengua) al pronunciar diferentes sonidos. Se prestó atención a las palabras en las que diferentes vocales siguen la misma consonante sólida. Al pronunciar tales palabras, los labios y la lengua a menudo funcionan de manera diferente, como resultado, nuestra percepción de los sonidos correspondientes también es diferente.

Los científicos no solo determinaron los grupos de neuronas responsables de los movimientos específicos de los órganos del tracto vocal, sino que también descubrieron que los centros del habla del cerebro coordinan los movimientos de los músculos de la lengua, la laringe y otros órganos del tracto vocal, dependiendo del contexto del habla, el orden en que se producen los sonidos. Sabemos que el lenguaje toma diferentes posiciones dependiendo de cuál será el próximo sonido en la palabra, y hay una gran cantidad de tales combinaciones de sonido; este es otro factor que hace que el sonido del habla humana sea natural.

El estudio de todas las variantes de coarticulación controladas por la actividad neuronal también desempeñará un papel en el desarrollo de tecnologías de síntesis del habla para personas que han perdido la capacidad de hablar, pero cuyas funciones neuronales se han conservado.

Para ayudar a las personas con discapacidad

, también se utilizan sistemas que funcionan según el principio opuesto: herramientas basadas en inteligencia artificial que ayudan a convertir el habla en texto. La presencia de entonaciones y acentos en el habla también es una dificultad para esta tecnología. Su presencia impide que los algoritmos de inteligencia artificial reconozcan palabras individuales.

Los empleados de Cisco, el Instituto de Física y Tecnología de Moscú y la Escuela Superior de Economía

presentaron recientemente

una posible solución al problema de convertir el inglés americano en texto. Su sistema utiliza la

base de pronunciación

CMUdict y las capacidades recurrentes de red neuronal. Su método consiste en una "limpieza" preliminar automática del discurso a partir de sonidos "extra". Por lo tanto, en términos de sonido, el habla está cerca del inglés americano hablado, sin "huellas" regionales o étnicas claramente expresadas.

El futuro de la investigación del habla.

En el futuro, el profesor Chang también

quiere explorar cómo funcionan los cerebros de las personas que hablan chino. En ellos, las variaciones en la frecuencia del tono fundamental pueden cambiar significativamente el significado de la palabra. Los científicos están interesados en cómo las personas perciben diferentes construcciones fonéticas en este caso.

Benjamin Dichter, uno de los colegas de Chang,

cree que el siguiente paso es ir más allá en la comprensión de la relación cerebro-laringe. El equipo ahora necesita aprender a adivinar qué frecuencia de tono elegirá el hablante analizando su actividad neuronal. Esta es la clave para crear un sintetizador de voz que suene natural.

Los científicos

creen que en el futuro cercano no será posible liberar dicho dispositivo, pero el estudio de Dichter y el equipo acercará la ciencia al momento en que el aparato de habla artificial aprenda a interpretar no solo palabras individuales, sino también entonaciones, lo que significa agregar emociones al habla.

Más interesante sobre el sonido: en nuestro canal Telegram :

¿Cómo sonó Star Wars?

¿Cómo sonó Star Wars?

Gadgets de audio de lujo

Gadgets de audio de lujo

Sonidos del mundo de las pesadillas.

Sonidos del mundo de las pesadillas.

Cine en los platos

Cine en los platos

Música en el trabajo

Música en el trabajo