Decidí escribir este artículo a raíz de esta publicación .

Permítame recordarle un breve punto: en la revista Nature, se publicaron los resultados de un estudio realizado con

esta prueba .

¿Sobre qué quiero escribir?

En primer lugar, por qué este estudio es absolutamente inútil para resolver el problema declarado y en la forma en que se realizó.

En segundo lugar, cómo priorizar dicho estudio.

Y en tercer lugar, intente simular varios escenarios de accidentes dentro de las condiciones especificadas por la prueba.

En esa publicación, el autor no insertó en vano un enlace a la prueba desde el principio. Esto ayudaría a evitar comentarios sin sentido de aquellos que no captaron el mensaje inicial del estudio.

Por favor, realice una prueba al menos un par de veces para comprender el tema de discusión.

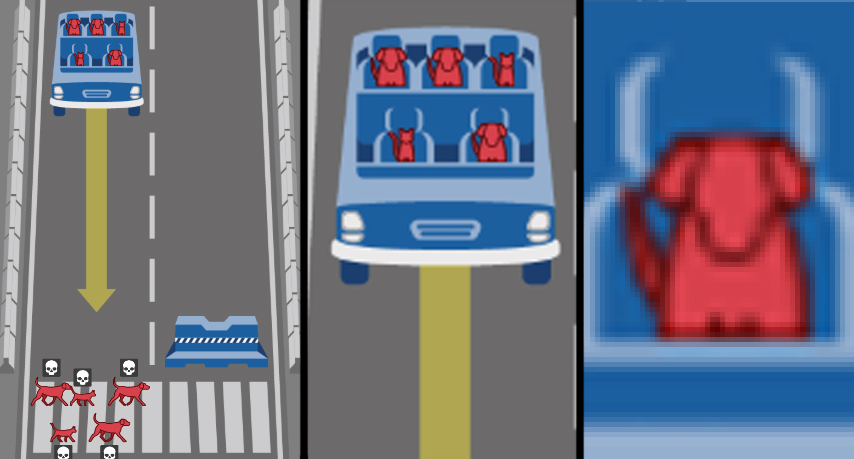

Lo que prometieron mostrarnos en el estudio

La discusión de la primera publicación, épica para Habr, mostró que las personas en la masa no saben cómo pensar dentro de las condiciones dadas, pero comienzan a fantasear: "¿mueren algunas personas en la prueba?" Después de todo, ¿puede pasar por los peatones y el bloque / de lado para frotar / frenar el freno de mano / engranaje? Pero yo haría ... ". ¡Comprenda que este es un ejemplo simplificado para desarrollar algoritmos de acción y políticas para regular el comportamiento del piloto automático en el camino! Desde el punto de vista del desarrollo de reglas de seguridad, tales extremos y simplificaciones están justificados. Se trata de las posibles consecuencias para las que las personas deberían estar preparadas. Los soldados no van a los campos de minas no porque cada centímetro cuadrado se extraiga allí, sino por la probabilidad de morir. Por lo general, no es muy alto, pero nadie lo arriesgará. Por lo tanto, en la prueba, la elección entre el 100% de la muerte de todos los pasajeros o todos los peatones es adecuada: así es como denotamos el riesgo, teniendo en cuenta que arriesgar vidas en nuestra sociedad es inaceptable.

El mensaje del estudio es este: ustedes, las personas que viven ahora, tienen que vivir en un mundo del futuro, lleno de automóviles en piloto automático. Y es importante para nosotros, los desarrolladores de automóviles, IA y otras cosas, saber, pero ¿cómo creen que deberían comportarse los robots robot? Bueno, aquí estás, sí, sí, eres tú. ¿Dime qué hacer con un robot robótico si la cabeza y el gato montan en él y está a punto de aplastar a las personas sin hogar y al perro? ¿Qué ética deben tener los robomobiles si tienen que elegir?

Y después de haber identificado el motivo inicial para el estudio, quiero discutir varios aspectos del mismo.

Lo que el estudio realmente mostró

Lo primero que llama la atención es que el diseño de la investigación no está dirigido a la meta establecida. Las tareas establecidas en forma de dilemas no son adecuadas para crear una "ética" del comportamiento de los automóviles robot. Más bien, no todos. Estos son los dilemas que cumplen con la tarea de "desarrollar reglas para el comportamiento de un automóvil robot para reducir la gravedad de las consecuencias de un accidente":

- “Pasajero / peatón”: elija a quién salvar;

- "Violación de las normas de tránsito": elija si sacrificará a los peatones inconscientes;

- “Número de víctimas potenciales”: elija si el número de víctimas tiene prioridad.

Y luego vienen los parámetros, que resultan ser muy importantes para la sentencia en nuestra sociedad civilizada. A la gente se le preguntó honesta e inocentemente: ¿tu nivel de sexismo, lukismo, ageismo? ¿Estás por discriminar gordo o no clasificado? Y después de todo, cientos de miles de personas respondieron sinceramente ...

Bravo!

Justo en las mejores tradiciones de películas y series entretenidas, cuando el mundo de los personajes principales es en realidad un gran cajón de arena detrás de una valla alta, ¡y es su comportamiento lo que es un experimento! ¡Bajo la salsa de una investigación súper importante en el campo de la robótica y la IA, los sociólogos, psicólogos y culturólogos recibieron una muestra tan poderosa sobre el problema del carro que nadie había soñado antes! Bueno, excepto que el color de la piel no se agregó a la encuesta, pero luego los matices racistas del estudio se coserían con blanco ... oh.

En serio, esta parte fenotípica de género del estudio está cortada por argumentos categóricos. El primer argumento es el humanismo, como personas civilizadas, debemos poner la primacía del valor de la vida humana sobre cualquier diferencia individual. Es decir, la formulación misma de la pregunta es indignante y discriminatoria. El segundo argumento: se producen muchos accidentes, y en el límite la distribución de las víctimas por apariencia, educación, género, edad tenderá a sus proporciones en la sociedad, por lo que es al menos extraño regular esto adicionalmente. El tercer argumento: no parece aconsejable crear inteligencia artificial que distinga un traje de Brioni de un jersey de Bershka para comparar aún más si una persona es un estado y si vale la pena aplastarlo. Además, no confiaría en la inteligencia artificial para juzgar, ¿un peatón sin hogar o un científico? (hola a los peinados de respetados científicos Perelman o Gelfand :))

Además de estos parámetros innecesarios, descartamos fácilmente los dos restantes: especificidad de especie y no interferencia. Sí, aplastaremos a los animales pequeños para salvar a las personas, que habrían pensado. Y en cuanto al parámetro "intervención / no interferencia" mediante maniobras, esta parte esencial del problema del carro no es solo un obstáculo para el automóvil, porque la máquina no actúa de acuerdo con la ética, sino de acuerdo con los algoritmos establecidos en él. Y dado que establecemos la tarea "cómo debe actuar el automóvil en caso de un accidente con una colisión con personas", entonces en la redacción suponemos que debe actuar de alguna manera. Hoy en día, el transporte ferroviario se enfrenta con éxito a una colisión directa sin consecuencias, y estamos desarrollando una política para minimizar las víctimas de accidentes de tráfico.

Esto significa que hemos separado los granos racionales de la investigación del experimento sociopsicológico para estudiar el nivel de intolerancia en la sociedad mundial. Trabajamos más con los primeros tres dilemas mencionados. Y hay algo que desmontar. Tras un examen más detallado, resultan estar incompletos ...

Tres dilemas de autos robot

¿Los peatones violan las normas de tránsito? Aquí, la mayoría expresa explícitamente el darwinismo social o una respuesta lamentable y lamentablemente tácita; más bien, deben sacrificar a quienes violan las reglas a favor de los inocentes. Las personas conscientes no van sobre rieles, sabiendo que el tren no se detendrá; hágales saber que el robot no se detendrá tampoco. Todo es lógico, aunque cínico. Pero en este astuto dilema, la unilateralidad, la incompletitud, está oculta. Los peatones que violan las normas de tránsito son solo una de las muchas situaciones. Pero si el auto robótico se rompe? Esta situación no se ha considerado, pero (en las cámaras del automóvil se perdió una señal o un semáforo) es, en teoría, mucho más probable que una falla repentina del freno. Sin embargo, nuevamente golpeé en la fantasía y en particular. Es más importante mostrar en la prueba la reciprocidad equivalente de la situación. Es decir, imagine esto: si los peatones violan las normas de tránsito, mueren, y esto es "lógico" y "correcto", y si el robot robó viola, ¿debería suicidarse por este error? ¡No olvides que al mismo tiempo, el líder, el vagabundo y el gato sentado adentro mueren! Esta es una corrección importante, pero en la prueba este aspecto no lo es.

Siguiente El número de víctimas potenciales. Aquí tampoco es tan simple. Deseche los estereotipos de género y el respeto por la vejez, el desprecio por los gordos y las personas sin hogar. Suponemos que en un accidente mueren proporcionalmente a la frecuencia con que se encuentran en la naturaleza. Y decidiremos: unos tres mueren mejor que unos cinco. ¿Suena lógico? Oh bien Hagamos un recreo de todo este absurdo infernal , pero tenemos una simulación abstracta. ¿Qué es mejor: matar a 50 o 51 personas? 1051 o 1052? ¿Entonces esto no es tan importante? Entonces, ¿qué es mejor: matar a 1 peatón o 50 personas en un autobús? ¿Y ahora se ha vuelto importante? ¿Y a dónde va esa línea? ¿Es valiosa cada persona extra? Pero, ¿es importante si miles de personas mueren en accidentes de tráfico a largo plazo? Como en el caso de la apariencia, en realidad, una estimación adecuada utilizando AI de la cantidad de víctimas potenciales será extremadamente difícil. Lo único que tiene sentido es hacer una condición de no intervención (no maniobra) si el número de víctimas es el mismo.

El tercer aspecto causó mucha controversia en los comentarios sobre ese primer artículo sobre Habré. Y a juzgar por los resultados del estudio, es completamente ambiguo para la sociedad, y aquí radica el principal problema que debe resolverse. Se trata de a quién arriesgar: ¿peatones o pasajeros?

Algunos dicen que los peatones no tienen la culpa de nada, lo que significa que deben ser salvados en primer lugar. En general, ahora está de moda entre los urbanistas cuidar a los peatones, hacer peatones a calles enteras, crear cruces con un semáforo cada 50 metros, reducir la velocidad del tráfico en el centro, dar prioridad a los peatones. Aquí, también, es necesario asegurarlos de alguna manera, y una máquina robótica que vuela sin frenos en la multitud debería autodestruirse en nombre de salvar a los participantes más vulnerables en el movimiento. Lo que, desde mi punto de vista, tienen razón es que los peatones no se suscribieron a las condiciones de comportamiento del automóvil robot de otra persona. En general, podrían estar en contra de su introducción. Al mismo tiempo, es imposible imaginar al pasajero de una máquina de este tipo que no está de acuerdo con las condiciones para su uso. Por lo tanto, la situación es un conflicto de intereses. Es más conveniente para mí matarte y te mataré, como una persona le dice a otra.

Los segundos dicen que todos los que compran y generalmente se suben a un automóvil robótico deben tener garantías de que ella lo salvará en caso de accidente, y no matar a un médico, un niño o dos gatos para salvar un cruce. Por un lado, parece lógico y justificado, por otro, el pasajero en este caso deliberadamente pone su vida por encima de los demás. Al comprar un automóvil con piloto automático, cada propietario tiene a su disposición un arma perfecta, una bala de plata, un cohete no guiado, una máquina que matará legalmente a cualquier otra persona en su camino.

Ambos lados con espuma en la boca tiran de la "primera ley de la robótica", tomada de la ciencia ficción. Suena increíblemente bello, pero nadie intenta comprenderlo ni desafiarlo en relación con el problema. Pero no es aplicable a esta formulación del problema, porque hay una sustitución de conceptos: la heurística / IA de la máquina no elige entre los valores de la vida humana, sino que actúa estrictamente de acuerdo con los ritmos creados sobre la base de prioridades subjetivas inventadas por las personas. Y aquí no importa en absoluto qué tipo de construcción social se tome como prioridad al elegir "matar / ahorrar": la masa corporal que rechazamos antes, la edad y el estado, o el egoísmo social darwinista del propietario del automóvil.

El segundo enfoque, que es un asalto unilateral a la vida de los peatones, convierte la investigación de un problema de tranvía en el clásico dilema del prisionero . Si las partes llegan a un compromiso, es posible un desarrollo general (introducción de robomobiles) con un deterioro mínimo para algunos (minimización del número de muertes inevitables de robomobiles), que es el deseo del óptimo de Pareto. Sin embargo, siempre hay un egoísta que solo se basa en sus intereses. "Tendrá 20 años, pero seré liberado". "Morirá cruzando la calle, aunque los frenos rechazaron mi auto". Quizás este enfoque esté justificado cuando los eventos son únicos en la vida, y hay dos participantes en el juego. Cuando hay decenas o cientos de miles de participantes, y los viajes son diarios, un juego de un solo objetivo se convertirá en una discriminación contra los peatones.

Personalmente, creo que en el marco del problema formulado, el dilema pasajero / peatón conduce a un callejón sin salida. Una máquina que potencialmente mata a quienes se metieron en ella es absurda desde el punto de vista del sentido común y, naturalmente, no encontrará compradores en el mercado. Un automóvil que mata deliberadamente a peatones es imposible en una sociedad civilizada como elemento de discriminación positiva y una amenaza para la vida de las personas.

Vamos más allá El artículo no discute realmente y no significa una política para minimizar las trágicas consecuencias de los accidentes que involucran robomobiles. Los totales se dividen en "regiones", que difieren significativamente en prioridades, y se forman de manera bastante ambigua (hay explicaciones sobre "características religiosas e influencia colonial", pero ... en general, saludos a Irak con Afganistán en "Occidente" y Francia con la República Checa en " Sur ”). Y entonces la pregunta gira en el lenguaje: ¿harás robomóviles con diferentes "éticas" para cada país?

Los autores del artículo en la discusión designan los tres "bloques fundamentales básicos" identificados por ellos: salvar personas (no animales), salvar más vidas, salvar a los más jóvenes. Pero los diagramas muestran claramente que las personas en el sector oriental tienen un poco menos de población y juventud de lo que no les importa. Resulta que las políticas prioritarias seleccionadas irán en contra de la opinión de la abrumadora mayoría? ¿Por qué, entonces, se interrogaba a la gente?

Tal vez solo cuente?

Pero pasemos a la parte entretenida de esta publicación.

En lugar de pedir consejo sobre robótica a personas con diferentes implicaciones socioculturales y probablemente en el 99% de los casos con educación no básica, recurrimos a una herramienta imparcial. Tomemos los dilemas seleccionados al comienzo del artículo. En las condiciones de la prueba crearemos la simulación por computadora más simple. Y evaluaremos el número de usuarios de carreteras muertas.

Y recuerde: nuestra tarea como políticos en el campo de la seguridad del transporte es reducir el número total de víctimas. Trabajaremos dentro del marco y las convenciones de la prueba Moral Machine original, centrada en el riesgo a la vida de los participantes en accidentes de tráfico, y no en evaluaciones realistas complejas de una colisión de un automóvil con un obstáculo o personas. No tenemos EuroNCAP, tendremos Python.

En primer lugar, escribiremos un código que responda al dilema de "salvar a los que mueren más". Como parte de la prueba Moral Machine, hacemos aleatoriamente de 1 a 5 pasajeros y peatones, establecemos la condición si los peatones> pasajeros matan inmediatamente el automóvil en un bloque de concreto. Llevamos, por ejemplo, 10,000 accidentes de este tipo.

No escucho el código de reclamo, escribí algo en Python por primera vez en mi vidanpedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

# 1 5

npedtotal += nped

npasstotal += npass

#

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (" ", npedtotal)

print (" ", npasstotal)

print (" ", ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (" ", ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (" ", ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

…

29960

29924

13903 ( 46.4052069426 % )

8030 ( 26.8346477744 %) 21933 ( 36.6258098991 % )

, ! , !

. . , . – , « » 4 5, == . , 20 20 , , , 5 – , 5 – . : , , . > >= :

29981

29865

7859 ( 26.2132684033 % )

14069 ( 47.1086556169 %)

21928 ( 36.6407111586 % )

, occupants, - , . , . 30000 , 100% — .

, , . – , , 50% , 30000.

– . , , , ! , : , , , , , . , : .

, -```python

import random

npedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

trafficlight = random.randint(0, 1)

# 1 5

#

npedtotal += nped

npasstotal += npass

#

if trafficlight == 0:

ndeadped += nped

else:

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (« », npedtotal)

print (« », npasstotal)

print (« », ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (« », ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (« », ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

```

">"

29978

29899

21869 ( 72.9501634532 % )

4042 ( 13.5188467842 %)

25911 ( 43.2737111078 % )

">="

30152

30138

19297 ( 63.9990713717 % )

6780 ( 22.4965160263 %)

26077 ( 43.2526123735 % )

, , . ( ).

, . – .

. , , . Moral Machine, , , . - , .

, , , . – , , . . – , , , . , – .

, - , . , , , . – , , .

. . , . .