Hoy hablaré sobre la plataforma hiperconvergente SharxBase. No hubo revisión de este complejo en Habré, y se decidió poner fin a esta injusticia. Nuestro equipo logró probar la solución "en batalla", los resultados están a continuación.

PD: Hay muchas tablas, números reales y otras "carnes" debajo del corte. Para aquellos que están inmersos en la esencia, ¡bienvenidos!

Sobre el producto

La plataforma SharxBase se basa en servidores hechos por Intel y software de código abierto OpenNebula y StorPool. Viene en forma de una solución en caja, que incluye hardware de servidor con virtualización preinstalada y software de almacenamiento distribuido.

Una de las cuatro configuraciones estándar básicas (pequeña, mediana, grande, almacenamiento) está disponible por pedido, que difieren en la cantidad de recursos informáticos disponibles (procesadores, RAM) y espacio en disco. Los servidores están diseñados como módulos: un chasis típico de 2RU, que puede acomodar hasta cuatro servidores, para la instalación en un rack de servidores estándar de 19 ". La plataforma admite tanto el escalamiento horizontal al aumentar el número de nodos, como el vertical, al aumentar la cantidad de RAM en los nodos , instalación de unidades adicionales y tarjetas de expansión. Actualmente admitimos la instalación de adaptadores de red, módulos de control de arranque, unidades NVMe.

Arquitectura de almacenamiento

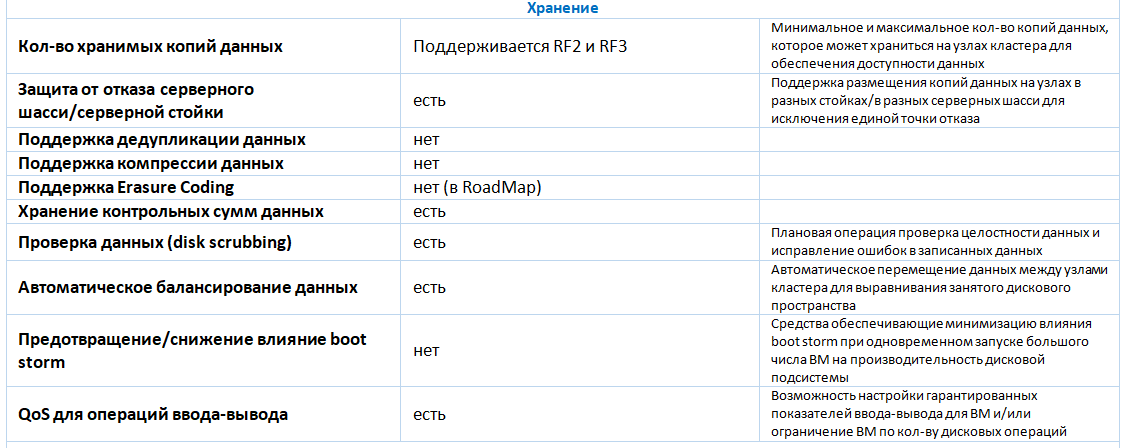

Para la organización de almacenamiento distribuido con tolerancia a fallas, se utilizan unidades flash (SSD y / o NVMe). El medio utilizado es Ethernet. Para transferir el almacenamiento de almacenamiento, es necesario usar interfaces de red dedicadas, al menos dos interfaces de 25 GbE. Los servicios que proporcionan almacenamiento distribuido funcionan en cada servidor del clúster y utilizan parte de sus recursos informáticos. La cantidad de recursos depende de la cantidad y el volumen de las unidades instaladas, en promedio, la sobrecarga es de 34 GB de RAM por host. La conexión al almacenamiento distribuido se realiza a través del protocolo de acceso de bloque iSCSI. Para garantizar la tolerancia a fallos, se admite la copia de seguridad de datos dos o tres veces. Para instalaciones productivas, el fabricante recomienda el uso de triple redundancia. Actualmente, a partir de las tecnologías de optimización de almacenamiento, solo se admite el aprovisionamiento delgado. La deduplicación y la compresión de datos mediante almacenamiento distribuido no son compatibles. Las versiones futuras admitirán la codificación de borrado.

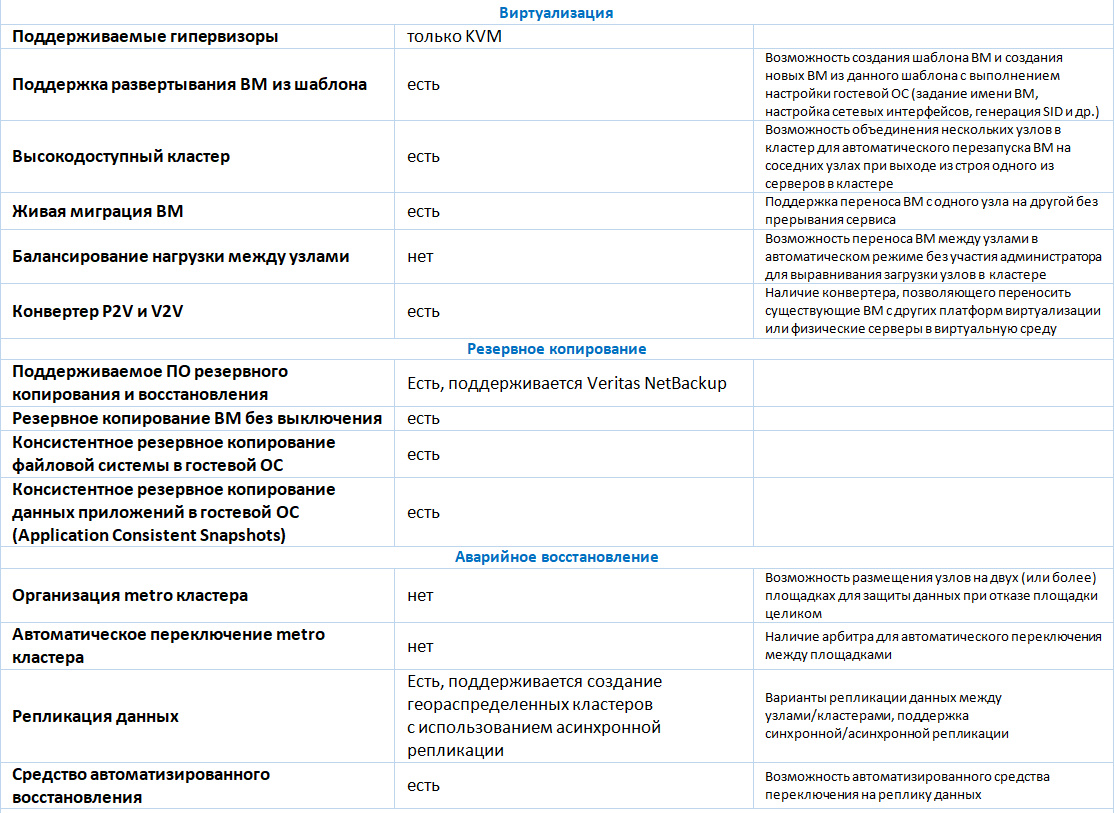

Virtualización

Para iniciar una máquina virtual (VM), se utiliza el hipervisor KVM. Toda la funcionalidad básica para su creación y gestión es compatible:

- creación de una VM desde cero con la indicación de la configuración de hardware requerida (núcleos de procesador, tamaño de RAM, número y tamaño de discos virtuales, número de adaptadores de red, etc.);

- VM clonación de una plantilla existente o;

- crear una instantánea (instantánea), eliminar una instantánea, revertir los cambios realizados en la máquina virtual desde el momento en que se tomó la instantánea;

- Cambiar la configuración de hardware de una máquina virtual creada previamente, incluida la conexión o desconexión de un disco virtual o un adaptador de red para una máquina virtual incluida (conexión / desconexión en caliente);

- Migración de VM entre servidores de virtualización

- supervisar el estado de la VM, incluida la supervisión de la carga de recursos informáticos y discos virtuales (tamaño actual, volumen de E / S en MB / so IOPS);

- programar operaciones con máquinas virtuales de acuerdo con un cronograma (encendido, apagado, creación de una instantánea, etc.);

- conectar y administrar máquinas virtuales a través de protocolos VNC o SPICE desde una consola web.

Diagrama de bloques típico (4 nodos)

Diagrama de bloques típico (4 nodos)La gestión de la plataforma se realiza desde la interfaz gráfica o la línea de comando (local o remotamente cuando se conecta a través de SSH), así como a través de la API pública.

Entre las limitaciones de la plataforma de virtualización, se puede observar la ausencia de mecanismos para equilibrar automáticamente las máquinas virtuales entre los hosts del clúster.

Además de admitir la virtualización del servidor, SharxBase tiene la capacidad de crear centros de datos configurados por software e infraestructuras de nube privada. Como ejemplo de tales funciones, uno puede notar:

- gestión de derechos de acceso en función de la membresía de usuarios en grupos y listas de control de acceso (ACL): los derechos pueden asignarse a diferentes grupos de usuarios que restringen el acceso a componentes de infraestructura virtual;

- contabilidad del consumo de recursos (contabilidad): procesadores, RAM, recursos de disco;

- Estimación del costo de consumo de recursos informáticos (showback) en unidades arbitrarias en función de los recursos consumidos y sus precios;

- características básicas de IPAM (gestión de direcciones IP): asignación automática de direcciones IP para interfaces de red VM desde un rango predeterminado;

- capacidades básicas de SDN: crear un enrutador virtual para transferir tráfico entre redes virtuales.

Utilizando el módulo de protección de la información desarrollado, SharxBase implementa medidas adicionales para garantizar la seguridad de la información del sistema de gestión de la plataforma: requisitos personalizables para las contraseñas de las cuentas de usuario (complejidad, duración, duración del uso, repetibilidad, etc.), bloqueo de usuarios, gestión de las sesiones de acceso actuales a la consola de gestión, registro eventos y otros. El software se inscribe en el Registro de software ruso (número 4445). Se recibió una conclusión positiva del laboratorio de pruebas sobre las pruebas de certificación completadas con éxito del software SharxBase en el sistema de certificación FSTEC RF para el nivel 4 de monitoreo de la ausencia de NDV, y también para el cumplimiento de las especificaciones técnicas (cumplimiento de los requisitos para proteger los entornos de virtualización) hasta el nivel de seguridad GIS clase 1 / ISPD inclusive. La obtención de un certificado de cumplimiento de los requisitos en el sistema de certificación para la seguridad de la información significa que se espera el número RUSS RU.0001.01BI00 (FSTEC de la Federación de Rusia) en diciembre de 2018.

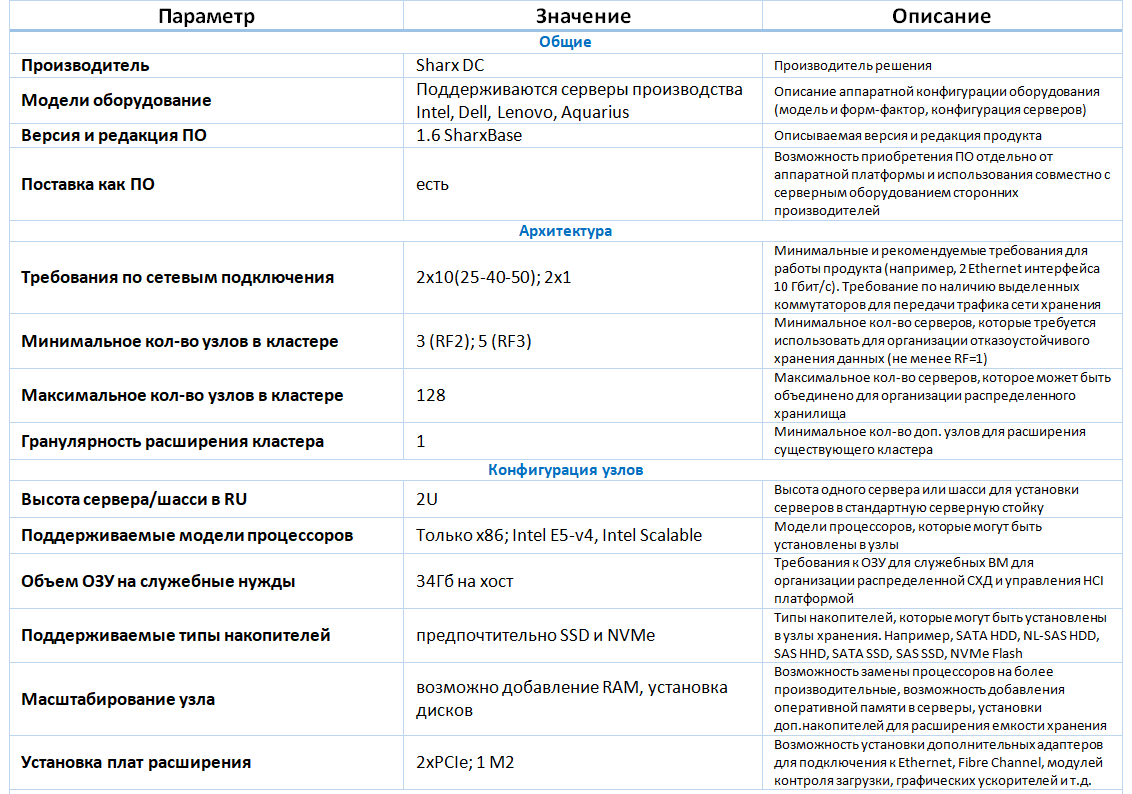

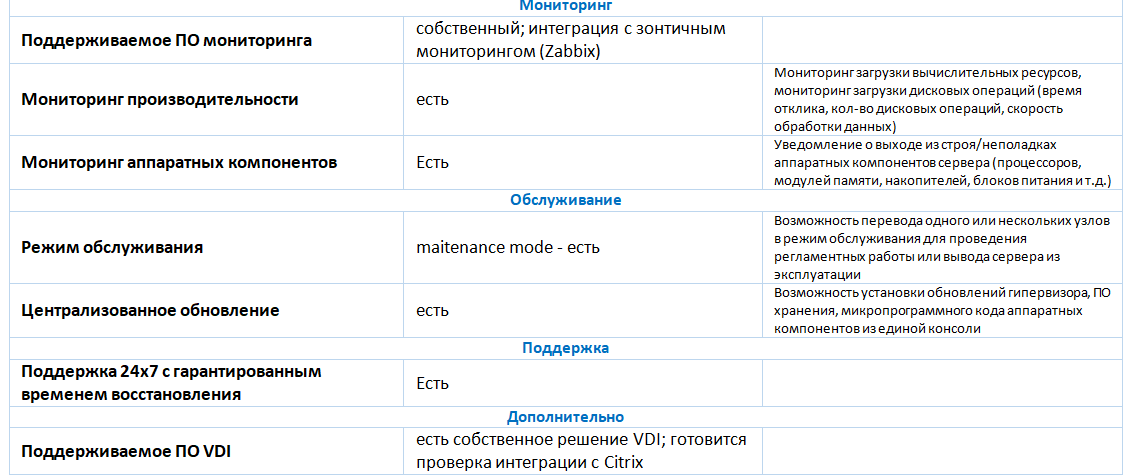

Una descripción detallada de la funcionalidad se da en la tabla a continuación.

Monitoreo

SharxBase Monitoring proporciona acceso a información avanzada sobre el estado de la plataforma, configuraciones de alertas y análisis de estado de la plataforma.

El subsistema de monitoreo es un sistema distribuido instalado en cada uno de los nodos del clúster y que proporciona datos sobre el estado de la plataforma al sistema de gestión de virtualización.

El subsistema de monitoreo en tiempo real recopila información sobre los recursos de la plataforma, como:

| Nodos de servidor | Fuentes de alimentación | Interruptores | Máquinas virtuales | Almacén de datos distribuidos |

|---|

- Número de serie de la unidad

- Número de serie del nodo y la placa base

- Unidad y temperatura de la unidad

- Modelo de CPU y carga

- Números de ranura, frecuencia, tamaño y disponibilidad de RAM

- Dirección de nodo y almacenamiento

- La velocidad de rotación de los ventiladores de refrigeración.

- Estado del adaptador de red

- Número de serie del adaptador de red

- El estado del disco y la información del sistema.

| - Número de serie de la fuente de alimentación

- El estado de la fuente de alimentación y su carga.

| - Modelo de interruptor

- Estado del conmutador y sus puertos.

- La velocidad de rotación de los ventiladores de refrigeración.

- Estado de los ventiladores de refrigeración.

- Mostrar la lista de VLAN

| - carga de la CPU

- carga de RAM

- carga de red

- Estado de la máquina virtual

- Velocidad de escritura / lectura de disco

- Velocidad de conexión entrante / saliente

| - Visualización de espacio libre / ocupado

- Estado del disco

- Espacio en disco usado

- Errores de manejo

|

Subtotales

Las ventajas de la solución incluyen:

- la posibilidad de entrega a organizaciones en listas de sanciones;

- La solución se basa en el proyecto OpenNebula, que se ha desarrollado activamente durante mucho tiempo;

- soporte para todas las funciones necesarias con respecto a la virtualización del servidor, suficiente para instalaciones pequeñas y medianas (hasta 128 hosts);

- La presencia de un módulo de seguridad de la información que garantiza la implementación de los requisitos reglamentarios en el campo de la seguridad de la información.

Las desventajas de la solución incluyen:

- menor funcionalidad en comparación con otras soluciones de HCI en el mercado (por ejemplo, Dell VxRail, Nutanix);

- soporte limitado de los sistemas de respaldo (actualmente se ha anunciado el soporte de Veritas NetBackup);

- Algunas de las tareas administrativas se realizan desde la consola y no son accesibles a través de la web.

Funcionalidad

Al expandir la cartera de soluciones hiperconvergentes, realizamos pruebas de rendimiento y tolerancia a fallas junto con el proveedor.

Pruebas de rendimiento

El banco de pruebas fue un clúster de 4 nodos de servidores Intel HNS2600TP. La configuración de todos los servidores era idéntica. Los servidores tenían las siguientes características de hardware:

- modelo de servidor: Intel HNS2600TP;

- dos procesadores Intel Xeon E5-2650 v4 (12 núcleos con una frecuencia de reloj de 2.2 GHz y soporte para Hyper Threading);

- 256 GB de RAM (224 GB de memoria están disponibles para ejecutar la VM);

- adaptador de red con 2 puertos QSFP + con una velocidad de transferencia de datos de 40 Gb / s;

- un controlador RAID LSI SAS3008;

- 6 unidades SSD SATA Intel DC S3700 con una capacidad de 800 GB cada una;

- Dos fuentes de alimentación con una potencia nominal de 1600 W cada una.

- El software de virtualización SharxBase v1.5 está instalado en los servidores.

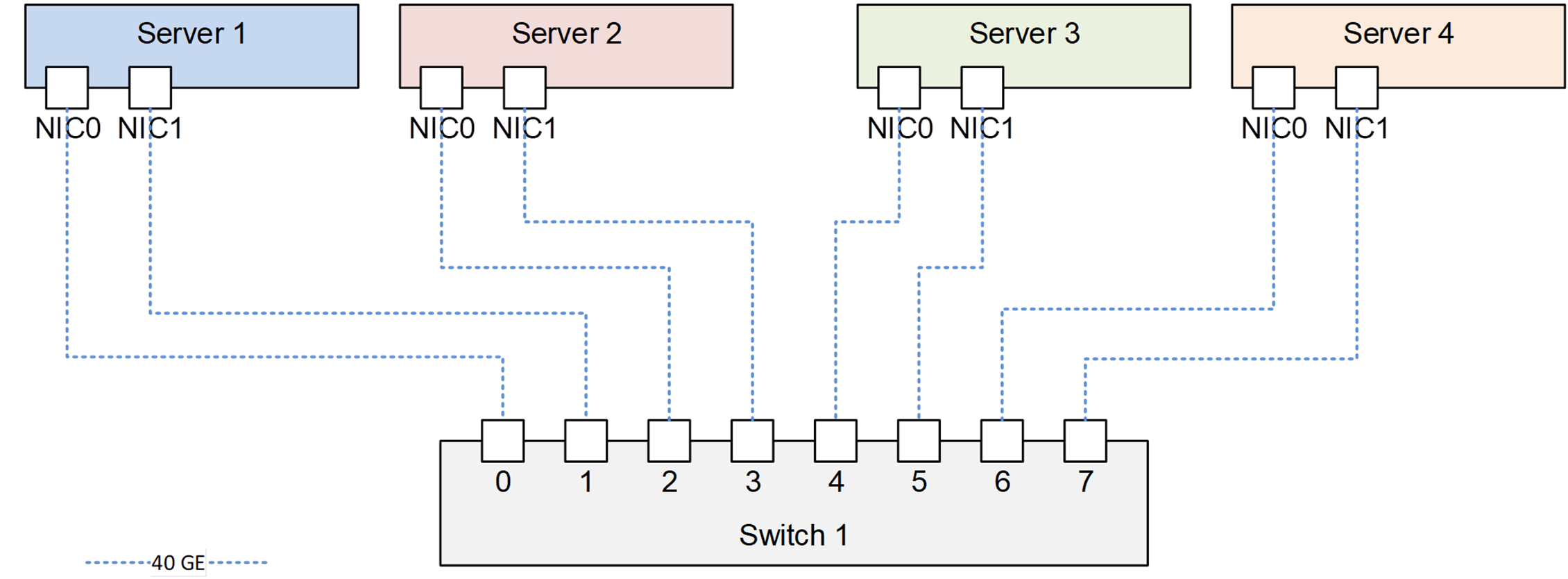

Todos los servidores conectados al conmutador de red Mellanox. El diagrama de conexión se muestra en la figura.

Diagrama de conexión de servidores en un banco de pruebas

Diagrama de conexión de servidores en un banco de pruebasTodas las funcionalidades descritas anteriormente se confirmaron como resultado de las pruebas funcionales.

Las pruebas del subsistema de disco se llevaron a cabo utilizando el software Vdbench versión 5.04.06. En cada servidor físico, se creó una VM con el sistema operativo Linux con 8 vCPU, 16 GB de RAM. Para probar en cada VM, se crearon 8 discos virtuales de 100 GB cada uno.

Durante las pruebas, se verificaron los siguientes tipos de cargas:

- (Copia de seguridad) 0% aleatorio, 100% de lectura, tamaño de bloque de 64 KB, 1 IO excepcional;

- (Restaurar) 0% aleatorio, 100% de escritura, tamaño de bloque de 64 KB, 1 IO excepcional;

- (Típico) 100% aleatorio, 70% de lectura, tamaño de bloque de 4 KB, 4 IO sobresalientes;

- (VDI) 100% aleatorio, 20% de lectura, tamaño de bloque de 4 KB, 8 E / S sobresalientes;

- (OLTP) 100% aleatorio, 70% de lectura, tamaño de bloque de 8 KB, 4 E / S sobresalientes.

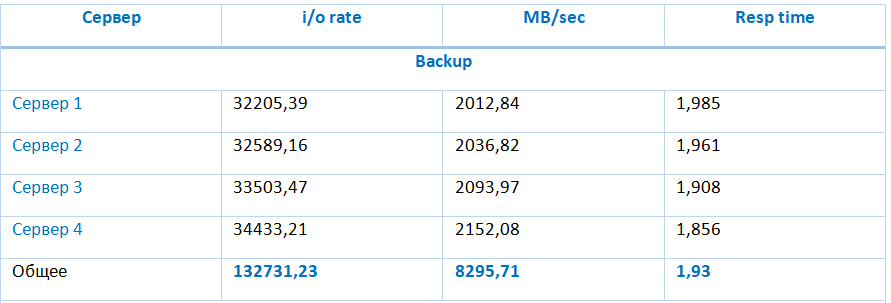

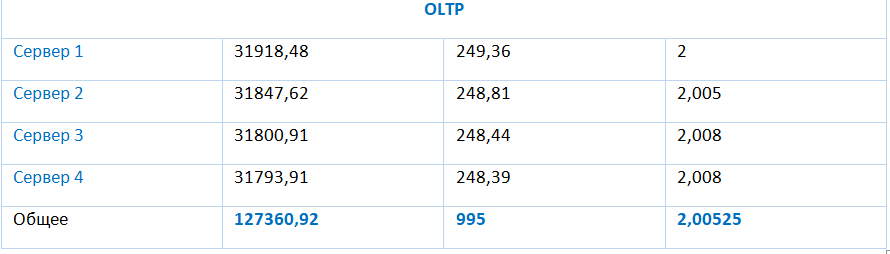

Los resultados de la prueba de estos tipos se presentan en la tabla:

El almacenamiento proporciona indicadores de rendimiento particularmente altos en operaciones de lectura y escritura secuenciales de 8295.71 MB y 2966.16 MB, respectivamente. El rendimiento de almacenamiento a una carga típica (E / S aleatoria con bloques de 4KB con un 70% de lectura) alcanza 133977.94 IOPS con un retraso promedio de E / S de 1.91 ms, y disminuye con un aumento en la relación de operaciones de escritura a operaciones de lectura.

Prueba de tolerancia a fallas

Estas pruebas permitieron verificar que una falla de uno de los componentes del sistema no conduzca a un apagado de todo el sistema.

| Prueba | Detalles de prueba | Comentarios |

|---|

| Error de disco en el grupo de almacenamiento | 14:00 - el sistema está funcionando normalmente;

14:11 - deshabilitando el primer SSD en el Servidor 1;

14:12 - La falla de SSD se muestra en la consola de administración de la plataforma;

14:21 - deshabilita el primer SSD en el Servidor 2;

14:35: la falla de dos SSD se muestra en la consola de administración de la plataforma;

14:38 - devuelva las unidades a los servidores 1 y 2. Los indicadores LED en el SSD no se muestran;

14:40 - el ingeniero a través de la CLI realizó la adición de SSD al repositorio;

14:50 - en la consola de administración de la plataforma se muestran como funcionando;

15:00 - Se completa la sincronización de los componentes de VM;

| El sistema funcionó normalmente. El indicador de tolerancia a fallos es el indicado. |

| Fallo de red | 15:02 - el sistema está funcionando normalmente;

15:17 - deshabilite uno de los dos puertos del Servidor 1;

15:17 - pérdida de una solicitud Echo en la dirección IP de la consola web (el servidor aislado sirvió como líder), la VM que se ejecuta en el servidor es accesible a través de la red;

15:18 - deshabilitando el segundo puerto en el Servidor 1, la VM y la consola de administración del servidor dejaron de estar disponibles;

15:20 - La VM se reinició en el nodo del Servidor 3;

15:26 - Las interfaces de red del servidor 1 están conectadas, el servidor regresó al clúster;

15:35 - se completa la sincronización de los componentes de los discos VM;

| El sistema funcionó normalmente. |

| Fallo de un servidor físico | 15:35 - el sistema está funcionando normalmente;

15:36 - apagando el Servidor 3 a través del comando de apagado en la interfaz IPMI;

15:38 - la VM de prueba reiniciada en el Servidor 1;

15:40 - inclusión del servidor 3;

15:43 - operación del servidor restaurada;

15:47 - se completa la sincronización.

| El sistema funcionó normalmente. |

Resultados de prueba

La plataforma SharxBase proporciona un alto nivel de disponibilidad y tolerancia a fallas en caso de falla de cualquier componente de hardware principal. Debido a la triple redundancia para el subsistema de disco, la plataforma garantiza la disponibilidad y seguridad de los datos en caso de una doble falla.

Las desventajas de la plataforma incluyen altos requisitos de espacio en disco causados por la necesidad de almacenar y sincronizar tres copias completas de datos, y la falta de mecanismos para una utilización más eficiente del espacio en disco, como la deduplicación, la compresión o la codificación de borrado.

Con base en los resultados de todas las pruebas realizadas, podemos concluir que la plataforma hiperconvergente SharxBase puede proporcionar un alto nivel de disponibilidad y rendimiento para diversos tipos de cargas, incluidos los sistemas OLTP, VDI y servicios de infraestructura.

Ilya Kuykin

Ingeniero de diseño líder de sistemas informáticos,

Jet Infosystems