Nubes, nubes y nubes otra vez. Pasar a las nubes, ya sea su nube privada en su centro de datos, una nube privada con un proveedor o con proveedores públicos como Amazon AWS, Microsoft Azure, IBM Cloud, Google Cloud, es implacable. Me di cuenta especialmente de esto cuando me mudé a los Estados Unidos. Aquí todos hablan de ellos y siempre: el aire está literalmente saturado con este tema. Los fabricantes de software y hardware lo entendieron perfectamente y no quieren perder esta oportunidad en este mundo cambiante.

Servicio de Kuberneties

Servicio de Kubernetiesse convierte en una herramienta importante y poderosa tanto para la creación y administración de Data Fabric (que se analiza más adelante) como para la competencia en el campo de los sistemas HCI. Anteriormente, NetApp HCI era una solución bastante simple que funcionaba solo con VMware, ya que Nutanix realmente comenzó. Ahora que NKS ha llegado, NetApp HCI será mucho más difícil para Nutanix en términos de aplicaciones de Next Generation DataCenter y Next Generation basadas en contenedores, pero al mismo tiempo dejará el nicho en el que teóricamente el hipervisor Nutanix puede ejecutarse en NetApp HCI.

Demostración del servicio Kubernetes de NetApp .

HCIUno de los primeros y bien merecidos HCI con los que muchos están familiarizados es Nutanix. A pesar de que Nutanix es un producto muy interesante, no está exento de inconvenientes. Lo más interesante de Nutanix, en mi opinión, es el ecosistema interno, no la arquitectura de almacenamiento. Si hablamos de las deficiencias, vale la pena señalar que el marketing podría ocultar a algunos ingenieros al transmitir el mensaje equivocado de que todos los datos son siempre locales y esto es bueno. Mientras que los competidores, al insinuar HCI de NetApp, necesitan acceder a los datos a través de la red, que es "larga" y generalmente "no es una HCI real", sin dar una definición de lo que es una HCI real, aunque no puede ser en principio, como, por ejemplo, en "Cloud", que nadie se compromete a dar una definición tampoco. Porque fue inventado por personas con fines de marketing, de modo que en el futuro sería posible complementar y cambiar el contenido de este concepto, y no con fines puramente técnicos, en los que inicialmente un objeto siempre tiene una definición sin cambios.

Inicialmente, era más fácil ingresar al mercado de HCI con la arquitectura accesible para las masas, lo cual es más fácil de consumir, es decir, simplemente usar la comedia del servidor con discos completos.

Pero esto no significa que estas sean las propiedades definitorias de HCI y la mejor opción de HCI. La declaración del problema realmente creó un problema, o como dije un matiz: cuando usa el almacenamiento en una arquitectura de nada compartido, que incluye Nutanix HCI basado en equipos comodity, debe garantizar la accesibilidad y la protección de datos, para esto debe copiar todos los registros al menos de un servidor a otro. Y cuando la máquina virtual genera un nuevo registro en el disco local, todo estaría bien si no fuera necesario duplicar este registro sincrónicamente y transferirlo a otro servidor y

esperar la respuesta de que está sano y salvo. En otras palabras, en Nutanix, y de hecho en cualquier arquitectura de nada compartido, la velocidad de los registros más o menos es, en el mejor de los casos, equivalente al hecho de que estos registros serían transferidos inmediatamente a través de la red al almacenamiento compartido.

Los principales lemas de diseño básico de HCI siempre han sido la simplicidad de la instalación y configuración iniciales, la capacidad de comenzar desde una configuración mínima, simple y económica y expandirse al tamaño deseado, facilidad de expansión / compresión, facilidad de administración desde una sola consola, automatización, todo esto está de alguna manera conectado con simplicidad, experiencia similar a la nube, flexibilidad y granularidad del consumo de recursos. Pero si el sistema de almacenamiento en la arquitectura HCI es una caja separada o parte del servidor, realmente no juega un papel importante para lograr esta simplicidad.

Resumiendo esto, podemos decir que el marketing sorprendentemente engañó a muchos ingenieros de que las unidades locales siempre son mejores, lo cual no es la realidad, porque desde un punto de vista técnico, a diferencia del marketing, no es tan simple. Tras llegar a la conclusión errónea de que existen arquitecturas HCI que usan solo discos locales, podemos llegar a la siguiente conclusión incorrecta de que los sistemas de almacenamiento conectados a través de la red siempre funcionarán más lentamente. Pero los principios de protección de la información, lógica y física en este mundo están diseñados de tal manera que esto es imposible de lograr, y no hay forma de alejarse de la comunicación a través de la red entre subsistemas de disco en la infraestructura de HCI, hay una diferencia fundamental en si los discos estarán localmente junto con los nodos informáticos o en un nodo de almacenamiento separado conectado a través de la red allí. Por el contrario, los nodos de almacenamiento dedicados le permiten lograr menos dependencias de los componentes HCI entre sí, por ejemplo, si reduce la cantidad de nodos en un clúster HCI basado en el mismo Nutanix o vSAN, automáticamente reduce el espacio en el clúster. Y viceversa: al agregar nodos informáticos, debe agregar discos a este servidor. Mientras está en la arquitectura HCI de NetApp, estos componentes no están interconectados. El pago de dicha infraestructura no está en absoluto en la velocidad del subsistema de disco, pero para comenzar es necesario tener al menos 2 nodos de almacenamiento y al menos 2 nodos de computación, para un total de 4 nodos. Se pueden empaquetar 4 nodos HCI de NetApp en 2U utilizando medios blades.

NetApp HCI

NetApp HCICon la compra de SolidFire, el HCI apareció en la línea de productos de NetApp (este producto no tiene su propio nombre, es por eso que simplemente se llama sistema HCI). Su principal diferencia con los sistemas HCI "clásicos" es un nodo de almacenamiento separado conectado a través de la red. El sistema SolidFire, que es la capa de "cien por ciento" para HCI, es radicalmente diferente de los sistemas All-Flash AFF, que se desarrollaron a partir de la línea FAS, que, a su vez, ha estado en el mercado durante aproximadamente 26 años.

Cuando lo conoces mejor (

lo que puedes hacer también ), queda claro que este es un producto de una ideología completamente diferente, dirigido a un segmento diferente de consumidores (proveedores de la nube) y que se adapta de manera ideal a sus tareas, tanto en términos de rendimiento, tolerancia a fallas y punto de vista de integración en un único ecosistema de facturación.

Recocido para las 200 pruebas de SolidAire de NetApp Arthur Alikulov, Evgeny Elizarov. Direcciones de NetApp 2018 .

NetApp se mueve hacia las nubesy ha dejado de ser solo un fabricante de sistemas de almacenamiento. Ahora es más bien una empresa nublada de gestión de citas, al menos se están moviendo obstinadamente en esta dirección. Una gran cantidad de diversas implementaciones de productos de NetApp hablan de esto: copia de seguridad SaaS para O365, copia de seguridad SaaS para Salesforce (y planes para Google Apps, Slack y ServiceNow). ONTAP Select se ha convertido en una decisión muy importante, independiente, y no como antes, una pequeña loción para replicar a un FAS "completo". NDAS se integra cada vez más en los sistemas de almacenamiento y la nube que anteriormente parecían no integrables, y proporciona una copia de seguridad, una búsqueda similar a Google en el directorio de archivos y la interfaz gráfica de administración como un servicio. FabricPool fue aún más profundo y combinó el SSD y la nube, lo que parecía poco probable o incluso loco antes.

El hecho de que NetApp haya terminado en cuatro de los proveedores de nube más grandes del mundo en un período de tiempo bastante corto indica la seriedad de sus intenciones. Además, el servicio NFS en Azure se crea exclusivamente en sistemas AFA de NetApp.

Demostración de archivos de Azure NetApp .

Los sistemas de almacenamiento AFF de NetApp están disponibles en Azure, AWS y Google como un servicio, NetApp se dedica a su soporte, actualización y mantenimiento, y los usuarios de la nube pueden consumir el espacio y la funcionalidad del sistema AFF para instantáneas, clonación, QoS como servicio.

NetApp Cloud Volumes Service para la demostración de AWS .

IBM Cloud utiliza ONTAP Select, que tiene exactamente la misma funcionalidad que el sistema AFF, pero se utiliza como software que se puede instalar en el servidor del servidor. Active IQ es un portal web que muestra información sobre el software y el equipo de NetApp y proporciona recomendaciones para anticipar problemas y actualizar algoritmos de inteligencia artificial que se ejecutan en telemetría ensamblada desde dispositivos y servicios de NetApp.

NetApp Active IQ Demo .

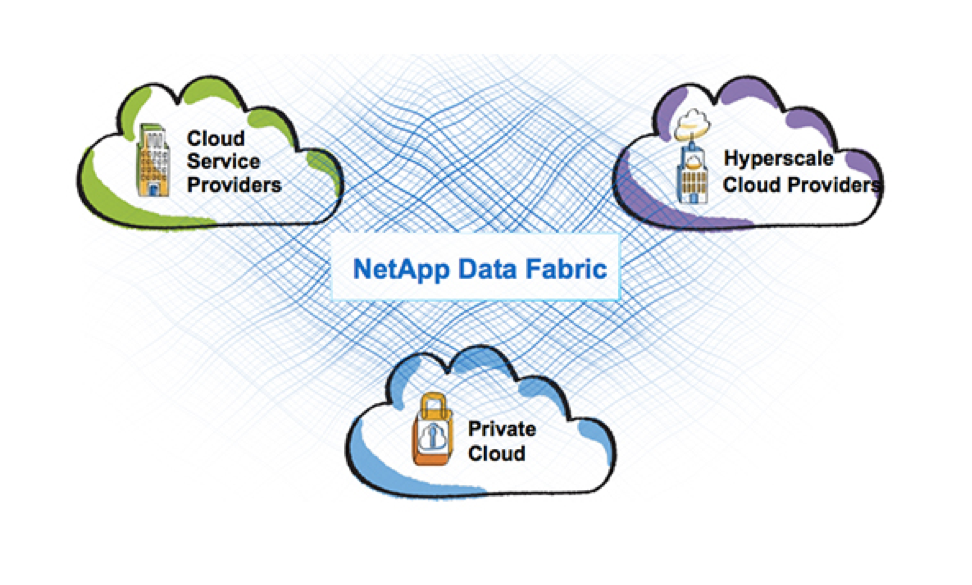

Tejido de datosEn general, la estrategia de Data Fabric que NetApp sigue actualmente está diseñada para combinar estos entornos completamente diferentes: nubes públicas y privadas, y todos los productos de NetApp. Después de todo, no basta con lanzar un producto en la nube, es necesario que se ajuste lógica y armoniosamente a los servicios de los proveedores de la nube. Y hoy NetApp es más que exitoso. Data Fabric a partir de la idea de marketing adquiere características bastante tangibles en forma de tecnologías y productos individuales: niveles de FabricPool entre SSD y S3, SnapMirror entre ONTAP y SolidFier / HCI, SnapCenter para ONTAP y SolidFier (que aún no se ha implementado), servicio de respaldo de datos NDAS su almacenamiento en la nube, el software MAX Data para memoria definida por software, todos estos son productos o funciones de NetApp que incorporan esta visión de Data Fabric. ONTAP Select ahora puede ejecutarse en Nutanix, brindando una rica funcionalidad de archivo a su ecosistema.

Data Fabric es en parte una visión del proceso de fusión o integración de todos los productos de NetApp e incluso las nubes, e incluso veo no solo marketing, sino incluso la fusión física de productos individuales.

No solo eso, quiero hacer una predicción. Durante varios años, he estado jugando este juego a expensas de las predicciones con algunos de mis colegas, y hasta ahora siempre he estado muy cerca o he adivinado el tren de pensamiento en esta compañía, veamos qué tan afortunado soy esta vez. Quiero enfatizar que esta es mi opinión personal, basada en los datos recibidos durante los 7 años de mi experiencia con NetApp e intuición, ninguno de NetApp me dijo esto, por lo que esto puede ser puramente un producto de mi imaginación:

- AFF se convertirá en parte de HCI

- Será posible migrar LUN en línea entre AFF / HCI

NetApp termina siendo un proveedor de almacenamientoeste puede ser un nombre de título demasiado alto, pero NetApp está pasando a una fase en la que la empresa se convierte en un operador nativo de la nube, de gestión de datos, definido por software y, como de costumbre, continúa produciendo almacenamiento. El almacenamiento no ha desaparecido y el borde no es visible por el hecho de que esto puede suceder en el futuro cercano, pero el énfasis está cambiando hacia la cobertura de la nube y hacia los datos en sí.

Este texto fue escrito en estrecha colaboración con Dmitry

bbk , si quieres saber más sobre las tecnologías de NetApp, no seas demasiado vago para ponerlo +, y los nuevos artículos no te harán esperar.

Si está interesado en noticias del mundo de NetApp, bienvenido al canal de telegramas

StorageTalks , pero si está buscando una comunidad activa de almacenamiento de habla rusa, venga al chat de telegramas

StorageDiscussions .