Durante varias semanas, el especialista en informática Siwei Lyu vio los videos falsos creados por su equipo con una preocupación atormentadora. Estas películas falsas hechas con el algoritmo de aprendizaje automático mostraron a las celebridades haciendo cosas que no harían. Le parecían extrañamente atemorizantes, y no solo porque sabía que eran falsos. "Se ven mal", recuerda sus pensamientos, "pero es muy difícil precisar exactamente qué causa esta impresión".

Pero una vez en su cerebro llegó un recuerdo de la infancia. Como muchos otros niños, jugaba "mirones" con niños. "Siempre perdí tales competencias", dice, "porque cuando miré sus caras sin parpadear, me sentí muy incómodo".

Se dio cuenta de que estas películas falsas le causaban una incomodidad similar: hacía de mirones a estas estrellas de cine, porque no abrían y no cerraban los ojos con tanta frecuencia como lo hacen las personas reales.

Para averiguar por qué, Luy, profesor de la Universidad de Albany, y su equipo estudiaron cada paso del software

DeepFake que creó estos videos.

Los programas de Deepfake toman muchas imágenes de una persona específica en la entrada, usted, su ex novia, Kim Jong-un, para que puedan verse desde diferentes ángulos, con diferentes expresiones faciales que dicen diferentes palabras. Los algoritmos aprenden cómo se ve este personaje, y luego sintetizan los conocimientos adquiridos en un video que muestra cómo esta persona hace lo que nunca hizo.

Pornografía Stephen Colbert hablando las palabras de John Oliver. El presidente

advierte sobre los peligros de los videos falsos.

Estos videos parecen convincentes durante unos segundos en la pantalla del teléfono, pero son (aún no) perfectos. Se pueden ver signos de falsificación, por ejemplo, de una manera extraña, ojos constantemente abiertos, derivados de las deficiencias del proceso de su creación. Mirando las entrañas de DeepFake, Lu se dio cuenta de que entre las imágenes que estudió el programa, no había tantas fotos con los ojos cerrados (¿porque no tienes una selfie en la que parpadeas?). "Se convierte en una distorsión", dice. La red neuronal no entiende el parpadeo. Los programas también pueden pasar por alto otras "señales fisiológicas inherentes a las personas", dijo Luya, quien describe este fenómeno: respirar a velocidad normal o la presencia de un pulso. Si bien este estudio se centró en los anuncios publicitarios creados con un software específico, en general se acepta que incluso un gran conjunto de fotografías puede no ser capaz de describir adecuadamente la percepción física de una persona, por lo que cualquier software capacitado en estas imágenes será imperfecto.

La revelación sobre el parpadeo reveló muchos videos falsos. Pero unas semanas después de que Lu y el equipo publicaron un borrador del trabajo en línea, recibieron una carta anónima que contenía enlaces a los siguientes videos falsos publicados en YouTube, donde las estrellas abrieron y cerraron los ojos en un modo más normal. Los creadores falsos han evolucionado.

Y esto es natural. Como Lu señaló en

una entrevista con The Conversation, "se puede agregar parpadeo a los videos falsos incluyendo imágenes con los ojos cerrados en la base de datos, o usando videos para entrenar". Sabiendo cuál es el signo de la falsificación, puede evitarlo: esto es "solo" un problema técnico. Lo que significa que los videos falsos se involucrarán en una carrera armamentista entre creadores y reconocedores. Investigaciones como el trabajo de Luy solo pueden complicar la vida de los fabricantes falsos. "Estamos tratando de elevar el listón", dice. "Queremos complicar este proceso, para que sea más lento".

Porque ahora es muy simple. Descargue el programa, google fotos de celebridades, aliméntelos a la entrada del programa. Ella los digiere, aprende de ellos. Y aunque todavía no es completamente independiente, con un poco de ayuda, da a luz y da a luz algo nuevo y bastante real.

"Está muy borrosa", dice Lu. Y no se refiere a imágenes. "Esta línea es entre verdad y falso", dijo.

Esto al mismo tiempo molesta y no sorprende a nadie que haya estado vivo recientemente y haya estado navegando por Internet. Pero esto preocupa especialmente a los departamentos militares y de inteligencia. En particular, es por eso que los estudios de Lu, como algunos otros trabajos, son financiados por un

programa DARPA llamado MediFor - Media Forensics [forense de medios].

El proyecto MediFor se lanzó en 2016, cuando la agencia notó un aumento en la actividad de los fabricantes falsificados. El proyecto está tratando de crear un sistema automatizado que estudie tres niveles de signos falsos y produzca una "evaluación de la realidad" de una imagen o video. En el primer nivel, se buscan pistas digitales sucias: ruido de una cámara de cierto modelo o artefactos de compresión. El segundo nivel es físico: la iluminación no está en la cara, el reflejo no se ve como debería verse con esta disposición de la lámpara. Este último es semántico: compara datos con información real confirmada. Si, por ejemplo, se afirma que el video que capturó el partido de fútbol fue filmado en Central Park a las 2 p.m.del martes 9 de octubre de 2018, ¿la condición del cielo coincide con el archivo meteorológico? Reúna todos los niveles y obtenga una evaluación de la realidad de los datos. DARPA espera que para el final de MediFor haya prototipos de sistemas con los que sea posible organizar controles a gran escala.

Sin embargo, el tiempo corre (¿o es solo un sonido repetitivo creado por una IA capacitada en datos relacionados con el seguimiento del tiempo?) "En unos años, podrá encontrar algo como la fabricación de eventos", dice el gerente del programa DARPA Matt Turek. "No solo una sola imagen o video editado, sino varias imágenes o clips que intentan transmitir un mensaje convincente".

El informático Juston Moore tiene una imagen más clara del futuro potencial en el Laboratorio Nacional de Los Alamos. Digamos: informamos al algoritmo que necesitamos un video en el que Moore robe una farmacia; lo presentamos en las grabaciones de video del sistema de seguridad de esta institución; enviarlo a la cárcel. En otras palabras, le preocupa que si los estándares para verificar la evidencia no se desarrollan (o no pueden) en paralelo con la fabricación de falsificaciones, será fácil sustituir a las personas. Y si los tribunales no pueden confiar en datos visuales, puede resultar que se ignoren las pruebas reales.

Llegamos a la conclusión lógica de que ver una vez no será mejor que escuchar cien veces. "Puede suceder que no confiemos en ninguna evidencia fotográfica", dice, "pero no quiero vivir en un mundo así".

Tal mundo no es tan increíble. Y el problema, según Moore, se extiende mucho más allá de reemplazar a los individuos. "Los algoritmos pueden

crear imágenes de personas que no pertenecen a personas reales, pueden alterar extrañas imágenes, convirtiendo un

caballo en una cebra ", dice Moore. Pueden

eliminar partes de imágenes y

eliminar objetos en primer plano

del video .

Tal vez no podamos tratar las falsificaciones más rápido de lo que se harán. Pero tal vez funcione, y esta oportunidad proporciona motivación para que el equipo de Moore estudie métodos digitales para estudiar evidencia. El programa de Los Alamos, que combina conocimiento de sistemas cibernéticos, sistemas de información, biología teórica y biofísica, es aproximadamente un año más joven que la agencia DARPA. Un enfoque se centra en la "compresibilidad", en los casos en que la imagen no contiene tanta información como parece. "Básicamente, nos basamos en la idea de que todos los generadores de imágenes de IA tienen un conjunto limitado de cosas que pueden crear", dice Moore. "Entonces, incluso si la imagen me parece bastante complicada a mí o a ti, puedes encontrar una estructura repetitiva en ella". Al reciclar píxeles, no queda mucho.

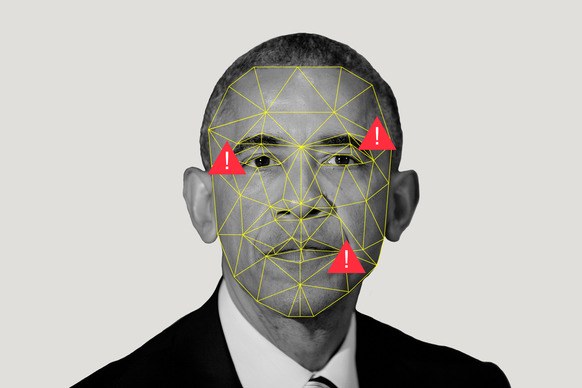

También usan algoritmos de codificación dispersos para jugar con coincidencias. Digamos que tenemos dos colecciones: un montón de imágenes reales y un montón de imágenes de IA creadas artificialmente. El algoritmo los estudia, creando lo que Moore llama un "diccionario de elementos visuales", señalando que las imágenes artificiales tienen algo en común y que las imágenes reales tienen algo en común. Si el amigo de Moore retuitea la imagen de Obama, y Moore considera que la imagen se hizo con IA, podrá ejecutarla a través del programa y descubrir qué diccionario estará más cerca.

Los Alamos, donde se encuentra una de las supercomputadoras más poderosas del mundo, carga recursos a este programa no solo porque alguien puede sustituir a Moore a través de un robo falso. La misión del laboratorio es "resolver los problemas de seguridad nacional con la ayuda de la excelencia científica". Su tarea principal es la seguridad nuclear, proporcionando garantías de que las bombas no explotarán cuando no deberían hacerlo, y explotarán cuando deberían (por favor, no), así como asistencia en la no proliferación. Todo esto requiere un conocimiento general del aprendizaje automático, porque ayuda, como dice Moore, "sacar grandes conclusiones de pequeños conjuntos de datos".

Pero además de todo esto, las empresas como Los Alamos deberían poder creer lo que ven, o saber cuándo no es necesario confiar en ellos. Porque, ¿qué pasa si ve imágenes satelitales de cómo un país moviliza o prueba armas nucleares? ¿Qué pasa si alguien falsifica las lecturas del sensor?

Este es un futuro aterrador que idealmente debería evitarse el trabajo de Moore y Lu. Pero en un mundo donde todo está perdido, ver no significa creer, pero las mediciones aparentemente absolutas pueden ser falsas. Todo lo digital está en duda.

Pero tal vez "duda" es la palabra incorrecta. Muchas personas tomarán falsificaciones al pie de la letra (¿recuerdan la

foto de un tiburón en Houston?), Especialmente si el contenido coincide con sus creencias. "La gente creerá en lo que tiende a creer", dice Moore.

La probabilidad de esto es mayor para el público en general que mira las noticias que en el campo de la seguridad nacional. Y para evitar la difusión de información errónea entre los tontos, DARPA ofrece colaboración en las redes sociales en un intento por ayudar a los usuarios a determinar que la credibilidad del video donde Kim Jong-un baila macarrones es bastante baja. Turek señala que las redes sociales pueden difundir la historia refutando el video tan rápido como el video en sí.

¿Pero lo harán? La exposición es un proceso

problemático (aunque no tan

ineficiente como los rumores lo tienen). Y las personas necesitan mostrar realmente los hechos antes de que puedan cambiar de opinión sobre la ficción.

Pero incluso si nadie puede cambiar la opinión de las masas sobre la veracidad del video, es importante que las personas que toman decisiones políticas y legales, sobre quién transporta cohetes o matan personas, están tratando de usar máquinas para separar la realidad aparente del sueño de IA.