A principios de esta semana

, tuvo lugar el próximo lanzamiento de Kubernetes, que se denominó "angelical",

1.13 . Este nombre está asociado con el número 113, que

se considera "angelical" y, según los desarrolladores de Kubernetes, simboliza "nuevos comienzos, transformación y el final de un capítulo antes de abrir nuevos". Sin profundizar en el análisis del simbolismo de lo que está sucediendo, de acuerdo con la tradición ya establecida para nuestro blog, informaremos por séptima vez sobre cambios clave en la nueva versión de Kubernetes, que están diseñados para complacer a los ingenieros de DevOps / SRE que trabajan con este producto.

Como fuentes de información, operamos con datos del

seguimiento de mejoras de Kubernetes , la tabla

CHANGELOG-1.13 y cuestiones relacionadas, solicitudes de extracción, propuestas de mejora de Kubernetes (KEP).

GA para kubeadm

Uno de los principales eventos del lanzamiento de Kubernetes 1.13 fue el anuncio de un estado estable (Disponibilidad general, GA) para la utilidad de consola

kubeadm . El blog de K8s incluso ha dedicado una

publicación separada a esto . Como mucha gente sabe, kubeadm es una herramienta para crear clústeres de Kubernetes de acuerdo con las mejores prácticas del proyecto, así como su soporte mínimo adicional. Una característica distintiva es que los desarrolladores se esfuerzan por mantenerlo compacto e independiente del proveedor / infraestructura, sin incluir soluciones a problemas tales como infraestructuras de aprovisionamiento, soluciones de red de terceros, complementos (monitoreo, registro, etc.), integraciones específicas con la nube proveedores.

El estado de GA marcó la madurez de kubeadm en las siguientes áreas:

- interfaz de consola estable que sigue la política de obsolescencia de Kubernetes: los comandos y los indicadores presentados en la versión de GA deben ser compatibles durante al menos un año después de su obsolescencia;

- implementación estable "bajo el capó" debido al hecho de que el clúster se crea mediante métodos que no cambiarán en el futuro cercano: el plano de control inicia la mayor cantidad de pods estáticos, se usan tokens bootstrap para

kubeadm join y ComponentConfig se usa para configurar kubelet; - esquema de configuración con una nueva API (v1beta1), que permite describir declarativamente casi todos los componentes del clúster (GitOps es posible para los clústeres creados con kubeadm): se planifica una actualización a la versión v1 sin cambios o con cambios mínimos;

- las llamadas fases (o interfaz de la caja de herramientas ) en kubeadm (

kubeadm init phase ), lo que le permite elegir qué procedimientos de inicialización se realizarán; - El equipo de

kubeadm upgrade garantiza actualizaciones de clúster entre las versiones 1.10.x, 1.11.x, 1.12.xy 1.13.x (actualizaciones, etcd, API Server, Controller Manager y Scheduler); - instalación segura de etcd de forma predeterminada (usa TLS en todas partes) con la capacidad de expandirse al clúster HA si es necesario.

También se puede notar que kubeadm ahora reconoce correctamente Docker 18.09.0 y sus versiones más recientes. Finalmente, los desarrolladores solicitan a los usuarios de kubeadm que realicen una pequeña

encuesta en

línea en la que pueden expresar sus deseos sobre el uso y desarrollo del proyecto.

CoreDNS por defecto

CoreDNS, que recibió un estado estable en la

versión 1.11 de Kubernetes , fue aún más lejos y se

convirtió en el servidor DNS predeterminado en K8 (en lugar de los kube-dns utilizados hasta ahora). Se planificó que esto sucedería ya en 1.12, pero los desarrolladores se enfrentaron a la necesidad de optimizaciones adicionales en la escalabilidad y el consumo de memoria, que se completaron solo con la versión actual.

El soporte para kube-dns continuará "durante al menos una próxima versión", pero los desarrolladores están hablando sobre la necesidad

de comenzar a migrar a una solución actualizada ahora.

De los cambios relacionados con el tema CoreDNS en Kubernetes 1.13, también se

puede observar el complemento

NodeLocal DNS Cache para mejorar el rendimiento de DNS. La mejora se logra ejecutando un agente en los nodos del clúster para la caché DNS, a la que accederán directamente los pods de este nodo. Por defecto, la función está deshabilitada, y para activarla, debe establecer

KUBE_ENABLE_NODELOCAL_DNS=true .

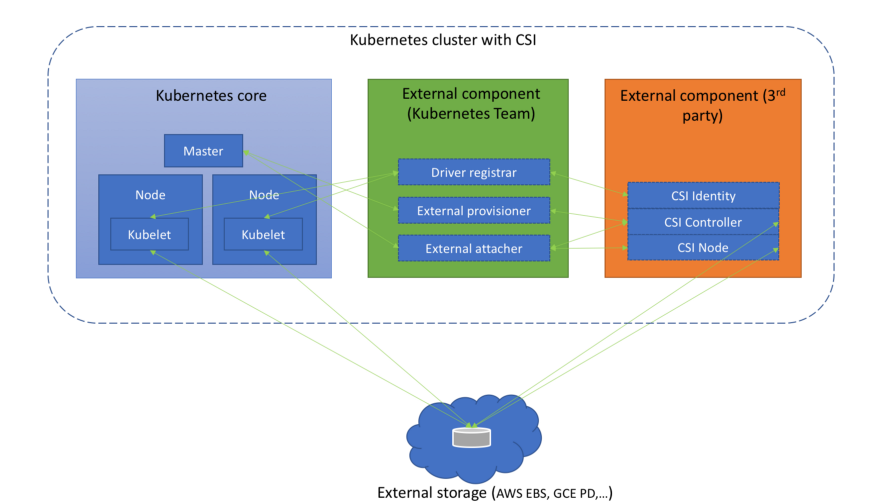

Instalaciones de almacenamiento

Se presta mucha atención en los últimos lanzamientos de Kubernetes para trabajar con la

Interfaz de almacenamiento de contenedores (CSI), que comenzó con la versión alfa de CSI en

K8s 1.9 , continuó con la versión beta en

1.10 ... Sin embargo, ya hemos

escrito sobre eso más

de una vez . Se alcanzó un nuevo hito significativo en K8 1.13: el

soporte CSI se declara estable (GA).

(Diagrama del artículo " Descripción de la interfaz de almacenamiento de contenedores ")

(Diagrama del artículo " Descripción de la interfaz de almacenamiento de contenedores ")Junto con esto, apareció el soporte para la especificación CSI v1.0.0 y el soporte para versiones anteriores del estándar (0.3 y anteriores) quedó en desuso. Esto significa que los controladores CSI más antiguos requerirán actualizar a CSI 1.0 (y pasar al nuevo directorio de registro del complemento Kubelet) para funcionar en Kubernetes 1.15 y versiones anteriores. Por cierto, desde los propios controladores, vale la pena señalar la

aparición de la versión alfa de la interfaz CSI para administrar el ciclo de vida de los volúmenes de AWS EBS (Elastic Block Store).

Una nueva adición al administrador de complementos ahora instala automáticamente CRI desde CSI si al menos una de las dos puertas de características está activada:

CSIDriverRegistry y

CSINodeInfo . Tiene el estado de la versión alfa, pero de hecho es solo una solución temporal al problema, descrita en detalle como

un mecanismo de instalación de CRD .

La planificación de volúmenes basada en topología (

Programación de volúmenes consciente de topología ), de la que hablamos en el contexto de la

versión Kubernetes 1.10 , se ha

vuelto estable . En resumen, el planificador en su trabajo tiene en cuenta las limitaciones de la topología del volumen del pod (por ejemplo, su zona y nodo).

La

oportunidad introducida en

Kubernetes 1.9 para usar

dispositivos crudos en bloque (no de red) como volúmenes persistentes se

ha traducido a beta y ahora está habilitada de forma predeterminada.

Concluimos el tema del almacenamiento con el hecho de que el soporte para GCERegionalPersistentDisk se

declara estable.

Nodos de clúster

Se

ha introducido la versión alfa de

soporte para complementos de monitoreo de dispositivos de terceros . La idea detrás de esta iniciativa es sacar el conocimiento específico del dispositivo

del árbol de Kubelet. Los administradores del clúster recibirán métricas informadas por los complementos del dispositivo a nivel de contenedor, y los fabricantes podrán crear estas métricas sin tener que hacer cambios en el núcleo de Kubernetes. Los detalles de la implementación se pueden encontrar en la propuesta, llamada

Kubelet Metadata API .

Declarado estable,

Kubelet Plugin Watcher (también conocido como Kubelet Device Plugin Registration) permite que los complementos a nivel de nodo (complementos de dispositivo, CSI y CNI) se comuniquen con Kubelet sobre ellos mismos.

Una nueva característica en estado alfa es

NodeLease . Si anteriormente el "latido" de un nodo fue determinado por NodeStatus, entonces con una nueva característica, cada nodo tiene un objeto

Lease asociado (en el espacio de nombres

kube-node-lease ), que el nodo actualiza periódicamente. El "pulso" ahora está configurado por ambos parámetros: el antiguo NodeStatus, que se informa al maestro solo en caso de cambios o por un tiempo de espera fijo (por defecto es una vez por minuto), y un nuevo objeto (se actualiza con frecuencia). Dado que este objeto es muy pequeño, mejorará en gran medida la escalabilidad y el rendimiento. Los autores se propusieron crear un nuevo "pulso" después de probar clústeres con un tamaño de más de 2000 nodos, que durante su trabajo podrían estar en contra de los límites de etcd, para más detalles ver

KEP-0009 .

type Lease struct { metav1.TypeMeta `json:",inline"` // Standard object's metadata. // More info: https://git.k8s.io/community/contributors/devel/api-conventions.md#metadata // +optional ObjectMeta metav1.ObjectMeta `json:"metadata,omitempty"` // Specification of the Lease. // More info: https://git.k8s.io/community/contributors/devel/api-conventions.md#spec-and-status // +optional Spec LeaseSpec `json:"spec,omitempty"` } type LeaseSpec struct { HolderIdentity string `json:"holderIdentity"` LeaseDurationSeconds int32 `json:"leaseDurationSeconds"` AcquireTime metav1.MicroTime `json:"acquireTime"` RenewTime metav1.MicroTime `json:"renewTime"` LeaseTransitions int32 `json:"leaseTransitions"` }

(La especificación compacta del nuevo objeto para representar el "pulso" del nodo - Lease - es idéntico a LeaderElectionRecord )Seguridad

La versión alfa de

Dynamic Audit Control sigue las ideas de Dynamic Admission Control y proporciona una configuración dinámica de capacidades de auditoría avanzadas, para esto ahora puede registrar (dinámicamente) un webhook que recibirá una secuencia de eventos. La necesidad de esta función se explica por el hecho de que la auditoría de Kubernetes ofrece funciones muy potentes, pero son difíciles de configurar y cada cambio de configuración aún requiere un reinicio del servidor.

El cifrado de datos en etcd (ver documentación oficial ) se ha transferido del estado experimental a beta.

kind: EncryptionConfiguration apiVersion: apiserver.config.k8s.io/v1 resources: - resources: - secrets providers: - identity: {} - aesgcm: keys: - name: key1 secret: c2VjcmV0IGlzIHNlY3VyZQ== - name: key2 secret: dGhpcyBpcyBwYXNzd29yZA== - aescbc: keys: - name: key1 secret: c2VjcmV0IGlzIHNlY3VyZQ== - name: key2 secret: dGhpcyBpcyBwYXNzd29yZA== - secretbox: keys: - name: key1 secret: YWJjZGVmZ2hpamtsbW5vcHFyc3R1dnd4eXoxMjM0NTY=

(Se toma un ejemplo de configuración con datos cifrados de la documentación ).Entre las innovaciones menos significativas en esta categoría:

- Ahora se puede configurar un servidor para rechazar solicitudes que no pueden entrar en los registros de auditoría.

PodSecurityPolicy objetos PodSecurityPolicy agregaron con soporte para la regla MayRunAs para las opciones fsGroup y fsGroup , que permite definir el rango de identificadores de grupo (GID) permitidos para pods / contenedores sin forzar el GID predeterminado. Además, con PodSecurityPolicy , la estrategia RunAsGroup ahora es posible en la especificación de RunAsGroup , es decir. Puede controlar el GID principal para contenedores.- Para kube-Scheduler, reemplazamos el puerto inseguro anterior (10251) con el nuevo puerto seguro (10259) y lo activamos de manera predeterminada. Si no se especifican indicadores adicionales, al cargarlos, se crean certificados autofirmados en la memoria.

CLI

El

kubectl diff , que

muestra la diferencia entre la configuración local y la descripción actual del objeto de trabajo (funciona y recursivamente para directorios con configuraciones), ha recibido el estado beta.

De hecho,

diff "predice" los cambios que se realizarán con el

kubectl apply , y se

utiliza otra nueva característica:

APIServer DryRun . Su esencia, el inicio inactivo, debe ser clara a partir del nombre, y una descripción más detallada está disponible en la

documentación de Kubernetes . Por cierto, en la versión 1.13, la función DryRun también se "actualizó" a la versión beta y se activó de forma predeterminada.

Y otro avance a la versión beta en el mundo de la consola de Kubernetes ha afectado el

nuevo mecanismo de complemento . En el camino,

corrigieron el orden de salida de los complementos (

kubectl plugin list ), eliminando la clasificación adicional desde allí.

Además, la salida de

los recursos de

almacenamiento efímero utilizados se

agregó al

kubectl describe node , y los volúmenes de tipo

proyectados se agregaron al

kubectl describe pod .

Otros cambios

La función del planificador de

desalojo basado en Taint se ha convertido al estado beta y se habilita de forma predeterminada después de una

larga pausa en el desarrollo. Su propósito es agregar automáticamente

manchas a los nodos (a través de NodeController o kubelet) ante la aparición de ciertas condiciones, como, por ejemplo,

node.kubernetes.io/not-ready , que corresponde al valor de

NodeCondition en

Ready=False .

Una anotación de pods críticos para el funcionamiento del clúster (

critical-pod ) está en desuso. En cambio, se propone utilizar

prioridades (en beta con Kubernetes 1.11) .

Para AWS, por primera vez (como parte de las versiones alfa), estuvo disponible lo siguiente:

- integración para AWS ALB (Application Load Balancer) con recursos de Kubernetes Ingress - aws-alb-ingress-controller (el proyecto fue creado originalmente por Ticketmaster y CoreOS para migrar el primero a la nube de AWS);

- CCM (Cloud Controller Manager) externo de AWS: cloud-provider-aws , responsable de lanzar controladores con la funcionalidad de proveedor específico de la nube (AWS).

SIG Azure implementó soporte adicional para Azure Disk (Ultra SSD, SSD estándar y Premium Azure Files) y promovió los

nodos del grupo de recursos cruzados a beta. Además, los complementos CNI para Windows ahora tienen

la capacidad de configurar DNS en un contenedor.

Compatibilidad

- La versión etcd es 3.2.24 (no ha cambiado desde Kubernetes 1.12).

- Versiones verificadas de Docker : 1.11.1, 1.12.1, 1.13.1, 17.03, 17.06, 17.09, 18.06 (tampoco han cambiado).

- Go versión - 1.11.2, coincide con el mínimo admitido.

- La versión CNI es 0.6.0.

- La versión CSI es 1.0.0.

- La versión de CoreDNS es 1.2.6.

PS

Lea también en nuestro blog: