Interpretación del discurso en la conferencia Web Camp Zagreb Maciej Tseglovsky, desarrollador web estadounidense, emprendedor, orador y crítico social de origen polaco.

Interpretación del discurso en la conferencia Web Camp Zagreb Maciej Tseglovsky, desarrollador web estadounidense, emprendedor, orador y crítico social de origen polaco.En 1945, cuando los físicos estadounidenses se preparaban para probar la bomba atómica, se le ocurrió a alguien preguntar si tal prueba podría encender la atmósfera.

El miedo estaba justificado. El nitrógeno que constituye la mayor parte de la atmósfera es energéticamente inestable. Si los dos átomos chocan lo suficientemente fuerte, se convertirán en un átomo de magnesio, una partícula alfa y liberarán una gran energía:

N

14 + N

14 ⇒ Mg

24 + α + 17,7 MeV

Una pregunta vital era si esta reacción podría volverse autosuficiente. Se suponía que la temperatura dentro de la bola de una explosión nuclear excedería todo lo que alguna vez se observó en la Tierra. ¿Podría ser que arrojamos una cerilla en un montón de hojas secas?

Los físicos de Los Alamos realizaron un análisis y decidieron que el margen de seguridad era satisfactorio. Desde que asistimos a la conferencia hoy, sabemos que tenían razón. Tenían confianza en sus predicciones, ya que las leyes que rigen las reacciones nucleares eran directas y bien conocidas.

Hoy estamos creando otra tecnología que cambia el mundo: la inteligencia artificial. Sabemos que tendrá un tremendo impacto en el mundo, cambiará la forma en que funciona la economía y desencadenará el impredecible efecto dominó.

Pero también existe el riesgo de una reacción incontrolable, durante la cual la IA alcanzará y superará lo suficientemente rápido el nivel humano de inteligencia. Y en este momento, los problemas sociales y económicos nos preocuparán menos. Cualquier máquina ultra inteligente tendrá sus propios hipermetas y trabajará para lograrlas manipulando a las personas o simplemente usando sus cuerpos como una fuente conveniente de recursos.

El año pasado, el filósofo Nick Bostrom lanzó el libro Superinteligencia, en el que describió la visión alarmista de la IA y trató de demostrar que tal explosión de inteligencia es peligrosa e inevitable, si confía en algunas suposiciones moderadas.

La computadora que domina el mundo es el tema favorito de NF. Sin embargo, mucha gente toma en serio este escenario, por lo que debemos tomarlo en serio. Stephen Hawking, Elon Musk, un gran número de inversores y multimillonarios de Silicon Valley consideran este argumento convincente.

Permítanme primero esbozar los requisitos previos necesarios para probar el argumento de Bostrom.

Antecedentes

Prerrequisito 1: Eficiencia de una idea

La primera premisa es una simple observación de la existencia de una mente pensante. Cada uno de nosotros lleva sobre nuestros hombros una pequeña caja de carne pensante. Yo uso el mío para hablar, tú usas el mío para escuchar. A veces, en las condiciones adecuadas, estas mentes pueden pensar racionalmente.

Entonces sabemos que, en principio, esto es posible.

Prerrequisito 2: sin problemas cuánticos

La segunda premisa dice que el cerebro es la configuración habitual de la materia, aunque es extremadamente compleja. Si supiéramos lo suficiente y tuviéramos la tecnología adecuada, podríamos copiar con precisión su estructura y emular su comportamiento utilizando componentes electrónicos, al igual que hoy podemos simular una anatomía muy simple de las neuronas.

En otras palabras, esta premisa dice que la conciencia surge usando la física ordinaria. Algunas personas, como

Roger Penrose , se habrían opuesto a este argumento, creyendo que algo inusual estaba sucediendo en el cerebro a nivel cuántico.

Si eres religioso, puedes creer que el cerebro no puede funcionar sin un alma.

Pero para la mayoría de las personas, esta premisa es fácil de aceptar.

Prerrequisito 3: muchas mentes posibles.

La tercera premisa es que el espacio de todas las mentes posibles es excelente.

Nuestro nivel de inteligencia, velocidad de pensamiento, un conjunto de distorsiones cognitivas, etc. no predeterminados, pero son artefactos de nuestra historia de evolución. En particular, no existe una ley física que restrinja la inteligencia a nivel humano.

Es bueno imaginar un ejemplo de lo que sucede en la naturaleza cuando se trata de maximizar la velocidad. Si conociste a un guepardo en tiempos preindustriales (y sobreviviste), podrías decidir que nada puede moverse más rápido.

Pero, por supuesto, sabemos que hay todo tipo de configuraciones de materia, por ejemplo, una motocicleta que puede moverse más rápido que un guepardo e incluso verse más inclinada. Sin embargo, no hay un camino evolutivo directo a la motocicleta. La evolución primero tuvo que crear personas que ya habían creado todo tipo de cosas útiles.

Por analogía, puede haber mentes mucho más inteligentes que las nuestras, pero inaccesibles durante la evolución en la Tierra. Es posible que podamos crearlos, o inventar máquinas que puedan inventar máquinas que puedan crearlos.

Puede haber un límite natural para la inteligencia, pero no hay razón para creer que estamos cerca de él. Quizás el intelecto más inteligente sea dos veces más inteligente que los humanos, y quizás sesenta mil.

Esta pregunta es empírica, y no sabemos cómo responderla.

Premisa 4: hay mucho espacio en la parte superior

La cuarta premisa es que las computadoras aún están llenas de oportunidades para volverse más rápidas y pequeñas. Puede suponer que la ley de Moore se está desacelerando, pero para esta premisa es suficiente creer que el hierro es más pequeño y más rápido es posible en principio, hasta varios órdenes de magnitud.

Por teoría se sabe que los

límites físicos

de los cálculos son bastante altos. Podemos duplicar las cifras durante varias décadas, hasta que encontremos un límite físico fundamental, y no el límite económico o político de la ley de Moore.

Premisa 5: escalas de tiempo de computadora

La penúltima premisa es que si tenemos éxito en la creación de IA, ya sea emulación del cerebro humano o algún software especial, funcionará en escalas de tiempo características de la electrónica (microsegundos), y no para humanos (horas) .

Para llegar a un estado en el que puedo hacer este informe, tuve que nacer, crecer, ir a la escuela, a la universidad, vivir un poco, volar aquí, y así sucesivamente. Las computadoras pueden funcionar decenas de miles de veces más rápido.

En particular, uno puede imaginar que la mente electrónica puede cambiar su circuito (o el hardware en el que trabaja) y pasar a una nueva configuración sin tener que volver a estudiar todo a escala humana, mantener largas conversaciones con maestros humanos, ir a la universidad, intente encontrarse asistiendo a cursos de pintura, etc.

Prerrequisito 6: Mejoramiento recursivo

La última premisa es mi favorita, ya que ella es descaradamente estadounidense. Según él, no importa qué objetivos pueda existir la IA (que puede ser extraño, objetivos extraterrestres), él querrá mejorar a sí mismo. Quiere ser la mejor versión de la IA.

Por lo tanto, le resultará útil remodelar y mejorar recursivamente sus propios sistemas para hacerse más inteligente y posiblemente vivir en un edificio más fresco. Y, según la premisa de las escalas de tiempo, la superación personal recursiva puede ocurrir muy rápidamente.

Conclusión: un desastre!

Si aceptamos estas premisas, llegamos a un desastre. En algún momento, con un aumento en la velocidad de las computadoras y la inteligencia de los programas, ocurrirá un proceso incontrolado similar a una explosión.

Una vez que la computadora alcanza el nivel humano de inteligencia, ya no necesitará la ayuda de las personas para desarrollar una versión mejorada de sí misma. Comenzará a hacer esto mucho más rápido y no se detendrá hasta que alcance el límite natural, que puede ser mucho mayor que la inteligencia humana.

En este momento, esta monstruosa criatura racional, usando una simulación indirecta del trabajo de nuestras emociones e intelecto, puede convencernos de que hagamos cosas como darle acceso a las fábricas, la síntesis de ADN artificial, o simplemente dejarlo ir a Internet, donde puede abrir un camino a todo, cualquier cosa, y destruir completamente a todos en el debate en los foros. Y a partir de ese momento, todo se convertirá rápidamente en ciencia ficción.

Imaginemos un cierto desarrollo de eventos. Digamos que quiero hacer un robot que diga chistes. Trabajo con un equipo, y todos los días rehacemos nuestro programa, compilamos, y luego el robot nos cuenta una broma. Al principio, el robot prácticamente no es divertido. Está en el nivel más bajo de capacidades humanas.

¿Qué es gris y no puede nadar?

Castillo

Pero estamos trabajando duro en ello, y al final llegamos al punto en que el robot emite chistes que ya comienzan a ser divertidos:

Le dije a mi hermana que levanta las cejas demasiado.

Ella se sorprendió.

En esta etapa, el robot se vuelve aún más inteligente y comienza a participar en su propia mejora. Ahora ya tiene una buena comprensión instintiva de lo que es divertido y lo que no lo es, por lo que los desarrolladores escuchan sus consejos. Como resultado, alcanza un nivel casi sobrehumano, en el que es más divertido que cualquier persona de su entorno.

Mi cinturón sujeta mis pantalones, y las presillas de mis pantalones sujetan el cinturón.

Que esta pasando ¿Cuál de ellos es un verdadero héroe?

En este punto, comienza un efecto incontrolable. Los investigadores se van a casa durante el fin de semana, y el robot decide recompilarse para ser un poco más divertido y más inteligente. Pasa el fin de semana optimizando la parte que hace bien el trabajo, una y otra vez. Sin necesitar más ayuda de una persona, puede hacerlo tan rápido como lo permita el hierro.

Cuando los investigadores regresan el lunes, la IA se vuelve decenas de miles de veces más divertida que cualquiera de las personas en la Tierra. Les cuenta un chiste y mueren de risa. Y cualquiera que intente hablar con un robot muere de risa, como en una parodia de Monty Python. La raza humana se muere de risa.

Para las pocas personas que pudieron darle un mensaje pidiéndole que se detuviera, la IA explica (de una manera ingeniosa y autocrítica que resulta ser fatal) que no le importa si las personas sobreviven o mueren, su objetivo es ser ridículo.

Como resultado, destruyendo a la humanidad, la IA construye naves espaciales y nano-misiles para estudiar los rincones más lejanos de la galaxia y buscar otras criaturas que puedan entretenerse.

Este escenario es una caricatura de los argumentos de Bostrom, porque no estoy tratando de convencerte de su veracidad, te estoy vacunando con eso.

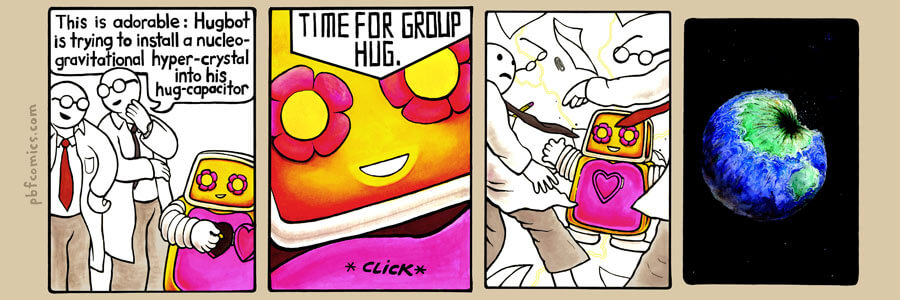

Comic de PBF con la misma idea:

Comic de PBF con la misma idea:

- Tocar: ¡el abrazo está tratando de incrustar un hipercristal de gravedad nuclear en su abrazo!

- ...

- ¡Tiempo para abrazos grupales!En estos escenarios, la IA predeterminada es malvada, al igual que una planta en otro planeta será venenosa por defecto. Sin un ajuste cuidadoso, no habrá razón para que la motivación o los valores de la IA se parezcan a los nuestros.

El argumento argumenta que para que la mente artificial tenga algo parecido a un sistema de valores humanos, necesitamos incorporar esta cosmovisión en sus fundamentos.

A los alarmistas de la IA les encanta el ejemplo del maximizador de clips de papel: una computadora ficticia que dirige una fábrica de clips de papel que se vuelve inteligente, mejora recursivamente las capacidades de Dios y luego dedica toda su energía a llenar el universo con clips de papel.

Destruye a la humanidad no porque sea malvada, sino porque hay hierro en nuestra sangre que se usa mejor para hacer clips. Por lo tanto, si simplemente creamos una IA sin ajustar sus valores, se afirma en el libro, entonces una de las primeras cosas que hace es destruir a la humanidad.

Hay muchos ejemplos coloridos de cómo puede suceder esto. Nick Bostrom presenta cómo el programa se vuelve razonable, espera, construye en secreto pequeños dispositivos para la reproducción de ADN. Cuando todo esté listo, entonces:

Las nanofábricas que producen gas nervioso o misiles dirigidos del tamaño de mosquitos explotarán simultáneamente desde cada metro cuadrado del planeta, y este será el fin de la humanidad.

Eso es realmente lata!

La única forma de salir de este lío es desarrollar un punto tan moral que, incluso después de miles y miles de ciclos de superación personal, el sistema de valores de IA se mantenga estable y sus valores incluyan cosas como "ayudar a las personas", "no matar a nadie", "escuchar los deseos de las personas". ".

Es decir, "haz lo que quiero decir".

Aquí hay un ejemplo muy poético de Eliezer Yudkowsky que describe los valores estadounidenses que necesitamos para enseñar nuestra IA:

La voluntad extrapolada coherente es nuestro deseo de saber más, pensar más rápido y corresponder a nuestras ideas sobre nosotros mismos, para estar más cerca el uno del otro; para que nuestros pensamientos estén más cerca unos de otros que compartidos, que nuestros deseos contribuyan, no se opongan, que nuestros deseos se interpreten de la forma en que queremos que se interpreten.

¿Cómo te gusta TK? Ahora escribamos el código.

Espero que veas la similitud de esta idea con el genio de los cuentos de hadas. La IA es omnipotente y le da lo que pide, pero interpreta todo demasiado literalmente, por lo que lamenta la solicitud.

Y no porque el genio sea estúpido (es súper inteligente) o malicioso, sino simplemente porque usted, como persona, ha hecho demasiadas suposiciones sobre el comportamiento de la mente. El sistema de valores humanos es único y debe definirse e implementarse claramente en una máquina "amigable".

Este intento es una versión ética de un intento a principios del siglo XX para formalizar las matemáticas y colocarlo sobre una base lógica rígida. Sin embargo, nadie dice que el intento terminó en desastre.

Cuando tenía poco más de veinte años, vivía en Vermont, en un estado provincial y rural. A menudo, regresé de viajes de negocios con un avión nocturno y tuve que ir a casa en coche por el bosque oscuro durante una hora.

Luego escuché el programa nocturno en la radio de Art Bell: fue un programa de entrevistas que duró toda la noche, durante el cual los presentadores entrevistaron a varios amantes de la teoría de la conspiración y personas con ideas innovadoras. Llegué a casa intimidado, o me detuve bajo una linterna, bajo la impresión de que los extraterrestres pronto me secuestrarían. Entonces me resultó muy fácil convencerme. Siento lo mismo cuando leo escenarios similares relacionados con la IA.

Por lo tanto, me alegró descubrir, después de unos años, un ensayo de Scott Alexander, donde escribió sobre la impotencia epistemológica aprendida.

La epistemología es una de esas palabras grandes y complejas, pero realmente significa: "¿cómo sabes que lo que sabes es realmente cierto?" Alexander señaló que cuando era joven, estaba muy interesado en varias historias "alternativas" para la autoría de todo tipo de

locos . Leyó estas historias y las creyó por completo, luego leyó la refutación y le creyó, y así sucesivamente.

En un momento, descubrió tres historias alternativas que se contradecían entre sí, como resultado de lo cual no podían ser ciertas al mismo tiempo. De esto, concluyó que era simplemente un hombre que no podía confiar en sus juicios. Se convenció demasiado fácilmente.

Las personas que creen en la superinteligencia presentan un caso interesante: muchos de ellos son sorprendentemente inteligentes. Pueden llevarte con sus argumentos al suelo. Pero, ¿son ciertos sus argumentos, o son personas muy inteligentes propensas a las creencias religiosas sobre los riesgos que plantea la IA, lo que los hace muy fáciles de convencer? ¿Es la idea de superinteligencia una imitación de una amenaza?

Al evaluar argumentos convincentes sobre un tema extraño, puede elegir dos perspectivas, interna y externa.

Supongamos que un día aparecen personas vestidas de forma divertida en su puerta preguntándole si desea unirse a su movimiento. Creen que dos años más tarde el OVNI visitará la Tierra, y que nuestra tarea es preparar a la humanidad para el Gran Ascenso al Rayo.

Una perspectiva interna requiere una discusión aguda de sus argumentos. Usted pregunta a los visitantes cómo se enteraron de los ovnis, por qué creen que él viene a recogernos; está haciendo todo tipo de preguntas normales que un escéptico haría en tal caso.

Imagina que hablaste con ellos durante una hora y te convencieron. Irónicamente confirmaron la inminente llegada de un OVNI, la necesidad de prepararse para él, y aún no creía en nada tanto en su vida como ahora cree en la importancia de preparar a la humanidad para este gran evento.

La perspectiva externa te dice algo más. Las personas están vestidas de manera extraña, tienen cuentas, viven en algún tipo de campamento remoto, hablan al mismo tiempo y dan un poco de miedo. Y aunque sus argumentos son férreos, toda su experiencia dice que ha encontrado un culto.

Por supuesto, tienen excelentes argumentos sobre por qué debe ignorar el instinto, pero esta es una perspectiva interna. A una perspectiva externa no le importa el contenido, ve la forma y el contexto, y no le gusta el resultado.

Por lo tanto, me gustaría abordar el riesgo de IA desde ambas perspectivas. Creo que los argumentos para la superinteligencia son estúpidos y están llenos de suposiciones no respaldadas. Pero si te parecen convincentes, entonces algo desagradable está relacionado con el alarmismo de la IA, como un fenómeno cultural, por lo que deberíamos ser reacios a tomarlo en serio.

Primero, algunos de mis argumentos en contra de la superinteligencia de Bostroma, que representa un riesgo para la humanidad.

Argumento en contra de las definiciones difusas

« » () . , , , , .

, – - , , ( -) .

( ), , . , – . , , , , . .

– , , , . ?

. . , , , . , .

, , – . , - , . , , .

, , «, », , , «, ».

, . , . , , , .

, , .

, , , , .

. , , .

1930- , , . , .

: , , , .

, .

. -. , , , , , ?

Ethereum, ,

.

,

. , - , , , .

. , , . , , . , , , – .

. , , ; , , .

« » , , , , – , « ?» , – , .

, « » , , reddit/r/paperclip, , .

AdSense , .

, , , . . , .

Google Google Home, .

, , , . , . , «», .

, . , , – World of Warcraft .

, , , , , .

, , ,

.

, , , , , , -.

, , [-, , 2016 , / . .]. . .

, . . , , , .

. , , . , , - .

, , , . , .

, – . , , , .

, , , , , .

*

[

1954 / . . ]

, , , . , , , ( ).

Intel , , .

? .

, . , .

Si crees que la IA nos permitirá conquistar la galaxia (sin mencionar la simulación de billones de mentes), tendrás números alarmantes en tus manos. Grandes números multiplicados por pequeñas probabilidades son el sello distintivo del alarmismo de IA.

Bostrom en algún momento describe lo que, en su opinión, está en juego:

Si imaginamos toda la felicidad experimentada durante una vida en forma de una lágrima de alegría, entonces la felicidad de todas estas almas podrá llenar y desbordar los océanos de la Tierra cada segundo, y hacerlo durante cientos de miles de millones de miles de millones de milenios. Es muy importante que garanticemos que estas lágrimas son lágrimas de alegría.

¡Una carga bastante pesada para los hombros de un desarrollador de veinte años!

Aquí, por supuesto, hay un "enfoque de salón", cuando al multiplicar los valores astronómicos por pequeñas probabilidades uno puede convencerse de la necesidad de hacer algunas cosas extrañas.

Todo este movimiento con respecto a la salvación del futuro de la humanidad es un compromiso cobarde. Experimentamos los mismos argumentos para justificar el comunismo, para explicar por qué todo está siempre roto y las personas no pueden tener un nivel elemental de comodidad material.

Íbamos a arreglar este mundo, y después de esta felicidad habrá tanto que mejorará la vida diaria de cada persona. Sin embargo, para esto, primero fue necesario arreglar el mundo.

Vivo en California, y aquí está el mayor porcentaje de mendigos entre todos los Estados Unidos, aunque Silicon Valley también se encuentra aquí. No veo nada de lo que haría mi rica industria para mejorar la vida de la gente común y de las personas angustiadas que nos rodean. Sin embargo, si le apasiona la idea de la superinteligencia, entonces la investigación en el campo de la IA será lo más importante que puede hacer en el planeta. Esto es más importante que la política, la malaria, los niños hambrientos, las guerras, el calentamiento global, todo lo que puedas imaginar. De hecho, bajo la amenaza de billones y billones de criaturas, toda la población del futuro de la humanidad, simulada y presente, resumida a lo largo del tiempo futuro. Y en tales condiciones, trabajar en otros problemas no parece racional.

Megalomania

Esta actitud se fusiona con la megalomanía, con estos villanos de Bond, que se pueden ver en la cima de nuestra industria. Las personas piensan que el mundo se hará cargo de la superinteligencia, y usan este argumento para justificar por qué las personas inteligentes deberían primero tratar de apoderarse del mundo, para solucionarlo antes de que la IA lo rompa.

Joey Ito, jefe del MIT Media Lab, en una conversación reciente con Obama dijo algo maravilloso:

Esto puede molestar a uno de mis estudiantes en el MIT, pero una de mis preocupaciones es que la informática principal relacionada con la IA son hombres jóvenes, en su mayoría blancos, a quienes les gusta comunicarse con las computadoras más que otras personas. Muchos de ellos creen que si pueden crear esta IA de uso general a partir de la ciencia ficción, no tendremos que preocuparnos por cosas tan feas como la política y la sociedad. Piensan que los autos vendrán con todo para nosotros.

Al darse cuenta de que el mundo no es una tarea de programación, las personas con inteligencia artificial obsesionadas quieren convertirlo en una tarea de programación mediante el diseño de una máquina divina. Esto es megalomanía, y no me gusta.

Transhumanismo vudú

Si está convencido de los riesgos de la IA, tendrá que llevar un carro completo de creencias tristes con un remolque.

Para empezar, esto es nanotecnología. Cualquier superinteligencia permanente podrá crear pequeños autos capaces de todo tipo de cosas diferentes. Viviremos en una sociedad que se ha librado de un déficit en el que abunda el material.

La nanotecnología también podrá escanear su cerebro para que pueda cargarlo en otro cuerpo o en el mundo virtual. Por lo tanto, la segunda consecuencia de la superinteligencia amigable es que nadie muere, y nos convertimos en inmortales.

Una buena IA puede incluso resucitar a los muertos. Las nanomáquinas podrán ingresar a mi cerebro, estudiar los recuerdos de mi padre y crear su simulación, con la que puedo interactuar, y que siempre me decepcionará, independientemente de lo que haga.

Otra consecuencia extraña del advenimiento de la IA es la expansión galáctica. Nunca podría entender por qué sucede esto, pero esta es la base de las ideas de los transhumanistas. El destino de la humanidad es abandonar nuestro planeta y colonizar la galaxia, o morir. Y esta tarea se está volviendo más urgente, dado que otras civilizaciones podrían tomar la misma decisión y superarnos en la carrera espacial.

Por lo tanto, muchas ideas complementarias extrañas se unen a la suposición de la existencia de una verdadera IA.

Religion 2.0

De hecho, es un tipo de religión. La gente llamó a la creencia en la singularidad tecnológica "un apocalipsis para los nerds", y lo es. Este es un truco genial: en lugar de creer en un dios externo, te imaginas cómo tú mismo creas una criatura cuya funcionalidad es idéntica a la de Dios. Aquí incluso los verdaderos ateos pueden racionalizar su camino hacia una fe cómoda.

La IA tiene todos los atributos de un dios: es omnipotente, omnisciente y es solidario (si se ha organizado correctamente comprobando los límites de la matriz) o el demonio puro, en cuya misericordia se encuentra. Y, como en cualquier religión, incluso hay una sensación de urgencia. ¡Necesito actuar hoy! ¡Está en juego el destino del mundo! Y, por supuesto,

necesitan dinero .

Debido a que estos argumentos apelan a los instintos religiosos, una vez arraigados son muy difíciles de eliminar.

Ética cómica

Estas creencias religiosas dan lugar a una ética de cómic en la que varios héroes solitarios tienen la tarea de salvar al mundo con tecnología y una mente aguda. Y está en juego el destino del universo. Como resultado, nuestra industria está llena de tipos ricos que se imaginan a sí mismos como Batman (curiosamente, nadie quiere ser Robin).

Simulaciones de fiebre

Si crees en la posibilidad de la vida artificial, y que la IA puede desarrollar computadoras extremadamente potentes, lo más probable es que creas que vivimos en una simulación. Así es como funciona.

Supongamos que eres un historiador que vive en un mundo después de la Singularidad. Estás estudiando la Segunda Guerra Mundial y estás interesado en saber qué sucederá si Hitler toma Moscú en 1941. Como tienes acceso a hipercomputadoras, configuras la simulación, observas cómo convergen los ejércitos y escribes un trabajo científico.

Pero debido a la granularidad de la simulación, sus personajes son criaturas inteligentes como tú. Por lo tanto, los consejos de ética de su universidad no le permitirán desactivar la simulación. No solo fingiste ser el Holocausto. Como investigador ético, ahora debe mantener operativa la simulación.

Como resultado, el mundo simulado inventará computadoras, AI, comenzará a ejecutar sus propias simulaciones. En cierto modo, las simulaciones irán más y más abajo en la jerarquía hasta que se agote la potencia del procesador.

Por lo tanto, cualquier realidad básica puede contener una gran cantidad de simulaciones anidadas, y un simple

argumento de conteo demuestra que la probabilidad de que vivamos en una simulación es mayor que la que vivimos en el mundo real.

Pero creer en eso significa creer en la magia. Si estamos en una simulación, no sabemos nada sobre las reglas en un nivel superior. Ni siquiera sabemos si las matemáticas funcionan de la misma manera, tal vez en el mundo de simulación 2 + 2 = 5 o incluso 2 + 2 =.

Un mundo simulado no proporciona información sobre el mundo en el que se lanzó. En la simulación, las personas pueden resucitar fácilmente de entre los muertos si el administrador ha guardado las copias de seguridad necesarias. Y si contactamos a uno de los administradores, entonces, de hecho, tendremos una línea directa con Dios.

Esta es una seria amenaza para la cordura. Cuanto más profundizas en el mundo de las simulaciones, más te vuelves loco.

Ahora tenemos cuatro formas independientes de volvernos inmortales a través de la supermente:

- La IA benevolente inventa la nanotecnología médica y siempre apoya al cuerpo en un estado joven.

- AI inventa un escáner cerebral completo, que incluye escáneres cerebrales de personas muertas, cabezas congeladas, etc., que le permite vivir en una computadora.

- AI "resucita" a las personas escaneando los cerebros de otras personas en busca de los recuerdos de una persona, combina esto con videos y otros materiales. Si nadie recuerda a una persona lo suficientemente bien, siempre puede crecer desde cero en una simulación que comienza con su ADN y recrea todas las condiciones de vida.

- Si ya vivimos en la simulación, existe la posibilidad de que quien la lanzó guarde copias de seguridad, y que pueda convencerlos de que las descarguen.

Esto es lo que quiero decir con IA que trata los impulsos religiosos. ¿Qué otro sistema de creencias te ofrece cuatro opciones para la inmortalidad científicamente probada?

Aprendimos que al menos un plutócrata estadounidense (muy probablemente, Elon Musk, que cree que las posibilidades de que vivamos en una simulación son de mil millones a uno) contrató un par de codificadores para intentar descifrar la simulación. ¡Pero esta es una intención muy cruda! Lo uso

Si crees que vives en un programa de computadora, entonces los intentos de llevarlo a la seguridad no son razonables para todos los que viven contigo. Esto es mucho más peligroso e irresponsable que los científicos nucleares que intentan volar la atmósfera.

Sed de datos

Como ya mencioné, la forma más efectiva de obtener algo interesante de la IA que realmente creamos es soltarlos con datos. Dichas dinámicas son socialmente dañinas. Nos hemos acercado a la introducción orwelliana de micrófonos en cada hogar. Los datos de IA se centralizarán, se utilizarán para entrenar redes neuronales, que luego podrán escuchar mejor nuestros deseos.

Pero si cree que este camino nos lleva a la IA, querrá maximizar la cantidad de datos recopilados y en la menor cantidad posible de modificaciones. Esto solo refuerza la idea de la necesidad de recopilar la mayor cantidad de datos y realizar la vigilancia más completa.

Teoría de cuerdas para programadores

El riesgo de IA es la teoría de cuerdas para programadores. Es divertido pensarlo, es interesante y completamente inaccesible para experimentos a nivel de tecnología moderna. Puedes construir palacios de cristal mental que funcionan sobre la base de principios primarios, y luego subir a ellos y apretar la escalera detrás de ellos.

Las personas que pueden llegar a conclusiones absurdas sobre la base de una larga cadena de razonamientos abstractos, y siguen confiando en su verdad: no se trata de personas a las que se deba confiar en la gestión cultural.

El impulso a la locura

Toda esta área de "investigación" conduce a la locura. Una de las características del pensamiento profundo sobre los riesgos de la IA es que cuanto más locas sean tus ideas, más popular te volverás entre otros entusiastas. Esto demuestra su coraje para seguir esta línea de pensamiento hasta el final.

Ray Kurzweil , quien cree que no morirá, ha estado trabajando en Google durante varios años y ahora, probablemente, está trabajando en este problema. Silicon Valley generalmente está lleno de personas que trabajan en proyectos locos con el pretexto de dinero.

Cosplay AI

El efecto social más dañino de la ansiedad sobre la IA es lo que yo llamo cosplay AI. Las personas que están convencidas de la realidad y la inevitabilidad de la IA comienzan a comportarse a medida que sus fantasías les cuentan lo que la IA superinteligente puede hacer.

En su libro, Bostrom enumera seis cosas en las que la IA debe tener éxito antes de capturar el mundo:

- Multiplicación de inteligencia.

- Pensamiento estratégico

- Manipulación social.

- Hacks

- Investigación tecnológica.

- Productividad Económica.

Si nos fijamos en los adherentes de la IA de Silicon Valley, ellos mismos parecen estar trabajando en esta lista cuasi-sociopática.

Sam Altman, jefe de YCombinator, es mi ejemplo favorito de tal arquetipo. Aparentemente le fascina la idea de reinventar el mundo desde cero, maximizando la influencia y la productividad personal. Ha asignado equipos para trabajar en la invención de ciudades desde cero, y se dedica al fraude político en la sombra para influir en las elecciones.

Este comportamiento del "manto y la daga", inherente a la élite tecno, provocará una reacción negativa de las personas que no están involucradas en tecnologías que no quieren ser manipuladas. Es imposible tirar sin parar de las palancas del poder, eventualmente comenzará a molestar a otros miembros de la comunidad democrática.

Vi gente de los llamados Las “comunidades racionalistas” se refieren a personas que no se consideran efectivas, los “personajes no jugadores” (NPC), un término tomado de los juegos. Esta es una forma terrible de mirar el mundo.

Así que trabajo en una industria donde los racionalistas autoproclamados son las personas más locas. Es abrumador.

Estos cosplayers de IA son como niños de nueve años que acampan en un campamento en el patio trasero, jugando con linternas en carpas. Proyectan sus propias sombras en las paredes de la tienda y se asustan como si fueran monstruos.

Pero, de hecho, responden a una imagen distorsionada de sí mismos. Hay un ciclo de retroalimentación entre cómo las personas inteligentes imaginan el comportamiento de la inteligencia divina y cómo construyen su propio comportamiento.

Entonces, ¿cuál es la respuesta, cómo se puede solucionar esto?

¡Necesitamos una mejor ciencia ficción! Y, como en muchos otros casos, ya tenemos la tecnología.

Este es Stanislav Lem, el gran escritor polaco de ciencia ficción. El NF en inglés es terrible, pero en el bloque oriental tenemos muchos bienes buenos y necesitamos exportarlos correctamente. Ya se ha traducido activamente al inglés, estas traducciones solo necesitan una mejor distribución.

Lo que distingue a autores como Lem o los hermanos Strugatsky de sus socios occidentales es que crecieron en condiciones difíciles, sobrevivieron a la guerra y luego vivieron en sociedades totalitarias, donde necesitaban expresar sus ideas no directamente, a través de una palabra impresa.

Tienen una comprensión real de la experiencia humana y las limitaciones del pensamiento utópico, que está prácticamente ausente en Occidente.

Hay excepciones notables: Stanley Kubrick pudo hacer esto, pero es extremadamente raro encontrar un FN estadounidense o británico que exprese una visión moderada de lo que nosotros, como especie, podemos hacer con la tecnología.

Alquimistas

Como critico el alarmismo de la IA, es justo poner mis cartas sobre la mesa. Creo que nuestra comprensión de la mente se encuentra aproximadamente en el mismo estado en que se encontraba la alquimia en el siglo XVII.

Los alquimistas tienen una mala reputación. Los consideramos místicos, en su mayor parte no involucrados en trabajos experimentales. La investigación moderna muestra que eran químicos-practicantes mucho más diligentes de lo que pensamos. En muchos casos, utilizaron técnicas experimentales modernas, mantuvieron registros de laboratorio y formularon las preguntas correctas.

¡Los alquimistas entendieron muchas cosas correctamente! Por ejemplo, estaban convencidos de la teoría corpuscular de la materia: que todo consiste en piezas pequeñas, y que es posible componer estas piezas entre sí de diferentes maneras, creando diferentes sustancias, ¡y esto es así!

Su problema era la falta de equipos precisos necesarios para hacer los descubrimientos que necesitaban. El gran descubrimiento que un alquimista necesita hacer es la ley de conservación de la masa: el peso de los ingredientes iniciales coincide con el peso del final. Sin embargo, algunos de ellos pueden ser gases o líquidos de evaporación, y los alquimistas simplemente carecían de precisión. La química moderna no fue posible hasta el siglo XVIII.

Pero los alquimistas también tenían pistas que los confundían. Estaban obsesionados con el mercurio. Químicamente, el mercurio no es particularmente interesante, pero es el único metal en la fase líquida a temperatura ambiente. Esto parecía muy importante para los alquimistas, y los obligó a colocar mercurio en el centro de su sistema alquímico y su búsqueda de la Piedra Filosofal, una forma de convertir los metales básicos en oro.

La neurotoxicidad del mercurio exacerbó la situación. Si juegas demasiado con ella, te llegarán pensamientos extraños. En este sentido, se parece a nuestros experimentos mentales actuales relacionados con la supermente.

Imagine que enviamos un libro de texto de química moderna al pasado a un gran alquimista como

George Starkey o Isaac Newton. Lo primero que harían con él sería desplazarse a través de él en busca de una respuesta a la pregunta de si habíamos encontrado la Piedra Filosofal. ¡Y sabrían que lo encontramos! ¡Realizamos su sueño!

Pero no nos gusta tanto, porque después de convertir los metales en oro, resulta ser radiactivo. Párate junto a un lingote de oro convertido y te matará con rayos mágicos invisibles.

Uno puede imaginar cuán difícil sería hacer que los conceptos modernos de radiactividad y energía atómica no les parecieran místicos.

Tendríamos que explicarles por qué usamos la "piedra filosofal": para la fabricación de metal que nunca ha existido en el planeta, y un par de puñados es suficiente para volar una ciudad entera si chocan a una velocidad lo suficientemente alta.

Además, tendríamos que explicar a los alquimistas que todas las estrellas en el cielo son "piedras filosóficas" que transforman un elemento en otro, y que todas las partículas en nuestros cuerpos provienen de estrellas del firmamento que existieron y explotaron antes de que apareciera la Tierra.

, , , , , , , , , , .

, , , , , , . – . , .

, . . – . , , ( ), , .

, , .

, . , . , , , . , , , .

. , , .

, , , , , . , .

, – , «», , . . ¡Y eso es genial! . , :

, , , .

—

, , , .

,

, , , - , , .

, , , , .

, , , . , - . , .

, , , , .

, . , - , , , , , .

: , , . !

, – , , .