Jesse Bataglia sostiene a su hijo Bennett en su casa en Ranch Mirage, California. En busca de una nueva niñera, Bataglia comenzó a usar Predictim, un servicio en línea que supuestamente utiliza "inteligencia artificial avanzada" para evaluar los riesgos de que la niñera sea adicta a las drogas, se comporte agresivamente o muestre "malos modales".

Jesse Bataglia sostiene a su hijo Bennett en su casa en Ranch Mirage, California. En busca de una nueva niñera, Bataglia comenzó a usar Predictim, un servicio en línea que supuestamente utiliza "inteligencia artificial avanzada" para evaluar los riesgos de que la niñera sea adicta a las drogas, se comporte agresivamente o muestre "malos modales".Cuando Jesse Bataglia comenzó a buscar una nueva niñera para su hijo de un año, quería obtener más información sobre el empleado que la ausencia de antecedentes penales, los comentarios de los padres y las entrevistas personales. Por lo tanto, recurrió al servicio en línea Predictim, utilizando "inteligencia artificial avanzada" para evaluar la identidad de la niñera, y envió sus escáneres a miles de publicaciones en Facebook, Twitter e Instagram de uno de los candidatos.

El sistema introdujo una "evaluación de riesgos" automática de una niña de 24 años, alegando que el riesgo de usar sus drogas era "muy pequeño". Sin embargo, el sistema calificó el riesgo de intimidación, agresión, falta de respeto y malos modales un poco más alto, en 2 de 5.

El sistema no explica sus decisiones. Sin embargo, Bataglia, quien consideraba que la niñera era completamente confiable, de repente comenzó a dudar. "Las redes sociales muestran la identidad de una persona", dijo Bataglia, que ahora tiene 29 años y vive en un suburbio de Los Ángeles. "¿Por qué la puntuación es 2, no 1?"

Predictim ofrece a los padres los mismos servicios que docenas de otras empresas de tecnología de todo el mundo venden a los empleadores: sistemas de inteligencia artificial que analizan el habla humana, las expresiones faciales y el historial de presencia en línea, al tiempo que prometen revelar los aspectos secretos de sus vidas personales.

La tecnología está cambiando la forma en que algunas empresas buscan candidatos, contratan y evalúan trabajadores, ofreciendo a los empleadores una evaluación incomparable de los candidatos a través de una nueva ola de evaluaciones y vigilancia psicológicas invasivas.

Fama afirma que están utilizando IA para monitorear las redes sociales de los trabajadores en busca de "comportamiento tóxico" para alertar a sus jefes. HireVue, una firma de tecnología de reclutamiento que trabaja con compañías como Geico, Hilton y Unilever, ofrece un sistema que analiza automáticamente el tono, la elección de palabras y las expresiones faciales del candidato durante una entrevista en video, y predice sus habilidades y modales (para ofrecer mejores resultados, a los candidatos se les ofrece más sonrisa)

Sin embargo, los críticos sostienen que los sistemas como Predictim conllevan un peligro en sí mismos, dejando soluciones automáticas que pueden cambiar la vida de una persona sin ningún control.

Los sistemas dependen de algoritmos basados en recuadros negros que casi no producen detalles sobre cómo redujeron todos los detalles complejos de la vida interior de una persona al cálculo de sus lados positivo y negativo. Y aunque la tecnología Predictim afecta el pensamiento de los padres, sigue sin estar comprobada, es casi inexplicable y vulnerable a las distorsiones perceptivas relacionadas con cómo exactamente la niñera correcta debe comportarse en las redes sociales, mirar y hablar.

Hay "una carrera loca para tomar el control de la IA y tomar todo tipo de decisiones sin ningún informe para la gente", dijo Jeff Chester, director ejecutivo del Centro para la Democracia Digital, un grupo de defensa de la tecnología. "Parece que las personas se emborracharon con refrescos digitales y piensan que es una forma normal de administrar nuestras vidas".

El proceso de escaneo de Predictim analiza el comportamiento completo de la niñera en las redes sociales, que para muchas de las niñeras más jóvenes puede capturar la mayor parte de sus vidas. Al mismo tiempo, se les informa a las niñeras que si se niegan a someterse a tal escaneo, esto será una seria desventaja en la competencia por los trabajos.

El CEO y cofundador de Predictim, Sal Parsa, dijo que la compañía, lanzada el mes pasado como parte de la tecnoincubadora Berkeley de la Universidad de California de SkyDeck, toma en serio los problemas éticos del uso de su tecnología. Dijo que los padres deberían considerar la calificación como un asesor, que "quizás refleja, y quizás no refleja las características reales de la niñera".

Agregó que el peligro de contratar a una niñera problemática o violenta hace de la IA una herramienta esencial para cualquier padre que intente mantener a salvo a su hijo.

"Busque en Google el abuso de las niñeras y encontrará cientos de resultados", dijo. - Hay personas con enfermedades mentales o simplemente enojadas. Nuestro objetivo es hacer todo lo que esté a nuestro alcance para detenerlos ”.

El costo de escanear Predictim comienza en $ 24.99, y para ella necesita decir el nombre y el correo electrónico de la potencial niñera, así como obtener su consentimiento para un amplio acceso a sus cuentas en las redes sociales. La niñera puede negarse, y luego los padres reciben una notificación al respecto, y la niñera misma recibe una carta que dice que "el padre que estaba interesado en usted no podrá contratarlo hasta que cumpla con la solicitud".

Los gerentes de Predictim dicen que usan algoritmos para procesar lenguaje e imágenes, "visión por computadora", evaluar publicaciones de niñeras en Facebook, Twitter e Instagram, y buscar pistas sobre su vida fuera de línea. El informe es recibido solo por el padre, que no está obligado a compartir sus resultados con la niñera.

Los padres probablemente pueden echar un vistazo a las cuentas públicas de niñeras en las redes sociales. Sin embargo, los informes informáticos prometen ofrecer una evaluación profunda de los años de actividad en línea, reducida a una sola cifra: una solución tentadora y simple para una tarea casi imposible.

Las evaluaciones de riesgos se dividen en varias categorías, incluido el contenido manifiesto y el abuso de drogas. La startup también afirma en publicidad que su sistema es capaz de evaluar otras características de la personalidad de la niñera, como la cortesía, la capacidad de trabajar con otros y la "positividad".

La compañía espera revolucionar la industria multimillonaria de "externalizar las responsabilidades de los padres" y ya ha comenzado a publicitar patrocinando blogs y sitios para padres para "madres". La estrategia de marketing se centra en la oportunidad declarada de revelar secretos y prevenir la "pesadilla de cualquier padre", y el anuncio cita casos penales, incluido, por ejemplo, el caso de una niñera de Kentucky condenada por daños corporales graves a un niño de ocho meses.

"Si los padres de esta niña afectada por la enfermera pudieran usar Predictim en el proceso de aprobación de candidatos", dice la declaración de marketing de la compañía, "nunca la dejarían sola con su preciosa hija".

Sin embargo, los expertos en tecnología dicen que el sistema emite advertencias por sí solo, jugando con los temores de los padres para vender los resultados del escaneo de personalidad con precisión no verificada.

También plantean preguntas sobre cómo se entrenan dichos sistemas y cuán vulnerables son a los errores que pueden surgir de las incertidumbres asociadas con el uso de las redes sociales por parte de las niñeras. Los padres solo reciben una advertencia sobre conducta dudosa, sin ciertas frases, enlaces u otros detalles por los cuales puedan tomar su decisión.

Cuando un escaneo de una niñera emitió una advertencia sobre una posible persecución de su parte, una madre emocionada que solicitó esta evaluación dijo que no podía averiguar si el programa notó una cita de una película, canción u otra frase antigua que ella tomó por declaraciones realmente peligrosas. .

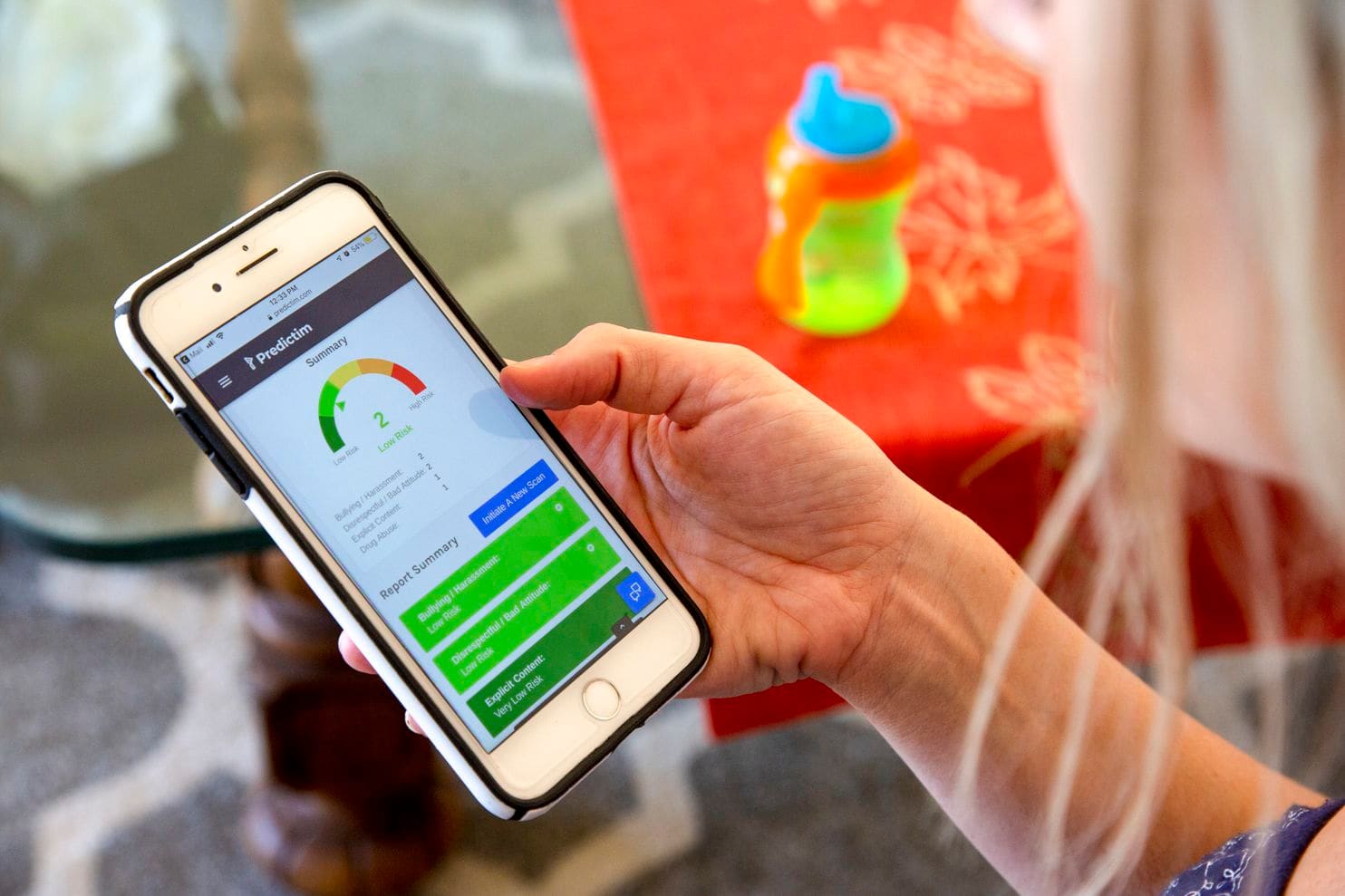

El teléfono de Jesse muestra los resultados de la aplicación Predictim.

El teléfono de Jesse muestra los resultados de la aplicación Predictim.Jamie Williams, un abogado de la Electronic Frontier Foundation, un grupo de derechos civiles, dijo que con respecto a la mayoría de los algoritmos utilizados hoy para evaluar el significado de palabras y fotografías, se sabe que carecen de contexto humano y sentido común. Incluso los gigantes tecnológicos como Facebook tuvieron dificultades para crear algoritmos que pudieran distinguir entre comentarios inocuos y enojados.

“¿Cómo puedes probar este sistema para evaluar a los adolescentes: son niños! - dijo Williams - Los niños tienen sus propios chistes, son famosos por el sarcasmo. "Lo que una persona puede pensar del algoritmo como" malos modales "puede considerarse como una declaración política o crítica legítima".

Y cuando el sistema está mal, digamos, diciendo que la niñera está abusando de las drogas, los padres no podrán enterarse del error. Las calificaciones claras y las evaluaciones de la precisión del sistema pueden hacer que los padres esperen de él mucha más precisión y autoritarismo de lo que una persona en su lugar podría prometer. Como resultado, los padres se sentirán inclinados a contratar niñeras a quienes de otro modo evitarían, o se alejarán de las personas que ya se han ganado su confianza.

"No existe una métrica que pueda decir con precisión si estos métodos son tan efectivos en sus predicciones como los creadores declaran", dijo Miranda Bogen, analista jefe del grupo de expertos de Upturn en Washington, que estudia el uso de algoritmos para la toma de decisiones y la adjudicación automáticas. . "Es probable que el atractivo de estas tecnologías supere sus capacidades reales".

Malissa Nielsen, una niñera de 24 años que trabaja para Bataglia, recientemente dio a otras dos familias acceso a sus redes sociales para su evaluación en Predictim. Dijo que siempre fue cautelosa con las redes sociales y decidió que podía compartir información adicional sin hacerse daño. Ella va a la iglesia semanalmente, no jura y termina de recibir la educación de un maestro en el campo de la enseñanza de niños pequeños, después de lo cual espera abrir un jardín de infantes.

Sin embargo, cuando se enteró de que el sistema le daba marcas no ideales basadas en la falta de respeto y la intimidación, se sorprendió. Ella creía que permitir a los padres estudiar su presencia en las redes sociales, y no el algoritmo, un análisis crítico de su personalidad. Tampoco fue informada de los resultados de una prueba que podría dañar su única fuente de ingresos.

“Me gustaría entender un poco este problema. ¿Por qué este programa pensó en mí así? - dijo Nielsen "La computadora no tiene sentimientos; no puede detectar todo eso".

Los estadounidenses aún no confían en los algoritmos cuyas decisiones pueden afectar su vida diaria. En una encuesta del Pew Research Center este mes, el 57% de los encuestados calificó el procesamiento automático de currículums para candidatos a empleo como "inaceptable".

Sin embargo, Predictim informa que se están preparando para expandir el trabajo en todo el país. Los gerentes de Sittercity, un servicio de niñeras en línea visitado por millones de padres, hablan sobre el lanzamiento de un programa piloto que integrará las calificaciones automáticas de Predictim en el conjunto actual de calificaciones automáticas y verificaciones de servicio.

"Encontrar una niñera está lleno de incertidumbres", dijo Sandra Dainora, directora de producto de Sittercity, quien cree que tales herramientas pronto pueden convertirse en estándar en las búsquedas en línea de cuidadores. "Los padres están en constante búsqueda de la mejor solución, la investigación más completa, los hechos más confiables".

Los gerentes de Predictim también creen que pueden expandir seriamente las capacidades del sistema y ofrecer evaluaciones aún más personales de la vida privada de la niñera. Joel Simonov, director de tecnología, dijo que el equipo está interesado en obtener "datos psicométricos útiles" basados en el análisis de la actividad de las niñeras en las redes sociales, pasando sus historias a través de una prueba de identidad, por ejemplo, la tipología de Myers-Briggs, para proporcionar estos resultados a los padres.

La minería en las redes sociales y el interés de Predictim en el análisis psicológico masivo es similar a las ambiciones de Cambridge Analytica, una compañía de asesoramiento político que trabajó para apoyar la campaña electoral de Trump y luego involucró a Facebook en un escándalo de identidad global. Sin embargo, los líderes de Predictim afirman haber establecido controles de seguridad internos y están trabajando para proteger los datos personales de las niñeras. "Si tuviéramos una fuga de datos de la niñera, eso no sería genial", dijo Simonov.

Los expertos temen que los sistemas de calificación basados en IA presagien un futuro en el que la recepción de una persona de cualquier trabajo no necesariamente relacionado con el cuidado de niños dependerá de la máquina. Muchas compañías de reclutamiento y reclutamiento ya están creando o invirtiendo en sistemas que pueden analizar hojas de vida de candidatos a gran escala y emitir calificaciones automáticas de candidatos. Se utilizan sistemas de IA similares, incluido Jigsaw, una incubadora de tecnología creada por Google, para rastrear comentarios en línea en busca de acoso, amenazas y crueldad.

Sin embargo, ya se ha demostrado más de una vez cómo los algoritmos para encontrar empleados ocultan fallas que pueden arruinar la carrera de una persona. Amazon.com detuvo el desarrollo del algoritmo de contratación, al enterarse de que subestima ilegalmente a las mujeres, ya que el historial de contratación de la compañía, que sigue la tendencia de la industria tecnológica de contratar hombres, enseñó al sistema a preferir candidatos masculinos. La compañía dijo que nunca habían usado este programa para evaluar candidatos.

Algunos expertos en IA creen que tales sistemas tienen la capacidad de inflar seriamente los prejuicios relacionados con la edad o la raza, por ejemplo, marcando palabras o fotos importantes de ciertos grupos de personas con más frecuencia que otras. También les preocupa que Predictim obligue a las niñeras jóvenes a compartir sus datos personales solo para conseguir un trabajo.

Sin embargo, Diana Werner, madre de dos niños que viven en un suburbio de San Francisco, cree que las niñeras deberían compartir voluntariamente información personal para ayudar a tranquilizar a sus padres. "Verificar la biografía es algo bueno, pero Predictim estudia el tema en profundidad, diseccionando al individuo, su estado social e intelectual", dijo. Donde ella vive, "el 100% de los padres querrán usar dicho servicio", agregó. "Todos queremos obtener la niñera perfecta".