Hola a todos!

Hablemos, como habrás adivinado, de las redes neuronales y el aprendizaje automático. Por el nombre está claro lo que se dirá sobre las redes de densidad de mezcla, luego solo MDN, no quiero traducir el nombre y dejarlo como está. Sí, sí, sí ... habrá un poco aburrido de matemática y teoría de la probabilidad, pero sin ella, desafortunadamente o afortunadamente, depende de ti decidir si es difícil imaginar el mundo del aprendizaje automático. Pero me apresuro a tranquilizarte, será relativamente pequeño y no será muy difícil. De todos modos, puede omitirlo, pero solo mire una pequeña cantidad de código en Python y PyTorch, es cierto, escribiremos la red usando PyTorch, así como varios gráficos con los resultados. Pero lo más importante es que habrá una oportunidad de comprender un poco y comprender qué son las redes de MD.

Bueno, empecemos!

Regresión

Para empezar, refresquemos un poco nuestro conocimiento y recordemos, brevemente, qué

es la regresión lineal .

Tenemos un vector

X = \ {x_1, x_2, ..., x_n \} necesitamos predecir el valor

, que de alguna manera depende de

usando algún modelo lineal:

Como función de error, usaremos el error al cuadrado:

Este problema se puede resolver directamente tomando la derivada de SE y estableciendo su valor en cero:

Por lo tanto, simplemente encontramos su mínimo, y SE es una función cuadrática, lo que significa que el mínimo siempre existirá. Después de eso, ya puedes encontrar fácilmente

:

Eso es todo, el problema está resuelto. Aquí es donde terminamos de recordar qué es la regresión lineal.

Por supuesto, la dependencia inherente a la naturaleza de la generación de datos puede ser diferente y luego ya debe agregarse algo de no linealidad a nuestro modelo. Resolver el problema de regresión directamente para datos grandes y reales también es una mala idea, ya que existe una matriz

dimensiones

, y uno todavía necesita encontrar su matriz inversa, y a menudo sucede que tal matriz simplemente no existe. En este caso, nos ayudan varios métodos basados en el descenso de gradiente. La no linealidad de los modelos se puede implementar de varias maneras, incluido el uso de redes neuronales.

Pero ahora, hablemos no sobre esto, sino sobre las funciones de error. ¿Cuál es la diferencia entre SE y Log-Likelihood cuando los datos pueden tener una relación no lineal?

Nos ocupamos del zoológico, a saber: OLS, LS, SE, MSE, RSSTodo esto es uno y lo mismo en esencia, RSS - suma residual de cuadrados, OLS - mínimos cuadrados ordinarios, LS - mínimos cuadrados, MSE - error cuadrático medio, SE - error cuadrático. En diferentes fuentes puedes encontrar diferentes nombres. La esencia de esto es solo una:

desviación cuadrática . Puedes confundirte, por supuesto, pero te acostumbras rápidamente.

Vale la pena señalar que MSE es la desviación estándar, un cierto valor promedio del error para todo el conjunto de datos de entrenamiento. En la práctica, generalmente se usa MSE. La fórmula no es particularmente diferente:

- el tamaño del conjunto de datos,

- predicción del modelo para

.

Basta! ¿Probabilidad? Esto es algo de la teoría de la probabilidad. Así es, es pura teoría de la probabilidad. Pero, ¿cómo puede relacionarse la desviación cuadrática con la función de probabilidad? Y cómo resulta. Está relacionado con encontrar la máxima verosimilitud (Máxima verosimilitud) y con una distribución normal, para ser más precisos, con su promedio

.

Para darse cuenta de que esto es así, veamos nuevamente la función de desviación cuadrada:

Ahora suponga que la función de probabilidad tiene una forma normal, es decir, una distribución gaussiana o normal:

En general, cuál es la función de probabilidad y cuál es el significado de la misma, no lo diré, puede leer sobre ella en otro lugar, también debe familiarizarse con el concepto de probabilidad condicional, el teorema de Bayes y mucho más, para una comprensión más profunda. Todo esto entra en la teoría pura de la probabilidad, que se estudia tanto en la escuela como en la universidad.

Ahora, recordando la fórmula de distribución normal, obtenemos:

¿Qué pasa si ponemos la desviación estándar

y elimine todas las constantes en la fórmula (2), simplemente elimine, no reduzca, porque encontrar el mínimo de la función no depende de ellas. Entonces veremos esto:

Todavía nada como? No? Bueno, ¿y si tomamos el logaritmo de la función? Del logaritmo, en general, hay algunas ventajas: la multiplicación se convertirá en una suma, un grado en multiplicación y

- para esta propiedad vale la pena aclarar que estamos hablando del logaritmo natural y, estrictamente hablando

. Y en general, el logaritmo de una función no cambia su máximo, y esta es la característica más importante para nosotros. La conexión con Log-Likelihood y Likelihood y por qué esto será útil se describirá a continuación en una pequeña digresión. Y entonces, lo que hicimos: eliminamos todas las constantes y tomamos el logaritmo de la función de probabilidad. También eliminaron el signo menos, convirtiendo así la probabilidad de registro en probabilidad de registro negativa (NLL), la conexión entre ellos también se describirá como una bonificación. Como resultado, obtuvimos la función NLL:

Eche otro vistazo a la función RSS (1). Sí, son lo mismo! Exactamente! También se ve que

.

Si utiliza la función de desviación estándar de MSE, obtenemos de esto:

donde

- expectativa matemática

- parámetros del modelo, en el futuro los denominaremos como:

.

Conclusión: Si la familia LS se usa como una función de error en la pregunta de regresión, entonces esencialmente resolvemos el problema de encontrar la función de máxima verosimilitud en el caso en que la distribución es gaussiana. Y el valor predicho

igual al promedio en la distribución normal. Y ahora sabemos cómo está conectado todo esto, cómo la teoría de probabilidad (con su función de probabilidad y distribución normal) y los métodos de desviación estándar u OLS están conectados. Se pueden encontrar más detalles sobre esto en [2].

Y aquí está el bono prometido. Como estamos hablando de las relaciones entre las diversas funciones de error, consideraremos (no necesariamente para ser leídas):

La relación entre Cross-Entropy, Likelihood, Log-Likelihood y Negative Log-LikelihoodSupongamos que tenemos datos

X = \ {x_1, x_2, x_3, x_4, ... \} , cada punto pertenece a una clase específica, por ejemplo

\ {x_1 \ rightarrow1, x_2 \ rightarrow2, x_3 \ rightarrow n, ... \} . Total allí

clases, mientras que ocurre la clase 1

veces, clase 2 -

tiempos y clase

-

tiempos Sobre estos datos entrenamos algún modelo

. La función de verosimilitud (verosimilitud) se verá así:

donde

- probabilidad pronosticada para la clase

.

Tomamos el logaritmo de la función de probabilidad y obtenemos Log-Likelihood:

Probabilidad

se encuentra en el rango de 0 a 1, basado en la definición de probabilidad. Por lo tanto, el logaritmo tendrá un valor negativo. Y si multiplicamos Log-Likelihood por -1 obtenemos la función Negative Log-Likelihood (NLL):

Si dividimos la NLL por el número de puntos en

,

entonces obtenemos:

Se puede observar que la probabilidad real de la clase

es igual a:

. Desde aquí obtenemos:

ahora si nos fijamos en la definición de entropía cruzada

entonces obtenemos:

En el caso de que solo tengamos dos clases

(clasificación binaria) obtenemos la fórmula para la entropía cruzada binaria (también puede conocer el conocido nombre Log-Loss):

De todo esto, puede entenderse que, en algunos casos, minimizar la entropía cruzada es equivalente a minimizar el NLL o encontrar el máximo de la función de probabilidad (Probabilidad) o Log-Probabilidad.

Un ejemplo Considere una clasificación binaria. Tenemos valores de clase:

y = np.array([0, 1, 1, 1, 1, 0, 1, 1]).astype(np.float32)

Probabilidad real

para la clase 0 es igual

, para la clase 1 es igual

. Supongamos que tenemos un clasificador binario que predice la probabilidad de la clase 0

para cada ejemplo, respectivamente, para la clase 1, la probabilidad es

. Tracemos los valores de la función de pérdida de registro para diferentes predicciones

:

En el gráfico puede ver que el mínimo de la función Log-Loss corresponde al punto 0.75, es decir. si nuestro modelo "aprendió" completamente la distribución de los datos de origen, . Regresión de la red neuronal

Entonces llegamos a una práctica más interesante. Veamos cómo puede resolver el problema de la regresión utilizando redes neuronales (redes neuronales). Implementaremos todo en el lenguaje de programación Python, para crear una red utilizamos la biblioteca de aprendizaje profundo PyTorch.

Generación de datos fuente

Datos de entrada

generar usando una distribución uniforme, tomar el intervalo de -15 a 15,

. Puntos

obtenemos usando la ecuación:

donde

Es un vector de ruido de dimensión

obtenido utilizando la distribución normal con parámetros:

.

El gráfico de los datos recibidos.Construcción de redes

Cree una red neuronal de avance directo o FFNN.

Building FFNN class Net(nn.Module): def __init__(self, input_dim=IN_DIM, out_dim=OUT_DIM, layer_size=40): super(Net, self).__init__() self.fc = nn.Linear(input_dim, layer_size) self.logit = nn.Linear(layer_size, out_dim) def forward(self, x): x = F.tanh(self.fc(x))

Nuestra red consta de una capa oculta con una dimensión de 40 neuronas y con una función de activación: tangente hiperbólica:

La capa de salida es una transformación lineal normal sin una función de activación.

Aprendiendo y obteniendo resultados

Como optimizador usaremos AdamOptimizer. El número de épocas de estudio = 2000, la tasa de aprendizaje (tasa de aprendizaje o lr) = 0.1.

Entrenamiento FFNN def train(net, x_train, y_train, x_test, y_test, epoches=2000, lr=0.1): criterion = nn.MSELoss() optimizer = optim.Adam(net.parameters(), lr=lr) N_EPOCHES = epoches BS = 1500 n_batches = int(np.ceil(x_train.shape[0] / BS)) train_losses = [] test_losses = [] for i in range(N_EPOCHES): for bi in range(n_batches): x_batch, y_batch = fetch_batch(x_train, y_train, bi, BS) x_train_var = Variable(torch.from_numpy(x_batch)) y_train_var = Variable(torch.from_numpy(y_batch)) optimizer.zero_grad() outputs = net(x_train_var) loss = criterion(outputs, y_train_var) loss.backward() optimizer.step() with torch.no_grad(): x_test_var = Variable(torch.from_numpy(x_test)) y_test_var = Variable(torch.from_numpy(y_test)) outputs = net(x_test_var) test_loss = criterion(outputs, y_test_var) test_losses.append(test_loss.item()) train_losses.append(loss.item()) if i%100 == 0: sys.stdout.write('\r Iter: %d, test loss: %.5f, train loss: %.5f' %(i, test_loss.item(), loss.item())) sys.stdout.flush() return train_losses, test_losses net = Net() train_losses, test_losses = train(net, x_train, y_train, x_test, y_test)

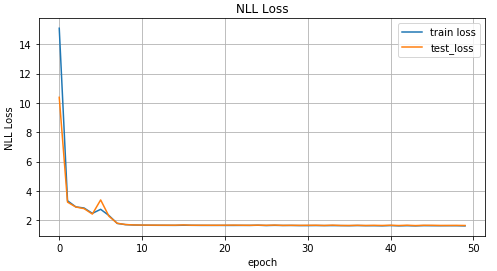

Ahora veamos los resultados del aprendizaje.

Gráfico de valores de función MSE dependiendo de la iteración del entrenamiento; gráfico de valores para datos de entrenamiento y datos de prueba.Resultados reales y pronosticados en datos de prueba.Datos invertidos

Complicamos la tarea e invertimos los datos.

Inversión de datos x_train_inv = y_train y_train_inv = x_train x_test_inv = y_train y_test_inv = x_train

Gráfico de datos invertidos.Para la predicción

usemos la red de distribución directa de la sección anterior y veamos cómo maneja esto.

inv_train_losses, inv_test_losses = train(net, x_train_inv, y_train_inv, x_test_inv, y_test_inv)

Gráfico de valores de función MSE dependiendo de la iteración del entrenamiento; gráfico de valores para datos de entrenamiento y datos de prueba.Resultados reales y pronosticados en datos de prueba.Como puede ver en los gráficos anteriores, nuestra red no

hizo frente a tales datos, simplemente no puede predecirlos. Y todo esto sucedió porque en un problema tan invertido por un punto

puede corresponder a varios puntos

. Usted pregunta, ¿qué pasa con el ruido? También creó una situación en la que para uno

podría obtener algunos valores

. Sí, eso es correcto. Pero el punto es que, a pesar del ruido, se trataba de una distribución definitiva. Y dado que nuestro modelo esencialmente predijo

, y en el caso de MSE, fue el valor promedio de la distribución normal (por qué se describe en la primera parte del artículo), luego se ocupó bien de la tarea "directa". De lo contrario, obtenemos varias distribuciones diferentes para uno

y en consecuencia no podemos obtener un buen resultado con solo una distribución normal.

Red de densidad de mezcla

¡Comienza la diversión! ¿Qué es la red de densidad de mezcla (en adelante, red MDN o MD)? En general, este es un cierto modelo que puede simular varias distribuciones a la vez:

Qué fórmula más extraña, dices. Vamos a resolverlo. Nuestra red de MD está aprendiendo a modelar la media

y varianza

para distribuciones

múltiples . En la fórmula (5)

- los llamados factores de significación de una distribución separada para cada punto

, un determinado factor de mezcla o cuánto contribuye cada una de las distribuciones a un determinado punto. Total allí

distribuciones

Algunas palabras más sobre

- de hecho, esto también es una distribución y representa la probabilidad de que para un punto

será una condición

.

Fuh, de nuevo, esta matemática, ya escribamos algo. Y así, comenzaremos a realizar una red. Para nuestra red tomamos

.

self.fc = nn.Linear(input_dim, layer_size) self.fc2 = nn.Linear(layer_size, 50) self.pi = nn.Linear(layer_size, coefs) self.mu = nn.Linear(layer_size, out_dim*coefs)

Defina las capas de salida para nuestra red:

x = F.relu(self.fc(x)) x = F.relu(self.fc2(x)) pi = F.softmax(self.pi(x), dim=1) sigma_sq = torch.exp(self.sigma_sq(x)) mu = self.mu(x)

Escribimos la función de error o la función de pérdida, fórmula (5):

def gaussian_pdf(x, mu, sigma_sq): return (1/torch.sqrt(2*np.pi*sigma_sq)) * torch.exp((-1/(2*sigma_sq)) * torch.norm((x-mu), 2, 1)**2) losses = Variable(torch.zeros(y.shape[0]))

Código de compilación MDN completo COEFS = 30 class MDN(nn.Module): def __init__(self, input_dim=IN_DIM, out_dim=OUT_DIM, layer_size=50, coefs=COEFS): super(MDN, self).__init__() self.fc = nn.Linear(input_dim, layer_size) self.fc2 = nn.Linear(layer_size, 50) self.pi = nn.Linear(layer_size, coefs) self.mu = nn.Linear(layer_size, out_dim*coefs)

Nuestra red de MD está lista para funcionar. Casi listo Queda por entrenarla y ver los resultados.

MDN Training def train_mdn(net, x_train, y_train, x_test, y_test, epoches=1000): optimizer = optim.Adam(net.parameters(), lr=0.01) N_EPOCHES = epoches BS = 1500 n_batches = int(np.ceil(x_train.shape[0] / BS)) train_losses = [] test_losses = [] for i in range(N_EPOCHES): for bi in range(n_batches): x_batch, y_batch = fetch_batch(x_train, y_train, bi, BS) x_train_var = Variable(torch.from_numpy(x_batch)) y_train_var = Variable(torch.from_numpy(y_batch)) optimizer.zero_grad() pi, mu, sigma_sq = net(x_train_var) loss = loss_fn(y_train_var, pi, mu, sigma_sq) loss.backward() optimizer.step() with torch.no_grad(): if i%10 == 0: x_test_var = Variable(torch.from_numpy(x_test)) y_test_var = Variable(torch.from_numpy(y_test)) pi, mu, sigma_sq = net(x_test_var) test_loss = loss_fn(y_test_var, pi, mu, sigma_sq) train_losses.append(loss.item()) test_losses.append(test_loss.item()) sys.stdout.write('\r Iter: %d, test loss: %.5f, train loss: %.5f' %(i, test_loss.item(), loss.item())) sys.stdout.flush() return train_losses, test_losses mdn_net = MDN() mdn_train_losses, mdn_test_losses = train_mdn(mdn_net, x_train_inv, y_train_inv, x_test_inv, y_test_inv)

Como nuestra red ha aprendido los valores medios para varias distribuciones, veamos esto:

pi, mu, sigma_sq = mdn_net(Variable(torch.from_numpy(x_test_inv)))

Representa gráficamente los dos valores medios más probables para cada punto (izquierda). Representa gráficamente los 4 valores medios más probables para cada punto (derecha).Representa gráficamente todos los valores medios para cada punto.Para predecir datos, seleccionaremos al azar varios valores

y

basado en el valor

. Y luego basado en ellos para generar datos objetivo

utilizando distribución normal.

Predicción de resultado def rand_n_sample_cumulative(pi, mu, sigmasq, samples=10): n = pi.shape[0] out = Variable(torch.zeros(n, samples, OUT_DIM)) for i in range(n): for j in range(samples): u = np.random.uniform() prob_sum = 0 for k in range(COEFS): prob_sum += pi.data[i, k] if u < prob_sum: for od in range(OUT_DIM): sample = np.random.normal(mu.data[i, k*OUT_DIM+od], np.sqrt(sigmasq.data[i, k])) out[i, j, od] = sample break return out pi, mu, sigma_sq = mdn_net(Variable(torch.from_numpy(x_test_inv))) preds = rand_n_sample_cumulative(pi, mu, sigma_sq, samples=10)

Datos pronosticados para 10 valores seleccionados al azar y (izquierda) y para dos (derecha).Se puede ver en las cifras que MDN hizo un excelente trabajo con la tarea "inversa".

Usando datos más complejos

Veamos cómo nuestra red de MD maneja datos más complejos, como los datos en espiral. La ecuación de la espiral hiperbólica en coordenadas cartesianas:

Generación de datos en espiral N = 2000 x_train_compl = [] y_train_compl = [] x_test_compl = [] y_test_compl = [] noise_train = np.random.uniform(-1, 1, (N, IN_DIM)).astype(np.float32) noise_test = np.random.uniform(-1, 1, (N, IN_DIM)).astype(np.float32) for i, theta in enumerate(np.linspace(0, 5*np.pi, N).astype(np.float32)):

Gráfico de datos en espiral.Por diversión, veamos cómo una red de Feed-Forward regular hará frente a tal tarea.

Como se esperaba, la red Feed-Forward no puede resolver el problema de regresión para dichos datos.Usamos la red de MD creada y descrita anteriormente para capacitarnos en datos espirales.

Mixture Density Network hizo un gran trabajo en esta situación.Conclusión

Al comienzo de este artículo, recordamos los conceptos básicos de la regresión lineal. Vimos eso en común entre encontrar el promedio para la distribución normal y MSE. Desmontó la conexión entre NLL y la entropía cruzada. Y lo más importante, descubrimos el modelo MDN, que puede aprender de los datos obtenidos de una distribución mixta. Espero que el artículo sea comprensible e interesante, a pesar del hecho de que hubo un poco de matemática.

El código completo se puede ver en

GitHub .

Literatura

- Redes de densidad de mezcla (Christopher M. Bishop, Grupo de Investigación de Computación Neural, Departamento de Informática y Matemáticas Aplicadas, Universidad de Aston, Birmingham) : el artículo describe completamente la teoría de las redes de MD.

- Mínimos cuadrados y máxima probabilidad (MROsborne)