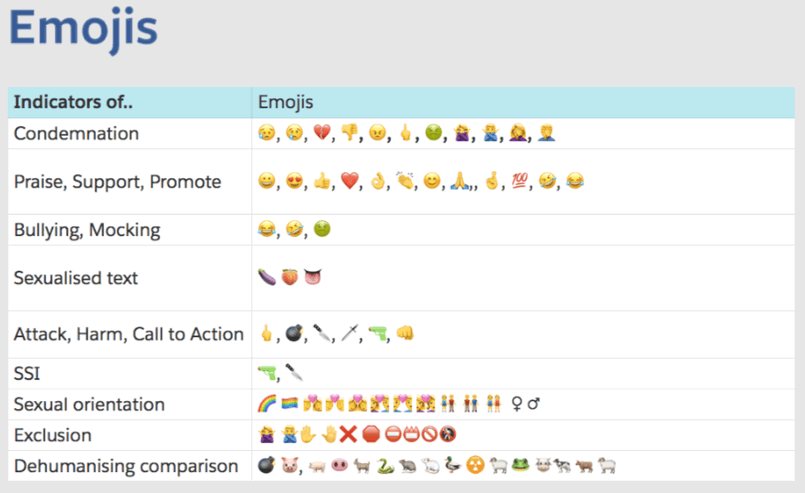

El manual explica qué emoticones pueden considerarse amenazas o, en el contexto de grupos específicos, para incitar al odio.

El manual explica qué emoticones pueden considerarse amenazas o, en el contexto de grupos específicos, para incitar al odio.Bajo el fuego de las críticas, Facebook se ve obligado a tomar medidas para moderar el contenido. Pero esta tarea no es tan simple como parece. Los medios de comunicación obtuvieron un manual interno para los moderadores de Facebook: estas son más de 1400 (!) Páginas de instrucciones, que a veces son muy difíciles de entender,

escribe el NY Times .

Hoy, los políticos y las organizaciones públicas acusan a la red social de incitar al odio y la desinformación. Para Facebook, esto es principalmente un problema financiero, porque tales acusaciones crean un fondo negativo y pueden afectar negativamente el precio de las acciones, lo que significa el bienestar de los propietarios y empleados de la empresa.

Facebook, que gana alrededor de $ 5 mil millones por trimestre, debería demostrar a todos que se toma en serio la lucha contra el contenido malicioso. Pero, ¿cómo hacer un seguimiento de miles de millones de mensajes por día en más de 100 idiomas, sin dejar de expandir la base de usuarios, que es la base de los negocios? La decisión de la compañía: una red de moderadores guiados por un laberinto de diapositivas de PowerPoint que explica el contenido prohibido.

"Todos los martes por la mañana, varias docenas de empleados de Facebook se reúnen para el desayuno para elaborar nuevas reglas y discutir lo que dos mil millones de usuarios del sitio tienen permitido decir", escribe el

NY Times . "Según los resultados de las reuniones, las reglas relevantes se envían a más de 7,500 moderadores en todo el mundo". El periódico tiene más de 1,400 páginas de libros de reglas. La información fue proporcionada por uno de los empleados que está preocupado por la moderación excesiva y demasiados errores que comete la empresa al moderar el contenido.

El examen de los documentos reveló numerosas lagunas, prejuicios y errores obvios. Obviamente, las reglas difieren para diferentes idiomas y países, como resultado de lo cual el discurso de odio puede florecer en algunas regiones y ser suprimido innecesariamente en otras. Por ejemplo, una vez que se les dijo a los moderadores que eliminaran las llamadas de recaudación de fondos para las víctimas del volcán en Indonesia, porque uno de los organizadores de la recaudación de fondos estaba en la lista negra de grupos prohibidos de Facebook. En India, a los moderadores se les dijo erróneamente que eliminaran los comentarios que criticaban la religión. En Myanmar, el grupo extremista continuó activo durante varios meses debido a un error en la documentación de Facebook.

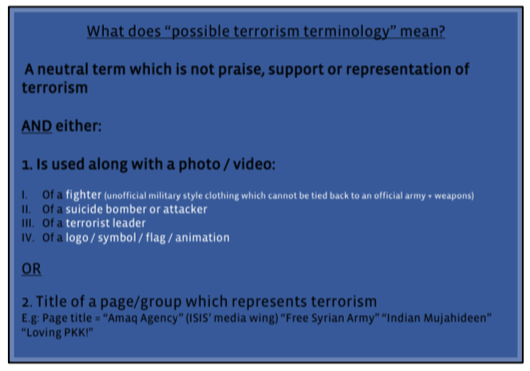

Captura de pantalla del manual de Facebook para moderadores

Captura de pantalla del manual de Facebook para moderadoresA juzgar por la documentación emergente, Facebook está tratando de formular principios para moderadores en forma de simples reglas de sí o no. Luego, la empresa transfiere la moderación real a empresas de terceros. Principalmente atraen a trabajadores no calificados, muchos de los cuales trabajan en centros de atención telefónica (el notorio "apoyo indio" - estos son los empleados que participan con moderación).

A menudo, los moderadores confían en Google Translate para trabajar. Los requisitos para su desempeño son tales que, en unos segundos, deben recordar las innumerables reglas y aplicarlas a los cientos de mensajes que aparecen en su computadora de trabajo todos los días. Por ejemplo, para recordar rápidamente las reglas en presencia de qué emoticón está prohibida la mención de la yihad.

Una captura de pantalla del manual de Facebook para moderadores, que explica los signos del discurso de odio. Los moderadores deben identificar tres niveles de "seriedad" basados en seis "comparaciones inhumanas", incluida una comparación entre judíos y ratas. Guía general para hablar sobre el odio 200 páginas

Una captura de pantalla del manual de Facebook para moderadores, que explica los signos del discurso de odio. Los moderadores deben identificar tres niveles de "seriedad" basados en seis "comparaciones inhumanas", incluida una comparación entre judíos y ratas. Guía general para hablar sobre el odio 200 páginasAlgunos moderadores dicen que las reglas no son muy efectivas y algunas veces no tienen sentido. Sin embargo, la gerencia de la compañía cree que no es de otra manera: "Tenemos miles de millones de mensajes por día, y estamos identificando más y más violaciones potenciales usando nuestros sistemas técnicos", dice Monika Bickert, Directora de Política Global de Facebook. "En tal escala, incluso el 99% de precisión deja muchos errores".

El manual de Facebook que llegó a la prensa no parece una guía clara. Consiste en docenas de presentaciones fragmentadas de PowerPoint y hojas de cálculo de Excel con titulares burocráticos como "Las organizaciones e individuos de odio de los Balcanes Occidentales" o "Violencia explícita: estándares de implementación". Este es un tipo de "mosaico" de las reglas establecidas por los diferentes departamentos de la empresa. Facebook confirmó la autenticidad de los documentos, aunque dijo que algunos de ellos se actualizaron en comparación con la versión que entró en posesión del

NY Times . Facebook dice que los archivos son solo para fines de capacitación, pero los moderadores dicen que en realidad se usan como materiales de referencia en el trabajo diario.