L'algorithme DeepStereo colle les clichés de Google Street View dans une vidéo fluide

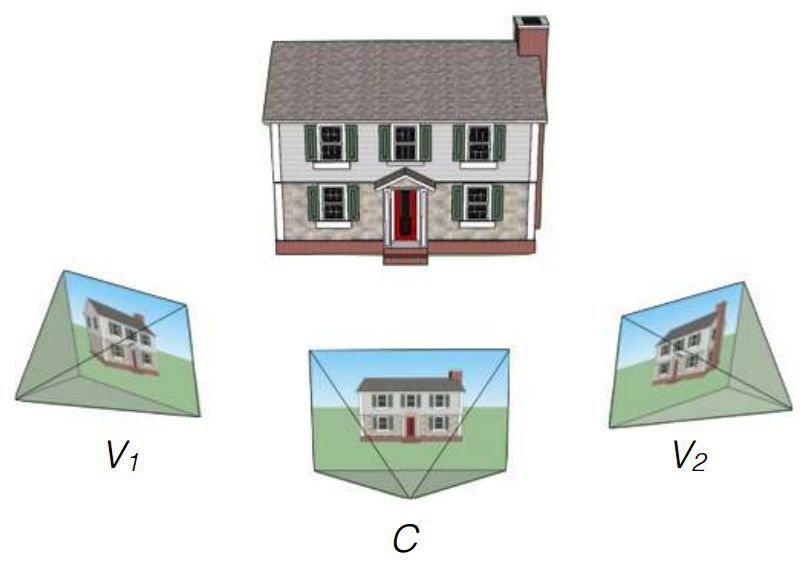

Les chercheurs de Google John Flynn, Ivan Nyulander, James Filbin et Noah Sneyvli ont créé un algorithme qui peut combiner des images du service de vue panoramique Street View en vidéos fluides avec des artefacts à peine perceptibles. L'algorithme est appelé DeepStereo, un exemple de son fonctionnement est présenté ci-dessus. L'utilisation probable de la technologie créée comprend la création d'animations simples, le traitement d'images, le cinéma et la réalité virtuelle.Il n'est pas toujours possible d'évaluer correctement un certain endroit uniquement par des cartes ou des photographies numériques. Regarder la rue d'une hauteur juste au-dessus de la taille humaine aide des services comme Google Street View. Mais ce sont des photos collées dans le panorama, pas des vidéos.Si vous devez créer une animation pour avancer à partir de prises de vue individuelles, la décision de simplement perdre la séquence d'images ne fonctionnera pas - cela se révélera trop rapide, car les images changeront à une fréquence d'au moins 24 images par seconde. Si vous conduisez sur une route ou une autoroute large et plate, vous pouvez créer une bonne animation dans le style du ralenti. Mais Google Street View a des panoramas de musées et de rues fleuries - le laps de temps d'un changement de cadre rapide ne fonctionnera pas ici. Besoin d'images manquantes entre les prises de vue. L'algorithme créé y est engagé.L'équipe de chercheurs a utilisé les connaissances approfondies de l'entreprise pour former l'algorithme. À l'entrée, il y a un ensemble d'images à partir de certains points, et le but est de créer de nouvelles images à partir d'autres points. La solution exacte à ce problème nécessite la construction d'un modèle d'environnement 3D, ce qui est le plus souvent impossible en raison d'obstacles. Le défi n'est pas nouveau. Certaines méthodes précédentes ont des problèmes qui conduisent à des lacunes près des barrières, à l'aliasing et au flou. Des difficultés particulières sont causées par les arbres et autres objets dont les éléments individuels peuvent obscurcir la vue. La nouvelle méthode de Flynn utilise une formation en vision par ordinateur afin qu'il puisse comprendre quels objets devraient se trouver dans les images manquantes. Pour la formation, des ensembles d'images d'une voiture en mouvement ont été utilisés. Les chercheurs disent que le volume de la base pour la formation s'élevait à 100 000 ensembles d'images.Ensuite, les tests ont été effectués en utilisant des séquences de trois plans de Google Street View. L'algorithme a été contraint de traiter deux images extrêmes et de présenter une variante de l'intermédiaire. La comparaison avec l'original a permis d'évaluer le travail.Le résultat final de l'équipe DeepStereo est crédible. À première vue, il n'est pas si facile de distinguer la vraie photographie. Les artefacts notables incluent une légère perte de résolution et la disparition de fines structures au premier plan. Les objets dont la structure complexe chevauche leurs propres détails peuvent apparaître flous. L'algorithme n'est également pas en mesure de créer des surfaces qui ne sont pas dans les images d'origine. Les objets en mouvement (piétons, voitures) sont intentionnellement flous pour créer un effet de mouvement.Une puissance de calcul impressionnante est requise pour le rendu. Pour créer une seule image avec une résolution de 512 × 512 pixels, environ 12 minutes de fonctionnement d'un système multicœur avec des caractéristiques techniques sans nom sont nécessaires. La création d'images à plus haute résolution nécessite trop de RAM. Les chercheurs expriment leur espoir d'optimiser l'algorithme avec la possibilité de réduire le temps de rendu à plusieurs minutes, voire quelques secondes lors de l'utilisation de processeurs de carte vidéo. À l'avenir, avec un raffinement significatif, le fonctionnement de l'algorithme sur le GPU est possible même en temps réel.Basé sur le texte de l'étude et la MIT Technology Review . arXiv: 1506.06825 [cs.CV]

La nouvelle méthode de Flynn utilise une formation en vision par ordinateur afin qu'il puisse comprendre quels objets devraient se trouver dans les images manquantes. Pour la formation, des ensembles d'images d'une voiture en mouvement ont été utilisés. Les chercheurs disent que le volume de la base pour la formation s'élevait à 100 000 ensembles d'images.Ensuite, les tests ont été effectués en utilisant des séquences de trois plans de Google Street View. L'algorithme a été contraint de traiter deux images extrêmes et de présenter une variante de l'intermédiaire. La comparaison avec l'original a permis d'évaluer le travail.Le résultat final de l'équipe DeepStereo est crédible. À première vue, il n'est pas si facile de distinguer la vraie photographie. Les artefacts notables incluent une légère perte de résolution et la disparition de fines structures au premier plan. Les objets dont la structure complexe chevauche leurs propres détails peuvent apparaître flous. L'algorithme n'est également pas en mesure de créer des surfaces qui ne sont pas dans les images d'origine. Les objets en mouvement (piétons, voitures) sont intentionnellement flous pour créer un effet de mouvement.Une puissance de calcul impressionnante est requise pour le rendu. Pour créer une seule image avec une résolution de 512 × 512 pixels, environ 12 minutes de fonctionnement d'un système multicœur avec des caractéristiques techniques sans nom sont nécessaires. La création d'images à plus haute résolution nécessite trop de RAM. Les chercheurs expriment leur espoir d'optimiser l'algorithme avec la possibilité de réduire le temps de rendu à plusieurs minutes, voire quelques secondes lors de l'utilisation de processeurs de carte vidéo. À l'avenir, avec un raffinement significatif, le fonctionnement de l'algorithme sur le GPU est possible même en temps réel.Basé sur le texte de l'étude et la MIT Technology Review . arXiv: 1506.06825 [cs.CV] Source: https://habr.com/ru/post/fr381787/

All Articles