Nous avons décidé d'essayer dans la pratique une nouvelle tendance dans la communauté informatique, à savoir le stockage défini par logiciel. Nous avons demandé à nos merveilleux fournisseurs un terrain d'essai.Configuration du stand:

Nous avons demandé à nos merveilleux fournisseurs un terrain d'essai.Configuration du stand:- 3 serveurs SuperMicro X9SCL / X9SCM de la configuration suivante:

- Processeur Intel E3-1220V2: 4 cœurs x 3,1 GHz

- RAM - 16 Go

- Adaptateur RAID Adaptec 6405E: 2x300 Go SAS 10K, 1x180 Go SSD - tous les disques doivent être configurés en mode JBOD

- 2x500GB SATA 7.4K connectés aux connecteurs sur le tapis. carte de circuit imprimé

- Carte réseau 2x1 Go

En fait, il existe de nombreuses solutions Virtual SAN maintenant, Starwind VSAN a chuté en raison des limitations importantes de la version gratuite, qui a tué toutes les fonctionnalités intéressantes, VMWARE VSAN a chuté en raison des exigences matérielles et du coût de possession élevé, ce qui n'est pas optimal pour les petits budgets régionaux, ainsi que pour le fait que ceux-ci. Les spécialistes VMWARE en marge ne recommandent pas d'utiliser leur VSAN pour les applications critiques. En conséquence, nous avons choisi une solution de Nutanix et EMC ScaleIO.ScaleIO est un SAN virtuel défini par logiciel d'EMC, peut fonctionner en mode libre sans presque aucune restriction (écrit dans la licence pour une utilisation hors production!) - le seul inconvénient grave est que ce système n'a pas de mécanismes intégrés pour la suppression automatique des données ou la mise en cache, j'utilise des disques SSD. (contrairement à concurrents à qui le SSD donne un sérieux avantage sur la vitesse des machines virtuelles). Sur le plan architectural, il ressemble fortement au système de stockage IBM XIV d'entreprise haut de gamme - même la taille de bloc est la même - 1 Mo.J'ai lu des exigences minimales contradictoires dans différentes sources:- Voici la configuration minimale requise pour une implémentation ScaleIO 1.31 et 1.32:

- La solution ScaleIO 1.31 et 1.32 n'est prise en charge que sur ESXi 5.5 GA.

- Trois serveurs ESXi avec 100 Go de capacité libre par serveur

- Réseau 1 gbps

- Quatre disques SATA de 7 200 tr / min par nœud

Cependant, dans la pratique, pour la version 1.32, ces restrictions n'étaient pas respectées.Étant donné qu'en production, nous utilisons le VMWARE racialement correct et que nous n'aimons pas le Hyper-V non orthodoxe, nous avons sélectionné la version d'essai de VMWARE ESXi 6.0 pour le déploiement en tant qu'hyperviseur. Par souci d'équité, il convient de noter que ScaleIO fonctionne correctement sur les hyperviseurs XEN, ESXi et Hyper-V suivants; sur ce dernier, avec l'aide de Windows 2012 r2, les artisans ont contourné le manque de mise en cache de la baie SSD à l'aide des outils intégrés de 2012 R2, ce qui a bien sûr eu un effet positif sur les performances du système. (il existe une technique sur Internet)Vous devez d'abord installer l'hyperviseur ESXi sur tous les hôtes et installer l'appliance VCENTER pour gérer le cluster VMWARE. Le premier incident nous attendait juste là - ESXi n'a jamais voulu voir le contrôleur Adaptec 6405E, bien qu'il soit présent dans VMWARE HCL.Nous téléchargeons les pilotes (Offline-Bundles et VIB) à partir du site Web Adaptec pour VMWARE et via VMWARE powercli en utilisant cet outil, nous préparons une image personnalisée de l'hyperviseur avec des pilotes intégrés - après cela, tout s'est bien passé.Ensuite, la virtualisation de l'appliance VCENTER est déployée et, encore une fois, via vmware powercli, les plug-ins ScaleIO sont enregistrés et les modèles de machine virtuelle ScaleIO au format .ova sont copiés dans le magasin de données (selon les instructions d'installation de ScaleIO).Après avoir redémarré tous les hôtes, le système est prêt à travailler sur l'installation de ScaleIO.Je recommande fortement de lire les instructions de déploiement, sinon de nombreux points seront incompréhensibles:- par exemple, vous devez comprendre des choses telles que le domaine de protection et comment il se rapporte aux pools de stockage,- quelles sont les recommandations pour créer des pools de stockage (qui ne devraient pas interférer avec le disque dur et le SSD , bien que cela soit possible)- pour comprendre ce qu'est FaultSets, bien que nous ne l'ayons pas utilisé. Comprendre ce qu'est la politique ZeroPadding, la politique de cache RAM et ses options, la politique de rechange. De nombreusesnuances ScaleIO ne prend pas en charge la possibilité d'utiliser des disques SSD comme cache pour un tableau de données! C'est une caractéristique désagréable. Les pools de SSD peuvent être collectés, mais ce sera juste un pool uniquement flash - rien de plus!

Nous vous recommandons d'utiliser l'adaptateur RAID de cache en lecture / écriture comme élément de cache s'il est équipé d'une batterie, et il existe également une fonction RAM CACHE lors de la création d'un domaine de protection qui utilise une partie de la RAM de l'hôte de virtualisation comme cache de baie! (sur 16 Go de RAM, nous avons réussi à allouer 1,3 Go de cache dans les paramètres, lisez la documentation)Vous avez également besoin de 2 VLAN virtuels: gestion et données, vous devrez émettre chacun des 4 (dans la configuration minimale) gestion SVM (SVM - ScaleIO Virtual Machine) IP et DATA IP avec indication de la passerelle et des masques. (Il est fortement conseillé de préparer un plan d'adressage à l'avance afin de ne pas remplir tous les champs obligatoires 10 fois).Au total, en mode minimum, l'installation crée 4 SVM sur nos 3 hôtes (SVM - ScaleIO Virtual Machine), prend 8 cpu sur tous (2 sur l'hôte: 2 machines virtuelles sur le premier hôte, donc 4 vcpu), prend 12 Go de mémoire sur tous.SVM sur node1 - mdm principal, sds, sdcSVM sur node2 - mdm secondaire, sds, sdcSVM sur node3 - disjoncteur, sdcSVM sur n'importe quel nœud - passerelle - (mise à jour centralisée, surveillance, maintenance)mdm - Meta Data Manager - gère tables d'allocation de périphériquessds - serveur de données ScaleIO - contrôle la livraison des disques physiques via des disques RDM dans VMWARE (mappage de disque brut)sdc - ScaleIO data client - dans le cas de VMWARE, il est ajouté. modules du noyau qui sont intégrés pendant la phase de déploiement ScaleIO et vous permettent d'obtenir de meilleures performances que lorsqu'ils fonctionnent sur la machine virtuelle SVM elle-même.En outre, un très grand avantage d'avoir SDC dans le noyau est que les volumes de données créés sur ScaleIO sont présentés dans VMWARE directement sous forme de LUN pour créer une banque de données, sans utiliser une couche supplémentaire de virtualisation et de présentation des volumes via le mécanisme iSCSI. Le processus de déploiement ne s'est pas déroulé sans heurts, car nous n'avions pas les VLAN et les adresses IP nécessaires pour SVM prêt. Après avoir préparé les données et redémarré l'assistant d'installation à la dernière étape, ces erreurs ont commencé à nous échapper:Échec: Ajouter le périphérique SDS ScaleIO-4c1885e7 aux disques durs du pool de stockage (ScaleIO - Timeout)Avec ce qu'il était connecté, je ne peux pas le dire. Nous nous sommes assis, réessayé. Les erreurs précédentes ont disparu, mais d'autres erreurs sont apparues sur l'un des SVM sur host2:Échec: Ajouter le périphérique SDS ScaleIO-4c1885eb aux disques durs du pool de stockage (ScaleIO - Le SDS est déjà attaché à ce MDM)Nous nous sommes assis et avons pensé ... découvert sur l'un des SVM où le mdm secondaire était situé, pour une raison quelconque lors de l'installation, les mappages RDM aux disques physiques n'ont pas été créés et, par conséquent, le service SDS n'a pas augmenté. Ainsi, l'un des nœuds que nous n'avons pas démarré.Ils ont de nouveau cliqué sur le bouton «Déployer l'environnement scaleio» et, voilà, l'hôte et la machine virtuelle vide ont été trouvés inutilisés, ont à nouveau entré les données sur les VLAN et les adresses IP, et l'hôte a démarré normalement sans erreur.Après cela, un moment intéressant attendait au stade de la création du volume sur lequel nous placerons les données. Je n'ai pas pu trouver cet élément dans l'interface graphique: ni dans le tableau de bord GUI installé sur Windows, ni dans l'interface graphique VMWARE, ni dans l'interface Web de la passerelle. beaucoup d'instructions pour créer à partir de cli - trouvées par hasard sur un blog.Je donne une capture d'écran - où se trouve le bouton précieux pour créer du volume dans l'interface graphique de VMWARE.

Le processus de déploiement ne s'est pas déroulé sans heurts, car nous n'avions pas les VLAN et les adresses IP nécessaires pour SVM prêt. Après avoir préparé les données et redémarré l'assistant d'installation à la dernière étape, ces erreurs ont commencé à nous échapper:Échec: Ajouter le périphérique SDS ScaleIO-4c1885e7 aux disques durs du pool de stockage (ScaleIO - Timeout)Avec ce qu'il était connecté, je ne peux pas le dire. Nous nous sommes assis, réessayé. Les erreurs précédentes ont disparu, mais d'autres erreurs sont apparues sur l'un des SVM sur host2:Échec: Ajouter le périphérique SDS ScaleIO-4c1885eb aux disques durs du pool de stockage (ScaleIO - Le SDS est déjà attaché à ce MDM)Nous nous sommes assis et avons pensé ... découvert sur l'un des SVM où le mdm secondaire était situé, pour une raison quelconque lors de l'installation, les mappages RDM aux disques physiques n'ont pas été créés et, par conséquent, le service SDS n'a pas augmenté. Ainsi, l'un des nœuds que nous n'avons pas démarré.Ils ont de nouveau cliqué sur le bouton «Déployer l'environnement scaleio» et, voilà, l'hôte et la machine virtuelle vide ont été trouvés inutilisés, ont à nouveau entré les données sur les VLAN et les adresses IP, et l'hôte a démarré normalement sans erreur.Après cela, un moment intéressant attendait au stade de la création du volume sur lequel nous placerons les données. Je n'ai pas pu trouver cet élément dans l'interface graphique: ni dans le tableau de bord GUI installé sur Windows, ni dans l'interface graphique VMWARE, ni dans l'interface Web de la passerelle. beaucoup d'instructions pour créer à partir de cli - trouvées par hasard sur un blog.Je donne une capture d'écran - où se trouve le bouton précieux pour créer du volume dans l'interface graphique de VMWARE. Hourra, retrouvé! Mais les "acclamations" ne tardèrent pas. Selon la capture d'écran sur le pool de stockage avec le nom HDD (où j'ai combiné les 6 disques SAS des 3 nœuds), nous avons une capacité totale de 1,6 To (ce qui correspond généralement à 6x300 Go), mais le volume avec un tel volume n'est pas créé ... et on ne sait pas quoi volume disponible pour l'utilisateur. J'ai lu des instructions sur Internet comment utiliser la CLI pour voir le volume disponible. Nous sommes passés par SSH à l'un des SVM MDM - je donne la commande:

Hourra, retrouvé! Mais les "acclamations" ne tardèrent pas. Selon la capture d'écran sur le pool de stockage avec le nom HDD (où j'ai combiné les 6 disques SAS des 3 nœuds), nous avons une capacité totale de 1,6 To (ce qui correspond généralement à 6x300 Go), mais le volume avec un tel volume n'est pas créé ... et on ne sait pas quoi volume disponible pour l'utilisateur. J'ai lu des instructions sur Internet comment utiliser la CLI pour voir le volume disponible. Nous sommes passés par SSH à l'un des SVM MDM - je donne la commande:ScaleIO-10-1-4-203:~ # scli --query_storage_pool --protection_domain_name pd2 --storage_pool_name hdds

Error: MDM failed command. Status: Invalid session. Please login and try again.

Quelle?J'essaie sur le deuxième MDM: l'erreur est quelque chose comme ne peut pas se connecter localhost: 6611Sur la passerelle, il est généralement dit qu'il n'y a pas de telles commandes. Tout est stupeur! Il n'est pas clair comment utiliser la CLI.Nous étudions attentivement le guide d'utilisation sur ScaleIO, en particulier sur les principes de base de la CLI, et il indique tout en bas que vous devez également vous connecter à la CLI et la date du lien, comment le faire, mais vous devez le faire comme ceci:ScaleIO-10-1-4-203:~

Enter password:

Et après cela, toutes les équipes CLI ont commencé à travailler à merveille.scli --query_storage_pool --protection_domain_name pd2 --storage_pool_name hdds

Storage Pool hdds (Id: 574711eb00000000) has 0 volumes and

544.0 GB (557056 MB) available for volume allocation

Background device scanner: Disabled

Zero padding is disabled

Spare policy: 34% out of total

Uses RAM Read Cache

RAM Read Cache write handling mode is 'cached'

1.6 TB (1667 GB) total capacity

1.1 TB (1100 GB) unused capacity

567.1 GB (580708 MB) spare capacity

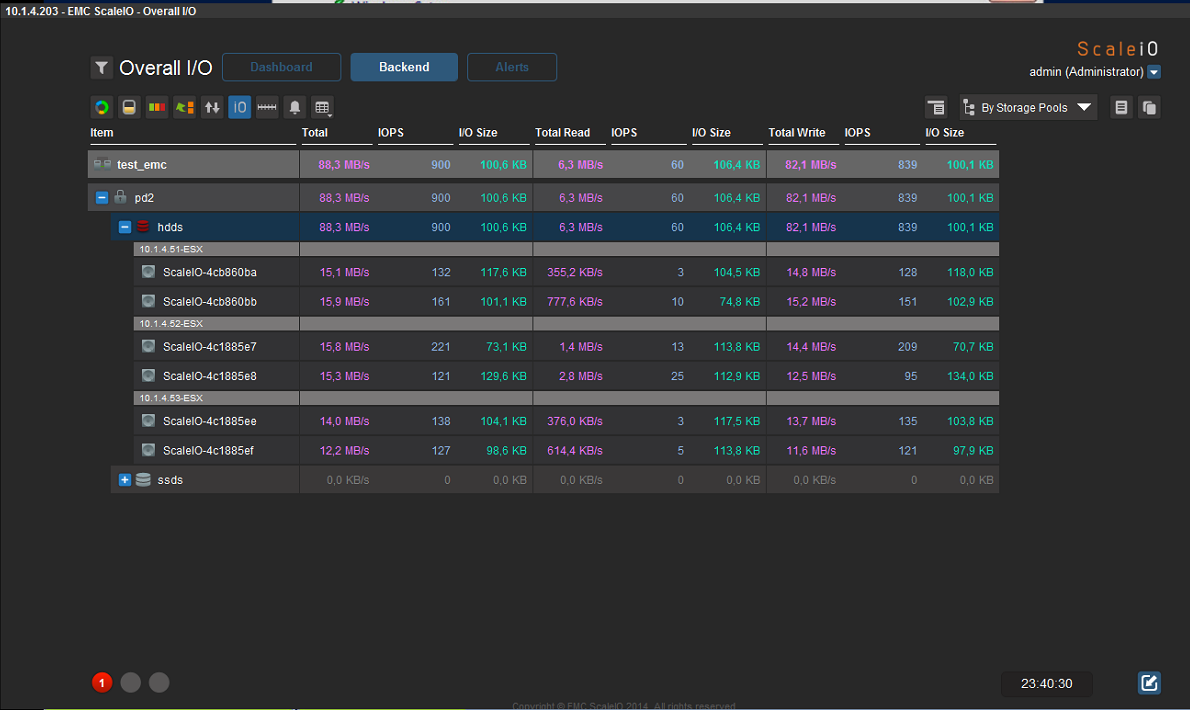

Attends quoi? le volume disponible dans notre boîtier est de 544 Go?! Comment? Pourquoi? Une explication de l'architecture de stockage est requise ici (voir capture d'écran): i.e. volume total du pool de stockage brut nommé HDD: 1,6 To moins 567,1 Go de capacité de réserve = 1,1 To de capacité inutilisée. La capacité de réserve est déterminée par le paramètre Stratégie de réserve dans les paramètres. Selon les recommandations de la documentation, pour une protection complète contre la défaillance d'un nœud, il est nécessaire que la capacité de stockage soit au moins 1 \ N du volume total de tous les disques physiques de tous les nœuds inclus dans le pool de stockage, où N est le nombre de nœuds qui se trouvent dans le pool (c.-à-d. e si nous avons 3 nœuds avec des disques dans ce pool de stockage, alors la capacité disponible dans notre cas est 1 \ 3 de 1,6 To (du volume total), respectivement 567,1 Go (580708 Mo).Ainsi, nous obtenons 1,1 To d'espace inutilisé dans le pool de stockage pour créer du volume. Cependant, à des fins de haute disponibilité et de fiabilité, ScaleIO stocke 2 copies de chaque bloc de données sur tous les disques physiques, respectivement, nous divisons le volume de 1,1 To par 2 fois, et en conséquence, nous obtenons le volume disponible pour créer un volume de 544,0 Go.Pendant le test de fonctionnement du système, nous avons réussi à atteindre les indicateurs suivants (la vitesse était de 85 à 130 Mo / s, mais vous devez comprendre que ce n'est que la charge d'une machine virtuelle, lorsque vous étendez la baie en ajoutant des nœuds avec des disques, je pense que tout sera proportionnel à la croissance avec IOPS):

i.e. volume total du pool de stockage brut nommé HDD: 1,6 To moins 567,1 Go de capacité de réserve = 1,1 To de capacité inutilisée. La capacité de réserve est déterminée par le paramètre Stratégie de réserve dans les paramètres. Selon les recommandations de la documentation, pour une protection complète contre la défaillance d'un nœud, il est nécessaire que la capacité de stockage soit au moins 1 \ N du volume total de tous les disques physiques de tous les nœuds inclus dans le pool de stockage, où N est le nombre de nœuds qui se trouvent dans le pool (c.-à-d. e si nous avons 3 nœuds avec des disques dans ce pool de stockage, alors la capacité disponible dans notre cas est 1 \ 3 de 1,6 To (du volume total), respectivement 567,1 Go (580708 Mo).Ainsi, nous obtenons 1,1 To d'espace inutilisé dans le pool de stockage pour créer du volume. Cependant, à des fins de haute disponibilité et de fiabilité, ScaleIO stocke 2 copies de chaque bloc de données sur tous les disques physiques, respectivement, nous divisons le volume de 1,1 To par 2 fois, et en conséquence, nous obtenons le volume disponible pour créer un volume de 544,0 Go.Pendant le test de fonctionnement du système, nous avons réussi à atteindre les indicateurs suivants (la vitesse était de 85 à 130 Mo / s, mais vous devez comprendre que ce n'est que la charge d'une machine virtuelle, lorsque vous étendez la baie en ajoutant des nœuds avec des disques, je pense que tout sera proportionnel à la croissance avec IOPS): Nutanix Comminity Edition 4.5 - gratuit pour une utilisation non commercialeEn général, la documentation de Nutanix, assez curieusement, est assez petite ... Certains points ont été clarifiés lors du processus d'installation. Nutanix combine à la fois un hyperviseur et un système de gestion de cluster de virtualisation (ala VMWARE Vcenter) en une "personne", ainsi qu'un système de stockage distribué fourni sur NFS avec des fonctions de haute disponibilité.Malheureusement, nous n'avons pas pu obtenir la version avec l'hyperviseur ESXi. Par conséquent, ils ont commencé à tester la version Community Edition, et elle présente de nombreuses limitations:- maximum 4 nœuds- maximum 4 disques par nœud (y compris les SSD, donc la capacité maximale par hôte est de 18 To (3 disques durs de 6 To))- Processeur Intel avec prise en charge VT-x 4 cœurs minimum- contrôleurs SATA AHCI (Advanced Host Controller Interface) intégrés- Contrôleurs LSI en mode informatique (les tests Nutanix montrent de meilleures performances que l'IR)- au moins 16 Go de mémoire par hôte (32 Go ou plus pour la déduplication est fortement recommandé - il ne s'allume pas pour 16)- SSD minimum par hôte 200 Go- minimum le volume SSD par hôte pour prendre en charge la déduplication de 300 Go (de préférence plus de 400 480)Nutanix n'a pas déterminé le contrôleur SAS ADAPTEC 6405E, nous n'avons donc pas pu utiliser de disques SAS (nous avons utilisé des disques SATA et SSD connectés aux connecteurs de la carte mère).L'installation nécessite un support sur chaque hôte: nous n'avons pas mis l'image finie sur les lecteurs locaux du serveur - nous avons mis un lecteur flash de 8 Go sur chaque hôte (les exigences minimales sont de 8 Go pour le lecteur flash, mieux 16, l'hyperviseur KVM (Acropolis) et CVM - le contrôle de la machine virtuelle y est placé - et ainsi de suite pour chaque hôte!), Le nombre total de machines virtuelles CVM par le nombre d'hôtes.Dans notre cas, la configuration suivante a été obtenue:- 16 gigaoctets de mémoire par hôte- pour chaque hôte 2 disques durs HDD SATA 500 Go- pour chaque hôte 1 disque dur SSD 500 Go- pour la déduplication vous avez besoin d'au moins 24 Go de mémoire par hôte + au moins 300 Go SSD par hôte, donc elle ne s'est pas retournée contre nous.En cas de non-respect des exigences minimales, le système n'est pas installé ...Vous ne pouvez pas modifier l'hyperviseur dans Community Edition - seul KVM est installé par défaut - c'est un énorme inconvénient, car nous sommes habitués à utiliser VMWARE ESXi.Après l'installation, une machine virtuelle de service (CVM - machine virtuelle de contrôle) apparaît sur chaque hôte, qui occupe 2 cœurs de processeur et réserve 12 Go de RAM sur chaque hôte - en tenir compte lors de la planification.Après l'installation sur tous les nœuds du cluster, nous créons des volumes pour le stockage des données: lors de la création du StorageContainer, si le facteur de réplication 2, alors l'espace disque libre est de 50% inférieur (tous les blocs de données sont dupliqués sur d'autres disques, par exemple, nous avons 3 hôtes, sur chaque 2 disques SATA 500 Go, soit un total de 6 disques + disques SSD sur chacun des hôtes, seulement 2,88 To de volume total dont 1,44 To disponibles pour l'utilisateur pour le stockage).Après la création, la matrice de disques est accessible et fournie via NFS: par exemple, elle s'est parfaitement connectée au cluster VMWARE 5.5 en tant que banque de données, respectivement, le stockage vmotion fonctionne également, bien que la vitesse soit beaucoup plus lente que FC 4Gb \ sec (c'est compréhensible avec une connexion gigabit - c'était intéressant conduirait sur 10G ou infiniband).Une machine live de 60 Go du cluster VMWARE a été déplacée d'environ 24 minutes vers le stockage Nutanix. Il est revenu 13 minutes au stockage FC de niveau entreprise.Écriture du fichier iso du serveur Windows sur la machine virtuelle vmware qui se trouve sur le stockage nutanix via nfs (1 Go / s) - 34 Mo / sec.Il n'y a pas d'outil interactif pour gérer les groupes de ports et vswitch - tout est fait à partir de cli.Un point non évident sur les réseaux pour exécuter des machines virtuelles: je vous conseille de lire attentivement la documentation. Pour les machines virtuelles à l'intérieur de Nutanix, nous avons utilisé les VLAN que tous nos autres systèmes de virtualisation utilisent pour accéder au réseau. Au stade de la configuration des réseaux virtuels, le numéro VLAN du réseau virtuel est simplement indiqué - il n'y a plus de paramètres, et dans les propriétés de la machine virtuelle la carte réseau virtuelle est configurée pour correspondre au numéro de réseau - et c'est tout, il n'y a pas d'autres paramètres dans l'interface graphique! Mais tout fonctionne.Pour installer des machines virtuelles invitées Windows, vous devez connecter un deuxième CDROM virtuel avec les pilotes VirtIO (par exemple, vous pouvez le prendre à partir d'ici (placez d'abord le fichier iso sur le référentiel): fedoraproject.org/wiki/Windows_Virtio_Drivers#Direct_download )Le temps d'installation de Guest VM sur Windows 2012 R2 n'était que de 7 minutes du début à la pleine charge du système de travail, la machine virtuelle fonctionne visuellement aussi rapidement - évidemment, le SSD aide.Vous pouvez placer une machine virtuelle sur le type de contrôleur de disque virtuel IDE (sans connecter les pilotes VirtIO), mais ce n'est pas une configuration recommandée - les performances seront bien moindres.Lors d'une panne de courant de test de l'un des hôtes du cluster, HA a fonctionné, le système ne s'est pas bloqué, les ressources disque sont accessibles à la fois sur le réseau et localement, les machines virtuelles qui étaient sur l'hôte déconnecté ont redémarré sur d'autres hôtes (s'il y a suffisamment de mémoire),Cependant, après avoir allumé le pouvoir du 3ème hôte, le fait désagréable était que le statut du système a été maintenu dans Critical pendant très longtemps - je ne sais pas ce que cela tire, mais il n'y a pas grand-chose de bon. (de 1 heure à 2). Par exemple, le même cluster VMWARE après connexion à l'hôte détermine rapidement son état et se reconnecte au cluster.En général, il convient de noter que l'interface Prism pour la gestion d'un cluster de Nutanix CE a une interface plutôt médiocre (quoique agréable). Seuls les paramètres de base sont disponibles, mais en général, ils sont suffisants à première vue, il existe des analyses graphiques personnalisables, bien que, bien sûr, elles soient beaucoup plus faibles que dans VCENTER.La sauvegarde n'est pas claire: après tout, ni les produits Symantec ni Veeam ne prennent en charge la virtualisation KVM ... évidemment, par le biais d'instantanés, mais qu'en est-il de la récupération granulaire des données dans ce cas (fichier par fichier).Visuellement, Nutanix était beaucoup plus rapide, qu'au stade de la copie des images sur son système de stockage, qu'au stade de l'installation du système d'exploitation sur une nouvelle machine virtuelle à partir de l'image, qu'au stade des redémarrages de démarrage: presque instantanément tout). Il y a un désir d'essayer Nutanix sur une configuration plus puissante et assurez-vous d'utiliser VMWARE EXSi.Bien sûr, je ne peux pas fournir de données de performances particulières pour les deux systèmes, mais vous pouvez obtenir des informations sur le "rake" lors de la configuration. Si je m'excuse - la première note sur Habré.

Nutanix Comminity Edition 4.5 - gratuit pour une utilisation non commercialeEn général, la documentation de Nutanix, assez curieusement, est assez petite ... Certains points ont été clarifiés lors du processus d'installation. Nutanix combine à la fois un hyperviseur et un système de gestion de cluster de virtualisation (ala VMWARE Vcenter) en une "personne", ainsi qu'un système de stockage distribué fourni sur NFS avec des fonctions de haute disponibilité.Malheureusement, nous n'avons pas pu obtenir la version avec l'hyperviseur ESXi. Par conséquent, ils ont commencé à tester la version Community Edition, et elle présente de nombreuses limitations:- maximum 4 nœuds- maximum 4 disques par nœud (y compris les SSD, donc la capacité maximale par hôte est de 18 To (3 disques durs de 6 To))- Processeur Intel avec prise en charge VT-x 4 cœurs minimum- contrôleurs SATA AHCI (Advanced Host Controller Interface) intégrés- Contrôleurs LSI en mode informatique (les tests Nutanix montrent de meilleures performances que l'IR)- au moins 16 Go de mémoire par hôte (32 Go ou plus pour la déduplication est fortement recommandé - il ne s'allume pas pour 16)- SSD minimum par hôte 200 Go- minimum le volume SSD par hôte pour prendre en charge la déduplication de 300 Go (de préférence plus de 400 480)Nutanix n'a pas déterminé le contrôleur SAS ADAPTEC 6405E, nous n'avons donc pas pu utiliser de disques SAS (nous avons utilisé des disques SATA et SSD connectés aux connecteurs de la carte mère).L'installation nécessite un support sur chaque hôte: nous n'avons pas mis l'image finie sur les lecteurs locaux du serveur - nous avons mis un lecteur flash de 8 Go sur chaque hôte (les exigences minimales sont de 8 Go pour le lecteur flash, mieux 16, l'hyperviseur KVM (Acropolis) et CVM - le contrôle de la machine virtuelle y est placé - et ainsi de suite pour chaque hôte!), Le nombre total de machines virtuelles CVM par le nombre d'hôtes.Dans notre cas, la configuration suivante a été obtenue:- 16 gigaoctets de mémoire par hôte- pour chaque hôte 2 disques durs HDD SATA 500 Go- pour chaque hôte 1 disque dur SSD 500 Go- pour la déduplication vous avez besoin d'au moins 24 Go de mémoire par hôte + au moins 300 Go SSD par hôte, donc elle ne s'est pas retournée contre nous.En cas de non-respect des exigences minimales, le système n'est pas installé ...Vous ne pouvez pas modifier l'hyperviseur dans Community Edition - seul KVM est installé par défaut - c'est un énorme inconvénient, car nous sommes habitués à utiliser VMWARE ESXi.Après l'installation, une machine virtuelle de service (CVM - machine virtuelle de contrôle) apparaît sur chaque hôte, qui occupe 2 cœurs de processeur et réserve 12 Go de RAM sur chaque hôte - en tenir compte lors de la planification.Après l'installation sur tous les nœuds du cluster, nous créons des volumes pour le stockage des données: lors de la création du StorageContainer, si le facteur de réplication 2, alors l'espace disque libre est de 50% inférieur (tous les blocs de données sont dupliqués sur d'autres disques, par exemple, nous avons 3 hôtes, sur chaque 2 disques SATA 500 Go, soit un total de 6 disques + disques SSD sur chacun des hôtes, seulement 2,88 To de volume total dont 1,44 To disponibles pour l'utilisateur pour le stockage).Après la création, la matrice de disques est accessible et fournie via NFS: par exemple, elle s'est parfaitement connectée au cluster VMWARE 5.5 en tant que banque de données, respectivement, le stockage vmotion fonctionne également, bien que la vitesse soit beaucoup plus lente que FC 4Gb \ sec (c'est compréhensible avec une connexion gigabit - c'était intéressant conduirait sur 10G ou infiniband).Une machine live de 60 Go du cluster VMWARE a été déplacée d'environ 24 minutes vers le stockage Nutanix. Il est revenu 13 minutes au stockage FC de niveau entreprise.Écriture du fichier iso du serveur Windows sur la machine virtuelle vmware qui se trouve sur le stockage nutanix via nfs (1 Go / s) - 34 Mo / sec.Il n'y a pas d'outil interactif pour gérer les groupes de ports et vswitch - tout est fait à partir de cli.Un point non évident sur les réseaux pour exécuter des machines virtuelles: je vous conseille de lire attentivement la documentation. Pour les machines virtuelles à l'intérieur de Nutanix, nous avons utilisé les VLAN que tous nos autres systèmes de virtualisation utilisent pour accéder au réseau. Au stade de la configuration des réseaux virtuels, le numéro VLAN du réseau virtuel est simplement indiqué - il n'y a plus de paramètres, et dans les propriétés de la machine virtuelle la carte réseau virtuelle est configurée pour correspondre au numéro de réseau - et c'est tout, il n'y a pas d'autres paramètres dans l'interface graphique! Mais tout fonctionne.Pour installer des machines virtuelles invitées Windows, vous devez connecter un deuxième CDROM virtuel avec les pilotes VirtIO (par exemple, vous pouvez le prendre à partir d'ici (placez d'abord le fichier iso sur le référentiel): fedoraproject.org/wiki/Windows_Virtio_Drivers#Direct_download )Le temps d'installation de Guest VM sur Windows 2012 R2 n'était que de 7 minutes du début à la pleine charge du système de travail, la machine virtuelle fonctionne visuellement aussi rapidement - évidemment, le SSD aide.Vous pouvez placer une machine virtuelle sur le type de contrôleur de disque virtuel IDE (sans connecter les pilotes VirtIO), mais ce n'est pas une configuration recommandée - les performances seront bien moindres.Lors d'une panne de courant de test de l'un des hôtes du cluster, HA a fonctionné, le système ne s'est pas bloqué, les ressources disque sont accessibles à la fois sur le réseau et localement, les machines virtuelles qui étaient sur l'hôte déconnecté ont redémarré sur d'autres hôtes (s'il y a suffisamment de mémoire),Cependant, après avoir allumé le pouvoir du 3ème hôte, le fait désagréable était que le statut du système a été maintenu dans Critical pendant très longtemps - je ne sais pas ce que cela tire, mais il n'y a pas grand-chose de bon. (de 1 heure à 2). Par exemple, le même cluster VMWARE après connexion à l'hôte détermine rapidement son état et se reconnecte au cluster.En général, il convient de noter que l'interface Prism pour la gestion d'un cluster de Nutanix CE a une interface plutôt médiocre (quoique agréable). Seuls les paramètres de base sont disponibles, mais en général, ils sont suffisants à première vue, il existe des analyses graphiques personnalisables, bien que, bien sûr, elles soient beaucoup plus faibles que dans VCENTER.La sauvegarde n'est pas claire: après tout, ni les produits Symantec ni Veeam ne prennent en charge la virtualisation KVM ... évidemment, par le biais d'instantanés, mais qu'en est-il de la récupération granulaire des données dans ce cas (fichier par fichier).Visuellement, Nutanix était beaucoup plus rapide, qu'au stade de la copie des images sur son système de stockage, qu'au stade de l'installation du système d'exploitation sur une nouvelle machine virtuelle à partir de l'image, qu'au stade des redémarrages de démarrage: presque instantanément tout). Il y a un désir d'essayer Nutanix sur une configuration plus puissante et assurez-vous d'utiliser VMWARE EXSi.Bien sûr, je ne peux pas fournir de données de performances particulières pour les deux systèmes, mais vous pouvez obtenir des informations sur le "rake" lors de la configuration. Si je m'excuse - la première note sur Habré.