Le pic du calcul avant le pic du pétrole?

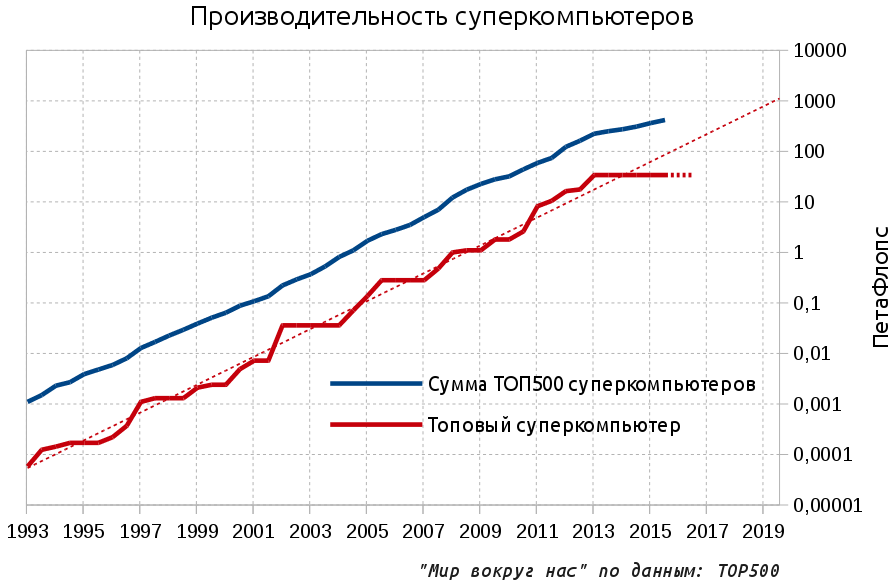

Aujourd'hui, nous allons essayer le genre de Cassandra populaire dans la blogosphère - les prophéties négatives. Ainsi, il est «bien connu» que l'hiver approche, l'humanité a atteint les limites de la croissance en tout, et nous vivons les derniers jours tranquilles avant l'inévitable glissement vers de nouveaux siècles sombres. La dernière source d'optimisme technologique et le symbole de progrès le plus frappant, qui a opposé ces 20 dernières années à de nombreux processus stagnants sur la planète, a été le développement rapide de la microélectronique. Le moment est venu de déchirer les couvertures de cette zone.Il semblerait que les progrès soient désormais plus rapides que jamais et tout utilisateur de smartphone vous parlera de processeurs de plus en plus rapides qui apparaissent dans les nouveaux modèles. Mais dans l'extrême nord, il faisait déjà froid contre le mur qui nous protégeait des recours. Là où les performances maximales de la microélectronique sont vraiment nécessaires - dans le domaine des superordinateurs aux frontières les plus avancées - les progrès ont cessé.Comme vous pouvez le voir sur le graphique, depuis trois ans, les performances du supercalculateur supérieur (exprimées en opérations à virgule flottante par seconde - FLOPS) n'ont pas augmenté. De plus, si vous regardez les plans annoncés, vous pouvez dire avec confiance que la situation ne changera pas au moins dans l'année à venir. La stagnation des performances du supercalculateur supérieur se prolongera donc jusqu'en 2016: Les lignes pointillées indiquent la tendance de développement exponentielle et les prévisions pour le supercalculateur haut de gamme pour 2016 (stagnation). Brièvement sur le matériel: dans l'article, les préfixes Pet et Ax sont utilisés. PetaFlops - 10 ^ 15 opérations par seconde, et l'avenir nécessaire et discuté de mille fois - ExaFlops, 10 ^ 18.Pour poursuivre la tendance exponentielle, les supercalculateurs devraient atteindre l'échelle ExFlops en 2019, et maintenant seulement environ 100 PetFlops pour 2018 sont prévus par Aurora. Mais quel est exactement le problème?D'après mon expérience, même de nombreux développeurs professionnels de logiciels et de matériel ne seront pas en mesure de vous dire quelle est l'importance des superordinateurs. Dans le monde moderne, au siècle de l'Internet omniprésent, d'énormes salles remplies de supports en fer et dédiées au traitement d'une tâche informatique complexe semblent être le destin du passé romantique du début de l'ère informatique des années 60-70. En effet, aujourd'hui, les ressources d'un seul ordinateur personnel suffisent pour résoudre de nombreux problèmes complexes, et les serveurs disponibles dans le commerce vous permettent de répondre aux besoins des grandes entreprises. Mais il existe également des services de cloud computing populaires qui vous promettent des ressources informatiques infinies pour une modeste récompense.Mais en fait, les superordinateurs sont la seule chose qui donne à l'humanité de sept milliards de dollars d'aujourd'hui la possibilité de continuer à se développer et à vivre sans craindre la malédiction malthusienne.Toutes les tâches avancées ne peuvent être résolues qu'avec l'aide d'une très grande puissance de calcul et d'un supercalculateur où tous les composants de la technologie informatique sont optimisés autant que possible, c'est l'outil le plus approprié pour résoudre ces problèmes. De plus, la simulation informatique directe peut être interprétée comme la troisième méthode scientifique de cognition en plus de la recherche théorique et expérimentale. Afin de ne pas être infondé, nous donnons quelques exemples.À propos de l'huile mère, qu'il a longtemps été impossible de trouver sans ordinateurs puissants, nous avons déjà écritet la conclusion était catégorique: le matin un supercalculateur dans l'huile du soir, le soir un supercalculateur dans l'huile du matin. Voyons d'autres sujets.AviationDans la conception de nouveaux avions, la simulation informatique a réduit le nombre d'essais physiques en soufflerie de 77 unités en 1979 à 11 en 1995 et depuis lors, la valeur est restée au même niveau. Quelque chose à cause de cela, nos avions sont restés à peu près les mêmes où ils étaient. La transition vers une simulation physique fondamentalement plus précise basée sur l'application directe des équations de Navier-Stokes nécessite des capacités de calcul de l'ordre de 50 exaflops, soit 1000 fois plus que le leader actuel - le chinois Tianhe-2 par 33 PetaFlops. Dans le même temps, le calcul de l'aérodynamique externe est encore relativement simple - mais, par exemple, un moteur typique se compose de milliers de pièces mobiles et la modélisation des flux internes nécessitera une puissance de calcul encore plus élevée.

Les lignes pointillées indiquent la tendance de développement exponentielle et les prévisions pour le supercalculateur haut de gamme pour 2016 (stagnation). Brièvement sur le matériel: dans l'article, les préfixes Pet et Ax sont utilisés. PetaFlops - 10 ^ 15 opérations par seconde, et l'avenir nécessaire et discuté de mille fois - ExaFlops, 10 ^ 18.Pour poursuivre la tendance exponentielle, les supercalculateurs devraient atteindre l'échelle ExFlops en 2019, et maintenant seulement environ 100 PetFlops pour 2018 sont prévus par Aurora. Mais quel est exactement le problème?D'après mon expérience, même de nombreux développeurs professionnels de logiciels et de matériel ne seront pas en mesure de vous dire quelle est l'importance des superordinateurs. Dans le monde moderne, au siècle de l'Internet omniprésent, d'énormes salles remplies de supports en fer et dédiées au traitement d'une tâche informatique complexe semblent être le destin du passé romantique du début de l'ère informatique des années 60-70. En effet, aujourd'hui, les ressources d'un seul ordinateur personnel suffisent pour résoudre de nombreux problèmes complexes, et les serveurs disponibles dans le commerce vous permettent de répondre aux besoins des grandes entreprises. Mais il existe également des services de cloud computing populaires qui vous promettent des ressources informatiques infinies pour une modeste récompense.Mais en fait, les superordinateurs sont la seule chose qui donne à l'humanité de sept milliards de dollars d'aujourd'hui la possibilité de continuer à se développer et à vivre sans craindre la malédiction malthusienne.Toutes les tâches avancées ne peuvent être résolues qu'avec l'aide d'une très grande puissance de calcul et d'un supercalculateur où tous les composants de la technologie informatique sont optimisés autant que possible, c'est l'outil le plus approprié pour résoudre ces problèmes. De plus, la simulation informatique directe peut être interprétée comme la troisième méthode scientifique de cognition en plus de la recherche théorique et expérimentale. Afin de ne pas être infondé, nous donnons quelques exemples.À propos de l'huile mère, qu'il a longtemps été impossible de trouver sans ordinateurs puissants, nous avons déjà écritet la conclusion était catégorique: le matin un supercalculateur dans l'huile du soir, le soir un supercalculateur dans l'huile du matin. Voyons d'autres sujets.AviationDans la conception de nouveaux avions, la simulation informatique a réduit le nombre d'essais physiques en soufflerie de 77 unités en 1979 à 11 en 1995 et depuis lors, la valeur est restée au même niveau. Quelque chose à cause de cela, nos avions sont restés à peu près les mêmes où ils étaient. La transition vers une simulation physique fondamentalement plus précise basée sur l'application directe des équations de Navier-Stokes nécessite des capacités de calcul de l'ordre de 50 exaflops, soit 1000 fois plus que le leader actuel - le chinois Tianhe-2 par 33 PetaFlops. Dans le même temps, le calcul de l'aérodynamique externe est encore relativement simple - mais, par exemple, un moteur typique se compose de milliers de pièces mobiles et la modélisation des flux internes nécessitera une puissance de calcul encore plus élevée. Hydrodynamique de calcul appliquée aux aubes de turbine (à gauche) et à l'avion X-43 avec un nombre de Mach = 7Énergie thermonucléaireDans le domaine de la physique thermonucléaire, qui est écrit de manière intéressante par un collègue de tnenergy, la conception de la prochaine génération de tokamaks est impossible sans progrès dans la modélisation du plasma à haute température dans un piège magnétique. Déjà, plusieurs milliards de particules dans l'espace avec une résolution de 131 millions de points participent aux modèles. Pour de telles échelles, les systèmes de commande Petaflops les plus puissants sont utilisés et de bons résultats sont obtenus, mais il est clair qu'une précision suffisante de simulation complète sur les principes de base devra être augmentée jusqu'à 13 millions de fois modestes.

Hydrodynamique de calcul appliquée aux aubes de turbine (à gauche) et à l'avion X-43 avec un nombre de Mach = 7Énergie thermonucléaireDans le domaine de la physique thermonucléaire, qui est écrit de manière intéressante par un collègue de tnenergy, la conception de la prochaine génération de tokamaks est impossible sans progrès dans la modélisation du plasma à haute température dans un piège magnétique. Déjà, plusieurs milliards de particules dans l'espace avec une résolution de 131 millions de points participent aux modèles. Pour de telles échelles, les systèmes de commande Petaflops les plus puissants sont utilisés et de bons résultats sont obtenus, mais il est clair qu'une précision suffisante de simulation complète sur les principes de base devra être augmentée jusqu'à 13 millions de fois modestes. Modélisation du comportement du plasma dans un tokamakClimat et météoLa modélisation du climat et des prévisions météorologiques précises nous permettent de planifier nos actions de manière optimale - la précision des prévisions augmente avec la croissance des performances des superordinateurs. À l'avenir, il sera possible de prévoir les précipitations et, par conséquent, les inondations et les coulées de boue. Sécheresse et mauvaises récoltes.

Modélisation du comportement du plasma dans un tokamakClimat et météoLa modélisation du climat et des prévisions météorologiques précises nous permettent de planifier nos actions de manière optimale - la précision des prévisions augmente avec la croissance des performances des superordinateurs. À l'avenir, il sera possible de prévoir les précipitations et, par conséquent, les inondations et les coulées de boue. Sécheresse et mauvaises récoltes. Aujourd'hui, une prévision météorologique sur 4 jours est aussi précise qu'une prévision météorologique sur une journée en 1980Des prévisions de plus en plus précises nécessitent un modèle à l'échelle planétaire plus détaillé, et une diminution constante de la cellule de simulation est nécessaire. Actuellement, les cellules du modèle pour les prévisions régionales à court terme ont des dimensions de 10x10 km, et les modèles climatiques à long terme utilisent une grille avec des cellules de centaines de km, tandis qu'une échelle de 1x1 km en surface (10000 fois plus grande que maintenant) et 100 mètres verticalement est requise. Oui avec une périodisation de 1 seconde, ce qui signifie pour deux mois 5 millions de secondes.Un exemple de modèle moderne avec une cellule de 300x300 km.

Aujourd'hui, une prévision météorologique sur 4 jours est aussi précise qu'une prévision météorologique sur une journée en 1980Des prévisions de plus en plus précises nécessitent un modèle à l'échelle planétaire plus détaillé, et une diminution constante de la cellule de simulation est nécessaire. Actuellement, les cellules du modèle pour les prévisions régionales à court terme ont des dimensions de 10x10 km, et les modèles climatiques à long terme utilisent une grille avec des cellules de centaines de km, tandis qu'une échelle de 1x1 km en surface (10000 fois plus grande que maintenant) et 100 mètres verticalement est requise. Oui avec une périodisation de 1 seconde, ce qui signifie pour deux mois 5 millions de secondes.Un exemple de modèle moderne avec une cellule de 300x300 km. Médecine et biologie.La médecine ne fait pas exception. Aujourd'hui, les supercalculateurs haut de gamme ne peuvent simuler que des parties individuelles ultra-petites de cellules:

Médecine et biologie.La médecine ne fait pas exception. Aujourd'hui, les supercalculateurs haut de gamme ne peuvent simuler que des parties individuelles ultra-petites de cellules: Sur la figure, le résultat de la modélisation du fonctionnement des canaux ioniques dans la membrane cellulaire sur les superordinateurs haut de gamme - et seulement environ 100 000 molécules sont impliquées. De plus, le nombre total de molécules dans une cellule humaine est de milliards, et les cellules elles-mêmes sont presque quadrillions (10 ^ 14). Le processus d'obtention de nouveaux médicaments et de leur mise sur le marché prend de 5 à 15 ans et il est maintenant question de nouveaux concepts dans la conception des dragues. Imaginez à quel point vous pouvez accélérer le processus et augmenter l'efficacité des médicaments si vous modélisez la situation de manière globale - à partir de l'ADN pathogène, qui, en fait, contient toutes les informations à son sujet et se termine par le modèle du corps humain, en tenant compte des caractéristiques génétiques individuelles.La vraie liste est beaucoup, beaucoup plus grande: la recherche de matériaux fondamentalement nouveaux avec les propriétés souhaitées, l'astrophysique, l'énergie nucléaire et bien plus encore. Comptabilité desexposantsLa question se pose: si les avantages sont si importants, alors pourquoi n'investissons-nous pas vraiment beaucoup d'argent dans de puissants superordinateurs? Le fait est que jusqu'à présent il y a eu un exposant de notre côté, à savoir l'exposant de Moore - tous les 18-24 mois, la densité des transistors double, et jusqu'à récemment, cela signifiait que la productivité doublait aussi.Par conséquent, les étudiants des joueurs étaient tourmentés par la question constante: "Dois-je acheter un ordinateur aujourd'hui pour 2000 dollars ou prendre quelque chose de plus simple pour 1000 dollars?" En effet, pour les 1000 $ restants dans 3-4 ans, il sera possible d'acheter un ordinateur deux fois plus puissant. Cela n'est pas surprenant, car une fonction linéaire perd toujours exponentiellement et la multiplication des coûts donne au mieux la même multiplication linéaire des performances au lieu d'une dépendance à la loi de puissance dans le cas d'un exposant. En règle générale, le budget des étudiants n'était pas flexible et le choix s'est porté sur la deuxième option, mais parfois ils voulaient s'impliquer, ils ont pris l'option de propagation et après quelques années, ils ont regardé diaboliquement cette vieille camelote.Un processus similaire, mais dans un environnement beaucoup plus sérieux, a eu lieu lors des discussions sur les nouveaux superordinateurs. Dans la plupart des cas, une voie plus modérée mais productive a été choisie. Il est significatif qu'au cours des 20 dernières années, seuls trois ordinateurs aient coûté plus de 300 millions de dollars et tous trois aient été construits en dehors des États-Unis: deux au Japon et un leader aujourd'hui en Chine, dans des pays qui revendiquent le leadership mondial. En effet, en plus des avantages réels, le fait d'avoir votre propre supercalculateur sur la première ligne de la notation est devenu une question de fierté nationale pour prouver l'existence d'une science avancée nationale.La fin de l’exposantD’année en année, on entend des exclamations selon lesquelles la loi de Moore est proche de la fin et jusqu’à présent, ce ne sont que des histoires d’horreur. Mais si vous le souhaitez, vous pouvez déjà discerner les cavaliers individuels de l'apocalypse:

Sur la figure, le résultat de la modélisation du fonctionnement des canaux ioniques dans la membrane cellulaire sur les superordinateurs haut de gamme - et seulement environ 100 000 molécules sont impliquées. De plus, le nombre total de molécules dans une cellule humaine est de milliards, et les cellules elles-mêmes sont presque quadrillions (10 ^ 14). Le processus d'obtention de nouveaux médicaments et de leur mise sur le marché prend de 5 à 15 ans et il est maintenant question de nouveaux concepts dans la conception des dragues. Imaginez à quel point vous pouvez accélérer le processus et augmenter l'efficacité des médicaments si vous modélisez la situation de manière globale - à partir de l'ADN pathogène, qui, en fait, contient toutes les informations à son sujet et se termine par le modèle du corps humain, en tenant compte des caractéristiques génétiques individuelles.La vraie liste est beaucoup, beaucoup plus grande: la recherche de matériaux fondamentalement nouveaux avec les propriétés souhaitées, l'astrophysique, l'énergie nucléaire et bien plus encore. Comptabilité desexposantsLa question se pose: si les avantages sont si importants, alors pourquoi n'investissons-nous pas vraiment beaucoup d'argent dans de puissants superordinateurs? Le fait est que jusqu'à présent il y a eu un exposant de notre côté, à savoir l'exposant de Moore - tous les 18-24 mois, la densité des transistors double, et jusqu'à récemment, cela signifiait que la productivité doublait aussi.Par conséquent, les étudiants des joueurs étaient tourmentés par la question constante: "Dois-je acheter un ordinateur aujourd'hui pour 2000 dollars ou prendre quelque chose de plus simple pour 1000 dollars?" En effet, pour les 1000 $ restants dans 3-4 ans, il sera possible d'acheter un ordinateur deux fois plus puissant. Cela n'est pas surprenant, car une fonction linéaire perd toujours exponentiellement et la multiplication des coûts donne au mieux la même multiplication linéaire des performances au lieu d'une dépendance à la loi de puissance dans le cas d'un exposant. En règle générale, le budget des étudiants n'était pas flexible et le choix s'est porté sur la deuxième option, mais parfois ils voulaient s'impliquer, ils ont pris l'option de propagation et après quelques années, ils ont regardé diaboliquement cette vieille camelote.Un processus similaire, mais dans un environnement beaucoup plus sérieux, a eu lieu lors des discussions sur les nouveaux superordinateurs. Dans la plupart des cas, une voie plus modérée mais productive a été choisie. Il est significatif qu'au cours des 20 dernières années, seuls trois ordinateurs aient coûté plus de 300 millions de dollars et tous trois aient été construits en dehors des États-Unis: deux au Japon et un leader aujourd'hui en Chine, dans des pays qui revendiquent le leadership mondial. En effet, en plus des avantages réels, le fait d'avoir votre propre supercalculateur sur la première ligne de la notation est devenu une question de fierté nationale pour prouver l'existence d'une science avancée nationale.La fin de l’exposantD’année en année, on entend des exclamations selon lesquelles la loi de Moore est proche de la fin et jusqu’à présent, ce ne sont que des histoires d’horreur. Mais si vous le souhaitez, vous pouvez déjà discerner les cavaliers individuels de l'apocalypse: Ci-dessus, cinq tendances pour diverses spécifications de microprocesseur. La loi de Moore semble se poursuivre: l'orange indique le nombre de transistors par unité de surface avec un doublement tous les 18-24 mois. Depuis 2005, le paramètre a augmenté 100 fois, mais il n'y a pas tellement de joie - les performances d'un cœur sont marquées en bleu et la croissance sur la même période est déjà inférieure à 10 fois. Le reste des transistors est allé augmenter le nombre de cœurs qui permettent des tâches de traitement en parallèle (noir).En 2005, il était possible d'acheter un processeur avec une vitesse d'horloge de 3,8 GHz, mais maintenant le processeur Intel avec une fréquence d'horloge supérieure à 4 GHz ne l'achète pas. Cela se réfère directement au graphique: la fréquence du processeur, qui était auparavant responsable de la moitié de la croissance de la productivité, n'a pas beaucoup changé depuis 2004 (vert), ainsi que la consommation d'énergie (rouge), qui reposait sur la possibilité de dissipation thermique.Ces tendances sont absolument symétriques dans l'architecture des superordinateurs. Si nous prenons le champion chinois d'aujourd'hui, nous voyons alors l'un des indicateurs de consommation d'énergie les plus élevés (18 MW), un grand nombre de cœurs de calcul, et même une régression au prix de PetaFlops. Tout cela a permis de construire un supercalculateur seulement deux fois plus productif que le concurrent précédent.Rejetez l'exposant bourgeois au nom de la ligne communiste!

Ci-dessus, cinq tendances pour diverses spécifications de microprocesseur. La loi de Moore semble se poursuivre: l'orange indique le nombre de transistors par unité de surface avec un doublement tous les 18-24 mois. Depuis 2005, le paramètre a augmenté 100 fois, mais il n'y a pas tellement de joie - les performances d'un cœur sont marquées en bleu et la croissance sur la même période est déjà inférieure à 10 fois. Le reste des transistors est allé augmenter le nombre de cœurs qui permettent des tâches de traitement en parallèle (noir).En 2005, il était possible d'acheter un processeur avec une vitesse d'horloge de 3,8 GHz, mais maintenant le processeur Intel avec une fréquence d'horloge supérieure à 4 GHz ne l'achète pas. Cela se réfère directement au graphique: la fréquence du processeur, qui était auparavant responsable de la moitié de la croissance de la productivité, n'a pas beaucoup changé depuis 2004 (vert), ainsi que la consommation d'énergie (rouge), qui reposait sur la possibilité de dissipation thermique.Ces tendances sont absolument symétriques dans l'architecture des superordinateurs. Si nous prenons le champion chinois d'aujourd'hui, nous voyons alors l'un des indicateurs de consommation d'énergie les plus élevés (18 MW), un grand nombre de cœurs de calcul, et même une régression au prix de PetaFlops. Tout cela a permis de construire un supercalculateur seulement deux fois plus productif que le concurrent précédent.Rejetez l'exposant bourgeois au nom de la ligne communiste! Les troupes cybernétiques chinoises suppriment les signets des processeurs Intel Xeon.Si les ordinateurs sont si importants, pourquoi ne pas simplement continuer sur la voie chinoise et agrandir le supercalculateur, puis le faire encore plus? Vous devez comprendre que toute augmentation de la productivité due à une augmentation linéaire de l'échelle n'est pas seulement une augmentation du prix en dollars, mais également la même augmentation linéaire de la consommation d'énergie. Si vous prenez un monstre chinois avec trois millions de cœurs et essayez de le faire passer du niveau 33 PetaFlops au niveau 30 ExaFlops, vous devrez réserver à l'usage exclusif deux douzaines de nouveaux réacteurs nucléaires, ce qui correspond à tous les réacteurs actuellement en construction en Chine. S'il est toujours possible de serrer la ceinture pour tirer, le niveau de 30 ZettaFlops avec ses 20'000 réacteurs nous est fermé pour toujours.Y a t-il une sortieEst-il possible de continuer l'exposant? Pour les années à venir - oui, toujours possible. Dans 2-3 ans, les superordinateurs sortiront environ trois fois plus puissants que les chinois haut de gamme et avec les meilleurs paramètres de consommation d'énergie et de coût PetAflops. Et que se passera-t-il ensuite?Personnellement, je n'en suis pas sûr, mais les experts ne sont pas très optimistes. Par exemple, un directeur de Microsoft a visité fin octobre un forum officiel sur le développement du futur système ExFlops aux États-Unis. Le forum a réuni tous les principaux fabricants de fer, ainsi que des représentants de diverses agences d'État développant et utilisant des superordinateurs.Pour citer :Il est évident pour tous les participants au forum:

Les troupes cybernétiques chinoises suppriment les signets des processeurs Intel Xeon.Si les ordinateurs sont si importants, pourquoi ne pas simplement continuer sur la voie chinoise et agrandir le supercalculateur, puis le faire encore plus? Vous devez comprendre que toute augmentation de la productivité due à une augmentation linéaire de l'échelle n'est pas seulement une augmentation du prix en dollars, mais également la même augmentation linéaire de la consommation d'énergie. Si vous prenez un monstre chinois avec trois millions de cœurs et essayez de le faire passer du niveau 33 PetaFlops au niveau 30 ExaFlops, vous devrez réserver à l'usage exclusif deux douzaines de nouveaux réacteurs nucléaires, ce qui correspond à tous les réacteurs actuellement en construction en Chine. S'il est toujours possible de serrer la ceinture pour tirer, le niveau de 30 ZettaFlops avec ses 20'000 réacteurs nous est fermé pour toujours.Y a t-il une sortieEst-il possible de continuer l'exposant? Pour les années à venir - oui, toujours possible. Dans 2-3 ans, les superordinateurs sortiront environ trois fois plus puissants que les chinois haut de gamme et avec les meilleurs paramètres de consommation d'énergie et de coût PetAflops. Et que se passera-t-il ensuite?Personnellement, je n'en suis pas sûr, mais les experts ne sont pas très optimistes. Par exemple, un directeur de Microsoft a visité fin octobre un forum officiel sur le développement du futur système ExFlops aux États-Unis. Le forum a réuni tous les principaux fabricants de fer, ainsi que des représentants de diverses agences d'État développant et utilisant des superordinateurs.Pour citer :Il est évident pour tous les participants au forum:

la microélectronique moderne basée sur la technologie CMOS approche de la fin de ses capacités.

Aucune technologie alternative ne sera disponible dans les dix prochaines années.Autrement dit, au cours des 10 prochaines années, le paradigme existant prendra fin et nous n'avons pas d'autre paradigme pour vous . Source: https://habr.com/ru/post/fr387109/

All Articles