Visite du centre de données suédois Facebook près du cercle polaire arctique

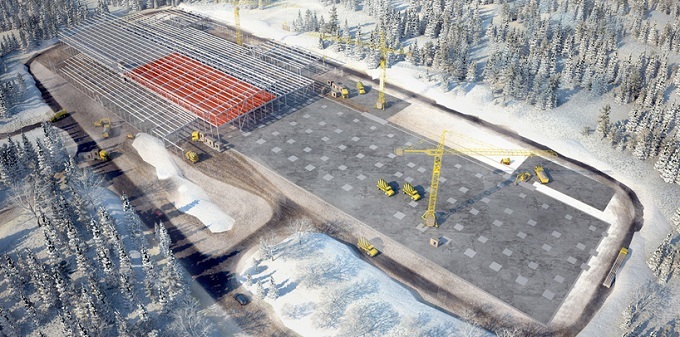

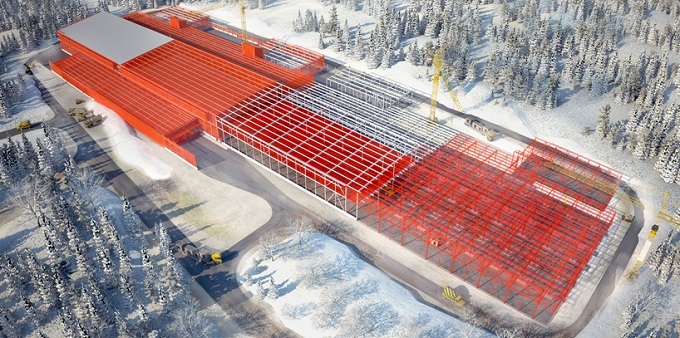

Un peu au sud du cercle polaire, au milieu d'une forêt à la périphérie de la ville suédoise de Luleå, se trouve une ferme de serveurs - un centre de données hypermonté Facebook. La façade du gigantesque bâtiment est encadrée par des milliers de panneaux métalliques rectangulaires, alors qu'elle ressemble elle-même à un véritable vaisseau spatial. La ferme de serveurs de l'entreprise à Lulea est immense. Il mesure 300 mètres de large et 100 mètres de long, ce qui correspond à peu près à la taille de quatre terrains de football. Fait intéressant, le projet de centre de données Facebook en Suède à un moment donné s'est avéré extrêmement proche de l'échec.Un écologiste local a déclaré que le nouveau centre de données pourrait nuire aux oiseaux, y compris le rare pic suédois à trois doigts qui niche près du campus. Mais les responsables de la municipalité de Lulea ont rejeté l'objection. Le projet Facebook semblait trop attractif, impliquant l'investissement de centaines de millions de dollars dans la construction et la création de nombreux emplois.

Fait intéressant, le projet de centre de données Facebook en Suède à un moment donné s'est avéré extrêmement proche de l'échec.Un écologiste local a déclaré que le nouveau centre de données pourrait nuire aux oiseaux, y compris le rare pic suédois à trois doigts qui niche près du campus. Mais les responsables de la municipalité de Lulea ont rejeté l'objection. Le projet Facebook semblait trop attractif, impliquant l'investissement de centaines de millions de dollars dans la construction et la création de nombreux emplois. La batterie de serveurs de Facebook est l'une des installations informatiques les plus écoénergétiques de l'histoire humaine. Il y a environ un siècle, la Suède a commencé la construction de nombreuses centrales hydroélectriques pour organiser l'alimentation électrique de son industrie de l'acier et des pâtes et papiers. De telles centrales hydroélectriques sont apparues à Lulea. Maintenant, ils sont utilisés pour alimenter le centre de données Facebook, qui, en passant, consomme environ la même quantité d'électricité qu'une aciérie. Selon les ingénieurs de Facebook, l'objectif de l'entreprise est de fournir 50% de l'énergie à ses centres de données via des sources d'énergie respectueuses de l'environnement et renouvelables d'ici 2018. Et le campus suédois a considérablement amené Facebook à ce niveau. Le campus abrite également trois puissants générateurs diesel de forme carrée,qui sera nécessaire en cas d'interruptions improbables du fonctionnement du réseau électrique central."Tant de centrales hydroélectriques sont connectées au réseau régional que les générateurs ne sont tout simplement pas nécessaires", a déclaré Jay Park, directeur du développement des infrastructures de Facebook. Selon Park, lors de la connexion des sous-stations au nouveau centre de données, les ingénieurs de Facebook ont utilisé le système de redondance 2N, c'est-à-dire que l'électricité provient de réseaux indépendants utilisant différentes routes. Dans le premier cas, des câbles souterrains sont utilisés, tandis que dans le second - des lignes électriques aériennes.

La batterie de serveurs de Facebook est l'une des installations informatiques les plus écoénergétiques de l'histoire humaine. Il y a environ un siècle, la Suède a commencé la construction de nombreuses centrales hydroélectriques pour organiser l'alimentation électrique de son industrie de l'acier et des pâtes et papiers. De telles centrales hydroélectriques sont apparues à Lulea. Maintenant, ils sont utilisés pour alimenter le centre de données Facebook, qui, en passant, consomme environ la même quantité d'électricité qu'une aciérie. Selon les ingénieurs de Facebook, l'objectif de l'entreprise est de fournir 50% de l'énergie à ses centres de données via des sources d'énergie respectueuses de l'environnement et renouvelables d'ici 2018. Et le campus suédois a considérablement amené Facebook à ce niveau. Le campus abrite également trois puissants générateurs diesel de forme carrée,qui sera nécessaire en cas d'interruptions improbables du fonctionnement du réseau électrique central."Tant de centrales hydroélectriques sont connectées au réseau régional que les générateurs ne sont tout simplement pas nécessaires", a déclaré Jay Park, directeur du développement des infrastructures de Facebook. Selon Park, lors de la connexion des sous-stations au nouveau centre de données, les ingénieurs de Facebook ont utilisé le système de redondance 2N, c'est-à-dire que l'électricité provient de réseaux indépendants utilisant différentes routes. Dans le premier cas, des câbles souterrains sont utilisés, tandis que dans le second - des lignes électriques aériennes.

La batterie de serveurs aide Facebook à traiter environ 350 millions de photos, 4,5 milliards de likes et 10 milliards de messages par jour. L'entreprise a commencé la construction du centre de données suédois afin d'améliorer la qualité de service pour les utilisateurs européens qui génèrent de plus en plus de données électroniques. Dans le même temps, il y a une forte probabilité que si vous téléchargez un selfie à Londres ou publiez une mise à jour de statut à Paris, vos données seront stockées dans Lulea. Dans un centre de données typique, un et demi à deux watts d'équipements électromécaniques et de systèmes de refroidissement tombent sur chaque watt de charge informatique, le centre de données de Luleå fonctionne beaucoup plus efficacement: son coefficient PUE est de 1,04.

La batterie de serveurs aide Facebook à traiter environ 350 millions de photos, 4,5 milliards de likes et 10 milliards de messages par jour. L'entreprise a commencé la construction du centre de données suédois afin d'améliorer la qualité de service pour les utilisateurs européens qui génèrent de plus en plus de données électroniques. Dans le même temps, il y a une forte probabilité que si vous téléchargez un selfie à Londres ou publiez une mise à jour de statut à Paris, vos données seront stockées dans Lulea. Dans un centre de données typique, un et demi à deux watts d'équipements électromécaniques et de systèmes de refroidissement tombent sur chaque watt de charge informatique, le centre de données de Luleå fonctionne beaucoup plus efficacement: son coefficient PUE est de 1,04.Concept de châssis

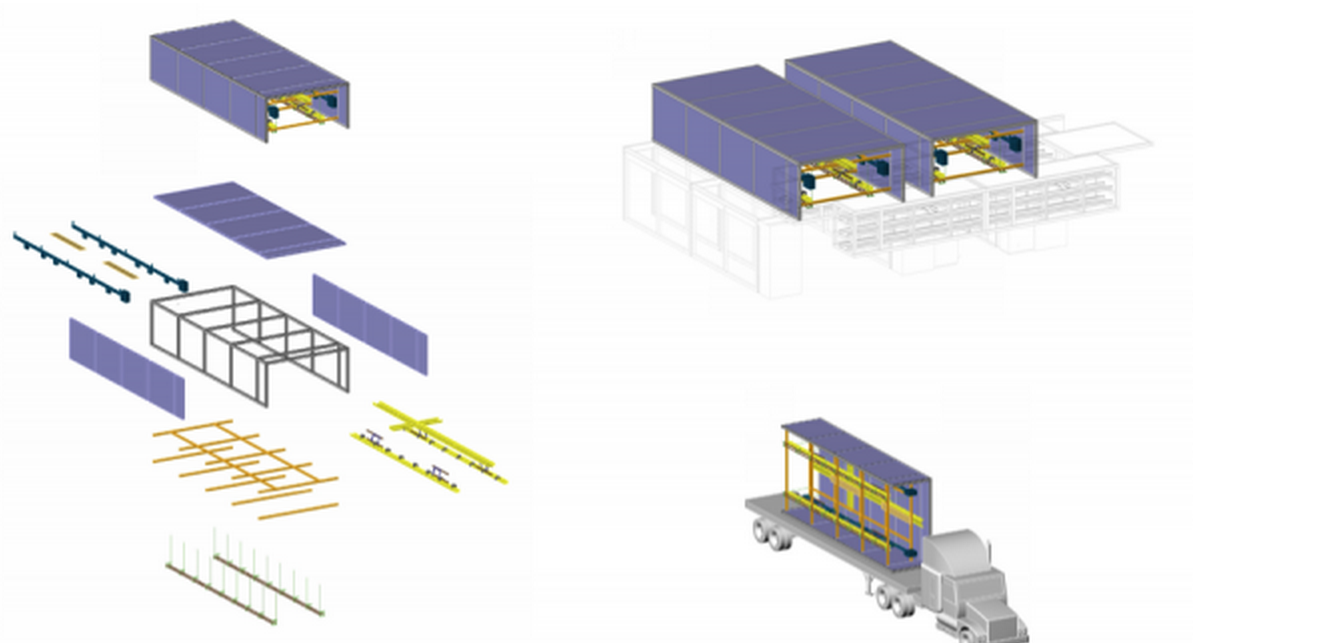

Facebook a construit une batterie de serveurs, répétant le concept de "châssis". En utilisant des conseils de diverses industries où l'automatisation et la standardisation de la production sont largement utilisées, nous avons réussi à former une vision de l'idée et à mettre en œuvre le «châssis» - la base (dans ce cas, un cadre en acier d'une taille approximative de 3,6 m par 12,2 m) et à utiliser la chaîne de montage pour ceux livrés sur le lieu de mise en œuvre éléments de travail. Marco Magarelli ingénieur de conception pour la construction du centre de données pour Facebook:

Marco Magarelli ingénieur de conception pour la construction du centre de données pour Facebook:, : , , - . «» , . «», . , .

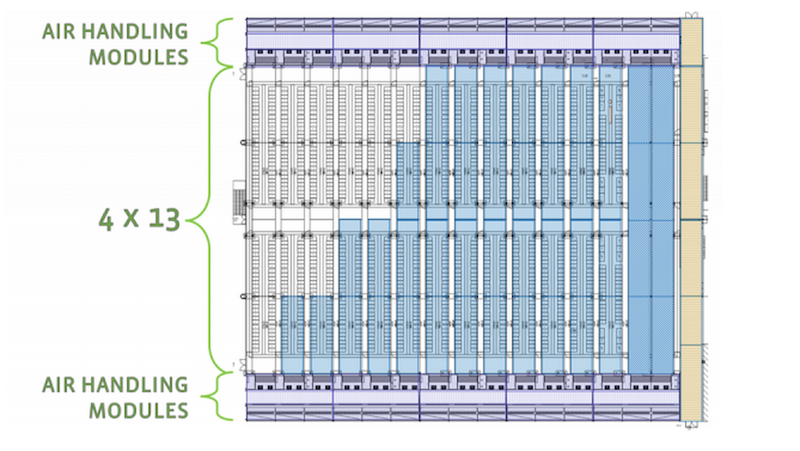

Après l'assemblage, le châssis est chargé dans le corps et transporté directement vers la batterie de serveurs elle-même. Dans le même bâtiment, l'ensemble livré est monté sur des poteaux en béton préparés. Deux châssis connectés forment un passage de 18 mètres. La salle des machines du centre de données habituel pourra accueillir 52 châssis, formant ainsi 13 couloirs, y compris ceux destinés au refroidissement des assemblages de serveurs.

Deux châssis connectés forment un passage de 18 mètres. La salle des machines du centre de données habituel pourra accueillir 52 châssis, formant ainsi 13 couloirs, y compris ceux destinés au refroidissement des assemblages de serveurs. Haute efficacité et respect de l'environnement du centre de données en raison de son emplacement. Les opérateurs suédois ont à leur disposition une électricité bon marché produite par des centrales hydroélectriques fiables, ainsi qu'un climat froid, que les informaticiens peuvent envelopper en leur faveur. Cela est dû, entre autres, aux basses températures de la région (en hiver, le thermomètre se maintient en moyenne autour de -20 C). Au lieu de dépenser de l'argent sur d'énormes climatiseurs énergivores pour refroidir des dizaines de milliers de serveurs à Lulea, les ingénieurs de Facebook utilisent l'air extérieur pour le faire fonctionner dans les heures ouvrables du centre de données après que l'air a été filtré et optimisé pour la température et l'humidité, ce qui refroidit les systèmes de serveurs. Le nouveau centre de données fonctionne comme un grand mécanisme.À l'intérieur se trouvent de longs couloirs, de nombreux serveurs avec des lumières clignotantes et le bourdonnement des fans géants.

Haute efficacité et respect de l'environnement du centre de données en raison de son emplacement. Les opérateurs suédois ont à leur disposition une électricité bon marché produite par des centrales hydroélectriques fiables, ainsi qu'un climat froid, que les informaticiens peuvent envelopper en leur faveur. Cela est dû, entre autres, aux basses températures de la région (en hiver, le thermomètre se maintient en moyenne autour de -20 C). Au lieu de dépenser de l'argent sur d'énormes climatiseurs énergivores pour refroidir des dizaines de milliers de serveurs à Lulea, les ingénieurs de Facebook utilisent l'air extérieur pour le faire fonctionner dans les heures ouvrables du centre de données après que l'air a été filtré et optimisé pour la température et l'humidité, ce qui refroidit les systèmes de serveurs. Le nouveau centre de données fonctionne comme un grand mécanisme.À l'intérieur se trouvent de longs couloirs, de nombreux serveurs avec des lumières clignotantes et le bourdonnement des fans géants.

Une bonne situation géographique permettra à huit mois de l'année de refroidir ce centre de données du nord uniquement en raison de l'air extérieur, ce qui le rend moins cher à entretenir en moyenne de 40% par rapport au même centre de données aux États-Unis. Un facteur important pour les investissements de Facebook a été le fait que pour la construction de son centre de données, la société américaine a reçu des subventions de l'Union européenne d'un montant de 10 millions de livres, et c'est ici que les prix de l'électricité les plus bas ont été offerts dans toute l'Europe.

Les ingénieurs de Facebook ont simplifié la conception des serveurs en éliminant l'utilisation d'un certain nombre de composants standard, tels que des emplacements de mémoire supplémentaires, des câbles et des boîtiers de protection en plastique. Ces serveurs, avec des cartes mères non protégées, sont logés dans un rack standard de la taille d'un réfrigérateur.

Les ingénieurs de Facebook ont simplifié la conception des serveurs en éliminant l'utilisation d'un certain nombre de composants standard, tels que des emplacements de mémoire supplémentaires, des câbles et des boîtiers de protection en plastique. Ces serveurs, avec des cartes mères non protégées, sont logés dans un rack standard de la taille d'un réfrigérateur.

Les experts sont convaincus que cette conception vous permet d'intensifier le flux d'air traversant chaque serveur. Le fonctionnement efficace de ces systèmes informatiques nécessite moins de capacité de refroidissement, car en raison du nombre réduit de composants, ils émettent moins d'énergie thermique que les analogues standard. Et en plus, les machines Facebook sont capables de fonctionner à des températures élevées.

Les experts sont convaincus que cette conception vous permet d'intensifier le flux d'air traversant chaque serveur. Le fonctionnement efficace de ces systèmes informatiques nécessite moins de capacité de refroidissement, car en raison du nombre réduit de composants, ils émettent moins d'énergie thermique que les analogues standard. Et en plus, les machines Facebook sont capables de fonctionner à des températures élevées.

Lorsque les ingénieurs de Facebook ont commencé à présenter leurs idées au "public", la plupart des experts dans le domaine des centres de données étaient encore sceptiques, en particulier en ce qui concerne le fonctionnement des systèmes de serveurs à des températures élevées. Mais, comme on dit, le temps a tout remis à sa place. En outre, l'amélioration continue des systèmes d'infrastructure par les participants à l'initiative Open Compute Project (en plus de Facebook, de nombreux fabricants de matériel et de micropuces, de fournisseurs d'hébergement et de colocation, ainsi que d'organisations bancaires éloignées du secteur informatique) a permis de les utiliser loin de l'Arctique. Prochain grand centre de données Facebook, il a été décidé de construire dans l'Iowa (USA), où le climat est tempéré. Comme en Suède, il y a plus qu'assez d'électricité bon marché à partir de sources renouvelables (en Iowa, les parcs éoliens jouent le rôle de centrales hydroélectriques).L'entreprise a également commencé à développer ses propres systèmes de stockage et équipements réseau.

Lorsque les ingénieurs de Facebook ont commencé à présenter leurs idées au "public", la plupart des experts dans le domaine des centres de données étaient encore sceptiques, en particulier en ce qui concerne le fonctionnement des systèmes de serveurs à des températures élevées. Mais, comme on dit, le temps a tout remis à sa place. En outre, l'amélioration continue des systèmes d'infrastructure par les participants à l'initiative Open Compute Project (en plus de Facebook, de nombreux fabricants de matériel et de micropuces, de fournisseurs d'hébergement et de colocation, ainsi que d'organisations bancaires éloignées du secteur informatique) a permis de les utiliser loin de l'Arctique. Prochain grand centre de données Facebook, il a été décidé de construire dans l'Iowa (USA), où le climat est tempéré. Comme en Suède, il y a plus qu'assez d'électricité bon marché à partir de sources renouvelables (en Iowa, les parcs éoliens jouent le rôle de centrales hydroélectriques).L'entreprise a également commencé à développer ses propres systèmes de stockage et équipements réseau.

HP a rapidement répondu à l'initiative du réseau social en lançant la vente d'un microserveur appelé Moonshot , qui est dépourvu de tout excès, est équipé de puces basse consommation et se caractérise par une efficacité énergétique élevée. La sortie de Moonshot a été le changement le plus radical dans la gamme de produits de ferme de serveurs entrepris par la société américaine ces dernières années. HP travaille également sur des mécanismes pour améliorer l'efficacité énergétique des serveurs grâce au refroidissement par eau.Selon le leadership du géant du réseau, seules quelques entreprises voudront faire face à de tels systèmes spécialisés qui ont été conçus principalement pour répondre aux besoins des grandes sociétés Internet qui possèdent des centres de données hyper-grands. Selon le porte-parole de Cisco, David McCulloch, le géant du réseau ne voit pas la nouvelle tendance comme une menace pour son activité. Il y a six ans, un autre grand fournisseur américain, Dell, a créé une équipe spéciale d'ingénieurs pour concevoir des systèmes informatiques sans les "fioritures" acquises par les sociétés Internet. Depuis lors, les revenus de Dell ont considérablement augmenté. Cela suggère que le vendeur a choisi la bonne direction pour le développement de son entreprise.Alors que le matériel spécialisé développé dans les murs des géants du Web Google et Amazon n'est accessible qu'aux opérateurs de centres de données de ces sociétés, l'ouverture de Facebook et la volonté du réseau social de partager leurs meilleures pratiques sont devenues les raisons de l'intérêt croissant pour ses centres de données, non seulement d'autres sociétés Internet - même les petites et moyennes entreprises sont activement intéressées par les développements du réseau social dans le domaine de l'amélioration de l'efficacité du centre de données. Facebook a créé des instructions étape par étape pour créer une batterie de serveurs hyper-échelle, qui peut être utilisée par toute entreprise disposant de suffisamment d'heures de travail et d'argent.

HP a rapidement répondu à l'initiative du réseau social en lançant la vente d'un microserveur appelé Moonshot , qui est dépourvu de tout excès, est équipé de puces basse consommation et se caractérise par une efficacité énergétique élevée. La sortie de Moonshot a été le changement le plus radical dans la gamme de produits de ferme de serveurs entrepris par la société américaine ces dernières années. HP travaille également sur des mécanismes pour améliorer l'efficacité énergétique des serveurs grâce au refroidissement par eau.Selon le leadership du géant du réseau, seules quelques entreprises voudront faire face à de tels systèmes spécialisés qui ont été conçus principalement pour répondre aux besoins des grandes sociétés Internet qui possèdent des centres de données hyper-grands. Selon le porte-parole de Cisco, David McCulloch, le géant du réseau ne voit pas la nouvelle tendance comme une menace pour son activité. Il y a six ans, un autre grand fournisseur américain, Dell, a créé une équipe spéciale d'ingénieurs pour concevoir des systèmes informatiques sans les "fioritures" acquises par les sociétés Internet. Depuis lors, les revenus de Dell ont considérablement augmenté. Cela suggère que le vendeur a choisi la bonne direction pour le développement de son entreprise.Alors que le matériel spécialisé développé dans les murs des géants du Web Google et Amazon n'est accessible qu'aux opérateurs de centres de données de ces sociétés, l'ouverture de Facebook et la volonté du réseau social de partager leurs meilleures pratiques sont devenues les raisons de l'intérêt croissant pour ses centres de données, non seulement d'autres sociétés Internet - même les petites et moyennes entreprises sont activement intéressées par les développements du réseau social dans le domaine de l'amélioration de l'efficacité du centre de données. Facebook a créé des instructions étape par étape pour créer une batterie de serveurs hyper-échelle, qui peut être utilisée par toute entreprise disposant de suffisamment d'heures de travail et d'argent.

Le top manager de Facebook Frank FrankovskyLe conseil d'administration de l'organisation à but non lucratif Open Compute Project Foundation, dirigée par le chef de Facebook Frank Frankovsky, comprend des chefs de tels géants du monde de la haute technologie et de la finance, respectivement Intel et Goldman Sachs. Dans le même temps, de nombreux grands fabricants de matériel asiatiques comme Quanta Computer et Tyan Computer ont déjà commencé à vendre des systèmes de serveurs basés sur des spécifications créées par des membres de l'Open Compute Project. L'initiative des médias sociaux s'est avérée très populaire.

Le top manager de Facebook Frank FrankovskyLe conseil d'administration de l'organisation à but non lucratif Open Compute Project Foundation, dirigée par le chef de Facebook Frank Frankovsky, comprend des chefs de tels géants du monde de la haute technologie et de la finance, respectivement Intel et Goldman Sachs. Dans le même temps, de nombreux grands fabricants de matériel asiatiques comme Quanta Computer et Tyan Computer ont déjà commencé à vendre des systèmes de serveurs basés sur des spécifications créées par des membres de l'Open Compute Project. L'initiative des médias sociaux s'est avérée très populaire.Campus de la batterie de serveurs

Une longue clôture a été posée autour du périmètre du campus du centre de données, qui a en fait été érigée pour empêcher les orignaux locaux de pénétrer à l'intérieur du campus.À l'intérieur du bâtiment, la culture de la Suède se mêle à l'américaine. À l'entrée, vous pouvez voir des photos colorées de cerfs à côté du logo et des montres Facebook, qui indiquent l'heure sur les autres campus de l'entreprise dans les États américains de Caroline du Nord, de l'Iowa et de l'Oregon. La plupart des cent cinquante employés suédois du campus sont des locaux. Les employés se mettent au travail sur des motoneiges et des vélos décorés du logo Facebook. Ils passent aussi souvent du temps ensemble, par exemple pour organiser la pêche sur la glace.

La plupart des cent cinquante employés suédois du campus sont des locaux. Les employés se mettent au travail sur des motoneiges et des vélos décorés du logo Facebook. Ils passent aussi souvent du temps ensemble, par exemple pour organiser la pêche sur la glace.

Source: https://habr.com/ru/post/fr387823/

All Articles