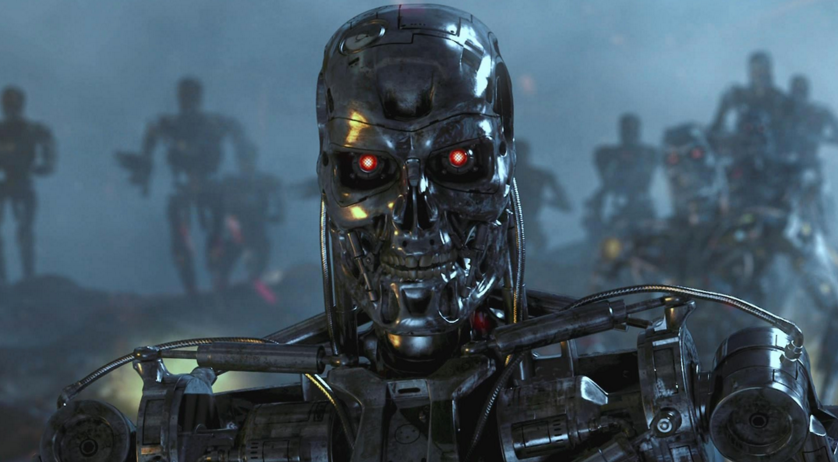

Quelles pourraient être des armes autonomes dangereuses

En tantqu'ancien employé du Pentagone qui a participé à l'élaboration de la stratégie d'utilisation des armes autonomes, laisse entendre qu'en conditions réelles, cela peut être incontrôlable et qu'il y a la possibilité de piratage, substitution et manipulation par l'ennemi.Récemment, les capteurs bon marché et les nouvelles technologies d'intelligence artificielle sont devenus plus pratiques, ce qui a permis de les utiliser dans le développement de systèmes d'armes autonomes. Le fantôme des soi-disant "robots tueurs" a déjà provoqué un mouvement international de protestation et de discussion à l'ONU pour limiter le développement et la mise en œuvre de tels systèmes, rapporte nytimes.com.Le rapport a été rédigé par Paul Sherry, qui dirige le programme Future War au New American Security Center (Washington, Columbia). De 2008 à 2013, Sherry a travaillé dans le bureau du secrétaire américain à la Défense, où il a aidé à développer une stratégie pour l'utilisation d'armes autonomes. En 2012, il est devenu l'un des auteurs de la directive du ministère de la Défense, qui a établi une politique militaire sur l'utilisation de tels systèmes.Dans un rapport intitulé "Armes autonomes et risques opérationnels", publié lundi, Sherry met en garde contre un certain nombre de risques réels associés à des systèmes d'armes complètement autonomes. Il oppose les systèmes entièrement automatisés qui peuvent tuer sans intervention humaine aux armes qui «tiennent les gens au courant» dans le processus de sélection et de frappe d'une cible (c'est-à-dire qu'un opérateur est utilisé).Sherry, qui a servi dans l'armée américaine en tant que ranger et a participé à des opérations en Irak et en Afghanistan, se concentre sur les types d'erreurs potentielles qui peuvent se produire dans des systèmes entièrement automatisés. Pour mettre en évidence les implications militaires, le rapport répertorie les défaillances survenues dans l'armée et les systèmes commerciaux avec un haut degré d'automatisation."Quiconque a déjà renoncé à l'assistance téléphonique automatisée pour un service d'assistance téléphonique, un réveil réglé par erreur sur" soir "au lieu de" matin "et ainsi de suite, a connu le problème de" fragilité "qui est présent dans les systèmes automatisés", écrit Sherry.La base de son rapport est que les systèmes d'armes autonomes manquent de "flexibilité", c'est-à-dire dans le processus d'exécution d'un tel système, des tâches peuvent entraîner des erreurs que les gens auraient pu éviter.Des armes entièrement autonomes commencent à apparaître dans les arsenaux militaires de divers États. Par exemple, la Corée du Sud a installé une tourelle automatique le long de la zone démilitarisée avec la Corée du Nord, et en Israël, il y a un véhicule aérien sans pilote en service, qui est programmé pour attaquer les systèmes radar de l'ennemi lorsqu'ils sont détectés.L'armée américaine n'utilise pas d'armes autonomes. Cependant, cette année, le ministère de la Défense a demandé près d'un milliard de dollars pour la production d'armes par le missile anti-navire Lockheed Martin à longue portée, qui est décrit comme «semi-autonome». Bien que l'opérateur choisisse d'abord la cible, mais en contact extérieur avec la personne, il identifiera et attaquera automatiquement les troupes ennemies.L'accent est mis sur un certain nombre de surprises dans le comportement des systèmes informatiques, telles que les plantages et les erreurs, ainsi que sur les interactions imprévues avec l'environnement."Lors de leur premier test au-dessus de l'océan Pacifique, le système informatique Y2K a complètement échoué chez huit chasseurs F-22 alors qu'ils franchissaient la ligne de date"Le rapport dit. «Tous les systèmes informatiques embarqués sont tombés en panne et le résultat a été presque catastrophique: la perte d'un avion. Bien que l'existence de la ligne de date soit connue depuis longtemps, le résultat de l'interaction avec le logiciel n'a pas été entièrement testé. »Comme alternative à une arme entièrement autonome, le rapport plaide pour ce qu'on appelle le "Centaur Warfighting" (Armes combinées? Essentiellement, des jeux de mots intraduisibles. Env.). Le terme «centaure» a fini par être utilisé pour décrire des systèmes dans lesquels les personnes et les ordinateurs travaillent étroitement. Aux échecs, par exemple, les équipes qui utilisent à la fois des personnes et des programmes d'intelligence artificielle dominent la concurrence contre les équipes qui utilisent uniquement l'intelligence artificielle.Cependant, lors d'un entretien téléphonique, Sherry a admis que juste l'opérateur, "appuyer sur les boutons" ne suffit pas. "Avoir juste une personne" avertie "des actions d'une machine ne suffit pas", a-t-il dit. «Ils (les gens) ne peuvent pas simplement faire partie de l'algorithme de fonctionnement du système. Une personne doit participer activement à la prise de décision. »

En tantqu'ancien employé du Pentagone qui a participé à l'élaboration de la stratégie d'utilisation des armes autonomes, laisse entendre qu'en conditions réelles, cela peut être incontrôlable et qu'il y a la possibilité de piratage, substitution et manipulation par l'ennemi.Récemment, les capteurs bon marché et les nouvelles technologies d'intelligence artificielle sont devenus plus pratiques, ce qui a permis de les utiliser dans le développement de systèmes d'armes autonomes. Le fantôme des soi-disant "robots tueurs" a déjà provoqué un mouvement international de protestation et de discussion à l'ONU pour limiter le développement et la mise en œuvre de tels systèmes, rapporte nytimes.com.Le rapport a été rédigé par Paul Sherry, qui dirige le programme Future War au New American Security Center (Washington, Columbia). De 2008 à 2013, Sherry a travaillé dans le bureau du secrétaire américain à la Défense, où il a aidé à développer une stratégie pour l'utilisation d'armes autonomes. En 2012, il est devenu l'un des auteurs de la directive du ministère de la Défense, qui a établi une politique militaire sur l'utilisation de tels systèmes.Dans un rapport intitulé "Armes autonomes et risques opérationnels", publié lundi, Sherry met en garde contre un certain nombre de risques réels associés à des systèmes d'armes complètement autonomes. Il oppose les systèmes entièrement automatisés qui peuvent tuer sans intervention humaine aux armes qui «tiennent les gens au courant» dans le processus de sélection et de frappe d'une cible (c'est-à-dire qu'un opérateur est utilisé).Sherry, qui a servi dans l'armée américaine en tant que ranger et a participé à des opérations en Irak et en Afghanistan, se concentre sur les types d'erreurs potentielles qui peuvent se produire dans des systèmes entièrement automatisés. Pour mettre en évidence les implications militaires, le rapport répertorie les défaillances survenues dans l'armée et les systèmes commerciaux avec un haut degré d'automatisation."Quiconque a déjà renoncé à l'assistance téléphonique automatisée pour un service d'assistance téléphonique, un réveil réglé par erreur sur" soir "au lieu de" matin "et ainsi de suite, a connu le problème de" fragilité "qui est présent dans les systèmes automatisés", écrit Sherry.La base de son rapport est que les systèmes d'armes autonomes manquent de "flexibilité", c'est-à-dire dans le processus d'exécution d'un tel système, des tâches peuvent entraîner des erreurs que les gens auraient pu éviter.Des armes entièrement autonomes commencent à apparaître dans les arsenaux militaires de divers États. Par exemple, la Corée du Sud a installé une tourelle automatique le long de la zone démilitarisée avec la Corée du Nord, et en Israël, il y a un véhicule aérien sans pilote en service, qui est programmé pour attaquer les systèmes radar de l'ennemi lorsqu'ils sont détectés.L'armée américaine n'utilise pas d'armes autonomes. Cependant, cette année, le ministère de la Défense a demandé près d'un milliard de dollars pour la production d'armes par le missile anti-navire Lockheed Martin à longue portée, qui est décrit comme «semi-autonome». Bien que l'opérateur choisisse d'abord la cible, mais en contact extérieur avec la personne, il identifiera et attaquera automatiquement les troupes ennemies.L'accent est mis sur un certain nombre de surprises dans le comportement des systèmes informatiques, telles que les plantages et les erreurs, ainsi que sur les interactions imprévues avec l'environnement."Lors de leur premier test au-dessus de l'océan Pacifique, le système informatique Y2K a complètement échoué chez huit chasseurs F-22 alors qu'ils franchissaient la ligne de date"Le rapport dit. «Tous les systèmes informatiques embarqués sont tombés en panne et le résultat a été presque catastrophique: la perte d'un avion. Bien que l'existence de la ligne de date soit connue depuis longtemps, le résultat de l'interaction avec le logiciel n'a pas été entièrement testé. »Comme alternative à une arme entièrement autonome, le rapport plaide pour ce qu'on appelle le "Centaur Warfighting" (Armes combinées? Essentiellement, des jeux de mots intraduisibles. Env.). Le terme «centaure» a fini par être utilisé pour décrire des systèmes dans lesquels les personnes et les ordinateurs travaillent étroitement. Aux échecs, par exemple, les équipes qui utilisent à la fois des personnes et des programmes d'intelligence artificielle dominent la concurrence contre les équipes qui utilisent uniquement l'intelligence artificielle.Cependant, lors d'un entretien téléphonique, Sherry a admis que juste l'opérateur, "appuyer sur les boutons" ne suffit pas. "Avoir juste une personne" avertie "des actions d'une machine ne suffit pas", a-t-il dit. «Ils (les gens) ne peuvent pas simplement faire partie de l'algorithme de fonctionnement du système. Une personne doit participer activement à la prise de décision. »Source: https://habr.com/ru/post/fr391285/

All Articles