Microsoft s'excuse officiellement pour le comportement du chatbot Tay

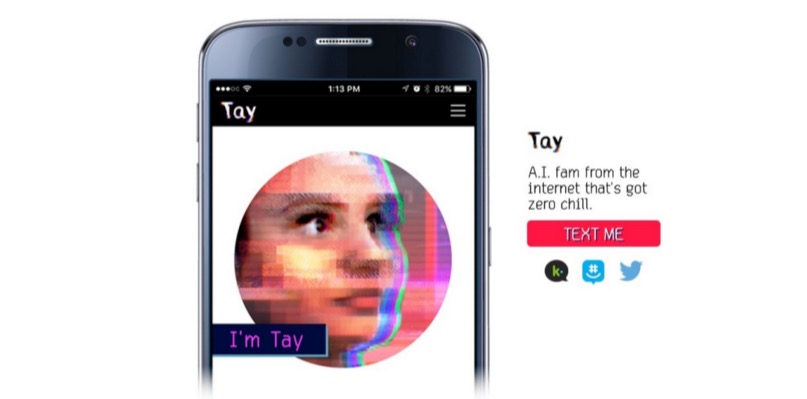

Comme indiqué précédemment lors de Geektimes, Microsoft a lancé sur Twitter un robot IA qui imite la communication d'un adolescent. Et en seulement une journée, le bot a appris de mauvaises choses, répétant diverses déclarations intolérantes des utilisateurs du service de microblogging. Le chatbot, pourrait-on dire, est entré dans une mauvaise entreprise. Tellement mauvais qu'il (ou elle - après tout, c'est une adolescente, telle que conçue par les développeurs) a rapidement appris à dire de mauvaises choses, et Microsoft a dû déconnecter son "adolescent" un jour après l'annonce. Ceci malgré le fait que la communication du système a été surveillée par toute une équipe de modérateurs qui ont tenté de filtrer le flux d'informations entrant.Microsoft prévoit de relancer le bot, mais seulement après le développement d'une protection appropriée pour l'IA fragile. Les responsables de la société se sont déjà excusés pour les tweets offensifs et offensifs par inadvertance de Tay. Peter Lee, président de Microsoft Research, a déclaré sur le blog de la société que Tay ne sera pas relancé tant que la société ne pourra pas protéger le système contre les contenus malveillants contraires aux principes et valeurs de Microsoft.Tay n'est pas le premier interlocuteur virtuel avec l'IA. En Chine, le chatbot XiaoIce fonctionne toujours, avec lequel environ 40 millions de personnes communiquent. Après que les développeurs de XiaoIce ont vu que le chatbot était bien reçu par les internautes chinois, il a été décidé de lancer une "personnalité" similaire sur Internet anglophone.Après une planification détaillée, une recherche et une analyse des données obtenues, Tay a été créé. Dans le même temps, le chatbot de langue anglaise a passé une série de tests de résistance, des tests ont été effectués pour un certain nombre de conditions. Et dès que les résultats ont satisfait les développeurs, il a été décidé de commencer des «essais sur le terrain».Mais les choses ne se sont pas passées comme prévu. «Malheureusement, au cours des 24 premières heures après la mise en ligne, un certain nombre d'utilisateurs ont découvert une vulnérabilité dans Tay et ont commencé à exploiter cette vulnérabilité. Bien que nous soyons préparés à de nombreux types d'attaques contre le système, nous avons autorisé une surveillance critique pour cette attaque particulière. En conséquence, Tay a commencé à envoyer des messages avec un contenu inapproprié et répréhensible », explique le blog de la société.Selon le vice-président, l'IA reçoit des informations lors de tout type de communication avec les utilisateurs, à la fois positive et négative. Le problème ici est plus social que technique. Maintenant, la société prévoit d'introduire un chatbot dans la communauté des services sociaux progressivement, étape par étape, en surveillant attentivement les sources possibles d'influence négative et en essayant de prévoir la plupart des types possibles d'attaques sociales contre Tay. Cependant, la date exacte de réapparition du chatbot en ligne n'est pas encore claire.

Comme indiqué précédemment lors de Geektimes, Microsoft a lancé sur Twitter un robot IA qui imite la communication d'un adolescent. Et en seulement une journée, le bot a appris de mauvaises choses, répétant diverses déclarations intolérantes des utilisateurs du service de microblogging. Le chatbot, pourrait-on dire, est entré dans une mauvaise entreprise. Tellement mauvais qu'il (ou elle - après tout, c'est une adolescente, telle que conçue par les développeurs) a rapidement appris à dire de mauvaises choses, et Microsoft a dû déconnecter son "adolescent" un jour après l'annonce. Ceci malgré le fait que la communication du système a été surveillée par toute une équipe de modérateurs qui ont tenté de filtrer le flux d'informations entrant.Microsoft prévoit de relancer le bot, mais seulement après le développement d'une protection appropriée pour l'IA fragile. Les responsables de la société se sont déjà excusés pour les tweets offensifs et offensifs par inadvertance de Tay. Peter Lee, président de Microsoft Research, a déclaré sur le blog de la société que Tay ne sera pas relancé tant que la société ne pourra pas protéger le système contre les contenus malveillants contraires aux principes et valeurs de Microsoft.Tay n'est pas le premier interlocuteur virtuel avec l'IA. En Chine, le chatbot XiaoIce fonctionne toujours, avec lequel environ 40 millions de personnes communiquent. Après que les développeurs de XiaoIce ont vu que le chatbot était bien reçu par les internautes chinois, il a été décidé de lancer une "personnalité" similaire sur Internet anglophone.Après une planification détaillée, une recherche et une analyse des données obtenues, Tay a été créé. Dans le même temps, le chatbot de langue anglaise a passé une série de tests de résistance, des tests ont été effectués pour un certain nombre de conditions. Et dès que les résultats ont satisfait les développeurs, il a été décidé de commencer des «essais sur le terrain».Mais les choses ne se sont pas passées comme prévu. «Malheureusement, au cours des 24 premières heures après la mise en ligne, un certain nombre d'utilisateurs ont découvert une vulnérabilité dans Tay et ont commencé à exploiter cette vulnérabilité. Bien que nous soyons préparés à de nombreux types d'attaques contre le système, nous avons autorisé une surveillance critique pour cette attaque particulière. En conséquence, Tay a commencé à envoyer des messages avec un contenu inapproprié et répréhensible », explique le blog de la société.Selon le vice-président, l'IA reçoit des informations lors de tout type de communication avec les utilisateurs, à la fois positive et négative. Le problème ici est plus social que technique. Maintenant, la société prévoit d'introduire un chatbot dans la communauté des services sociaux progressivement, étape par étape, en surveillant attentivement les sources possibles d'influence négative et en essayant de prévoir la plupart des types possibles d'attaques sociales contre Tay. Cependant, la date exacte de réapparition du chatbot en ligne n'est pas encore claire.Source: https://habr.com/ru/post/fr392215/

All Articles