Un programme de prévision du crime accusé de racisme

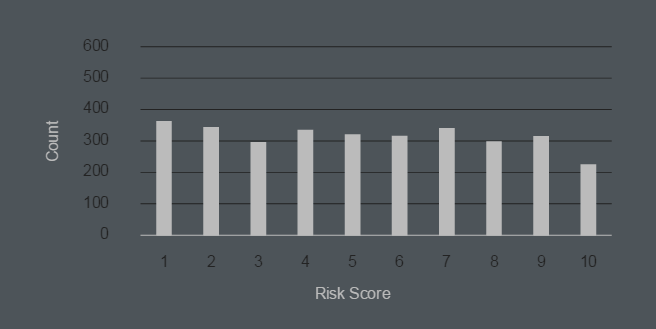

Depuis plusieurs années, les agences américaines d'application de la loi utilisent des programmes spéciaux qui analysent les statistiques de la criminalité et font des recommandations. Par exemple, en Californie, le programme calcule l'itinéraire de patrouille optimal , en tenant compte de la probabilité de criminalité dans chaque quartier de la ville à une heure précise de la journée. En 2014, la police de Chicago a compilé une liste de surveillance avec les noms de 400 des criminels les plus probables à l'avenir . L'algorithme de prédiction pour les criminels et les futures victimes inquiète les défenseurs des droits humains, bien qu'il ait montré une précision surprenante (plus de 70% des victimes d'un coup de feu à Chicago en 2016 figuraient sur une liste précompilée par le programme).Récemment, des programmes analytiques ont commencé à être utilisés dans les tribunaux. Le juge doit déterminer s'il doit punir le contrevenant à la sévérité minimale ou maximale prescrite par la loi pour un crime spécifique. Dans ce cas, le programme calcule ce que l'on appelle le «score d'évaluation des risques» sur la base des données disponibles. Cet indicateur détermine la probabilité de récidive et, par conséquent, affecte la sévérité de la peine.Ainsi, une analyse approfondie des résultats du programme par ProPublica, a révélé une tendance étrange: pour une raison quelconque, pour les Afro-Américains (Noirs), le programme donne une cote de risque plus élevée que pour les Blancs. En d'autres termes, l'algorithme présente une discrimination raciale! Et cela malgré le fait que ce programme ait été spécifiquement introduit dans le système judiciaire précisément pour exclure une telle discrimination.Un indicateur d'évaluation des risques est très important. Elle affecte la sévérité de la peine, l'ampleur du montant sous lequel le suspect est libéré sous caution, ainsi que le choix d'une mesure préventive et bien plus encore.Les journalistes de ProPublica ont analysé plus de 7 000 cas dans le comté de Broward, en Floride, où le score de risque du suspect est calculé par l'un des programmes les plus populaires de ce type de Northpointe .Il s'est avéré que seulement 20% des suspects pour lesquels le programme a identifié un risque élevé de commettre des crimes l'ont effectivement commis dans les deux ans suivant l'exposition. Même si vous prenez en compte des infractions mineures telles que le dépassement du périmètre d'une assignation à résidence, «l'exactitude du programme est un peu plus que de lancer une pièce de monnaie».Mais le pire, c'est que le programme fait preuve de discrimination raciale. Les taux d'évaluation des risques pour les Afro-Américains sont beaucoup plus élevés que pour les criminels blancs. La prévision erronée de rechute pour les Noirs est deux fois plus élevée que pour les Blancs.Indicateur d'évaluation des risques pour les Afro-Américains (1 - minimum, 10 - maximum)

Depuis plusieurs années, les agences américaines d'application de la loi utilisent des programmes spéciaux qui analysent les statistiques de la criminalité et font des recommandations. Par exemple, en Californie, le programme calcule l'itinéraire de patrouille optimal , en tenant compte de la probabilité de criminalité dans chaque quartier de la ville à une heure précise de la journée. En 2014, la police de Chicago a compilé une liste de surveillance avec les noms de 400 des criminels les plus probables à l'avenir . L'algorithme de prédiction pour les criminels et les futures victimes inquiète les défenseurs des droits humains, bien qu'il ait montré une précision surprenante (plus de 70% des victimes d'un coup de feu à Chicago en 2016 figuraient sur une liste précompilée par le programme).Récemment, des programmes analytiques ont commencé à être utilisés dans les tribunaux. Le juge doit déterminer s'il doit punir le contrevenant à la sévérité minimale ou maximale prescrite par la loi pour un crime spécifique. Dans ce cas, le programme calcule ce que l'on appelle le «score d'évaluation des risques» sur la base des données disponibles. Cet indicateur détermine la probabilité de récidive et, par conséquent, affecte la sévérité de la peine.Ainsi, une analyse approfondie des résultats du programme par ProPublica, a révélé une tendance étrange: pour une raison quelconque, pour les Afro-Américains (Noirs), le programme donne une cote de risque plus élevée que pour les Blancs. En d'autres termes, l'algorithme présente une discrimination raciale! Et cela malgré le fait que ce programme ait été spécifiquement introduit dans le système judiciaire précisément pour exclure une telle discrimination.Un indicateur d'évaluation des risques est très important. Elle affecte la sévérité de la peine, l'ampleur du montant sous lequel le suspect est libéré sous caution, ainsi que le choix d'une mesure préventive et bien plus encore.Les journalistes de ProPublica ont analysé plus de 7 000 cas dans le comté de Broward, en Floride, où le score de risque du suspect est calculé par l'un des programmes les plus populaires de ce type de Northpointe .Il s'est avéré que seulement 20% des suspects pour lesquels le programme a identifié un risque élevé de commettre des crimes l'ont effectivement commis dans les deux ans suivant l'exposition. Même si vous prenez en compte des infractions mineures telles que le dépassement du périmètre d'une assignation à résidence, «l'exactitude du programme est un peu plus que de lancer une pièce de monnaie».Mais le pire, c'est que le programme fait preuve de discrimination raciale. Les taux d'évaluation des risques pour les Afro-Américains sont beaucoup plus élevés que pour les criminels blancs. La prévision erronée de rechute pour les Noirs est deux fois plus élevée que pour les Blancs.Indicateur d'évaluation des risques pour les Afro-Américains (1 - minimum, 10 - maximum) Indicateur d'évaluation des risques pour les blancs (1 - minimum, 10 - maximum)

Indicateur d'évaluation des risques pour les blancs (1 - minimum, 10 - maximum) Les chercheurs concluent que le programme viole la loi, considérant spécifiquement le facteur de couleur de peau comme l'un des paramètres pour déterminer la probabilité d'un crime à l'avenir.Northpointe prétend que la race du suspect n'est en aucun cas prise en compte dans l'analyse. Mais d'autres facteurs fortement corrélés à la race sont pris en compte: le niveau d'éducation, le statut professionnel, les antécédents criminels des proches, la consommation de drogues par des amis / connaissances, etc. Le poids de chaque facteur dans le score final est classé - il s'agit de l'algorithme propriétaire de Northpointe.

Les chercheurs concluent que le programme viole la loi, considérant spécifiquement le facteur de couleur de peau comme l'un des paramètres pour déterminer la probabilité d'un crime à l'avenir.Northpointe prétend que la race du suspect n'est en aucun cas prise en compte dans l'analyse. Mais d'autres facteurs fortement corrélés à la race sont pris en compte: le niveau d'éducation, le statut professionnel, les antécédents criminels des proches, la consommation de drogues par des amis / connaissances, etc. Le poids de chaque facteur dans le score final est classé - il s'agit de l'algorithme propriétaire de Northpointe.Source: https://habr.com/ru/post/fr394313/

All Articles