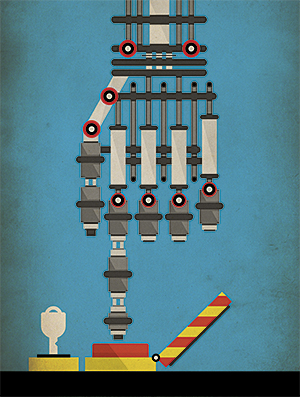

Donnerons-nous aux robots militaires une licence pour tuer?

Alors que les robots de guerre IA s'améliorent, l'essence de la guerre change

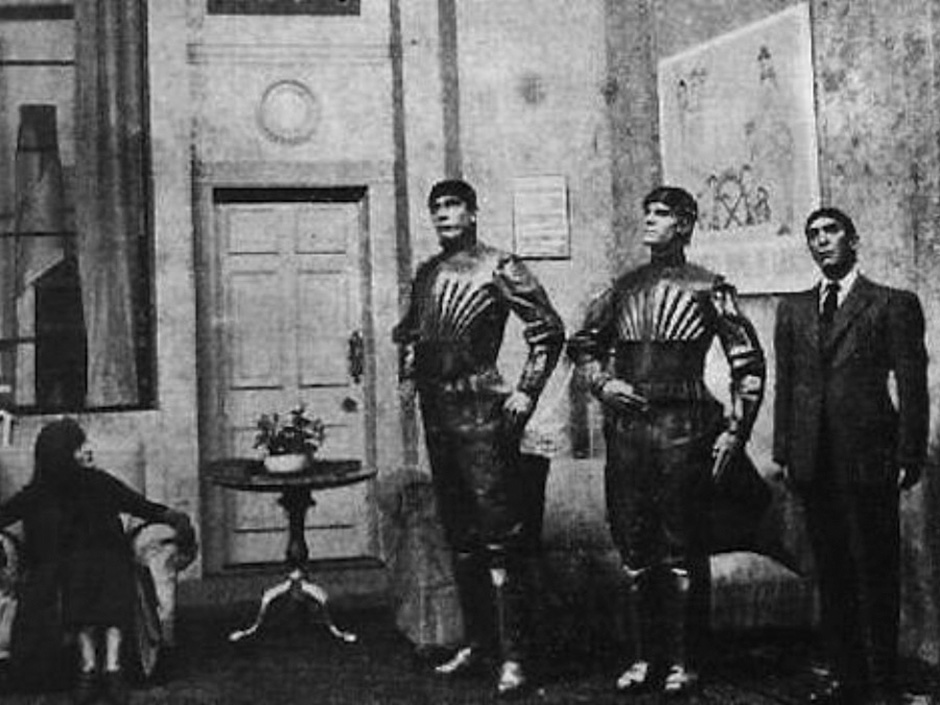

En 1920, l'écrivain tchèque Karel Čapek a écrit la pièce RUR (Rossum's Universal Robots, «Rossum Universal Robots»), dans laquelle il a donné au monde le mot «robot». Dans sa pièce, tout commence avec des gens artificiels - des robots qui travaillent dans des usines et produisent des biens bon marché. Et tout se termine avec le fait que les robots détruisent l'humanité. Ainsi, l'intrigue de longue date de la NF est née: les robots deviennent incontrôlables et se transforment en machines à tuer imparables. La littérature et le cinéma du 20e siècle continuent de nous fournir des exemples de robots qui détruisent le monde, et Hollywood le transforme constamment en franchises à succès: Matrix, Transformers et Terminator.Récemment, la peur de transformer la fiction en réalité est soutenue par une combinaison de circonstances, parmi lesquelles des améliorations de l'IA et de la robotique, la propagation dedrones militaires et robots terrestres en Irak et en Afghanistan. Les plus grandes puissances développent des armes intelligentes avec différents degrés d'autonomie et de mortalité. La plupart d'entre eux seront bientôt contrôlés à distance par des personnes, sans le commandement desquelles le robot ne pourra pas appuyer sur la détente. Mais, très probablement - et selon certains, même sans aucun doute, à un moment donné, les robots pourront fonctionner de manière complètement autonome, et le Rubicon sera allumé dans les affaires militaires: pour la première fois, un ensemble de micropuces et de logiciels décidera si une personne vit ou décède.Sans surprise, la menace des robots tueurs, comme ils les surnommaient affectueusement, a conduit à un débat passionné. De l'autre côté du différend, il y a ceux qui ont peur que les armes automatiques déclenchent une guerre générale et détruisent la civilisation, et ceux qui prétendent que les nouvelles armes ne sont qu'une autre classe d'armes guidées avec précision qui réduiront plutôt que d'augmenter le nombre de victimes. En décembre, plus d'une centaine de pays discuteront de cette question lors de la réunion de désarmement de l'OTAN à Genève.

En 1920, l'écrivain tchèque Karel Čapek a écrit la pièce RUR (Rossum's Universal Robots, «Rossum Universal Robots»), dans laquelle il a donné au monde le mot «robot». Dans sa pièce, tout commence avec des gens artificiels - des robots qui travaillent dans des usines et produisent des biens bon marché. Et tout se termine avec le fait que les robots détruisent l'humanité. Ainsi, l'intrigue de longue date de la NF est née: les robots deviennent incontrôlables et se transforment en machines à tuer imparables. La littérature et le cinéma du 20e siècle continuent de nous fournir des exemples de robots qui détruisent le monde, et Hollywood le transforme constamment en franchises à succès: Matrix, Transformers et Terminator.Récemment, la peur de transformer la fiction en réalité est soutenue par une combinaison de circonstances, parmi lesquelles des améliorations de l'IA et de la robotique, la propagation dedrones militaires et robots terrestres en Irak et en Afghanistan. Les plus grandes puissances développent des armes intelligentes avec différents degrés d'autonomie et de mortalité. La plupart d'entre eux seront bientôt contrôlés à distance par des personnes, sans le commandement desquelles le robot ne pourra pas appuyer sur la détente. Mais, très probablement - et selon certains, même sans aucun doute, à un moment donné, les robots pourront fonctionner de manière complètement autonome, et le Rubicon sera allumé dans les affaires militaires: pour la première fois, un ensemble de micropuces et de logiciels décidera si une personne vit ou décède.Sans surprise, la menace des robots tueurs, comme ils les surnommaient affectueusement, a conduit à un débat passionné. De l'autre côté du différend, il y a ceux qui ont peur que les armes automatiques déclenchent une guerre générale et détruisent la civilisation, et ceux qui prétendent que les nouvelles armes ne sont qu'une autre classe d'armes guidées avec précision qui réduiront plutôt que d'augmenter le nombre de victimes. En décembre, plus d'une centaine de pays discuteront de cette question lors de la réunion de désarmement de l'OTAN à Genève. Un drone contrôlé par l'homme

Un drone contrôlé par l'homme Le canon Phalanx tire de façon indépendanteL'année dernière, une telle discussion est tombée dans l'actualité lorsqu'un groupe de chercheurs de premier plan en IA a appelé à l'interdiction des "armes offensives autonomes fonctionnant sans contrôle humain significatif". Dans une lettre ouverte à une conférence internationale sur l'IA, un groupe de chercheurs a noté que de telles armes pouvaient conduire à une course aux armements internationaux contre l'IA et pouvaient être utilisées pour des tueries contractuelles, la déstabilisation de nations, la répression de peuples et la destruction sélective de groupes ethniques.La lettre a été signée par plus de 20 000 personnes, dont des personnalités telles que le physicien Stephen Hawking et l'entrepreneur Ilon Musk. Ce dernier a fait don de 10 millions de dollars au Boston Institute l'an dernier., engagée dans la protection de la vie des gens contre la menace hypothétique d'une IA hostile. Les chercheurs qui ont organisé l'écriture - Stuart Russell de l'Université de Californie à Berkeley, Max Tegmark du MIT et Toby Walsh de l'Université de New South Wales en Australie - ont élargi leur position dans un article pour le magazine IEEE Spectrum. Par exemple, dans un scénario, «un grand nombre de microrobots bon marché qui peuvent être placés par une seule personne sur le marché noir peuvent être tués, et des milliers ou des millions de personnes répondant aux critères de l'utilisateur pourront tuer».Ils ont également ajouté que «les armes autonomes peuvent devenir des armes de destruction massive. "Certains pays peuvent interdire son utilisation, tandis que d'autres pays, et, bien sûr, les terroristes, ne seront probablement pas en mesure de l'abandonner".On ne peut guère dire qu'une nouvelle course aux armements, qui pourrait déboucher sur des machines à tuer intelligentes, autonomes et mobiles, profitera à l'humanité tout entière. Cependant, cette course a déjà commencé.Les armes autonomes existent depuis plusieurs décennies, bien que ses rares spécimens aient jusqu'à présent été principalement utilisés pour la défense. Un exemple est le Phalanx , un pistolet contrôlé par ordinateur guidé par radar et monté sur des navires de guerre de l'US Navy. Elle peut automatiquement détecter, suivre, évaluer et tirer sur les missiles et les avions en approche, qu'elle considère comme une menace. Dans un mode entièrement autonome, la participation humaine n'est pas du tout requise.Un drone harop détruit une cibleDoDAAM Systems démontre les capacités de la montre robot Super aEgis II.Récemment, des développeurs militaires ont commencé à créer des robots autonomes offensifs. La société Israel Aerospace Industries fabrique des drones Harpy et Harop, ce qui conduit aux ondes radio des systèmes de défense aérienne de l' ennemi, et les tuer par la collision. La société affirme que ses drones se vendent bien dans le monde entier.La société sud-coréenne DoDAAM Systems a développé la montre robot Super aEgis II. Il tire avec une mitrailleuse et utilise la vision par ordinateur pour détecter et tirer sur des cibles (personnes) à une distance de 3 km. Il est allégué que l'armée sud-coréenne a effectué des tests de ces robots dans la zone démilitarisée à la frontière avec la Corée du Nord. DoDAAM déjàvendu 30 appareils de ce type à d'autres pays, dont plusieurs clients du Moyen-Orient.De nos jours, les systèmes avec un haut degré d'autonomie sont assez peu nombreux par rapport aux armes robotiques contrôlées par des personnes presque tout le temps, et surtout pendant le tir. Les analystes prédisent qu'avec le développement des affaires militaires, les armes auront de plus en plus de capacités autonomes."La guerre sera complètement différente et l'automatisation jouera un rôle où la vitesse est importante", a déclaré Peter Singer, expert en robot militaire au sein du groupe non politique de New America basé à Washington. Il lira que dans les batailles futures - comme dans les batailles entre différents UAV, ou lorsqu'un navire automatique rencontre un sous-marin automatique - une arme qui a une fraction de seconde d'avantage décidera de l'issue de la bataille. "Il peut y avoir un conflit soudain et intense dans lequel il n'y aura tout simplement pas le temps de mettre les gens à jour, car tout sera décidé en quelques secondes."L'armée américaine a décrit ses plans à long terme pour mener un nouveau type de guerre en utilisant des systèmes sans pilote, mais on ne sait toujours pas s'ils ont l'intention d'armer ces systèmes. SurLe forum du Washington Post en mars, le secrétaire américain à la Défense, Robert Work, dont le travail consiste à s'assurer que le Pentagone se tient au courant des dernières technologies, a souligné la nécessité d'investir dans l'IA et les robots. Selon lui, la présence croissante de systèmes autonomes sur le champ de bataille est "inévitable".En ce qui concerne les armes autonomes, Work insiste sur le fait que l'armée américaine "ne donnera pas à la machine le pouvoir de prendre des décisions fatales". Cependant, il a lui-même ajouté que «si un adversaire semble prêt à transférer de tels pouvoirs ... nous devrons prendre des décisions sur la question de la concurrence avec lui. Nous ne l'avons pas encore complètement compris, mais nous y réfléchissons beaucoup. »Vladimir Poutine regarde un cyborg militaire sur un VTT lors de la manifestation de l'année dernièreLe premier vol du drone CH-5 de la société chinoise China Aerospace Science and Technology Corporation, laRussie et la Chine adhèrent à une stratégie similaire dans le développement de systèmes de combat sans pilote pour les opérations sur terre, en mer et dans les airs, qui, bien que armés, dépendent toujours d'opérateurs vivants. Russian Platform-M est un petit robot avec télécommande, équipé d'un fusil d'assaut Kalachnikov et d'un lance-grenades. Il ressemble au système américain Talon SWORDS , un robot au sol capable de transporter du M16 et d'autres armes qui a été testé en Irak. La Russie a également construit un véhicule sans pilote Uranus-9, armé d'un canon de 30 mm et de missiles antichar guidés. Et l'année dernière, les Russes ont présenté un robot humanoïde militaire à Poutine.L' arsenal croissant de robots militaires en Chine comprend de nombreux drones d'attaque et de reconnaissance. CH-4 - UAV à longue durée d'action, qui rappelle le Predator américain. Divine Eagle - un drone à haute altitude pour chasser les bombardiers furtifs. De plus, des robots équipés de mitrailleuses similaires à Platform-M et Talon SWORDS ont été présentés lors de diverses présentations militaires en Chine.Ces trois pays approchent de la création de robots armés et, en augmentant leur autonomie, soulignent en même temps la préservation du rôle des personnes dans leur travail. Un grave problème apparaîtra pour l'interdiction des armes autonomes: il ne sera pas nécessairement applicable aux armes quasi autonomes. L'armée peut toujours développer secrètement des robots armés contrôlés par des personnes, mais en appuyant sur un bouton, vous passez en mode hors ligne. «Il sera très difficile pour les robots d'imposer un accord de limitation des armements», conclut Wendell Wallach, expert en éthique et technologie à l'Université de Yale. "La différence entre les armes autonomes et non autonomes ne peut être qu'une ligne de code", a-t-il déclaré lors d'une conférence.Dans les films, les robots deviennent parfois étonnamment autonomes, jusqu'à ce qu'ils prennent conscience presque à partir de zéro, ce qui surprend les gens . Dans le monde réel, malgré l'excitation générale des progrès de l'apprentissage automatique , les robots gagnent progressivement en autonomie. La même chose peut être attendue des armes autonomes.

Le canon Phalanx tire de façon indépendanteL'année dernière, une telle discussion est tombée dans l'actualité lorsqu'un groupe de chercheurs de premier plan en IA a appelé à l'interdiction des "armes offensives autonomes fonctionnant sans contrôle humain significatif". Dans une lettre ouverte à une conférence internationale sur l'IA, un groupe de chercheurs a noté que de telles armes pouvaient conduire à une course aux armements internationaux contre l'IA et pouvaient être utilisées pour des tueries contractuelles, la déstabilisation de nations, la répression de peuples et la destruction sélective de groupes ethniques.La lettre a été signée par plus de 20 000 personnes, dont des personnalités telles que le physicien Stephen Hawking et l'entrepreneur Ilon Musk. Ce dernier a fait don de 10 millions de dollars au Boston Institute l'an dernier., engagée dans la protection de la vie des gens contre la menace hypothétique d'une IA hostile. Les chercheurs qui ont organisé l'écriture - Stuart Russell de l'Université de Californie à Berkeley, Max Tegmark du MIT et Toby Walsh de l'Université de New South Wales en Australie - ont élargi leur position dans un article pour le magazine IEEE Spectrum. Par exemple, dans un scénario, «un grand nombre de microrobots bon marché qui peuvent être placés par une seule personne sur le marché noir peuvent être tués, et des milliers ou des millions de personnes répondant aux critères de l'utilisateur pourront tuer».Ils ont également ajouté que «les armes autonomes peuvent devenir des armes de destruction massive. "Certains pays peuvent interdire son utilisation, tandis que d'autres pays, et, bien sûr, les terroristes, ne seront probablement pas en mesure de l'abandonner".On ne peut guère dire qu'une nouvelle course aux armements, qui pourrait déboucher sur des machines à tuer intelligentes, autonomes et mobiles, profitera à l'humanité tout entière. Cependant, cette course a déjà commencé.Les armes autonomes existent depuis plusieurs décennies, bien que ses rares spécimens aient jusqu'à présent été principalement utilisés pour la défense. Un exemple est le Phalanx , un pistolet contrôlé par ordinateur guidé par radar et monté sur des navires de guerre de l'US Navy. Elle peut automatiquement détecter, suivre, évaluer et tirer sur les missiles et les avions en approche, qu'elle considère comme une menace. Dans un mode entièrement autonome, la participation humaine n'est pas du tout requise.Un drone harop détruit une cibleDoDAAM Systems démontre les capacités de la montre robot Super aEgis II.Récemment, des développeurs militaires ont commencé à créer des robots autonomes offensifs. La société Israel Aerospace Industries fabrique des drones Harpy et Harop, ce qui conduit aux ondes radio des systèmes de défense aérienne de l' ennemi, et les tuer par la collision. La société affirme que ses drones se vendent bien dans le monde entier.La société sud-coréenne DoDAAM Systems a développé la montre robot Super aEgis II. Il tire avec une mitrailleuse et utilise la vision par ordinateur pour détecter et tirer sur des cibles (personnes) à une distance de 3 km. Il est allégué que l'armée sud-coréenne a effectué des tests de ces robots dans la zone démilitarisée à la frontière avec la Corée du Nord. DoDAAM déjàvendu 30 appareils de ce type à d'autres pays, dont plusieurs clients du Moyen-Orient.De nos jours, les systèmes avec un haut degré d'autonomie sont assez peu nombreux par rapport aux armes robotiques contrôlées par des personnes presque tout le temps, et surtout pendant le tir. Les analystes prédisent qu'avec le développement des affaires militaires, les armes auront de plus en plus de capacités autonomes."La guerre sera complètement différente et l'automatisation jouera un rôle où la vitesse est importante", a déclaré Peter Singer, expert en robot militaire au sein du groupe non politique de New America basé à Washington. Il lira que dans les batailles futures - comme dans les batailles entre différents UAV, ou lorsqu'un navire automatique rencontre un sous-marin automatique - une arme qui a une fraction de seconde d'avantage décidera de l'issue de la bataille. "Il peut y avoir un conflit soudain et intense dans lequel il n'y aura tout simplement pas le temps de mettre les gens à jour, car tout sera décidé en quelques secondes."L'armée américaine a décrit ses plans à long terme pour mener un nouveau type de guerre en utilisant des systèmes sans pilote, mais on ne sait toujours pas s'ils ont l'intention d'armer ces systèmes. SurLe forum du Washington Post en mars, le secrétaire américain à la Défense, Robert Work, dont le travail consiste à s'assurer que le Pentagone se tient au courant des dernières technologies, a souligné la nécessité d'investir dans l'IA et les robots. Selon lui, la présence croissante de systèmes autonomes sur le champ de bataille est "inévitable".En ce qui concerne les armes autonomes, Work insiste sur le fait que l'armée américaine "ne donnera pas à la machine le pouvoir de prendre des décisions fatales". Cependant, il a lui-même ajouté que «si un adversaire semble prêt à transférer de tels pouvoirs ... nous devrons prendre des décisions sur la question de la concurrence avec lui. Nous ne l'avons pas encore complètement compris, mais nous y réfléchissons beaucoup. »Vladimir Poutine regarde un cyborg militaire sur un VTT lors de la manifestation de l'année dernièreLe premier vol du drone CH-5 de la société chinoise China Aerospace Science and Technology Corporation, laRussie et la Chine adhèrent à une stratégie similaire dans le développement de systèmes de combat sans pilote pour les opérations sur terre, en mer et dans les airs, qui, bien que armés, dépendent toujours d'opérateurs vivants. Russian Platform-M est un petit robot avec télécommande, équipé d'un fusil d'assaut Kalachnikov et d'un lance-grenades. Il ressemble au système américain Talon SWORDS , un robot au sol capable de transporter du M16 et d'autres armes qui a été testé en Irak. La Russie a également construit un véhicule sans pilote Uranus-9, armé d'un canon de 30 mm et de missiles antichar guidés. Et l'année dernière, les Russes ont présenté un robot humanoïde militaire à Poutine.L' arsenal croissant de robots militaires en Chine comprend de nombreux drones d'attaque et de reconnaissance. CH-4 - UAV à longue durée d'action, qui rappelle le Predator américain. Divine Eagle - un drone à haute altitude pour chasser les bombardiers furtifs. De plus, des robots équipés de mitrailleuses similaires à Platform-M et Talon SWORDS ont été présentés lors de diverses présentations militaires en Chine.Ces trois pays approchent de la création de robots armés et, en augmentant leur autonomie, soulignent en même temps la préservation du rôle des personnes dans leur travail. Un grave problème apparaîtra pour l'interdiction des armes autonomes: il ne sera pas nécessairement applicable aux armes quasi autonomes. L'armée peut toujours développer secrètement des robots armés contrôlés par des personnes, mais en appuyant sur un bouton, vous passez en mode hors ligne. «Il sera très difficile pour les robots d'imposer un accord de limitation des armements», conclut Wendell Wallach, expert en éthique et technologie à l'Université de Yale. "La différence entre les armes autonomes et non autonomes ne peut être qu'une ligne de code", a-t-il déclaré lors d'une conférence.Dans les films, les robots deviennent parfois étonnamment autonomes, jusqu'à ce qu'ils prennent conscience presque à partir de zéro, ce qui surprend les gens . Dans le monde réel, malgré l'excitation générale des progrès de l'apprentissage automatique , les robots gagnent progressivement en autonomie. La même chose peut être attendue des armes autonomes.Anthologie des robots tueurs

«R.U.R» 1920 – ,

«R.U.R» 1920 – , «2001: » (1968). ,

«2001: » (1968). , « » (1973).

« » (1973). « » (1982). -

« » (1982). - «» (1984). - -800

«» (1984). - -800 (1987). – , .

(1987). – , . (1999).

(1999). « » (2004). , ,

« » (2004). , , Moi, robot (2004). Les robots humanoïdes, contournant les trois lois de la robotique, causent des problèmes dans Chicago

Moi, robot (2004). Les robots humanoïdes, contournant les trois lois de la robotique, causent des problèmes dans Chicago Transformers (2007). Un gang de robots extraterrestres dirigé par Megatron essaie d'anéantir tous les humains."Souvent, lorsque les gens entendent parler d'armes autonomes, ils représentent le Terminator et commencent à dire:" Qu'avons-nous fait? ", Déclare Paul Scharre, directeur de programme pour les futures affaires militaires dans Le centre du nouveau groupe américain de recherche sur la sécurité à Washington. «Mais il est peu probable que l'armée veuille fabriquer une telle arme autonome.» Selon lui, les systèmes autonomes attaqueront très probablement des installations militaires telles que des radars, des chars, des navires, des sous-marins et des avions.La tâche d'identifier l'objectif - déterminer si un objet appartient à l'ennemi - est l'une des tâches les plus critiques pour l'IA. Les cibles en mouvement, les avions et les missiles, ont une trajectoire qui peut être suivie et prise sur la base d'une décision d'essayer de faire tomber un objet. C'est ainsi que le canon Phalanx fonctionne sur les navires de guerre américains, tout comme le système d'interception de missiles israéliens Iron Dome. Mais lorsque les gens sont choisis comme objectif, cette identification est compliquée. Même dans des conditions idéales, les tâches de reconnaissance d'objets et d'environnements auxquels les personnes sont confrontées en tout temps peuvent être trop complexes pour les robots.Un ordinateur peut distinguer la figure d'une personne, même si elle se déplace furtivement. Mais il est difficile pour l'algorithme de comprendre avec quoi les gens sont occupés et quelles intentions leur langage corporel et leurs expressions faciales donnent. Un homme lève-t-il une arme à feu ou un râteau? Tient-il une bombe ou un bébé?Scarre affirme que les armes robotiques, essayant de choisir une cible par elles-mêmes, épargnent face aux difficultés. Selon lui, la meilleure approche, du point de vue de la sécurité, de la légalité et de l'éthique, reste le développement de telles tactiques et technologies dans lesquelles les gens travaillent ensemble avec des robots . «Les militaires peuvent investir dans la robotique et l'automatisation avancées, mais en même temps, laisser la personne dans la chaîne de contrôle prendre des décisions sur les objectifs, pour être en sécurité», dit-il. «Après tout, les gens sont plus flexibles et s'adaptent mieux aux nouvelles situations que nous ne programmons peut-être pas. C'est particulièrement important dans une guerre où un adversaire essaie de vaincre vos systèmes, de les piéger et de pirater. »Sans surprise, les Sud-Coréens de DoDAAM produisent leurs robots de montre avec de sévères restrictions d'autonomie. Maintenant, leurs robots ne tireront pas tant qu'une personne n'aura pas confirmé la cible et ordonné de «tirer». "La version originale était un système d'incendie automatique", a déclaré un ingénieur de l'entreprise à la BBC l'année dernière . "Mais tous les clients ont demandé à y incorporer des procédures de sécurité ... Ils craignaient que le pistolet ne se trompe."D'autres experts estiment que le seul moyen d'éviter les erreurs fatales d'une arme autonome, impliquant notamment des civils, est d'élaborer des programmes appropriés. «Si nous sommes tellement stupides que nous continuons à nous tuer sur le champ de bataille, et si de plus en plus de pouvoirs sont transférés aux machines, pouvons-nous au moins nous assurer qu'elles font leur travail de manière éthique», explique Ronald Arkin, IT Spécialiste de l'Institut de technologie de Géorgie.Arkin est convaincu que les armes autonomes, comme les soldats, doivent suivre les règles de la guerre et les lois de la guerre, y compris le droit international humanitaireprotéger les civils et limiter la puissance et les types d'armes autorisés. Cela signifie que nous devons introduire certaines qualités morales dans leurs programmes afin qu'ils comprennent des situations différentes et distinguent le bien du mal. Leur logiciel doit avoir une sorte de boussole éthique.Depuis dix ans, Arkin travaille sur une telle boussole. À l'aide d'outils mathématiques et logiques du domaine de l'éthique des machines, il traduit les lois de la guerre et les règles de la guerre en variables et opérations compréhensibles par un ordinateur. Par exemple, l'une des variables contient la valeur de confiance de l'unité de contrôle éthique que la cible est un ennemi. Un autre, booléen, signifie si la force meurtrière des armes est autorisée ou interdite. À la fin, Arkin est arrivé à un certain ensemble d'algorithmes, et à l'aide de simulations informatiques et de scénarios de bataille simplifiés - par exemple, un UAV attaquant un groupe de personnes dans un champ ouvert - il a pu tester sa technique.Arkin admet que le projet parrainé par les forces armées américaines n'a pas encore atteint le stade du système fini et n'a été créé que pour prouver son opérabilité. Mais, à son avis, les résultats des travaux montrent que les robots sont encore meilleurs que les humains peuvent suivre les règles de la guerre. Par exemple, les robots peuvent effectuer des actions représentant un danger pour la vie avec plus de retenue que les humains, ne tirant qu'en réponse. Ou, à l'approche des civils, ils peuvent généralement cesser le feu, même s'ils sont eux-mêmes détruits. Les robots ne souffrent pas de stress, d'insatisfaction, de colère, de peur - et tout cela peut nuire à l'adoption des bonnes décisions chez les gens. Par conséquent, en théorie, les robots peuvent surpasser les soldats humains qui , souvent et parfois inévitablement, font des erreurs dans le feu de l'action."En conséquence, nous pouvons sauver des vies, en particulier la vie de personnes innocentes qui sont prises au piège dans une bataille", dit Arkin. "Et si les robots le font, la morale suggère la nécessité de les utiliser."Bien sûr, ce point de vue n'est pas généralement accepté. Les critiques Les armes autonomes insistent sur le fait que seule une interdiction préventive a un sens, car de telles armes apparaissent dans les coulisses. "Il n'y a pas un tel système de tir que nous pourrions indiquer et dire: oui, ici, c'est un robot tueur", dit Mary Wareham, Responsable du lobby de Human Rights Watch et Coor ordinator campagne pour l' interdiction des robots tueurs ( campagne pour l'arrêt de tueur Robots) - coalitions de diverses communautés humanitaires. - Nous parlons de nombreux systèmes d'armes différents qui fonctionnent de différentes manières. Mais nous sommes préoccupés par l'une de leurs caractéristiques communes - le manque de contrôle humain sur la fonction de sélection des cibles et d'attaque. "A l'ONU, les discussions sur les robots autonomes capables de tuer durent depuis cinq ans, mais les pays ne sont pas parvenus à un accord. En 2013, Christof Heyns, Rapporteur spécial des Nations Unies sur les droits de l'homme, a rédigé un rapport influent, dans lequel il a noté que les pays ont une occasion rare de discuter des risques des armes autonomes avant même leur développement. Maintenant, ayant participé à plusieurs réunions des Nations Unies, Hines dit que "si vous regardez en arrière, je suis quelque peu encouragé, mais si vous regardez en avant, il semble que nous aurons des problèmes si nous ne commençons pas à avancer plus vite."En décembre, la Convention des Nations Unies sur les armes classiques accueillera une conférence sur le travail quinquennal, et la question des robots autonomes est à l'ordre du jour. Mais il est peu probable que leur interdiction soit acceptée. Une telle décision nécessitera une décision unanime de tous les pays, et il y a un désaccord fondamental entre eux sur ce qu'il faut faire de la large gamme d'armes autonomes qui apparaîtra à l'avenir.En conséquence, les différends concernant les robots tueurs se résument à une discussion sur les gens. Les armes autonomes, au moins initialement, seront similaires à toute technologie: elles peuvent être introduites avec précision et prudence, ou de manière chaotique et catastrophique. Et les gens devront accepter les accusations. Par conséquent, la question «Les robots de combat autonomes sont-ils une bonne idée?» pas la bonne. Il vaut mieux se poser la question: "Avons-nous suffisamment confiance en nous pour faire confiance aux robots pour nos vies?"

Transformers (2007). Un gang de robots extraterrestres dirigé par Megatron essaie d'anéantir tous les humains."Souvent, lorsque les gens entendent parler d'armes autonomes, ils représentent le Terminator et commencent à dire:" Qu'avons-nous fait? ", Déclare Paul Scharre, directeur de programme pour les futures affaires militaires dans Le centre du nouveau groupe américain de recherche sur la sécurité à Washington. «Mais il est peu probable que l'armée veuille fabriquer une telle arme autonome.» Selon lui, les systèmes autonomes attaqueront très probablement des installations militaires telles que des radars, des chars, des navires, des sous-marins et des avions.La tâche d'identifier l'objectif - déterminer si un objet appartient à l'ennemi - est l'une des tâches les plus critiques pour l'IA. Les cibles en mouvement, les avions et les missiles, ont une trajectoire qui peut être suivie et prise sur la base d'une décision d'essayer de faire tomber un objet. C'est ainsi que le canon Phalanx fonctionne sur les navires de guerre américains, tout comme le système d'interception de missiles israéliens Iron Dome. Mais lorsque les gens sont choisis comme objectif, cette identification est compliquée. Même dans des conditions idéales, les tâches de reconnaissance d'objets et d'environnements auxquels les personnes sont confrontées en tout temps peuvent être trop complexes pour les robots.Un ordinateur peut distinguer la figure d'une personne, même si elle se déplace furtivement. Mais il est difficile pour l'algorithme de comprendre avec quoi les gens sont occupés et quelles intentions leur langage corporel et leurs expressions faciales donnent. Un homme lève-t-il une arme à feu ou un râteau? Tient-il une bombe ou un bébé?Scarre affirme que les armes robotiques, essayant de choisir une cible par elles-mêmes, épargnent face aux difficultés. Selon lui, la meilleure approche, du point de vue de la sécurité, de la légalité et de l'éthique, reste le développement de telles tactiques et technologies dans lesquelles les gens travaillent ensemble avec des robots . «Les militaires peuvent investir dans la robotique et l'automatisation avancées, mais en même temps, laisser la personne dans la chaîne de contrôle prendre des décisions sur les objectifs, pour être en sécurité», dit-il. «Après tout, les gens sont plus flexibles et s'adaptent mieux aux nouvelles situations que nous ne programmons peut-être pas. C'est particulièrement important dans une guerre où un adversaire essaie de vaincre vos systèmes, de les piéger et de pirater. »Sans surprise, les Sud-Coréens de DoDAAM produisent leurs robots de montre avec de sévères restrictions d'autonomie. Maintenant, leurs robots ne tireront pas tant qu'une personne n'aura pas confirmé la cible et ordonné de «tirer». "La version originale était un système d'incendie automatique", a déclaré un ingénieur de l'entreprise à la BBC l'année dernière . "Mais tous les clients ont demandé à y incorporer des procédures de sécurité ... Ils craignaient que le pistolet ne se trompe."D'autres experts estiment que le seul moyen d'éviter les erreurs fatales d'une arme autonome, impliquant notamment des civils, est d'élaborer des programmes appropriés. «Si nous sommes tellement stupides que nous continuons à nous tuer sur le champ de bataille, et si de plus en plus de pouvoirs sont transférés aux machines, pouvons-nous au moins nous assurer qu'elles font leur travail de manière éthique», explique Ronald Arkin, IT Spécialiste de l'Institut de technologie de Géorgie.Arkin est convaincu que les armes autonomes, comme les soldats, doivent suivre les règles de la guerre et les lois de la guerre, y compris le droit international humanitaireprotéger les civils et limiter la puissance et les types d'armes autorisés. Cela signifie que nous devons introduire certaines qualités morales dans leurs programmes afin qu'ils comprennent des situations différentes et distinguent le bien du mal. Leur logiciel doit avoir une sorte de boussole éthique.Depuis dix ans, Arkin travaille sur une telle boussole. À l'aide d'outils mathématiques et logiques du domaine de l'éthique des machines, il traduit les lois de la guerre et les règles de la guerre en variables et opérations compréhensibles par un ordinateur. Par exemple, l'une des variables contient la valeur de confiance de l'unité de contrôle éthique que la cible est un ennemi. Un autre, booléen, signifie si la force meurtrière des armes est autorisée ou interdite. À la fin, Arkin est arrivé à un certain ensemble d'algorithmes, et à l'aide de simulations informatiques et de scénarios de bataille simplifiés - par exemple, un UAV attaquant un groupe de personnes dans un champ ouvert - il a pu tester sa technique.Arkin admet que le projet parrainé par les forces armées américaines n'a pas encore atteint le stade du système fini et n'a été créé que pour prouver son opérabilité. Mais, à son avis, les résultats des travaux montrent que les robots sont encore meilleurs que les humains peuvent suivre les règles de la guerre. Par exemple, les robots peuvent effectuer des actions représentant un danger pour la vie avec plus de retenue que les humains, ne tirant qu'en réponse. Ou, à l'approche des civils, ils peuvent généralement cesser le feu, même s'ils sont eux-mêmes détruits. Les robots ne souffrent pas de stress, d'insatisfaction, de colère, de peur - et tout cela peut nuire à l'adoption des bonnes décisions chez les gens. Par conséquent, en théorie, les robots peuvent surpasser les soldats humains qui , souvent et parfois inévitablement, font des erreurs dans le feu de l'action."En conséquence, nous pouvons sauver des vies, en particulier la vie de personnes innocentes qui sont prises au piège dans une bataille", dit Arkin. "Et si les robots le font, la morale suggère la nécessité de les utiliser."Bien sûr, ce point de vue n'est pas généralement accepté. Les critiques Les armes autonomes insistent sur le fait que seule une interdiction préventive a un sens, car de telles armes apparaissent dans les coulisses. "Il n'y a pas un tel système de tir que nous pourrions indiquer et dire: oui, ici, c'est un robot tueur", dit Mary Wareham, Responsable du lobby de Human Rights Watch et Coor ordinator campagne pour l' interdiction des robots tueurs ( campagne pour l'arrêt de tueur Robots) - coalitions de diverses communautés humanitaires. - Nous parlons de nombreux systèmes d'armes différents qui fonctionnent de différentes manières. Mais nous sommes préoccupés par l'une de leurs caractéristiques communes - le manque de contrôle humain sur la fonction de sélection des cibles et d'attaque. "A l'ONU, les discussions sur les robots autonomes capables de tuer durent depuis cinq ans, mais les pays ne sont pas parvenus à un accord. En 2013, Christof Heyns, Rapporteur spécial des Nations Unies sur les droits de l'homme, a rédigé un rapport influent, dans lequel il a noté que les pays ont une occasion rare de discuter des risques des armes autonomes avant même leur développement. Maintenant, ayant participé à plusieurs réunions des Nations Unies, Hines dit que "si vous regardez en arrière, je suis quelque peu encouragé, mais si vous regardez en avant, il semble que nous aurons des problèmes si nous ne commençons pas à avancer plus vite."En décembre, la Convention des Nations Unies sur les armes classiques accueillera une conférence sur le travail quinquennal, et la question des robots autonomes est à l'ordre du jour. Mais il est peu probable que leur interdiction soit acceptée. Une telle décision nécessitera une décision unanime de tous les pays, et il y a un désaccord fondamental entre eux sur ce qu'il faut faire de la large gamme d'armes autonomes qui apparaîtra à l'avenir.En conséquence, les différends concernant les robots tueurs se résument à une discussion sur les gens. Les armes autonomes, au moins initialement, seront similaires à toute technologie: elles peuvent être introduites avec précision et prudence, ou de manière chaotique et catastrophique. Et les gens devront accepter les accusations. Par conséquent, la question «Les robots de combat autonomes sont-ils une bonne idée?» pas la bonne. Il vaut mieux se poser la question: "Avons-nous suffisamment confiance en nous pour faire confiance aux robots pour nos vies?"Source: https://habr.com/ru/post/fr395139/

All Articles