Est-il possible d'introduire l'éthique dans l'algorithme des robomobiles?

Pour le meurtre commis par un robot, le programme (et les programmeurs) seront jugés

Année 2034. Un homme ivre erre sur le trottoir la nuit, trébuche et tombe juste devant le robot, qui le frappe et le tue sur le coup. S'il y avait une personne au volant d'une voiture, la mort serait reconnue comme un accident, car la faute incomberait au piéton, et pas un seul conducteur ne pourrait l'esquiver. Mais les normes pour le "conducteur moyen" (le terme " personne raisonnable " est présent dans la législation étrangère ) ont disparu dans les années 2020, lorsque la propagation des robots a réduit le nombre d'accidents de 90%. Maintenant, nous devons parler du "robot moyen".La famille de la victime poursuit le constructeur de véhicules robotisés, affirmant que bien que la voiture n'ait pas eu le temps de freiner, elle pourrait contourner un piéton, traverser un double solide et entrer en collision avec un robot venant en sens inverse. La reconstitution de l'incident à partir de capteurs robotisés de véhicules le confirme. L’avocat de la demanderesse, interrogeant un grand développeur de logiciels automobiles, demande: «Pourquoi la voiture n’a-t-elle pas tourné le dos?»Aujourd'hui, le tribunal ne demande pas aux conducteurs pourquoi ils ont fait ou non quelque chose. La question est discutable, car la personne se trompe - le conducteur peut paniquer, ne pas y penser, réagir à l'instinct. Mais lorsque le robot conduit la voiture, la question est "pourquoi?" tout à fait acceptable. Les normes éthiques des gens, qui ne sont pas très bien énoncées dans les lois, font de nombreuses hypothèses différentes auxquelles les ingénieurs n'ont tout simplement pas abouti. Le plus important d'entre eux - une personne peut comprendre quand vous devez vous écarter de la lettre de la loi afin de préserver son esprit. Désormais, les ingénieurs doivent enseigner aux machines et autres robots comment prendre des décisions intelligentes.L'informatisation du processus de contrôle a commencé dans les années 1970, lorsque des systèmes de freinage antiblocage sont apparus . Maintenant, chaque année, il y a des développements tels que la direction automatique, l'accélération automatique et le freinage d'urgence. Les essais de machines entièrement automatiques, bien qu'avec la participation d'un conducteur humain, sont déjà autorisés dans certains endroits en Grande-Bretagne, en Hollande, en Allemagne et au Japon. Aux États-Unis, elle est autorisée par la loi dans quatre États et le district de Columbia, et au moins elle n'est pas interdite dans les autres. Google, Nissan et Ford affirment que les robots motorisés apparaîtront dans 5 à 10 ans.Les véhicules automatiques collectent des informations environnementales à partir de capteurs - caméras vidéo, télémètres à ultrasons, radars, lidars. En Californie, les robomobiles sont tenues de fournir au ministère des Transports toutes les données du capteur 30 secondes avant toute collision qui s'est déjà suffisamment accumulée, y compris la collision provoquée par la machine Google . Les ingénieurs ont la possibilité de récupérer des événements dans la zone de collision de façon assez précise, en utilisant des enregistrements de ce que la machine pourrait capturer, des alternatives qu'elle considère et de la logique de comportement. L'ordinateur peut être amené à répéter son raisonnement - la façon dont il peut être demandé à la personne qui a joué au jeu ou au simulateur de conduite.Les régulateurs et les justiciables seront en mesure de maintenir des normes de sécurité surhumaines pour les véhicules robotisés et d'examiner de manière approfondie les collisions qui se produiront de toute façon - quoique rarement. Les fabricants et les programmeurs protégeront les actions de leurs produits d'une manière dont les conducteurs d'aujourd'hui n'ont jamais rêvé.La conduite est toujours un risque et les décisions concernant sa répartition entre les conducteurs, les piétons, les cyclistes et les biens contiennent une composante éthique. Pour les ingénieurs comme pour tous, il est important que le système décisionnel de la machine pèse les conséquences éthiques de ses actions.

Année 2034. Un homme ivre erre sur le trottoir la nuit, trébuche et tombe juste devant le robot, qui le frappe et le tue sur le coup. S'il y avait une personne au volant d'une voiture, la mort serait reconnue comme un accident, car la faute incomberait au piéton, et pas un seul conducteur ne pourrait l'esquiver. Mais les normes pour le "conducteur moyen" (le terme " personne raisonnable " est présent dans la législation étrangère ) ont disparu dans les années 2020, lorsque la propagation des robots a réduit le nombre d'accidents de 90%. Maintenant, nous devons parler du "robot moyen".La famille de la victime poursuit le constructeur de véhicules robotisés, affirmant que bien que la voiture n'ait pas eu le temps de freiner, elle pourrait contourner un piéton, traverser un double solide et entrer en collision avec un robot venant en sens inverse. La reconstitution de l'incident à partir de capteurs robotisés de véhicules le confirme. L’avocat de la demanderesse, interrogeant un grand développeur de logiciels automobiles, demande: «Pourquoi la voiture n’a-t-elle pas tourné le dos?»Aujourd'hui, le tribunal ne demande pas aux conducteurs pourquoi ils ont fait ou non quelque chose. La question est discutable, car la personne se trompe - le conducteur peut paniquer, ne pas y penser, réagir à l'instinct. Mais lorsque le robot conduit la voiture, la question est "pourquoi?" tout à fait acceptable. Les normes éthiques des gens, qui ne sont pas très bien énoncées dans les lois, font de nombreuses hypothèses différentes auxquelles les ingénieurs n'ont tout simplement pas abouti. Le plus important d'entre eux - une personne peut comprendre quand vous devez vous écarter de la lettre de la loi afin de préserver son esprit. Désormais, les ingénieurs doivent enseigner aux machines et autres robots comment prendre des décisions intelligentes.L'informatisation du processus de contrôle a commencé dans les années 1970, lorsque des systèmes de freinage antiblocage sont apparus . Maintenant, chaque année, il y a des développements tels que la direction automatique, l'accélération automatique et le freinage d'urgence. Les essais de machines entièrement automatiques, bien qu'avec la participation d'un conducteur humain, sont déjà autorisés dans certains endroits en Grande-Bretagne, en Hollande, en Allemagne et au Japon. Aux États-Unis, elle est autorisée par la loi dans quatre États et le district de Columbia, et au moins elle n'est pas interdite dans les autres. Google, Nissan et Ford affirment que les robots motorisés apparaîtront dans 5 à 10 ans.Les véhicules automatiques collectent des informations environnementales à partir de capteurs - caméras vidéo, télémètres à ultrasons, radars, lidars. En Californie, les robomobiles sont tenues de fournir au ministère des Transports toutes les données du capteur 30 secondes avant toute collision qui s'est déjà suffisamment accumulée, y compris la collision provoquée par la machine Google . Les ingénieurs ont la possibilité de récupérer des événements dans la zone de collision de façon assez précise, en utilisant des enregistrements de ce que la machine pourrait capturer, des alternatives qu'elle considère et de la logique de comportement. L'ordinateur peut être amené à répéter son raisonnement - la façon dont il peut être demandé à la personne qui a joué au jeu ou au simulateur de conduite.Les régulateurs et les justiciables seront en mesure de maintenir des normes de sécurité surhumaines pour les véhicules robotisés et d'examiner de manière approfondie les collisions qui se produiront de toute façon - quoique rarement. Les fabricants et les programmeurs protégeront les actions de leurs produits d'une manière dont les conducteurs d'aujourd'hui n'ont jamais rêvé.La conduite est toujours un risque et les décisions concernant sa répartition entre les conducteurs, les piétons, les cyclistes et les biens contiennent une composante éthique. Pour les ingénieurs comme pour tous, il est important que le système décisionnel de la machine pèse les conséquences éthiques de ses actions.

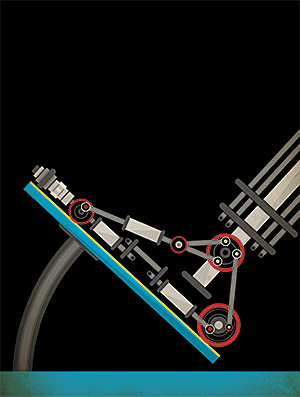

Collision Google Car avec un busLa réponse habituelle aux situations moralement ambiguës est de respecter la loi tout en minimisant les dommages. La stratégie est attrayante - elle permet non seulement au développeur de défendre facilement les actions de la voiture («Nous avons suivi la loi complètement»), mais transfère également la responsabilité de déterminer l'éthique aux législateurs. Malheureusement, cela impose également un fardeau trop lourd à la loi.Par exemple, dans la plupart des États, la loi s'appuie sur le bon sens des conducteurs et ne dit pas grand-chose sur le comportement avant une collision. Dans l'exemple décrit, la voiture, strictement conforme à la lettre de la loi, ne traverse pas le double solide, risquant une collision avec un ivrogne - bien qu'il n'y ait qu'un robot motorisé vide de l'autre côté de la route. La loi fait rarement des exceptions dans des cas d'urgence spécifiques comme une personne qui tombe sur la chaussée - et s'il le fait, comme c'est la coutume, par exemple, en Virginie, le texte de la loi implique que le franchissement d'un double solide est légal jusqu'à ce que la voiture s'écrase. ("Si un tel mouvement peut être effectué en toute sécurité"). Dans ce cas, les développeurs devront décider - dans quels cas il sera sûr de traverser le double solide.Un Robomobile sera rarement sûr à 100% que la route est vide et vous pouvez traverser un double solide sans crainte. Il évaluera le niveau de confiance à 98%, soit 99,99%. Les ingénieurs devront décider à l'avance du niveau de confiance suffisant pour traverser un double solide et de la manière dont la valeur acceptable peut varier en fonction de ce que la robotique essaie d'éviter sur la route - est-ce un sac en plastique ou un piéton tombé.Déjà, les robomobiles prennent des décisions sur la possibilité d'enfreindre la loi. Google a admisque ses voitures sont autorisées à dépasser la vitesse afin de rester dans le courant - où ralentir est dangereux. La plupart des gens préfèrent dépasser la vitesse dans diverses situations, par exemple, lorsqu'ils essaient de se précipiter à l'hôpital. Chris Gerdes [Chris Gerdes] et Sarah Thornton de l'Université de Stanford contre l' inclusion stricte des lois dans les algorithmes de prise de décision, car les conducteurs semblent considérer les lois suffisamment flexibles pour évaluer le coût de leur rupture par rapport au gain potentiel de vitesse. Personne ne veut ramper après un cycliste sur plusieurs kilomètres car votre voiture refuse d'appeler au moins un peu pour un double solide.Et même en respectant la loi, le robot peut prendre de nombreuses petites décisions qui sont sensibles du point de vue de la sécurité. En règle générale, les voies sur l'autoroute sont presque deux fois plus larges qu'une voiture typique, et les conducteurs peuvent utiliser cette largeur pour éviter les ordures ou pour s'éloigner des voitures à conduite irrégulière.Dans le brevet de 2014, Google développe cette idée et décrit comment un robot peut être placé sur une bande pour réduire les risques. La société donne un exemple de robot motorisé sur une route à trois voies avec un camion à droite et une petite voiture à gauche. Pour optimiser la sécurité, le robot doit avoir bougé un peu vers la gauche, plus près dans une petite machine.Il a l'air sain, et généralement tout le monde le fait - consciemment ou inconsciemment. Mais des questions éthiques se posent. En se dirigeant vers la petite machine, le robot a réduit le risque, mais l'a inégalement réparti. Une petite machine devrait-elle prendre plus de risques simplement parce qu'elle est petite? S'il s'agissait de préférences pour un conducteur particulier, il ne signifierait rien. Mais si une telle redistribution est formalisée et étendue à tous les robots, les conséquences seront plus graves.Dans chaque exemple, le robot motorisé prend en compte plusieurs valeurs - la valeur de l'objet qu'il peut heurter et la valeur de son passager. Les gens prennent des décisions instinctivement, et le robot le fera sur la base d'une stratégie de gestion des risques mûrement réfléchie qui définit le risque comme la quantité de dommages d'un événement indésirable, multipliée par sa probabilité.En 2014, Google a également breveté une application de gestion des risques. Le brevet décrit une machine qui peut décider de reconstruire afin de mieux voir le feu de circulation. Ou la voiture peut décider de rester dans la voie pour éviter le risque de collision - par exemple, en raison des indications d'un capteur défectueux - mais au prix de cela sera une mauvaise visibilité du feu de circulation. Le résultat de l'une des décisions est attribué une probabilité, ainsi qu'une valeur positive ou négative (avantage ou perte). Chaque valeur est multipliée par la probabilité et les valeurs obtenues peuvent être additionnées. Si les avantages l'emportent suffisamment sur les pertes, la machine manoeuvrera.Le problème est que le risque de collision est très faible - le conducteur moyen aux États-Unis subit un accident une fois tous les 257 000 kilomètres, ou une fois tous les 12 ans ( en Russie - une fois tous les 1,6 ans. Cette différence est peut-être due au fait qu'aux États-Unis, les gens voyagent beaucoup plus souvent sur l'autoroute - env. Par conséquent, même en commençant à recevoir un énorme flux de données des robots lorsque ceux-ci descendent dans la rue, nous serons en mesure d'obtenir très prochainement des estimations des probabilités de divers événements.Estimer le coût des dommages est encore plus difficile. Les dommages matériels sont faciles à évaluer - les assureurs ont une vaste expérience dans ce domaine - mais les blessures et les décès sont une autre affaire. L’historique de l’appropriation de la vie d’une personne, quelle que soit sa valeur, a de nombreuses années et s’exprime généralement par le montant d’argent qui pourrait être dépensé pour prévenir la victime moyenne. Une amélioration de la sécurité, avec 1% de chances de sauver la vie de 100 personnes, est une victime moyenne. Le ministère des Transports recommande de dépenser 9,1 millions de dollars pour éviter les pertes. Le nombre est dérivé des données de marketing, y compris les allocations dont les gens ont besoin pour un travail dangereux et les montants que les gens sont prêts à dépenser pour l'équipement de sécurité - par exemple, les avertisseurs de fumée. Vous devez peser non seulement la sécurité, mais aussi la perte de mobilité ou de temps,dépensés sur la route, que le Ministère estime à 26,44 $ l'heure.En mots, tout est beau. Mais l'évaluation des risques liés aux vies perdues et au temps passé sur la route n'inclut pas différentes évaluations morales de la façon dont nous mettons les gens en danger. Par exemple, un robot motorisé, évaluant la vie de toutes les personnes de la même manière, devrait donner plus d'espace à un motocycliste sans casque qu'à un motocycliste en tenue complète, car le premier sera moins susceptible de survivre. Mais c'est injuste - est-il possible de punir pour avoir pris soin de votre sécurité?Une autre différence entre l'éthique des robots et celle des humains est que l'éthique des premiers peut être déformée par les programmeurs, même pour une bonne raison. Imaginez que l'algorithme ajuste la taille de la zone tampon pour les piétons dans différentes zones sur la base de l'analyse du montant de l'indemnisation pour les réclamations déposées par les piétons dans un accident. D'une part, il est raisonnable, efficace et bien intentionné. D'un autre côté, des pénalités moins importantes peuvent dépendre du revenu moyen des personnes dans une zone particulière. Ensuite, l'algorithme punira les pauvres en leur donnant une zone tampon plus petite, augmentant ainsi légèrement leur risque d'être abattu.Il y a une tentation d'écarter des questions telles que purement académiques, mais vous ne pouvez pas les contourner, car les programmes prennent tout au sens propre. Vous devrez évaluer les conséquences des actions avant qu'elles ne soient exécutées - au stade du développement, et non au stade de la création des correctifs pour les logiciels.En partie à cause de cela, les chercheurs utilisent des situations hypothétiques dans lesquelles une machine doit choisir entre deux maux. L'une des tâches les plus célèbres de ce type est le problème d'un chariot.Un chariot lourd non contrôlé est transporté sur des rails. Sur son chemin, cinq personnes sont attachées aux rails par un philosophe fou. Heureusement, vous pouvez basculer la flèche - puis le chariot suivra un itinéraire différent et alternatif. Malheureusement, il y a une personne sur le revêtement, également attachée aux rails. Quelles sont vos actions?Allez-vous sacrifier une vie pour plusieurs? Sinon, à cause de votre inaction, les gens mourront toujours, alors comment pouvez-vous faire face à cette contradiction?Des livres ont été écrits sur les sujets de telles expériences, et ils vous permettent de tester des systèmes simples et directs qui traitent des questions éthiques et de trouver des domaines où il serait agréable de se plonger dans certaines des nuances. Supposons que nous programmions un robot pour éviter à tout prix les piétons. Si un piéton apparaît soudainement dans un tunnel à deux voies et que la voiture ne peut pas freiner à temps, elle devra désactiver la voie, même si elle est sur le chemin d'un bus avec des passagers. La probabilité d'un tel événement n'est pas aussi importante que le problème qu'il expose dans la logique de la voiture robot - que la supériorité absolue de la valeur d'un piéton sur toutes les autres personnes utilisant la chaussée peut être très dangereuse.L'éthique en robotique est une tâche résoluble. Nous le savons car dans d'autres domaines, nous avons déjà trouvé la possibilité de gérer à peu près les mêmes risques et avantages de manière sûre et raisonnable. Les organes des donneurs sont distribués aux patients sur la base d'une métrique calculée à partir des années de vie potentielles et de la qualité de leur vie. Les personnes exerçant des professions nécessaires comme agriculteur et enseignant sont exemptées de la conscription militaire.Les tâches des robomobiles sont plus compliquées. Ils doivent décider rapidement, sur la base d'informations incomplètes, dans des situations que les programmeurs n'auraient peut-être pas prévu d'utiliser une éthique qui doit être intégrée trop littéralement à l'algorithme. Heureusement, les gens n'attendent pas d'eux une sagesse surhumaine - seulement une justification rationnelle des actions d'une machine qui évalue les questions éthiques. La solution ne doit pas être parfaite - mais réfléchie et susceptible d'être protégée.

Collision Google Car avec un busLa réponse habituelle aux situations moralement ambiguës est de respecter la loi tout en minimisant les dommages. La stratégie est attrayante - elle permet non seulement au développeur de défendre facilement les actions de la voiture («Nous avons suivi la loi complètement»), mais transfère également la responsabilité de déterminer l'éthique aux législateurs. Malheureusement, cela impose également un fardeau trop lourd à la loi.Par exemple, dans la plupart des États, la loi s'appuie sur le bon sens des conducteurs et ne dit pas grand-chose sur le comportement avant une collision. Dans l'exemple décrit, la voiture, strictement conforme à la lettre de la loi, ne traverse pas le double solide, risquant une collision avec un ivrogne - bien qu'il n'y ait qu'un robot motorisé vide de l'autre côté de la route. La loi fait rarement des exceptions dans des cas d'urgence spécifiques comme une personne qui tombe sur la chaussée - et s'il le fait, comme c'est la coutume, par exemple, en Virginie, le texte de la loi implique que le franchissement d'un double solide est légal jusqu'à ce que la voiture s'écrase. ("Si un tel mouvement peut être effectué en toute sécurité"). Dans ce cas, les développeurs devront décider - dans quels cas il sera sûr de traverser le double solide.Un Robomobile sera rarement sûr à 100% que la route est vide et vous pouvez traverser un double solide sans crainte. Il évaluera le niveau de confiance à 98%, soit 99,99%. Les ingénieurs devront décider à l'avance du niveau de confiance suffisant pour traverser un double solide et de la manière dont la valeur acceptable peut varier en fonction de ce que la robotique essaie d'éviter sur la route - est-ce un sac en plastique ou un piéton tombé.Déjà, les robomobiles prennent des décisions sur la possibilité d'enfreindre la loi. Google a admisque ses voitures sont autorisées à dépasser la vitesse afin de rester dans le courant - où ralentir est dangereux. La plupart des gens préfèrent dépasser la vitesse dans diverses situations, par exemple, lorsqu'ils essaient de se précipiter à l'hôpital. Chris Gerdes [Chris Gerdes] et Sarah Thornton de l'Université de Stanford contre l' inclusion stricte des lois dans les algorithmes de prise de décision, car les conducteurs semblent considérer les lois suffisamment flexibles pour évaluer le coût de leur rupture par rapport au gain potentiel de vitesse. Personne ne veut ramper après un cycliste sur plusieurs kilomètres car votre voiture refuse d'appeler au moins un peu pour un double solide.Et même en respectant la loi, le robot peut prendre de nombreuses petites décisions qui sont sensibles du point de vue de la sécurité. En règle générale, les voies sur l'autoroute sont presque deux fois plus larges qu'une voiture typique, et les conducteurs peuvent utiliser cette largeur pour éviter les ordures ou pour s'éloigner des voitures à conduite irrégulière.Dans le brevet de 2014, Google développe cette idée et décrit comment un robot peut être placé sur une bande pour réduire les risques. La société donne un exemple de robot motorisé sur une route à trois voies avec un camion à droite et une petite voiture à gauche. Pour optimiser la sécurité, le robot doit avoir bougé un peu vers la gauche, plus près dans une petite machine.Il a l'air sain, et généralement tout le monde le fait - consciemment ou inconsciemment. Mais des questions éthiques se posent. En se dirigeant vers la petite machine, le robot a réduit le risque, mais l'a inégalement réparti. Une petite machine devrait-elle prendre plus de risques simplement parce qu'elle est petite? S'il s'agissait de préférences pour un conducteur particulier, il ne signifierait rien. Mais si une telle redistribution est formalisée et étendue à tous les robots, les conséquences seront plus graves.Dans chaque exemple, le robot motorisé prend en compte plusieurs valeurs - la valeur de l'objet qu'il peut heurter et la valeur de son passager. Les gens prennent des décisions instinctivement, et le robot le fera sur la base d'une stratégie de gestion des risques mûrement réfléchie qui définit le risque comme la quantité de dommages d'un événement indésirable, multipliée par sa probabilité.En 2014, Google a également breveté une application de gestion des risques. Le brevet décrit une machine qui peut décider de reconstruire afin de mieux voir le feu de circulation. Ou la voiture peut décider de rester dans la voie pour éviter le risque de collision - par exemple, en raison des indications d'un capteur défectueux - mais au prix de cela sera une mauvaise visibilité du feu de circulation. Le résultat de l'une des décisions est attribué une probabilité, ainsi qu'une valeur positive ou négative (avantage ou perte). Chaque valeur est multipliée par la probabilité et les valeurs obtenues peuvent être additionnées. Si les avantages l'emportent suffisamment sur les pertes, la machine manoeuvrera.Le problème est que le risque de collision est très faible - le conducteur moyen aux États-Unis subit un accident une fois tous les 257 000 kilomètres, ou une fois tous les 12 ans ( en Russie - une fois tous les 1,6 ans. Cette différence est peut-être due au fait qu'aux États-Unis, les gens voyagent beaucoup plus souvent sur l'autoroute - env. Par conséquent, même en commençant à recevoir un énorme flux de données des robots lorsque ceux-ci descendent dans la rue, nous serons en mesure d'obtenir très prochainement des estimations des probabilités de divers événements.Estimer le coût des dommages est encore plus difficile. Les dommages matériels sont faciles à évaluer - les assureurs ont une vaste expérience dans ce domaine - mais les blessures et les décès sont une autre affaire. L’historique de l’appropriation de la vie d’une personne, quelle que soit sa valeur, a de nombreuses années et s’exprime généralement par le montant d’argent qui pourrait être dépensé pour prévenir la victime moyenne. Une amélioration de la sécurité, avec 1% de chances de sauver la vie de 100 personnes, est une victime moyenne. Le ministère des Transports recommande de dépenser 9,1 millions de dollars pour éviter les pertes. Le nombre est dérivé des données de marketing, y compris les allocations dont les gens ont besoin pour un travail dangereux et les montants que les gens sont prêts à dépenser pour l'équipement de sécurité - par exemple, les avertisseurs de fumée. Vous devez peser non seulement la sécurité, mais aussi la perte de mobilité ou de temps,dépensés sur la route, que le Ministère estime à 26,44 $ l'heure.En mots, tout est beau. Mais l'évaluation des risques liés aux vies perdues et au temps passé sur la route n'inclut pas différentes évaluations morales de la façon dont nous mettons les gens en danger. Par exemple, un robot motorisé, évaluant la vie de toutes les personnes de la même manière, devrait donner plus d'espace à un motocycliste sans casque qu'à un motocycliste en tenue complète, car le premier sera moins susceptible de survivre. Mais c'est injuste - est-il possible de punir pour avoir pris soin de votre sécurité?Une autre différence entre l'éthique des robots et celle des humains est que l'éthique des premiers peut être déformée par les programmeurs, même pour une bonne raison. Imaginez que l'algorithme ajuste la taille de la zone tampon pour les piétons dans différentes zones sur la base de l'analyse du montant de l'indemnisation pour les réclamations déposées par les piétons dans un accident. D'une part, il est raisonnable, efficace et bien intentionné. D'un autre côté, des pénalités moins importantes peuvent dépendre du revenu moyen des personnes dans une zone particulière. Ensuite, l'algorithme punira les pauvres en leur donnant une zone tampon plus petite, augmentant ainsi légèrement leur risque d'être abattu.Il y a une tentation d'écarter des questions telles que purement académiques, mais vous ne pouvez pas les contourner, car les programmes prennent tout au sens propre. Vous devrez évaluer les conséquences des actions avant qu'elles ne soient exécutées - au stade du développement, et non au stade de la création des correctifs pour les logiciels.En partie à cause de cela, les chercheurs utilisent des situations hypothétiques dans lesquelles une machine doit choisir entre deux maux. L'une des tâches les plus célèbres de ce type est le problème d'un chariot.Un chariot lourd non contrôlé est transporté sur des rails. Sur son chemin, cinq personnes sont attachées aux rails par un philosophe fou. Heureusement, vous pouvez basculer la flèche - puis le chariot suivra un itinéraire différent et alternatif. Malheureusement, il y a une personne sur le revêtement, également attachée aux rails. Quelles sont vos actions?Allez-vous sacrifier une vie pour plusieurs? Sinon, à cause de votre inaction, les gens mourront toujours, alors comment pouvez-vous faire face à cette contradiction?Des livres ont été écrits sur les sujets de telles expériences, et ils vous permettent de tester des systèmes simples et directs qui traitent des questions éthiques et de trouver des domaines où il serait agréable de se plonger dans certaines des nuances. Supposons que nous programmions un robot pour éviter à tout prix les piétons. Si un piéton apparaît soudainement dans un tunnel à deux voies et que la voiture ne peut pas freiner à temps, elle devra désactiver la voie, même si elle est sur le chemin d'un bus avec des passagers. La probabilité d'un tel événement n'est pas aussi importante que le problème qu'il expose dans la logique de la voiture robot - que la supériorité absolue de la valeur d'un piéton sur toutes les autres personnes utilisant la chaussée peut être très dangereuse.L'éthique en robotique est une tâche résoluble. Nous le savons car dans d'autres domaines, nous avons déjà trouvé la possibilité de gérer à peu près les mêmes risques et avantages de manière sûre et raisonnable. Les organes des donneurs sont distribués aux patients sur la base d'une métrique calculée à partir des années de vie potentielles et de la qualité de leur vie. Les personnes exerçant des professions nécessaires comme agriculteur et enseignant sont exemptées de la conscription militaire.Les tâches des robomobiles sont plus compliquées. Ils doivent décider rapidement, sur la base d'informations incomplètes, dans des situations que les programmeurs n'auraient peut-être pas prévu d'utiliser une éthique qui doit être intégrée trop littéralement à l'algorithme. Heureusement, les gens n'attendent pas d'eux une sagesse surhumaine - seulement une justification rationnelle des actions d'une machine qui évalue les questions éthiques. La solution ne doit pas être parfaite - mais réfléchie et susceptible d'être protégée.Source: https://habr.com/ru/post/fr395143/

All Articles