Comment le centre régional de données de l'État a été créé

"Ce n'est pas un endroit qui colore une personne, mais une personne est un endroit"Nous voyons tous régulièrement des critiques de différents types de centres de traitement des données (DPC): grands, petits, sous-marins, arctiques, innovants, productifs, etc. Cependant, il n'y a pratiquement aucune critique de ces héros invisibles, qu'ils travaillent pour notre bien dans les donjons d'État, et encore plus dans les régions. Par conséquent, je veux partager ma propre expérience dans la création d'un centre de données dans le territoire de Stavropol.

"Ce n'est pas un endroit qui colore une personne, mais une personne est un endroit"Nous voyons tous régulièrement des critiques de différents types de centres de traitement des données (DPC): grands, petits, sous-marins, arctiques, innovants, productifs, etc. Cependant, il n'y a pratiquement aucune critique de ces héros invisibles, qu'ils travaillent pour notre bien dans les donjons d'État, et encore plus dans les régions. Par conséquent, je veux partager ma propre expérience dans la création d'un centre de données dans le territoire de Stavropol.Connaissance

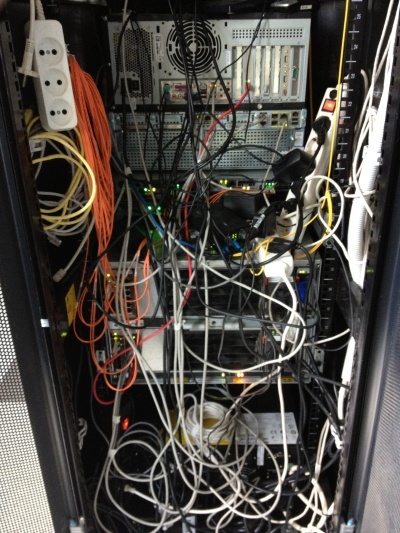

C'était une chaude journée d'été, comme je m'en souviens maintenant - le 18 juin 2012. Ce jour-là, pénétrant dans les murs de notre futur datacenter, j'ai vu exactement cette photo qui, franchement, m'a plongé dans un petit choc. Rencontrez GKU SK "Centre régional des technologies de l'information" à l'aube de son existence. Toutes les images sont cliquables. Il ressemblait au seul rack de notre futur centre de données en juin 2012.

C'était une organisation assez jeune. Sa tâche principale au moment du début de mon activité était le soutien à la gestion électronique des documents des pouvoirs publics (OGV). Mon objectif était de créer un centre de données et une organisation au service de celui-ci. Tous les systèmes d'information d'État existants devraient avoir migré vers le centre de données, ainsi que tous les nouveaux. A cette époque, il y avait une croissance rapide des services publics électroniques et l'automatisation générale des pouvoirs publics.À cette époque, il n'y avait pas de compréhension particulière de ce qu'était le gouvernement électronique. L'essentiel était de comprendre que «ce n'est pas l'endroit qui colore la personne, mais la personne - l'endroit». J'avais une petite équipe, composée de moi, mais c'était suffisant pour commencer, d'autant plus que l'automatisation des processus de routine évite les ballonnements inutiles du personnel. Et voici à quoi ressemblait le data center avant mon départ, juillet 2014.

Mon objectif était de créer un centre de données et une organisation au service de celui-ci. Tous les systèmes d'information d'État existants devraient avoir migré vers le centre de données, ainsi que tous les nouveaux. A cette époque, il y avait une croissance rapide des services publics électroniques et l'automatisation générale des pouvoirs publics.À cette époque, il n'y avait pas de compréhension particulière de ce qu'était le gouvernement électronique. L'essentiel était de comprendre que «ce n'est pas l'endroit qui colore la personne, mais la personne - l'endroit». J'avais une petite équipe, composée de moi, mais c'était suffisant pour commencer, d'autant plus que l'automatisation des processus de routine évite les ballonnements inutiles du personnel. Et voici à quoi ressemblait le data center avant mon départ, juillet 2014. Avant de rejoindre cette organisation, j'ai travaillé en tant que spécialiste de premier plan dans le département de support de l'une des principales banques. Et cette expérience a été très utile pour la mise en œuvre dans l' OGV . En général, j'ai beaucoup aimé le secteur bancaire du point de vue de l'informatique, mais c'est une autre histoire. Ici, je devais remplir dans une certaine mesure les fonctions du «cardinal gris»: l'ingénieur en chef qui était absent de l'état-major.Le centre de données que je crée doit non seulement être fiable, mais désastreux, productif et bon marché. Il me semble que c'est la raison pour laquelle j'ai été invitée à travailler ici, car je devais d'abord parvenir à une utilisation efficace de ce qui existe déjà. Et les intégrateurs n'avaient qu'une seule suggestion: si vous me donnez plus d'argent ... Y compris c'est pourquoi je n'ai pas eu recours aux services d'intégrateurs, etc. d'entrepreneurs.Étant donné que toutes les ressources ont effectivement migré vers notre «cloud» - nous avons dû introduire le concept de «cloud privé public», du fait que l'appareil conceptuel existant, composé de «nuages» «publics» et «privés», ne satisfaisait pas pleinement la logique de fourniture ressources. Dehors, c'était un «cloud privé», de l'intérieur c'était un «cloud public», mais uniquement pour l'UGA. À cet égard, la licence de logiciel comportait certaines caractéristiques.J'ai réussi à décider de certains moments conceptuels avant de venir dans l'organisation, ils devaient être pris pour acquis. Le projet s'est développé en étroite collaboration avec IBM, Microsoft, Cisco. Pourquoi exactement ces fournisseurs? Pour moi, c'est ainsi que cela s'est produit historiquement. Je le regrette? Pas du tout! D'autres fournisseurs pourraient-ils être utilisés? Bien sûr, par exemple, DELL, HP ou tout autre, ainsi que leurs combinaisons arbitraires.Comme une plate-forme de virtualisation a été achetée - VMWare, à l'époque 5 versions. Ici, je pense que tout le monde conviendra que le choix est pratiquement incontesté, car d'autres n'ont pas fourni de capacités similaires à la tolérance aux pannes.Lors de l'audit initial de la capacité disponible dans les racks de la ville, j'ai découvert une paire de châssis IBM BladeCenter: E et H.Le châssis était équipé de lames HS22, qui étaient loin d'être les pires, un milieu dur à l'époque. La condition, bien sûr, était quelque peu déplorable; les indicateurs d'erreur de gravure étaient particulièrement ennuyeux. Vue d'un des racks disponibles en juin 2012. Faites attention à l'installation de l'équipement "à travers la boîte", en particulier l'équipement Cisco.

Avant de rejoindre cette organisation, j'ai travaillé en tant que spécialiste de premier plan dans le département de support de l'une des principales banques. Et cette expérience a été très utile pour la mise en œuvre dans l' OGV . En général, j'ai beaucoup aimé le secteur bancaire du point de vue de l'informatique, mais c'est une autre histoire. Ici, je devais remplir dans une certaine mesure les fonctions du «cardinal gris»: l'ingénieur en chef qui était absent de l'état-major.Le centre de données que je crée doit non seulement être fiable, mais désastreux, productif et bon marché. Il me semble que c'est la raison pour laquelle j'ai été invitée à travailler ici, car je devais d'abord parvenir à une utilisation efficace de ce qui existe déjà. Et les intégrateurs n'avaient qu'une seule suggestion: si vous me donnez plus d'argent ... Y compris c'est pourquoi je n'ai pas eu recours aux services d'intégrateurs, etc. d'entrepreneurs.Étant donné que toutes les ressources ont effectivement migré vers notre «cloud» - nous avons dû introduire le concept de «cloud privé public», du fait que l'appareil conceptuel existant, composé de «nuages» «publics» et «privés», ne satisfaisait pas pleinement la logique de fourniture ressources. Dehors, c'était un «cloud privé», de l'intérieur c'était un «cloud public», mais uniquement pour l'UGA. À cet égard, la licence de logiciel comportait certaines caractéristiques.J'ai réussi à décider de certains moments conceptuels avant de venir dans l'organisation, ils devaient être pris pour acquis. Le projet s'est développé en étroite collaboration avec IBM, Microsoft, Cisco. Pourquoi exactement ces fournisseurs? Pour moi, c'est ainsi que cela s'est produit historiquement. Je le regrette? Pas du tout! D'autres fournisseurs pourraient-ils être utilisés? Bien sûr, par exemple, DELL, HP ou tout autre, ainsi que leurs combinaisons arbitraires.Comme une plate-forme de virtualisation a été achetée - VMWare, à l'époque 5 versions. Ici, je pense que tout le monde conviendra que le choix est pratiquement incontesté, car d'autres n'ont pas fourni de capacités similaires à la tolérance aux pannes.Lors de l'audit initial de la capacité disponible dans les racks de la ville, j'ai découvert une paire de châssis IBM BladeCenter: E et H.Le châssis était équipé de lames HS22, qui étaient loin d'être les pires, un milieu dur à l'époque. La condition, bien sûr, était quelque peu déplorable; les indicateurs d'erreur de gravure étaient particulièrement ennuyeux. Vue d'un des racks disponibles en juin 2012. Faites attention à l'installation de l'équipement "à travers la boîte", en particulier l'équipement Cisco. En tant que système de stockage, une étagère DS3512, connectée optiquement, avec des disques de 2 To installés, a été installée sur un site. Sur un autre site, les étagères DS3512 et DS3524 ont été installées.Sur le site de sauvegarde, l'espace libre a été alloué afin que VMWare ne démarre pas sans intervention manuelle: il détecte les autres copies installées et s'arrête, ne commençant qu'avec l'aide de la clé correspondante. La distribution elle-même s'est déroulée selon le principe: chaque machine virtuelle a son propre LUN. Lorsqu'il était nécessaire d'allouer de l'espace supplémentaire à la machine virtuelle, mais sur le LUN existant, ce n'était pas le cas ... Lessites étaient connectés entre eux par un réseau de données mince d'une largeur de 1 Gbit / s. Il n'y avait pas de réseau dédié pour le même trafic de virtualisation et de service.Après un bref examen et audit de l'infrastructure informatique (et c'était bref, car il n'y avait pratiquement pas d'infrastructure), il a été conclu que j'avais un exemple classique de la façon de le faire. Il n'y avait aucun schéma, ni documentation d'accompagnement, même les mots de passe administrateur étaient loin d'être connus, ils devaient être réinitialisés et restaurés.Je me mis résolument au travail.

En tant que système de stockage, une étagère DS3512, connectée optiquement, avec des disques de 2 To installés, a été installée sur un site. Sur un autre site, les étagères DS3512 et DS3524 ont été installées.Sur le site de sauvegarde, l'espace libre a été alloué afin que VMWare ne démarre pas sans intervention manuelle: il détecte les autres copies installées et s'arrête, ne commençant qu'avec l'aide de la clé correspondante. La distribution elle-même s'est déroulée selon le principe: chaque machine virtuelle a son propre LUN. Lorsqu'il était nécessaire d'allouer de l'espace supplémentaire à la machine virtuelle, mais sur le LUN existant, ce n'était pas le cas ... Lessites étaient connectés entre eux par un réseau de données mince d'une largeur de 1 Gbit / s. Il n'y avait pas de réseau dédié pour le même trafic de virtualisation et de service.Après un bref examen et audit de l'infrastructure informatique (et c'était bref, car il n'y avait pratiquement pas d'infrastructure), il a été conclu que j'avais un exemple classique de la façon de le faire. Il n'y avait aucun schéma, ni documentation d'accompagnement, même les mots de passe administrateur étaient loin d'être connus, ils devaient être réinitialisés et restaurés.Je me mis résolument au travail.Début du voyage

Dans une organisation aussi sérieuse à l'avenir, au moment de mon arrivée de l'infrastructure informatique, il n'y avait absolument rien: un seul commutateur intelligent, un réseau peer-to-peer, des ressources partagées sur chaque lieu de travail ... En général, tout est exactement comme vous imaginez la situation dans la région.En conséquence, l'infrastructure d'entreprise a été rapidement créée au départ. Pour ce qui a été commandé tout ce qui était disponible à l'époque. Armé d'un testeur de réseau, j'ai trouvé et signé tous les fils. Parce que au moment du câblage, il n'y avait pas de plan de travail - quelque part, au lieu de téléphones, il y avait des PC, quelque part il n'y avait pas assez de fils et de nombreux autres «charmes» standard.Malheureusement, lors de la conception de la salle des serveurs pour le futur centre de données, personne n'a fait un plancher surélevé ou un bac métallique sous le plafond. Naturellement, il n'y avait plus d'argent non plus, j'ai donc dû apporter la beauté par moi-même.Puisque personne ne m'a permis de raccourcir les fils à ce moment-là: "tout à coup, vous devez déplacer le rack dans le coin le plus éloigné de la pièce, quoi alors?" - J'ai dû faire la 110e croix sous le plafond, à partir de laquelle déjà abaisser les fils dans le rack. De sorte qu'en cas de mouvement du rack, les fils courts peuvent être retirés de la croix, en installant des fils plus longs. Vue du mur 110e panneau transversal lors de l'installation, ainsi qu'un couteau pour terminer les fils. Il a également été immédiatement déterminé que les cordons de brassage seraient codés par couleur, car il n'y avait qu'un câble bleu et rouge, la téléphonie devait être rouge et tout ce qui concernait le réseau était bleu. Type de rack avant et après l'installation.

Dans le rack, j'ai trouvé un PBX de bureau Panasonic KX-NCP500 équipé de 4 lignes de ville et 8 lignes d'extension. Je m'intéressais le moins aux lignes téléphoniques internes, tout de même c'était un PBX IP: petit à petit j'ai tout transféré en VOIP. Comme je n'avais aucune expérience sérieuse dans la configuration du PBX, j'ai dû bricoler un peu. Le simple fait de comprendre la nécessité d'élever votre propre serveur STUN en valait la peine ...

Il a également été immédiatement déterminé que les cordons de brassage seraient codés par couleur, car il n'y avait qu'un câble bleu et rouge, la téléphonie devait être rouge et tout ce qui concernait le réseau était bleu. Type de rack avant et après l'installation.

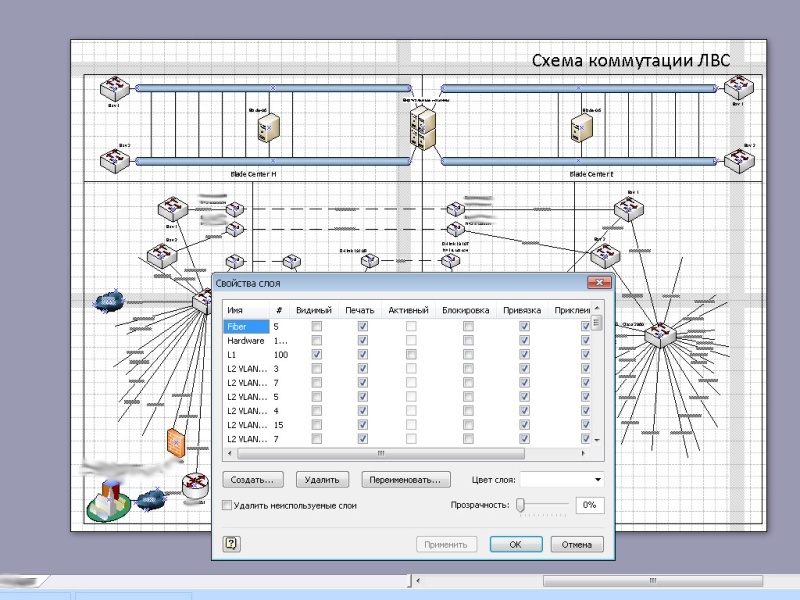

Dans le rack, j'ai trouvé un PBX de bureau Panasonic KX-NCP500 équipé de 4 lignes de ville et 8 lignes d'extension. Je m'intéressais le moins aux lignes téléphoniques internes, tout de même c'était un PBX IP: petit à petit j'ai tout transféré en VOIP. Comme je n'avais aucune expérience sérieuse dans la configuration du PBX, j'ai dû bricoler un peu. Le simple fait de comprendre la nécessité d'élever votre propre serveur STUN en valait la peine ... À ce titre, l'organisation ne disposait pas de son propre réseau; tous les ordinateurs étaient situés sur un grand intranet. Cela ne me convenait pas, en tant que personne qui n'avait aucune connaissance directe de la sécurité des informations: en bordure du réseau, j'ai installé et configuré un routeur basé sur FreeBSD, et segmenté le réseau lui-même afin de pouvoir contrôler pleinement l'interfonctionnement. Avec cette approche, généralement un seul segment souffre.Concernant le réseau OGV lui - même , il était clair qu'il existait quelque part. J'ai dû restaurer l'intégralité de la topologie du réseau en fonction des configurations des équipements, soigneusement esquisser et documenter. Les configurations ont progressivement pris une forme humaine; une logique de description et de dénomination est apparue.Après presque six mois, j'ai finalement trouvé de la documentation sur le réseau OGV. Mais, malheureusement, c'était 90% incompatible avec ce qui était en fait. Il était de très haute qualité, c'était l'un des rares documents sur lesquels il était possible de travailler. Mais personne, à en juger par les paramètres, n'a fonctionné.Au fur et à mesure de l'examen du réseau, j'ai mis à jour tous les nœuds, car presque tous les équipements avaient un logiciel très obsolète installé. Quelque part, cela n'était pas nécessaire, mais quelque part cela a corrigé les problèmes existants. Les anciennes (à gauche, 2012) et les nouvelles (à droite, 2016) vues de la page principale du site.

À ce titre, l'organisation ne disposait pas de son propre réseau; tous les ordinateurs étaient situés sur un grand intranet. Cela ne me convenait pas, en tant que personne qui n'avait aucune connaissance directe de la sécurité des informations: en bordure du réseau, j'ai installé et configuré un routeur basé sur FreeBSD, et segmenté le réseau lui-même afin de pouvoir contrôler pleinement l'interfonctionnement. Avec cette approche, généralement un seul segment souffre.Concernant le réseau OGV lui - même , il était clair qu'il existait quelque part. J'ai dû restaurer l'intégralité de la topologie du réseau en fonction des configurations des équipements, soigneusement esquisser et documenter. Les configurations ont progressivement pris une forme humaine; une logique de description et de dénomination est apparue.Après presque six mois, j'ai finalement trouvé de la documentation sur le réseau OGV. Mais, malheureusement, c'était 90% incompatible avec ce qui était en fait. Il était de très haute qualité, c'était l'un des rares documents sur lesquels il était possible de travailler. Mais personne, à en juger par les paramètres, n'a fonctionné.Au fur et à mesure de l'examen du réseau, j'ai mis à jour tous les nœuds, car presque tous les équipements avaient un logiciel très obsolète installé. Quelque part, cela n'était pas nécessaire, mais quelque part cela a corrigé les problèmes existants. Les anciennes (à gauche, 2012) et les nouvelles (à droite, 2016) vues de la page principale du site. Un site a également été développé, tout en augmentant leurs propres serveurs de noms, hébergement virtuel et service de messagerie. Je suis extrêmement méfiant à l'égard des organisations où les employés ont des adresses postales sur des services de courrier clairement publics, en particulier dans les agences gouvernementales.En général, les deux premiers mois de travail ont passé, je pense, est très fructueux.

Un site a également été développé, tout en augmentant leurs propres serveurs de noms, hébergement virtuel et service de messagerie. Je suis extrêmement méfiant à l'égard des organisations où les employés ont des adresses postales sur des services de courrier clairement publics, en particulier dans les agences gouvernementales.En général, les deux premiers mois de travail ont passé, je pense, est très fructueux.Première étape

Initialement, le centre de données, à l'exception du travail de workflow interministériel, n'était plus utilisé pour rien. Sans aucun doute, la gestion des documents est l'une des parties les plus importantes du travail des autorités de l'État. Souvent, précisément en raison de la complexité du flux de travail, de nombreux problèmes se posent dans le travail de notre État, et c'est le flux de travail électronique qui est le moyen de sortir de cette situation.Je pense que la question la plus intéressante est: sur quoi fonctionne le gouvernement électronique dans le centre de données?Le centre de données lui-même se compose de plusieurs sites géographiquement répartis, ainsi le concept de tolérance aux catastrophes est mis en œuvre, le travail est en cours 24/7/365. Les sites étaient interconnectés par le tronc principal de 32 fibres monomodes.Le cœur du centre de données est constitué par les lames IBM HS22 et HS23 (désormais Lenovo), qui sont distribuées par paires sur les plates-formes. Chaque châssis peut accueillir 14 lames; au stade initial, cinq lames ont été installées.Chaque lame possède deux processeurs, si je ne me trompe pas, E5650 (6 cœurs, 12 Mo de cache), de la RAM aux globes oculaires de 192 Go. Lames sans disques, à l'intérieur j'ai décidé d'installer un flash USB avec une image VMWare pour maximiser la séparation des performances et du stockage, les journaux sont écrits sur un stockage commun, la liaison montante de chaque lame est de 2 Gb / s. La liaison montante peut être augmentée à 10 Gbit / s en installant le commutateur approprié dans le châssis et une carte réseau dans chaque lame. Notre coffre principal à 32 fibres. Comme l'OS - VMWare vSphere (quand je l'ai quitté c'était 5.5) Standard. Dans une version plus avancée, je ne voyais pas l'intérêt: la fonctionnalité proposée était suffisante en excès. Et ce qui manquait - vous pouviez vous écrire.À l'avenir, le nombre de lames a été augmenté en raison de serveurs IBM HS23 légèrement plus puissants.La redondance électrique sur chaque site était différente, mais pas moins de deux sources d'alimentation. De plus, dans chaque rack, il existe des onduleurs installés en plus qui alimentent le rack, par paires: les alimentations des appareils sont alimentées par différentes sources. Cela n'est peut-être pas nécessaire, mais il y a eu quelques moments où les onduleurs montés en rack sont venus à la rescousse. Il n'y a pas grand-chose, mais il n'y a pas beaucoup de redondance dans de tels systèmes.Le refroidissement était également varié. Sur le site principal, il s'agissait de climatiseurs industriels muraux avec une unité d'équilibrage. La température a été maintenue à 21 degrés. Sur un autre site, il s'agissait de climatiseurs industriels au sol et d'une alimentation en air souterraine. IBM SVC . Contrôleur de notre système de stockage.

Le système de stockage est évolutif, basé sur le contrôleur IBM SVC , ce qui a permis d'obtenir la redondance du même RAID 6 + 1, la redondance sur plusieurs chemins, la connexion inter-unités via une optique de liaison montante 8 Gb / s. N'importe quelle partie du centre de données pourrait à tout moment passer en mode autonome en cas d'accident ou de maintenance de routine. Presque toutes les ressources physiques sont virtualisées dans un centre de données fonctionnel: le stockage est virtualisé sur la base d'IBM

Comme l'OS - VMWare vSphere (quand je l'ai quitté c'était 5.5) Standard. Dans une version plus avancée, je ne voyais pas l'intérêt: la fonctionnalité proposée était suffisante en excès. Et ce qui manquait - vous pouviez vous écrire.À l'avenir, le nombre de lames a été augmenté en raison de serveurs IBM HS23 légèrement plus puissants.La redondance électrique sur chaque site était différente, mais pas moins de deux sources d'alimentation. De plus, dans chaque rack, il existe des onduleurs installés en plus qui alimentent le rack, par paires: les alimentations des appareils sont alimentées par différentes sources. Cela n'est peut-être pas nécessaire, mais il y a eu quelques moments où les onduleurs montés en rack sont venus à la rescousse. Il n'y a pas grand-chose, mais il n'y a pas beaucoup de redondance dans de tels systèmes.Le refroidissement était également varié. Sur le site principal, il s'agissait de climatiseurs industriels muraux avec une unité d'équilibrage. La température a été maintenue à 21 degrés. Sur un autre site, il s'agissait de climatiseurs industriels au sol et d'une alimentation en air souterraine. IBM SVC . Contrôleur de notre système de stockage.

Le système de stockage est évolutif, basé sur le contrôleur IBM SVC , ce qui a permis d'obtenir la redondance du même RAID 6 + 1, la redondance sur plusieurs chemins, la connexion inter-unités via une optique de liaison montante 8 Gb / s. N'importe quelle partie du centre de données pourrait à tout moment passer en mode autonome en cas d'accident ou de maintenance de routine. Presque toutes les ressources physiques sont virtualisées dans un centre de données fonctionnel: le stockage est virtualisé sur la base d'IBM SVC ; les ressources du processeur et de la RAM sont virtualisées sur la base de VMWare vSphere. Si nous utilisons la virtualisation pour utiliser le VLAN sur les commutateurs, nous pouvons supposer que l'infrastructure réseau est également virtualisée.Presque tous les équipements qui prennent en charge la télécommande, je me suis connecté au réseau et configuré. Sur les sites distants, tout fonctionne, y compris via des prises électriques contrôlées (elles sont apparues plus tard, dans la deuxième étape), donc, en cas de panne d'un équipement sans télécommande, il peut être réinitialisé par l'alimentation.Le centre de données a été créé en plusieurs étapes. La première phase comprenait la mise en ordre et la création d'une infrastructure cloud. L'objectif initial était de créer un niveau de stockage virtualisé basé sur IBM SVC .Au fur et à mesure que le plan était mis en œuvre, les serveurs qui étaient auparavant situés dans des organisations tierces ont commencé à se déplacer vers notre site. Nous avons donc déplacé plusieurs anciens serveurs IBM avec des services fonctionnels qui consommaient et chauffaient plus d'un châssis BladeCenter. Bien sûr, progressivement, leurs services sont passés au «cloud». Type de racks dans l'éditeur.

La première chose est le plan. À ce moment-là, je pouvais déjà travailler comme bon me semblait (tout de même, il y avait déjà quelques projets terminés, et j'avais déjà gagné la confiance qu'il y avait des travaux sans échecs). Par conséquent, au début, j'ai assemblé les racks dans l'éditeur, discutant et discutant simultanément avec moi-même. Processus de montage de l'équipement dans un rack.

SVC ; les ressources du processeur et de la RAM sont virtualisées sur la base de VMWare vSphere. Si nous utilisons la virtualisation pour utiliser le VLAN sur les commutateurs, nous pouvons supposer que l'infrastructure réseau est également virtualisée.Presque tous les équipements qui prennent en charge la télécommande, je me suis connecté au réseau et configuré. Sur les sites distants, tout fonctionne, y compris via des prises électriques contrôlées (elles sont apparues plus tard, dans la deuxième étape), donc, en cas de panne d'un équipement sans télécommande, il peut être réinitialisé par l'alimentation.Le centre de données a été créé en plusieurs étapes. La première phase comprenait la mise en ordre et la création d'une infrastructure cloud. L'objectif initial était de créer un niveau de stockage virtualisé basé sur IBM SVC .Au fur et à mesure que le plan était mis en œuvre, les serveurs qui étaient auparavant situés dans des organisations tierces ont commencé à se déplacer vers notre site. Nous avons donc déplacé plusieurs anciens serveurs IBM avec des services fonctionnels qui consommaient et chauffaient plus d'un châssis BladeCenter. Bien sûr, progressivement, leurs services sont passés au «cloud». Type de racks dans l'éditeur.

La première chose est le plan. À ce moment-là, je pouvais déjà travailler comme bon me semblait (tout de même, il y avait déjà quelques projets terminés, et j'avais déjà gagné la confiance qu'il y avait des travaux sans échecs). Par conséquent, au début, j'ai assemblé les racks dans l'éditeur, discutant et discutant simultanément avec moi-même. Processus de montage de l'équipement dans un rack.

L'installation a été effectuée conformément aux normes, meilleures pratiques et recommandations décrites, y compris dans IBM RedBook. Bien sûr, pour la première fois on a ri de «lisons la documentation», mais après la «méthode de piquer scientifique» les serveurs ont refusé de se mettre en place parce que pour l'un la distance entre les guides est trop grande, pour l'autre elle est trop petite - j'ai trouvé dans redbook tailles standard pour l'assemblage des racks, après quoi tout s'est réuni la première fois. La première étape du centre de données, juin 2013. En arrière-plan, le tambourin de l'administrateur suprême.

L'installation a été effectuée conformément aux normes, meilleures pratiques et recommandations décrites, y compris dans IBM RedBook. Bien sûr, pour la première fois on a ri de «lisons la documentation», mais après la «méthode de piquer scientifique» les serveurs ont refusé de se mettre en place parce que pour l'un la distance entre les guides est trop grande, pour l'autre elle est trop petite - j'ai trouvé dans redbook tailles standard pour l'assemblage des racks, après quoi tout s'est réuni la première fois. La première étape du centre de données, juin 2013. En arrière-plan, le tambourin de l'administrateur suprême. À cette époque, près d'un an s'était déjà écoulé depuis que je travaillais dans cette organisation au profit de l'État. Pour cette année, nous n'avons jamais eu recours aux services d'intégrateurs ou d'autres entrepreneurs. Je ne vais pas dissimuler, plusieurs fois j'ai demandé l'aide de collègues d'IBM pour des questions sur leur équipement et nous avons résolu ensemble les problèmes qui sont apparus, pour lesquels merci beaucoup à eux.Le centre de données déjà à ce stade est devenu indicatif et a régulièrement reçu des visiteurs pour montrer comment l'infrastructure informatique devrait fonctionner et ressembler. Cela ne devrait pas ressembler à une infrastructure informatique. La photo a été prise le deuxième jour de mon travail, 2012.

À cette époque, près d'un an s'était déjà écoulé depuis que je travaillais dans cette organisation au profit de l'État. Pour cette année, nous n'avons jamais eu recours aux services d'intégrateurs ou d'autres entrepreneurs. Je ne vais pas dissimuler, plusieurs fois j'ai demandé l'aide de collègues d'IBM pour des questions sur leur équipement et nous avons résolu ensemble les problèmes qui sont apparus, pour lesquels merci beaucoup à eux.Le centre de données déjà à ce stade est devenu indicatif et a régulièrement reçu des visiteurs pour montrer comment l'infrastructure informatique devrait fonctionner et ressembler. Cela ne devrait pas ressembler à une infrastructure informatique. La photo a été prise le deuxième jour de mon travail, 2012. Dans le processus de mise en œuvre du centre de données, il est devenu clair pour moi que les ressources devaient être fournies efficacement aux consommateurs - les organismes gouvernementaux. De plus, certains systèmes d'information écrits «originaux» qui sont passés au cloud ont généré de très grandes quantités d'informations sur le réseau.L'accès exclusivement via Internet ne semblait pas une si bonne idée, car il n'offrait pas une vitesse d'accès suffisante. Et étendre la connexion à Internet dans tous les groupes publics est une procédure extrêmement coûteuse. Par conséquent, il a été décidé de déployer notre propre réseau: économiquement, du point de vue de la sécurité, cela s'est avéré beaucoup plus rentable que la location de canaux de communication du même Rostelecom.Pourquoi cela n'a-t-il pas été fait initialement? La réponse est simple: il n'y avait pas de spécialistes qualifiés pour ce travail, seulement des entrepreneurs externes. Et ils cherchent à s'accrocher à l'externalisation.À ce stade, j'ai dû planifier et construire l'infrastructure du fournisseur. Dans le même temps, de nombreux réseaux OGV ont dû être audités . Bien sûr, dans certains OGV, il y avait des services informatiques assez solides (par exemple, au ministère des Finances, au ministère de la Défense, dans l'appareil gouvernemental et autres). Mais il y en avait aussi des franchement faibles, où ils ne pouvaient même pas comprimer le fil. J'ai dû prendre tout ça sous mon aile, car la qualification le permettait.Par conséquent, en particulier, j'ai dû développer une architecture de réseau typique de l' OGVque l'on devait s'efforcer. La normalisation et la typification sont la clé d'un fonctionnement efficace. Selon mes calculs préliminaires, il devrait y avoir au moins 100 à 150 objets d'administration par personne dans notre organisation. L'une des fournitures d'équipement Cisco.

Bien sûr, dans le réseau en construction, en plus des technologies VLAN évidentes, d'autres technologies modernes ont été utilisées pour faciliter l'administration: OSPF, VTP, PVST, MSTP, HSRP, QoS, etc. Bien sûr, je voulais augmenter la redondance d'état, mais, malheureusement, ASR ne disposait pas de suffisamment de ressources matérielles. Malheureusement, cela n'a pas fonctionné pour arriver à MPLS. Oui, et ce n'était pas nécessaire. À mesure que le réseau se développait, j'ai commencé à prendre le contrôle de l'équipement OGV

Dans le processus de mise en œuvre du centre de données, il est devenu clair pour moi que les ressources devaient être fournies efficacement aux consommateurs - les organismes gouvernementaux. De plus, certains systèmes d'information écrits «originaux» qui sont passés au cloud ont généré de très grandes quantités d'informations sur le réseau.L'accès exclusivement via Internet ne semblait pas une si bonne idée, car il n'offrait pas une vitesse d'accès suffisante. Et étendre la connexion à Internet dans tous les groupes publics est une procédure extrêmement coûteuse. Par conséquent, il a été décidé de déployer notre propre réseau: économiquement, du point de vue de la sécurité, cela s'est avéré beaucoup plus rentable que la location de canaux de communication du même Rostelecom.Pourquoi cela n'a-t-il pas été fait initialement? La réponse est simple: il n'y avait pas de spécialistes qualifiés pour ce travail, seulement des entrepreneurs externes. Et ils cherchent à s'accrocher à l'externalisation.À ce stade, j'ai dû planifier et construire l'infrastructure du fournisseur. Dans le même temps, de nombreux réseaux OGV ont dû être audités . Bien sûr, dans certains OGV, il y avait des services informatiques assez solides (par exemple, au ministère des Finances, au ministère de la Défense, dans l'appareil gouvernemental et autres). Mais il y en avait aussi des franchement faibles, où ils ne pouvaient même pas comprimer le fil. J'ai dû prendre tout ça sous mon aile, car la qualification le permettait.Par conséquent, en particulier, j'ai dû développer une architecture de réseau typique de l' OGVque l'on devait s'efforcer. La normalisation et la typification sont la clé d'un fonctionnement efficace. Selon mes calculs préliminaires, il devrait y avoir au moins 100 à 150 objets d'administration par personne dans notre organisation. L'une des fournitures d'équipement Cisco.

Bien sûr, dans le réseau en construction, en plus des technologies VLAN évidentes, d'autres technologies modernes ont été utilisées pour faciliter l'administration: OSPF, VTP, PVST, MSTP, HSRP, QoS, etc. Bien sûr, je voulais augmenter la redondance d'état, mais, malheureusement, ASR ne disposait pas de suffisamment de ressources matérielles. Malheureusement, cela n'a pas fonctionné pour arriver à MPLS. Oui, et ce n'était pas nécessaire. À mesure que le réseau se développait, j'ai commencé à prendre le contrôle de l'équipement OGV , en l'ajustant simultanément comme il se doit. Dans le processus de connexion des administrations de la région, j'ai dû mener des actions de sensibilisation et d'éducation et aider mes collègues des administrations de district et rurales.La liaison montante totale entre les sites à la première étape n'était que de quelques gigabits. Mais j'ai déjà alloué un canal pour que vSphere fonctionne.Le réseau lui-même s'est avéré être géographiquement très distribué, y compris un assez grand nombre de nœuds distants connectés via VPN L2 / L3.Beaucoup, bien sûr, pourrait être résolu par de sérieux investissements financiers, mais j'ai réussi avec ce que j'ai. Souvent, l'équipement disponible était utilisé de manière inefficace, alors j'ai juste trouvé de meilleurs endroits pour cela. Surtout au cours de la première année de vie, tout le monde était très sceptique quant aux perspectives de mise en œuvre de ce projet.Mais après la première année, lorsque, grâce à notre organisation, des économies budgétaires directes et indirectes de dizaines de millions de roubles ont été démontrées, et l'attitude a radicalement changé. L'un des schémas de réseau. La plupart des nœuds pour des raisons évidentes sont cachés.

, en l'ajustant simultanément comme il se doit. Dans le processus de connexion des administrations de la région, j'ai dû mener des actions de sensibilisation et d'éducation et aider mes collègues des administrations de district et rurales.La liaison montante totale entre les sites à la première étape n'était que de quelques gigabits. Mais j'ai déjà alloué un canal pour que vSphere fonctionne.Le réseau lui-même s'est avéré être géographiquement très distribué, y compris un assez grand nombre de nœuds distants connectés via VPN L2 / L3.Beaucoup, bien sûr, pourrait être résolu par de sérieux investissements financiers, mais j'ai réussi avec ce que j'ai. Souvent, l'équipement disponible était utilisé de manière inefficace, alors j'ai juste trouvé de meilleurs endroits pour cela. Surtout au cours de la première année de vie, tout le monde était très sceptique quant aux perspectives de mise en œuvre de ce projet.Mais après la première année, lorsque, grâce à notre organisation, des économies budgétaires directes et indirectes de dizaines de millions de roubles ont été démontrées, et l'attitude a radicalement changé. L'un des schémas de réseau. La plupart des nœuds pour des raisons évidentes sont cachés.

Deuxième étape

Lors de la deuxième étape, nous devions déjà augmenter les capacités matérielles de notre centre de données. L'extension des capacités a nécessité un changement de châssis du modèle E vers H, une réinstallation des baies existantes. L'espace disque a été augmenté en augmentant le nombre d'étagères du disque dur. Les étagères avec les disques durs IBM DS3512 et l'étagère DS3524 sont visibles en haut.

Plusieurs autres serveurs physiques ont déménagé pour nous. Le nombre de machines virtuelles a considérablement augmenté. Un outil de sauvegarde basé sur la bibliothèque de bandes IBM TS3200 a été ajouté. Au premier plan se trouve la bandothèque IBM TS3200.

Naturellement, j'ai commencé l'installation de nouveaux équipements avec une planification préalable. Ici, il fallait déjà modéliser des racks des deux côtés. Planification de l'expansion du centre de données.

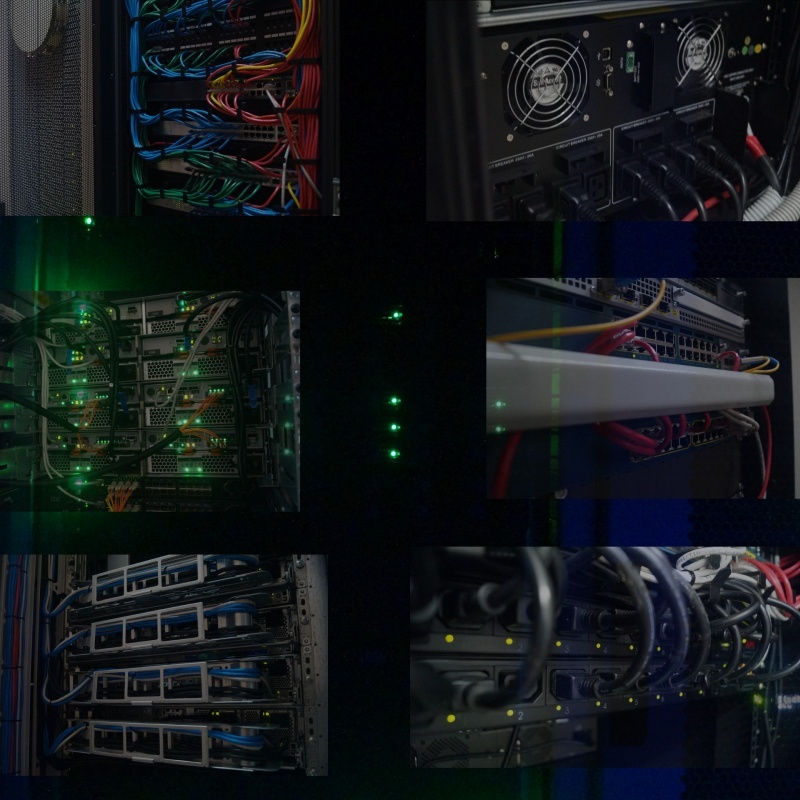

Le déménagement a été achevé dès que possible. Étant donné qu'à ce moment-là, la virtualisation fonctionnait pleinement, le processus de déplacement était complètement invisible, car avant le transfert et la déconnexion des équipements sur un site, tous les serveurs virtuels migraient vers un autre, et à la fin du travail, tout revenait à la normale.Bien entendu, outre le site principal, une commande a également été mise en place sur le site de la réserve. Dans le même temps, grâce à un système de sauvegarde pleinement opérationnel, il a finalement été possible d'y restaurer l'ordre. Type de racks après expansion de la ressource, 2014.

Le déménagement a été achevé dès que possible. Étant donné qu'à ce moment-là, la virtualisation fonctionnait pleinement, le processus de déplacement était complètement invisible, car avant le transfert et la déconnexion des équipements sur un site, tous les serveurs virtuels migraient vers un autre, et à la fin du travail, tout revenait à la normale.Bien entendu, outre le site principal, une commande a également été mise en place sur le site de la réserve. Dans le même temps, grâce à un système de sauvegarde pleinement opérationnel, il a finalement été possible d'y restaurer l'ordre. Type de racks après expansion de la ressource, 2014. Et comme à ce moment-là notre centre de données était déjà devenu exemplaire, j'ai décidé de prêter attention aux détails: les unités libres disponibles étaient couvertes de lunettes noires, et là où la ventilation était nécessaire, des lunettes perforées étaient installées. Même les boulons de montage qui fixent l'équipement dans le rack, j'ai retiré et peint en noir de la bombe aérosol. Un peu, mais sympa. Type de racks sur le site de réserve lors de l'installation (à gauche) et à la fin (à droite).

Afin de se débarrasser des convertisseurs de médias qui se trouvent partout, une paire de châssis D-Link DMC-1000 a été achetée, y compris fournir des convertisseurs de support d'alimentation de secours grâce à la paire d'alimentations.

Et comme à ce moment-là notre centre de données était déjà devenu exemplaire, j'ai décidé de prêter attention aux détails: les unités libres disponibles étaient couvertes de lunettes noires, et là où la ventilation était nécessaire, des lunettes perforées étaient installées. Même les boulons de montage qui fixent l'équipement dans le rack, j'ai retiré et peint en noir de la bombe aérosol. Un peu, mais sympa. Type de racks sur le site de réserve lors de l'installation (à gauche) et à la fin (à droite).

Afin de se débarrasser des convertisseurs de médias qui se trouvent partout, une paire de châssis D-Link DMC-1000 a été achetée, y compris fournir des convertisseurs de support d'alimentation de secours grâce à la paire d'alimentations. Dans le même temps, des travaux sont en cours pour moderniser le réseau. J'ai fermé l'anneau du cœur du réseau de transmission de données à une vitesse de 20 Gbit / s entre les sites. En optimisant les équipements existants, le réseau de service pour le fonctionnement de l'infrastructure virtuelle a acquis une liaison montante de 10 Gb / s, ce qui a permis de migrer la quasi-totalité des lames en même temps, avec suffisamment de bande passante.La compatibilité des équipements SNR avec les équipements Cisco et Brocade existants s'est avérée très agréable. Bien sûr, à un moment donné, la présence d'équipement Brocade dans le châssis a été une surprise désagréable pour moi, car je n'avais pas eu à travailler avec lui auparavant. Mais heureusement, la connaissance des principes du réseau nous a permis d'y faire face rapidement.Une partie importante du travail, je considère l'exactitude de l'exécution. Tout devrait non seulement bien fonctionner, mais aussi être beau. Plus l'ordre est important, plus la fiabilité est élevée. J'ai eu la chance qu'aucun de moi n'ait une telle approche du travail. C'est pourquoi, avec l'un de nos collègues dans les racks, j'ai été placé, je pense, dans un ordre type. Il doit y avoir de l'ordre partout.

Dans le même temps, des travaux sont en cours pour moderniser le réseau. J'ai fermé l'anneau du cœur du réseau de transmission de données à une vitesse de 20 Gbit / s entre les sites. En optimisant les équipements existants, le réseau de service pour le fonctionnement de l'infrastructure virtuelle a acquis une liaison montante de 10 Gb / s, ce qui a permis de migrer la quasi-totalité des lames en même temps, avec suffisamment de bande passante.La compatibilité des équipements SNR avec les équipements Cisco et Brocade existants s'est avérée très agréable. Bien sûr, à un moment donné, la présence d'équipement Brocade dans le châssis a été une surprise désagréable pour moi, car je n'avais pas eu à travailler avec lui auparavant. Mais heureusement, la connaissance des principes du réseau nous a permis d'y faire face rapidement.Une partie importante du travail, je considère l'exactitude de l'exécution. Tout devrait non seulement bien fonctionner, mais aussi être beau. Plus l'ordre est important, plus la fiabilité est élevée. J'ai eu la chance qu'aucun de moi n'ait une telle approche du travail. C'est pourquoi, avec l'un de nos collègues dans les racks, j'ai été placé, je pense, dans un ordre type. Il doit y avoir de l'ordre partout.

Pendant ce temps

Parallèlement à la création physique du centre de données et du réseau OGV , il y a eu un développement de logiciels pour le fonctionnement du gouvernement électronique, auquel j'ai également eu l'occasion de participer. Tant en termes de mise en œuvre et de déploiement qu'en termes de soutien idéologique. Pour le soutien d'une véritable idéologie, merci beaucoup à la direction d'alors.J'ai dû régulièrement auditer des bases de données, inciter les développeurs à utiliser des index dans les bases de données, intercepter des requêtes gourmandes en ressources et optimiser les goulots d'étranglement. L'un des systèmes, à l'exception des clés primaires, n'avait plus d'index. Le résultat - au début d'un fonctionnement intensif, les performances de la base de données ont commencé à se dégrader fortement, ont dû planter des index par elles-mêmes.Grâce à une intervention opportune dans le processus de développement, tous les systèmes d'État développés ont été rendus multi-plateformes. Et là où il n'était pas urgent d'utiliser Windows comme base, tout fonctionnait sous le contrôle de la famille de systèmes Linux. Il s'est avéré que le principal obstacle à la création d'applications multiplateformes était l'utilisation de la notation non universelle dans les chemins d'écriture. Souvent, après avoir remplacé une barre oblique par une autre, le système d'État est devenu brusquement multiplateforme.Le réseau créé couvrait d'une manière ou d'une autre la quasi-totalité de l' OGV , j'étais prêt à commencer à fournir une connectivité à Internet, filtrer le trafic, une protection antivirus et empêcher les attaques de l'extérieur et de l' OGV. En particulier, cela était censé permettre des économies budgétaires importantes grâce à une utilisation plus efficace de la bande passante des canaux.Ayant créé un service de support technique unifié pour l' OGV , j'avais prévu de créer des emplois de haute technologie, de concentrer au sein de notre organisation les principales forces pour un accompagnement qualifié, laissant des techniciens sur le terrain, tout en améliorant le niveau de spécialistes du terrain en organisant des conférences et des webinaires, des retraites ...La troisième étape de la modernisation du datacenter devait être la plus intéressante pour moi. À la fin de la deuxième étape, un dialogue a été établi avec Elbrus, le développeur de processeurs nationaux, l'accès au banc de test a été obtenu, et il est devenu clair qu'au moins un tiers des fonctionnalités des systèmes d'exploitation peuvent être transférées sur la plate-forme matérielle nationale! Juste dans la prochaine, 2015, une nouvelle version matérielle du processeur domestique devait être publiée ... Le budget pour l'année suivante comprenait la somme pour l'achat de serveurs ...

Pour résumer

Mais mes rêves de transférer des services publics vers une plate-forme matérielle nationale n'étaient pas destinés à se réaliser (comme d'autres plans), car j'ai été contraint de changer de travail pour un travail non moins intéressant, mais mieux rémunéré. C'est dommage, bien sûr, je pense que je pourrais donner une bonne impulsion à la mise en œuvre de la plate-forme matérielle nationale. De plus, c'était avant la vague de substitution des importations.Au moment de la fin de ma carrière dans cette organisation sur la base de notre data center, j'ai réussi à planifier, créer, déployer ou participer à la création de:Au total, plus de 120 serveurs virtuels travaillaient alors sur nos 7 paires de serveurs physiques, utilisant environ 30 à 40% des ressources CPU et RAM, environ 50% du système de stockage. Au total, à cette époque, notre personnel était d'environ 30 à 35 personnes, y compris l'ensemble du personnel administratif et de gestion, service de traitement des appels.Efficacité d'utilisation, j'en suis sûr, sur le visage.En fait, vous pouvez encore en dire beaucoup sur la formation de presque chacun des services, puis vous obtenez un volume de souvenirs assez important.Remerciements

- Tout d'abord, à vous, cher lecteur, d'avoir lu ici.

- Ma femme pour aide et soutien.

- À la direction de l'institution publique d'État SK "Centre régional des technologies de l'information" pour la confiance placée.

- Gestion du ministère de l'industrie, de l'énergie et des communications du territoire de Stavropol pour le soutien administratif.

- Tous les collègues qui ont eu la chance de travailler à l'époque.

Source: https://habr.com/ru/post/fr395197/

All Articles