L'IA génère des sons réalistes dans les images

Des employés du Massachusetts Institute of Computer Science and Artificial Intelligence Laboratory (CSAIL) et Google Research ont conçu un réseau de neurones qui a appris à produire des séquences vidéo arbitraires , à générer des sons réalistes et à prédire les propriétés des objets. Le programme analyse la vidéo, reconnaît les objets, leur mouvement et le type de contact - choc, glissement, frottement, etc. Sur la base de ces informations, il génère un son qu'une personne dans 40% des cas considère comme plus réaliste que le vrai.Les scientifiques suggèrent que ce développement sera largement utilisé au cinéma et à la télévision pour générer des effets sonores à partir d'une séquence vidéo sans son. De plus, il peut être utile pour entraîner des robots de mieux comprendre les propriétés du monde.Les sons ambiants en disent long sur les propriétés des objets environnants, donc dans le processus d'auto-apprentissage, les futurs robots peuvent agir comme des enfants - toucher des objets, les essayer au toucher, enfoncer un bâton en eux, essayer de bouger, de soulever. Dans ce cas, le robot reçoit une rétroaction, reconnaissant les propriétés de l'objet - son poids, son élasticité, etc.Le son émis par un objet en contact contient également des informations importantes sur les propriétés de l'objet. «Lorsque vous faites glisser votre doigt sur un verre de vin, le son que vous faites correspond à la quantité de liquide versée dans le verre», explique Andrew Owens , étudiant diplômé , auteur principal d'un article scientifique publié, qui n'est pas encore prêt pour une revue scientifique, mais seulement publié.accessible au public sur arXiv.org. La présentation des travaux scientifiques aura lieu à la conférence annuelle sur la vision industrielle et la reconnaissance des formes (CVPR) à Las Vegas ce mois-ci.Les scientifiques ont sélectionné 977 vidéos dans lesquelles les gens effectuent des actions avec des objets environnants, constitués de divers matériaux: gratter, les battre avec un bâton, etc. Au total, les vidéos contenaient 46 577 actions. Les élèves du CSAIL ont marqué manuellement toutes les actions, en indiquant le type de matériau, le lieu de contact, le type d'action (choc / grattage / autre) et le type de réaction du matériau ou de l'objet (déformation, forme statique, mouvement dur, etc.). Des vidéos avec du son ont été utilisées pour former le réseau neuronal, et des étiquettes placées manuellement ont été utilisées uniquement pour analyser le résultat de la formation du réseau neuronal, mais pas pour le former..

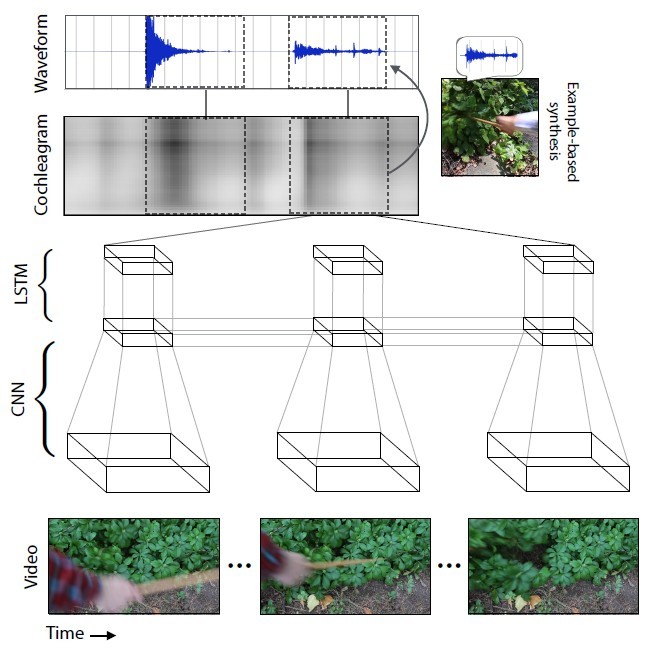

Des employés du Massachusetts Institute of Computer Science and Artificial Intelligence Laboratory (CSAIL) et Google Research ont conçu un réseau de neurones qui a appris à produire des séquences vidéo arbitraires , à générer des sons réalistes et à prédire les propriétés des objets. Le programme analyse la vidéo, reconnaît les objets, leur mouvement et le type de contact - choc, glissement, frottement, etc. Sur la base de ces informations, il génère un son qu'une personne dans 40% des cas considère comme plus réaliste que le vrai.Les scientifiques suggèrent que ce développement sera largement utilisé au cinéma et à la télévision pour générer des effets sonores à partir d'une séquence vidéo sans son. De plus, il peut être utile pour entraîner des robots de mieux comprendre les propriétés du monde.Les sons ambiants en disent long sur les propriétés des objets environnants, donc dans le processus d'auto-apprentissage, les futurs robots peuvent agir comme des enfants - toucher des objets, les essayer au toucher, enfoncer un bâton en eux, essayer de bouger, de soulever. Dans ce cas, le robot reçoit une rétroaction, reconnaissant les propriétés de l'objet - son poids, son élasticité, etc.Le son émis par un objet en contact contient également des informations importantes sur les propriétés de l'objet. «Lorsque vous faites glisser votre doigt sur un verre de vin, le son que vous faites correspond à la quantité de liquide versée dans le verre», explique Andrew Owens , étudiant diplômé , auteur principal d'un article scientifique publié, qui n'est pas encore prêt pour une revue scientifique, mais seulement publié.accessible au public sur arXiv.org. La présentation des travaux scientifiques aura lieu à la conférence annuelle sur la vision industrielle et la reconnaissance des formes (CVPR) à Las Vegas ce mois-ci.Les scientifiques ont sélectionné 977 vidéos dans lesquelles les gens effectuent des actions avec des objets environnants, constitués de divers matériaux: gratter, les battre avec un bâton, etc. Au total, les vidéos contenaient 46 577 actions. Les élèves du CSAIL ont marqué manuellement toutes les actions, en indiquant le type de matériau, le lieu de contact, le type d'action (choc / grattage / autre) et le type de réaction du matériau ou de l'objet (déformation, forme statique, mouvement dur, etc.). Des vidéos avec du son ont été utilisées pour former le réseau neuronal, et des étiquettes placées manuellement ont été utilisées uniquement pour analyser le résultat de la formation du réseau neuronal, mais pas pour le former.. Le réseau neuronal a analysé les caractéristiques du son qui correspondent à chaque type d'interaction avec les objets - volume, hauteur et autres caractéristiques. Au cours de la formation, le système a étudié la vidéo image par image, analysé le son dans cette image et trouvé une correspondance avec le son le plus similaire dans la base de données déjà accumulée. Le plus important était d'apprendre au réseau neuronal à étirer le son en images.

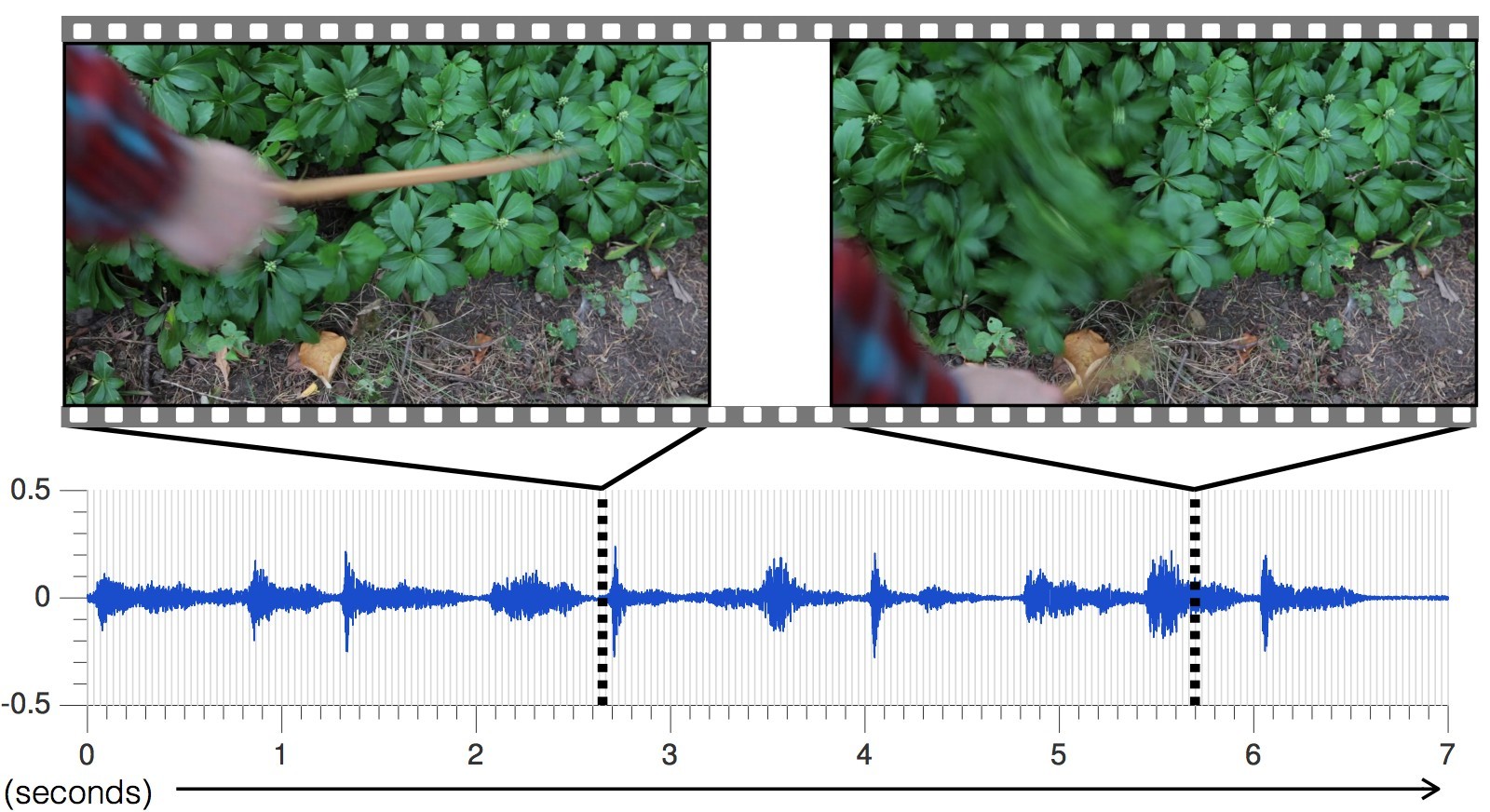

Le réseau neuronal a analysé les caractéristiques du son qui correspondent à chaque type d'interaction avec les objets - volume, hauteur et autres caractéristiques. Au cours de la formation, le système a étudié la vidéo image par image, analysé le son dans cette image et trouvé une correspondance avec le son le plus similaire dans la base de données déjà accumulée. Le plus important était d'apprendre au réseau neuronal à étirer le son en images. Avec chaque nouvelle vidéo, la précision de la prédiction des sons augmentait.Le son généré par le réseau de neurones pour différentes scènes, par rapport à la réalité

Avec chaque nouvelle vidéo, la précision de la prédiction des sons augmentait.Le son généré par le réseau de neurones pour différentes scènes, par rapport à la réalité , ce qui a permis au réseau de neurones d'apprendre à prédire avec précision les sons les plus divers avec toutes les nuances: des pierres qui frappent au lierre bruissant.«Les approches actuelles des chercheurs dans le domaine de l'intelligence artificielle se concentrent sur un seul des cinq sens: les spécialistes de la vision industrielle étudient les images visuelles, les spécialistes de la reconnaissance vocale étudient le son, etc.», explique Abhinav Gupta, professeur adjoint de robotique à l'Université Carnegie Mellon. «Cette étude est un pas dans la bonne direction qui imite le processus d'apprentissage de la même manière que les gens, c'est-à-dire en intégrant le son et la vision.»Pour tester l'efficacité de l'IA, les scientifiques ont mené une étude en ligne sur Amazon Mechanical Turk, dont les participants ont été invités à comparer deux options pour le son d'une vidéo particulière et à déterminer quel son est réel et lequel ne l'est pas.À la suite de l'expérience, l'IA a réussi à tromper les gens dans 40% des cas . Cependant, selon certains commentateurs sur les forums , il n'est pas si difficile de tromper une personne, car une partie importante des connaissances sur l'image sonore du monde est obtenue par les gens modernes à partir de longs métrages et de jeux informatiques. La gamme sonore pour les films et les jeux est composée de spécialistes utilisant des collections d'échantillons standard. Autrement dit, nous entendons constamment la même chose.Dans une expérience en ligne, dans deux cas sur cinq, les gens pensaient que le son généré par le programme était plus réaliste que le son réel de la vidéo. C'est un meilleur résultat que d'autres méthodes pour synthétiser des sons réalistes.

, ce qui a permis au réseau de neurones d'apprendre à prédire avec précision les sons les plus divers avec toutes les nuances: des pierres qui frappent au lierre bruissant.«Les approches actuelles des chercheurs dans le domaine de l'intelligence artificielle se concentrent sur un seul des cinq sens: les spécialistes de la vision industrielle étudient les images visuelles, les spécialistes de la reconnaissance vocale étudient le son, etc.», explique Abhinav Gupta, professeur adjoint de robotique à l'Université Carnegie Mellon. «Cette étude est un pas dans la bonne direction qui imite le processus d'apprentissage de la même manière que les gens, c'est-à-dire en intégrant le son et la vision.»Pour tester l'efficacité de l'IA, les scientifiques ont mené une étude en ligne sur Amazon Mechanical Turk, dont les participants ont été invités à comparer deux options pour le son d'une vidéo particulière et à déterminer quel son est réel et lequel ne l'est pas.À la suite de l'expérience, l'IA a réussi à tromper les gens dans 40% des cas . Cependant, selon certains commentateurs sur les forums , il n'est pas si difficile de tromper une personne, car une partie importante des connaissances sur l'image sonore du monde est obtenue par les gens modernes à partir de longs métrages et de jeux informatiques. La gamme sonore pour les films et les jeux est composée de spécialistes utilisant des collections d'échantillons standard. Autrement dit, nous entendons constamment la même chose.Dans une expérience en ligne, dans deux cas sur cinq, les gens pensaient que le son généré par le programme était plus réaliste que le son réel de la vidéo. C'est un meilleur résultat que d'autres méthodes pour synthétiser des sons réalistes. Le plus souvent, l'IA a trompé les participants à l'expérience avec les sons de matériaux tels que les feuilles et la saleté, car ces sons sont plus complexes et pas aussi «propres» que ceux produits, par exemple, par le bois ou le métal.Revenant à la formation du réseau neuronal, en tant que sous-produit de l'étude, il a été constaté que l'algorithme peut distinguer les matériaux mous des matériaux durs avec une précision de 67%, prédisant simplement leur son. En d'autres termes, le robot peut regarder le chemin d'asphalte et l'herbe devant lui - et conclure que l'asphalte est dur et l'herbe est douce. Le robot le saura par le son prédit, sans même marcher sur l'asphalte et l'herbe. Ensuite, il peut aller où il veut - et tester ses sentiments en vérifiant avec la base de données et, si nécessaire, en apportant des corrections dans la bibliothèque d'échantillons sonores. De cette façon, à l'avenir, les robots étudieront et maîtriseront le monde qui les entoure.Cependant, les chercheurs ont encore beaucoup de travail à faire pour améliorer la technologie. Le réseau neuronal est maintenant souvent confondu avec le mouvement rapide des objets, sans tomber dans le moment exact du contact. De plus, l'IA ne peut générer que du son basé sur le contact direct, qui est enregistré sur vidéo, et il y a tellement de sons autour de nous qui ne sont pas basés sur le contact visuel: le bruit des arbres, le bourdonnement d'un ventilateur dans un ordinateur. «Ce qui serait vraiment cool, c'est de simuler en quelque sorte un son qui n'est pas si étroitement lié à la séquence», explique Andrew Owens.

Le plus souvent, l'IA a trompé les participants à l'expérience avec les sons de matériaux tels que les feuilles et la saleté, car ces sons sont plus complexes et pas aussi «propres» que ceux produits, par exemple, par le bois ou le métal.Revenant à la formation du réseau neuronal, en tant que sous-produit de l'étude, il a été constaté que l'algorithme peut distinguer les matériaux mous des matériaux durs avec une précision de 67%, prédisant simplement leur son. En d'autres termes, le robot peut regarder le chemin d'asphalte et l'herbe devant lui - et conclure que l'asphalte est dur et l'herbe est douce. Le robot le saura par le son prédit, sans même marcher sur l'asphalte et l'herbe. Ensuite, il peut aller où il veut - et tester ses sentiments en vérifiant avec la base de données et, si nécessaire, en apportant des corrections dans la bibliothèque d'échantillons sonores. De cette façon, à l'avenir, les robots étudieront et maîtriseront le monde qui les entoure.Cependant, les chercheurs ont encore beaucoup de travail à faire pour améliorer la technologie. Le réseau neuronal est maintenant souvent confondu avec le mouvement rapide des objets, sans tomber dans le moment exact du contact. De plus, l'IA ne peut générer que du son basé sur le contact direct, qui est enregistré sur vidéo, et il y a tellement de sons autour de nous qui ne sont pas basés sur le contact visuel: le bruit des arbres, le bourdonnement d'un ventilateur dans un ordinateur. «Ce qui serait vraiment cool, c'est de simuler en quelque sorte un son qui n'est pas si étroitement lié à la séquence», explique Andrew Owens.Source: https://habr.com/ru/post/fr395243/

All Articles