NVIDIA recherche des moyens d'optimiser les images BP

La société prévoit d'augmenter le confort de BP et de réduire la charge sur la puissance de calcul en simulant la vision périphérique

L'œil humain est complexe. En tant qu'omnivores, nous avons un angle de vision assez large, mais nous ne voyons toujours clairement que ce sur quoi nos yeux sont focalisés. Le reste de la zone nous permet de distinguer les objets, mais nous les voyons flous, flous. C'est ce que nous appelons la vision périphérique.Au départ, les fabricants de casques VR recherchaient la clarté de l'image sur les écrans, le taux de rafraîchissement du cadre et la qualité globale de l'image. Maintenant que les produits HTC, Oculus et Sony entrent sur un vaste marché, il est temps de penser à l'optimisation, car tout le monde ne peut pas se permettre un ordinateur de bureau d'une valeur de 1 500 à 2 500 $ pour essayer un nouveau produit. Et cela sans le coût du casque lui-même.La principale charge financière est constituée par les cartes vidéo qui rendent les images en deux flux sur les écrans des casques VR. Et NVidia, en tant qu'acteur principal du marché et fournisseur, a pensé à optimiser et à améliorer le confort du processus d'immersion dans le monde VR.Maintenant, l'image entière dans les casques VR est dessinée avec le même degré de qualité. En regardant n'importe quelle partie de l'écran, l'utilisateur verra la même image de qualité. Mais en réalité, l'œil humain ne voit clairement que dans une zone de focalisation étroite, et tout le reste tombe sur la vision périphérique, l'image à partir de laquelle notre cerveau traite et s'adoucit.NVidia a conclu que simuler le comportement de l'œil réel lors du rendu d'images sur les écrans des casques BP serait une bonne solution, car, d'une part, cela réduira la charge sur la puissance de calcul du PC auquel le casque est connecté, et d'autre part, augmentera le réalisme comportement de l'image et, par conséquent, augmenter le confort du gameplay.Mais comme nos yeux sont mobiles, il est impossible de faire un "flou" clair de la mise au point au milieu de l'écran. Pour simuler le comportement de la vision réelle, les ingénieurs de NVIDIA ont eu recours à un système de suivi oculaire pour déterminer clairement où l'utilisateur regarde. En conséquence, ils ont réussi à développer un système qui simule le comportement de la vision humaine de manière très réaliste et en même temps économise les ressources informatiques du système:

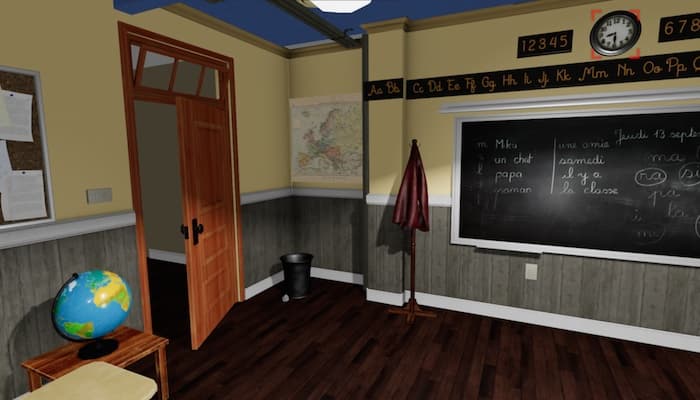

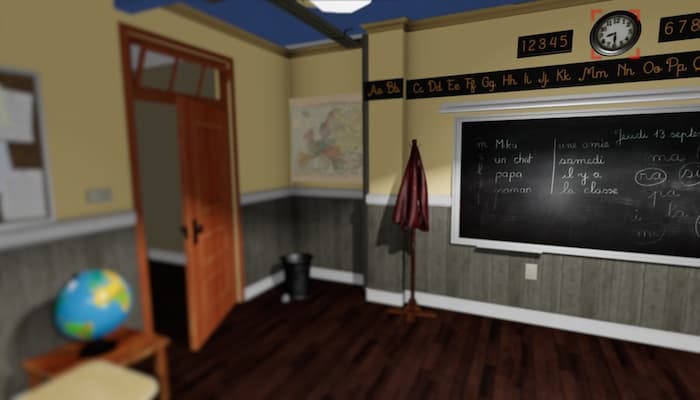

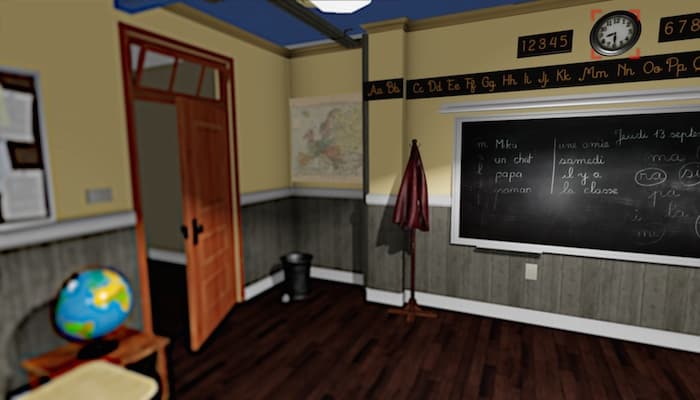

L'œil humain est complexe. En tant qu'omnivores, nous avons un angle de vision assez large, mais nous ne voyons toujours clairement que ce sur quoi nos yeux sont focalisés. Le reste de la zone nous permet de distinguer les objets, mais nous les voyons flous, flous. C'est ce que nous appelons la vision périphérique.Au départ, les fabricants de casques VR recherchaient la clarté de l'image sur les écrans, le taux de rafraîchissement du cadre et la qualité globale de l'image. Maintenant que les produits HTC, Oculus et Sony entrent sur un vaste marché, il est temps de penser à l'optimisation, car tout le monde ne peut pas se permettre un ordinateur de bureau d'une valeur de 1 500 à 2 500 $ pour essayer un nouveau produit. Et cela sans le coût du casque lui-même.La principale charge financière est constituée par les cartes vidéo qui rendent les images en deux flux sur les écrans des casques VR. Et NVidia, en tant qu'acteur principal du marché et fournisseur, a pensé à optimiser et à améliorer le confort du processus d'immersion dans le monde VR.Maintenant, l'image entière dans les casques VR est dessinée avec le même degré de qualité. En regardant n'importe quelle partie de l'écran, l'utilisateur verra la même image de qualité. Mais en réalité, l'œil humain ne voit clairement que dans une zone de focalisation étroite, et tout le reste tombe sur la vision périphérique, l'image à partir de laquelle notre cerveau traite et s'adoucit.NVidia a conclu que simuler le comportement de l'œil réel lors du rendu d'images sur les écrans des casques BP serait une bonne solution, car, d'une part, cela réduira la charge sur la puissance de calcul du PC auquel le casque est connecté, et d'autre part, augmentera le réalisme comportement de l'image et, par conséquent, augmenter le confort du gameplay.Mais comme nos yeux sont mobiles, il est impossible de faire un "flou" clair de la mise au point au milieu de l'écran. Pour simuler le comportement de la vision réelle, les ingénieurs de NVIDIA ont eu recours à un système de suivi oculaire pour déterminer clairement où l'utilisateur regarde. En conséquence, ils ont réussi à développer un système qui simule le comportement de la vision humaine de manière très réaliste et en même temps économise les ressources informatiques du système: image complètement rendue pour BP, mise au point sur l'horloge

image complètement rendue pour BP, mise au point sur l'horloge Juste la périphérie «floue» de l'image pour BP, mise au point sur l'horloge

Juste la périphérie «floue» de l'image pour BP, mise au point sur l'horloge «La périphérie floue» de l'image pour BP avec maintien du niveau de contraste nécessaire, imitation de la vision réelle, concentration sur l'horlogeMême maintenant, rien qu'en regardant l'image, vous pouvez reconnaître que les ingénieurs NVIDIA sont sur la bonne voie. En se concentrant sur la montre même sur l'écran du moniteur, la différence entre la première et la troisième image, à première vue, est pratiquement absente. Le développement est basé sur la technologie SMI existante (SensoMotoric Instruments), qui a été introduite pour Oculus Rift DK2 en novembre 2014.Si vous pensez que les ingénieurs de NVIDIA «font mousser» tout ce qui n'est pas au point, vous vous trompez. Au cours du travail, il a été constaté que lors du rendu traditionnel de l'image dans le domaine de la vision périphérique, des creux et des scintillements se forment, provoquant une sensation d'inconfort. Juste le "flou" de l'image réduit le contraste, ce qui provoque une sensation de "tunneling" de la vision.C'est pourquoi les ingénieurs ont créé un algorithme complet qui évalue la forme, la couleur et le contraste, ainsi que le mouvement de l'objet. Grâce à cela, le «plus bleu» pour l'utilisateur passe confortablement et presque imperceptiblement, sans effets secondaires.Démonstration vidéo des étapes des images "floues" pour BP de NVIDIA

«La périphérie floue» de l'image pour BP avec maintien du niveau de contraste nécessaire, imitation de la vision réelle, concentration sur l'horlogeMême maintenant, rien qu'en regardant l'image, vous pouvez reconnaître que les ingénieurs NVIDIA sont sur la bonne voie. En se concentrant sur la montre même sur l'écran du moniteur, la différence entre la première et la troisième image, à première vue, est pratiquement absente. Le développement est basé sur la technologie SMI existante (SensoMotoric Instruments), qui a été introduite pour Oculus Rift DK2 en novembre 2014.Si vous pensez que les ingénieurs de NVIDIA «font mousser» tout ce qui n'est pas au point, vous vous trompez. Au cours du travail, il a été constaté que lors du rendu traditionnel de l'image dans le domaine de la vision périphérique, des creux et des scintillements se forment, provoquant une sensation d'inconfort. Juste le "flou" de l'image réduit le contraste, ce qui provoque une sensation de "tunneling" de la vision.C'est pourquoi les ingénieurs ont créé un algorithme complet qui évalue la forme, la couleur et le contraste, ainsi que le mouvement de l'objet. Grâce à cela, le «plus bleu» pour l'utilisateur passe confortablement et presque imperceptiblement, sans effets secondaires.Démonstration vidéo des étapes des images "floues" pour BP de NVIDIASource: https://habr.com/ru/post/fr396385/

All Articles