L'intelligence artificielle a des problèmes de langage

Des machines sensibles au langage seraient très utiles. Mais nous ne savons pas comment les construire.

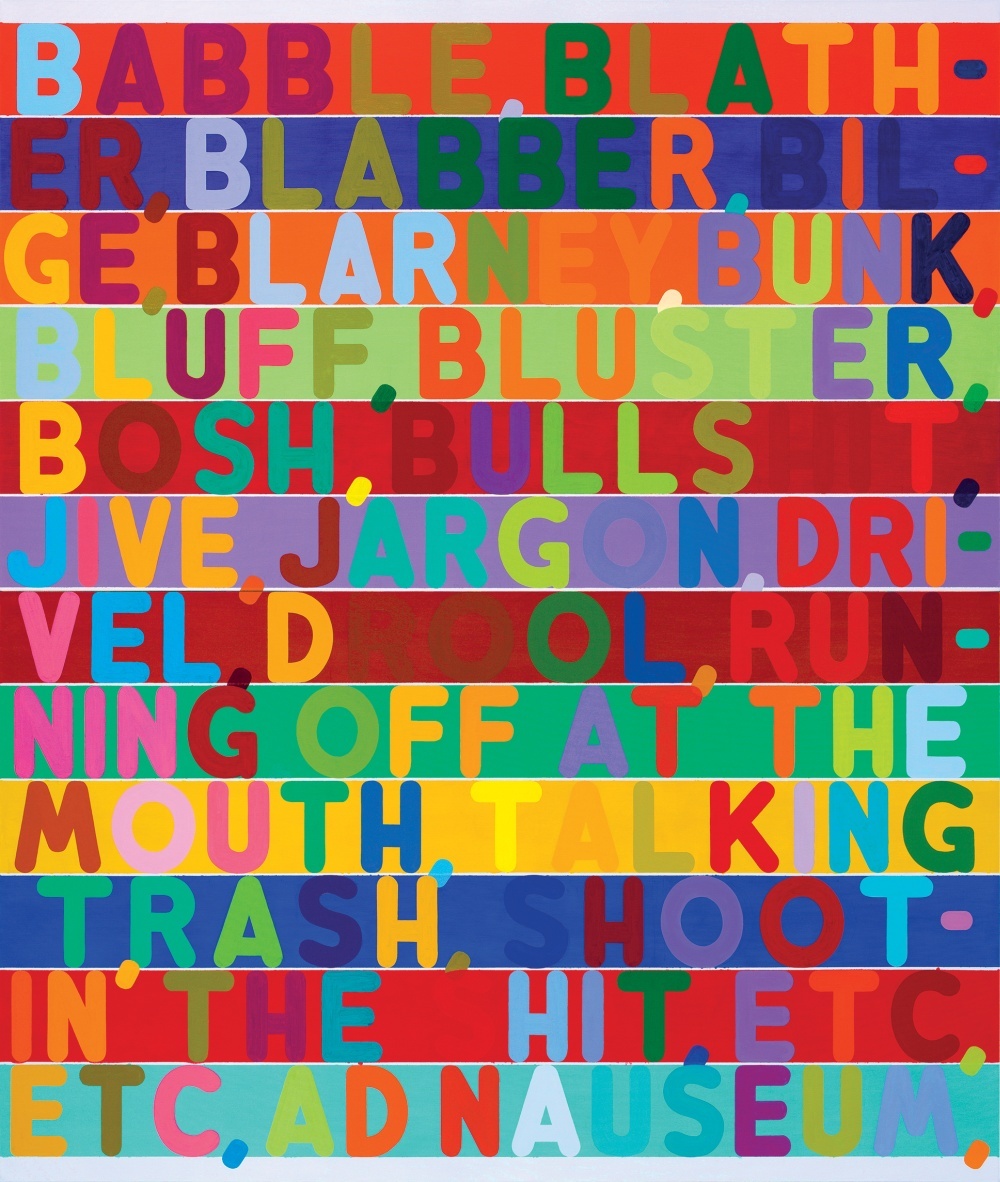

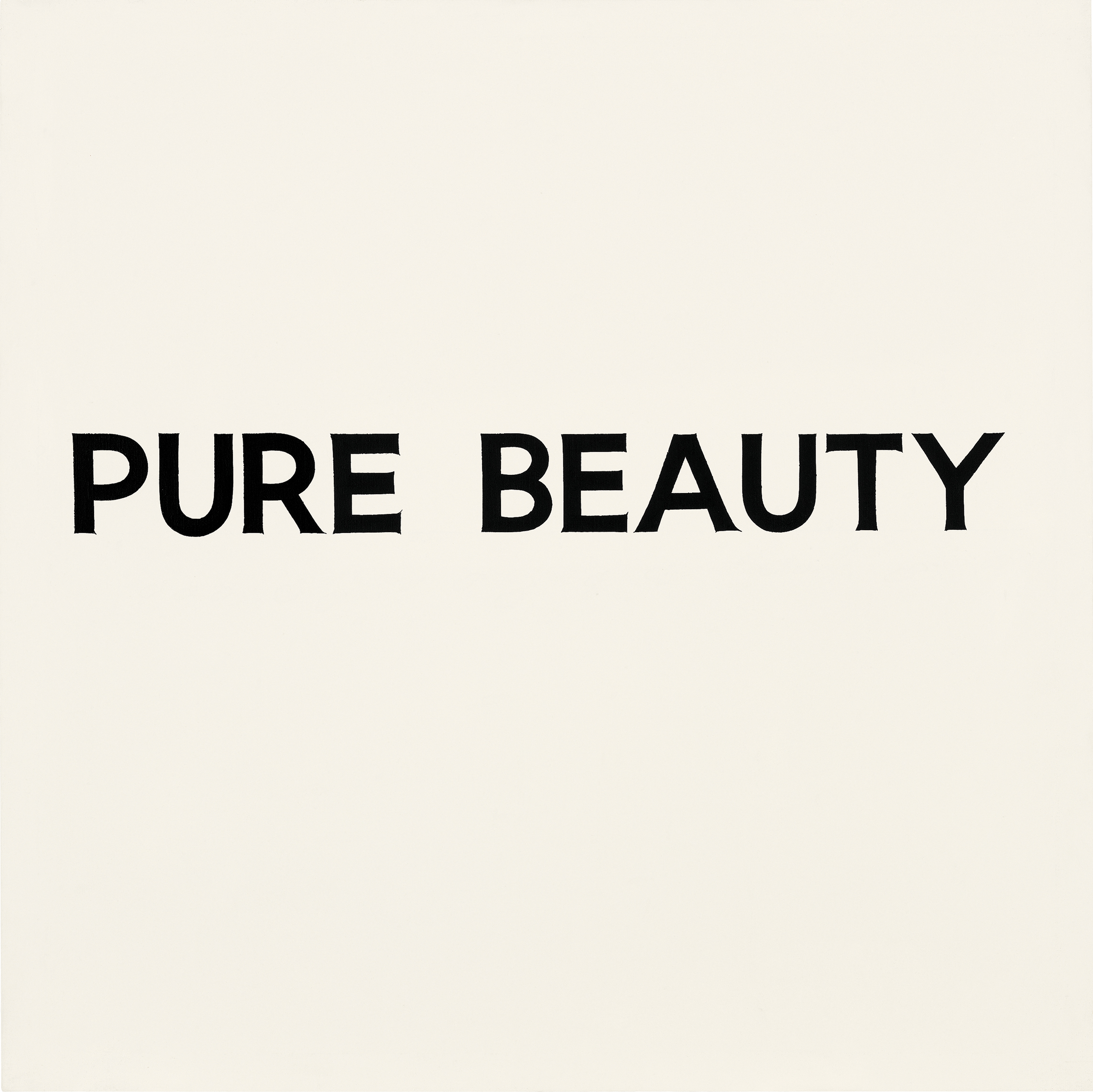

À propos des illustrations de l'article: l'une des difficultés à comprendre une langue par ordinateur est le fait que souvent le sens des mots dépend du contexte et même de l'apparence des lettres et des mots. Dans les images présentées dans l'article, plusieurs artistes démontrent l'utilisation de divers indices visuels qui véhiculent une charge sémantique qui dépasse les frontières des lettres elles-mêmes.Au milieu d'un jeu de go tendu, qui se déroulait à Séoul en Corée du Sud entre Lee Sedol, l'un des meilleurs joueurs de tous les temps, et AlphaGo, une IA créée par Google, le programme a fait un geste mystérieux qui a démontré sa supériorité maladroite sur un rival humain.Au coup 37, AlphaGo a décidé de mettre la pierre noire dans une position étrange à première vue. Tout s'est passé au point qu'elle a dû perdre un morceau de territoire important - une erreur de débutant dans un jeu basé sur le contrôle de l'espace sur le plateau. Deux commentateurs de télévision discutaient pour savoir s'ils comprenaient correctement le cours de l'ordinateur et s'il s'était cassé. Il s'est avéré que, malgré la contradiction du bon sens, le 37e coup a permis à AlphaGo de construire une structure insurmontable au centre de la planche. Le programme de Google a essentiellement remporté le match avec une décision à laquelle personne n'aurait pensé.Victoire d'AlphaGoégalement impressionnant car l'ancien jeu de go était souvent considéré comme un test d'intelligence intuitive. Ses règles sont simples. Deux joueurs à tour de rôle posent des pierres noires ou blanches à l'intersection des lignes horizontales et verticales du plateau, essayant d'entourer les pierres de l'adversaire et de les retirer du plateau. Mais bien jouer est incroyablement difficile.Si les joueurs d'échecs sont capables de calculer le jeu plusieurs étapes à venir, cela devient rapidement une tâche incroyablement difficile, en plus, il n'y a pas de gambits classiques dans le jeu. Il n'y a pas non plus de moyen facile de mesurer les avantages, et même pour un joueur expérimenté, il peut être difficile d'expliquer pourquoi il a fait un tel mouvement. Pour cette raison, il est impossible d'écrire un simple ensemble de règles qui serait suivi par un programme jouant au niveau expert.AlphaGo n'a pas appris à jouer au go. Le programme a analysé des centaines de milliers de jeux et joué des millions de matchs avec lui-même. Parmi les différentes techniques d'IA, elle a utilisé la méthode de plus en plus populaire connue sous le nom d'apprentissage en profondeur. Il est basé sur des calculs mathématiques, dont la méthode est inspirée par la façon dont les couches interconnectées de neurones dans le cerveau sont activées lors du traitement de nouvelles informations. Le programme s'est enseigné pendant de nombreuses heures de pratique, perfectionnant progressivement un sens intuitif de la stratégie. Et le fait qu'elle ait ensuite réussi à battre l'un des meilleurs joueurs de go au monde est une nouvelle étape dans l'intelligence artificielle et l'IA.

À propos des illustrations de l'article: l'une des difficultés à comprendre une langue par ordinateur est le fait que souvent le sens des mots dépend du contexte et même de l'apparence des lettres et des mots. Dans les images présentées dans l'article, plusieurs artistes démontrent l'utilisation de divers indices visuels qui véhiculent une charge sémantique qui dépasse les frontières des lettres elles-mêmes.Au milieu d'un jeu de go tendu, qui se déroulait à Séoul en Corée du Sud entre Lee Sedol, l'un des meilleurs joueurs de tous les temps, et AlphaGo, une IA créée par Google, le programme a fait un geste mystérieux qui a démontré sa supériorité maladroite sur un rival humain.Au coup 37, AlphaGo a décidé de mettre la pierre noire dans une position étrange à première vue. Tout s'est passé au point qu'elle a dû perdre un morceau de territoire important - une erreur de débutant dans un jeu basé sur le contrôle de l'espace sur le plateau. Deux commentateurs de télévision discutaient pour savoir s'ils comprenaient correctement le cours de l'ordinateur et s'il s'était cassé. Il s'est avéré que, malgré la contradiction du bon sens, le 37e coup a permis à AlphaGo de construire une structure insurmontable au centre de la planche. Le programme de Google a essentiellement remporté le match avec une décision à laquelle personne n'aurait pensé.Victoire d'AlphaGoégalement impressionnant car l'ancien jeu de go était souvent considéré comme un test d'intelligence intuitive. Ses règles sont simples. Deux joueurs à tour de rôle posent des pierres noires ou blanches à l'intersection des lignes horizontales et verticales du plateau, essayant d'entourer les pierres de l'adversaire et de les retirer du plateau. Mais bien jouer est incroyablement difficile.Si les joueurs d'échecs sont capables de calculer le jeu plusieurs étapes à venir, cela devient rapidement une tâche incroyablement difficile, en plus, il n'y a pas de gambits classiques dans le jeu. Il n'y a pas non plus de moyen facile de mesurer les avantages, et même pour un joueur expérimenté, il peut être difficile d'expliquer pourquoi il a fait un tel mouvement. Pour cette raison, il est impossible d'écrire un simple ensemble de règles qui serait suivi par un programme jouant au niveau expert.AlphaGo n'a pas appris à jouer au go. Le programme a analysé des centaines de milliers de jeux et joué des millions de matchs avec lui-même. Parmi les différentes techniques d'IA, elle a utilisé la méthode de plus en plus populaire connue sous le nom d'apprentissage en profondeur. Il est basé sur des calculs mathématiques, dont la méthode est inspirée par la façon dont les couches interconnectées de neurones dans le cerveau sont activées lors du traitement de nouvelles informations. Le programme s'est enseigné pendant de nombreuses heures de pratique, perfectionnant progressivement un sens intuitif de la stratégie. Et le fait qu'elle ait ensuite réussi à battre l'un des meilleurs joueurs de go au monde est une nouvelle étape dans l'intelligence artificielle et l'IA. Quelques heures après le 37e coup, AlphaGo a gagné le match et a commencé à mener 2-0 dans un match de cinq matchs. Après cela, Sedol s'est tenu devant une foule de journalistes et de photographes et s'est excusé poliment d'avoir laissé l'humanité tomber. "Je suis resté sans voix", a-t-il dit, clignant des yeux sous les éclats de flash.L'incroyable succès d'AlphaGo montre les progrès accomplis en matière d'IA au cours des dernières années, après des décennies de désespoir et de défis décrits comme «l'hiver de l'IA». Le deep learning permet aux machines d'apprendre par elles-mêmes comment effectuer des tâches complexes, dont la solution il y a quelques années ne pouvait être imaginée sans la participation de l'intelligence humaine. La robotique se profile déjà à l'horizon. Dans un avenir proche, les systèmes d'apprentissage en profondeur aideront à diagnostiquer les maladies et à fournir des recommandations de traitement.Mais malgré ces avancées impressionnantes, l'une des principales possibilités n'est nullement donnée par l'IA: le langage. Des systèmes comme Siri et IBM Watson peuvent reconnaître de simples commandes verbales et écrites et répondre à des questions simples, mais ils ne sont pas en mesure de maintenir une conversation ou de comprendre réellement les mots utilisés. Pour que l'IA change notre monde, cela doit changer.Bien qu'AlphaGo ne parle pas, il possède une technologie qui peut fournir une meilleure compréhension de la langue. Chez Google, Facebook, Amazon et les laboratoires scientifiques, les chercheurs tentent de résoudre ce problème tenace en utilisant les mêmes outils d'IA - y compris le deep learning - qui sont responsables du succès d'AlphaGo et de la résurgence de l'IA. Leur succès déterminera la portée et les propriétés de ce qui commence déjà à se transformer en une révolution de l'IA. Cela déterminera notre avenir - aurons-nous des machines avec lesquelles il sera facile de communiquer, ou les systèmes avec l'IA resteront de mystérieuses boîtes noires, bien que plus autonomes. "Il n'y a aucun moyen de créer un système humanoïde avec l'IA à moins qu'il ne soit basé sur le langage", a déclaré Josh Tenenbaum, professeur de sciences cognitives et d'informatique au MIT. «C'est l'une des choses les plus évidentes qui définissent l'intelligence humaine.»Peut-être que les mêmes technologies qui ont permis à AlphaGo de conquérir vont permettre aux ordinateurs de maîtriser la langue, sinon il faudra autre chose. Mais sans comprendre la langue, l'impact de l'IA sera différent. Bien sûr, nous aurons toujours des programmes incroyablement puissants et intelligents comme AlphaGo. Mais notre relation avec l'IA ne sera pas si proche et probablement pas aussi amicale. "La plus grande question depuis le début de la recherche était" Et si vous aviez des appareils intelligents en termes d'efficacité, mais pas comme nous en termes de manque d'empathie pour qui nous sommes? ", Déclare Terry Winograd, Honoré professeur à l'Université de Stanford. «Vous pouvez imaginer des machines qui ne sont pas basées sur l'intelligence humaine, qui fonctionnent avec les mégadonnées et contrôlent le monde.»

Quelques heures après le 37e coup, AlphaGo a gagné le match et a commencé à mener 2-0 dans un match de cinq matchs. Après cela, Sedol s'est tenu devant une foule de journalistes et de photographes et s'est excusé poliment d'avoir laissé l'humanité tomber. "Je suis resté sans voix", a-t-il dit, clignant des yeux sous les éclats de flash.L'incroyable succès d'AlphaGo montre les progrès accomplis en matière d'IA au cours des dernières années, après des décennies de désespoir et de défis décrits comme «l'hiver de l'IA». Le deep learning permet aux machines d'apprendre par elles-mêmes comment effectuer des tâches complexes, dont la solution il y a quelques années ne pouvait être imaginée sans la participation de l'intelligence humaine. La robotique se profile déjà à l'horizon. Dans un avenir proche, les systèmes d'apprentissage en profondeur aideront à diagnostiquer les maladies et à fournir des recommandations de traitement.Mais malgré ces avancées impressionnantes, l'une des principales possibilités n'est nullement donnée par l'IA: le langage. Des systèmes comme Siri et IBM Watson peuvent reconnaître de simples commandes verbales et écrites et répondre à des questions simples, mais ils ne sont pas en mesure de maintenir une conversation ou de comprendre réellement les mots utilisés. Pour que l'IA change notre monde, cela doit changer.Bien qu'AlphaGo ne parle pas, il possède une technologie qui peut fournir une meilleure compréhension de la langue. Chez Google, Facebook, Amazon et les laboratoires scientifiques, les chercheurs tentent de résoudre ce problème tenace en utilisant les mêmes outils d'IA - y compris le deep learning - qui sont responsables du succès d'AlphaGo et de la résurgence de l'IA. Leur succès déterminera la portée et les propriétés de ce qui commence déjà à se transformer en une révolution de l'IA. Cela déterminera notre avenir - aurons-nous des machines avec lesquelles il sera facile de communiquer, ou les systèmes avec l'IA resteront de mystérieuses boîtes noires, bien que plus autonomes. "Il n'y a aucun moyen de créer un système humanoïde avec l'IA à moins qu'il ne soit basé sur le langage", a déclaré Josh Tenenbaum, professeur de sciences cognitives et d'informatique au MIT. «C'est l'une des choses les plus évidentes qui définissent l'intelligence humaine.»Peut-être que les mêmes technologies qui ont permis à AlphaGo de conquérir vont permettre aux ordinateurs de maîtriser la langue, sinon il faudra autre chose. Mais sans comprendre la langue, l'impact de l'IA sera différent. Bien sûr, nous aurons toujours des programmes incroyablement puissants et intelligents comme AlphaGo. Mais notre relation avec l'IA ne sera pas si proche et probablement pas aussi amicale. "La plus grande question depuis le début de la recherche était" Et si vous aviez des appareils intelligents en termes d'efficacité, mais pas comme nous en termes de manque d'empathie pour qui nous sommes? ", Déclare Terry Winograd, Honoré professeur à l'Université de Stanford. «Vous pouvez imaginer des machines qui ne sont pas basées sur l'intelligence humaine, qui fonctionnent avec les mégadonnées et contrôlent le monde.»Parler aux voitures

Quelques mois après le triomphe d'AlphaGo, je suis allé dans la Silicon Valley, le cœur du boom de l'IA. Je voulais rencontrer des chercheurs qui ont fait des progrès significatifs dans les applications pratiques de l'IA et qui essaient de donner aux machines une compréhension du langage.J'ai commencé avec Vinohrad, qui vit dans une banlieue à l'extrémité sud du campus de Stanford à Palo Alto, non loin du siège de Google, Facebook et Apple. Ses cheveux gris bouclés et sa moustache épaisse lui donnent l'apparence d'un scientifique respectable, et il infecte avec son enthousiasme.En 1968, Grapes a fait l'une des premières tentatives pour apprendre aux machines à parler. En tant que prodige mathématique passionné de langue, il est venu au nouveau laboratoire d'IA du MIT pour obtenir son diplôme. Il a décidé de créer un programme qui communique avec les gens grâce à la saisie de texte dans la langue de tous les jours. A cette époque, cela ne semblait pas un objectif aussi audacieux. De très grandes étapes ont été franchies dans le développement de l'IA, et d'autres équipes du MIT ont construit des systèmes sophistiqués de vision par ordinateur et des manipulateurs robotiques. «Il y avait un sentiment de possibilités inconnues et illimitées», se souvient-il. Mais tout le monde ne croyait pas que la langue était si facile à conquérir. Certains critiques, dont le linguiste influent et professeur du MIT Noam Chomsky, ont pensé qu'il serait très difficile pour les chercheurs en IA d'enseigner aux machines à comprendre, car la mécanique du langage chez l'homme était très mal comprise. Grapes se souvient d'une fête à laquelle un étudiant Chomsky s'est éloigné de lui après avoir entendu qu'il travaillait dans un laboratoire d'IA.Mais il y a des raisons d'être optimiste. Joseph Weizenbaum, professeur au MIT d'origine allemande, a créé le premier programme de chatbot il y a quelques années. Son nom était ELIZA et elle était programmée pour répondre comme une psychologue de dessins animés, répétant des parties clés de déclarations ou posant des questions inspirantes pour continuer la conversation. Si vous lui avez dit que vous étiez en colère contre votre mère, le programme pourrait dire: «Qu'est-ce qui vous vient à l'esprit lorsque vous pensez à votre mère?». Un truc bon marché qui a étonnamment bien fonctionné. Weisenbaum a été choqué lorsque certains sujets ont commencé à vérifier leurs sombres secrets avec sa voiture.Les raisins voulaient faire quelque chose qui pourrait prétendre de façon convaincante qu'il comprenait la langue. Il a commencé par réduire l'ampleur du problème. Il a créé un environnement virtuel simple, le «monde des blocs», composé d'un ensemble d'objets fictifs sur une table fictive. Il a ensuite créé un programme, le nommant SHRDLU, qui peut analyser tous les noms, verbes et règles de grammaire simples nécessaires pour communiquer dans ce monde virtuel simplifié. SHRDLU (un mot sans signification composé d'une ligne de lettres du clavier du linotype) pourrait décrire des objets, répondre à des questions sur leurs relations et changer le monde des blocs en réponse aux commandes d'entrée. Elle avait même un certain souvenir et si vous lui demandiez de déplacer le «cône rouge», puis écriviez sur un certain cône, elle supposait que vous pensiez à ce cône rouge, et pas à aucun autre.

Mais tout le monde ne croyait pas que la langue était si facile à conquérir. Certains critiques, dont le linguiste influent et professeur du MIT Noam Chomsky, ont pensé qu'il serait très difficile pour les chercheurs en IA d'enseigner aux machines à comprendre, car la mécanique du langage chez l'homme était très mal comprise. Grapes se souvient d'une fête à laquelle un étudiant Chomsky s'est éloigné de lui après avoir entendu qu'il travaillait dans un laboratoire d'IA.Mais il y a des raisons d'être optimiste. Joseph Weizenbaum, professeur au MIT d'origine allemande, a créé le premier programme de chatbot il y a quelques années. Son nom était ELIZA et elle était programmée pour répondre comme une psychologue de dessins animés, répétant des parties clés de déclarations ou posant des questions inspirantes pour continuer la conversation. Si vous lui avez dit que vous étiez en colère contre votre mère, le programme pourrait dire: «Qu'est-ce qui vous vient à l'esprit lorsque vous pensez à votre mère?». Un truc bon marché qui a étonnamment bien fonctionné. Weisenbaum a été choqué lorsque certains sujets ont commencé à vérifier leurs sombres secrets avec sa voiture.Les raisins voulaient faire quelque chose qui pourrait prétendre de façon convaincante qu'il comprenait la langue. Il a commencé par réduire l'ampleur du problème. Il a créé un environnement virtuel simple, le «monde des blocs», composé d'un ensemble d'objets fictifs sur une table fictive. Il a ensuite créé un programme, le nommant SHRDLU, qui peut analyser tous les noms, verbes et règles de grammaire simples nécessaires pour communiquer dans ce monde virtuel simplifié. SHRDLU (un mot sans signification composé d'une ligne de lettres du clavier du linotype) pourrait décrire des objets, répondre à des questions sur leurs relations et changer le monde des blocs en réponse aux commandes d'entrée. Elle avait même un certain souvenir et si vous lui demandiez de déplacer le «cône rouge», puis écriviez sur un certain cône, elle supposait que vous pensiez à ce cône rouge, et pas à aucun autre. SHRDLU est devenu la bannière de progrès considérables en IA. Mais ce n'était qu'une illusion. Lorsque Vinograd a tenté d'élargir le monde des blocs du programme, les règles nécessaires pour tenir compte des mots supplémentaires et des difficultés de grammaire sont devenues incontrôlables. Quelques années plus tard, il s'est rendu et a quitté le domaine de l'IA, se concentrant sur d'autres études. «Les restrictions étaient beaucoup plus fortes qu'elles ne le semblaient alors», dit-il.Grapes a décidé qu'avec les outils disponibles à l'époque, il était impossible d'apprendre à la machine à vraiment comprendre la langue. Le problème, selon Hubert Dreyfus, professeur de philosophie à l'Université de Californie à Berkeley, tel qu'il l'a exprimé en 1972, What Computers Can't Do, est que de nombreuses actions humaines nécessitent une compréhension instinctive. qui ne peut pas être défini par un ensemble de règles simples. C'est pourquoi, avant le début du match entre Sedol et AlphaGo, de nombreux experts doutaient que les machines soient capables de maîtriser le jeu de go.

SHRDLU est devenu la bannière de progrès considérables en IA. Mais ce n'était qu'une illusion. Lorsque Vinograd a tenté d'élargir le monde des blocs du programme, les règles nécessaires pour tenir compte des mots supplémentaires et des difficultés de grammaire sont devenues incontrôlables. Quelques années plus tard, il s'est rendu et a quitté le domaine de l'IA, se concentrant sur d'autres études. «Les restrictions étaient beaucoup plus fortes qu'elles ne le semblaient alors», dit-il.Grapes a décidé qu'avec les outils disponibles à l'époque, il était impossible d'apprendre à la machine à vraiment comprendre la langue. Le problème, selon Hubert Dreyfus, professeur de philosophie à l'Université de Californie à Berkeley, tel qu'il l'a exprimé en 1972, What Computers Can't Do, est que de nombreuses actions humaines nécessitent une compréhension instinctive. qui ne peut pas être défini par un ensemble de règles simples. C'est pourquoi, avant le début du match entre Sedol et AlphaGo, de nombreux experts doutaient que les machines soient capables de maîtriser le jeu de go. Mais pendant que Dreyfus prouvait son point de vue, plusieurs chercheurs développaient une approche qui, en fin de compte, donnerait aux machines le type d'intelligence dont elles avaient besoin. Inspirés par les neurosciences, ils ont expérimenté des réseaux de neurones artificiels - des couches de simulations mathématiques de neurones qui peuvent être entraînées à s'activer en réponse à certaines données d'entrée. Au début, ces systèmes fonctionnaient de manière incroyablement lente et l'approche a été rejetée comme impraticable pour la logique et le raisonnement. Cependant, une caractéristique clé des réseaux de neurones était la capacité d'apprendre ce qui n'était pas programmé manuellement, et plus tard, il s'est avéré utile pour des tâches simples telles que la reconnaissance de l'écriture manuscrite. Cette compétence a trouvé une utilisation commerciale dans les années 1990 pour lire les chiffres des chèques. Les partisans de la méthode étaient convaincus qu'avec le temps, les réseaux de neurones permettraient aux machines d'en faire beaucoup plus.Ils ont affirmé qu'un jour cette technologie aiderait et reconnaîtrait la langue.Au cours des dernières années, les réseaux de neurones sont devenus plus complexes et plus puissants. L'approche a prospéré grâce à des améliorations mathématiques clés et, plus important encore, à un matériel informatique plus rapide et à l'arrivée de quantités massives de données. En 2009, des chercheurs de l'Université de Toronto ont montré que les réseaux multicouches d'apprentissage en profondeur peuvent reconnaître la parole avec une précision record. Et en 2012, le même groupe a remporté le concours de vision industrielle en utilisant un algorithme d'apprentissage en profondeur qui a montré une précision incroyable.Un réseau neuronal d'apprentissage en profondeur reconnaît les objets dans les images avec une astuce simple. La couche de neurones simulés reçoit une entrée sous forme d'image et certains des neurones sont activés en réponse à l'intensité de pixels individuels. Le signal résultant passe à travers de nombreuses couches de neurones interconnectés avant d'atteindre la couche de sortie, qui signale l'observation d'un objet. Une technique mathématique appelée «rétropropagation» est utilisée pour ajuster la sensibilité des neurones du réseau afin de créer la bonne réponse. C'est cette étape qui donne au système l'occasion d'apprendre. Différentes couches du réseau répondent à des propriétés telles que les bords, les couleurs ou la texture. De tels systèmes sont aujourd'hui capables de reconnaître des objets, des animaux ou des visages avec une précision qui rivalise avec l'homme.Il y a un problème évident avec l'application de la technologie d'apprentissage en profondeur à la langue. Les mots sont des caractères arbitraires, et c'est ainsi qu'ils diffèrent essentiellement des images. Deux mots peuvent avoir une signification similaire et contenir des lettres complètement différentes. Et le même mot peut signifier différentes choses selon le contexte.Dans les années 1980, les chercheurs ont eu l'idée délicate de transformer une langue en un type de problème qu'un réseau neuronal peut gérer. Ils ont montré que les mots peuvent être représentés comme des vecteurs mathématiques, ce qui nous permet de calculer la similitude des mots apparentés. Par exemple, «bateau» et «eau» sont proches dans l'espace vectoriel, bien qu'ils semblent différents. Des chercheurs de l'Université de Montréal dirigés par Yoshua Bengio et une autre équipe de Google ont utilisé cette idée pour construire des réseaux dans lesquels chaque mot d'une phrase est utilisé pour construire une représentation plus complexe. Geoffrey Hinton, professeur à l'Université de Toronto et éminent chercheur en apprentissage en profondeur qui travaille également pour Google, appelle cela un «vecteur mental».En utilisant deux de ces réseaux, vous pouvez traduire d'une langue à une autre avec une excellente précision. Et en combinant ces types de réseaux avec celui qui reconnaît les objets dans les images, vous pouvez obtenir des sous-titres étonnamment précis.

Mais pendant que Dreyfus prouvait son point de vue, plusieurs chercheurs développaient une approche qui, en fin de compte, donnerait aux machines le type d'intelligence dont elles avaient besoin. Inspirés par les neurosciences, ils ont expérimenté des réseaux de neurones artificiels - des couches de simulations mathématiques de neurones qui peuvent être entraînées à s'activer en réponse à certaines données d'entrée. Au début, ces systèmes fonctionnaient de manière incroyablement lente et l'approche a été rejetée comme impraticable pour la logique et le raisonnement. Cependant, une caractéristique clé des réseaux de neurones était la capacité d'apprendre ce qui n'était pas programmé manuellement, et plus tard, il s'est avéré utile pour des tâches simples telles que la reconnaissance de l'écriture manuscrite. Cette compétence a trouvé une utilisation commerciale dans les années 1990 pour lire les chiffres des chèques. Les partisans de la méthode étaient convaincus qu'avec le temps, les réseaux de neurones permettraient aux machines d'en faire beaucoup plus.Ils ont affirmé qu'un jour cette technologie aiderait et reconnaîtrait la langue.Au cours des dernières années, les réseaux de neurones sont devenus plus complexes et plus puissants. L'approche a prospéré grâce à des améliorations mathématiques clés et, plus important encore, à un matériel informatique plus rapide et à l'arrivée de quantités massives de données. En 2009, des chercheurs de l'Université de Toronto ont montré que les réseaux multicouches d'apprentissage en profondeur peuvent reconnaître la parole avec une précision record. Et en 2012, le même groupe a remporté le concours de vision industrielle en utilisant un algorithme d'apprentissage en profondeur qui a montré une précision incroyable.Un réseau neuronal d'apprentissage en profondeur reconnaît les objets dans les images avec une astuce simple. La couche de neurones simulés reçoit une entrée sous forme d'image et certains des neurones sont activés en réponse à l'intensité de pixels individuels. Le signal résultant passe à travers de nombreuses couches de neurones interconnectés avant d'atteindre la couche de sortie, qui signale l'observation d'un objet. Une technique mathématique appelée «rétropropagation» est utilisée pour ajuster la sensibilité des neurones du réseau afin de créer la bonne réponse. C'est cette étape qui donne au système l'occasion d'apprendre. Différentes couches du réseau répondent à des propriétés telles que les bords, les couleurs ou la texture. De tels systèmes sont aujourd'hui capables de reconnaître des objets, des animaux ou des visages avec une précision qui rivalise avec l'homme.Il y a un problème évident avec l'application de la technologie d'apprentissage en profondeur à la langue. Les mots sont des caractères arbitraires, et c'est ainsi qu'ils diffèrent essentiellement des images. Deux mots peuvent avoir une signification similaire et contenir des lettres complètement différentes. Et le même mot peut signifier différentes choses selon le contexte.Dans les années 1980, les chercheurs ont eu l'idée délicate de transformer une langue en un type de problème qu'un réseau neuronal peut gérer. Ils ont montré que les mots peuvent être représentés comme des vecteurs mathématiques, ce qui nous permet de calculer la similitude des mots apparentés. Par exemple, «bateau» et «eau» sont proches dans l'espace vectoriel, bien qu'ils semblent différents. Des chercheurs de l'Université de Montréal dirigés par Yoshua Bengio et une autre équipe de Google ont utilisé cette idée pour construire des réseaux dans lesquels chaque mot d'une phrase est utilisé pour construire une représentation plus complexe. Geoffrey Hinton, professeur à l'Université de Toronto et éminent chercheur en apprentissage en profondeur qui travaille également pour Google, appelle cela un «vecteur mental».En utilisant deux de ces réseaux, vous pouvez traduire d'une langue à une autre avec une excellente précision. Et en combinant ces types de réseaux avec celui qui reconnaît les objets dans les images, vous pouvez obtenir des sous-titres étonnamment précis.Le sens de la vie

Assis dans une salle de conférence au cœur du siège animé de Google à Mountain View, en Californie, l'un des chercheurs de l'entreprise qui a développé cette approche, Quoc Le, discute de l'idée d'une machine capable de soutenir une vraie conversation. Les ambitions de Lee expliquent en quoi les machines parlantes peuvent être utiles. «J'ai besoin d'un moyen de simuler des pensées dans une voiture», dit-il. "Et si vous voulez faire semblant d’être des pensées, vous pouvez demander à la voiture ce qu’elle pense." Google enseigne déjà à ses ordinateurs les bases de la langue. En mai, la société a dévoilé le système Parsey McParseface, qui peut reconnaître la syntaxe, les noms, les verbes et d'autres éléments de texte. Il est facile de voir comment la compréhension d'une langue peut aider une entreprise. L'algorithme de recherche Google a simplement suivi les mots clés et les liens entre les pages Web. Maintenant, le système RankBrain lit le texte des pages pour comprendre sa signification et améliorer les résultats de recherche. Lee veut pousser cette idée encore plus loin. En adaptant le système, qui s'est avéré utile pour les traductions et les signatures d'images, lui et ses collègues ont créé Smart Reply, qui lit le contenu des lettres sur Gmail et propose des réponses possibles. Ils ont également créé un programme qui a appris via le chat d'assistance Google pour répondre à des questions techniques simples.Lee a récemment créé un programme qui peut générer des réponses décentes à des questions difficiles. Elle s'est formée aux dialogues de 18 900 films. Certaines réponses ont effrayé la cible. Par exemple, Lee a demandé «Quel est le but de la vie?» Et le programme a répondu «Au service d'un bien supérieur». "C'est une bonne réponse", se souvient-il avec un sourire. "Peut-être mieux que je ne me répondrais moi-même."Il n'y a qu'un seul problème qui apparaît lorsque l'on regarde plus de réponses du système. Lorsque Lee a demandé: «Combien de pattes un chat a-t-il?», Le système a répondu: «Je pense que quatre.» Puis il a demandé: «Combien de pattes a un mille-pattes?» Et il a reçu l'étrange réponse «Huit». En fait, le programme de Lee ne comprend pas de quoi il parle. Elle comprend que certaines combinaisons de symboles sont combinées ensemble, mais ne comprend pas le monde réel. Elle ne sait pas à quoi ressemble un mille-pattes ni comment il se déplace. C'est encore une illusion d'intelligence, sans bon sens, que les gens tiennent pour acquis. Les systèmes d'apprentissage profond sont plutôt fragiles dans ce sens. Un système de Google qui crée des légendes pour les images commet parfois des erreurs étranges, par exemple, il décrit un panneau routier comme un réfrigérateur avec de la nourriture.Par une étrange coïncidence, le voisin de Terry Vinohrad à Palo Alto s'est avéré être un homme qui peut aider les ordinateurs à mieux comprendre le vrai sens des mots. Fei-Fei Li, directrice du Laboratoire d'intelligence artificielle de Stanford, était en congé de maternité lors de ma visite, mais elle m'a invitée à la maison et m'a présenté fièrement son bébé de trois mois, Phoenix. "Remarquez qu'elle vous regarde plus qu'elle ne me regarde", a déclaré Lee lorsque le Phénix m'a regardé. - C'est parce que tu es nouveau; c'est une reconnaissance précoce du visage. "Pendant la majeure partie de sa carrière, Lee a étudié l'apprentissage automatique et la vision par ordinateur. Il y a plusieurs années, sous sa direction, on a tenté de créer une base de données de millions d'images d'objets, chacune étant signée avec les mots-clés correspondants. Mais Lee pense que les machines ont besoin d'une compréhension plus compliquée de ce qui se passe dans le monde, et cette année, son équipe a publié une autre base de données avec des images, dont les annotations étaient beaucoup plus riches. Pour chaque photo, les gens ont fait des dizaines de signatures: «Chien sur une planche à roulettes», «Le chien a une fourrure ondulée épaisse», «Route avec des fissures» et ainsi de suite. Ils espèrent que les systèmes d'apprentissage automatique apprendront à comprendre le monde physique. «La partie linguistique du cerveau reçoit beaucoup d'informations, y compris du système visuel», explique Lee. "Une partie importante de l'IA sera l'intégration de ces systèmes."Ce processus est plus proche d'enseigner aux enfants à connecter les mots avec les objets, les relations et les actions. Mais l'analogie avec l'enseignement aux gens ne va pas trop loin. Les enfants n'ont pas besoin de voir un chien sur une planche à roulettes pour l'imaginer ou le décrire avec des mots. Lee pense que les outils actuels pour l'IA et l'apprentissage automatique ne suffiront pas à créer une véritable IA. «Ce ne sera pas seulement un apprentissage approfondi avec un grand ensemble de données», dit-elle. «Nous, les humains, faisons très mal avec les calculs de big data, mais très bien avec les abstractions et la créativité.»Personne ne sait comment doter les machines de ces qualités humaines et si cela est possible. Existe-t-il quelque chose exclusivement humain dans de telles qualités qui ne permet pas à l'IA de les posséder?Les experts en sciences cognitives, tels que Tenenbaum du MIT, croient que les réseaux de neurones actuels manquent de composants critiques de l'esprit - quelle que soit la taille de ces réseaux. Les gens sont capables d'apprendre relativement rapidement sur des quantités de données relativement petites et ils ont la capacité intégrée de simuler efficacement un monde en trois dimensions. «Le langage est construit sur d'autres possibilités, probablement plus profondes et présentes chez les bébés avant même qu'ils ne commencent à maîtriser le langage: perception visuelle du monde, travail avec notre appareil moteur, compréhension de la physique du monde et des intentions d'autres créatures», explique Tenenbaum.S'il a raison, alors sans essayer de simuler le processus d'apprentissage humain, de créer des modèles mentaux et de la psychologie, il sera très difficile de recréer la compréhension du langage en IA.

Google enseigne déjà à ses ordinateurs les bases de la langue. En mai, la société a dévoilé le système Parsey McParseface, qui peut reconnaître la syntaxe, les noms, les verbes et d'autres éléments de texte. Il est facile de voir comment la compréhension d'une langue peut aider une entreprise. L'algorithme de recherche Google a simplement suivi les mots clés et les liens entre les pages Web. Maintenant, le système RankBrain lit le texte des pages pour comprendre sa signification et améliorer les résultats de recherche. Lee veut pousser cette idée encore plus loin. En adaptant le système, qui s'est avéré utile pour les traductions et les signatures d'images, lui et ses collègues ont créé Smart Reply, qui lit le contenu des lettres sur Gmail et propose des réponses possibles. Ils ont également créé un programme qui a appris via le chat d'assistance Google pour répondre à des questions techniques simples.Lee a récemment créé un programme qui peut générer des réponses décentes à des questions difficiles. Elle s'est formée aux dialogues de 18 900 films. Certaines réponses ont effrayé la cible. Par exemple, Lee a demandé «Quel est le but de la vie?» Et le programme a répondu «Au service d'un bien supérieur». "C'est une bonne réponse", se souvient-il avec un sourire. "Peut-être mieux que je ne me répondrais moi-même."Il n'y a qu'un seul problème qui apparaît lorsque l'on regarde plus de réponses du système. Lorsque Lee a demandé: «Combien de pattes un chat a-t-il?», Le système a répondu: «Je pense que quatre.» Puis il a demandé: «Combien de pattes a un mille-pattes?» Et il a reçu l'étrange réponse «Huit». En fait, le programme de Lee ne comprend pas de quoi il parle. Elle comprend que certaines combinaisons de symboles sont combinées ensemble, mais ne comprend pas le monde réel. Elle ne sait pas à quoi ressemble un mille-pattes ni comment il se déplace. C'est encore une illusion d'intelligence, sans bon sens, que les gens tiennent pour acquis. Les systèmes d'apprentissage profond sont plutôt fragiles dans ce sens. Un système de Google qui crée des légendes pour les images commet parfois des erreurs étranges, par exemple, il décrit un panneau routier comme un réfrigérateur avec de la nourriture.Par une étrange coïncidence, le voisin de Terry Vinohrad à Palo Alto s'est avéré être un homme qui peut aider les ordinateurs à mieux comprendre le vrai sens des mots. Fei-Fei Li, directrice du Laboratoire d'intelligence artificielle de Stanford, était en congé de maternité lors de ma visite, mais elle m'a invitée à la maison et m'a présenté fièrement son bébé de trois mois, Phoenix. "Remarquez qu'elle vous regarde plus qu'elle ne me regarde", a déclaré Lee lorsque le Phénix m'a regardé. - C'est parce que tu es nouveau; c'est une reconnaissance précoce du visage. "Pendant la majeure partie de sa carrière, Lee a étudié l'apprentissage automatique et la vision par ordinateur. Il y a plusieurs années, sous sa direction, on a tenté de créer une base de données de millions d'images d'objets, chacune étant signée avec les mots-clés correspondants. Mais Lee pense que les machines ont besoin d'une compréhension plus compliquée de ce qui se passe dans le monde, et cette année, son équipe a publié une autre base de données avec des images, dont les annotations étaient beaucoup plus riches. Pour chaque photo, les gens ont fait des dizaines de signatures: «Chien sur une planche à roulettes», «Le chien a une fourrure ondulée épaisse», «Route avec des fissures» et ainsi de suite. Ils espèrent que les systèmes d'apprentissage automatique apprendront à comprendre le monde physique. «La partie linguistique du cerveau reçoit beaucoup d'informations, y compris du système visuel», explique Lee. "Une partie importante de l'IA sera l'intégration de ces systèmes."Ce processus est plus proche d'enseigner aux enfants à connecter les mots avec les objets, les relations et les actions. Mais l'analogie avec l'enseignement aux gens ne va pas trop loin. Les enfants n'ont pas besoin de voir un chien sur une planche à roulettes pour l'imaginer ou le décrire avec des mots. Lee pense que les outils actuels pour l'IA et l'apprentissage automatique ne suffiront pas à créer une véritable IA. «Ce ne sera pas seulement un apprentissage approfondi avec un grand ensemble de données», dit-elle. «Nous, les humains, faisons très mal avec les calculs de big data, mais très bien avec les abstractions et la créativité.»Personne ne sait comment doter les machines de ces qualités humaines et si cela est possible. Existe-t-il quelque chose exclusivement humain dans de telles qualités qui ne permet pas à l'IA de les posséder?Les experts en sciences cognitives, tels que Tenenbaum du MIT, croient que les réseaux de neurones actuels manquent de composants critiques de l'esprit - quelle que soit la taille de ces réseaux. Les gens sont capables d'apprendre relativement rapidement sur des quantités de données relativement petites et ils ont la capacité intégrée de simuler efficacement un monde en trois dimensions. «Le langage est construit sur d'autres possibilités, probablement plus profondes et présentes chez les bébés avant même qu'ils ne commencent à maîtriser le langage: perception visuelle du monde, travail avec notre appareil moteur, compréhension de la physique du monde et des intentions d'autres créatures», explique Tenenbaum.S'il a raison, alors sans essayer de simuler le processus d'apprentissage humain, de créer des modèles mentaux et de la psychologie, il sera très difficile de recréer la compréhension du langage en IA.Expliquer

Le bureau de Noah Goodman au département de psychologie de Stanford est presque vide, à l'exception de quelques peintures asractiques sur l'un des murs et de plusieurs plantes envahies. Goodman a griffonné quelque chose sur son ordinateur portable au moment de mon arrivée, posant ses pieds nus sur la table. Nous nous sommes promenés sur le campus ensoleillé pour acheter du café glacé. «La particularité de la langue est qu'elle repose non seulement sur une grande quantité d'informations sur la langue, mais aussi sur la compréhension universelle du monde qui nous entoure et ces deux domaines de connaissance sont implicitement liés l'un à l'autre», explique-t-il.Goodman et ses étudiants ont développé le langage de programmation Webppl, qui peut être utilisé pour doter les ordinateurs d'un bon sens probabiliste, ce qui est très important dans les conversations. Une version expérimentale est capable de reconnaître le jeu de mots, et l'autre est l'hyperbole. Si elle dit que certaines personnes doivent passer «l'éternité» à attendre une table dans un restaurant, elle décidera automatiquement que l'utilisation du sens littéral de ce mot dans ce cas est peu probable et que les gens sont susceptibles d'attendre longtemps et de s'énerver. Le système ne peut pas encore être qualifié de véritable intelligence, mais il montre comment de nouvelles approches peuvent aider les programmes d'IA à parler un peu plus vivement.L'exemple de Goodman montre également à quel point il sera difficile d'enseigner un langage aux machines. Comprendre la signification du terme «éternité» dans un certain contexte est un exemple de ce que les systèmes d'IA devront apprendre, et c'est en fait une chose assez simple et rudimentaire.Néanmoins, malgré la complexité et la complexité de la tâche, les premiers succès des chercheurs utilisant l'apprentissage profond pour reconnaître des images ou jouer au jeu donnent l'espoir que nous sommes sur le point de faire une percée dans le domaine du langage. Dans ce cas, cette percée est arrivée juste à temps. Si l'IA doit devenir un outil universel, aider les gens à compléter et à renforcer leur propre intelligence et à effectuer des tâches dans un mode de symbiose sans problème, alors la langue est la clé pour atteindre cet état. Surtout si les systèmes d'IA utiliseront de plus en plus l'apprentissage en profondeur et d'autres technologies pour l'auto-programmation."En général, les systèmes d'apprentissage en profondeur sont stupéfaits", a déclaré John Leonard, professeur de véhicules robotisés au MIT. "D'un autre côté, leur travail est assez difficile à comprendre."Toyota, qui étudie une variété de technologies de conduite autonome, a lancé un projet de recherche au MIT dirigé par Gerald Sussman, un expert en IA et en langages de programmation, pour développer un système de conduite autonome qui peut expliquer pourquoi à un moment donné ou une autre action. La manière évidente de donner une telle explication serait verbale. «Créer des systèmes bien informés est un grand défi», explique Leonard, qui dirige un autre projet Toyota au MIT. "Mais, oui, idéalement, ils devraient donner non seulement une réponse, mais une explication."Quelques semaines après mon retour de Californie, j'ai rencontré David Silver, un chercheur de Google DeepMind et développeur d'AlphaGo. Il a parlé du match contre Sedol lors d'une conférence scientifique à New York. Silver a expliqué que lorsque le programme du deuxième match a pris une décision décisive, son équipe n'a pas été moins surprise que les autres. Ils ne pouvaient voir qu'AlphaGo prédisait les chances de gagner, et cette prédiction n'a pas beaucoup changé après le 37e coup. Quelques jours plus tard, après avoir soigneusement analysé le jeu, l'équipe a fait une découverte: en digérant les jeux précédents, le programme a calculé qu'un joueur humain pouvait faire un tel mouvement avec une probabilité de 1 sur 10 000. Et ses jeux d'entraînement ont montré qu'une telle manœuvre fournit un avantage positionnel inhabituellement fort .Donc, dans un sens, la voiture savait que cette décision toucherait le point faible de Sedol.Silver a déclaré que Google envisage plusieurs façons de commercialiser cette technologie, notamment des assistants intelligents et des outils de soins de santé. Après la conférence, je lui ai demandé l'importance de pouvoir communiquer avec l'IA contrôlant de tels systèmes. "Une question intéressante", a-t-il dit après une pause. - Pour certaines applications, cela peut être utile. Par exemple, dans les soins de santé, il peut être important de savoir pourquoi une décision particulière a été prise. »En fait, l'IA devient de plus en plus complexe et déroutante et il est très difficile d'imaginer comment nous travaillerons avec eux sans langage - sans la possibilité de leur demander «Pourquoi?». De plus, la capacité de communiquer facilement avec les ordinateurs les rendrait plus utiles et ressemblerait à de la magie. Après tout, la langue est la meilleure de nos façons de comprendre le monde et d'interagir avec lui. Il est temps que les voitures nous rattrapent.Source: https://habr.com/ru/post/fr396977/

All Articles