Merci pour la mémoire: comment la mémoire bon marché change l'informatique

La première DRAM Micron, d'une capacité de 1 MbitRAM (mémoire à accès aléatoire, une mémoire à accès aléatoire) est présente dans tout système informatique, des petits contrôleurs intégrés aux serveurs industriels. Les données sont stockées dans SRAM (RAM statique) ou DRAM (RAM dynamique) pendant que le processeur travaille avec elles. Avec la baisse des prix de la RAM, le modèle de déplacement des données entre la RAM et un emplacement de stockage permanent peut disparaître.La RAM est fortement influencée par les fluctuations du marché, mais à long terme sa valeur diminue. En 2000, un gigaoctet de mémoire coûtait plus de 1 000 $, et maintenant il ne coûte que 5 $. Cela nous permet d'imaginer une architecture système complètement différente.Les bases de données sont généralement stockées sur des disques, d'où les informations nécessaires sont lues en mémoire, si nécessaire, puis traitées. On pense généralement que la quantité de mémoire dans un système est de plusieurs ordres de grandeur inférieure au volume des disques - par exemple, gigaoctets contre téraoctets. Mais avec l'augmentation de la mémoire, il devient plus efficace de charger plus de données dans la mémoire, ce qui réduit le nombre de lectures et d'écritures. Avec une diminution du coût de la RAM, il devient possible de charger l'intégralité de la base de données en mémoire, d'effectuer des opérations dessus et de les réécrire. Nous sommes maintenant arrivés au point où certaines bases de données ne sont pas écrites sur le disque et se bloquent constamment en mémoire.

La première DRAM Micron, d'une capacité de 1 MbitRAM (mémoire à accès aléatoire, une mémoire à accès aléatoire) est présente dans tout système informatique, des petits contrôleurs intégrés aux serveurs industriels. Les données sont stockées dans SRAM (RAM statique) ou DRAM (RAM dynamique) pendant que le processeur travaille avec elles. Avec la baisse des prix de la RAM, le modèle de déplacement des données entre la RAM et un emplacement de stockage permanent peut disparaître.La RAM est fortement influencée par les fluctuations du marché, mais à long terme sa valeur diminue. En 2000, un gigaoctet de mémoire coûtait plus de 1 000 $, et maintenant il ne coûte que 5 $. Cela nous permet d'imaginer une architecture système complètement différente.Les bases de données sont généralement stockées sur des disques, d'où les informations nécessaires sont lues en mémoire, si nécessaire, puis traitées. On pense généralement que la quantité de mémoire dans un système est de plusieurs ordres de grandeur inférieure au volume des disques - par exemple, gigaoctets contre téraoctets. Mais avec l'augmentation de la mémoire, il devient plus efficace de charger plus de données dans la mémoire, ce qui réduit le nombre de lectures et d'écritures. Avec une diminution du coût de la RAM, il devient possible de charger l'intégralité de la base de données en mémoire, d'effectuer des opérations dessus et de les réécrire. Nous sommes maintenant arrivés au point où certaines bases de données ne sont pas écrites sur le disque et se bloquent constamment en mémoire. Puce mégabit de Carl Zeiss

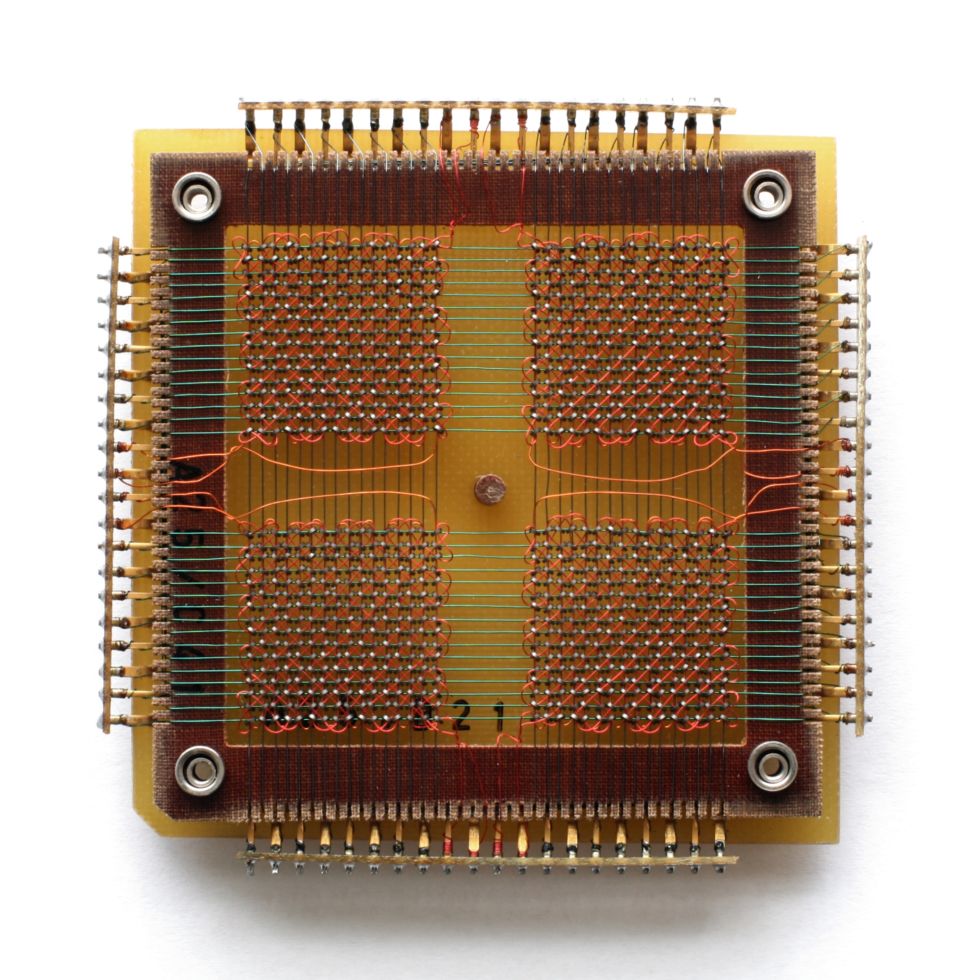

Puce mégabit de Carl Zeiss Jusqu'en 1975, la RAM était une

Jusqu'en 1975, la RAM était une puce EPROM de 4 mégaoctets de mémoire à noyau magnétique effacée à l'aide d'un rayonnement ultraviolet envoyé à travers une fenêtre.Un

puce EPROM de 4 mégaoctets de mémoire à noyau magnétique effacée à l'aide d'un rayonnement ultraviolet envoyé à travers une fenêtre.Un tas devitesses d'accès à la mémoire DRAM modernes sont mesurées en nanosecondes, et les temps d'accès au disque sont mesurés en millisecondes - c.-à-d. , la mémoire est un million de fois plus rapide. La vitesse de transfert de données en mémoire, bien sûr, n'est pas un million de fois plus rapide - ce sont des gigaoctets par seconde contre plusieurs centaines de mégaoctets par seconde pour un disque dur rapide - mais au moins la vitesse de la RAM dépasse la vitesse du lecteur d'un ordre de grandeur.Dans le monde réel, les différences ne sont pas si graves, mais lire les données d'un disque dans la RAM et les réécrire est un sérieux goulot d'étranglement, ainsi qu'un champ pour que des erreurs apparaissent. La disparition de cette étape entraîne une simplification des instructions, une augmentation de la simplicité et de l'efficacité.Avec la baisse des prix de la RAM dans les grandes entreprises et les centres de données, il est devenu courant de fournir aux serveurs des téraoctets de mémoire. Mais à part la taille, la base de données en mémoire ne veut généralement pas être conservée pour des raisons de fiabilité. La RAM perd du contenu lorsqu'une panne de courant ou un système est compromis. Ces problèmes sont rencontrés en essayant de se conformer à la norme de fiabilité de la base de données ACID (atomicité, cohérence, isolation, durabilité - atomicité, cohérence, isolation, durabilité).Les problèmes peuvent être évités avec les transtypages et les journaux. Tout comme vous pouvez effectuer des sauvegardes de base de données à partir de disques, les bases de données en mémoire peuvent être copiées dans le stockage. La création de transtypages empêche d'autres processus de lire des données, de sorte que la fréquence des points d'arrêt est un compromis entre la vitesse et la fiabilité. Et cela, à son tour, peut être lissé en enregistrant les transactions, ou en enregistrant, en enregistrant les modifications des données afin qu'un état ultérieur puisse être recréé à partir d'une copie antérieure. Mais quand même, lorsque la base de données est complètement en mémoire, un certain pourcentage de redondance est perdu.Les programmes de gestion des bases de données en mémoire (IMDBS) vous permettent de créer des systèmes hybrides dans lesquels certaines tables de base de données sont en mémoire et d'autres vivent sur disque. C'est mieux que la mise en cache et c'est pratique dans les cas où il est inutile de garder la base de données entière en mémoire.Les bases de données peuvent être compressées, en particulier sur les systèmes avec des colonnes qui stockent les tables sous forme d'ensembles de colonnes plutôt que de lignes. La plupart des technologies de compression préfèrent que les données voisines soient du même type et les colonnes des tableaux contiennent presque toujours des données du même type. Et bien que la compression implique d'augmenter la charge de calcul, le stockage des colonnes est bien adapté aux requêtes complexes dans de très grands ensembles de données - c'est pourquoi les utilisateurs et les scientifiques du Big Data s'y intéressent .À grande échelle, des entreprises telles que Google sont passées à la RAM afin qu'un grand nombre de requêtes de recherche soient traitées à une vitesse acceptable. Il existe également des problèmes d'accès à de grandes quantités de mémoire, car la quantité de RAM connectée à une carte mère est limitée et l'organisation de l'accès partagé entraîne des retards supplémentaires.

tas devitesses d'accès à la mémoire DRAM modernes sont mesurées en nanosecondes, et les temps d'accès au disque sont mesurés en millisecondes - c.-à-d. , la mémoire est un million de fois plus rapide. La vitesse de transfert de données en mémoire, bien sûr, n'est pas un million de fois plus rapide - ce sont des gigaoctets par seconde contre plusieurs centaines de mégaoctets par seconde pour un disque dur rapide - mais au moins la vitesse de la RAM dépasse la vitesse du lecteur d'un ordre de grandeur.Dans le monde réel, les différences ne sont pas si graves, mais lire les données d'un disque dans la RAM et les réécrire est un sérieux goulot d'étranglement, ainsi qu'un champ pour que des erreurs apparaissent. La disparition de cette étape entraîne une simplification des instructions, une augmentation de la simplicité et de l'efficacité.Avec la baisse des prix de la RAM dans les grandes entreprises et les centres de données, il est devenu courant de fournir aux serveurs des téraoctets de mémoire. Mais à part la taille, la base de données en mémoire ne veut généralement pas être conservée pour des raisons de fiabilité. La RAM perd du contenu lorsqu'une panne de courant ou un système est compromis. Ces problèmes sont rencontrés en essayant de se conformer à la norme de fiabilité de la base de données ACID (atomicité, cohérence, isolation, durabilité - atomicité, cohérence, isolation, durabilité).Les problèmes peuvent être évités avec les transtypages et les journaux. Tout comme vous pouvez effectuer des sauvegardes de base de données à partir de disques, les bases de données en mémoire peuvent être copiées dans le stockage. La création de transtypages empêche d'autres processus de lire des données, de sorte que la fréquence des points d'arrêt est un compromis entre la vitesse et la fiabilité. Et cela, à son tour, peut être lissé en enregistrant les transactions, ou en enregistrant, en enregistrant les modifications des données afin qu'un état ultérieur puisse être recréé à partir d'une copie antérieure. Mais quand même, lorsque la base de données est complètement en mémoire, un certain pourcentage de redondance est perdu.Les programmes de gestion des bases de données en mémoire (IMDBS) vous permettent de créer des systèmes hybrides dans lesquels certaines tables de base de données sont en mémoire et d'autres vivent sur disque. C'est mieux que la mise en cache et c'est pratique dans les cas où il est inutile de garder la base de données entière en mémoire.Les bases de données peuvent être compressées, en particulier sur les systèmes avec des colonnes qui stockent les tables sous forme d'ensembles de colonnes plutôt que de lignes. La plupart des technologies de compression préfèrent que les données voisines soient du même type et les colonnes des tableaux contiennent presque toujours des données du même type. Et bien que la compression implique d'augmenter la charge de calcul, le stockage des colonnes est bien adapté aux requêtes complexes dans de très grands ensembles de données - c'est pourquoi les utilisateurs et les scientifiques du Big Data s'y intéressent .À grande échelle, des entreprises telles que Google sont passées à la RAM afin qu'un grand nombre de requêtes de recherche soient traitées à une vitesse acceptable. Il existe également des problèmes d'accès à de grandes quantités de mémoire, car la quantité de RAM connectée à une carte mère est limitée et l'organisation de l'accès partagé entraîne des retards supplémentaires.La vie après la RAM

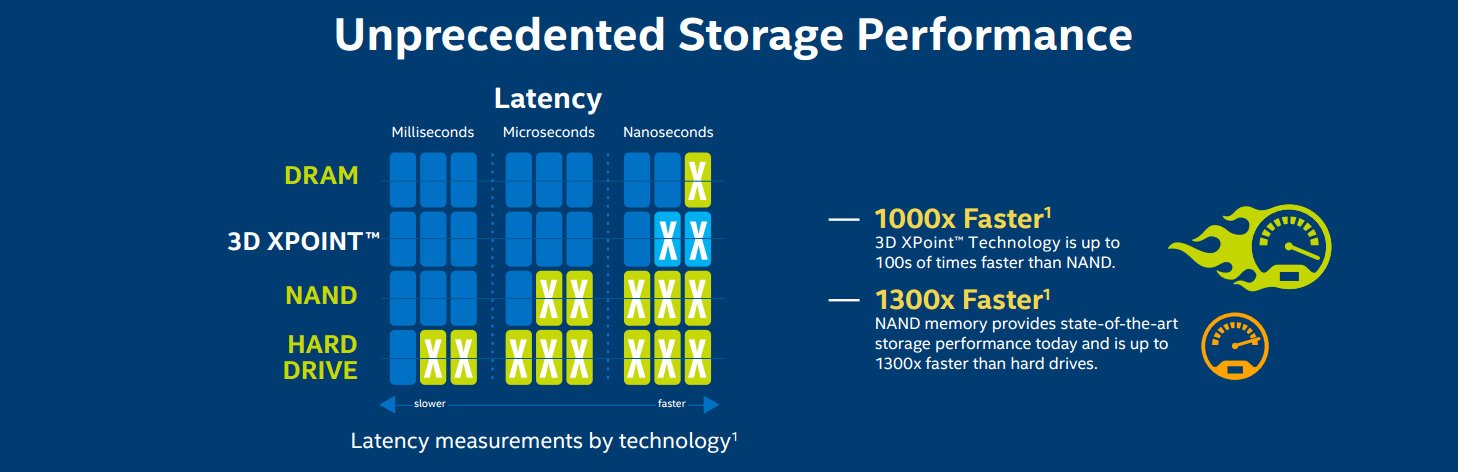

Mais vous ne pouvez pas garantir que travailler avec des données en mémoire est l'avenir du traitement des données. Une autre méthode consiste à utiliser de la RAM non volatile (RAM non volatile, NVRAM), familière aux utilisateurs sous forme de SSD , offrant une architecture compatible avec les systèmes de disques. Ils fonctionnent désormais sur une mémoire flash NAND, qui offre des vitesses de lecture et d'écriture élevées par rapport aux disques durs mécaniques. Mais elle a ses propres problèmes. La mémoire flash nécessite des tensions relativement élevées pour enregistrer les données, et elle dégénère progressivement, contre laquelle des algorithmes spéciaux sont appelés à lutter, entraînant un ralentissement progressif du fonctionnement. Le coût de la mémoire et du stockage au fil du temps (dollars par mégaoctet)Comme vous pouvez le voir sur le graphique, au fil du temps, le coût des disques diminue à peu près le même que le coût de la RAM. La baisse du coût des disques SSD a conduit à leur distribution dans les centres de données et les lieux de travail, mais jusqu'à présent, on ne sait pas quel est l'avenir de cette technologie. Une étude de Google publiée en février 2016, basée sur six ans d'utilisation, a conclu que la mémoire flash est beaucoup moins fiable que les disques durs - par exemple, elle produit des erreurs fatales - bien qu'elle nécessite des remplacements plus rares. Et les SSD à usage professionnel ne diffèrent pas en qualité des options grand public.Mais de nouveaux types de NVRAM font déjà leur apparition. La RAM ferroélectrique (FRAM) était autrefois censée remplacer la RAM et les lecteurs flash dans les appareils mobiles, mais maintenant l'attention s'est portée sur la RAM magnétorésistive (MRAM). En termes de vitesse, il approche de la RAM et le délai d'accès est de 50 nanosecondes - il est plus lent que 10 ns en DRAM, mais 1000 fois plus rapide que les microsecondes en NAND.

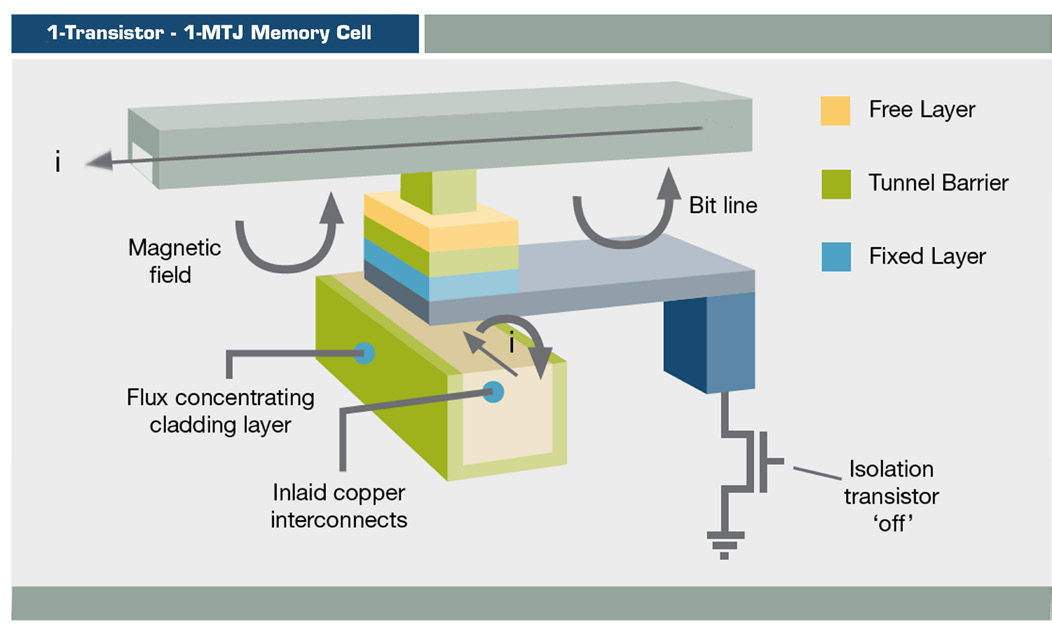

Le coût de la mémoire et du stockage au fil du temps (dollars par mégaoctet)Comme vous pouvez le voir sur le graphique, au fil du temps, le coût des disques diminue à peu près le même que le coût de la RAM. La baisse du coût des disques SSD a conduit à leur distribution dans les centres de données et les lieux de travail, mais jusqu'à présent, on ne sait pas quel est l'avenir de cette technologie. Une étude de Google publiée en février 2016, basée sur six ans d'utilisation, a conclu que la mémoire flash est beaucoup moins fiable que les disques durs - par exemple, elle produit des erreurs fatales - bien qu'elle nécessite des remplacements plus rares. Et les SSD à usage professionnel ne diffèrent pas en qualité des options grand public.Mais de nouveaux types de NVRAM font déjà leur apparition. La RAM ferroélectrique (FRAM) était autrefois censée remplacer la RAM et les lecteurs flash dans les appareils mobiles, mais maintenant l'attention s'est portée sur la RAM magnétorésistive (MRAM). En termes de vitesse, il approche de la RAM et le délai d'accès est de 50 nanosecondes - il est plus lent que 10 ns en DRAM, mais 1000 fois plus rapide que les microsecondes en NAND. Schéma MRAM MRAMstocke les informations en utilisant l'orientation magnétique plutôt que la charge électrique, en utilisant une structure en couches minces et une jonction tunnel magnétique. La commutation MRAM est déjà utilisée dans des produits tels que les matrices de stockage EqualLogic de Dell, mais jusqu'à présent uniquement pour la journalisation.Le transfert de spin MRAM (ST-MRAM) utilise une structure plus complexe qui permet potentiellement une augmentation de la densité. Maintenant, Everspin le lance sur le marché, récemment publié sur le NASDAQ sous le code MRAM. Les autres entreprises qui explorent cette opportunité sont Crocus, Micron, Qualcomm, Samsung, Spin Transfer Technologies (STT) et Toshiba.

Schéma MRAM MRAMstocke les informations en utilisant l'orientation magnétique plutôt que la charge électrique, en utilisant une structure en couches minces et une jonction tunnel magnétique. La commutation MRAM est déjà utilisée dans des produits tels que les matrices de stockage EqualLogic de Dell, mais jusqu'à présent uniquement pour la journalisation.Le transfert de spin MRAM (ST-MRAM) utilise une structure plus complexe qui permet potentiellement une augmentation de la densité. Maintenant, Everspin le lance sur le marché, récemment publié sur le NASDAQ sous le code MRAM. Les autres entreprises qui explorent cette opportunité sont Crocus, Micron, Qualcomm, Samsung, Spin Transfer Technologies (STT) et Toshiba. Mémoire 3D XPoint

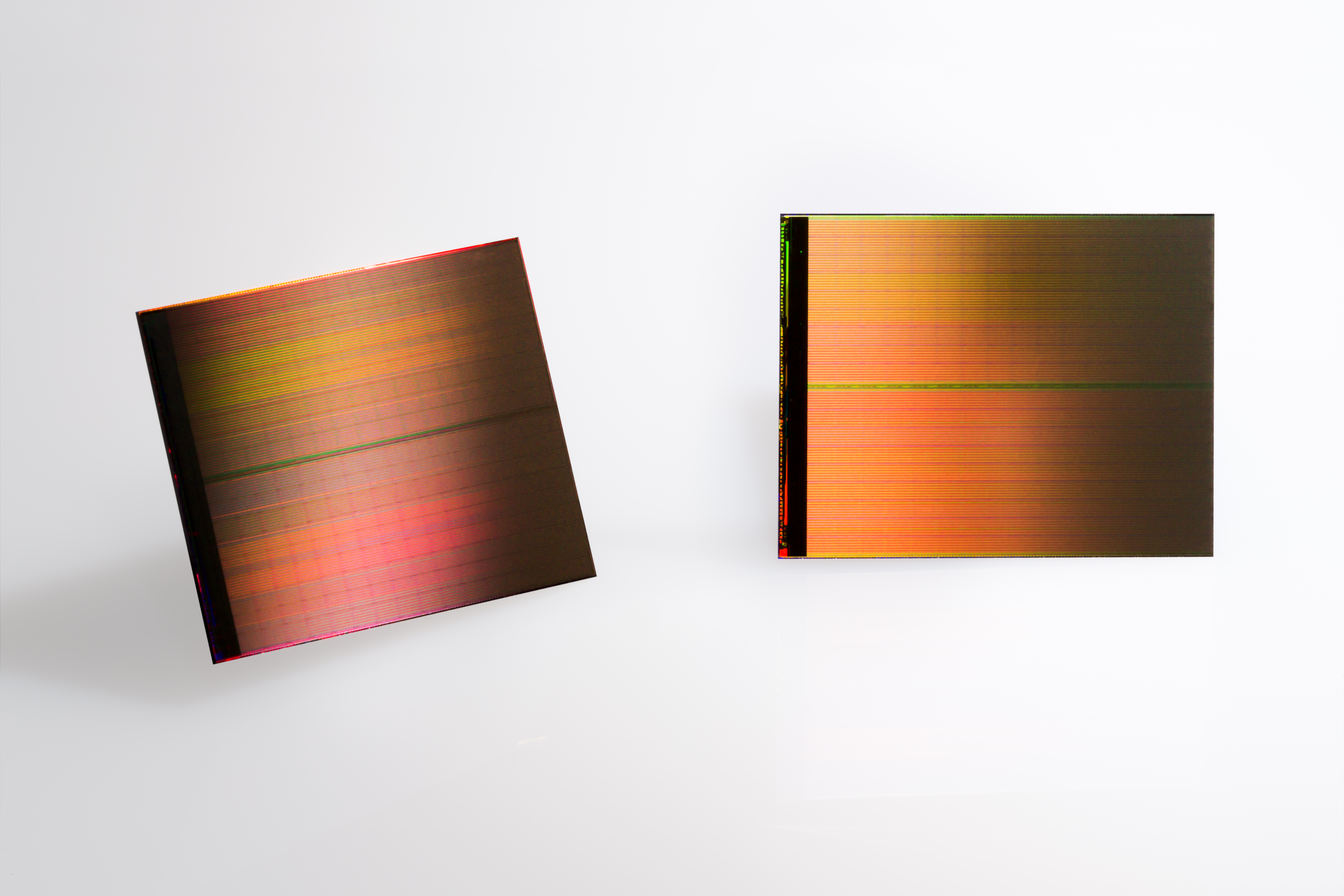

Mémoire 3D XPoint Deux

Deux diagrammes de puces 3D XPoint de 128 Go pour comparaison de vitesse Intel / Micron 3D XPoint

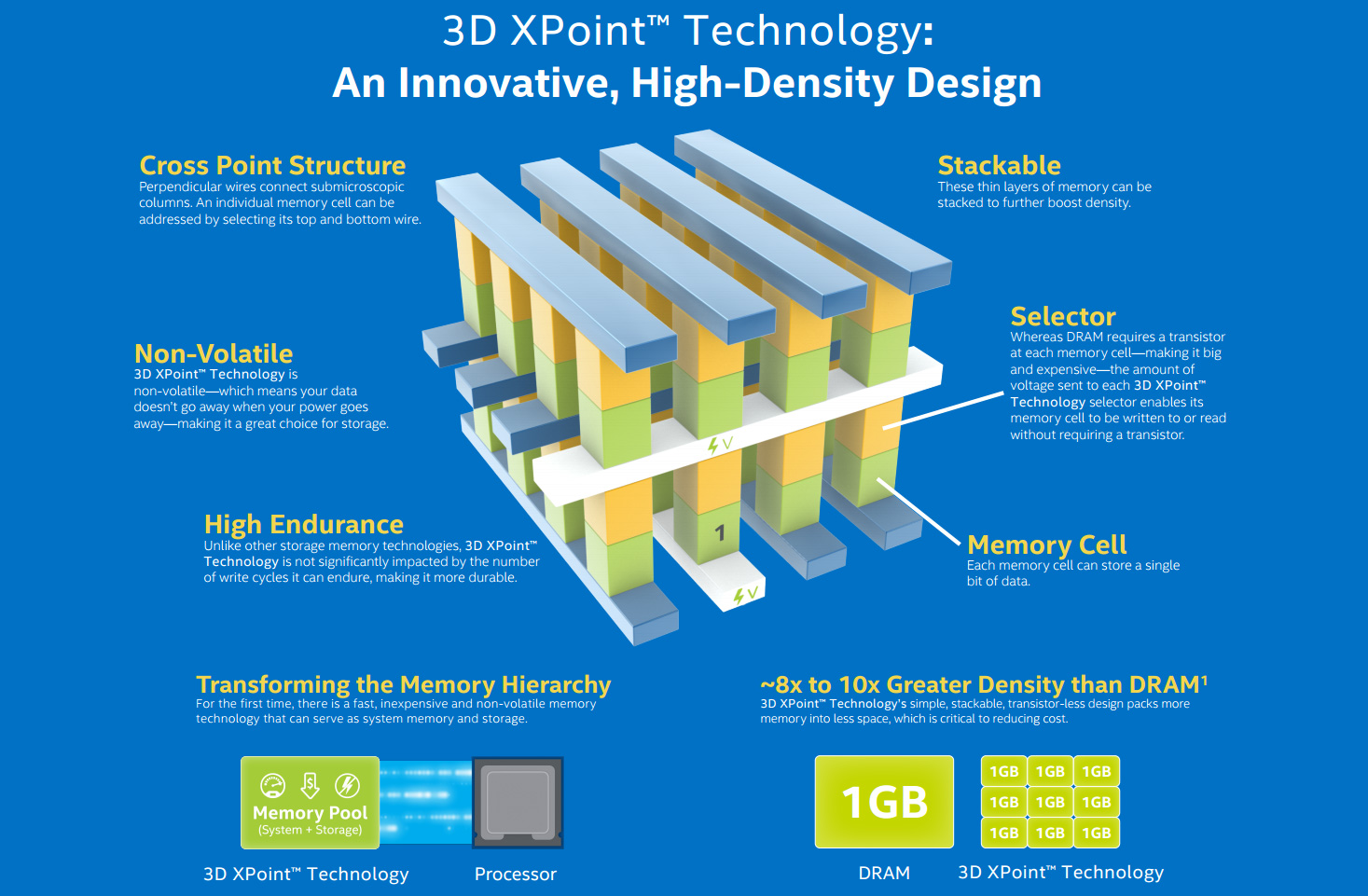

diagrammes de puces 3D XPoint de 128 Go pour comparaison de vitesse Intel / Micron 3D XPoint Parallèlement, Intel travaille avec Micron sur un type de NVRAM appelé 3D XPoint (prononcé «crosspoint»). Cette forme de mémoire à changement de phase (PCM), connue sous le nom de RAM résistive (ReRAM), a été rendue publique en 2015. «3D» signifie la possibilité d'une construction multicouche de mémoire. Intel pense que XPoint peut fonctionner 1 000 fois plus vite que NAND et être 10 fois plus volumineux, bien que ces allégations aient récemment légèrement diminué. Le prix devrait être compris entre le flash et la DRAM. Pour cette raison, il est peu probable qu'il prenne racine dans les maisons, mais à grande échelle, il peut remplacer la RAM et le SSD.IBM travaille également sur la mémoire à changement de phase. Comme Intel, leur technologie est basée sur du verre de chalcogénure utilisé dans des supports optiques réinscriptibles. En utilisant l'électricité pour transformer le matériau d'un état amorphe en l'un des trois cristaux cristallins, l'entreprise bénéficie d'une percée de capacités qui permettra de réduire le coût de la mémoire par rapport à la DRAM.La course RAM affectera tous les niveaux de développement informatique. L'augmentation de la mémoire de 8 à 16 Go sur les bureaux des utilisateurs finaux accélérera le multitâche et augmentera l'efficacité des programmes gourmands en mémoire.Dans les ultrabooks, les SSD sont déjà la norme et les capacités croissantes en font déjà des candidats au remplacement des disques durs. La prochaine génération de NAND en trois dimensions(V-NAND, vertical) promet une plus grande efficacité et densité d'enregistrement. Samsung prévoit que d'ici 2020, il y aura 512 Go de SSD pour les utilisateurs finaux au prix de la vis téraoctet d'aujourd'hui.Pour les moyennes entreprises et les établissements universitaires, une mémoire RAM moins chère signifie une meilleure analyse des données en mémoire - si le logiciel suit. SAP HANA est une base de données en mémoire, une plate-forme pour l'utilisation généralisée du cloud et des solutions sur site, qui permet aux petites entreprises de travailler avec le Big Data. IBM et Oracle ont des bases de données similaires.RAM démocratise la technologie - la technologie devient moins chère et la différence entre les grandes et les petites organisations est effacée.

Parallèlement, Intel travaille avec Micron sur un type de NVRAM appelé 3D XPoint (prononcé «crosspoint»). Cette forme de mémoire à changement de phase (PCM), connue sous le nom de RAM résistive (ReRAM), a été rendue publique en 2015. «3D» signifie la possibilité d'une construction multicouche de mémoire. Intel pense que XPoint peut fonctionner 1 000 fois plus vite que NAND et être 10 fois plus volumineux, bien que ces allégations aient récemment légèrement diminué. Le prix devrait être compris entre le flash et la DRAM. Pour cette raison, il est peu probable qu'il prenne racine dans les maisons, mais à grande échelle, il peut remplacer la RAM et le SSD.IBM travaille également sur la mémoire à changement de phase. Comme Intel, leur technologie est basée sur du verre de chalcogénure utilisé dans des supports optiques réinscriptibles. En utilisant l'électricité pour transformer le matériau d'un état amorphe en l'un des trois cristaux cristallins, l'entreprise bénéficie d'une percée de capacités qui permettra de réduire le coût de la mémoire par rapport à la DRAM.La course RAM affectera tous les niveaux de développement informatique. L'augmentation de la mémoire de 8 à 16 Go sur les bureaux des utilisateurs finaux accélérera le multitâche et augmentera l'efficacité des programmes gourmands en mémoire.Dans les ultrabooks, les SSD sont déjà la norme et les capacités croissantes en font déjà des candidats au remplacement des disques durs. La prochaine génération de NAND en trois dimensions(V-NAND, vertical) promet une plus grande efficacité et densité d'enregistrement. Samsung prévoit que d'ici 2020, il y aura 512 Go de SSD pour les utilisateurs finaux au prix de la vis téraoctet d'aujourd'hui.Pour les moyennes entreprises et les établissements universitaires, une mémoire RAM moins chère signifie une meilleure analyse des données en mémoire - si le logiciel suit. SAP HANA est une base de données en mémoire, une plate-forme pour l'utilisation généralisée du cloud et des solutions sur site, qui permet aux petites entreprises de travailler avec le Big Data. IBM et Oracle ont des bases de données similaires.RAM démocratise la technologie - la technologie devient moins chère et la différence entre les grandes et les petites organisations est effacée. Google Data Center avec des serveurs personnalisés

Google Data Center avec des serveurs personnalisés Sequoia Supercomputer

Sequoia Supercomputer

Supercalculateur Sunway TaihuLight, l'ordinateur le plus rapide du monde, 93 pétans flops

Supercalculateur Sunway TaihuLight, l'ordinateur le plus rapide du monde, 93 pétans flops Titan, le supercalculateur le plus rapide des États-Unis

Titan, le supercalculateur le plus rapide des États-Unis EcoPod HP data centerEnfin et surtout , le besoin est de disposer d'une mémoire de supercalculateur. Le Sunway TaihuLight SC chinois le plus rapide d'aujourd'hui contient 1 300 To de DRAM DDR3, ce qui est relativement petit pour sa vitesse de 93 pétaflops (quadrillions d'opérations en virgule flottante par seconde). En particulier, de ce fait, sa consommation d'énergie n'est que de 15,3 MW, mais cela peut devenir un facteur limitant.Maintenant, tout le monde s'efforce d'obtenir le préfixe exaflops, ou 1000 pétaflops. L'ordinateur post-K japonais, développé par Riken et Fujitsu, sera prêt d'ici 2020 et comprendra le cube de mémoire hybride de Micron, une implémentation multicouche de DRAM, et peut-être aussi utiliser 3D XPoint NVRAM. Le projet européen NEXTGenIO au Edinburgh Supercomputer Center prévoit de réaliser des exaflops d'ici 2022, en utilisant également 3D XPoint.Aux États-Unis, l'Exascale Computing Project, développé dans le cadre de l'initiative NSCI, devrait présenter deux supercalculateurs de vitesse similaire d'ici 2023. Leur architecture est encore en cours de développement, mais comme la vitesse et l'efficacité énergétique sont une priorité, la RAM y jouera un rôle central.

EcoPod HP data centerEnfin et surtout , le besoin est de disposer d'une mémoire de supercalculateur. Le Sunway TaihuLight SC chinois le plus rapide d'aujourd'hui contient 1 300 To de DRAM DDR3, ce qui est relativement petit pour sa vitesse de 93 pétaflops (quadrillions d'opérations en virgule flottante par seconde). En particulier, de ce fait, sa consommation d'énergie n'est que de 15,3 MW, mais cela peut devenir un facteur limitant.Maintenant, tout le monde s'efforce d'obtenir le préfixe exaflops, ou 1000 pétaflops. L'ordinateur post-K japonais, développé par Riken et Fujitsu, sera prêt d'ici 2020 et comprendra le cube de mémoire hybride de Micron, une implémentation multicouche de DRAM, et peut-être aussi utiliser 3D XPoint NVRAM. Le projet européen NEXTGenIO au Edinburgh Supercomputer Center prévoit de réaliser des exaflops d'ici 2022, en utilisant également 3D XPoint.Aux États-Unis, l'Exascale Computing Project, développé dans le cadre de l'initiative NSCI, devrait présenter deux supercalculateurs de vitesse similaire d'ici 2023. Leur architecture est encore en cours de développement, mais comme la vitesse et l'efficacité énergétique sont une priorité, la RAM y jouera un rôle central.Source: https://habr.com/ru/post/fr398373/

All Articles