Rumeur de machine. Réseau de neurones SoundNet formé pour reconnaître les objets par le son

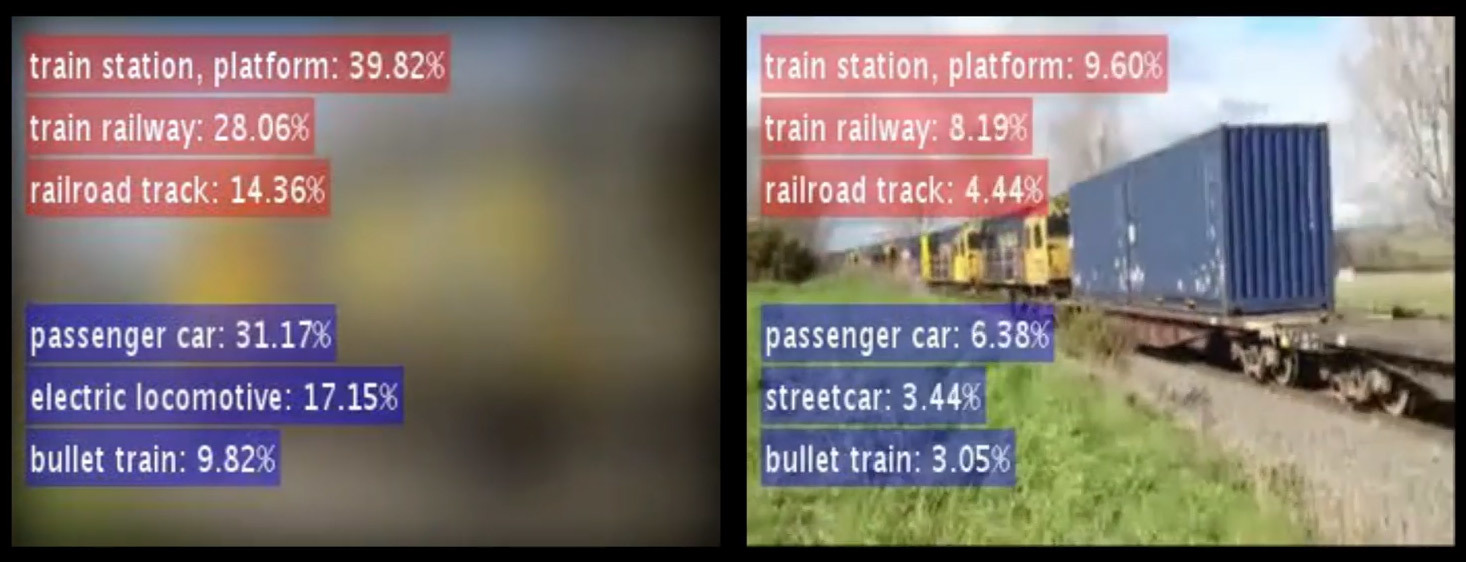

À gauche: une tentative de reconnaître la scène et les objets uniquement par le son. À droite: une véritable source sonoreRécemment, les réseaux de neurones ont fait des progrès considérables dans la reconnaissance d'objets et de scènes en vidéo. De telles réalisations sont rendues possibles par la formation sur des ensembles de données massifs avec des objets marqués (par exemple, voir la base de données «Apprentissage de fonctionnalités approfondies pour la reconnaissance de scènes à l'aide de lieux» . NIPS, 2014) En regardant des photographies ou des vidéos, l'ordinateur peut déterminer presque précisément la scène en sélectionnant une description appropriée parmi 401 scènespar exemple, une cuisine encombrée, une cuisine élégante, une chambre d'adolescent, etc. Mais dans le domaine de la compréhension, les sons du réseau neuronal n'ont pas encore montré de tels progrès. Des spécialistes du laboratoire d'informatique et d'intelligence artificielle du Massachusetts Institute of Technology (CSAIL) ont corrigé cette lacune en développant le système d' apprentissage automatique SoundNet .En fait, être capable de localiser une scène par son est une tâche tout aussi importante que de localiser une scène par vidéo. Au final, l'image de l'appareil photo peut souvent être floue ou ne pas fournir suffisamment d'informations. Mais si le microphone fonctionne, le robot pourra déjà savoir où il se trouve.Du point de vue de la science, la formation des réseaux de neurones SoundNet est une tâche assez banale. Les employés de la CSAIL ont utilisé la méthode de synchronisation naturelle entre la vision artificielle et l'audition machine, enseignant au réseau neuronal à extraire automatiquement la représentation sonore d'un objet à partir de matériel vidéo non alloué. Pour la formation, nous avons utilisé environ 2 millions de vidéos Flickr (26 To de données), ainsi qu'une base de données de sons annotés - 50 catégories et environ 2000 échantillons.

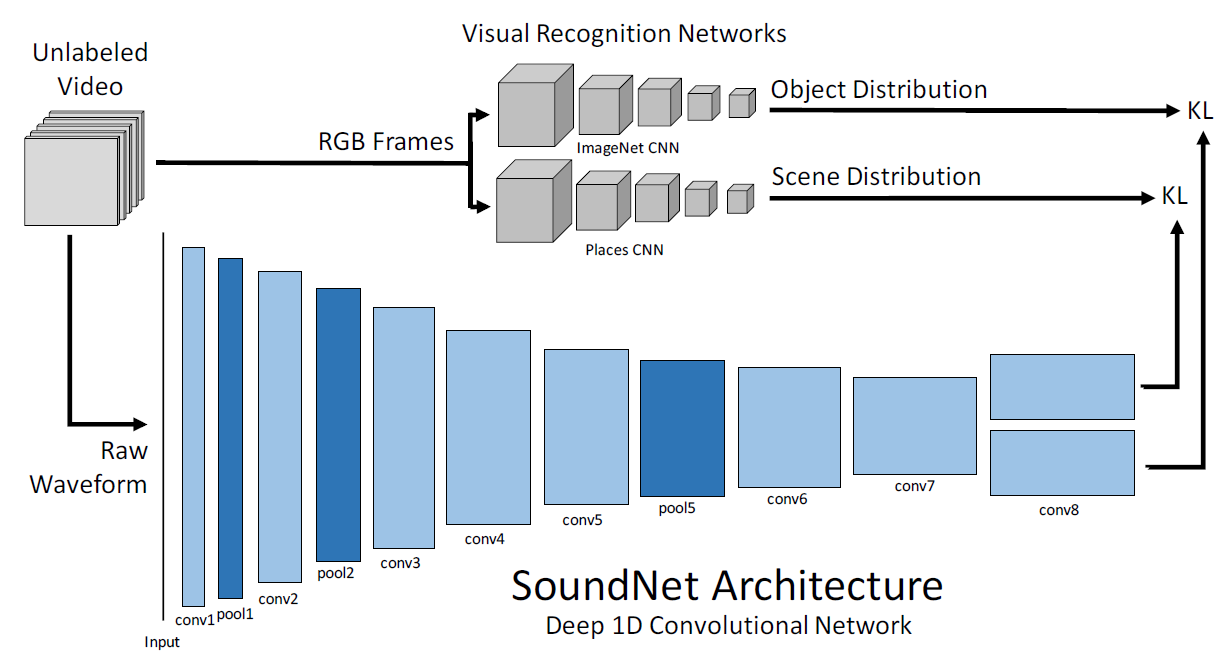

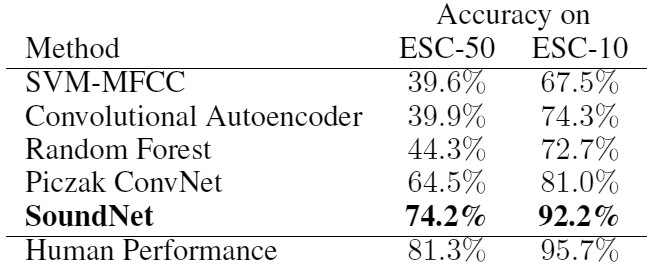

À gauche: une tentative de reconnaître la scène et les objets uniquement par le son. À droite: une véritable source sonoreRécemment, les réseaux de neurones ont fait des progrès considérables dans la reconnaissance d'objets et de scènes en vidéo. De telles réalisations sont rendues possibles par la formation sur des ensembles de données massifs avec des objets marqués (par exemple, voir la base de données «Apprentissage de fonctionnalités approfondies pour la reconnaissance de scènes à l'aide de lieux» . NIPS, 2014) En regardant des photographies ou des vidéos, l'ordinateur peut déterminer presque précisément la scène en sélectionnant une description appropriée parmi 401 scènespar exemple, une cuisine encombrée, une cuisine élégante, une chambre d'adolescent, etc. Mais dans le domaine de la compréhension, les sons du réseau neuronal n'ont pas encore montré de tels progrès. Des spécialistes du laboratoire d'informatique et d'intelligence artificielle du Massachusetts Institute of Technology (CSAIL) ont corrigé cette lacune en développant le système d' apprentissage automatique SoundNet .En fait, être capable de localiser une scène par son est une tâche tout aussi importante que de localiser une scène par vidéo. Au final, l'image de l'appareil photo peut souvent être floue ou ne pas fournir suffisamment d'informations. Mais si le microphone fonctionne, le robot pourra déjà savoir où il se trouve.Du point de vue de la science, la formation des réseaux de neurones SoundNet est une tâche assez banale. Les employés de la CSAIL ont utilisé la méthode de synchronisation naturelle entre la vision artificielle et l'audition machine, enseignant au réseau neuronal à extraire automatiquement la représentation sonore d'un objet à partir de matériel vidéo non alloué. Pour la formation, nous avons utilisé environ 2 millions de vidéos Flickr (26 To de données), ainsi qu'une base de données de sons annotés - 50 catégories et environ 2000 échantillons. Architecture du réseau neuronal SoundNetBien que la formation du réseau neuronal se soit déroulée sous observation visuelle, le système donne un excellent résultat en mode autonome selon la classification d'au moins trois scènes acoustiques standard, selon lesquelles les développeurs l'ont vérifié. De plus, un test du réseau neuronal a montré qu'elle avait appris de façon indépendante à reconnaître les sons caractéristiques de certaines scènes, et les développeurs n'ont pas fourni ses échantillons pour reconnaître ces objets spécifiquement. Sur la base de matériaux vidéo non alloués, le réseau de neurones lui-même a appris quelle scène correspond au son d'une foule en liesse (c'est un stade) et du twitter d'oiseau (c'est une pelouse ou un parc). Simultanément à la scène, le réseau neuronal reconnaît un objet spécifique, qui est la source du son.La vidéo montre quelques exemples de reconnaissance d'objets par le son. Au début, le son retentit et le résultat de la reconnaissance s'affiche, et l'image elle-même est floue - vous pouvez donc essayer de vous vérifier. Serez-vous capable de comprendre le lieu d'action et la présence de certains objets uniquement par le son aussi précisément que le fait le réseau neuronal. Par exemple, quel est probablement le sens de la chanson "Happy Birthday To You!", Qui est chantée à l'unisson par plusieurs personnes? La bonne réponse: l'objet brûle des bougies , la scène est un restaurant, un café, un bar .«La vision industrielle a commencé à fonctionner si bien que nous pouvons transférer cette technologie dans d'autres domaines», a déclaré Carl Vondrick, étudiant au Massachusetts Institute of Technology en génie électrique et informatique, l'un des auteurs des travaux scientifiques. - Nous avons utilisé la relation naturelle entre la vision par ordinateur et le son. Il a été possible d'atteindre une grande échelle en raison de la multitude de matériaux vidéo non étiquetés, de sorte que le réseau neuronal a appris à comprendre le son.Les tests SoundNet ont été effectués sur deux bases de données standard d'enregistrements sonores, et ils ont montré une précision de reconnaissance des objets 13 à 15% plus élevée que le meilleur de ces programmes. Sur un ensemble de données avec 10 catégories différentes de sons, SoundNet classe les sons avec une précision de 92%, et sur un ensemble de données avec 50 catégories, il montre une précision de 74%. À titre de comparaison, sur les mêmes ensembles de données, les gens montrent une précision de reconnaissance de 96% et 81% en moyenne.

Architecture du réseau neuronal SoundNetBien que la formation du réseau neuronal se soit déroulée sous observation visuelle, le système donne un excellent résultat en mode autonome selon la classification d'au moins trois scènes acoustiques standard, selon lesquelles les développeurs l'ont vérifié. De plus, un test du réseau neuronal a montré qu'elle avait appris de façon indépendante à reconnaître les sons caractéristiques de certaines scènes, et les développeurs n'ont pas fourni ses échantillons pour reconnaître ces objets spécifiquement. Sur la base de matériaux vidéo non alloués, le réseau de neurones lui-même a appris quelle scène correspond au son d'une foule en liesse (c'est un stade) et du twitter d'oiseau (c'est une pelouse ou un parc). Simultanément à la scène, le réseau neuronal reconnaît un objet spécifique, qui est la source du son.La vidéo montre quelques exemples de reconnaissance d'objets par le son. Au début, le son retentit et le résultat de la reconnaissance s'affiche, et l'image elle-même est floue - vous pouvez donc essayer de vous vérifier. Serez-vous capable de comprendre le lieu d'action et la présence de certains objets uniquement par le son aussi précisément que le fait le réseau neuronal. Par exemple, quel est probablement le sens de la chanson "Happy Birthday To You!", Qui est chantée à l'unisson par plusieurs personnes? La bonne réponse: l'objet brûle des bougies , la scène est un restaurant, un café, un bar .«La vision industrielle a commencé à fonctionner si bien que nous pouvons transférer cette technologie dans d'autres domaines», a déclaré Carl Vondrick, étudiant au Massachusetts Institute of Technology en génie électrique et informatique, l'un des auteurs des travaux scientifiques. - Nous avons utilisé la relation naturelle entre la vision par ordinateur et le son. Il a été possible d'atteindre une grande échelle en raison de la multitude de matériaux vidéo non étiquetés, de sorte que le réseau neuronal a appris à comprendre le son.Les tests SoundNet ont été effectués sur deux bases de données standard d'enregistrements sonores, et ils ont montré une précision de reconnaissance des objets 13 à 15% plus élevée que le meilleur de ces programmes. Sur un ensemble de données avec 10 catégories différentes de sons, SoundNet classe les sons avec une précision de 92%, et sur un ensemble de données avec 50 catégories, il montre une précision de 74%. À titre de comparaison, sur les mêmes ensembles de données, les gens montrent une précision de reconnaissance de 96% et 81% en moyenne. Même les gens ne savent parfois pas exactement ce qu'ils entendent. Essayez de mener vous-même une telle expérience. Laissez un collègue démarrer une vidéo arbitraire à partir de YouTube - et vous essayez de ne pas regarder le moniteur pour dire ce qui se passe, d'où viennent les sons et ce qui est affiché à l'écran. Loin de toujours, vous pouvez deviner. La tâche de l'intelligence artificielle n'est donc vraiment pas facile, mais SoundNet a réussi à y faire face assez bien.À l'avenir, ces programmes informatiques pourraient trouver une application pratique. Par exemple, votre téléphone mobile reconnaîtra automatiquement que vous êtes entré dans un lieu public - un cinéma ou un théâtre, et coupera automatiquement le volume de la sonnerie. Si le film a commencé et que le public s'est calmé, le téléphone désactivera automatiquement le son et activera l'alerte vibrante.L'orientation par le terrain par le son aidera dans les programmes de contrôle des robots autonomes et autres machines.Dans les systèmes de sécurité et les maisons intelligentes, le système peut spécifiquement répondre automatiquement à des sons spécifiques d'une manière spécifique. Par exemple, le son d'une fenêtre cassée. Dans les «villes intelligentes» du futur, la reconnaissance du bruit des rues permettra de comprendre ses causes et de faire face à la pollution sonore.L'article scientifique a été publié le 27 octobre 2016 dans le domaine public à arXiv.org (arXiv: 1610.09001, pdf ).

Même les gens ne savent parfois pas exactement ce qu'ils entendent. Essayez de mener vous-même une telle expérience. Laissez un collègue démarrer une vidéo arbitraire à partir de YouTube - et vous essayez de ne pas regarder le moniteur pour dire ce qui se passe, d'où viennent les sons et ce qui est affiché à l'écran. Loin de toujours, vous pouvez deviner. La tâche de l'intelligence artificielle n'est donc vraiment pas facile, mais SoundNet a réussi à y faire face assez bien.À l'avenir, ces programmes informatiques pourraient trouver une application pratique. Par exemple, votre téléphone mobile reconnaîtra automatiquement que vous êtes entré dans un lieu public - un cinéma ou un théâtre, et coupera automatiquement le volume de la sonnerie. Si le film a commencé et que le public s'est calmé, le téléphone désactivera automatiquement le son et activera l'alerte vibrante.L'orientation par le terrain par le son aidera dans les programmes de contrôle des robots autonomes et autres machines.Dans les systèmes de sécurité et les maisons intelligentes, le système peut spécifiquement répondre automatiquement à des sons spécifiques d'une manière spécifique. Par exemple, le son d'une fenêtre cassée. Dans les «villes intelligentes» du futur, la reconnaissance du bruit des rues permettra de comprendre ses causes et de faire face à la pollution sonore.L'article scientifique a été publié le 27 octobre 2016 dans le domaine public à arXiv.org (arXiv: 1610.09001, pdf ).Source: https://habr.com/ru/post/fr399659/

All Articles