Des études montrent que les modèles informatiques, appelés réseaux de neurones utilisés dans un nombre croissant d'applications, peuvent apprendre à reconnaître des séquences dans des données en utilisant les mêmes algorithmes que le cerveau humain.

Le cerveau résout son problème canonique - l'entraînement - en ajustant bon nombre de ses composés selon un ensemble de règles inconnu. Pour révéler ces règles, les scientifiques ont commencé à développer des modèles informatiques il y a 30 ans en essayant de reproduire le processus d'apprentissage. Aujourd'hui, dans un nombre croissant d'expériences, il devient clair que ces modèles se comportent de manière très similaire au cerveau réel dans certaines tâches. Les chercheurs disent que cette similitude suggère un ajustement de base entre le cerveau et les algorithmes d'apprentissage informatique.

L'algorithme utilisé par le modèle informatique est appelé

la machine de Boltzmann . Il a été

inventé par Jeffrey Hinton et Terry Seinowski en 1983 [en fait, en

1985 - env. trad.]. Il semble très prometteur comme une explication théorique simple de plusieurs processus se produisant dans le cerveau - développement, formation de la mémoire, reconnaissance des objets et des sons, cycles de sommeil et de réveil.

«C'est la meilleure opportunité que nous ayons aujourd'hui pour comprendre le cerveau», explique Sue Becker, professeur de psychologie, de neurobiologie et de comportement à l'Université. McMaster à Hamilton, Ontario. "Je ne connais pas de modèle décrivant un plus large éventail de phénomènes liés à l'apprentissage et à la structure cérébrale."

Hinton, un pionnier dans le domaine de l'IA, a toujours voulu comprendre les règles par lesquelles le cerveau améliore ou affaiblit la communication - c'est-à-dire l'algorithme d'apprentissage. «J'ai décidé que pour comprendre quelque chose, il fallait le construire», dit-il. Suivant l'approche réductionniste des physiciens, il prévoit de créer des modèles informatiques simples du cerveau en utilisant différents algorithmes d'apprentissage et de voir «lesquels fonctionneront», explique Hinton, en partie professeur d'informatique à l'Université de Toronto et en partie à Google.

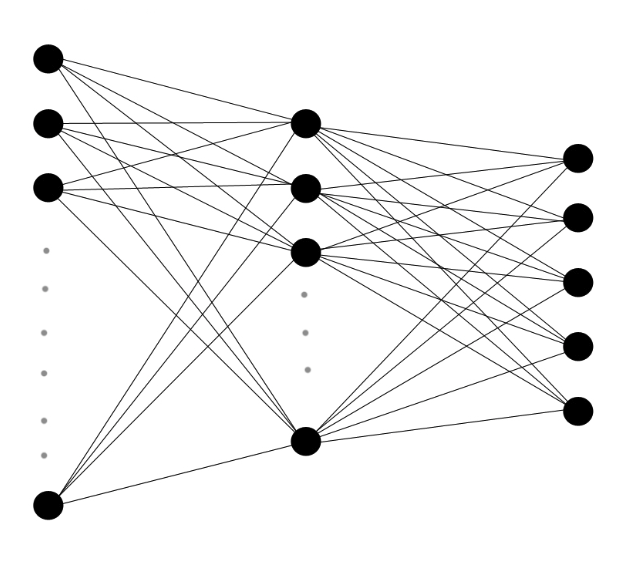

Les réseaux de neurones multicouches sont constitués de couches de neurones artificiels avec des connexions pondérées entre eux. J'envoie aux données entrantes une cascade de signaux en couches, et l'algorithme détermine la variation des poids de chaque connexion.

Les réseaux de neurones multicouches sont constitués de couches de neurones artificiels avec des connexions pondérées entre eux. J'envoie aux données entrantes une cascade de signaux en couches, et l'algorithme détermine la variation des poids de chaque connexion.Dans les années 1980 et 1990, Hinton, l'arrière-arrière-petit-fils de la logique du XIXe siècle, George Boole, dont les travaux ont constitué la base de l'informatique moderne, a inventé plusieurs algorithmes d'apprentissage automatique. Les algorithmes qui contrôlent la façon dont un ordinateur apprend des données sont utilisés dans des modèles informatiques appelés «réseaux de neurones artificiels» - des réseaux de neurones virtuels interconnectés qui transmettent des signaux à leurs voisins, s’allument ou s’éteignent ou se «déclenchent». Lorsque des données sont envoyées au réseau, cela conduit à une cascade de réponses, et l'algorithme, basé sur l'image de ces réponses, choisit d'augmenter ou de diminuer le poids des connexions, ou synapses, entre chaque paire de neurones.

Depuis des décennies, de nombreux modèles informatiques Hinton végètent. Mais grâce aux progrès de la puissance du processeur, aux progrès dans la compréhension du cerveau et des algorithmes, les réseaux de neurones jouent un rôle de plus en plus important en neurobiologie. Sejnowski [Sejnowski], chef du laboratoire informatique de neurobiologie de l'Institut de recherche biologique. Salka à La Jolla, en Californie, déclare: «Il y a trente ans, nous avions des idées très approximatives; maintenant, nous commençons à en tester certains. »

Machines à cerveau

Les premières tentatives de Hinton pour reproduire le cerveau étaient limitées. Les ordinateurs pouvaient exécuter ses algorithmes d'apprentissage sur de petits réseaux de neurones, mais les modèles de mise à l'échelle surchargeaient très rapidement les processeurs. En 2005, Hinton a découvert que si vous divisez les réseaux de neurones en couches et exécutez les algorithmes séparément sur chaque couche, répétant approximativement la structure et le développement du cerveau, le processus devient plus efficace.

Bien que Hinton ait publié sa découverte dans

deux magazines bien connus , les réseaux de neurones n'étaient plus à la mode à ce moment-là, et il «avait du mal à intéresser les gens», a déclaré Lee Deng, chercheur principal chez Microsoft Research. Cependant, Deng connaissait Hinton et a décidé de tester sa méthode «d'apprentissage en profondeur» en 2009, reconnaissant rapidement son potentiel. Au cours des années suivantes, les algorithmes d'apprentissage sont utilisés dans la pratique dans un nombre croissant d'applications, comme l'assistant personnel de Google Now ou la fonction de recherche vocale sur les téléphones Microsoft Windows.

L'un des algorithmes les plus prometteurs, la machine Boltzmann, tire son nom du physicien autrichien du 19e siècle, Ludwig Boltzmann, qui a développé une branche de la physique traitant un grand nombre de particules, connue sous le nom de mécanique statistique. Boltzmann a découvert une équation qui donne la probabilité qu'un gaz moléculaire ait une certaine énergie lorsqu'il atteint l'équilibre. Si vous remplacez les molécules par des neurones, le résultat tendra vers la même équation.

Les synapses du réseau commencent par une distribution aléatoire des poids, et les poids sont progressivement ajustés selon une procédure assez simple: le circuit de réponse généré en cours de réception de données par la machine (comme les images ou les sons) est comparé au circuit de réponse aléatoire de la machine qui se produit lorsque les données ne sont pas entrées.

Joffrey Hinton pense que la meilleure approche pour comprendre les processus d'apprentissage dans le cerveau est de construire des ordinateurs qui apprennent de la même manière.

Joffrey Hinton pense que la meilleure approche pour comprendre les processus d'apprentissage dans le cerveau est de construire des ordinateurs qui apprennent de la même manière.Chaque synapse virtuelle suit les deux ensembles statistiques. Si les neurones qui y sont connectés sont plus souvent déclenchés dans une séquence rapprochée lors de la réception de données que lors d'une opération aléatoire, alors le poids de la synapse augmente d'une valeur proportionnelle à la différence. Mais si deux neurones sont plus souvent déclenchés ensemble au cours d'une opération aléatoire, la synapse les reliant est alors considérée comme trop forte et affaiblie.

La version la plus utilisée de la machine Boltzmann fonctionne mieux après la «formation», après avoir traité des milliers d'échantillons de données séquentiellement sur chaque couche. Premièrement, la couche inférieure du réseau reçoit des données brutes sous forme d'images ou de sons et, à la manière des cellules rétiniennes, les neurones sont déclenchés s'ils détectent des contrastes dans leur zone de données, comme le passage de la lumière à l'obscurité. Leur déclenchement peut déclencher le déclenchement des neurones qui leur sont associés, selon le poids de la synapse qui les relie. Comme le déclenchement de paires de neurones virtuels est constamment comparé aux statistiques de fond, des connexions significatives entre les neurones apparaissent et s'intensifient progressivement. Les poids des synapses sont spécifiés et des catégories de sons et d'images sont intégrées aux connexions. Chaque couche suivante est entraînée de manière similaire, en utilisant les données de la couche située en dessous.

Si vous transmettez une image d'une voiture à un réseau de neurones formé pour détecter certains objets dans les images, la couche inférieure fonctionnera si elle détecte un contraste qui indique un visage ou un point final. Ces signaux iront aux neurones de niveau supérieur qui déterminent les angles, les parties des roues, etc. Au niveau supérieur, les neurones ne sont déclenchés qu'en réagissant à l'image de la voiture.

«La magie de ce qui se passe sur le Web est qu'elle peut résumer», explique Yann LeCun, directeur du Data Science Center de l'Université de New York. "Si vous lui montrez une voiture qu'elle n'a jamais vue auparavant, et si la voiture aura des formes et des caractéristiques communes avec les machines qui lui sont montrées pendant l'entraînement, elle peut déterminer qu'il s'agit d'une voiture."

Les réseaux de neurones ont récemment accéléré leur développement grâce au mode multicouche Hinton, à l'utilisation de puces informatiques à haute vitesse pour le traitement des graphiques et à la croissance explosive du nombre d'images et d'enregistrements vocaux disponibles pour la formation. Les réseaux sont capables de reconnaître correctement 88% des mots en anglais, tandis que la personne moyenne en reconnaît 96%. Ils peuvent détecter des voitures et des milliers d'autres objets dans des images avec une précision similaire, et au cours des dernières années, ils ont pris une position dominante dans les compétitions d'apprentissage automatique.

Construire un cerveau

Personne ne sait comment déterminer directement les règles selon lesquelles le cerveau est entraîné, mais il existe de nombreuses coïncidences indirectes entre le comportement du cerveau et la machine de Boltzmann.

Les deux sont formés sans supervision, en utilisant uniquement les modèles existants dans les données. «Votre mère ne vous dit pas un million de fois ce qui est montré sur l'image», dit Hinton. - Vous devez apprendre à reconnaître les choses sans l'avis des autres. Après avoir étudié les catégories, ils vous indiquent les noms de ces catégories. Les enfants apprennent donc les chiens et les chats, puis ils apprennent que les chiens sont appelés «chiens» et que les chats sont appelés «chats».

Le cerveau adulte n'est pas aussi flexible que le jeune, tout comme la machine Boltzmann, après s'être entraîné pour 100 000 images de voitures, il ne changera pas beaucoup après en avoir vu une autre. Ses synapses ont déjà les bons poids pour catégoriser les voitures. Mais la formation ne s'arrête pas. De nouvelles informations peuvent être intégrées dans la structure du cerveau et des machines Boltzmann.

Au cours des deux dernières décennies, une étude de l'activité cérébrale dans un rêve a fourni la première preuve que le cerveau utilise un algorithme similaire à l'algorithme de Boltzmann pour incorporer de nouvelles informations et mémoires dans sa structure. Les neuroscientifiques savent depuis longtemps que le sommeil joue un rôle important dans la consolidation de la mémoire et aide à intégrer de nouvelles informations. En 1995, Hinton et ses collègues ont

suggéré que le sommeil joue le rôle d'un niveau de base dans l'algorithme, dénotant l'activité des neurones en l'absence de données d'entrée.

"Pendant le sommeil, vous venez de déterminer la fréquence de base des neurones", explique Hinton. - Vous découvrez la corrélation de leur travail dans le cas où le système fonctionne seul. Et puis, si les neurones sont plus en corrélation, augmentez simplement les poids entre eux. Et si moins, réduisez le poids. "

Au niveau de la synapse, "cet algorithme peut être fourni de plusieurs manières", explique Sezhnowski, conseiller de l'administration présidentielle dans le cadre de

l'initiative BRAIN , une étude dotée d'une subvention de 100 millions de dollars destinée à développer de nouvelles techniques d'étude du cerveau.

Il dit qu'il est plus facile pour le cerveau de travailler avec l'algorithme de Boltzmann, en passant de la construction de synapses le jour à la diminution la nuit.

Giulio Tononi , directeur du Center for Sleep and Consciousness Studies de l'Université du Wisconsin-Madison, a constaté que l'expression des gènes dans les synapses les modifie selon cette hypothèse: les gènes impliqués dans la croissance des synapses sont plus actifs pendant la journée et les gènes impliqués dans la contraction synapses - la nuit.

Dans une autre option, «la ligne de base peut être calculée dans un rêve, puis des modifications par rapport à celle-ci peuvent être apportées pendant la journée», explique Sezhnowski. Dans son laboratoire, des modèles informatiques détaillés des synapses et des réseaux qu'ils prennent en charge sont construits pour déterminer comment ils collectent des statistiques sur les modes d'éveil et de sommeil, et quand la force des synapses change pour afficher cette différence.

Difficultés avec le cerveau

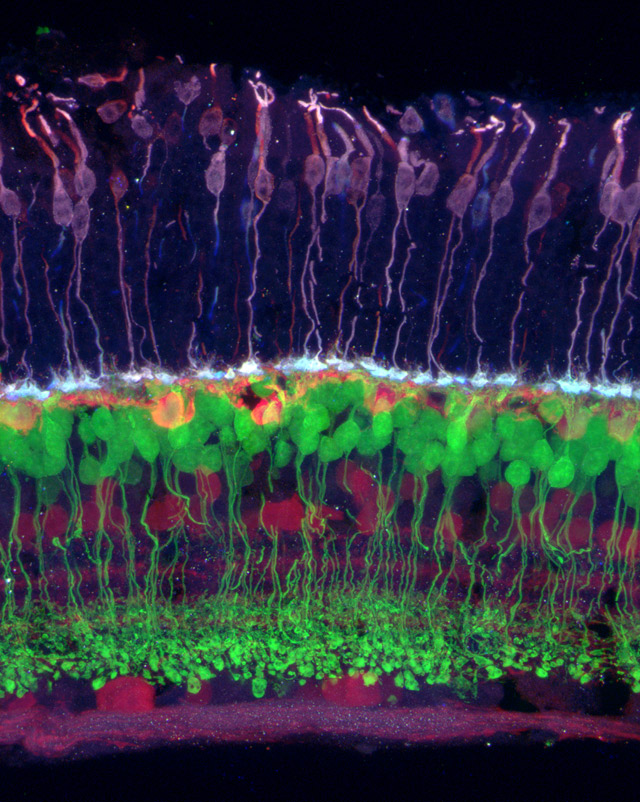

Image de la rétine dans laquelle différents types de cellules sont indiqués par différentes couleurs. La couleur (violet) se connecte à l'horizontale (orange), qui se connecte au bipolaire (vert) et à celles - aux cellules de la rétine et du ganglion (violet).

Image de la rétine dans laquelle différents types de cellules sont indiqués par différentes couleurs. La couleur (violet) se connecte à l'horizontale (orange), qui se connecte au bipolaire (vert) et à celles - aux cellules de la rétine et du ganglion (violet).L'algorithme de Boltzmann peut être l'un des nombreux utilisés par le cerveau pour affiner les synapses. Dans les années 1990, plusieurs groupes indépendants ont développé un modèle théorique de la façon dont le système visuel code efficacement le flux d'informations vers la rétine. La théorie postulait que dans les couches inférieures du cortex visuel, il existe un processus de «codage dispersé», similaire à la compression d'image, à la suite de quoi les derniers stades du système visuel fonctionnent plus efficacement.

Les prédictions du modèle passent progressivement des tests de plus en plus rigoureux. Dans un

article publié dans PLOS Computational Biology, des neuroscientifiques computationnels de Grande-Bretagne et d'Australie ont découvert que lorsque les réseaux de neurones utilisant l'algorithme de codage dispersé Products of Experts inventé par Hinton en 2002 traitent les mêmes données visuelles inhabituelles que les chats vivants reçoivent (par exemple, les chats et les réseaux de neurones étudient les images rayées), leurs neurones produisent des connexions inhabituelles presque identiques.

"Au moment où l'information atteint le cortex visuel, le cerveau, nous pensons, la présente comme un code dispersé", a déclaré Bruno Olshausen, neuroscientifique informatique et directeur du Redwood Center for Theoretical Neurobiology de l'Université de Californie à Berkeley, qui a aidé à développer théorie du codage dispersé. "Comme si une machine Boltzmann était assise dans votre tête et essayait de comprendre les connexions qui existent entre les éléments du code dispersé."

Olshausen et l'équipe ont utilisé des modèles de réseaux neuronaux des couches supérieures du cortex visuel pour montrer comment le cerveau est capable de

maintenir une perception stable de l'apport visuel malgré le mouvement des images. Dans une autre

étude, ils ont découvert que l'activité des neurones dans le cortex visuel des chats regardant un film en noir et blanc est très bien décrite par la machine Boltzmann.

L'une des applications possibles de ce travail est la création de neuroprothèses, par exemple une rétine artificielle. Si vous regardez comment «l'information est formatée dans le cerveau, vous pouvez comprendre comment stimuler le cerveau pour lui faire croire qu'il voit une image», explique Olshausen.

Sezhnowski dit que la compréhension des algorithmes de croissance et de réduction des synapses permettra aux chercheurs de les changer et d'apprendre comment le fonctionnement du réseau neuronal est perturbé. «Ensuite, ils peuvent être comparés aux problèmes bien connus des gens», dit-il. - Presque tous les troubles mentaux peuvent s'expliquer par des problèmes de synapses. Si nous pouvons mieux comprendre les synapses, nous pouvons comprendre comment le cerveau fonctionne normalement, comment il traite les informations, comment il apprend et ce qui ne va pas si, par exemple, vous développez la schizophrénie. »

L'approche de l'étude du cerveau à l'aide de réseaux de neurones contraste fortement avec l'approche du

Human Brain Project . Il s'agit du plan annoncé par le neuroscientifique suisse Henry Marcram pour créer une simulation précise du cerveau humain à l'aide d'un superordinateur. Contrairement à l'approche de Hinton, qui commence par un modèle grandement simplifié et suit le chemin de la complication progressive, Markram souhaite inclure immédiatement la plus grande quantité possible de données, jusqu'aux molécules individuelles, et espère qu'en conséquence, il aura une fonctionnalité et une conscience complètes.

Le projet a reçu un financement de 1,3 milliard de dollars de la Commission européenne, mais Hinton pense que cette méga-simulation échouera, coincée dans trop de pièces mobiles que personne ne comprend encore.

De plus, Hinton ne croit pas que le cerveau ne peut être compris que par ses images. Ces données devraient être utilisées pour créer et affiner des algorithmes. «Une réflexion théorique et des recherches sur l’espace des algorithmes d’apprentissage sont nécessaires pour créer une théorie comme celle-ci», dit la machine de Boltzmann. La prochaine étape pour Hinton est le développement d'algorithmes pour former encore plus de réseaux neuronaux cérébraux, tels que les synapses connectent les neurones au sein d'une couche, et pas seulement entre différentes couches. «L'objectif principal est de comprendre les avantages qui peuvent être obtenus en compliquant les calculs à chaque étape», dit-il.

L'hypothèse est que plus de connexions conduiront à des boucles dorsales plus fortes, ce qui, selon Olshausen, aidera très probablement le cerveau à «remplir les détails manquants». Les couches supérieures interfèrent avec le travail des neurones des couches inférieures traitant des informations partielles. «Tout cela est étroitement lié à la conscience», dit-il.

Le cerveau humain est encore beaucoup plus complexe que n'importe quel modèle. Il est plus grand, plus dense, plus efficace, il a plus d'interconnexions et de neurones complexes - et il fonctionne simultanément avec plusieurs algorithmes. Olshausen suggère que nous comprenons environ 15% de l'activité du cortex visuel. Bien que les modèles avancent, les neurosciences sont toujours "similaires à la physique avant Newton", dit-il. Néanmoins, il est convaincu que le processus de travail sur la base de ces algorithmes sera un jour capable d'expliquer l'énigme principale du cerveau - comment les données des organes sensoriels sont transformées en un sens subjectif de la réalité. La conscience, dit Olshausen, "est quelque chose qui émerge de la réalité, une machine Boltzmann très complexe."