Ce qui peut être appelé IA et ce qui ne peut pas l'être - dans un sens, dépend de la définition. On ne peut nier qu'AlphaGo - une IA qui joue, développée par l'équipe Google DeepMind et vaincu le champion du monde - ainsi que des systèmes similaires avec une formation approfondie au cours des dernières années ont été en mesure de résoudre des problèmes de calcul assez complexes. Mais nous mèneront-ils à une véritable IA complète, à une intelligence généralisée, ou OI? À peine - et voici pourquoi.

L'une des principales caractéristiques de l'interface utilisateur que vous devez gérer lors de sa création est qu'elle doit être en mesure de traiter de manière indépendante avec le monde extérieur et de développer sa propre compréhension interne de tout ce qu'elle rencontre, entend, dit ou fait. Sinon, vous vous retrouverez entre les mains de programmes d'IA modernes, dont la signification a été définie par le développeur de l'application. L'IA, en fait, ne comprend pas ce qui se passe et son domaine de spécialisation est très étroit.

Le problème de la signification est peut-être la tâche la plus fondamentale de l'IA, et il n'a pas encore été résolu. L'une des premières personnes à l'exprimer fut le scientifique cognitif Stevan Harnad, qui a écrit en 1990 l'ouvrage «Le problème de la correspondance des symboles». Même si vous ne croyez pas que nous manipulons des symboles, la tâche demeure: comparer la représentation existant au sein du système avec le monde réel.

Pour les détails, nous notons que la tâche de compréhension nous amène à quatre sous-tâches:

1. Comment structurer les informations qu'une personne (personne ou IA) reçoit du monde extérieur?

2. Comment connecter cette information structurée avec le monde, c'est-à-dire comment construire une compréhension du monde par une personne?

3. Comment synchroniser cette compréhension avec d'autres personnalités? (Sinon, la communication sera impossible et l'intellect se révélera inexplicable et isolé).

4. Pourquoi une personne fait-elle quelque chose? Comment démarrer tout ce mouvement?

Le premier problème, la structuration, est bien résolu grâce à l'apprentissage en profondeur et à des algorithmes de formation similaires qui ne nécessitent pas de supervision - il est, par exemple, utilisé dans AlphaGo. Dans ce domaine, nous avons réalisé des succès importants, notamment grâce à la récente augmentation de la puissance de calcul et à l'utilisation de GPU, qui parallèlement particulièrement bien le traitement de l'information. Ces systèmes fonctionnent en prenant un signal excessivement redondant, exprimé dans un espace multidimensionnel, et en le réduisant à des signaux de plus petites dimensions, tout en minimisant la perte d'informations. En d'autres termes, ils captent une partie importante du signal du point de vue du traitement de l'information.

Le deuxième problème, celui de la connexion de l'information avec le monde réel, c'est-à-dire la création de la «compréhension», est directement lié à la robotisation. Pour interagir avec le monde, vous avez besoin d'un corps et pour établir cette connexion, vous devez interagir avec le monde. Par conséquent, je soutiens souvent que sans robotisation, il n'y a pas d'IA (bien qu'il existe d'excellents robots sans IA, mais c'est une autre histoire). C'est ce qu'on appelle souvent le «problème de l'incarnation», et la plupart des chercheurs en IA conviennent que l'intelligence et l'incarnation sont étroitement liées. Différentes formes d'intelligence existent dans différents corps, qui peuvent être facilement vues des animaux.

Tout commence par des choses aussi simples que la recherche de sens dans vos propres parties du corps et comment les contrôler pour obtenir l'effet souhaité dans le monde visible, comment la sensation d'espace, de distance, de couleur, etc. est construite. Dans ce domaine, des recherches détaillées ont été menées par un scientifique tel que J. Kevin O'Regan, connu pour sa «théorie sensorimotrice de la conscience». Mais ce n'est que la première étape, car il faudra alors construire de plus en plus de concepts abstraits à partir de ces structures sensorimotrices mondaines. Nous n'avons pas encore atteint ce stade, mais des recherches sur ce sujet sont déjà en cours.

Le troisième problème est la question de l'origine de la culture. Chez certains animaux, les formes de culture les plus simples peuvent être tracées et même des capacités transmises de génération en génération, mais dans un volume très limité, et seuls les humains ont atteint le seuil de croissance exponentielle des connaissances acquises que nous appelons culture. La culture est un catalyseur pour l'intelligence, et l'IA qui n'a pas la capacité d'interagir culturellement n'aura qu'un intérêt académique.

Mais la culture ne peut pas être entrée manuellement dans la machine sous forme de code. Cela devrait être le résultat d'un processus d'apprentissage. La meilleure façon de chercher des moyens de comprendre ce processus est la

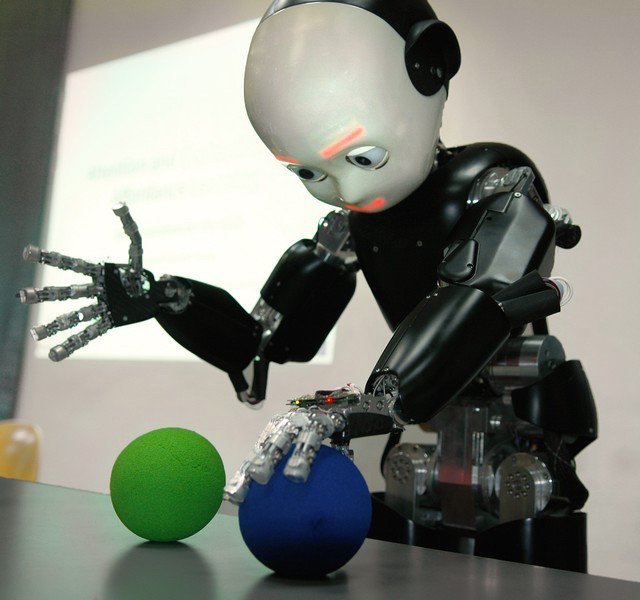

psychologie du développement . Les travaux sur ce sujet ont été réalisés par Jean Piaget et Michael Tomasello, qui ont étudié le processus d'acquisition des connaissances culturelles par les enfants. Cette approche a engendré une nouvelle discipline de la robotique, le «développement robotique», en prenant un enfant comme modèle (comme c'est le cas avec le robot iCub dans l'illustration).

En outre, cette question est étroitement liée à l'étude du processus d'apprentissage des langues, et c'est l'un des sujets que j'étudie moi-même. Le travail de personnes comme Luc Steels et d'autres a montré que le processus d'acquisition d'une langue peut être comparé à l'évolution: une personne crée de nouveaux concepts en interagissant avec le monde, en les utilisant pour communiquer avec d'autres personnalités et en sélectionnant des structures qui aident à communiquer plus efficacement que d'autres (principalement pour atteindre des objectifs communs). Après des centaines d'essais et d'erreurs, comme dans le cas de l'évolution biologique, le système génère le meilleur concept et sa traduction syntaxique / grammaticale.

Ce processus a été testé expérimentalement et il est étonnamment similaire à la façon dont les langues naturelles évoluent et se développent. Il est également responsable de l'apprentissage instantané, lorsqu'une personne perçoit le concept immédiatement - de telles choses ne sont pas en mesure d'expliquer des modèles basés sur des statistiques comme l'apprentissage en profondeur. Aujourd'hui, plusieurs laboratoires de recherche utilisant cette approche tentent d'aller plus loin sur le chemin de la perception de la grammaire, des gestes et des phénomènes culturels plus complexes. Plus précisément, il s'agit du AI Lab, fondé par moi dans la société française engagée dans la robotique Aldebaran. Maintenant, il fait partie du groupe SoftBank - ils ont créé les robots

Nao ,

Romeo et

Pepper (ci-dessous).

Enfin, le quatrième problème est confronté à une «motivation intrinsèque». Pourquoi une personne fait-elle quelque chose, et pas seulement se repose-t-elle? Les conditions de survie ne suffisent pas à expliquer le comportement humain. Même si vous nourrissez et assurez la sécurité d'une personne, elle ne reste pas assise à attendre le retour de la faim. Les gens étudient l'environnement, essaient de faire quelque chose et sont motivés par une forme de curiosité inhérente. Le chercheur Pierre-Yves Oudeyer a montré que l'expression mathématique la plus simple de la curiosité sous la forme du désir d'une personne de maximiser la vitesse d'apprentissage est suffisante pour produire un comportement étonnamment complexe et inattendu (voir, par exemple, une expérience avec un «terrain de jeu» menée dans Sony CSL).

Apparemment, quelque chose de similaire est nécessaire au système pour y induire un désir de passer par les trois étapes précédentes: structurer l'information sur le monde, la combiner avec votre corps et créer des concepts significatifs, puis choisir la plus efficace du point de vue de la communication pour créer une articulation une culture dans laquelle la coopération est possible. De mon point de vue, c'est exactement ce qu'est le programme OI.

Je répète que le développement rapide de l'apprentissage en profondeur et le succès récent d'une telle IA dans des jeux comme go sont de très bonnes nouvelles, car cette IA trouvera de nombreux points d'application dans la recherche médicale, l'industrie, la conservation de l'environnement et d'autres domaines. Mais ce n'est qu'une partie du problème, que j'ai essayé d'expliquer ici. Je ne crois pas que le deep learning soit une panacée qui nous mènera à une véritable IA, au sens d'une machine capable d'apprendre à vivre en paix, d'interagir naturellement avec nous, de comprendre la complexité de nos émotions et des distorsions culturelles, et finalement de nous aider à faire du monde un meilleur endroit.