Lawrence Kraus est physicien théoricien, cosmologiste, directeur du projet Origins, fondateur de la School of Earth and Space Research de l'Arizona State University. Il est l'auteur de livres à succès comme The Universe from Nothing et The Physics of Star Trek. Traduction d'un extrait de son futur livre, "La plus grande histoire racontée jusqu'à présent: pourquoi sommes-nous ici?" [La plus belle histoire jamais racontée - Jusqu'à présent: pourquoi sommes-nous ici?].

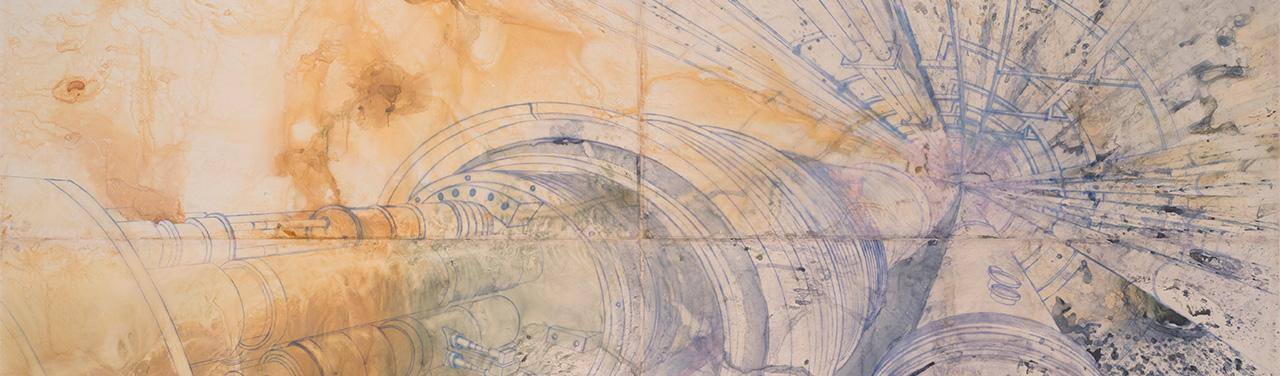

Avant la découverte de la particule de Higgs en 2012, les experts en physique des particules rêvaient de deux types de cauchemars. La première est qu'ils ne trouveront rien au Grand collisionneur de hadrons (LHC). Dans ce cas, il s'agirait du dernier accélérateur majeur construit pour sonder la structure fondamentale de l'univers. La seconde est qu'ils trouveront la particule de Higgs prédite par le physicien théoricien Peter Higgs en 1964 sur le LHC ... et rien de plus.

Chaque découverte d'un niveau de réalité nous montre les niveaux suivants. Par conséquent, chaque découverte importante en science nous laisse généralement plus de questions que de réponses. Mais ensuite, cela nous donne généralement au moins un diagramme de la voie à suivre, nous aidant à chercher des réponses à de nouvelles questions. La découverte réussie de la particule de Higgs et la confirmation de l'existence dans l'espace d'un fond invisible du champ de Higgs (dans le monde quantique, chaque particule, telle qu'une particule de Higgs, est associée à un champ), est devenue une confirmation de poids des audacieuses découvertes scientifiques du 20e siècle.

Mais

les mots

de Sheldon Lee Glashow n'ont pas perdu de leur pertinence: la particule de Higgs est similaire à un égout. Elle cache tous les détails désordonnés dont nous ne voulons pas parler. Le champ de Higgs interagit avec la plupart des particules élémentaires lorsqu'elles se déplacent dans l'espace, et crée une force de résistance qui ralentit leur mouvement et leur donne l'apparence d'une masse. Par conséquent, les masses de particules élémentaires mesurées par nous et rendant possible notre monde familier sont une sorte d'illusion, un accident de notre perception.

Cette idée peut sembler élégante, mais en fait c'est un ajout spécial au modèle standard de physique - expliquant trois des quatre forces connues et comment elles interagissent avec la matière. Il a été ajouté à la théorie pour satisfaire aux exigences nécessaires à une description précise de notre monde. Mais la théorie elle-même ne l'exige pas. L'univers pourrait facilement exister avec des particules sans masse et une interaction faible à longue distance (l'une des quatre interactions - le reste sera une force forte, électromagnétique et gravitationnelle). Ce ne serait tout simplement pas nous et nos questions. De plus, la physique exacte du modèle de Higgs n'est pas définie uniquement à l'intérieur du modèle standard. La particule pourrait être 20 fois plus lourde ou 100 fois plus légère.

Alors pourquoi existe-t-il même? Et pourquoi a-t-elle une telle masse? (Étant donné que lorsqu'un scientifique pose la question "Pourquoi?", Il signifie en fait "Comment?") S'il n'y avait pas de particule de Higgs, il n'y aurait pas un tel monde que nous observons - mais cela ne peut évidemment pas être appelé une explication. Ou est-ce possible? Comprendre les bases de la physique de Higgs signifie comprendre comment nous sommes nous-mêmes apparus. Lorsque nous demandons: «Pourquoi sommes-nous ici?», En fait, nous demandons: «Pourquoi les Higgs sont-ils ici?» Et le modèle standard ne peut pas répondre à cette question.

Il y a quelques indices qui viennent d'une combinaison de théorie et d'expérience. Peu de temps après avoir établi la structure claire du modèle standard, en 1974, et bien avant la confirmation expérimentale de ses détails au cours de la prochaine décennie, deux groupes différents de physiciens de Harvard, dans lesquels travaillaient Sheldon Lee Glashow et

Stephen Weinberg , ont remarqué quelque chose d'intéressant. Glashow, avec

Howard Georgie , a fait ce qu'il savait le mieux: rechercher des modèles dans les particules et interactions existantes, et de nouvelles possibilités en utilisant la théorie mathématique des groupes.

Dans le modèle standard, les interactions faibles et électromagnétiques sont combinées aux hautes énergies en une seule force, que les physiciens appellent «électrofaibles». Cela signifie que les mêmes mathématiques contrôlent l'interaction faible et électromagnétique, elles obéissent toutes les deux aux mêmes symétries, et ces deux forces sont des réflexions différentes de la même théorie unifiée. Mais la symétrie est "spontanément brisée" par l'interaction du champ de Higgs avec des particules qui transfèrent une faible interaction, mais pas avec des particules qui transportent l'électromagnétique. Cette propriété de la nature conduit au fait que ces deux interactions semblent séparées et différentes sur les échelles disponibles pour nos mesures - tandis que l'interaction faible fonctionne à courte distance et l'interaction électromagnétique à longue distance.

Georges et Glashow ont essayé d'élargir cette idée et de relier une interaction forte avec eux, et ont constaté que toutes les particules connues et trois interactions sans gravité s'intègrent naturellement dans une structure fondamentalement symétrique. Ils ont estimé que cette symétrie peut se dégrader spontanément à une certaine échelle d'énergie ultra-élevée (et à une courte distance), ce qui dépasse les capacités des expériences modernes, et donner lieu à deux symétries distinctes - les interactions fortes et électrofaibles. En conséquence, à des énergies plus faibles et à de grandes distances, la symétrie électrofaibles est détruite, divisant l'interaction électrofaibles en un faible, agissant à de courtes distances, et électromagnétique, agissant à long.

Ils ont modestement appelé une telle théorie la Grande Théorie de l'Unification (TVO).

À la même époque, Weinberg et Georgie, ainsi que

Helen Quinn, ont remarqué quelque chose d'intéressant, développant le travail de Frank Wilchek, David Gross et David Politzer. Si à de petites distances l'interaction forte devient plus faible, alors l'électromagnétique et le faible deviennent plus forts.

Il n'était pas nécessaire d'avoir sept travées dans le front pour savoir si la force de trois interactions différentes à petite échelle coïncidait. Après avoir calculé, ils ont trouvé (avec la précision avec laquelle les interactions ont été mesurées) qu'une telle union est possible, mais seulement à des distances de 15 ordres de grandeur plus petites que la taille du proton.

Si TVO était celui proposé par Howard Georgie et Glashow - alors c'était une bonne nouvelle, car si toutes les particules que nous observons dans la nature sont combinées de cette manière, alors il doit y avoir de nouvelles particules (

bosons d'étalonnage ) qui fournissent une connexion entre les quarks (dont les protons et neutrons) et des électrons avec des neutrinos. Et cela signifierait que les protons peuvent se désintégrer en particules plus légères, ce que nous pouvons observer en principe. Comme l'écrivait Glashow, «les diamants ne sont pas éternels».

Et même alors, on savait que la durée de vie du proton est extrêmement longue. Non seulement parce que nous existons encore 14 milliards d'années après le Big Bang, mais aussi parce que nous ne mourons pas du cancer dans l'enfance. Si la durée de vie moyenne des protons était inférieure à un milliard de milliards d'années, alors dans l'enfance, suffisamment de protons se désintégreraient dans notre corps pour que leur rayonnement nous tue. En mécanique quantique, tous les processus sont probabilistes. Si le proton moyen vit un milliard de milliards d'années, et si vous avez un milliard de milliards de protons, l'un d'eux se désintègre en moyenne chaque année. Et dans

notre corps, bien plus d'un milliard de milliards de protons.

Cependant, avec une échelle de distances incroyablement petite et, par conséquent, avec une échelle de masse aussi énorme, associée à une rupture de symétrie spontanée dans TVO, les nouveaux bosons de jauge reçoivent d'énormes masses. Et cela conduirait au fait que les interactions contrôlées par eux se produiraient à de si petites distances qu'elles seraient incroyablement faibles du point de vue des protons et des neutrons. En conséquence, bien que les protons puissent se désintégrer, dans notre cas, avant cela, ils peuvent survivre, peut-être un million de milliards de milliards d'années.

Grâce aux résultats obtenus par Glashow avec Georgie, ainsi que Georges avec Quinn et Weinberg, les attentes d'une grande synthèse étaient dans l'air. Après le succès de la théorie de l'électro-faiblesse, les physiciens des particules étaient ambitieux et croyaient en une unification ultérieure.

Comment savez-vous si ces idées sont vraies? Il était impossible de construire un accélérateur capable de travailler à des énergies un million de milliards de fois supérieures à la masse restante de protons. La circonférence d'une telle machine devrait être comparable à l'orbite de la lune. Et même s'il était possible, à la suite de l'échec du supercollider supraconducteur, aucun gouvernement n'approuverait une telle estimation [Ce collisionneur, également appelé Desertron, devait être construit au Texas dans les années 90, mais en raison de problèmes budgétaires, le projet a été annulé. Il était prévu que sa circonférence soit de 87,1 km. 2 milliards de dollars ont été dépensés pour la construction, et le coût final a été estimé à 12 milliards de dollars - environ. trad.].

Heureusement, il y avait une autre façon - d'utiliser la probabilité décrite par moi, limitant la durée de vie du proton. Si TVO prédit une durée de vie de protons de mille milliards de milliards de milliards d'années, alors vous devez remplir mille milliards de milliards de milliards de protons dans un détecteur, puis en moyenne l'un d'entre eux se désintègre chaque année.

Et où trouver autant de protons? C'est simple: dans 3000 tonnes d'eau.

Tout ce qui était nécessaire pour cela était de placer un réservoir d'eau dans l'obscurité, de s'assurer qu'il n'y avait pas de fond radioactif à cet endroit, de l'entourer de cellules photoélectriques sensibles capables de détecter des éclairs de lumière dans le détecteur, puis d'attendre un an qu'un flash clignote lorsque le proton se désintègre. Cela semble effrayant, mais néanmoins, c'est selon un tel schéma qu'au moins deux grandes usines expérimentales ont été payées et construites - l'une

souterraine profonde dans une mine de sel près du lac Érié (IMB), l'autre

dans une mine de zinc de Kamioka au Japon (Kamiokande). Les mines ont été utilisées pour couper les rayons cosmiques, sur le fond desquels il serait impossible de remarquer la désintégration du proton.

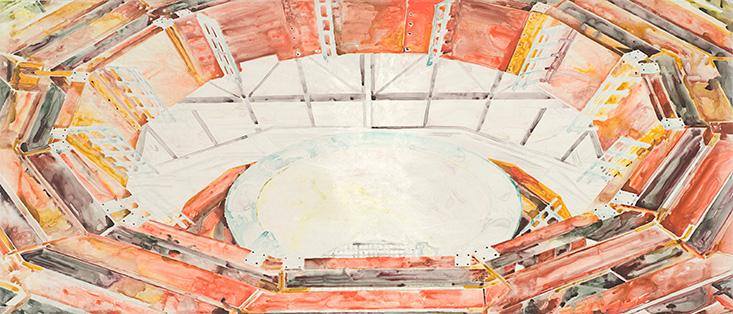

Grand collisionneur de hadrons

Grand collisionneur de hadronsLes deux expériences ont commencé à fonctionner en 1982-1983. Les scientifiques ont été tellement emportés par TVO qu'ils attendaient avec confiance que le signal apparaisse bientôt. Dans ce cas, TVO serait l'aboutissement d'une décennie de formidables développements et découvertes en physique des particules - sans parler du prochain

Nobel pour Glashow , et peut-être même de quelques autres.

Malheureusement, dans ce cas, la nature n'était pas si gentille. Pas un seul signal n'est apparu la première année, ni la deuxième, ni la troisième. Le modèle simple et élégant de Glashow et Georgie a rapidement dû être rejeté. Mais la fièvre TBO avait déjà capturé des scientifiques, et il était difficile de s'en débarrasser. D'autres suggestions ont été faites concernant les théories de l'unification, en raison desquelles la désintégration des protons dépasserait le cadre des expériences actuelles.

Le 23 février 1987, un autre événement s'est produit, démontrant à nouveau un aphorisme quasi universel: chaque nouvelle fenêtre sur l'Univers nous prend par surprise. Ce jour-là, un groupe d'astronomes sur des plaques photographiques accumulées pendant la nuit a découvert l'étoile explosive la plus proche (supernova) de tout ce que nous avons vu au cours des 400 dernières années. Cette étoile, située à 160 000 années-lumière de nous, se trouvait dans le

Grand Nuage de Magellan , une petite galaxie, un satellite de la Voie lactée, que l'on peut voir dans l'hémisphère sud.

Si nos théories sur l'explosion des étoiles sont vraies, la plupart de l'énergie qu'elles émettent devrait prendre la forme d'un neutrino, malgré le fait que la lumière de leur explosion est la plus brillante des feux d'artifice cosmiques (et qu'elles explosent sur une étoile dans une galaxie en 100 ans). Des calculs approximatifs ont montré que les détecteurs d'eau IMB et Kamiokande devaient détecter environ 20 collisions avec des neutrinos. Et lorsque les expérimentateurs de ces détecteurs ont étudié les données de ce jour, IBM a trouvé 8 candidats sur un intervalle de 10 secondes, et sur Kamiokand - 11. Pour la physique des neutrinos, ce n'était qu'une mer de données. L'astrophysique des neutrinos a soudainement mûri. Probablement, 1900 travaux scientifiques de divers physiciens (dont moi-même) étaient basés sur ces 19 événements, qui ont réalisé que cet événement nous ouvrait une fenêtre sans précédent sur les noyaux des étoiles qui explosent et sur le laboratoire non seulement pour l'astrophysique, mais aussi pour la physique des neutrinos.

Poussé par l'idée que les grands détecteurs de désintégration de protons peuvent simultanément devenir des détecteurs astrophysiques de neutrinos, plusieurs groupes de scientifiques ont commencé à construire une nouvelle génération de ces détecteurs à double usage. Le plus grand a été reconstruit dans la mine de Kamioka et surnommé Super Kamiokande - et pour cause. Ce réservoir d'eau géant pesant 50 000 tonnes, entouré de 11 800 photocellules, a fonctionné dans une mine existante, et l'expérience a été réalisée avec une propreté en laboratoire. Cela était nécessaire, car avec un détecteur aussi énorme, il fallait prendre soin non seulement des rayons cosmiques externes, mais aussi des contaminants radioactifs internes qui éclipseraient tous les signaux utiles.

Pendant ce temps, l'intérêt pour les neutrinos astrophysiques était également à son apogée. Le soleil émet des neutrinos à la suite de réactions nucléaires ayant lieu dans son noyau, et pendant 20 ans, le physicien Ray Davis a découvert des neutrinos solaires, mais les événements se sont produits trois fois moins que ce que les meilleurs modèles du Soleil avaient prédit. Un nouveau type de détecteur de neutrinos solaires appelé Sudbury Neutrino Observatory (SNO) a été construit à la mine de Sudbury au Canada.

À ce jour, Super Kamiokande a travaillé de manière presque continue, subissant parfois diverses améliorations, pendant 20 ans. Aucun signal de désintégration de protons et aucune nouvelle supernovae n'ont depuis été observés. Cependant, une observation précise des neutrinos, couplée à des observations supplémentaires sur SNO, a confirmé sans équivoque la réalité de la carence en neutrinos solaires découverte par Ray Davis. Il a été constaté que le déficit n'existe pas en raison de phénomènes astrophysiques se produisant dans le Soleil, mais en raison des propriétés des neutrinos. Il est devenu clair qu'au moins l'un des trois types de neutrinos n'est pas sans masse. Étant donné que les neutrinos ne sont pas inclus dans le modèle standard, il s'agit de la première observation confirmée selon laquelle de nouveaux éléments physiques fonctionnent en dehors du modèle standard et de Higgs.

Des neutrinos de haute énergie bombardent régulièrement la Terre après que des protons de rayons cosmiques de haute énergie sont entrés en collision avec l'atmosphère et ont produit une

large couche d'air de particules subatomiques secondaires, où se trouvent également ces neutrinos. Leurs observations ont montré que le deuxième type de neutrino avait également une masse. Elle est légèrement plus grande que la première, mais bien inférieure à la masse de l'électron. Pour cette observation, les équipes de SNO et Kamiokande ont reçu un prix Nobel en 2015 - une semaine avant que je commence à écrire ce livre. À ce jour, ces allusions séduisantes à la nouvelle physique n'ont pas été expliquées à l'aide de nos théories.

L'absence de désintégration des protons a été une déception, mais pas une surprise totale. Depuis la première proposition de TVO, le paysage de la physique a subi des changements. Des mesures plus précises des valeurs des trois interactions non gravitationnelles, ainsi que des calculs plus complexes des changements de leur amplitude avec la distance, ont montré que si seules les particules du modèle standard existent dans la nature, alors les forces de ces trois interactions ne seront pas combinées sur une seule échelle. Pour que la Grande Unification se produise, une nouvelle physique devra exister, située à une échelle d'énergie qui surpasse tout ce que nous avons observé jusqu'à présent. Et la présence de nouvelles particules changerait non seulement l'échelle d'énergie pour combiner les trois interactions, mais augmenterait également l'échelle pour le TBO, réduisant ainsi le taux de désintégration du proton - et augmentant leur durée de vie au-delà de millions de milliards de milliards d'années.

Grand collisionneur de hadrons

Grand collisionneur de hadronsParallèlement à ces événements, les théoriciens ont activement utilisé de nouveaux outils mathématiques pour étudier un nouveau type probable de symétrie, qu'ils ont commencé à appeler supersymétrie. Cette symétrie fondamentale diffère des autres qui lui sont connues en ce qu'elle lie deux types de particules différents - les fermions (particules avec un spin demi-entier) et les bosons (particules avec un spin entier). Et l'essentiel est que si une telle symétrie est observée dans la nature, alors pour chaque particule connue dans le modèle standard, il doit y avoir au moins une nouvelle particule. Pour chaque nouveau boson, un fermion doit exister. Pour chaque fermion, un boson.

Puisque nous n'observons pas ces particules, cette symétrie ne peut pas se manifester au niveau de l'univers qui nous est accessible, et doit donc être brisée - ce qui signifie que les nouvelles particules doivent avoir des masses suffisamment grandes pour ne pas encore être trouvées dans les accélérateurs existants.

Qu'est-ce qui est si attrayant en symétrie qui double soudainement le nombre de particules dans la nature quand il n'y a aucune preuve de leur existence? Pour la plupart, elle est séduite par la Grande Unification. Puisque si TVO existe sur une échelle de masse de 15 à 16 ordres de magnitude plus grande, les masses de repos de protons, alors il est 13 ordres de grandeur plus grand que les échelles auxquelles la symétrie électrofaible est brisée. La question est de savoir comment et pourquoi dans les lois fondamentales de la nature il y a un si grand écart d'échelle. En particulier, si Higgs est vraiment la dernière particule du modèle standard, alors la question se pose: pourquoi l'échelle d'énergie de rupture de symétrie Higgs est-elle de 13 ordres de grandeur plus petite que l'échelle de rupture de symétrie d'un nouveau champ qui brise la symétrie DEUX en interactions séparées?

Et le problème est encore pire qu'il n'y paraît.

Si nous considérons les effets des particules virtuelles (apparaissant et disparaissant si rapidement que leur existence ne peut être confirmée qu'indirectement), y compris les particules d'une masse arbitrairement grande (telles que les particules de jauge du supposé TBT), il devient clair que la masse et l'échelle de la rupture de symétrie de Higgs augmentent approchant la grande échelle de TVO. D'où le soi-disant le problème du naturel . Techniquement parlant, l'existence d'une énorme hiérarchie d'échelles n'est pas naturelle , de celles sur lesquelles la particule de Higgs rompt la symétrie électrofaible, à celles sur lesquelles la symétrie TVO est brisée par un nouveau champ scalaire, quel qu'il soit.Le physicien mathématique Edwart Whitten a écrit dans son ouvrage historique de 1981 que la supersymétrie a une propriété spéciale. Il peut réduire l'effet des particules virtuelles de masse et d'énergie arbitrairement grandes sur les propriétés du monde aux échelles disponibles pour nos observations. Puisque les fermions virtuels et les bosons virtuels de la même masse conduisent à des corrections quantiques identiques, à part le signe, alors si chaque boson correspond à un fermion de la même masse, alors les effets quantiques des particules virtuelles sont mutuellement annihilés. Et cela signifie que l'effet des particules virtuelles d'une masse et d'une énergie arbitrairement grandes sur les propriétés du monde aux échelles disponibles pour nos observations disparaît complètement.Si la supersymétrie elle-même est brisée (comme il se doit, sinon tous les partenaires supersymétriques de la matière ordinaire auraient la même masse que les particules ordinaires, et nous les aurions découvertes il y a longtemps), alors les corrections quantiques ne sont pas détruites. Ils conduisent à des ajouts aux masses à des échelles comparables à celle à laquelle la supersymétrie est rompue. S'ils étaient comparables à l'échelle de la violation de la symétrie électrofaible, cela expliquerait l'échelle de la masse de Higgs.Cela signifie également que l'on peut s'attendre à l'observation d'un tas de nouvelles particules - partenaires supersymétriques de la matière ordinaire - à l'échelle que le LHC sonde actuellement.Cela résoudrait le problème de la naturalité, car cela protégerait les masses du boson de Higgs des corrections quantiques, ce qui les pousserait à l'échelle énergétique du TVO. La supersymétrie peut permettre l'existence d'une grande hiérarchie «naturelle» d'énergie et de masse, divisant l'échelle électrofaible et l'échelle du TVO.Le fait que la supersymétrie puisse en principe résoudre le problème de la hiérarchie a accru son attrait pour les physiciens. Les théoriciens ont commencé à explorer des modèles réalistes, notamment la rupture de la supersymétrie et d'autres conséquences de cette idée. Après cela, la «valeur d'échange» de la supersymétrie a battu tous les records. Puisque, si nous incluons la possibilité de rupture spontanée de la supersymétrie dans les calculs des changements dans trois interactions non gravitationnelles en fonction de la distance, il s'avère que la force de ces trois interactions converge naturellement soudainement vers une échelle de petites distances. TVO est de nouveau opérationnel!Les modèles dont la supersymétrie est brisée ont une autre caractéristique intéressante. Bien avant la découverte du quark supérieur, il a été démontré que si le quark supérieur est lourd, alors grâce à l'interaction avec d'autres partenaires supersymétriques, il peut contribuer à des corrections quantiques des propriétés de la particule de Higgs, ce qui entraînera une modification du champ de Higgs. Si la Grande Unification se produit à une échelle beaucoup plus grande d'énergies, alors le champ de Higgs devrait former un fond cohérent dans tout l'espace au niveau d'énergie auquel les mesures de courant ont lieu. En bref, l'échelle d'énergie de la rupture de symétrie électro-faible peut naturellement se produire dans une théorie dans laquelle VO se produit à une échelle beaucoup plus grande. Et quand le quark supérieur a été découvert et établi qu'il était vraiment lourd,cela a ajouté à l'attrait de la possibilité que la rupture de la supersymétrie soit responsable des échelles d'énergie observées de l'interaction faible.Mais tout cela a un prix. Pour qu'une théorie fonctionne, il doit y avoir deux bosons de Higgs, pas un. De plus, dans un accélérateur comme le LHC, il serait nécessaire de trouver de nouvelles particules supersymétriques - il est capable de sonder la nouvelle physique dans la région des échelles électrofaibles. Et enfin, ce qui semblait être une restriction trop stricte pendant un certain temps - le plus léger des Higgs ne pouvait pas être trop lourd, ou ce mécanisme ne fonctionnerait pas du tout.Alors que la recherche de Higgs se poursuivait sans grand succès, les accélérateurs se sont constamment rapprochés de la limite supérieure théorique de la masse lumineuse de Higgs dans les théories supersymétriques. Cette valeur était d'environ 135 masses de protons, et les détails dépendaient déjà du modèle spécifique. Si Higgs n'était pas trouvé sur cette échelle, cela signifierait que tout le battage médiatique autour de la supersymétrie serait toujours du battage médiatique.Mais cela s'est avéré différemment. Les Higgs trouvés sur le LHC ont une masse de 125 fois le proton. Il est possible que nous atteignions une grande synthèse.À ce jour, la réponse n'est pas claire. Les signes de la présence de nouvelles particules supersymétriques, s'ils existaient, auraient dû être si clairement visibles sur le LHC que certains physiciens pensaient que les chances de découvrir la supersymétrie étaient beaucoup plus susceptibles de trouver Higgs. Mais tout s'est mal passé. Après trois ans de fonctionnement, aucun signe de supersymétrie n'est visible. La situation devient inconfortable. Les restrictions plus faibles imposées aux masses des partenaires supersymétriques de la matière ordinaire augmentent tout le temps. S'ils montent trop haut, l'échelle de rupture de supersymétrie ne sera plus proche de l'échelle d'électro-faiblesse et de nombreuses propriétés de rupture de supersymétrie attrayantes qui permettent de résoudre le problème de hiérarchie s'évaporeront simplement.Mais l'espoir demeure et le LHC est remis en marche, déjà à une énergie plus élevée. Il est possible que des particules supersymétriques soient bientôt détectées. Leur détection conduira à un autre résultat important. L'un des plus grands mystères de la cosmologie est la nature de la matière noire, qui semble dominer toutes les galaxies que nous voyons. Elle existe tellement qu'elle ne peut pas être constituée des mêmes particules que la matière normale. S'il était constitué de particules normales, alors, par exemple, les prédictions sur l'abondance d'éléments légers tels que l'hélium obtenus pendant le Big Bang ne seraient pas cohérentes avec les observations. Par conséquent, les physiciens sont assez convaincus que la matière noire consiste en un nouveau type de particules élémentaires. Mais lequel?Le partenaire supersymétrique le plus léger de la matière ordinaire dans la plupart des modèles est complètement stable et ses propriétés ressemblent beaucoup aux neutrinos. Il interagirait faiblement et serait électriquement neutre, de sorte qu'il n'absorberait ni n'émettrait de lumière. De plus, les calculs d'il y a 30 ans, dans lesquels j'étais également engagé, ont montré que l'abondance résiduelle de la particule supersymétrique la plus légère restant après le Big Bang se révélerait naturellement telle qu'elle correspondrait à la dominance en masse de la matière noire dans les galaxies.Dans ce cas, notre galaxie aurait un halo de particules de matière noire sifflant à travers ses parties, y compris la pièce dans laquelle vous la lisez. Comme beaucoup d'entre nous l'ont compris depuis longtemps, cela signifie que vous pouvez développer des détecteurs souterrains sensibles, similaires, au moins en substance, aux détecteurs de neutrinos existants, et détecter directement les particules de matière noire. Une douzaine d'excellentes expériences à travers le monde essaient de faire exactement cela. Mais jusqu'à présent, personne n'a rien trouvé.Par conséquent, nous vivons maintenant dans des moments meilleurs ou pires. Il y a une course entre le LHC et les détecteurs souterrains de matière noire pour que le droit soit le premier à découvrir sa nature. Si un groupe annonce sa découverte, il inaugurera la découverte d'un tout nouveau monde de découvertes, conduisant potentiellement à une compréhension de TVO elle-même. Et s'il n'y a pas de découvertes dans les années à venir, il sera possible d'exclure l'option d'origine supersymétrique de la matière noire - et, en général, toute l'idée de la supersymétrie comme solution au problème de la hiérarchie. Dans ce cas, vous devrez retourner au conseil d'administration, cependant, en l'absence de tout signal du LHC, nous ne comprendrons pas dans quelle direction nous devrions nous diriger afin de développer un nouveau modèle de la nature.Tout est devenu beaucoup plus intéressant lorsque le LHC a découvert un signal possible nous promettant une nouvelle particule six fois plus lourde que le Higgs. Les caractéristiques de cette particule ne correspondent aux caractéristiques attendues d'aucun des partenaires supersymétriques de la matière ordinaire. Habituellement, lors du traitement d'un grand tableau de données, les indices les plus séduisants des signaux disparaissent et six mois après l'apparition de ce signal et du traitement des données, il disparaissait. Sinon, il pourrait changer toute notre idée de TVO et de symétrie électro-faible, faisant allusion à l'existence d'une nouvelle interaction fondamentale et d'un nouvel ensemble de particules qui lui sont associées. Mais, même si elle a conduit à l'apparition d'un travail scientifique théorique plein d'espoir, la nature a décidé à sa manière.Mais une équipe de physiciens ne s'inquiète pas de l'absence d'une détection expérimentale claire ou d'une confirmation de la supersymétrie depuis longtemps et encore. La beauté mathématique de la supersymétrie en 1984 a inspiré les scientifiques à ressusciter une idée qui somnole depuis les années 1960. Ensuite, Yoichiro Nambu et ses collègues ont essayé de comprendre une forte interaction, la présentant comme des signaux de type chaîne reliant les quarks. Et lorsque la supersymétrie a été incluse dans la théorie des cordes quantiques pour obtenir ce qui est devenu connu sous le nom de théorie des supercordes, des résultats mathématiques étonnamment beaux ont commencé à apparaître. Parmi eux se trouve la possibilité de combiner non seulement trois interactions non gravitationnelles, mais en général les quatre forces connues dans la nature dans une théorie de champ quantique cohérente.Cependant, cette théorie nécessite l'existence d'un tas de dimensions supplémentaires d'espace-temps, que personne n'a encore observées. De plus, la théorie ne fait aucune prédiction qui pourrait être vérifiée au niveau expérimental actuel. De plus, il est devenu si compliqué récemment qu'il semble maintenant que les cordes elles-mêmes ne sont plus les variables dynamiques centrales de cette théorie.Mais cela n'a pas freiné l'enthousiasme des adeptes les plus zélés, dévoués et extrêmement talentueux de la théorie des supercordes, maintenant connus sous le nom de M-théories, qui y travaillent depuis 30 ans. Des déclarations d'énormes succès apparaissent périodiquement, mais jusqu'à présent, la théorie M manque d'un élément clé qui a assuré le triomphe d'une entreprise scientifique telle que le modèle standard: la capacité d'entrer en contact avec le monde que nous pouvons mesurer, de résoudre des mystères inexplicables par d'autres méthodes et de fournir des éléments fondamentaux explications de pourquoi notre monde est ce qu'il est. Cela ne signifie pas que la théorie M est erronée, mais jusqu'à présent, elle ne représente que le raisonnement, bien qu'elle ait un bon motif.Si vous suivez les leçons de l'histoire, il devient clair que la plupart des théories physiques avancées se sont révélées fausses. Sinon, n'importe qui pourrait s'engager dans la physique théorique. Il a fallu plusieurs siècles, et si l'on prend en compte la science des Grecs anciens, puis plusieurs millénaires, la méthode des essais et erreurs, qui a conduit à l'émergence du modèle standard.Et nous y voilà. De nouvelles révélations expérimentales nous attendent-elles prochainement, qui pourront confirmer ou réfuter les plus grands arguments de la physique théorique? Ou sommes-nous au bord du désert, et la nature ne nous donnera pas d'indices sur le sens de la recherche de réponses aux secrets de l'espace? Nous découvrirons, et en tout cas, nous devrons vivre avec une nouvelle réalité.

Leur détection conduira à un autre résultat important. L'un des plus grands mystères de la cosmologie est la nature de la matière noire, qui semble dominer toutes les galaxies que nous voyons. Elle existe tellement qu'elle ne peut pas être constituée des mêmes particules que la matière normale. S'il était constitué de particules normales, alors, par exemple, les prédictions sur l'abondance d'éléments légers tels que l'hélium obtenus pendant le Big Bang ne seraient pas cohérentes avec les observations. Par conséquent, les physiciens sont assez convaincus que la matière noire consiste en un nouveau type de particules élémentaires. Mais lequel?Le partenaire supersymétrique le plus léger de la matière ordinaire dans la plupart des modèles est complètement stable et ses propriétés ressemblent beaucoup aux neutrinos. Il interagirait faiblement et serait électriquement neutre, de sorte qu'il n'absorberait ni n'émettrait de lumière. De plus, les calculs d'il y a 30 ans, dans lesquels j'étais également engagé, ont montré que l'abondance résiduelle de la particule supersymétrique la plus légère restant après le Big Bang se révélerait naturellement telle qu'elle correspondrait à la dominance en masse de la matière noire dans les galaxies.Dans ce cas, notre galaxie aurait un halo de particules de matière noire sifflant à travers ses parties, y compris la pièce dans laquelle vous la lisez. Comme beaucoup d'entre nous l'ont compris depuis longtemps, cela signifie que vous pouvez développer des détecteurs souterrains sensibles, similaires, au moins en substance, aux détecteurs de neutrinos existants, et détecter directement les particules de matière noire. Une douzaine d'excellentes expériences à travers le monde essaient de faire exactement cela. Mais jusqu'à présent, personne n'a rien trouvé.Par conséquent, nous vivons maintenant dans des moments meilleurs ou pires. Il y a une course entre le LHC et les détecteurs souterrains de matière noire pour que le droit soit le premier à découvrir sa nature. Si un groupe annonce sa découverte, il inaugurera la découverte d'un tout nouveau monde de découvertes, conduisant potentiellement à une compréhension de TVO elle-même. Et s'il n'y a pas de découvertes dans les années à venir, il sera possible d'exclure l'option d'origine supersymétrique de la matière noire - et, en général, toute l'idée de la supersymétrie comme solution au problème de la hiérarchie. Dans ce cas, vous devrez retourner au conseil d'administration, cependant, en l'absence de tout signal du LHC, nous ne comprendrons pas dans quelle direction nous devrions nous diriger afin de développer un nouveau modèle de la nature.Tout est devenu beaucoup plus intéressant lorsque le LHC a découvert un signal possible nous promettant une nouvelle particule six fois plus lourde que le Higgs. Les caractéristiques de cette particule ne correspondent aux caractéristiques attendues d'aucun des partenaires supersymétriques de la matière ordinaire. Habituellement, lors du traitement d'un grand tableau de données, les indices les plus séduisants des signaux disparaissent et six mois après l'apparition de ce signal et du traitement des données, il disparaissait. Sinon, il pourrait changer toute notre idée de TVO et de symétrie électro-faible, faisant allusion à l'existence d'une nouvelle interaction fondamentale et d'un nouvel ensemble de particules qui lui sont associées. Mais, même si elle a conduit à l'apparition d'un travail scientifique théorique plein d'espoir, la nature a décidé à sa manière.Mais une équipe de physiciens ne s'inquiète pas de l'absence d'une détection expérimentale claire ou d'une confirmation de la supersymétrie depuis longtemps et encore. La beauté mathématique de la supersymétrie en 1984 a inspiré les scientifiques à ressusciter une idée qui somnole depuis les années 1960. Ensuite, Yoichiro Nambu et ses collègues ont essayé de comprendre une forte interaction, la présentant comme des signaux de type chaîne reliant les quarks. Et lorsque la supersymétrie a été incluse dans la théorie des cordes quantiques pour obtenir ce qui est devenu connu sous le nom de théorie des supercordes, des résultats mathématiques étonnamment beaux ont commencé à apparaître. Parmi eux se trouve la possibilité de combiner non seulement trois interactions non gravitationnelles, mais en général les quatre forces connues dans la nature dans une théorie de champ quantique cohérente.Cependant, cette théorie nécessite l'existence d'un tas de dimensions supplémentaires d'espace-temps, que personne n'a encore observées. De plus, la théorie ne fait aucune prédiction qui pourrait être vérifiée au niveau expérimental actuel. De plus, il est devenu si compliqué récemment qu'il semble maintenant que les cordes elles-mêmes ne sont plus les variables dynamiques centrales de cette théorie.Mais cela n'a pas freiné l'enthousiasme des adeptes les plus zélés, dévoués et extrêmement talentueux de la théorie des supercordes, maintenant connus sous le nom de M-théories, qui y travaillent depuis 30 ans. Des déclarations d'énormes succès apparaissent périodiquement, mais jusqu'à présent, la théorie M manque d'un élément clé qui a assuré le triomphe d'une entreprise scientifique telle que le modèle standard: la capacité d'entrer en contact avec le monde que nous pouvons mesurer, de résoudre des mystères inexplicables par d'autres méthodes et de fournir des éléments fondamentaux explications de pourquoi notre monde est ce qu'il est. Cela ne signifie pas que la théorie M est erronée, mais jusqu'à présent, elle ne représente que le raisonnement, bien qu'elle ait un bon motif.Si vous suivez les leçons de l'histoire, il devient clair que la plupart des théories physiques avancées se sont révélées fausses. Sinon, n'importe qui pourrait s'engager dans la physique théorique. Il a fallu plusieurs siècles, et si l'on prend en compte la science des Grecs anciens, puis plusieurs millénaires, la méthode des essais et erreurs, qui a conduit à l'émergence du modèle standard.Et nous y voilà. De nouvelles révélations expérimentales nous attendent-elles prochainement, qui pourront confirmer ou réfuter les plus grands arguments de la physique théorique? Ou sommes-nous au bord du désert, et la nature ne nous donnera pas d'indices sur le sens de la recherche de réponses aux secrets de l'espace? Nous découvrirons, et en tout cas, nous devrons vivre avec une nouvelle réalité.