Cela ne vaut probablement pas la peine de parler de ce que la soi-disant

loi de Moore chez Geektimes est en détail - nous le savons tous, au moins approximativement. En bref, cette loi est une observation empirique faite par Gordon Moore. Il y avait plusieurs libellés de la loi elle-même, mais la version moderne dit que le nombre de transistors placés sur une puce de circuit intégré double tous les 24 mois. Un peu plus tard, une sorte de loi est apparue, où elle apparaît non pas deux ans, mais 18 mois. Ce n'est pas dû à Moore, mais à David House d'Intel. Selon lui, les performances des processeurs devraient doubler tous les 18 mois en raison de la croissance simultanée du nombre de transistors et de la vitesse de chacun d'entre eux.

Depuis le libellé de la loi, les développeurs d'éléments électroniques tentent de suivre le rythme établi. D'une manière générale, pour 1965 la loi était quelque chose d'inhabituel, on peut même la qualifier de radicale. Ensuite, les «mini-ordinateurs» n'étaient toujours pas très petits, occupant le volume d'un bureau ordinaire dans la pièce, voire plus. À cette époque, il était difficile d'imaginer que les ordinateurs pourraient même faire partie d'un réfrigérateur, d'une machine à laver ou d'autres appareils ménagers au fil du temps. La plupart des gens n'ont jamais vu d'ordinateur et ceux qui en ont vu n'ont presque jamais travaillé avec eux. Eh bien, ceux qui travaillaient utilisaient des cartes perforées et d'autres outils peu pratiques pour interagir avec les ordinateurs, ce qui, à son tour, permettait de résoudre un éventail de tâches assez étroit.

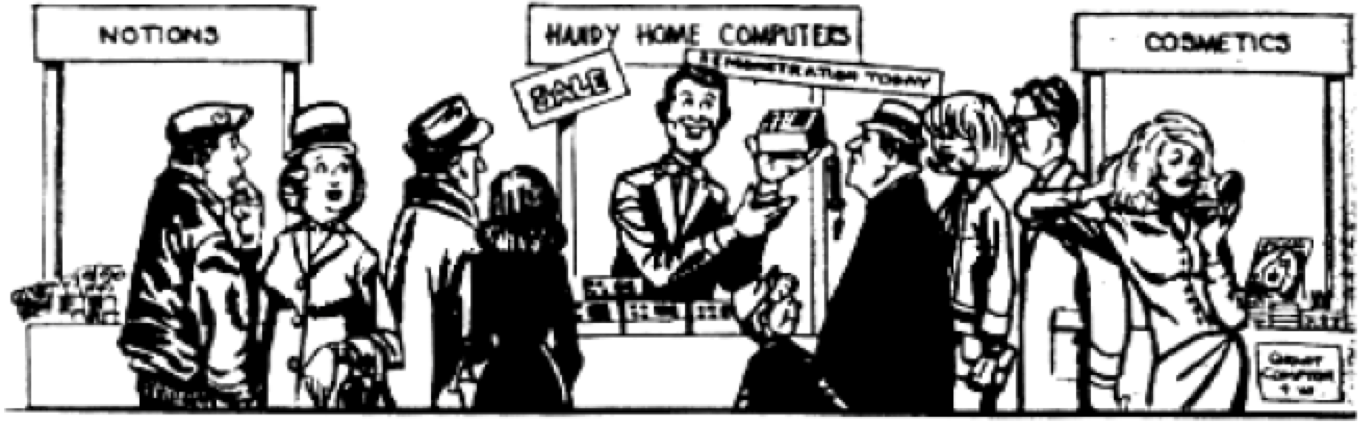

Après que l'idée de Moore soit devenue connue, ils ont même commencé à plaisanter dans les magazines. Par exemple, dans l'un d'eux, ils ont affiché ici une telle caricature:

Il était alors difficile d'imaginer que bientôt même de tels ordinateurs ne seraient plus du tout considérés comme petits. Au fait, Moore a vu l'illustration et elle a été très surprise par son originalité. Autant que l'on puisse en juger, l'artiste a essayé de transmettre une attitude quelque peu sceptique quant à l'idée de réduire constamment la taille des PC. Mais après 25 ans, cette illustration est devenue une réalité quotidienne.

Influence de la loi de Moore

Comme mentionné ci-dessus, il existe plusieurs variantes de la loi de Moore, nous ne parlons pas seulement d'une augmentation constante du nombre de transistors dans la puce. L’une des conséquences de l’idée de Moore est de chercher à savoir à quelle vitesse fonctionneront tous les transistors rétrécissants. De plus, les scientifiques et les spécialistes des technologies de l'information, utilisant l'idée de Moore, ont essayé et essaient de prédire à quelle vitesse la quantité de RAM, la mémoire principale augmentera, la productivité des puces, etc.

Mais l'essentiel n'est pas de savoir quelle version de la loi de Moore est la plus curieuse / utile, mais quel impact l'idée principale a eu sur notre monde. On distingue ici trois formes principales d'influence. Il s'agit d'une rivalité entre développeurs, prévoyant et modifiant l'architecture des systèmes informatiques.

RivalitéLa loi de Moore peut être utilisée pour savoir combien d'informations peuvent être stockées dans le volume d'une puce. Cette loi, soit dit en passant, peut être attribuée à la RAM sur le terrain. A l'aube de la technologie informatique, ou plutôt du PC, une puce informatique pourrait stocker

. Les puces elles-mêmes ont commencé à s'appeler RAM (Random Access Memory). Les puces avec 16K ont commencé à en produire beaucoup. Puis, en pleine conformité avec la loi de Moore, ou même plus rapidement, des puces avec 64 K. sont apparues. Les ingénieurs qui ont développé ces puces connaissaient la loi et essayaient de la respecter. Ainsi, dès le début, un cycle de production spécial et ininterrompu a été établi, lorsque les ingénieurs, libérant une puce, ont déjà terminé le travail sur sa prochaine génération. Cette situation est maintenant observée. Tout le monde connaît les règles et le jeu, et tout le monde y participe.

PrévisionConnaissant la tendance à une augmentation du nombre de transistors dans le volume des puces (et la formule était initialement suffisamment claire), les ingénieurs de n'importe quelle entreprise fabriquant des composants électroniques pourraient à peu près imaginer quand la génération de puces serait libérée. Et c'était une prévision assez précise. On pourrait également imaginer en quelle année et avec quelles performances le processeur fonctionnera.

Les ingénieurs des entreprises ont commencé à élaborer des plans de production, en se concentrant principalement sur la loi de Moore. Les vendeurs d'ordinateurs avaient une bonne idée du moment auquel la génération de machines devrait quitter le marché et celle qui devrait apparaître.

On peut dire que la loi de Moore a établi le processus de production pour la production de composants et de systèmes électroniques. Il n'y a pas eu de surprise à cet égard, et il ne pouvait pas y en avoir, car tout le monde a travaillé à peu près à la même vitesse, sans essayer de dépasser ou de prendre du retard sur le délai fixé par Moore. Tout était parfaitement prévisible.

Architecture et éléments PC

Architecture et éléments PCLa loi de Moore a tout de même permis aux ingénieurs de développer une conception de puces qui est devenue une référence depuis longtemps. Il s'agit d'un Intel 4004 et de ses incarnations ultérieures. Une architecture spécialisée a été développée, appelée

architecture von Neumann .

En mars 1945, les principes de l'architecture logique ont été formalisés dans un document intitulé «La première ébauche du rapport EDVAC» - un rapport pour le laboratoire balistique de l'armée américaine, sur la base duquel l'argent ENIAC a été construit et EDVAC développé. Le rapport, puisqu'il ne s'agissait que d'une ébauche, n'était pas destiné à être publié, mais uniquement à être diffusé au sein du groupe, cependant, German Goldstein, conservateur du projet de l'armée américaine, a multiplié ce travail scientifique et l'a envoyé à un large cercle de scientifiques pour examen. Étant donné que seul le nom de von Neumann [1] figurait sur la première page du document, les lecteurs du document avaient la fausse impression qu'il était l'auteur de toutes les idées présentées dans l'ouvrage. Le document a fourni suffisamment d'informations pour que ceux qui le lisent puissent construire leurs ordinateurs, similaires à EDVAC, sur les mêmes principes et avec la même architecture, ce qui est devenu par la suite "l'architecture von Neumann".

Après la fin de la Seconde Guerre mondiale et la fin des travaux sur ENIAK en février 1946, l'équipe d'ingénieurs et de scientifiques se sépara, John Mokley, John Eckert décida de se tourner vers les affaires et de créer des ordinateurs sur une base commerciale. Von Neumann, Goldstein et Burks ont déménagé à l'Institut de recherche avancée, où ils ont décidé de créer leur propre machine IAS, similaire à EDVAC, et de l'utiliser pour des travaux de recherche. En juin 1946, ils [2] [3] ont exposé leurs principes de construction d'ordinateurs dans l'article classique, «Une considération préliminaire de la conception logique d'un dispositif informatique électronique». Plus d'un demi-siècle s'est écoulé depuis lors, mais les dispositions qui y sont avancées restent d'actualité. L'article justifie de manière convaincante l'utilisation d'un système binaire pour représenter les nombres, car avant toutes les machines informatiques stockaient les nombres traités sous forme décimale. Les auteurs ont démontré les avantages du système binaire pour la mise en œuvre technique, la commodité et la simplicité d'effectuer des opérations arithmétiques et logiques dans celui-ci. Par la suite, les ordinateurs ont commencé à traiter des types d'informations non numériques - texte, graphique, son et autres, mais le codage des données binaires constitue toujours la base d'information de tout ordinateur moderne.

Toutes les fondations qui ont été posées il y a plusieurs décennies et sont devenues la fondation. À l'avenir, presque tout est resté inchangé, les développeurs ont seulement essayé de rendre les ordinateurs de plus en plus productifs.

Il convient de rappeler que la loi de Moore est la base de tout. Toutes ses incarnations ont servi de support au modèle de base du développement de la technologie informatique, et déjà peu de choses pouvaient conduire à une rupture de ce cycle. Et plus le développement de la technologie informatique progressait, plus on peut dire que les développeurs de ces systèmes étaient enlisés dans la loi. En effet, la création d'une architecture informatique différente prend des années et des années, et peu d'entreprises pouvaient se permettre ce luxe - la recherche de modes alternatifs de développement de la technologie informatique. Des organismes de recherche comme le MIT ont mené des expériences courageuses comme la Lisp Machine et la Connection Machine, vous pouvez mentionner ici l'un des projets japonais. Mais tout cela n'a abouti à rien, l'architecture de von Neumann est restée en usage.

Le travail des ingénieurs et des programmeurs consistait désormais à optimiser le travail de leurs programmes et de leur matériel pour que chaque millimètre carré de puces fonctionne de plus en plus efficacement. Les développeurs rivalisaient pour mettre en cache des quantités de données toujours plus importantes. De plus, divers fabricants de composants électroniques ont essayé (et essaient toujours) de placer autant de cœurs que possible dans un seul processeur. Quoi qu'il en soit, tout le travail s'est concentré sur un nombre limité d'architectures de processeur. Ce sont X86, ARM et PowerPC. Il y a trente ans, il y en avait beaucoup plus.

X86 est principalement utilisé sur les ordinateurs de bureau, les ordinateurs portables et les serveurs cloud. Les processeurs ARM fonctionnent sur les téléphones et les tablettes. Eh bien, PowerPC dans la plupart des cas est utilisé dans l'industrie automobile.

Une exception intéressante aux règles strictes du jeu établies par la loi de Moore est le GPU. Ils ont été développés afin de traiter des informations graphiques avec un haut degré d'efficacité, donc leur architecture est différente du processeur (encore). Mais pour faire face à sa tâche, le GPU devait être développé indépendamment de l'évolution des processeurs. L'architecture des cartes vidéo a été optimisée pour gérer la grande quantité de données nécessaires au rendu de l'image à l'écran. Par conséquent, les ingénieurs ont développé ici un type de puce différent, qui ne remplaçait pas les processeurs existants, mais complétait leurs capacités.

Quand la loi de Moore cessera-t-elle de fonctionner?

Au sens habituel, il a déjà cessé de fonctionner, dans cette compréhension classique, dont il a été question plus haut. Cela est mis en évidence par diverses sources, dont par exemple

celle-ci . Maintenant, la course est toujours en cours. Par exemple, dans le même premier processeur commercial Intel 4004 5 bits commercialisé en 1971, il y avait 2 300 transistors. Après 45 ans, en 2016, Intel a présenté le processeur 24 cœurs Xeon Broadwell-WS avec 5,7 milliards de transistors. Ce processeur est disponible en technologie 14 nm. IBM a récemment annoncé un processeur 7 nm avec 20 milliards de transistors, puis un processeur 5 nm avec 30 milliards de transistors.

Mais 5 nm est une couche d'une épaisseur de seulement 20 atomes. Ici, l'ingénierie se rapproche déjà de la limite technique d'une nouvelle amélioration du processus. De plus, la densité des transistors dans les processeurs modernes est très élevée. 5 voire 10 milliards de transistors par millimètre carré. La vitesse de transmission du signal dans le transistor est très élevée et est d'une grande importance. La fréquence centrale des processeurs les plus rapides modernes est de 8,76 GHz. Une accélération supplémentaire, bien que possible, est également un problème technique, et elle est très, très importante. C'est pourquoi les ingénieurs ont choisi de créer des processeurs multicœurs, plutôt que de continuer à augmenter la fréquence d'un cœur unique.

Cela a permis de maintenir le rythme d'augmentation du nombre d'opérations par seconde prévu par la loi de Moore. Néanmoins, le multinucléarisme lui-même est une certaine dérogation à la loi. Néanmoins, un certain nombre d'experts estiment que peu importe la façon dont nous essayons de «rattraper», l'essentiel est que le rythme du développement technologique, en particulier l'informatique, soit plus ou moins conforme à la loi de Moore.

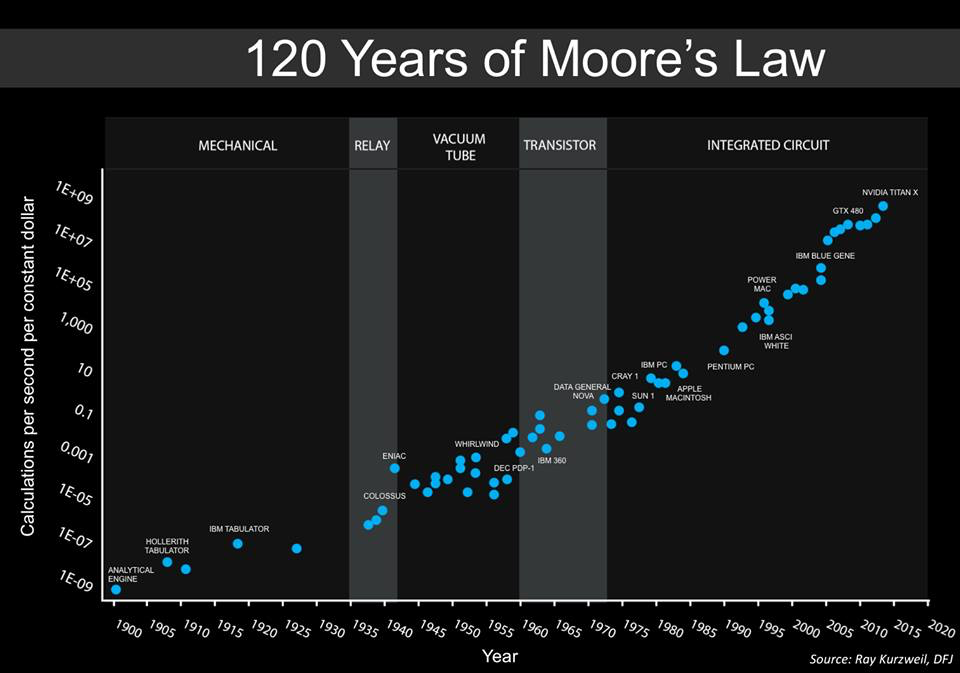

Ci-dessous est un graphique construit par Steve Jurvetson, co-fondateur de Draper Fisher Jurvetson. Il affirme qu'il s'agit d'un calendrier augmenté précédemment soumis par

Ray Kurzweil .

Ce graphique montre le coût relatif du nombre d'opérations par unité de temps (1 seconde). Autrement dit, nous pouvons voir clairement combien informatique moins chère au fil du temps. De plus, les calculs sont devenus de plus en plus universels, pour ainsi dire. Dans les années 40, il y avait des machines spécialisées conçues pour casser les codes militaires. Dans les années 1950, les ordinateurs ont commencé à être utilisés pour exécuter des tâches courantes, et cette tendance se poursuit encore aujourd'hui.

Fait intéressant, les deux dernières positions sur le graphique sont les GPU, GTX 450 et NVIDIA Titan X. Fait intéressant, en 2010, il n'y avait pas de GPU sur le graphique, seulement des processeurs multicœurs.

En général, le GPU est déjà là, et beaucoup en sont satisfaits. De plus, maintenant une direction telle que l'apprentissage en profondeur, l'une des manifestations des réseaux de neurones, devient de plus en plus populaire. De nombreuses entreprises, grandes et petites, sont engagées dans leur développement. Et les GPU sont idéaux pour les réseaux de neurones.

Pourquoi tout ça? Le fait est que l'augmentation globale du nombre de calculs est toujours préservée, oui, mais les méthodes et les équipements évoluent.

Qu'est-ce que tout cela signifie?

Maintenant, la forme même de l'informatique est en train de changer. Les architectes n'auront bientôt plus besoin de penser à quoi faire pour suivre la loi de Moore. Maintenant, de nouvelles idées sont progressivement introduites qui atteindront des sommets inaccessibles aux systèmes informatiques conventionnels à architecture traditionnelle. Peut-être que, dans un avenir proche, la vitesse de calcul ne sera pas si importante, il sera possible d'améliorer les performances du système différemment.

Systèmes d'auto-apprentissage

Systèmes d'auto-apprentissageMaintenant, de nombreux réseaux de neurones dépendent du GPU. Des systèmes à architecture spécialisée sont en cours de création pour eux. Par exemple, Google a développé ses propres puces, appelées unités TensorFlow (ou TPU). Ils vous permettent d'économiser de la puissance de calcul grâce à l'efficacité des calculs. Google utilise ces puces dans ses centres de données, et de nombreux services cloud de l'entreprise fonctionnent sur leur base. En conséquence, les performances du système sont plus élevées et la consommation d'énergie est plus faible.

Puces spécialiséesDans les appareils mobiles conventionnels, les processeurs ARM fonctionnent maintenant, qui sont spécialisés. Ces processeurs traitent les informations des caméras, optimisent le traitement de la parole et travaillent en temps réel avec la reconnaissance faciale. La spécialisation dans tout est ce que l'électronique attend.

Architecture spécialiséeOui, le coin n'a pas convergé sur l'architecture von Neumann, maintenant des systèmes avec différentes architectures conçues pour effectuer différentes tâches sont en cours de développement. Cette tendance est non seulement maintenue, mais même accélérée.

Sécurité informatiqueLes cybercriminels sont de plus en plus qualifiés, avec le piratage de certains systèmes, vous pouvez maintenant obtenir des millions, des dizaines de millions de dollars. Mais dans la plupart des cas, le piratage du système est possible en raison d'erreurs logicielles ou matérielles. La grande majorité des astuces utilisées par les crackers fonctionnent sur des systèmes avec l'architecture von Neumann, mais elles ne fonctionneront pas avec d'autres systèmes.

Systèmes quantiquesLes soi-disant ordinateurs quantiques sont une technologie expérimentale, qui, entre autres, est également très coûteuse. Les éléments cryogéniques sont utilisés ici, ainsi que de nombreuses autres choses que l'on ne trouve pas dans les systèmes conventionnels. Les ordinateurs quantiques sont complètement différents des ordinateurs habituels et la loi de Moore ne s’applique pas à eux. Néanmoins, avec leur aide, selon les experts, il est possible d'augmenter radicalement les performances de certains types de calculs. C'est peut-être la loi de Moore qui a conduit les scientifiques et les ingénieurs à rechercher de nouvelles façons d'augmenter l'efficacité de l'informatique et à les trouver.

En guise de postface

Très probablement, dans 5 à 10 ans, nous verrons des systèmes informatiques complètement nouveaux, nous parlons maintenant de la technologie des semi-conducteurs. Ces systèmes seront en avance sur nos plans les plus fous et se développeront à un rythme très rapide. Très probablement, des spécialistes, essayant de contourner la loi de Moore, créeront de nouvelles technologies de développement de puces qui, s’ils nous en avaient parlé maintenant, nous auraient semblé magiques. Que diraient les gens qui vivaient il y a 50 ans s'ils recevaient un smartphone moderne? Peu de gens comprendraient comment tout fonctionne. C'est donc dans notre cas.