Le temps est venu pour l'informatique inspirée de la structure du cerveau. Les algorithmes qui utilisent les réseaux de neurones et l'apprentissage profond qui imitent certains aspects du cerveau humain permettent aux ordinateurs numériques d'atteindre des sommets incroyables dans la traduction de la langue, de rechercher des modèles insaisissables dans d'énormes quantités de données et de battre les gens dans Go.

Mais alors que les ingénieurs continuent de développer activement cette stratégie de calcul, capable de beaucoup, l'efficacité énergétique de l'informatique numérique approche de sa limite. Nos centres de données et superordinateurs consomment déjà des mégawatts - 2% de toute l'électricité consommée aux États-Unis est destinée aux centres de données. Et le cerveau humain vaut bien 20 watts, et c'est une petite fraction de l'énergie contenue dans la nourriture quotidienne consommée. Si nous voulons améliorer les systèmes informatiques, nous devons faire en sorte que les ordinateurs ressemblent à des cerveaux.

Un regain d'intérêt pour les technologies neuromorphiques est associé à cette idée, promettant de conduire les ordinateurs au-delà des simples réseaux de neurones, vers des circuits qui fonctionnent comme des neurones et des synapses. Le développement de circuits physiques similaires au cerveau est déjà assez bien développé. Le travail effectué dans mon laboratoire et dans d'autres institutions à travers le monde au cours des 35 dernières années a conduit à la création de composants nerveux artificiels, similaires aux synapses et aux dendrites, qui réagissent et génèrent des signaux électriques de la même manière que les vrais.

Alors, que faut-il pour intégrer ces blocs de construction dans un cerveau informatique à part entière? En 2013, Bo Marr, mon ancien étudiant diplômé au Georgia Institute of Technology, m'a aidé à

évaluer le meilleur des avancées modernes en ingénierie et en neurobiologie . Nous avons conclu qu'il est possible de créer une version silicium du cortex du cerveau humain à l'aide de transistors. De plus, la machine finale occuperait moins d'un mètre cube dans l'espace et consommerait moins de 100 watts, ce qui n'est pas si différent du cerveau humain.

Je ne veux pas dire que la création d'un tel ordinateur sera facile. Le système que nous avons inventé nécessitera plusieurs milliards de dollars pour son développement et sa construction, et pour lui donner de la compacité, il inclura plusieurs innovations innovantes. La question se pose également de savoir comment nous allons programmer et former un tel ordinateur. Les chercheurs en neuromorphisme ont encore du mal à comprendre comment faire fonctionner ensemble des milliers de neurones artificiels et comment trouver des applications utiles pour l'activité pseudo-cérébrale.

Néanmoins, le fait que nous puissions proposer un tel système suggère que nous n'avions pas longtemps avant l'apparition de puces à plus petite échelle adaptées à une utilisation dans l'électronique portable et portable. De tels gadgets consomment peu d'énergie, donc une puce neuromorphique à haute efficacité énergétique - même si elle ne prend qu'une partie des calculs, disons, le traitement du signal - peut devenir révolutionnaire. Les fonctionnalités existantes, telles que la reconnaissance vocale, peuvent fonctionner dans des environnements bruyants. Vous pouvez même imaginer les smartphones du futur effectuant une traduction vocale en temps réel dans une conversation entre deux personnes. Pensez-y: au cours des 40 années écoulées depuis l'avènement des circuits intégrés pour le traitement du signal, la loi de Moore a amélioré leur efficacité énergétique d'environ 1 000 fois. Les puces neuromorphes très cérébrales peuvent facilement dépasser ces améliorations, réduisant la consommation d'énergie de 100 millions de fois. En conséquence, les calculs qui nécessitaient auparavant un centre de données tiennent dans la paume de votre main.

Dans une machine idéale approchant le cerveau, il sera nécessaire de recréer des analogues de toutes les principales composantes fonctionnelles du cerveau: des synapses qui connectent les neurones et leur permettent de recevoir et de répondre aux signaux; dendrites combinant et effectuant des calculs locaux sur la base des signaux entrants; le noyau, ou soma, est la région de chaque neutron, combinant l'entrée des dendrites et transmettant la sortie à l'axone.

Les versions les plus simples de ces composants de base sont déjà implémentées dans le silicium. Le début de ce travail a été donné par le même semi-conducteur à oxyde métallique, ou MOSFET, dont des milliards de copies sont utilisées pour construire des circuits logiques dans les processeurs numériques modernes.

Ces appareils ont beaucoup en commun avec les neurones. Les neurones fonctionnent au moyen de barrières à tension contrôlée, et leur activité électrique et chimique dépend principalement des canaux dans lesquels les ions se déplacent entre les espaces intérieur et extérieur de la cellule. Il s'agit d'un processus analogique fluide dans lequel il y a une accumulation ou une réduction constante du signal, au lieu d'opérations marche / arrêt simples.

Les MOSFET sont également contrôlés en tension et fonctionnent par les mouvements des unités de charge individuelles. Et lorsque les MOSFET fonctionnent en mode «sous-seuil», sans atteindre le seuil de tension, en activant et en désactivant les modes, la quantité de courant traversant l'appareil est très faible - moins d'un millième du courant qui peut être trouvé dans les commutateurs ou les portes numériques typiques.

L'idée que la physique des transistors sous-seuil peut être utilisée pour créer des circuits de type cérébral a été exprimée par Carver Mead de Caltech, qui a contribué à la révolution dans le domaine des circuits intégrés de très grande taille dans les années 1970. Mil a souligné que les concepteurs de puces n'utilisaient pas beaucoup d'aspects intéressants de leur comportement, utilisant des transistors exclusivement pour la logique numérique. Ce processus, comme

il l'a écrit en 1990 , est similaire au fait que "toutes les belles physiques qui existent dans les transistors sont écrasées en zéros et en uns, puis les portes ET et OU sont douloureusement construites sur cette base pour réinventer la multiplication". Un ordinateur plus «physique» ou basé sur la physique pourrait faire plus de calculs par unité d'énergie qu'un ordinateur numérique conventionnel. Mead a prédit qu'un tel ordinateur prendrait moins de place.

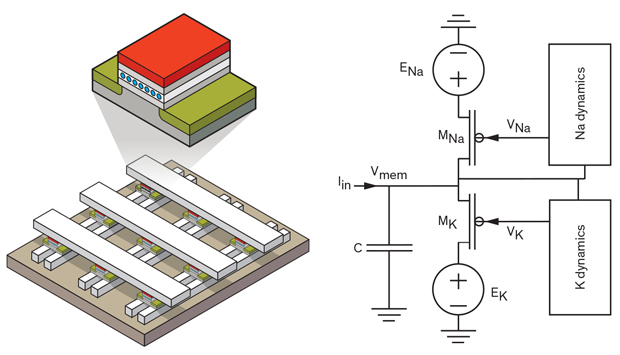

Au cours des années suivantes, les ingénieurs des systèmes neuromorphiques ont créé tous les blocs de base du cerveau à partir de silicium avec une grande précision biologique. Les dendrites, les axones et les somes de neurones peuvent être fabriqués à partir de transistors standard et d'autres éléments. Par exemple, en 2005, Ethan Farquhar et moi avons

créé un circuit neuronal à partir d'un ensemble de six MOSFET et d'un tas de condensateurs. Notre modèle a émis des impulsions électriques, très similaires à celles qui émettent le calmar des neurones du poisson-chat - un objet expérimental de longue date. De plus, notre schéma a atteint de tels indicateurs avec des niveaux de consommation actuels et énergétiques proches de ceux existant dans le cerveau du calmar. Si nous voulions utiliser des circuits analogiques pour modéliser les équations dérivées par les neuroscientifiques pour décrire ce comportement, il nous faudrait utiliser 10 fois plus de transistors. Effectuer de tels calculs sur un ordinateur numérique nécessiterait encore plus d'espace.

Synapses et silure: un transistor à grille flottante (en haut à gauche), capable de stocker une quantité de charge différente, peut être utilisé pour créer un réseau de coordonnées de synapses artificielles (en bas à gauche). Les versions électroniques d'autres composants du neurone, comme le poisson-chat (à droite), peuvent être fabriquées à partir de transistors standard et d'autres composants.

Les synapses sont un peu plus difficiles à émuler. Un appareil se comportant comme une synapse doit pouvoir se rappeler dans quel état il se trouve, réagir d'une certaine manière au signal entrant et adapter ses réponses dans le temps.

Il existe plusieurs approches possibles pour créer des synapses. La plus développée d'entre elles est une

synapse à transistor unique (STLS), sur laquelle mes collègues de Kaltech et moi avons travaillé dans les années 1990, lorsque j'étais étudiant diplômé à Mead.

Nous avons introduit STLS pour la première fois en 1994, et il est devenu un outil important pour les ingénieurs qui créent des circuits analogiques modernes - par exemple, des réseaux neuronaux physiques. Dans les réseaux de neurones, chaque nœud du réseau a un poids qui lui est associé, et ces poids déterminent comment les données de différents nœuds sont combinées. STLS a été le premier appareil capable de contenir un ensemble de poids différents et de reprogrammer à la volée. De plus, l'appareil est non volatile, c'est-à-dire qu'il se souvient de son état, même lorsqu'il n'est pas utilisé - cette circonstance réduit considérablement le besoin d'énergie.

STLS est un type de transistor à grille flottante, un appareil utilisé pour créer des cellules dans la mémoire flash. Dans un MOSFET conventionnel, la grille contrôle le courant traversant le canal. Le transistor à grille flottante possède une deuxième grille, entre la grille électrique et le canal. Cet obturateur n'est pas directement connecté à la terre ou à tout autre composant. Grâce à cette isolation électrique, renforcée par des isolants en silicium de haute qualité, la charge est stockée longtemps dans une grille flottante. Cet obturateur est capable de prendre une charge différente et peut donc donner une réponse électrique à plusieurs niveaux - et cela est nécessaire pour créer une synapse artificielle qui peut varier sa réponse au stimulus.

Mes collègues et moi avons utilisé STLS pour démontrer le premier réseau de coordonnées, un modèle de calcul populaire auprès des chercheurs en nanodispositifs. Dans un réseau bidimensionnel, les périphériques sont situés à l'intersection des lignes d'entrée allant de haut en bas et des lignes de sortie allant de gauche à droite. Une telle configuration est utile en ce qu'elle vous permet de programmer séparément la force de connexion de chaque «synapse», sans interférer avec d'autres éléments du réseau.

Grâce en particulier au récent programme DARPA appelé

SyNAPSE , l'ingénierie du neuromorphisme a stimulé la recherche sur les synapses artificielles créées à partir de nanodispositifs tels que les memristors, la mémoire résistive et la mémoire à état de phase, ainsi que les dispositifs à grille flottante. Mais ces nouvelles synapses artificielles seront difficiles à améliorer sur la base de tableaux à obturateur flottant il y a vingt ans. Les mémoires et autres types de nouvelle mémoire sont difficiles à programmer. L'architecture de certains d'entre eux est telle qu'il est assez difficile d'accéder à un périphérique spécifique dans un tableau de coordonnées. D'autres nécessitent un transistor dédié pour la programmation, ce qui augmente considérablement leur taille. Étant donné que la mémoire avec un obturateur flottant peut être programmée pour une large gamme de valeurs, il est plus facile de l'ajuster pour compenser les écarts de production d'un appareil à l'autre par rapport à d'autres nanodispositifs. Plusieurs groupes de recherche qui ont étudié les dispositifs neuromorphiques ont essayé d'incorporer des nanodispositifs dans leurs conceptions et ont donc commencé à utiliser des dispositifs d'obturation flottants.

Et comment pouvons-nous combiner tous ces composants cérébraux? Dans le cerveau humain, les neurones et les synapses sont entrelacés. Les développeurs de puces neuromorphes doivent également choisir une approche intégrée avec le placement de tous les composants sur une seule puce. Mais dans de nombreux laboratoires, vous ne le trouverez pas: pour faciliter le travail avec les projets de recherche, les unités de base individuelles sont situées à différents endroits. Les synapses peuvent être placées dans un réseau à l'extérieur de la puce. Les connexions peuvent passer par une autre puce, une matrice de portes programmables par l'utilisateur (FPGA).

Mais lors de la mise à l'échelle de systèmes neuromorphiques, vous devez vous assurer que nous ne copions pas la structure des ordinateurs modernes qui perdent une quantité importante d'énergie en transférant des bits entre la logique, la mémoire et le stockage. Aujourd'hui, un ordinateur peut facilement consommer 10 fois plus d'énergie pour déplacer des données que pour l'informatique.

Le cerveau, au contraire, minimise la consommation d'énergie des communications en raison de la forte localisation des opérations. Les éléments de mémoire du cerveau, tels que la puissance de synapse, sont mélangés avec des composants de transmission de signal. Et les «fils» du cerveau - les dendrites et les axones qui transmettent les signaux entrants et les impulsions sortantes - sont généralement courts par rapport à la taille du cerveau, et ils n'ont pas besoin de beaucoup d'énergie pour maintenir le signal. De l'anatomie, nous savons que plus de 90% des neurones se connectent à seulement 1000 voisins.

Une autre grande question pour les créateurs de puces et d'ordinateurs de type cerveau est les algorithmes qui devront y travailler. Même un système légèrement cérébral peut donner un gros avantage sur un système numérique conventionnel. Par exemple, en 2004, mon groupe a utilisé des dispositifs à grille flottante pour effectuer la multiplication dans le traitement du signal, et cela a pris 1 000 fois moins d'énergie et 100 fois moins d'espace qu'un système numérique. Au fil des ans, les chercheurs ont démontré avec succès des approches neuromorphiques à d'autres types de calcul pour le traitement du signal.

Mais le cerveau est toujours 100 000 fois plus efficace que ces systèmes. En effet, bien que nos technologies neuromorphiques actuelles tirent parti de la physique neuronale des transistors, elles n'utilisent pas d'algorithmes comme ceux que le cerveau utilise pour faire son travail.

Aujourd'hui, nous commençons à peine à découvrir ces algorithmes physiques - des processus qui peuvent permettre aux puces cérébrales de fonctionner avec une efficacité proche du cerveau. Il y a quatre ans, mon groupe a utilisé du silure, des synapses et des dendrites en silicium pour exécuter un algorithme de recherche de mots qui reconnaît les mots dans les enregistrements audio. Cet algorithme a montré une amélioration de mille fois de l'efficacité énergétique par rapport au traitement du signal analogique. En conséquence, en réduisant la tension appliquée aux puces et en utilisant des transistors plus petits, les chercheurs doivent créer des puces de performances comparables à celles du cerveau dans de nombreux types de calcul.

Lorsque j'ai commencé la recherche sur le neuromorphisme il y a 30 ans, tout le monde pensait que le développement de systèmes similaires au cerveau nous offrirait des opportunités incroyables. En effet, des industries entières sont désormais construites autour de l'IA et de l'apprentissage en profondeur, et ces applications promettent de transformer complètement nos appareils mobiles, nos institutions financières et l'interaction des personnes dans les lieux publics.

Et pourtant, ces applications reposent très peu sur notre connaissance des fonctions cérébrales. Au cours des 30 prochaines années, nous pourrons sans doute voir comment ces connaissances sont de plus en plus utilisées. Nous avons déjà de nombreux blocs matériels de base nécessaires pour convertir la neurobiologie en ordinateur. Mais nous devons encore mieux comprendre comment cet équipement devrait fonctionner - et quels schémas de calcul donneront les meilleurs résultats.

Considérez cela comme un appel à l'action. Nous avons accompli beaucoup de choses en utilisant un modèle très approximatif du cerveau. Mais les neurosciences peuvent nous conduire à créer des ordinateurs de type cerveau plus complexes. Et quoi de mieux que d'utiliser notre cerveau pour comprendre comment fabriquer ces nouveaux ordinateurs?