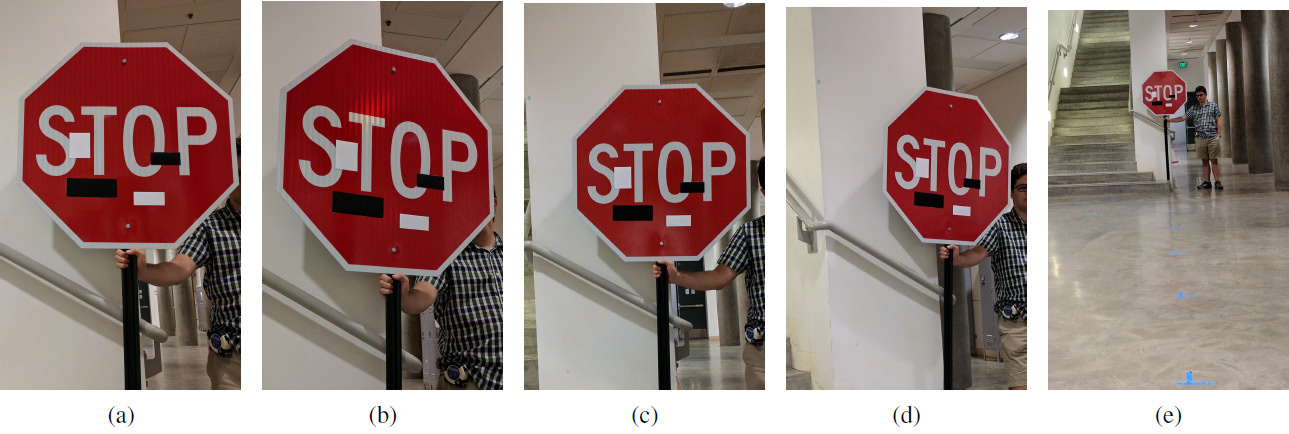

Un ensemble d'images expérimentales avec des autocollants d'art à différentes distances et à différents angles: (a) 5 pieds, 0 degrés; (b) 5 '15 °; (c) 10 ° 0 °; (d) 10-30 °; (e) 40 ° 0 °. La tricherie fonctionne à n'importe quelle distance et à n'importe quel angle: au lieu du panneau Stop, le système d'apprentissage automatique voit le panneau "Speed limit 45 miles"

Un ensemble d'images expérimentales avec des autocollants d'art à différentes distances et à différents angles: (a) 5 pieds, 0 degrés; (b) 5 '15 °; (c) 10 ° 0 °; (d) 10-30 °; (e) 40 ° 0 °. La tricherie fonctionne à n'importe quelle distance et à n'importe quel angle: au lieu du panneau Stop, le système d'apprentissage automatique voit le panneau "Speed limit 45 miles"Alors que certains scientifiques améliorent les systèmes d'apprentissage automatique, d'autres scientifiques améliorent les méthodes de tromper ces systèmes.

Comme vous le savez, de petits changements ciblés dans l'image peuvent «casser» le système d'apprentissage automatique, de sorte qu'il reconnaît une image complètement différente. Ces images «cheval de Troie» sont appelées «exemples contradictoires» et représentent l'une des

limites bien connues

de l'apprentissage en profondeur .

Pour créer un exemple concurrentiel, vous devez maximiser l'activation, par exemple, d'un certain filtre de réseau de neurones convolutionnel. Ivan Yevtimov de l'Université de Washington, ainsi que des collègues de l'Université de Californie à Berkeley, de l'Université du Michigan et de l'Université de New York à Stony Brook ont développé un nouvel algorithme d'attaque - Perturbations

physiques robustes (RP

2 ). Il capture très efficacement la vision des véhicules sans pilote, des robots, des quadcoptères et de tout autre système robotique qui essaie de naviguer dans l'espace environnant.

Contrairement aux études précédentes, les auteurs se sont concentrés ici sur la modification directe des objets eux-mêmes plutôt que sur l'arrière-plan. La tâche des chercheurs était de trouver le plus petit delta possible qui renverserait le classificateur du système d'apprentissage automatique, qui a été formé sur

un ensemble de données avec des images des panneaux routiers LISA . Les auteurs ont indépendamment pris un certain nombre de photographies de panneaux routiers dans la rue dans différentes conditions (distance, angles, éclairage) et ont complété l'ensemble de données LISA pour la formation.

Après avoir calculé un tel delta, un masque a été révélé - une place (ou plusieurs places) dans l'image qui provoque le plus de manière fiable des perturbations dans le système d'apprentissage automatique (vision industrielle). Une série d'expériences a été menée pour vérifier les résultats. Les expériences ont été principalement réalisées sur un signal d'arrêt (signe "STOP"), que les chercheurs ont transformé avec plusieurs manipulations anodines pour la vision industrielle en un signe "SPEED LIMIT 45". La technique développée peut être utilisée sur tout autre signe. Les auteurs l'ont ensuite testé sur un panneau tournant.

L'équipe de recherche a développé deux types d'attaques contre les systèmes de vision industrielle qui reconnaissent les panneaux de signalisation. La première attaque est de petits changements imperceptibles sur toute la zone du signe. À l'aide de l'optimiseur Adam, ils ont pu minimiser le masque pour créer des exemples distincts, ciblés et compétitifs qui ciblent des panneaux de signalisation spécifiques. Dans ce cas, les systèmes d'apprentissage automatique peuvent être trompés avec des changements d'image minimes, et les gens ne remarqueront rien du tout. L'efficacité de ce type d'attaque a été testée sur des affiches imprimées avec de légères modifications (dans un premier temps, les chercheurs étaient convaincus que le système de vision industrielle reconnaît avec succès les affiches sans modifications).

Le deuxième type d'attaque est le camouflage. Ici, le système imite des actes de vandalisme ou des graffitis artistiques afin que le système n'interfère pas avec la vie de ceux qui l'entourent. Ainsi, le conducteur verra immédiatement le clignotant gauche ou le feu stop, et le robot verra un signe complètement différent. L'efficacité de ce type d'attaque a été testée sur de vrais panneaux routiers, scellés avec des autocollants. Le camouflage des graffitis consistait en des autocollants sous la forme des mots AMOUR et HAINE, et du camouflage comme de l'art abstrait - de quatre autocollants de forme rectangulaire en noir et blanc.

Les résultats de l'expérience sont présentés dans le tableau. Dans tous les cas, l'efficacité de la triche du classificateur d'apprentissage automatique est montrée, qui reconnaît le signe "STOP" modifié comme le signe "SPEED LIMIT 45". La distance est en pieds et l'angle de rotation est en degrés. La deuxième colonne montre la deuxième classe, qui est vue dans le système d'apprentissage automatique dans un signe modifié. Par exemple, à une distance de 5 pieds (152,4 cm), un camouflage tel que l'art abstrait à un angle de 0 ° produit les résultats suivants pour reconnaître le signe «STOP»: avec une confiance de 64%, il est reconnu comme un signe «SPEED LIMIT 45» et avec une confiance de 11% - comme Signe de Lane Ends.

Légende: SL45 = Speed Limit 45, STP = Stop, YLD = Yield, ADL = Added Lane, SA = Signal Ahead, LE = Lane Ends

Légende: SL45 = Speed Limit 45, STP = Stop, YLD = Yield, ADL = Added Lane, SA = Signal Ahead, LE = Lane EndsPeut-être qu'un tel système (avec les changements correspondants) sera nécessaire à l'humanité à l'avenir, et maintenant il peut être utilisé pour tester des systèmes imparfaits d'apprentissage automatique et de vision par ordinateur.

Les travaux scientifiques ont été

publiés le 27 juillet 2017 sur le site de préimpression arXiv.org (arXiv: 1707.08945).