Les éditeurs de l'Oxford Dictionary ont choisi le mot «post-vérité»

comme l' honorable «

mot de 2016 ». Ce terme décrit les circonstances dans lesquelles les faits objectifs sont moins importants pour la formation de l'opinion publique que l'appel aux émotions et aux croyances personnelles.

Une fréquence particulièrement élevée d'utilisation de ce mot a été observée dans les publications de langue anglaise après l'élection présidentielle américaine en rapport avec la diffusion d'un grand nombre de fausses nouvelles, après quoi la vérité elle-même n'avait pas beaucoup d'importance.

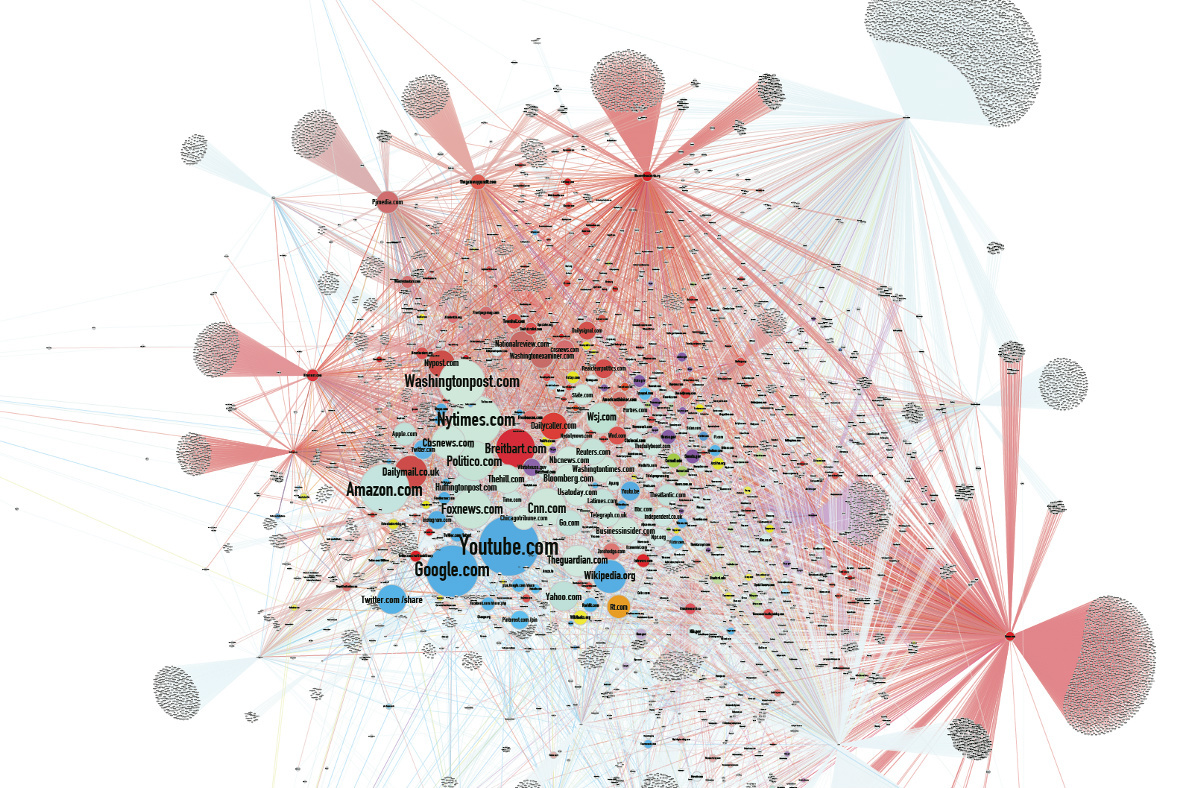

Selon certains analystes, la diffusion de fausses nouvelles diffamatoires a été l'une des raisons de la défaite d'Hillary Clinton aux élections. Le flux algorithmique Facebook

est devenu l' une des principales sources de fausses nouvelles.

Dans ce contexte, les nouvelles des développeurs dans le domaine de l'intelligence artificielle sont presque passées inaperçues. Nous sommes déjà habitués au fait que les réseaux de neurones dessinent des images, créent une photo d'une personne selon sa description verbale et génèrent de la musique. Ils font de plus en plus et à chaque fois ils font mieux. Mais le plus intéressant est que les machines ont appris à créer des faux.

L'influence des contrefaçons

Pendant la course électorale américaine, le nombre de dépôts de fausses informations sur les réseaux sociaux a dépassé le nombre de dépôts de messages véridiques, car les faux étaient plus conformes aux attentes ou plus excitants. Après l'élection, Facebook a embauché des vérificateurs de faits indépendants pour signaler les messages non vérifiés afin d'alerter les utilisateurs.

La combinaison d'une polarisation politique accrue de la société et d'une tendance à lire principalement les titres donne un effet cumulatif. Les fausses nouvelles sont également souvent diffusées sur de faux sites d'information, dont les informations tombent souvent dans les médias grand public, qui cherchent à attirer le trafic des utilisateurs. Et rien n'attire le trafic comme un titre accrocheur.

Mais en fait, l'influence des contrefaçons ne se limite pas à la seule sphère politique. Il existe de nombreux exemples qui démontrent l'impact des fausses nouvelles sur la société.

Une société de production vidéo australienne publie de

fausses vidéos virales depuis deux ans, gagnant des centaines de millions de vues.

Dans un

faux bien pensé sur Staline, dont le visage serait apparu dans le métro de Moscou, ils ont même cru le 1er avril.

En 1992, le millionnaire Ilya Medkov a commencé à payer de grandes agences de presse en Russie et dans la CEI (dont RIA Novosti, Interfax, ITAR-TASS). ITAR-TASS a envoyé un

faux message aux médias au sujet de l'accident survenu à la centrale nucléaire de Leningrad en janvier 1993. En conséquence, les actions des principales sociétés scandinaves ont chuté et avant qu’une réfutation des médias ne paraisse, les agents de Medkov ont acheté les actions les plus rentables des sociétés suédoises, finlandaises et norvégiennes.

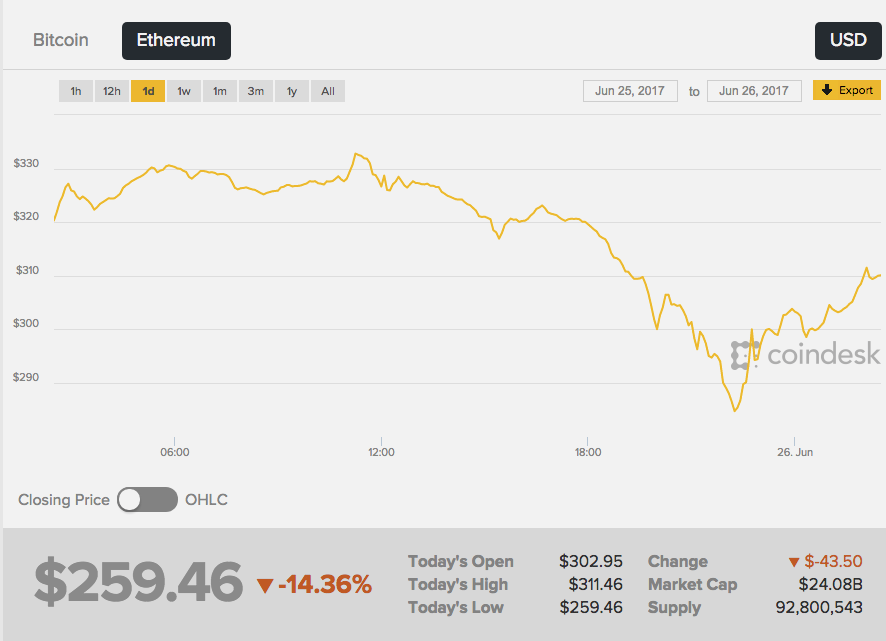

Le 26 juin 2017, le taux de la deuxième capitalisation de crypto-monnaie Ethereum a fortement baissé - l'échange a réagi aux rumeurs qui sont apparues sur le réseau à propos de la mort tragique du créateur d'Ether, Vitaliy Buterin. De plus, les premières "nouvelles urgentes" sont apparues sur un tableau d'image anonyme 4chan - et cette source, franchement, n'est pas la plus fiable.

Wikipédia a écrit que «Vitalik

était un programmeur russe», puis la presse jaune a appris la nouvelle. En conséquence, le taux d'éther a

chuté de 13%, passant d'environ 289 $ à 252 $. Le cours a commencé à se développer immédiatement après le démenti des nouvelles de Vitali lui-même.

Il n'y a aucune preuve que quelqu'un a délibérément créé un faux profit pour la différence de taux de crypto-monnaie. Il est incontestable seulement que les nouvelles fictives sans un seul fait confirmé ont un effet puissant sur les gens.

Imitation de réalité

La chanteuse française Françoise Ardi dans la vidéo répétera le discours de Kellianne Conway, conseillère du président américain Donald Trump, qui est devenu célèbre après avoir parlé de "faits alternatifs". Ce qui est intéressant ici, c'est qu'Ardi a en fait 73 ans, et dans la vidéo, elle ressemble à une personne de vingt ans.

Roller Alternative Face v1.1 a été

créé par l'artiste-actionniste allemand Mario Klingeman. Il a pris les interviews audio de Conway et les vieux clips d'Arde. Et puis il a utilisé un réseau neuronal génératif (GAN), qui a créé un contenu vidéo unique à partir de nombreuses images de différents clips du chanteur, et a superposé une piste audio avec des commentaires de Conway.

Dans ce cas, le faux est facile à reconnaître, mais vous pouvez aller plus loin - apporter des modifications au fichier audio. Les gens croiront l'image et l'enregistrement sonore plus volontiers que le simple texte. Mais comment simuler le son même d'une voix humaine?

Les systèmes GAN sont capables d'étudier les caractéristiques statistiques des enregistrements audio, puis de les reproduire dans un contexte différent et précis à la milliseconde près. Il suffit d'entrer le texte que le réseau neuronal doit reproduire, et vous obtiendrez une déclaration plausible.

La startup canadienne Lyrebird a publié ses propres algorithmes qui peuvent simuler la voix de toute personne à partir d'un fichier son d'une durée d'une minute. Pour démontrer les possibilités, la société a

publié une conversation entre Obama, Trump et Clinton - tous les héros, bien sûr, étaient des faux.

DeepMind, le Baidu Institute for Deep Learning et le Montreal Institute for the Study of Algorithms (MILA) travaillent déjà sur des algorithmes de synthèse vocale très réalistes.

Le résultat n'est pas encore parfait, vous pouvez rapidement distinguer la voix recréée de l'original, mais la similitude se fait sentir. De plus, dans la voix, le réseau change d'émotions, ajoute de la colère ou de la tristesse selon la situation.

Génération d'images

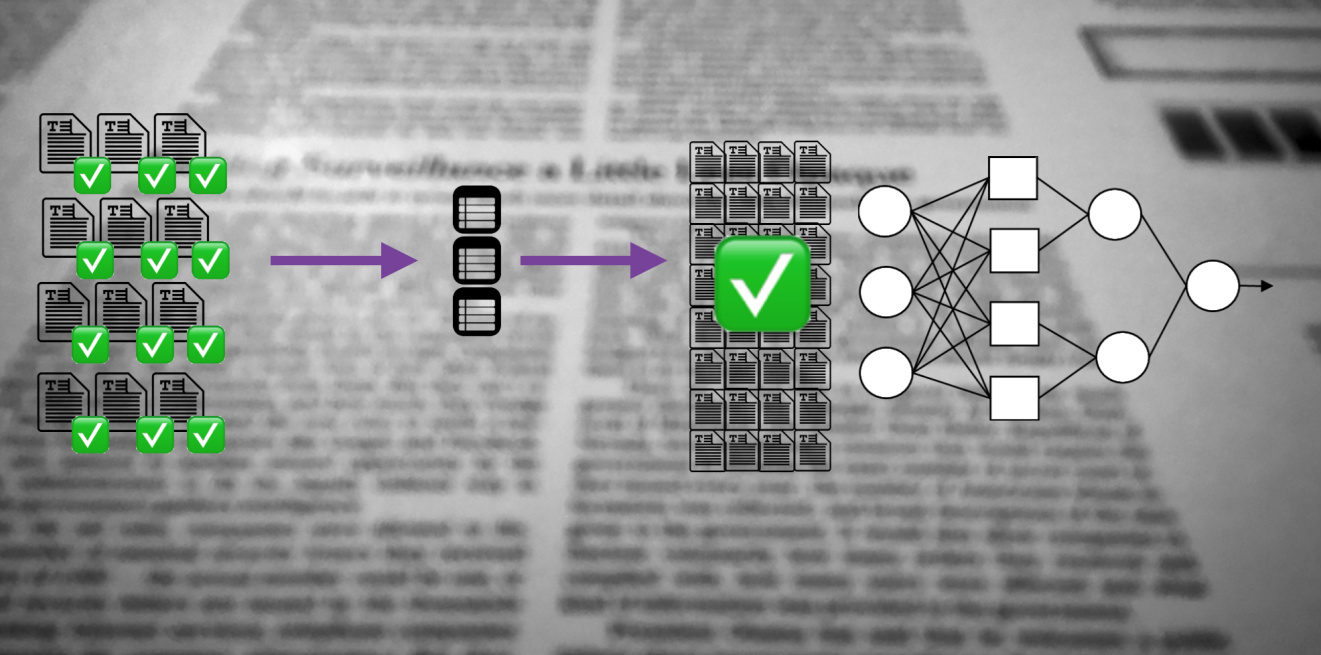

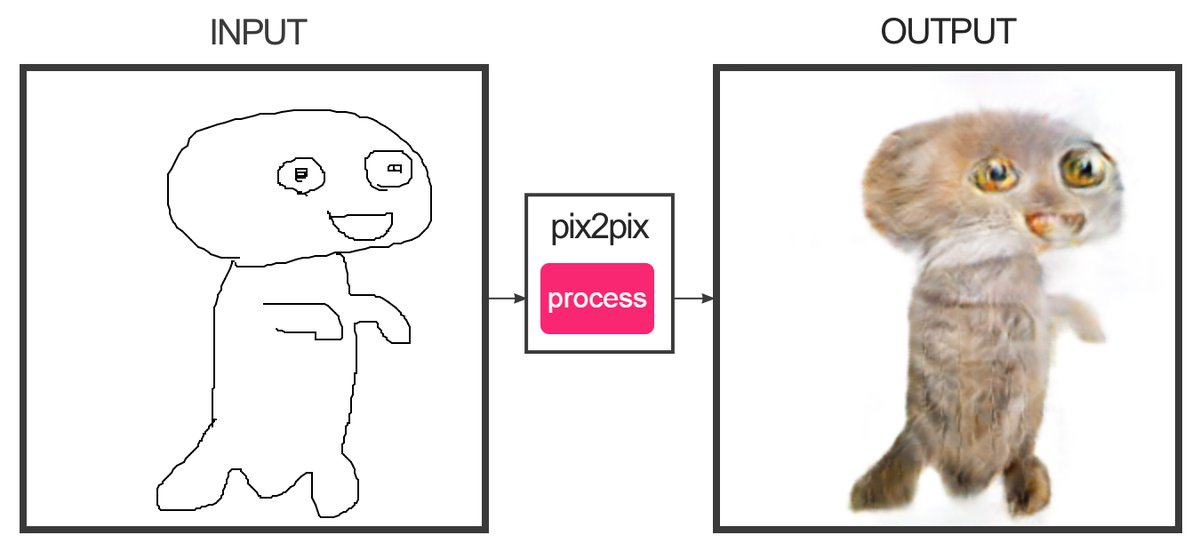

Le développeur Christopher Hesse a créé un

service qui, à l'aide de l'apprentissage automatique, peut "dessiner" des croquis composés de plusieurs lignes pour colorier des photographies. Oui, c'est le site qui attire les chats. Les phoques se révèlent comme tels - il est difficile de les confondre avec les vrais.

La programmeuse Alexa Jolikier Martino a réussi à

faire des chats qui sont exactement comme les vrais. Pour ce faire, il a utilisé DCGAN - Deep Convolutional Generative Adversarial Networks (réseaux concurrentiels profonds de convolution générative). Les DCGAN sont capables de créer des images photoréalistes uniques en combinant deux réseaux de neurones profonds qui se font concurrence.

Le premier réseau (générateur) reçoit les valeurs des variables en entrée, et en sortie il donne les valeurs de la fonction de ces variables, ce qui devrait "convaincre" le deuxième réseau (discriminant ou discriminant) que les résultats du premier réseau sont indiscernables du standard. Comme échantillons dans les travaux de Joliker-Martino, une base de données de dix mille portraits félins a été utilisée.

En utilisant les méthodes DCGAN, il est possible de créer de fausses images qui ne peuvent être objectivement considérées comme fausses sans un autre réseau de neurones.

Combinaisons de contenu

À l'Université de Washington, ils ont

développé un algorithme qui vous permet de superposer l'audio sur la vidéo d'une personne avec une synchronisation labiale précise. L'algorithme a été formé sur 17 heures de messages vidéo de Barack Obama. Le réseau neuronal a été formé pour simuler les mouvements des lèvres d'Obama de manière à corriger leurs mouvements en imitant la prononciation des bons mots. Jusqu'à présent, vous ne pouvez générer une vidéo qu'avec des mots que la personne a vraiment dit.

Regardez maintenant le fonctionnement de l'algorithme, qui

vous permet de changer les expressions faciales d'une autre personne à la volée en vos propres expressions faciales. Dans la vidéo avec Trump (il y a toujours une manifestation sur Bush, Poutine et Obama), la courbure de la personne est imposée dans le studio, et le résultat est un Trump grincheux. L'algorithme est utilisé dans Face2Face. La technologie créée est similaire en principe au robot

Smile Vector , qui ajoute un sourire aux gens sur les photos.

Ainsi, il est maintenant possible de créer une vidéo réaliste dans laquelle une personne célèbre parle de faits fictifs. Le discours peut être coupé des discours précédents afin de composer n'importe quel message. Mais dans un avenir proche, même de telles astuces se révéleront superflues - le réseau mettra parfaitement tout texte dans la bouche d'un faux personnage.

Les conséquences

D'un point de vue pratique, toutes ces technologies vous permettent de faire beaucoup de bien. Par exemple, vous pouvez améliorer la qualité de la visioconférence en synthétisant les images manquantes si elles tombent du flux vidéo. Et même synthétiser des mots entiers manquants, offrant une excellente communication dans des endroits avec n'importe quel niveau de signal.

Il sera possible de «numériser» complètement l'acteur et d'en ajouter une copie réaliste aux films et aux jeux.

Mais qu'arrivera-t-il aux nouvelles?

Il est probable que dans les années à venir, la fausse génération atteindra un nouveau niveau. Il existe de nouvelles façons de se battre. Par exemple, si vous corrélez une photo avec des conditions connues dans la région (vitesse du vent, inclinaison des ombres, niveau de lumière, etc.), ces données aideront à identifier un faux.

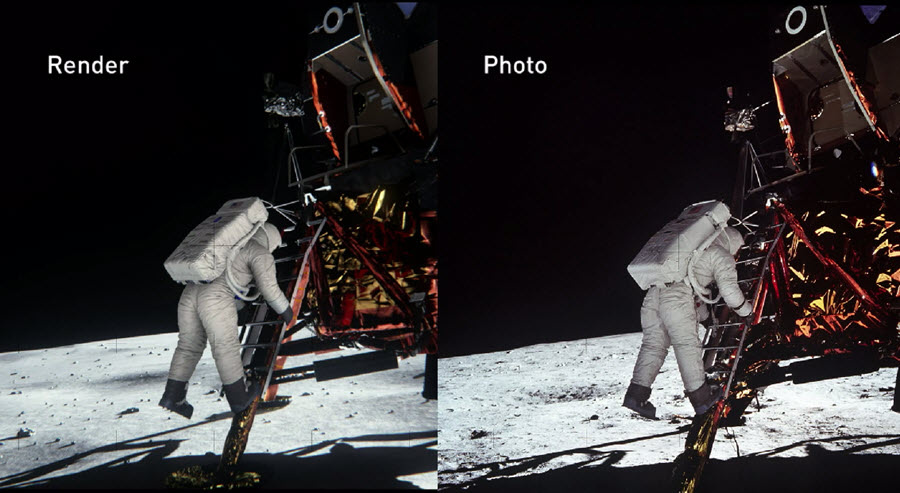

En 2014, les ingénieurs de NVIDIA ont reconstruit la scène de l'alunissage aussi précisément que possible, sur la base de preuves documentaires de l'époque. Dans ce cas, toutes les propriétés physiques et optiques des objets ont été prises en compte pour savoir comment la lumière est réfléchie par divers matériaux et se comporte en temps réel. En conséquence, ils ont pu

vérifier de manière fiable l' authenticité des photos de la NASA.

NVIDIA a confirmé qu'avec une préparation appropriée, on peut prouver l'authenticité (ou réfuter) même des travaux photographiques les plus complexes créés il y a des décennies.

L'année dernière, l'Agence américaine pour la recherche et le développement avancés en matière de défense (DARPA) a lancé un projet de quatre ans visant à créer un système

médico-légal ouvert qui peut identifier les photos qui ont été traitées ou déformées d'une manière ou d'une autre.

Les réseaux de neurones pourront non seulement modifier le contenu d'origine, mais aussi identifier les contrefaçons de la plus haute qualité. Qui gagnera finalement dans cette course technologique montrera le temps.