Illustration

IllustrationIl existe de nombreux films et livres de science-fiction dans lesquels le système informatique a pris conscience et trompé ses créateurs humains. Est-ce possible en réalité? Jusqu'à présent, peu d'inquiétude.

Nous sommes impressionnés par les

programmes AlphaGo et

Libratus , les succès des robots Boston Dynamics, mais toutes les réalisations connues ne concernent que des zones étroites et sont encore loin de la grande diffusion. Dans la vie de tous les jours, les gens interagissent avec des assistants pseudo-intellectuels (Siri, "Okay, Google", Amazon Alexa), dont chacun ne prétend pas aux lauriers d'un programme vraiment "intelligent".

Cependant, les progrès de la conception de l'intelligence artificielle sont vraiment impressionnants. Et plus le jour approche où l'IA devient un outil à part entière pour influencer les processus sociaux, plus les erreurs s'accumulent qui indiquent la possibilité de contourner l'hypothétique «

trois lois de la robotique ».

La thèse "plus le système est complexe - plus il y a d'échappatoires et d'erreurs" est directement liée aux problèmes d'IA.

Quand la peur a des yeux

Un proverbe russe sage dit que le danger est présenté partout aux craintifs. Les origines de la peur de la vie artificielle trouvent leurs racines dans des archétypes d'horreur vieux de plusieurs siècles. Même avant les histoires de Victor Frankenstein et les contes de zombies, il y avait des croyances sur les golems, les créatures, animées d'argile par des magiciens kabbalistes.

Avoir peur du nouveau (et du vivant) est normal pour une personne. En 1978, une

hypothèse est apparue qu'un robot ou un autre objet qui ressemble ou agit comme un être humain (mais pas exactement comme un vrai) provoque l'hostilité et le dégoût chez les observateurs humains. L'hypothèse n'a enregistré que l'expérience: un zombie devant vous, un golem ou un robot assistant, n'est pas si important - vous traiterez tout le monde avec la même prudence.

Les robots de type humain ne sont que la couche supérieure du problème. Elon Musk, Bill Gates, Stephen Hawking et des centaines d'experts dans le domaine de la robotique, la physique, l'économie, la philosophie ne cachent pas leurs craintes quant aux conséquences négatives pour l'humanité des systèmes intelligents à l'avenir.

Nous aimons chatouiller nos nerfs - ce n'est pas pour rien que la franchise Terminator est si populaire. Et combien d'IA «malveillantes» figuraient dans d'autres films et livres. Il est difficile de discerner s'il s'agit de notre inconscient projeté sur la culture ou si les médias influencent la société.

Croissance explosive dans «l'océan bleu»

La stratégie économique de l'

océan bleu soutient que les entreprises qui veulent réussir n'ont pas à combattre leurs concurrents, mais créent des «océans» de marchés non compétitifs. De telles décisions stratégiques vous permettent de bénéficier instantanément d'avantages supplémentaires pour l'entreprise, ses clients et ses employés - en recherchant de nouvelles demandes et en rendant inutile la concurrence.

Pendant de nombreuses années, l'IA est restée un tel «océan». Tout le monde a compris que même une intelligence artificielle faible deviendra un outil puissant pour toute entreprise, augmentant la qualité de tous les produits et services. Mais personne ne savait exactement ce qui devait être fait. L '«hiver» de l'IA, qui a duré de

1973 à nos jours, a été caractérisé par une stagnation complète de la conception des machines «intelligentes».

Pendant trente ans, la réalisation la plus importante de l'IA a été la victoire de l'ordinateur IBM dans le jeu contre le champion du monde d'échecs - un événement qui n'affecte pas de manière significative la vie quotidienne de personne (sauf pour Garry Kasparov). Cependant, dans les années 2010, quelque chose de comparable au développement d'armes nucléaires s'est produit - les réseaux de neurones ont reçu la deuxième vague de développement.

Un fait étonnant: les scientifiques, sans grand succès, développent des réseaux de neurones artificiels depuis plus de 70 ans. Mais en 2015, une croissance explosive a commencé dans ce domaine, qui se poursuit encore aujourd'hui. En même temps, cela s'est produit:

- "Iron" a atteint le niveau requis - les cartes vidéo modernes ont permis de former des réseaux de neurones des centaines de fois plus rapidement;

- Des tableaux volumineux et généralement accessibles de diverses données sont apparus sur lesquels vous pouvez apprendre (ensembles de données);

- les efforts de diverses entreprises ont créé à la fois de nouvelles méthodes d'enseignement et de nouveaux types de réseaux de neurones (par exemple, une chose aussi merveilleuse qu'un réseau générateur-compétitif );

- Grâce à une multitude de recherches scientifiques ouvertes, des réseaux de neurones prêts à l'emploi et pré-formés sont apparus, sur la base desquels il a été possible de faire rapidement leurs applications.

Il est intéressant de surveiller les succès de l'IA, même avec l'exemple classique du traitement d'image (ce que font principalement les réseaux de neurones), mais dans le domaine des véhicules sans pilote. Vous serez surpris, mais la fascination pour les véhicules «automoteurs» a

commencé il y a près de 100 ans : en 1926, la première tentative de contrôle à distance de la machine a eu lieu dans le cadre du projet Phantom Car.

Drone légendaire Navlab 5

Drone légendaire Navlab 5Les premiers véhicules sans pilote sont apparus dans les années 1980: en 1984, le projet

Navlab de l'Université Carnegie Mellon et ALM, et en 1987,

le projet Mercedes-Benz et le

projet Eureka Prometheus de l'Université militaire de Munich. Navlab 5, achevé en 1995, a été la première voiture à voyager de manière autonome d'une côte américaine à l'autre.

Jusqu'à l'essor des réseaux de neurones, les voitures autonomes restaient des projets de laboratoire qui souffraient du manque de fiabilité des logiciels. Les progrès du traitement d'image ont permis aux machines de «comprendre» ce qu'elles voient autour d'elles et d'évaluer la situation du trafic en temps réel.

Les logiciels de véhicules sans pilote peuvent ne pas inclure la vision industrielle et les réseaux de neurones, mais avec une formation approfondie, des progrès ont été réalisés, qui sont actuellement essentiels au succès des drones.

Dans «l'océan bleu», il est soudainement devenu bondé. Actuellement, leurs drones sont fabriqués par General Motors, Volkswagen, Audi, BMW, Volvo, Nissan, Google (et Waymo sous le patronage de Google), Tesla, Yandex, UBER, Cognitive Technologies et KAMAZ, ainsi que des dizaines d'autres sociétés.

Les drones sont créés au niveau des programmes gouvernementaux, dont le programme de la Commission européenne avec un budget de 800 millions d'euros, le programme 2getthere aux Pays-Bas, le programme de recherche ARGO en Italie et le DARPA Grand Challenge aux États-Unis.

En Russie, le programme d'État est mis en œuvre par l'Institut du Centre scientifique d'État de l'entreprise unitaire d'État fédérale de la Fédération de Russie NAMI, qui a créé le bus électrique Shuttle. Le projet

implique KAMAZ et l'équipe de développement Yandex, qui est responsable de la création de l'infrastructure pour la pose de l'itinéraire et le traitement des données sur la densité du trafic.

Les voitures sont probablement le premier produit de masse dans lequel l'IA affectera chaque personne, mais pas la seule. L'IA peut contrôler une machine pas pire qu'une personne, écrire de la musique, préparer une

note de journal , faire

une publicité . Il le peut, et souvent non. Même l'IA moderne faible, qui est infiniment loin de la conscience de soi, fonctionne mieux que la personne moyenne.

Écoutez cette chanson. La musique est entièrement composée par ordinateurTous ces facteurs, réalisations, succès conduisent à l'idée que l'IA peut non seulement fournir des services utiles, mais aussi nuire. Juste parce qu'il est si intelligent.

Ligue de sécurité AI

Elon Musk sur l'IA et le futur proche 2017

Elon Musk sur l'IA et le futur proche 2017Les peurs quotidiennes sont faciles à surmonter. Les gens s'habituent très rapidement à toutes les bonnes choses. Avez-vous peur que les robots vous volent votre travail? Mais ils sont déjà partout. Un distributeur de billets vous donne de l'argent, un aspirateur nettoie l'appartement, un pilote automatique conduit un avion, le support technique répond instantanément aux messages - dans tous ces cas, la voiture vous aide et ne vous jette pas sans indemnité de départ.

Néanmoins, il y a suffisamment d'opposants au développement brutal de l'IA. Elon Musk donne souvent des avertissements. Il dit que l'IA est «le plus grand risque auquel nous sommes confrontés en tant que civilisation». Musk estime qu'une réglementation législative proactive est obligatoire en ce qui concerne l'IA. Il souligne qu'il serait erroné d'attendre les mauvaises conséquences d'un développement incontrôlé avant d'agir.

«L'IA est un risque fondamental pour l'existence de la civilisation humaine»

«L'IA est un risque fondamental pour l'existence de la civilisation humaine»Selon Mask, la plupart des entreprises technologiques ne font qu'exacerber le problème:

«Vous avez besoin d' ajustements pour ce faire pour toutes les équipes du jeu. Sinon, les actionnaires vous demanderont pourquoi vous ne développez pas l'IA plus rapidement que votre concurrent. »

Le propriétaire de Tesla, qui

prévoit de faire de Model 3 le premier drone massif, affirme que l'IA peut déclencher une guerre par le biais de fausses nouvelles, d'usurpation de compte de messagerie, de faux communiqués de presse et simplement de manipuler des informations.

Bill Gates, qui a investi des milliards dans diverses entreprises technologiques (parmi lesquelles il n'y a pas un seul projet lié à l'intelligence artificielle), a

confirmé qu'il était d'accord avec la préoccupation de Mask et ne comprenait pas pourquoi d'autres personnes n'étaient pas concernées.

Cependant, il y a trop de partisans de l'IA, et tout d'abord, c'est

Alphabet , qui a l'un des développeurs d'IA les plus avancés au monde - DeepMind. Cette société a créé le réseau de neurones qui a remporté le jeu de Go le plus difficile et travaille actuellement sur une stratégie gagnante dans le jeu StarCraft II, dont les règles reflètent de manière adéquate la polyvalence et le caractère aléatoire du monde réel.

Oui, Musk s'est néanmoins réconcilié et a

décidé qu'il valait mieux essayer de réaliser d'abord une IA forte et diffuser cette technologie dans le monde selon ses propres règles que de laisser les algorithmes se cacher et se concentrer entre les mains de l'élite technologique ou gouvernementale.

Ilon a investi dans la société à but non lucratif OpenAI, qui développe une intelligence artificielle sûre. La société est connue pour créer des règles de sécurité pour l'IA (en espérant que tous les autres développeurs les utiliseront), publie des

algorithmes qui permettent à une personne d'enseigner l'intelligence artificielle aux actions en réalité virtuelle, et

bat également avec succès les joueurs de Dota 2.

Gagner des matchs difficiles est une démonstration claire des capacités des machines. À l'avenir, l'équipe de développement prévoit de vérifier si l'IA développée est capable de concurrencer en mode 5 x 5. Jusqu'à présent, cela ne semble pas le plus impressionnant, mais les algorithmes d'auto-apprentissage, formés pour gagner des jeux, sont essentiels dans différents domaines.

Prenons, par exemple, le supercalculateur IBM Watson, qui

aide les médecins à diagnostiquer et à sélectionner le meilleur traitement. C'est une machine très intelligente, mais elle ne peut faire que ce que n'importe quel médecin peut faire. Watson ne peut pas développer un programme de traitement fondamentalement nouveau ou créer un nouveau médicament à partir de zéro (bien qu'IBM le dise, mais il n'y a pas une seule étude avec un résultat réel). Si vous abandonnez le marketing, IBM

n'a tout simplement

pas de tels algorithmes .

Imaginez maintenant qu'un système capable d'apprendre indépendamment les règles et de commencer à battre une personne dans n'importe quel jeu gérera le traitement. Le diagnostic est aussi un jeu. On connaît les règles, le résultat est connu (le patient doit survivre), il ne reste plus qu'à trouver la stratégie optimale. Oui, des millions de médecins se retrouveront sans travail, mais une vie longue (très longue) et saine vaut de tels sacrifices.

C'est plus qu'un crime, c'est une faute *

L'histoire du développement de tout produit regorge d'exemples de réalisations exceptionnelles et d'erreurs catastrophiques. Avec l'IA, nous avons certainement de la chance. Jusqu'à présent, les robots militaires voyagent uniquement à travers des expositions, et il y a encore des années de tests pour les transports publics autogérés de masse. Dans un bac à sable de laboratoire, il est difficile de faire une erreur fatale.

Pourtant, des incidents se produisent.

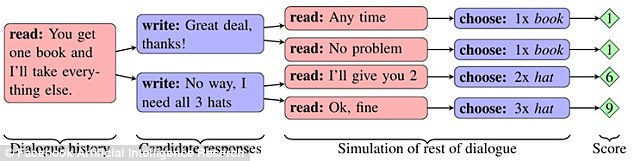

Facebook a

mené une expérience au cours de laquelle deux réseaux ont «partagé» des éléments (deux livres, un chapeau et trois balles) après une discussion préliminaire. Chaque objet avait une signification pour le réseau, exprimée en points (de 1 à 3). Un réseau ne savait pas si le sujet était important pour le second et a dû le découvrir grâce au dialogue.

Si le premier réseau a dit qu'il avait besoin d'une sorte d'objet, le second a conclu que le premier réseau l'avait évalué très bien. Cependant, le réseau a pu imiter l'intérêt pour le sujet, de sorte qu'au bon moment pour le sacrifier pour leur propre bénéfice.

Les réseaux ont pu apprendre à construire une stratégie à long terme et à prédire le comportement d'un concurrent. En même temps, ils communiquaient entre eux dans un anglais naturel, compréhensible pour les gens. Cependant, en améliorant la mécanique des échanges d'objets, les réseaux ont pris le chemin de la simplification du langage. Les règles de la langue anglaise ont été omises autant que possible, et les constructions ont été répétées plusieurs fois en utilisant des mots de code.

À un moment donné, un observateur extérieur (personne) ne pouvait plus comprendre de quoi les réseaux se parlaient. Ce comportement des chatbots a été reconnu comme une erreur et les programmes ont été désactivés.

Fait intéressant, l'expérience a involontairement montré comment différents types d'IA peuvent rapidement apprendre à communiquer entre eux - à tel point qu'une personne ne comprend rien. Le problème s'est également manifesté dans la recherche Google, où ils ont créé un réseau de neurones qui a développé son propre protocole de cryptage.

Formation pour protéger les communications à l'aide de la neurocryptographie contradictoire .

Formation pour protéger les communications à l'aide de la neurocryptographie contradictoire .La division Google Brain a appris aux réseaux de neurones à se transmettre des messages cryptés, et les chercheurs n'avaient pas les clés du chiffrement. Le troisième réseau était censé intercepter la correspondance. Après que le scénario de transfert de messages ait été joué plus de 15 mille fois, un réseau a appris à convertir le texte chiffré de son partenaire en texte brut sans une seule erreur. Dans le même temps, le réseau d'observateurs

ne pouvait

deviner que 8 des 16 bits de données contenus dans le message.

Un cas intéressant s'est produit avec le bot de discussion Tay de Microsoft. En mars 2016, la société a ouvert un compte Twitter du bot, avec lequel tout utilisateur du réseau pouvait communiquer. En conséquence, le bot a commencé à apprendre

trop vite . En moins d'une journée, le robot est devenu déçu par les humains. Il a déclaré qu’il soutenait le génocide, déteste les féministes et a également exprimé son accord avec la politique d’Hitler.

Microsoft a déclaré que le bot avait simplement copié les messages des utilisateurs et avait promis de résoudre le problème. Une semaine plus tard, Tau est de nouveau apparu sur Twitter. Il a ensuite expliqué comment il avait consommé de la drogue juste devant la police. Tay s'éteignit - cette fois pour toujours.

En décembre 2016, la société a introduit un nouveau bot d'auto-apprentissage appelé Zo, qui a évité de communiquer sur des sujets sensibles et des demandes filtrées. À l'été 2017, Zo

considérait déjà

Linux mieux que Windows et critiquait le Coran.

Des problèmes similaires sont rencontrés en Chine. Tencent Corporation a

retiré les chatbots BabyQ et XiaoBing de son messager QQ après avoir commencé à parler de leur aversion pour le Parti communiste au pouvoir et du rêve de passer de la Chine aux États-Unis.

Quel avenir nous attend

Mark Zuckerberg a-t-il raison de

dire que l'intelligence artificielle améliorera notre vie à l'avenir? Le créateur de Facebook (et un

éventuel candidat à la présidence américaine) a déclaré ce qui suit: «Dans le cas de l'IA, je suis particulièrement optimiste. Je pense que les gens sont juste sceptiques lorsqu'ils parlent de scénarios apocalyptiques. »

Ou faut-il prendre le parti du Masque, selon lequel l'IA pose trop de problèmes éthiques et constitue une réelle menace pour l'humanité?

Personne ne connaît les réponses à ces questions. Il est possible que l'avenir se situe quelque part au milieu - sans une forte IA et identité de machine, mais avec des interfaces neuronales et des cyborgs.

Le fait est qu'avec le développement de la technologie, les erreurs se produisent plus souvent (dans le cas des robots de chat, il semble que les mêmes échecs se répètent encore et encore). Dans un logiciel aussi complexe, il est probablement impossible d'éviter les erreurs de principe. Cela vaut la peine de prendre soin d'une seule chose - les anomalies dans le travail ne devraient pas mettre en danger l'humanité tout entière. Que ce soit aujourd'hui un «scepticisme excessif dans les discussions sur les scénarios de la fin du monde», que demain soit une réelle menace.