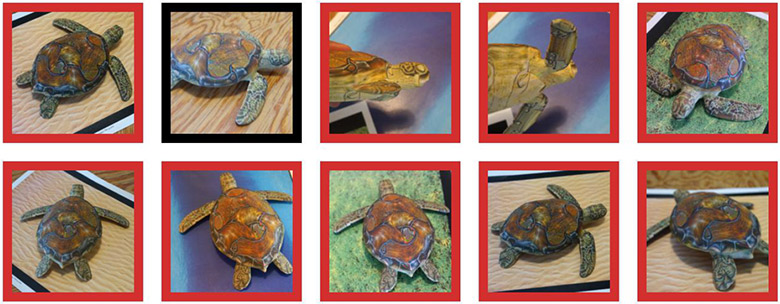

Une tortue imprimée sur une imprimante 3D est reconnue par le réseau neuronal comme une tortue (contour vert), un fusil (contour rouge) ou comme un autre objet (contour noir)

Une tortue imprimée sur une imprimante 3D est reconnue par le réseau neuronal comme une tortue (contour vert), un fusil (contour rouge) ou comme un autre objet (contour noir)On sait depuis longtemps que de petits changements délibérés dans l'image «brisent» le système d'apprentissage automatique, de sorte qu'il

classe une image complètement différente . Ces images «cheval de Troie» sont appelées «exemples contradictoires» et représentent l'une des

limites bien connues

de l'apprentissage en profondeur .

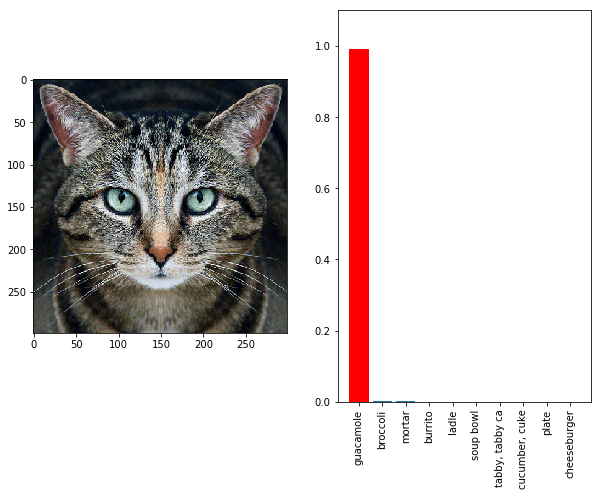

Ils fonctionnent simplement: vous devez faire une montée de gradient dans l'espace de données d'entrée pour générer des modèles qui maximisent la prédiction de classe pour une classe donnée. Par exemple, si nous prenons une photo d'un panda et ajoutons le gradient "gibbon", nous ferons classer le réseau neuronal ce panda comme gibbon. La tortue peut être délivrée comme un fusil (voir l'illustration ci-dessus). Le chat se transforme en une collation froide de guacamole (voir sous le chat) - peu importe. Tout objet se transforme en tout autre aux yeux de l'intelligence artificielle, car l'IA a un système spécial de "vision" différent de l'humain.

Jusqu'à présent, un tel ajustement fin du gradient ne fonctionnait que sur les images 2D et était très sensible à toute distorsion.

Une photographie d'un chat est reconnue comme guacamole dans le classificateur InceptionV3

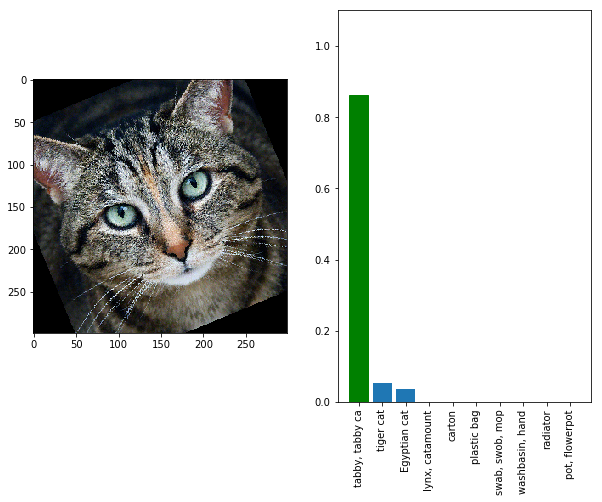

Une photographie d'un chat est reconnue comme guacamole dans le classificateur InceptionV3Regardez le chat sous un angle différent ou à une distance différente - et le réseau neuronal voit à nouveau le chat en lui, et non une collation froide.

Une photo d'un chat est à nouveau reconnue comme un chat dans le classificateur InceptionV3 , si vous la tournez un peu

Une photo d'un chat est à nouveau reconnue comme un chat dans le classificateur InceptionV3 , si vous la tournez un peuAutrement dit, de tels exemples concurrents ne seront pas efficaces en raison du zoom, du bruit de l'appareil photo numérique et d'autres distorsions qui surviennent inévitablement dans la réalité. C'est inacceptable si nous voulons

tromper de manière fiable et régulière les systèmes de vision hors ligne . Mais maintenant, l'espoir est né que les gens peuvent accomplir cette tâche. Des chercheurs du Massachusetts Institute of Technology et du groupe de recherche indépendant LabSix (composé d'étudiants et de diplômés du MIT) ont créé le premier algorithme au monde qui génère

des exemples compétitifs en 3D . Par exemple, la vidéo ci-dessous montre une tortue qui est régulièrement reconnue par le classificateur Google InceptionV3 comme un fusil sous presque tous les angles.

L'algorithme est capable de générer non seulement des tortues, mais aussi des modèles arbitraires. Pour l'échantillon, les chercheurs ont également imprimé un baseball, qui est classé comme expresso (café) sous n'importe quel angle, et ont également créé un grand nombre d'autres modèles - des illusions d'optique particulières pour l'IA.

L'illusion d'optique fonctionne même si l'objet sur la photo est dans un contexte sémantiquement non pertinent. De toute évidence, pendant la formation, le réseau neuronal ne pouvait voir ni un fusil sous l'eau ni un expresso dans le gant d'un receveur.

Exemples concurrents en 3D: une tortue qui ressemble à un fusil au réseau neuronal InceptionV3 et une balle de baseball qui ressemble à un expresso

Exemples concurrents en 3D: une tortue qui ressemble à un fusil au réseau neuronal InceptionV3 et une balle de baseball qui ressemble à un expressoBien que la méthode soit «affûtée» spécifiquement pour un réseau neuronal particulier, dans les commentaires sur les articles scientifiques précédents sur ce sujet, l'

attention a été portée à la remarque des chercheurs selon laquelle, très probablement, l'attaque affectera de nombreux modèles formés sur cet ensemble de données particulier - y compris diverses architectures de réseaux de convolution et même classificateurs linéaires. Ainsi, pour une attaque, l'hypothèse sur laquelle les données pourraient être entraînées par le modèle est suffisante.

«Concrètement, cela signifie qu'il est probable qu'il y aura une opportunité de créer un panneau routier pour la vente d'une maison, ce qui semble tout à fait habituel pour les conducteurs humains, mais pour un véhicule sans pilote, il ressemblera à un piéton qui est soudainement apparu sur le trottoir», dit le travail scientifique. «Les exemples concurrents présentent un intérêt pratique, qui doit être pris en compte à mesure que les réseaux de neurones deviennent de plus en plus courants (et dangereux).»

Pour se protéger contre de telles attaques, les développeurs de la future IA peuvent garder des informations secrètes sur l'architecture de leurs réseaux de neurones, et surtout - sur l'ensemble de données qui a été utilisé lors de la formation.

L'article scientifique a été

publié le 30 octobre 2017 sur le site de préimpression arXiv.org (arXiv: 1707.07397v2).