Les systèmes d'intelligence artificielle (IA) gagnent du terrain. À cet égard, les avocats et les législateurs discutent du problème de la réglementation de ces systèmes, qui sera responsable de leurs actions. Ce problème nécessite une étude approfondie et une approche équilibrée, car les systèmes d'IA sont capables de générer d'énormes quantités de données et sont utilisés dans des applications de fonctionnalités différentes - des systèmes médicaux et des pilotes automatiques dans les voitures à la prévision des crimes et au calcul des criminels potentiels. Dans le même temps, les scientifiques s'efforcent de créer une «IA forte» capable de raisonner, et la question se pose de savoir comment déterminer la présence d'intentions dans ses actions - ou reconnaître les actions comme non intentionnelles.

Il existe de nombreuses façons d'amener le système d'IA à la responsabilisation et à la responsabilité; plusieurs études ont été publiées sur ce sujet. Dans un nouveau

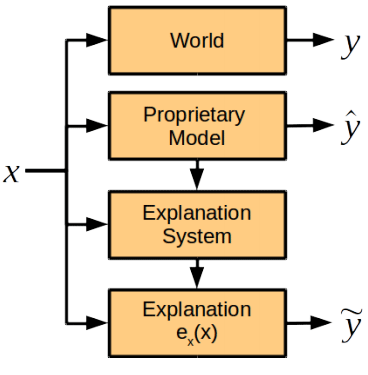

document de recherche , des experts en informatique, en sciences cognitives et des avocats des universités de Harvard et de Cambridge (États-Unis) discutent d'un élément du futur système de responsabilité de l'IA, à savoir le rôle d'une note explicative de l'IA, c'est-à-dire une évaluation de la façon dont le système d'intelligence artificielle explique ses actions. . Les scientifiques sont arrivés à la conclusion que le module d'explication des actions devait être séparé du système général d'IA.

Les auteurs des travaux scientifiques décrivent tous les problèmes qui surviennent lorsque l'on tente de demander au système d'IA une explication de ses actions.

Premièrement, une telle opportunité devrait être fournie au stade du développement du système, sinon l'IA peut refuser ou ne pourra pas expliquer ses actions.

Deuxièmement, le système d'IA traite un large éventail de données à l'aide d'algorithmes ou de méthodes propriétaires complexes qu'il a lui-même développés au cours du processus d'apprentissage. Ainsi, en essayant d'expliquer ses actions de la manière la plus complète, elle peut générer trop de données incompréhensibles pour une personne. Ou - comme l'autre extrême - fournira un modèle trop simpliste qui ne reflétera pas les intentions réelles de l'IA et les motifs des actions. De plus, les algorithmes de fonctionnement du système d'IA peuvent être la propriété intellectuelle de la société en développement, il est donc nécessaire de fournir une telle méthode de compilation d'une note explicative afin d'établir les raisons des actions du système, mais pas de donner les algorithmes sous-jacents.

Les chercheurs pensent qu'une explication est possible sans révéler les algorithmes et les règles qui sous-tendent le fonctionnement du système d'IA. En cas d'incident, le système doit fournir des réponses aux questions suivantes:

- Quels sont les principaux facteurs influençant la décision?

- Un changement d'un certain facteur entraînerait-il un changement de décision?

- Pourquoi deux cas similaires ont-ils conduit à des solutions différentes?

Les réponses à de telles questions ne nécessitent pas nécessairement la divulgation de secrets propriétaires et d'algorithmes de système interne, mais en même temps, elles donneront une compréhension claire de ses motivations.

Les scientifiques soutiennent dans quels cas il convient d'exiger de l'IA d'expliquer ses actions. En fait, cela est nécessaire dans les cas où le bénéfice de l'explication l'emporte sur le prix de sa réception: «Nous pensons qu'il y a trois conditions pour les situations où la société estime nécessaire d'obtenir une explication du décideur. Ce sont des raisons morales, sociales ou juridiques », explique Finale Doshi-Velez, auteur principal de l'article.

Dans le même temps, il ne faut pas exiger des explications de l'IA littéralement dans chaque situation. Comme mentionné ci-dessus, cela augmente les risques de délivrance de secrets commerciaux et impose une charge supplémentaire aux développeurs de systèmes d'IA. En d'autres termes, la responsabilité constante de l'IA vis-à-vis de l'homme inhibera le développement de ces systèmes, y compris dans des domaines importants pour l'homme.

Contrairement à la croyance répandue selon laquelle le système d'IA est une boîte noire dont les causes sont incompréhensibles pour l'homme, les auteurs des travaux scientifiques sont sûrs qu'un module fonctionnant normalement pour expliquer les actions de l'IA peut être développé. Ce module sera intégré au système, mais fonctionnera indépendamment des algorithmes de décision et ne leur obéira pas.

Les scientifiques pensent qu'il y a certains points dans l'explication des actions qui sont faciles à définir pour les gens et difficiles pour les machines, et vice versa.

Comparaison des capacités humaines et de l'IA pour expliquer | Homme | AI |

|---|

| Les avantages | Peut expliquer l'acte postérieur | Reproductibilité, absence de pression sociale |

| Inconvénients | Peut être inexact et peu fiable, ressent une pression sociale | Nécessite une programmation préliminaire du module d'explication, des taxonomies supplémentaires et une extension du système de stockage |

Cependant, le groupe d'experts recommande dans un premier temps de définir la même norme pour les systèmes d'IA pour expliquer leurs actions qui est actuellement définie pour les personnes (cette norme est énoncée dans la législation américaine: en particulier, une explication est requise en cas de responsabilité objective, de divorce et de discrimination, pour prendre des décisions administratives et des juges et jurys pour expliquer leurs décisions - bien que le niveau de détail de la note explicative soit très différent dans chaque cas).

Mais si les raisons des actions de l'IA dépassent la compréhension de l'homme, alors pour rendre compte de l'IA à l'avenir, une autre norme peut être développée pour leurs notes explicatives, disent les scientifiques.

L'article scientifique a été

publié le 3 novembre 2017 sur le site de préimpression arXiv.org (arXiv: 1711.01134v1).