En mai 2017, les chercheurs de Google Brain ont présenté le projet

AutoML , qui automatise la conception de modèles d'apprentissage automatique. Les expériences AutoML ont montré que ce système peut générer de petits réseaux de neurones avec de très bonnes performances - tout à fait comparables aux réseaux de neurones conçus et formés par des experts humains. Cependant, au début, AutoML était limité à de petits ensembles de données scientifiques comme CIFAR-10 et Penn Treebank.

Les ingénieurs de Google se sont demandés - et si nous assignions des tâches plus sérieuses au générateur d'IA? Ce système d'

intelligence artificielle est-il capable de générer une autre intelligence artificielle qui sera meilleure que l'

intelligence artificielle artificielle dans certaines tâches importantes comme la classification d'objets d'

ImageNet - le plus célèbre des ensembles de données à grande échelle en vision

industrielle ? Il y avait donc un réseau neuronal

NASNet , créé presque sans intervention humaine.

Il s'est avéré que l'IA fait face à la conception et à la formation de réseaux de neurones pas pire que les humains. La tâche de classer les objets de l'ensemble de données ImageNet et de définir les objets de l'ensemble de données

COCO faisait partie du projet

Learning Architectures transférables pour la reconnaissance d'image évolutive .

Les développeurs du projet AutoML

disent que la tâche s'est avérée non triviale, car les nouveaux ensembles de données sont de plusieurs ordres de grandeur plus grands que les précédents avec lesquels le système est habitué à travailler. J'ai dû changer certains algorithmes d'opération AutoML, y compris la refonte de l'espace de recherche afin qu'AutoML puisse trouver la meilleure couche et la dupliquer plusieurs fois avant de créer la version finale du réseau neuronal. De plus, les développeurs ont exploré les options pour l'architecture des réseaux de neurones pour CIFAR-10 - et transféré manuellement l'architecture la plus réussie aux tâches ImageNet et COCO.

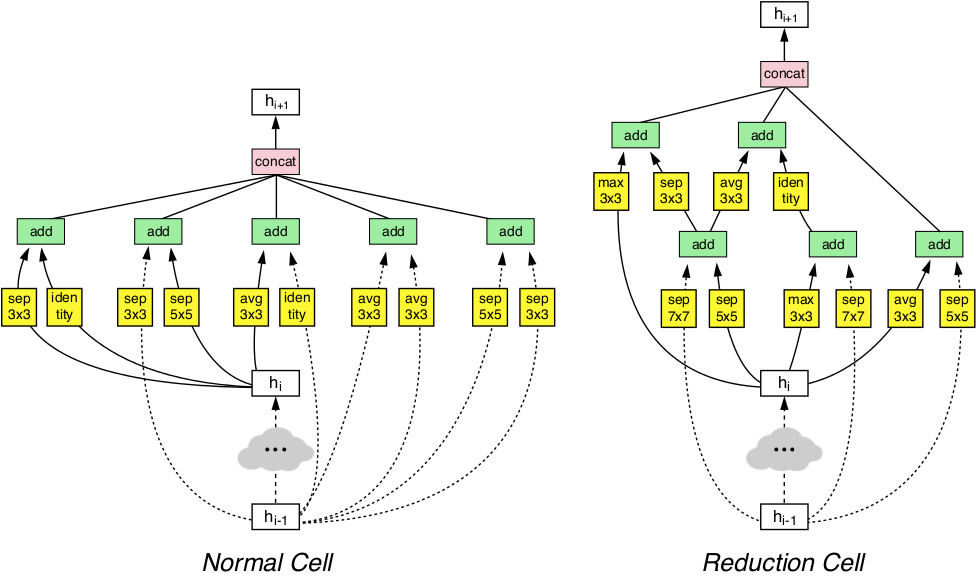

Grâce à ces manipulations, le système AutoML a pu détecter les couches les plus efficaces du réseau neuronal qui fonctionnaient bien pour CIFAR-10 et en même temps fonctionnaient bien dans les tâches ImageNet et COCO. Ces deux couches découvertes ont été combinées pour former une architecture innovante appelée NASNet.

L'architecture NASNet se compose de deux types de couches: une couche normale (à gauche) et une couche de réduction (à droite). Ces deux couches sont conçues par un générateur AutoML.

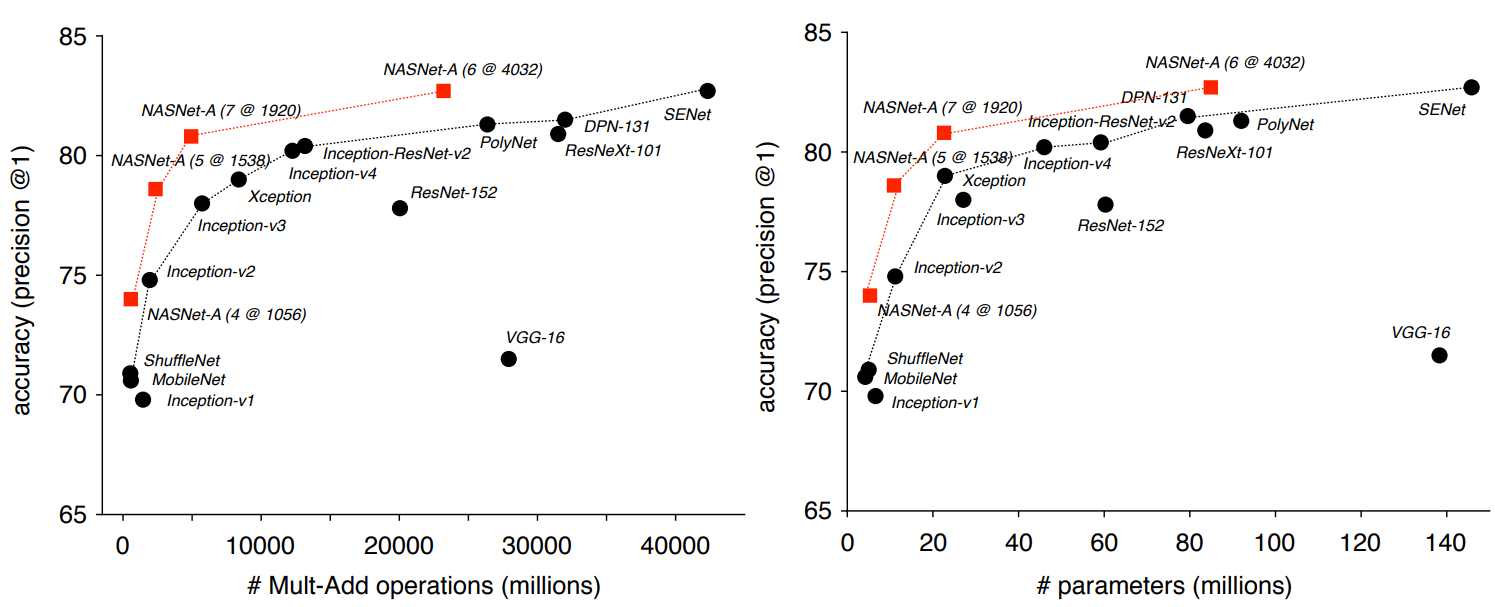

L'architecture NASNet se compose de deux types de couches: une couche normale (à gauche) et une couche de réduction (à droite). Ces deux couches sont conçues par un générateur AutoML.Les références ont montré que l'IA générée automatiquement surpasse tous les autres systèmes de vision industrielle créés et formés par des experts humains dans la classification et la définition des objets.

Ainsi, dans la tâche de classification basée sur ImageNet, le réseau neuronal NASNet a démontré une précision de prédiction de 82,7% sur l'ensemble de test. Ce résultat est supérieur à tous les modèles de vision industrielle précédemment conçus de la famille Inception. Le système NASNet a montré un résultat d'au moins 1,2 point de pourcentage supérieur à tous les réseaux de neurones de vision industrielle connus, y compris les derniers résultats de travaux non encore publiés dans la presse scientifique, mais déjà publiés sur le site de préimpression arXiv.org.

Les chercheurs soulignent que NASNet peut être mis à l'échelle et, par conséquent, adapté pour travailler sur des systèmes avec de faibles ressources informatiques sans trop de perte de précision. Le réseau neuronal est capable de fonctionner même sur un téléphone mobile avec un processeur faible avec une ressource mémoire limitée. Les auteurs disent que la version miniature de NASNet montre une précision de 74%, ce qui est de 3,1 points de pourcentage supérieur aux réseaux de neurones connus de la plus haute qualité pour les plates-formes mobiles.

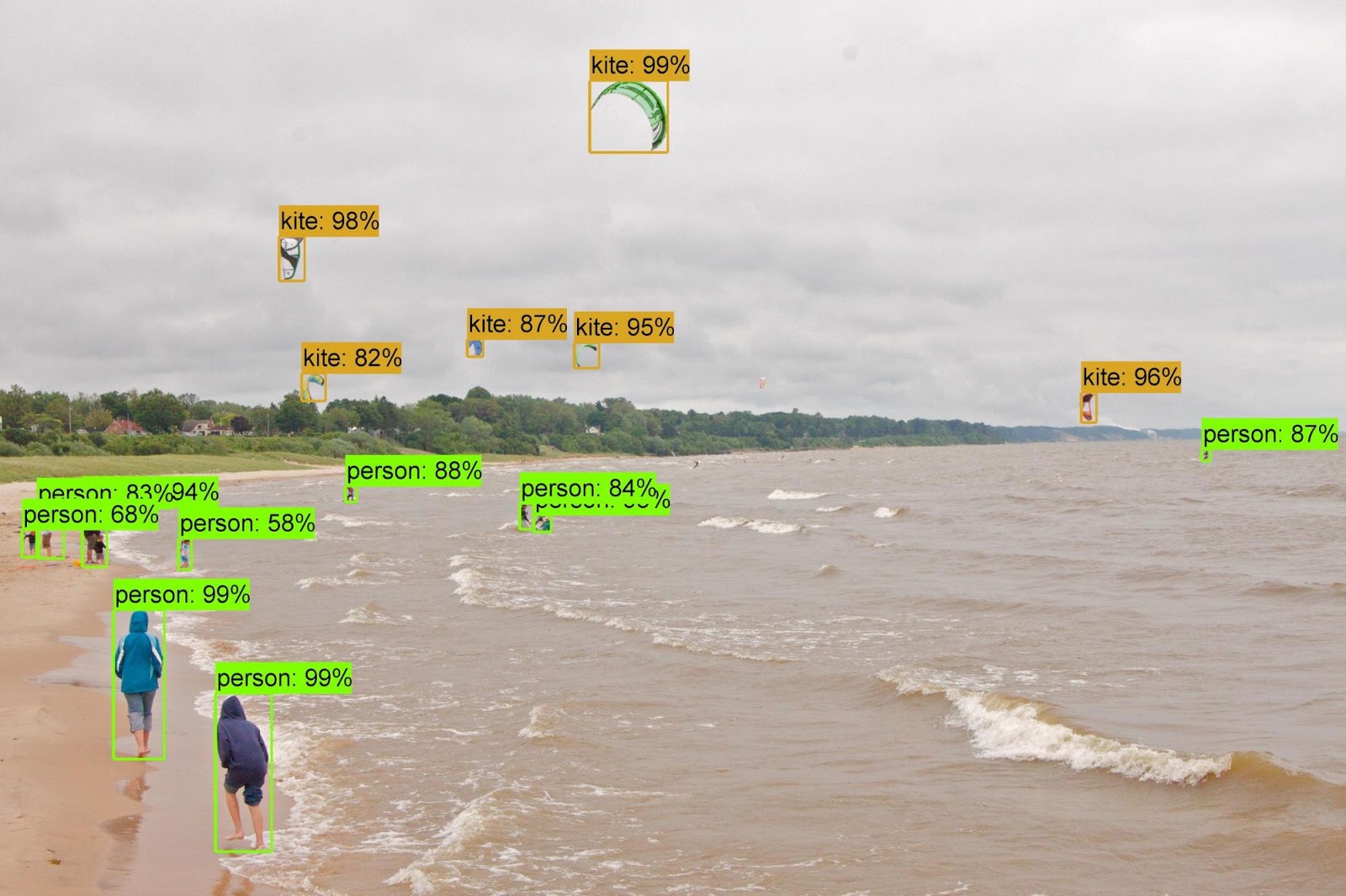

Lorsque les attributs acquis du classificateur ImageNet ont été transférés vers la reconnaissance d'objets et combinés avec le cadre

Faster-RCNN , le système a montré les meilleurs résultats dans le problème de reconnaissance d'objets COCO à la fois dans le grand modèle et dans la version réduite pour les plates-formes mobiles. Le grand modèle a montré un résultat de 43,1% mAP, soit 4 points de pourcentage de mieux que le concurrent le plus proche.

Les auteurs ont ouvert le code source de NASNet dans les référentiels

Slim et

Object Detection pour TensorFlow, afin que chacun puisse découvrir un nouveau réseau de neurones dans son propre travail.

L'article scientifique a été

publié le 1er décembre 2017 sur le site de préimpression arXiv.org (arXiv: 1707.07012v3, troisième version).