Les nouveaux systèmes d'imagerie, microscopes et matrices vidéo génèrent des images numériques basées sur des calculs informatiques plutôt que sur des objectifs traditionnels.

Même les artisans médiévaux ont pu créer des lentilles en verre et des miroirs incurvés pour projeter des images. Ces conceptions ont été utilisées pour fabriquer des microscopes, des caméras sténopé, des télescopes et d'autres instruments qui nous permettent de mieux voir les très petits et les gros objets situés loin et à proximité, sur Terre et dans le ciel. La prochaine révolution dans la formation d'images a eu lieu vers le milieu du XIXe siècle: la photographie a été inventée. Vous pouvez maintenant capturer des «moments arrêtés», les lire et les reproduire. Aujourd'hui, l'ère de la photographie chimique touche à sa fin, une nouvelle ère fleurit - l'imagerie numérique. Ses racines se trouvent dans la technologie de la télévision, mais nous considérerons le début de l'ère de 1975, lorsque le premier appareil photo numérique est apparu. Aujourd'hui, des milliards de webcams et d'appareils photo dans les téléphones portables du monde entier capturent plus d'un billion d'images par an, et nombre d'entre elles sont immédiatement téléchargées sur Internet. Malgré l'augmentation explosive du nombre, de la variété et des modes d'utilisation des systèmes d'imagerie, les tâches des ingénieurs opticiens restent en grande partie inchangées: créer une image optique de haute qualité qui transmet avec précision la scène à «rendre belle».

Cependant, au cours des 10 à 20 dernières années, un nouveau paradigme a commencé à émerger: l'imagerie informatique. Ce paradigme ne supplante peut-être pas complètement les approches traditionnelles, mais il mettra en doute des idées vieilles de plusieurs siècles et aidera à créer des méthodes alternatives pour concevoir des systèmes d'imagerie. Par exemple, de nouvelles fonctions et formes de systèmes d'imagerie sont déjà à notre disposition, y compris des appareils super miniatures pour photographier des objets macroscopiques et des microscopes sans lentilles.

Comme son nom l'indique, l'informatique joue un rôle clé dans la formation de l'image numérique finale. Pendant longtemps, ils se sont améliorés à l'aide du traitement numérique de l'image: ils ont supprimé l'effet yeux rouges lors de la prise de vue avec le flash, ajusté les couleurs, etc., mais les circuits optiques des objectifs n'ont jamais été conçus en tenant compte de ces besoins. Cependant, le traitement numérique du signal permet, par exemple, de corriger les distorsions optiques telles que les "oreillers" ou les distorsions grand angle sur les bords de l'image. Lorsque le télescope orbital Hubble a envoyé les premières images sur Terre à la fin des années 1980, elles étaient beaucoup plus «savonneuses» que prévu. Il est vite devenu évident qu'il y avait des problèmes avec l'optique. Les scientifiques de la NASA ont déterminé le problème et, jusqu'à ce que le télescope soit réparé, ils ont corrigé de nombreux défauts pendant plusieurs années à l'aide d'algorithmes de traitement numérique sophistiqués.

Au milieu des années 1990, Wade Thomas Cathey et Edward R. Dowski, Jr., ont eu l'idée de concevoir des objectifs pour produire des images floues «dégradées», mais dégradées de telle manière que Les algorithmes de traitement numérique ont permis de ne rendre les images ni pires, ni même meilleures, prises avec des objectifs traditionnels. En particulier, Katie et Dowsky se sont tournés vers la caractéristique de toutes les caméras traditionnelles: la profondeur de champ limitée. Si vous vous concentrez sur un objet à une distance moyenne de vous, il sera net, mais les objets de plus en plus éloignés deviendront flous. La profondeur de champ fait référence à la zone dans laquelle tous les objets semblent raisonnablement nets. Ainsi, deux scientifiques ont proposé un nouvel objectif, qui a presque autant brouillé les images optiques des objets à toutes les distances. Et puis un algorithme spécial a rendu l'image plus nette, obtenant une profondeur de champ inaccessible pour les objectifs ordinaires. Bien que de nombreux scientifiques aient encore amélioré la technique décrite, l'idée de Katie et Dowsky a fait beaucoup progresser la discipline de la capture informatique et de la formation d'images.

Une autre conséquence de ce travail scientifique a été que les circuits optiques pour les lentilles sont en train d'être développés sur la base de la création d'images pour les ordinateurs, pas les personnes. Il est paradoxal qu'à notre époque de prise de vue totale, très peu de gens aient vu de vraies images optiques formées par des caméras. Les jours sont révolus depuis longtemps lorsque le photographe, se penchant vers l'appareil photo et se couvrant d'une épaisse cape, a sorti l'obturateur et, avant d'insérer la cassette avec le film, a vu sur le verre dépoli une image «live» directement formée par l'objectif. Aujourd'hui, on voit sur les écrans le résultat du traitement numérique d'images optiques tombées sur des matrices de silicium.

Le prochain domaine d'application pour la combinaison de l'optique et du traitement numérique a été la simplification de la conception de l'objectif. Dans votre smartphone, un objectif d'appareil photo peut être composé de 7 à 8 éléments optiques, et les objectifs d'appareil photo professionnels sont parfois composés de plus de 15 éléments optiques. Un grand nombre de lentilles sont nécessaires pour corriger les défauts d'image - aberrations inhérentes à tout système optique: chromatique (image fantôme autour des objets) et optique (distorsion de la forme et des proportions des objets). Autrement dit, des conceptions d'objectifs complexes sont nécessaires pour produire des images «belles». La combinaison de l'optique et du traitement numérique aidera à déplacer une partie du travail pour corriger les aberrations vers un composant numérique, ce qui vous permettra d'abandonner certains éléments optiques sans compromettre la qualité de l'image numérique finale. C'est-à-dire que les algorithmes de traitement jouent le rôle d'éléments optiques virtuels. Cette approche a permis de créer des systèmes optiques plus compacts et moins chers sans perte de qualité.

Dans quelle mesure ces idées seront-elles développées? Quelle proportion de la tâche d'imagerie peut être transférée de l'optique à un composant numérique? Comment un circuit optique peut-il être simple pour obtenir une image décente? Est-il réaliste de se débarrasser des lentilles et des miroirs? Cela a été réalisé au cours des dernières années de trois manières: les objectifs et les images optiques qu'ils forment sont complètement exclus. Les méthodes sont basées sur la diffraction, la reconstruction de phase optique et la technique de détection compressive. Et pour obtenir l'image finale adaptée aux personnes, des calculs informatiques sont activement utilisés.

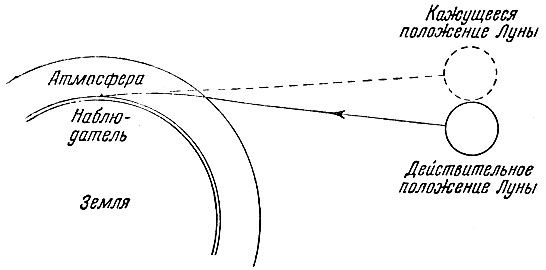

Les lentilles traditionnelles focalisent un faisceau de lumière en utilisant la réfraction : la lumière est réfractée lorsqu'elle passe à travers une frontière de média (verre d'air) à différentes vitesses de lumière. Grâce à l'effet de réfraction, un crayon immergé dans un verre en verre avec de l'eau semble être courbé: la lumière réfléchie par le crayon est réfractée lorsqu'elle pénètre dans l'air le long du trajet vers vos yeux. Par conséquent, la partie sous-marine du crayon que nous voyons n'est pas là où elle se trouve réellement.

Soit dit en passant, grâce à la réfraction (réfraction) à la frontière de l'espace et de l'atmosphère terrestre, tous les objets célestes semblent être situés légèrement plus haut que leur emplacement réel:

Les miroirs incurvés comme ceux utilisés dans les grands télescopes forment une image différemment: en utilisant la réflexion . Pour comprendre la différence entre la réfraction et la réflexion, imaginez la lumière sous forme de rayons (lignes).

Deux autres phénomènes physiques aideront à changer la direction de la propagation de la lumière et à utiliser sa nature ondulatoire (rappelez-vous la dualité onde-particule ): la diffraction et l' interférence . Lorsque deux ondes de lumière cohérentes se rencontrent, elles se chevauchent, l'amplitude des ondes résultante apparaît. Si le maximum d'une onde coïncide toujours avec le maximum de l'autre, alors les ondes se renforcent mutuellement, c'est ce qu'on appelle une interférence constructive . Si le maximum d'une onde coïncide toujours avec le minimum de l'autre, alors les ondes s'annulent - c'est une interférence destructrice , à la suite de laquelle la lumière peut disparaître complètement.

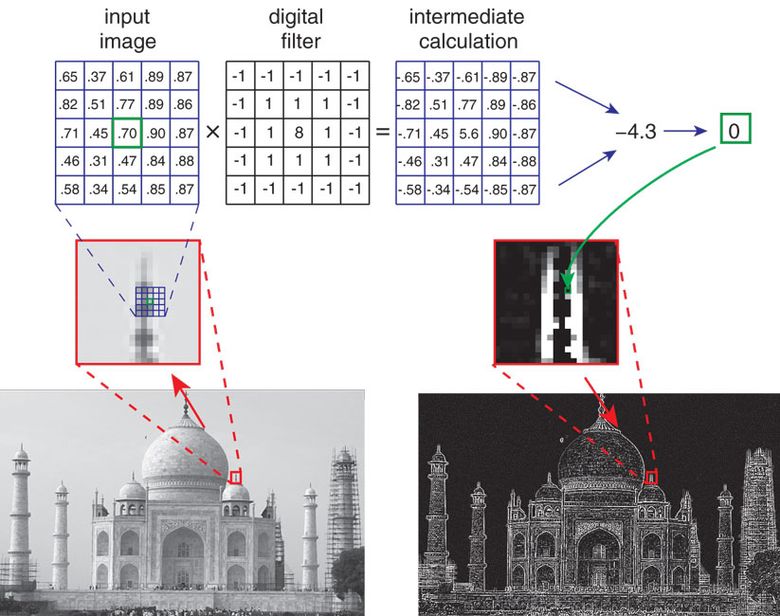

Vous pouvez contrôler la lumière par diffraction en la dirigeant vers le réseau de diffraction - une série des meilleurs coups (rasters) - sur une surface lisse. Étant donné que les ondes de différentes longueurs sont réfléchies dans différentes directions, une coloration des couleurs se produit. Par exemple, lorsque la lumière blanche est réfléchie par de minuscules rainures sur la surface d'un CD ou d'un DVD, nous voyons des rayures arc-en-ciel. En raison de la dépendance des longueurs d'onde sur le raster, il est impossible de créer un réseau de diffraction qui remplace simplement les lentilles. Une image optique formée par un réseau ne sera jamais aussi bonne qu'une image provenant d'un objectif bien conçu. Néanmoins, il est tout à fait possible de créer des images numériques acceptables en utilisant une combinaison d'optiques de diffraction (en utilisant la diffraction) et un traitement de signal adapté (en tenant compte de l'optique).

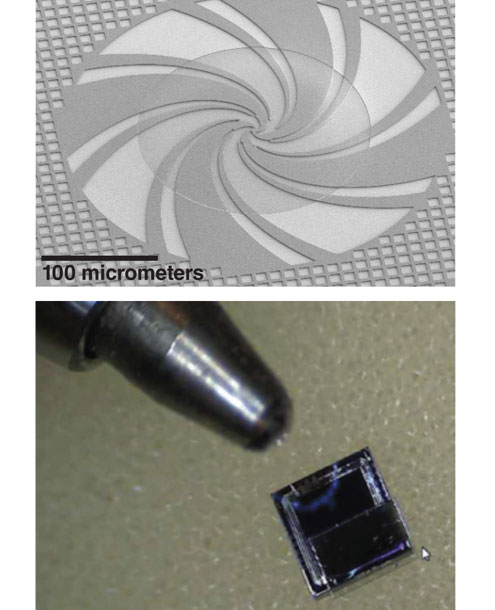

Dans l'une des classes de dispositifs non objectifs pour la prise de vue macroscopique, des réseaux de diffraction miniatures sont utilisés, situés pas à pas dans l'épaisseur d'un matériau transparent (verre ou silicate) et retardant une partie de la lumière incidente par rapport à l'autre partie. Les propriétés mathématiques du schéma étagé sont telles que la distribution de la lumière dans le matériau dépend faiblement de la longueur d'onde, et donc d'une légère variation de l'épaisseur du verre lui-même, qui se produit inévitablement lors de la fabrication. Les réseaux sont attachés à un capteur photosensible - comme la matrice dans les appareils photo numériques conventionnels. La lumière incidente traverse les réseaux et atteint le réseau, qui a déjà été spécialement décomposé en «composants». Elle ne ressemble pas du tout à une image ordinaire: une sorte de nuage flou, incompréhensible à l'œil humain. Cependant, ce nuage contient suffisamment d'informations visuelles (bien que distribuées de manière inhabituelle) pour en recréer l'image souhaitée à l'aide d'un processus de calcul appelé convolution d'image.

L'algorithme de reconstruction d'image est légèrement sensible au bruit visuel, par exemple les fluctuations aléatoires du nombre de photons ou le bruit électrique lors de la conversion du signal du capteur en une représentation numérique (dite erreur de quantification). Par conséquent, l'image peut être visuellement bruyante. Bien que cette qualité soit suffisante pour un certain nombre de tâches simples (par exemple, pour compter le nombre de personnes dans un cadre), cependant, pour une image plus décente, vous devez capturer plus d'informations sur la scène prise. La solution "dans le front" est de prendre plusieurs grilles de phases miniatures conçues pour capturer diverses informations sur la scène. C'est-à-dire que chaque réseau forme une image numérique de composant, ces composants peuvent ensuite être traités et une meilleure image peut être obtenue.

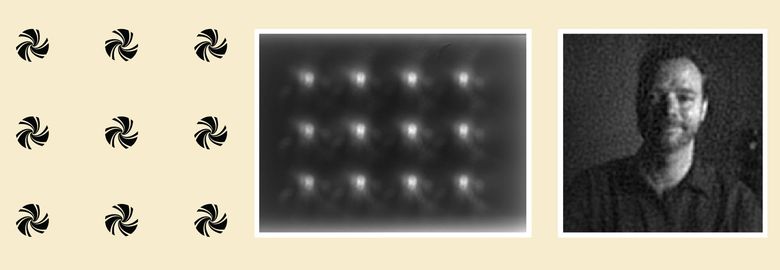

Un type de système d'imagerie sans lentille utilise des réseaux qui diffusent la lumière, plutôt que de la focaliser comme des lentilles. Dans l'exemple ci-dessus, un réseau de 12 microgrids en phase binaire (à gauche) est conçu pour capturer autant d'informations visuelles que possible sur la scène. Après que la lumière a traversé le réseau, 12 points flous sont obtenus, dont aucun ne permet à une personne de comprendre ce qui est filmé ici (au centre). Cependant, cette image optique contient suffisamment d'informations pour obtenir un portrait complètement lisible (à droite) à l'aide d'un traitement numérique appelé «convolution d'image».

Cette approche aidera non seulement à former une image de la scène, mais aussi à l'analyser: pour déterminer les propriétés visuelles (par exemple, s'il y a un visage humain sur la photo), la direction et la vitesse du mouvement global de la scène ( flux visuel, flux visuel), pour calculer le nombre de personnes dans à l'intérieur. Dans de telles situations, les réseaux de diffraction sont conçus pour extraire les informations nécessaires et l'algorithme de traitement est adapté à une tâche spécifique. Disons que si nous devons lire un code-barres vertical, nous utilisons un réseau de diffraction vertical et un algorithme qui amène chaque pixel d'une image numérique à une valeur de seuil: la lumière est convertie en sombre, sombre en noir. Le résultat est une image numérique en noir et blanc, et elle peut déjà être reconnue par l'algorithme de lecture de code-barres.

Microscopie à reconstruction de phase

L'approche de création de microscopes biaisés diffère des méthodes de création de caméras de calcul pour des macro-objets, bien que le phénomène de diffraction soit également utilisé ici. Cependant, contrairement à un appareil qui filme une scène avec un éclairage ordinaire créé par le soleil ou des lampes, seul le rayonnement laser cohérent ou la lumière monochromatique d'une ou plusieurs sources peuvent être sélectionnés pour un éclairage en microscopie. Cela vous permet de contrôler la diffraction et l'interférence de la lumière. De plus, les objets qui nous intéressent sont si petits que la diffraction se produira lorsque la lumière passera à travers les objets eux-mêmes, et non à travers un réseau de diffraction artificiel.

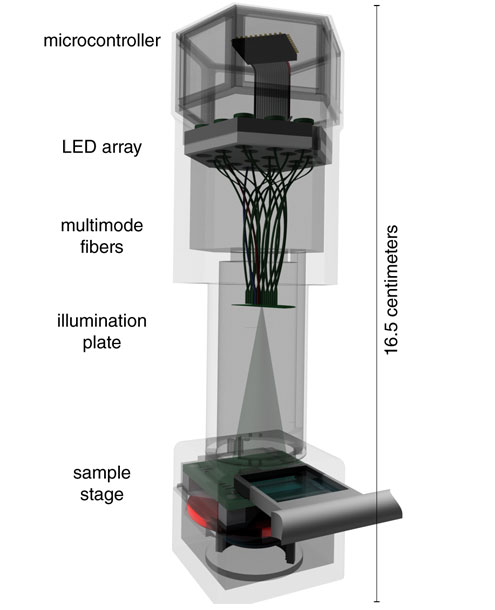

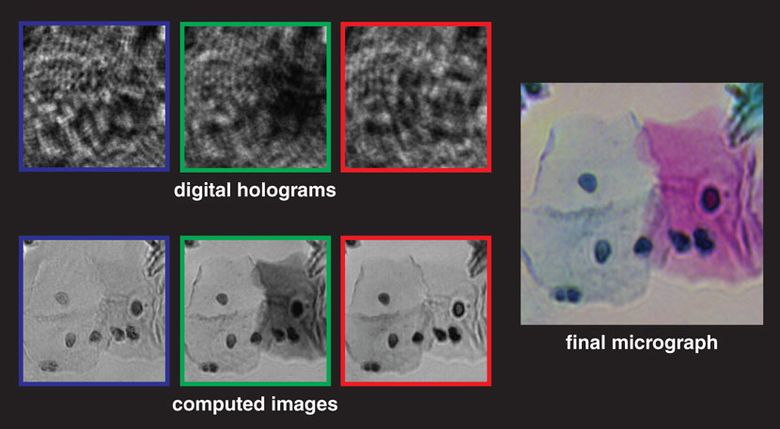

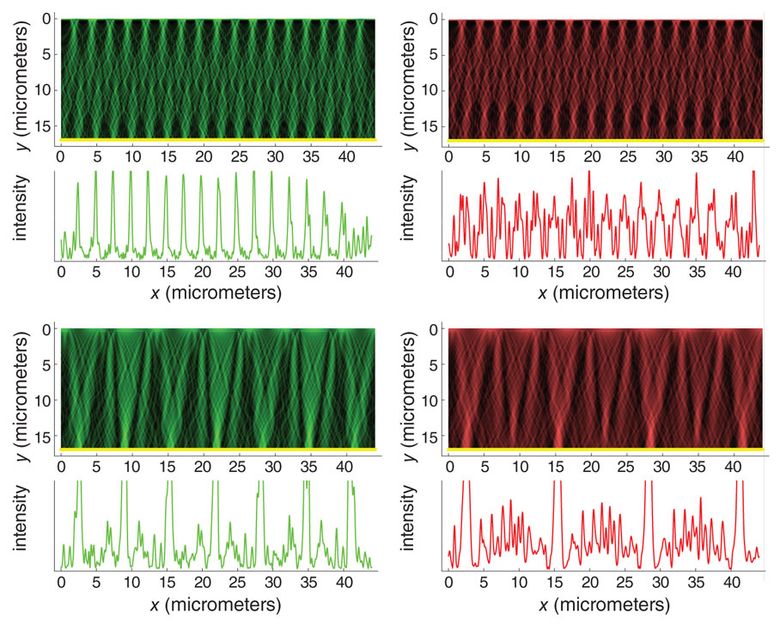

Le schéma d'un tel microscope implique que l'échantillon est placé au-dessus d'une matrice photosensible avec un grand nombre de petits pixels: une matrice de 10 mégapixels, par exemple, que l'on trouve souvent dans les appareils photo numériques. Ce schéma est également appelé «microscope sur puce» car l'échantillon est placé directement sur la matrice de formation d'image. La lumière d'un laser ou d'une LED de couleur spectralement pure est incidente sur l'échantillon et diffusée sur les objets à photographier. Les ondes de diffraction résultantes - formant le faisceau objet ( faisceau objet) - se superposent à l'illumination qui traverse l'échantillon sans distorsion - le faisceau de référence (faisceau de référence). Le résultat est un motif d'interférence complexe enregistré par une matrice photosensible et utilisé en holographie numérique en ligne. L'image brute ressemble vaguement aux ombres microscopiques de l'échantillon, et dans certains cas, elle suffit pour calculer approximativement le nombre et l'emplacement des objets. Mais l'image holographique brute est trop boueuse, bruyante, contient des "artefacts annulaires" et ne permet pas de déterminer la morphologie des objets. L'image est mauvaise.

Le motif d'interférence passe par plusieurs étapes du traitement numérique, l'étape principale est l' algorithme de reconstruction de phase. Dans ce document, en utilisant la physique des interférences optiques, des conclusions sont tirées sur la structure et l'emplacement des objets dans l'échantillon. En bref: l'algorithme recherche des informations optiques sur la phase perdue dans l'hologramme sur la matrice (qui enregistre uniquement le motif d'interférence, et non les phases des rayons lumineux individuels eux-mêmes). L'algorithme calcule de manière itérative les informations de phase dans le faisceau objet, ce qui a très probablement conduit à l'apparition d'un tel motif d'interférence optique. Lorsque des informations sur la phase dans le faisceau d'objet sont déterminées, l'algorithme calcule son changement dans le temps pour construire une image des objets, formant l'image numérique finale.

Comme pour les macro-appareils, la résolution est augmentée en capturant plusieurs images optiques, chacune contenant des informations légèrement différentes. Par exemple, avant d'enregistrer chaque image, vous pouvez légèrement déplacer la source de lumière, ou l'échantillon lui-même, ou la matrice. Ensuite, les trames sont traitées et combinées pour obtenir une image d'interférence de résolution accrue (qui est toujours incompréhensible pour l'homme), puis les phases de restauration de phase et de restauration temporaire sont effectuées.

Les microscopes objectifs sur puce présentent plusieurs avantages.

Premièrement, la zone de prise de vue de l'échantillon (c'est-à-dire le champ de vision) peut être extrêmement grande, elle n'est limitée que par la taille de la matrice photosensible sur laquelle l'échantillon est placé. Les matrices modernes vous permettent de fournir un champ de vision de 20 millimètres carrés à 20 centimètres carrés.

Deuxièmement, même des objets transparents (par exemple, la plupart des bactéries dans une couche d'eau) peuvent être étudiés avec des microscopes objectifs s'ils changent la phase de la lumière qui les traverse. Des microscopes optiques à objectif spécial permettent également l'étude de ces "objets de phase", bien qu'avec un champ de vision beaucoup plus petit et la taille totale de l'échantillon.

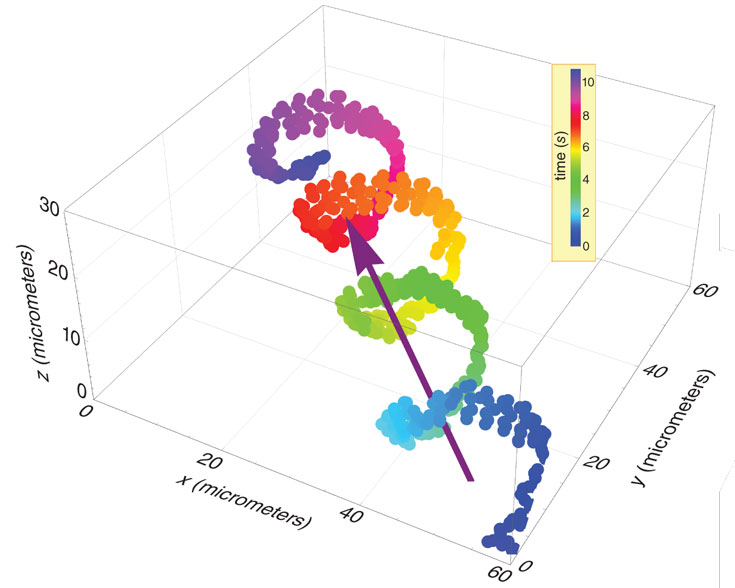

Troisièmement, le traitement numérique de l'image optique permet d'isoler différents types de cellules (par exemple, des spermatozoïdes ou des cellules sanguines dans les capillaires) et de suivre leurs mouvements. Grâce à cela, les médecins et les biologistes peuvent obtenir des données importantes.

Quatrièmement, ces microscopes sont beaucoup moins chers et plus compacts que les traditionnels. Les microscopes sans objectif peuvent être connectés à un téléphone mobile, utilisés dans les zones rurales, et les données numériques peuvent être transférées n'importe où pour une analyse plus approfondie.

Technique de détection compressive

La troisième approche de la formation d'images biaisées est basée sur les dernières avancées en mathématiques et en statistiques de signaux - la technique de détection compressive . Une image optique sur une matrice est un signal complexe, qui se présente sous la forme d'une liste de nombres et est traité par différents algorithmes. Comme un signal sonore complexe se compose de nombreux sons plus simples, chacun étant ajouté dans la bonne proportion, l'image est formée à partir d'un grand nombre d'images plus simples. Un ensemble d'images ou de signaux simples est appelé base . Dans le domaine du son, la base la plus courante est un ensemble de tons cosinus purs. Peu importe la complexité du son. Tout, d'un klaxon de voiture à une symphonie de Beethoven, peut être créé en ajoutant un grand nombre d'ondes cosinus de base, pour chacune desquelles l'intensité et le décalage temporel souhaités sont sélectionnés.

Quelle pourrait être une base similaire dans le domaine de l'image? Les deux bases visuelles les plus populaires et utiles sont des ensembles d' ondes cosinus bidimensionnelles et des motifs d'ondelettes multi-résolution. Ces éléments de base sont mathématiquement élégants et forment la base des schémas modernes de compression d'image JPEG et JPEG 2000. Au lieu de stocker et de transmettre les valeurs de chaque pixel dans une image numérique, vous opérez sur un fichier décrivant les amplitudes des différents signaux de base des composants. Par conséquent, le fichier «compressé» est beaucoup plus petit que l'image elle-même. Pendant des décennies, ces bases ont fidèlement servi d'outil de traitement d'images numériques, mais n'ont pas conduit à la création de nouvelles méthodes pour le développement de circuits optiques; par conséquent, aucun élément optique ne facilite l'introduction de bases.

Passons à la détection compressive. Théoriquement, les statistiques montrent que même si les informations sur la scène sont redondantes (c'est-à-dire que l'image peut être compressée), il n'est pas nécessaire de mesurer les bases, les mesures d'un échantillon aléatoire sont suffisantes. « », , ( ), compressive sensing. , , .

, (), . . «» , , (). , .

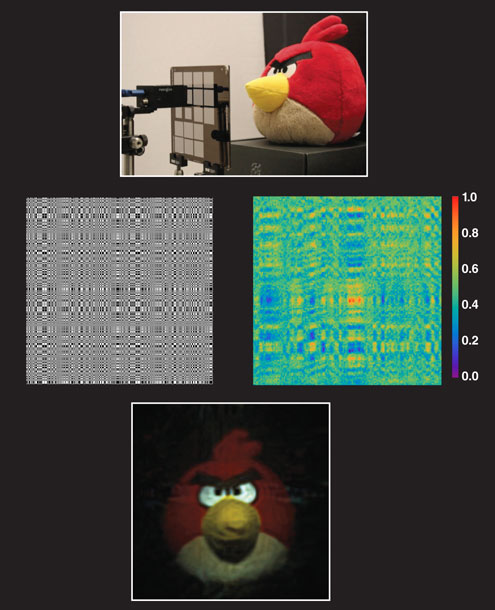

, -. (coded apertures) ( - ) . FlatCam (Ashok Veeraraghavan) . , (. ). — Angry Birds — ( ) . , , , . , . , . compressive sensing «» , .

.

, . , , , . 0,5 0,2 — , . FlatCam , , .

, , , , . , - , . , , .

. , , , , , , . , , , . , , , .

, . , - .