Sundar Pichai est venu à l'amphithéâtre Shoreline à Mountain View hier à 20 heures, heure de Moscou, et a ouvert Google I / O 2018. La conférence durera trois jours du 8 au 10 mai, mais l'essentiel a été annoncé depuis la scène lors d'un discours d'ouverture traditionnel. Android P a appris des gestes comme dans iOS 11 sur l'iPhone X, Google Assistant parle maintenant à six voix différentes et réussit presque le test de Turing, et les développeurs recevront le kit ML pour implémenter l'apprentissage automatique dans leurs applications.

Assistant Google

Assistant est le point culminant du programme. Au cours des deux années qui ont suivi l'annonce, il s'est installé sur 500 millions d'appareils différents. En plus des smartphones, ce sont des haut-parleurs intelligents, des écouteurs, des téléviseurs et des montres. Il est intégré aux voitures de 40 fabricants différents et prend en charge le travail avec plus de 5000 appareils électroménagers tels que les lave-vaisselle et les appels.

Maintenant, on lui a appris à parler à six voix différentes et à comprendre plusieurs commandes en une seule phrase à la fois. D'ici la fin de l'année, Google Assistant travaillera dans 80 pays et prendra en charge 30 langues, dont le russe. Et oui, vous n'avez plus besoin de dire constamment "OK Google". Autrement dit, vous pouvez dire: "Ok Google, règle une alarme à 7 heures du matin et rappelle-moi d'acheter du yaourt quand je suis près du supermarché."

Auparavant, de l'assistant, nous nous attendions principalement à une réponse verbale, d'un haut-parleur intelligent, par exemple. Mais sur cette E / S, Google a montré plusieurs appareils de la catégorie des écrans intelligents - il s'agit essentiellement d'une colonne intelligente, uniquement avec un écran tactile. Une telle colonne avec un écran peut dire «OK Google, allume Jimmy Kimmel», et elle trouvera son émission sur YouTube et la lancera. Sur le même appareil, selon Google, il est pratique de rechercher des recettes. La différence fondamentale entre les soi-disant «écrans intelligents» et les tablettes conventionnelles n'est pas encore très claire.

Aux États-Unis, Google Assistant a également appris à travailler dans le cadre du programme de ramassage et de livraison et lié à des réseaux populaires: Starbucks, 7-Eleven, Dunkin 'Donuts et autres. Aux États-Unis, vous pouvez maintenant parler avec l'assistant et demander à commander un latte au caramel pour le ramasser dans un café pratique.

Tout ce que vous direz à l'Assistant, il s'en souviendra et commencera progressivement à donner des conseils et à construire une image du jour à venir, comme Google Now l'a fait, mais plus précisément. Toutes ces puces apparaîtront dans la nouvelle version d'Android à l'été 2018.

Google duplex

Sur Google I / O, Sundar a révélé ce que l'entreprise appelle Google Duplex. Toutes les réalisations de ces dernières années ont été combinées, ce qui a permis à l'assistant de mener avec succès une conversation téléphonique avec une personne sans méfiance. C'est du moins ce qu'ils ont dit depuis la scène. Si toutes ces "euh ...", "hmm" et autres nuances de discours purement humaines ont vraiment donné le réseau neuronal, alors nous sommes sur le point de faire passer le test de Turing par l'ordinateur. Voyez par vous-même:

Vous demandez à l'assistant de vous réserver une table dans le restaurant, et il y appelle en arrière-plan et accepte tout. Voix Il reste à attendre qu'un assistant virtuel soit également planté à l'autre bout du fil.

Google prévoit une expérience à part entière impliquant de petites entreprises quelques semaines plus tard. Les assistants prévoient de «mettre le téléphone» pour qu'il réponde aux appels des clients.

Android P

La version bêta d'Android P apparaîtra le 8 mai et sera disponible sur 11 smartphones:

- Sony Xperia XZ2

- Xiaomi Mi Mix 2S

- Nokia 7 Plus

- Oppo r15 pro

- Vivo x21

- OnePlus 6

- PH-1 essentiel

- Google Pixel / XL

- Google Pixel 2/2 XL

La nouvelle version de l'OS a révisé l'approche de la navigation et des gestes. En particulier, ils ont implémenté un appel à la liste des applications ouvertes de la même manière que dans l'iPhone X - avec un balayage de bas en haut. Le bouton d'appel de l'application en arrière-plan a été complètement abandonné et le bouton Retour n'apparaît que si une application est ouverte. De plus, la conception de certains éléments d'interface sera mise à jour conformément à Material Design 2.

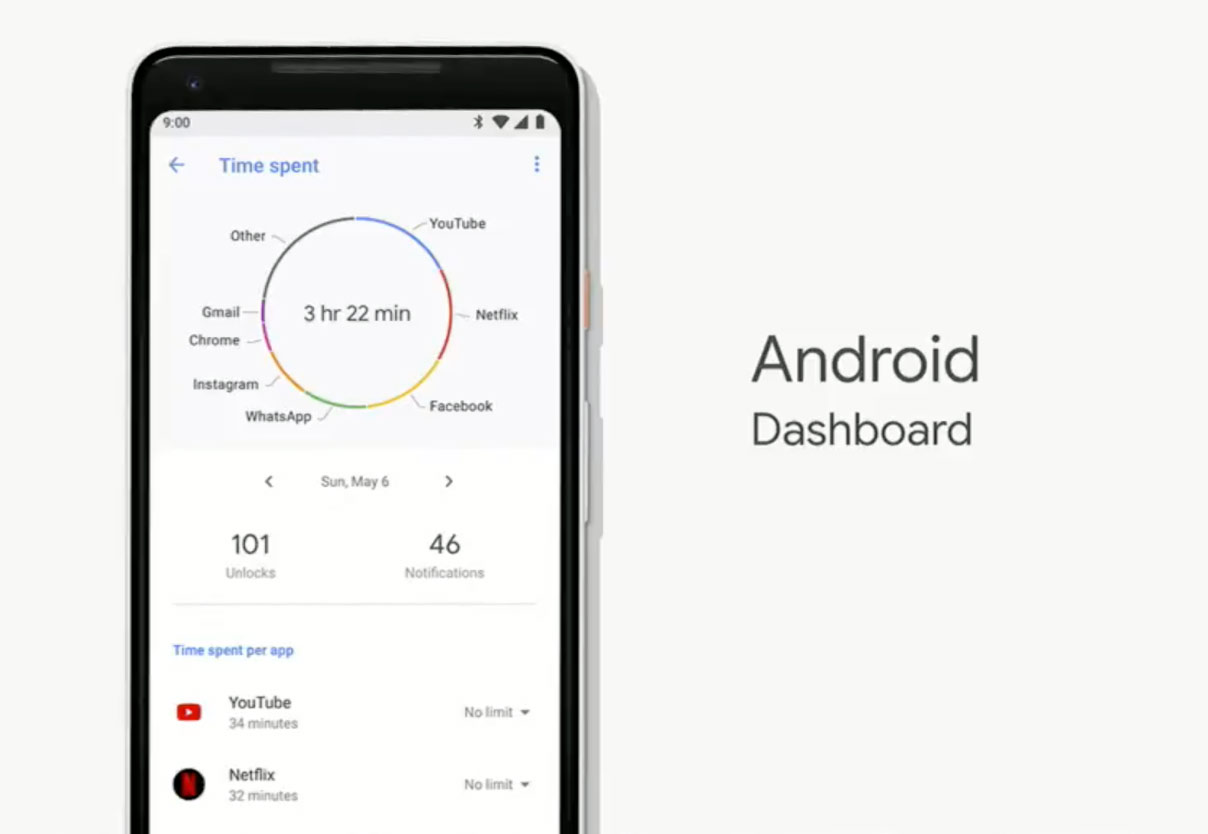

Pichai a parlé de plusieurs nouvelles fonctionnalités séparément. Par exemple, «Dashboard» est apparu dans Android P, qui affiche des statistiques d'utilisation du smartphone: combien de fois vous l'avez déverrouillé dans une journée, combien de notifications vous lisez.

Dans les paramètres de l'application YouTube pour Android, vous pouvez sélectionner un mode dans lequel de temps en temps un rappel apparaîtra qu'il est temps de faire une pause si vous regardez une vidéo en continu depuis longtemps. De plus, les notifications de nouvelles vidéos des chaînes auxquelles vous êtes abonné peuvent désormais être reçues sous forme de résumé quotidien, et non individuellement.

Family Link - un panneau de contrôle pour les appareils de vos enfants qui vous aidera à limiter le temps passé devant l'écran.

Actualités Google

Sur Google I / O, Sundar Pichai a parlé de la renaissance de Google News. Maintenant, "News" est similaire à Yandex.Zen - c'est un agrégateur de nouvelles intelligent qui sait ce que vous lisez habituellement et à quelles ressources vous faites confiance. Il filtre les inutiles et affiche cinq histoires significatives au cours des dernières heures sur l'onglet «Pour vous».

Apprentissage automatique

Avec l'apprentissage automatique, les nouveaux appareils Android peuvent considérablement économiser l'énergie de la batterie en prédisant quelle application vous lancerez ensuite, avec une probabilité d'environ 60%.

Mais l'essentiel - maintenant l'API pour accéder à des fonctionnalités de smartphone telles que la reconnaissance de texte et de visage sur les photos ou, par exemple, la numérisation de codes à barres est désormais disponible pour tous les développeurs grâce au Kit d'apprentissage machine. En outre, ils ont déclaré depuis la scène que les développeurs auraient accès aux réseaux de neurones cloud de Google, mais ils n'ont pas fourni de détails.