L'hystérie entourant l'avenir de l'intelligence artificielle (IA) a conquis le monde. Les nouvelles sensationnelles ne manquent pas sur la façon dont l'IA peut

guérir les maladies ,

accélérer l'innovation et

améliorer la

créativité d'une personne. Si vous lisez les gros titres des médias, vous pouvez décider que vous vivez déjà dans un avenir où l'IA a pénétré tous les aspects de la société.

Bien que l'on ne puisse nier que l'IA nous a ouvert un

riche ensemble d'opportunités prometteuses , elle a également conduit à l'émergence de la pensée, qui peut être décrite comme la foi en l'omnipotence de l'IA. Selon cette philosophie, s'il y a suffisamment de données, les algorithmes d'apprentissage automatique

pourront résoudre tous les problèmes de l'humanité .

Mais cette idée a un gros problème. Il ne soutient pas les progrès de l'IA, mais met en péril la valeur de l'intelligence artificielle, négligeant les principes de sécurité importants et préparant les gens à des attentes irréalistes concernant les capacités de l'IA.

Croire en la toute-puissance de l'IA

En quelques années seulement, la croyance en l'omnipotence de l'IA s'est propagée des conversations des évangélistes de la technologie de la Silicon Valley dans l'esprit des représentants du gouvernement et des législateurs du monde entier. Le pendule est passé du concept anti-utopique de l'

IA détruisant l'humanité à la foi utopique dans l'

avènement de notre sauveur algorithmique .

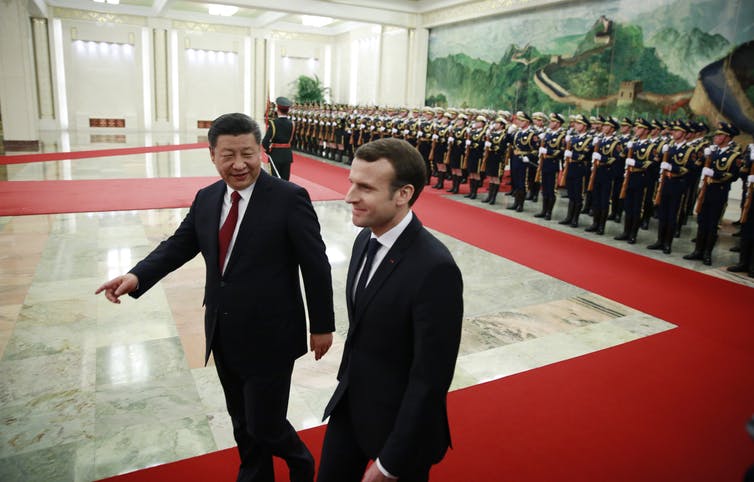

Nous voyons déjà comment les gouvernements apportent leur soutien aux programmes nationaux de développement de l'IA et rivalisent dans la

course aux

armements rhétorique et technologique pour gagner un avantage dans le secteur en plein essor de l'apprentissage automatique (MO). Par exemple, le gouvernement britannique a

promis d'investir 300 millions de livres sterling dans la recherche sur l'IA pour devenir un leader dans ce domaine. Fasciné par le potentiel transformateur de l'IA, le président français

Emmanuel Macron a décidé de

faire de la France un centre international d'IA . Le gouvernement chinois augmente ses capacités d'IA avec un

plan gouvernemental visant à créer une industrie chinoise de l'IA de 150 milliards de dollars d'ici 2030. La croyance en l'omnipotence de l'IA prend de l'ampleur et ne va pas abandonner.

Réseaux de neurones - plus faciles à dire qu'à faire

Alors que de nombreuses déclarations politiques vantent les effets transformateurs de la «

révolution de l'IA » imminente

, elles sous-estiment généralement la complexité de l'introduction de systèmes MO avancés dans le monde réel.

Les

réseaux de neurones sont l'une

des variétés les plus prometteuses de la technologie de l'IA. Cette forme d'apprentissage automatique est basée sur une imitation exemplaire de la structure neuronale du cerveau humain, mais à une échelle beaucoup plus petite. De nombreux produits basés sur l'IA utilisent des réseaux de neurones pour extraire des modèles et des règles à partir de grandes quantités de données. Mais de nombreux politiciens ne comprennent pas qu'en ajoutant simplement un réseau de neurones au problème, nous n'obtenons pas nécessairement sa solution immédiatement. Ainsi, en ajoutant un réseau de neurones à la démocratie, nous ne la rendrons pas instantanément moins discriminée, plus honnête ou personnalisée.

Contester la bureaucratie des données

Les systèmes d'IA nécessitent une énorme quantité de données pour fonctionner, mais dans le secteur public, il n'y a généralement pas d'

infrastructure de données appropriée pour prendre en charge les systèmes MO avancés. La plupart des données sont stockées dans des archives hors ligne. Un petit nombre de sources de données numérisées existantes se noient dans la bureaucratie. Les données sont le plus souvent réparties entre différents services gouvernementaux, dont chacun requiert une autorisation spéciale d'accès. Entre autres, le secteur public ne dispose généralement pas de suffisamment de talents dotés des capacités techniques nécessaires pour tirer pleinement parti des

avantages de l'IA .

Pour ces raisons, le

sensationnalisme lié à l'IA fait l'objet de nombreuses critiques. Stuart Russell, professeur d'informatique à Berkeley, préconise depuis longtemps une approche plus réaliste, se concentrant sur les

applications quotidiennes les

plus simples de l' IA, au lieu de la prise de contrôle hypothétique du monde par des robots superintelligents. De même, le professeur de robotique du MIT,

Rodney Brooks, écrit que "presque toutes les innovations en robotique et en IA nécessitent beaucoup, beaucoup plus de temps pour une mise en œuvre réelle que ce que les spécialistes de ce domaine et tout le monde imaginent".

L'un des nombreux défis du déploiement de systèmes MO est que l'IA est extrêmement

vulnérable aux attaques . Cela signifie qu'une IA malveillante peut attaquer une autre IA pour la forcer à émettre des prédictions incorrectes ou à agir d'une certaine manière. De nombreux

chercheurs ont averti qu'il est impossible de déployer immédiatement l'IA sans préparer des

normes de sécurité et des mécanismes de protection appropriés. Mais jusqu'à présent, le sujet de la sécurité de l'IA n'a pas reçu l'attention voulue.

L'apprentissage automatique n'est pas magique

Si nous voulons profiter des avantages de l'IA et minimiser les risques potentiels, nous devons commencer à réfléchir à la manière dont nous pouvons appliquer de manière significative les OI à certains domaines du gouvernement, des entreprises et de la société. Et cela signifie que nous devons commencer à discuter de l'

éthique de l'IA et de la

méfiance de nombreuses personnes au MO.

Plus important encore, nous devons comprendre les limites de l'IA et les points auxquels les gens doivent encore prendre le contrôle. Au lieu de dessiner une image irréaliste des capacités de l'IA, vous devez prendre du recul et

séparer les véritables capacités technologiques de l'IA de la magie.

Pendant longtemps,

Facebook a estimé que des problèmes tels que la propagation de la désinformation et l'incitation à la haine pouvaient être reconnus et arrêtés par des algorithmes. Mais sous la pression des législateurs, l'entreprise a rapidement promis de remplacer ses algorithmes par une

armée de 10 000 évaluateurs humains .

En médecine, ils reconnaissent également que l'IA ne peut pas être considérée comme la solution à tous les problèmes. Le programme

IBM Watson for Oncology était une IA censée aider les médecins à lutter contre le cancer. Et bien qu'il ait été conçu pour donner les meilleures recommandations, les experts ont du

mal à faire confiance à la machine . En conséquence, le programme a été

fermé dans la plupart des hôpitaux, où ses essais ont eu lieu.

Des problèmes similaires se posent dans le domaine législatif lorsque des

algorithmes ont été utilisés par les tribunaux américains pour prononcer des peines. Les algorithmes ont calculé les valeurs de risque et donné aux juges des

recommandations sur les peines. Mais il s'est avéré que le système renforce la discrimination raciale structurelle, après quoi il a été abandonné.

Ces exemples montrent qu'il n'y a pas de solutions basées sur l'IA pour tout. Utiliser l'IA pour l'IA elle-même n'est pas toujours productif ou utile. Tous les problèmes ne sont pas mieux résolus à l'aide de l'intelligence artificielle. C'est la leçon la plus importante pour tous ceux qui ont l'intention d'augmenter les investissements dans les programmes gouvernementaux de développement de l'IA: toutes les décisions ont un prix, et tout ce qui peut être automatisé n'a pas besoin d'être automatisé.