Automatisation d'un système de surveillance basé sur Icinga2 et Puppet

Automatisation d'un système de surveillance basé sur Icinga2 et Puppet

Parlons un peu de ... Infrastructure en tant que code (IaC).

Sur Habré il y a de très bons articles sur Icinga2, il y a aussi d'excellents articles sur Puppet:

Icinga2 est une option facileNous augmentons la microsurveillance sur icinga2 avec le minimum de dépensesConfigurer un serveur Puppet moderne à partir de zéroCependant, le sujet de l'automatisation et de l'intégration de ces deux systèmes étonnants n'est pas divulgué du tout.

Dans ce guide, je vais montrer dans un exemple «vivant» comment combiner ces deux

systèmes, obtenez un outil puissant pour surveiller votre infrastructure avec toutes les fonctions nécessaires. Cet article est une sorte de guide d'action sur l'installation du package «tout en un flacon». Après avoir terminé ce guide, vous disposerez d'une solution de surveillance entièrement opérationnelle, qui peut être «terminée» par vous-même. Essayons!

Donc:

Nous avons soulevé un nouvel hôte. Et nous avons besoin de:

1. Pour que sa surveillance apparaisse automatiquement dans Icinga2 et que des contrôles de base soient créés:

Chèques

| Instantanés

| Explications

|

Hôte

|

| A une fréquence donnée, on vérifie avec la commande ping que l'hôte est «live».

|

Utilisation du disque

|

| Vérifiez que nous avons suffisamment d'espace disque libre. |

Charge moyenne

|

| Nous surveillons dynamiquement la charge sur le serveur. Le nombre de processeurs dessus est pris en compte. |

Mémoire libre

|

| Nous vérifions que nous avons suffisamment de mémoire libre sur le serveur. |

Ports ouverts

|

| Nous analysons les ports du serveur et créons une carte des ports ouverts. Nous vérifions que nous n'avions pas de nouveaux ports ouverts ou fermés. |

Mises à jour critiques

|

| Nous surveillons la présence de mises à jour critiques sur le serveur. |

2. Ajoutez des contrôles personnalisés pour divers services de manière pratique et compréhensible. Ce qui montrerait alors au réalisateur quels bons gars nous sommes et obtiendrait un prix!

Quelques exemples:

Le service

| Code de vérification YAML

|

|---|

Hôte virtuelVérifiez l'hôte "en direct" ou non.

| '%{::fqdn} virtual host' : target: /etc/icinga2/zones.d/master/%{::fqdn}.conf apply: true assign: [ 'host.name == %{::fqdn}' ] display_name: '%{::fqdn} virtualhost' check_command: 'http' vars: http_uri: / http_ssl: true http_vhost: 'hostname' http_address: "%{lookup('host_address')}"

|

PostgreSQLVérifiez que nous pouvons nous connecter à la base de données PostgreSQL.

| '%{::fqdn} PostgreSQL': target: /etc/icinga2/zones.d/master/%{::fqdn}.conf apply: true assign: [ 'host.name == %{::fqdn}' ] display_name: 'PostgreSQL' command_endpoint: '%{::fqdn}' check_command: "postgres" vars: postgres_host: "localhost" postgres_action: "connection" phone_notifications: true

|

Statut NginxNous surveillons l'état de Nginx via stub_status.

| '%{::fqdn} nginx status' : target: /etc/icinga2/zones.d/master/%{::fqdn}.conf apply: true assign: [ 'host.name == %{::fqdn}' ] command_endpoint: '%{::fqdn}' display_name: 'nginx status' check_command: 'nginx_status' vars: nginx_status_host_address: localhost nginx_status_servername: server.com nginx_status_critical: '1600,60,30' nginx_status_warn: '1500,55,25'

|

3. Que tout était propre, fiable et beau. Et surtout, ne passez pas plus de 30 minutes à vous occuper de la configuration initiale.

Vous devez avoir une expérience avec Docker, et donc avec Linux - par lui-même.

Cette configuration est décrite sous Debian / Ubuntu. Et, même si je ne vois aucune raison pour qu'il ne travaille pas sur d'autres systèmes de type Unix, je ne peux moi-même donner de telles garanties. J'ai quelques machines avec CentOS, cela fonctionne là-bas, mais la plupart, néanmoins, sont Debian / Ubuntu.

Commençons

Je dirai tout de suite, c'est pratique pour moi lorsque toute la configuration de l'hôte est des services, des configurations, des logiciels, des comptes, etc. - ils sont décrits par un fichier yaml, cela évite en fait de documenter l'infrastructure et donne une configuration claire. Il a ouvert le projet correspondant dans le référentiel git, où les noms de fichiers correspondent au nom d'hôte, puis a ouvert la configuration de l'hôte souhaité. Et vous pouvez immédiatement voir quels services sont sur l'hôte, ce qui est sauvegardé à partir de cela, ce qui est surveillé, etc.

Voici à quoi ressemble la structure du projet dans le référentiel: project_1/hostname1.com.yaml project_2/hostname2.com.yaml project_3/hostname3.com.yaml

J'utilise ici un tel modèle, qui décrit la configuration de l'un de nos serveurs:

Modèle complet #============================|INPUT DATA|=================================# #---------------------------------------|VARS|----------------------------# #---//Information about variables, keys & contacts//----------------------# host_address: xxxx my_company: my_mail_domain: my_ssh_port: #---------------------------------------|CLASSES|-------------------------# #---//Classes are modules installed on the server.//----------------------# #---//These modules process the arguments typed below.//------------------# #---//Without classes nothing will work.//--------------------------------# #---//Class default_role is mandatory. This class will install//----------# #---//etckeeper, some required perl modules and manages all the logics.//-# classes: - default_role #---------------------------------------|TIMEZONE|------------------------# #---//Set timezone, which will be used on the host.//---------------------# timezone::timezone: Europe/Moscow #---------------------------------------|FACTS|---------------------------# #---//Facts are variables which puppet agent uses.//----------------------# facter::facts_hash: role: value: 'name' company: value: 'name of company' file: 'location.txt' #=========================================================================# #============================|PUPPET|=====================================# #---//Settings for puppet agent.//----------------------------------------# puppet::runmode: cron puppet::ca_server: puppet::puppetmaster: #=========================================================================# #============================|CRON TASKS|=================================# cron_tasks: Name: command: user: minute: '' hour: '' #=========================================================================# #============================|SUPERVISOR|=================================# #---//Supervisor is a process manager//-----------------------------------# supervisord::install_pip: false supervisord::install_init: false supervisord::service_name: supervisor supervisord::package_provider: apt supervisord::executable: /usr/bin/supervisord supervisord::executable_ctl: /usr/bin/supervisorctl supervisord::config_file: /etc/supervisor/supervisord.conf supervisord::programs: 'name': ensure: present command: 'su - rails -c "/home/name/s2"' autostart: no autorestart: 'false' directory: /home/name/domainName/current #=========================================================================# #============================|SECURITY|===================================# #-------------------------------------|FIREWALL|--------------------------# #---//Iptables rules//----------------------------------------------------# firewall: 096 Allow inbound SSH: dport: proto: tcp action: accept #-------------------------------------|FAIL2BAN|--------------------------# #-------------------------------------|ACCESS|----------------------------# #--------------------------------------------|ACCOUNTS|-------------------# #---//Discription of accounts which will be created on server.//----------# accounts: user: shell: '/bin/bash' password: '' locked: false purge_sshkeys: true groups: - docker sshkeys: - #--------------------------------------------|SUDO|-----------------------# #---//Appointment permissions for users.//--------------------------------# sudo::config_file_replace: false sudo::configs: user: content: #--------------------------------------------|SSH|------------------------# #--------//Settings for ssh server.//-------------------------------------# ssh::storeconfigs_enabled: true ssh::server_options: Protocol: '2' Port: PasswordAuthentication: 'yes' PermitRootLogin: 'without-password' SyslogFacility: 'AUTHPRIV' UsePAM: 'yes' X11Forwarding: 'no' #--------------------------------------------|VPN|------------------------# #---//Settings for vpn server.//------------------------------------------# openvpn::servers: 'namehost': country: '' province: '' city: '' organization: '' email: '' server: 'xxxx 255.255.255.0' dev: tun local: openvpn::client_defaults: server: 'namehost' openvpn::clients: # Firstname Lastname 'user': {} openvpn::client_specific_configs: 'user': server: 'namehost' redirect_gateway: true route: - xxxx 255.255.255.255 #=========================================================================# #============================|OPERATING SYSTEM|===========================# #---------------------------------------------|SYSCTL|--------------------# #---//set sysctl parameters//---------------------------------------------# sysctl::base::values: fs.file-max: value: '2097152000' net.netfilter.nf_conntrack_max: value: '1048576' net.nf_conntrack_max: value: '1048576' net.ipv6.conf.all.disable_ipv6: value: '1' vm.oom_kill_allocating_task: value: '1' net.ipv4.ip_forward: value: '0' net.ipv4.tcp_keepalive_time: value: '3' net.ipv4.tcp_keepalive_intvl: value: '60' net.ipv4.tcp_keepalive_probes: value: '9' #---------------------------------------------|RCS|-----------------------# #---//Managment of RC scenario//------------------------------------------# rcs::tmptime: '-1' #---------------------------------------------|WEB SERVERS|---------------# #---------------------------------------------------------|HAPROXY|-------# #---//HAProxy is software that provides a high availability load//--------# #---//balancer and proxy server for TCP and HTTP-based applications//-----# #---// that spreads requests across multiple servers.//-------------------# haproxy::merge_options: true haproxy::defaults_options: log: global maxconn: 20000 option: [ 'tcplog', 'redispatch', 'dontlognull' ] retries: 3 stats: enable timeout: [ 'http-request 10s', 'queue 1m', 'check 10s', 'connect 300000000ms', 'client 300000000ms', 'server 300000000ms' ] haproxy_server: stats: ipaddress: ports: '9090' options: mode: 'http' stats: [ 'uri /', 'auth puppet:123123123' ] postgres: collect_exported: false ipaddress: '0.0.0.0' ports: '5432' options: option: - tcplog balance: roundrobin haproxy_balancemember: hostname1: listening_service: postgres server_names: hostname1 ipaddresses: ports: 6432 options: check hostname2: listening_service: postgres server_names: hostname2 ipaddresses: ports: 6432 options: - check - backup #---------------------------------------------|NGINX|---------------------# #---//Nginx is a web server which can also be used as a reverse proxy,//--# #---//load balancer, mail proxy and HTTP cache//--------------------------# nginx::nginx_cfg_prepend: 'load_module': - modules/ngx_http_geoip_module.so nginx::http_raw_append: - 'real_ip_header X-Forwarded-For;' - 'geoip_country /usr/share/GeoIP/GeoIP.dat;' - 'set_real_ip_from 0.0.0.0/0;' nginx::worker_rlimit_nofile: 16384 nginx::confd: true nginx::server_purrge: true nginx::server::maintenance: true #---------------------------------------------nginx-|MAPS|----------------# nginx::string_mappings: allowed_country: ensure: present string: '$geoip_country_code' mappings: - key: 'default' value: 'yes' - key: 'US' value: 'no' #---------------------------------------------nginx-|UPSTREAMS|-----------# nginx::nginx_upstreams: : ensure: present members: - #---------------------------------------------nginx-|VHOSTS|--------------# nginx::nginx_servers: 'hostname': proxy: 'http://' location_raw_append: - 'if ($allowed_country = no) {return 403;}' try_files: - '' - /index.html - =404 ssl: true ssl_cert: ssl_key: ssl_trusted_cert: ssl_redirect: false ssl_port: 443 error_pages: '403': /usa-restrict.html #---------------------------------------------nginx-|HTTPAUTH|------------# httpauth: 'admin': file: password: '' realm: realm mechanism: basic ensure: present #---------------------------------------------nginx-|LOCATIONS|-----------# nginx::nginx_locations: 'domain1.com/usa-restricted': location: /usa-restrict.html www_root: /home/clientName1/clientName1-client-release/current/dist server: domain1.com ssl: true '^~ domain2.com/resources/upload/': location: '^~ /resources/upload/' server: domain2.com location_alias: '/home/clientName2/upload/' raw_append: - 'if ($allowed_country = no) {return 403;}' '/nginx_status-domain3.com': location: /nginx_status stub_status: on raw_append: - access_log off; - allow 127.0.0.1; - deny all; #---------------------------------------------nginx-|WELL-KNOWN|----------# #---//These locations are needed for SSL certificates generating//--------# #---//with Letsencrypt.//-------------------------------------------------# 'x.hostname.zz/.well-known': location: '/.well-known' server: x.hostname.zz proxy: 'http://kibana' auth_basic: auth_basic_user_file: add_header Pragma public;public, must-revalidate, proxy-revalidate/home/hostname/hostname-release/shared/ecosystem.config.jslogslog_typeformat%{::domain}%{lookup('host_address')}/32(rw,fsid=root,insecure,no_subtree_check,async,no_root_squash)host_addresso=Debian,n=${distro_codename}o=Debian,n=${distro_codename}-securityo=Debian,n=${distro_codename}-updateso=Debian,n=${distro_codename}-proposedo=Debian,n=${distro_codename}-backportso=debian icinga,n=icinga-${distro_codename}o=Zabbix,n=${distro_codename}%{lookup('my_ftp_hostname')}%{lookup('my_backup_ftp_username')}%{lookup('my_backup_ftp_password')}%{lookup('my_backup_compressor')}/tmp/mediastagetv_netbynet%{lookup('host_address')}:/%{lookup('host_address')}redis%{lookup('host_address')}*.*;auth,authpriv.none /var/log/syslog\nmail.* -/var/log/mail.log\n& stopauth,authpriv.* /var/log/auth\n& stop:programname,contains,\ /var/log/puppetlabs/puppet/puppet-agent.log\n& stop:msg,contains,\ /var/log/iptables/iptables.log\n& stop:msg,regex,\ /var/log/admin/auth.log\n& stop:msg,regex,\ /var/log/admin/auth.log\n& stop #---------------------------------------------|LOGWATCH|------------------# #---//Logwatch is a log-analysator for create short reports.//------------# logwatch::format: text logwatch::service: # Ignore this servie - -http - -iptables #---------------------------------------------|LOGROTATE|-----------------# #---//Management of rotation of log files.//------------------------------# my_rclogs_path: '/home/hostname/hostname/shared/log' my_rclogs_amazon_path: '/home/hostname1/hostname1/shared/log_amazon' my_ttlogs_path: '/home/hostname2/hostname2/shared/log' my_ttlogs_amazon_path: '/home/hostname/hostname/shared/log_amazon' logrotate::ensure: latest logrotate::config: dateext: true compress: true logrotate::rules: booking-logs: path: '%{lookup("my_rclogs_path")}/booking_com.log' size: 2500M rotate: 20 copytruncate: true delaycompress: true dateext: true dateformat: -%Y%m%d-%s compress: true postrotate: mv %{lookup('my_rclogs_path')}/booking_com.log*.gz %{lookup('my_rclogs_amazon_path')}/ #---------------------------------------------|ATOP|----------------------# #---//ATOP service displays a new information about CPU//-----------------# #---//and memory utilization.//-------------------------------------------# atop::service: true atop::interval: 30 #----------------------------------------|DNS|----------------------------# #---//Management of file /etc/resolv.conf//-------------------------------# resolv_conf::nameservers: - 0.0.0.0 - 0.0.0.0 #=========================================================================# #============================|DATABASES|==================================# #--------------------------------------|MYSQL|----------------------------# #---//MySQL is a relational database management system.//-----------------# mysql::server::package_ensure: 'installed' #· mysql::server::root_password: mysql::server::manage_config_file: true mysql::server::service_name: 'mysql' # required for puppet module mysql::server::override_options: 'mysqld': 'bind-address': '*' : , : , : , mysql::server::db: : user: password: host: grant: - #-------------------------------------|ELASTICSEARCH|---------------------# #---//Elasticsearch is a search engine based on Lucene.//-----------------# #---//It provides a distributed, multitenant-capable full-text search//---# #---//engine with an HTTP web interface and schema-free JSON documents.//-# elasticsearch::version: 5.5.1 elasticsearch::manage_repo: true elasticsearch::repo_version: 5.x elasticsearch::java_install: false elasticsearch::restart_on_change: true elasticsearch_instance: 'es-01': ensure: 'present' #-------------------------------------|REDIS|-----------------------------# #---//Redis is an in-memory database project implementing//---------------# #---//a distributed, in-memory key-value store with//---------------------# #---//optional durability.//----------------------------------------------# redis::bind: 0.0.0.0 #-------------------------------------|ZOOKEPER|--------------------------# #---//Zooker is a centralized service for distributed systems//-----------# #---//to a hierarchical key-value store, which is used to provide//-------# #---//a distributed configuration service, synchronization service,//-----# #---//and naming registry for large distributed systems.//----------------# zookeeper::init_limit: '1000' zookeeper::id: '1' zookeeper::purge_interval: '1' zookeeper::servers: - #-------------------------------------|POSTGRES|--------------------------# #---//Postgres, is an object-relational database management system//------# #---//with an emphasis on extensibility and standards compliance.//-------# #---//As a database server, its primary functions are to store data//----# #---//securely and return that data in response to requests from other//--# #---//software applications.//--------------------------------------------# postgresql::server::postgres_password: postgresql::server::ip_mask_allow_all_users: '0.0.0.0/0' postgresql::postgresql::server: ip_mask_allow_all_users: '0.0.0.0/32' postgres_db: master: user: password: confluence: user: password: postgres_config: 'max_connections': value: 300 postgres_hba: 'Allow locals without password': order: 1 description: 'locals postgres no password' type: 'host' address: '127.0.0.1/32' database: 'all' user: 'all' auth_method: 'trust' #----------------------------------------------|PGBOUNCER|----------------# #---//PgBouncer is a connection pooler for PostgreSQL//-------------------# pgbouncer::group: postgres pgbouncer::user: postgres pgbouncer::userlist: - user: password: pgbouncer::databases: - source_db: recommender host: dest_db: recommender auth_user: recommender pool_size: 200 auth_pass: - source_db: master host: dest_db: recommender auth_user: recommender pool_size: 50 auth_pass: - source_db: slave host: dest_db: recommender auth_user: recommender pool_size: 200 auth_pass: #=========================================================================# #==============================|APPLICATION SERVICES|=====================# #---------------------------------------------------|CONFLUENCE|----------# #---------------------------------------------------|JENKINS|-------------# #=========================================================================#

Exemple de section de surveillance:

#============================|MONITORING|=================================# #---------------------------------------|ICINGA SERVICES|-----------------# #---//Managment of monitoring system.//-----------------------------------# icinga2_service: '%{::fqdn} virtual host' : target: /etc/icinga2/zones.d/master/%{::fqdn}.conf apply: true assign: [ 'host.name == %{::fqdn}' ] display_name: '%{::fqdn} virtualhost' check_command: 'http' vars: http_uri: / http_ssl: true http_vhost: 'hostname' http_address: '%{::fqdn} nginx status' : target: /etc/icinga2/zones.d/master/%{::fqdn}.conf apply: true assign: [ 'host.name == %{::fqdn}' ] command_endpoint: '%{::fqdn}' display_name: 'nginx status' check_command: 'nginx_status' vars: nginx_status_host_address: localhost nginx_status_servername: server.com nginx_status_critical: '1600,60,30' nginx_status_warn: '1500,55,25' '%{::fqdn} redis': target: /etc/icinga2/zones.d/master/%{::fqdn}.conf apply: true assign: [ 'host.name == %{::fqdn}' ] display_name: 'Redis' command_endpoint: '%{::fqdn}' check_command: vars: redis_hostname: localhost redis_port: 6379 redis_perfvars: '*' #=========================================================================#

Le schéma général de fonctionnement d'un tel schéma ne comprend que deux actions simples:

- Nous démarrons la marionnette sur l'hôte - l'hôte voit les vérifications qui lui appartiennent et les exporte vers puppetDB.

- Exécutez puppet dans le conteneur icinga2 - les vérifications de puppetdb se transforment en véritables configurations Icinga2.

Ici, beaucoup diront:

"Pourquoi dois-je faire tout cela, si je peux augmenter le icinga2 habituel et ajouter des chèques avec mes mains ou via l'interface Web?"En effet, si vous avez besoin de surveiller une douzaine d'hôtes avec des centaines de services, et que vous êtes une personne assez soignée avec une bonne mémoire (introuvable dans la nature), cela n'a aucun sens de clôturer un jardin. C'est une tout autre affaire si vous avez une infrastructure assez grande et si vous avez le sentiment que vous avez peut-être oublié quelque chose quelque part. À de tels moments, l'automatisation aide beaucoup, car aide à tout mettre sur les étagères et à éviter, à bien des égards, le facteur humain.

Indiquez les principaux avantages:

Regardons ce modèle: icinga2_service: '%{::fqdn} disk service': target: /etc/icinga2/zones.d/master/%{::fqdn}.conf apply: true assign: [ 'host.name == %{::fqdn}' ] display_name: 'Disk usage' command_endpoint: '%{::fqdn}' check_command: 'disk' vars: #All disks disk_all: true disk_exclude_type: - aufs - tmpfs disk_ignore_ereg_path: - /run/docker

+ 1. Hiera — .. . Icinga2, , . , , , .

+ 2. , . — .

+ 3. , .. , Icinga2 , puppet Icinga2.

+ 4. Ainsi, toutes les vérifications que nous avons stockées dans une seule base de données puppetDB, nous pouvons créer des scripts assez puissants pour une automatisation supplémentaire, dans laquelle nous utiliserons ces informations.

Alors allons-y

1. Installez la marionnette.

J'espère que vous avez configuré docker et docker-compose.Sinon, vous devez les installer:Installation de Docker ...Installation de Docker-compose ...2. Nous clonons le référentiel sur notre serveur:

git clone http://git.comgress64.com/external/puppet-icinga2-how-to.git

3. Ouvrez docker-compose.yaml avec votre éditeur préféré et regardez-le.

Nous voyons que dans ce pack, nous avons plusieurs conteneurs qui montent à la fois - PuppetServer, PuppetDb, serveur PostgreSQL et PuppetBoard. Volumes également montés à partir du répertoire actuel. Cette configuration n'est pas optimale pour tout le monde, alors pensez à votre infrastructure. Quelqu'un a déjà un serveur PostgreSQL, quelqu'un veut stocker du code sur une autre section - voici la liberté de la créativité. À ce stade, je suggère de laisser le modèle par défaut - vous pouvez toujours y revenir plus tard. Prenons notre pack de conteneurs et voyons ce qui s'est passé:4. Lancez le conteneur Puppet, Postgres, Puppetdb et Graphite.

Nous avons maintenant chargé plusieurs images et lancé des conteneurs, créé des bases de données dans PostgreSQL. Attendons que tous les serveurs soient démarrés - les erreurs peuvent être ignorées, car elles devraient se stabiliser après un certain temps. Appuyez sur Ctrl + C pour quitter le mode d'affichage du journal.5. Vérifiez le travail de notre maître de marionnettes:

docker run --net puppeticinga2howto_default --link puppet:puppet puppet/puppet-agent

6. Si tout va bien, vous verrez cette conclusion:

Notice: Applied catalog in 0.03 seconds Changes: Total: 1 Events: Success: 1 Total: 1 Resources: Changed: 1 Out of sync: 1 Total: 8 Time: Schedule: 0.00 File: 0.00 Transaction evaluation: 0.01 Catalog application: 0.03 Convert catalog: 0.04 Config retrieval: 0.45 Node retrieval: 1.38 Last run: 1532605377 Fact generation: 2.24 Plugin sync: 4.50 Filebucket: 0.00 Total: 8.65 Version: Config: 1532605376 Puppet: 5.5.1

Configurez le serveur Icinga2.7. Créez l'image à partir du Dockerfile en procédant comme suit:

docker-compose build icinga

8. Exécutez le conteneur dans lequel le serveur Icinga2 vivra.

docker-compose up -d icinga

9. Jusqu'à présent, notre conteneur est vide. Configurons le serveur icinga2 à l'aide de notre serveur Puppet en faisant:

10. Installez et configurez Icinga, Icingaweb2 et Apache.

Votre serveur Icinga2 est prêt!

Icingaweb2

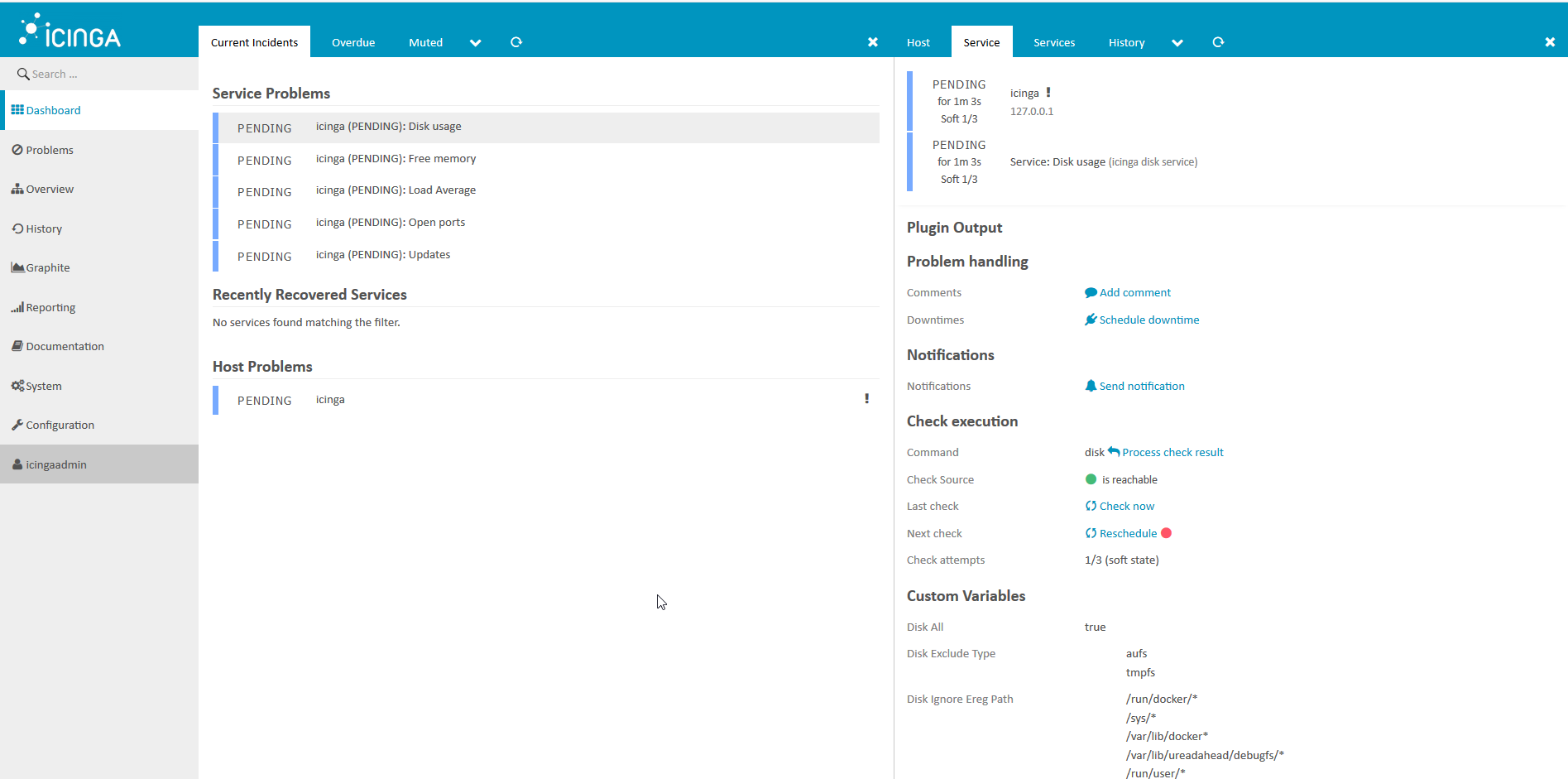

1. Voyons ce que nous avons.

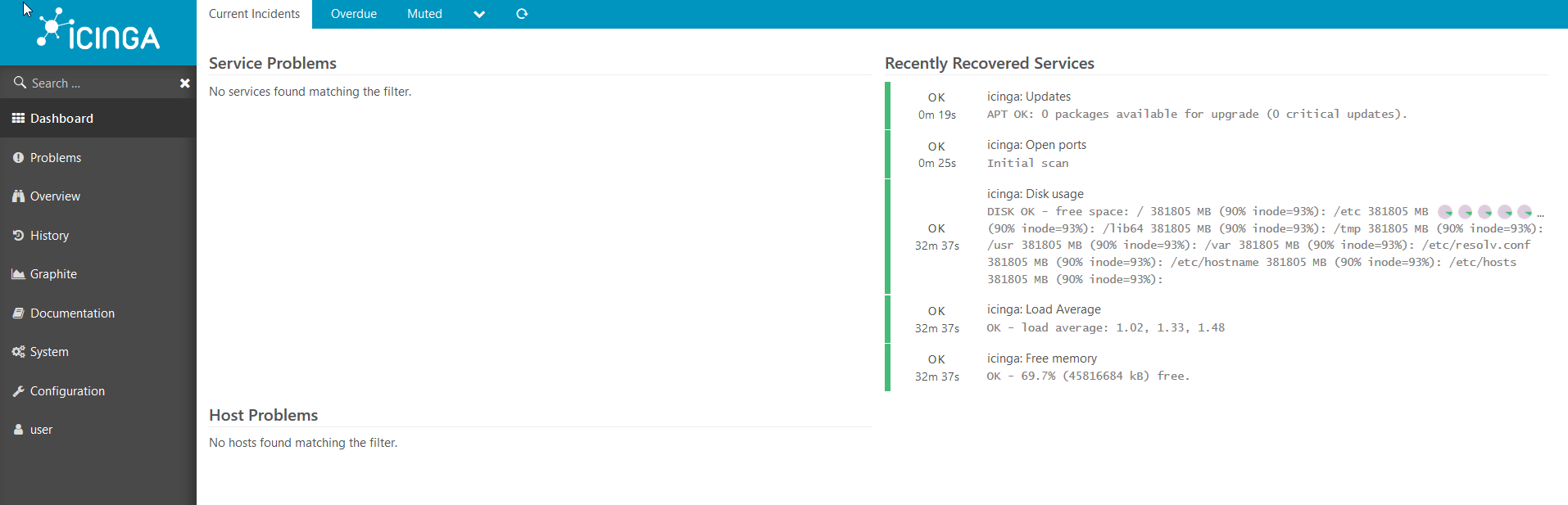

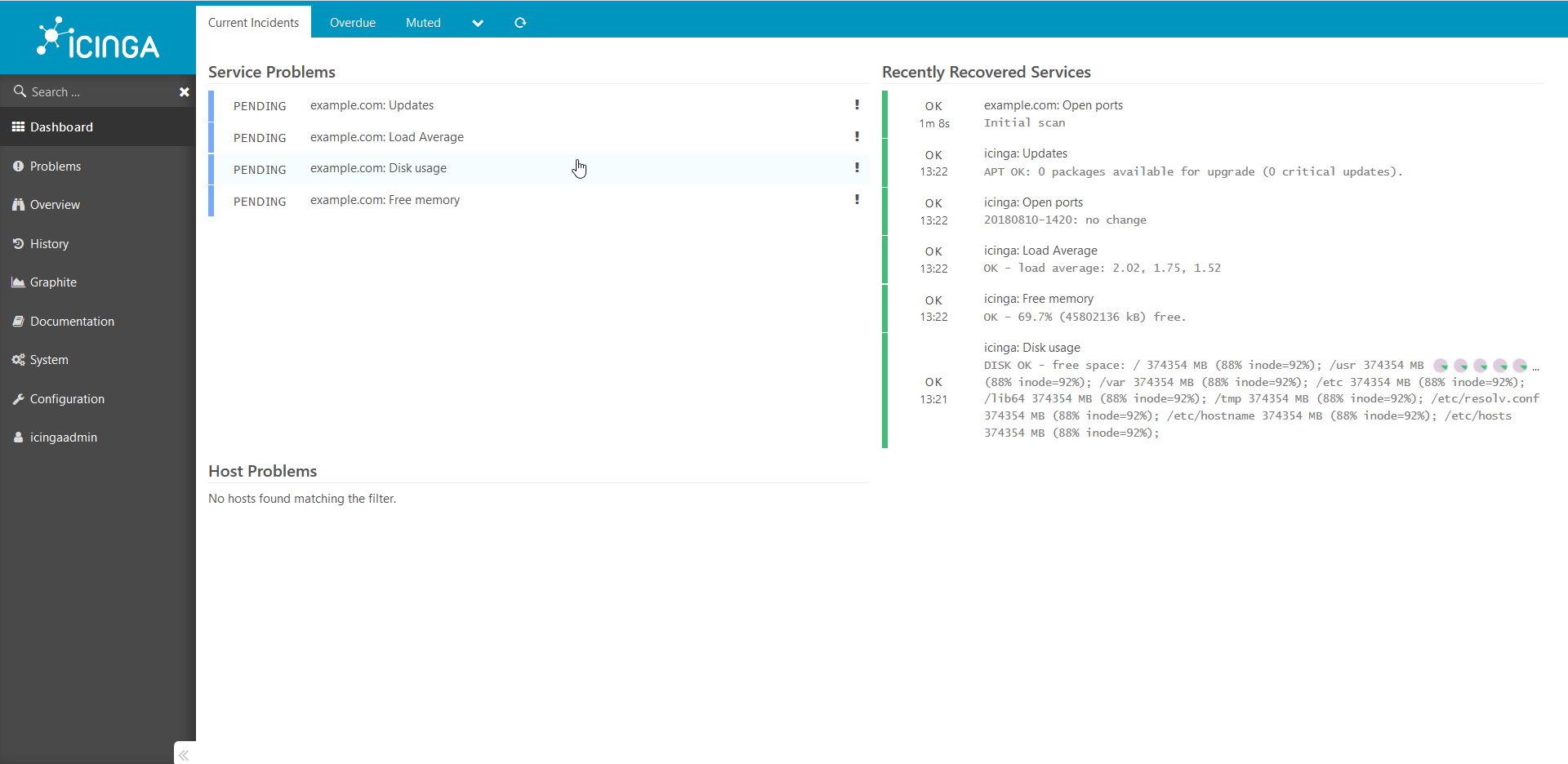

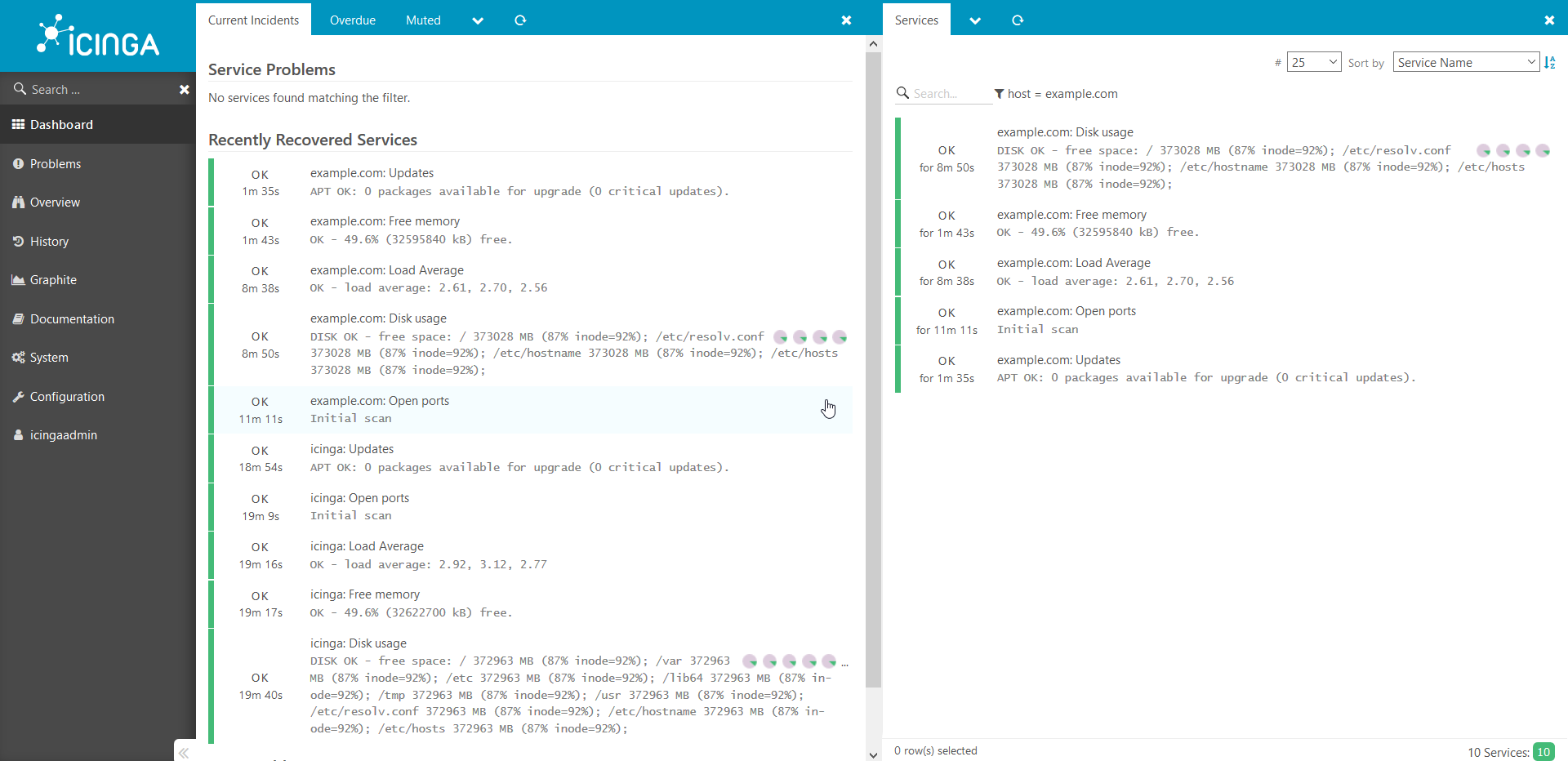

Il est pratique d'examiner l'état du système de surveillance dans le navigateur, procédez comme suit :Ouvrez dans le navigateur http://ip___:8081/icingaweb2et accédez à Icinga avec le nom d'utilisateur par défaut: icingaadmin / icinga .Nous voyons cette image: Après quelques minutes, nous voyons que toutes les vérifications ont fonctionné pour nous: Les

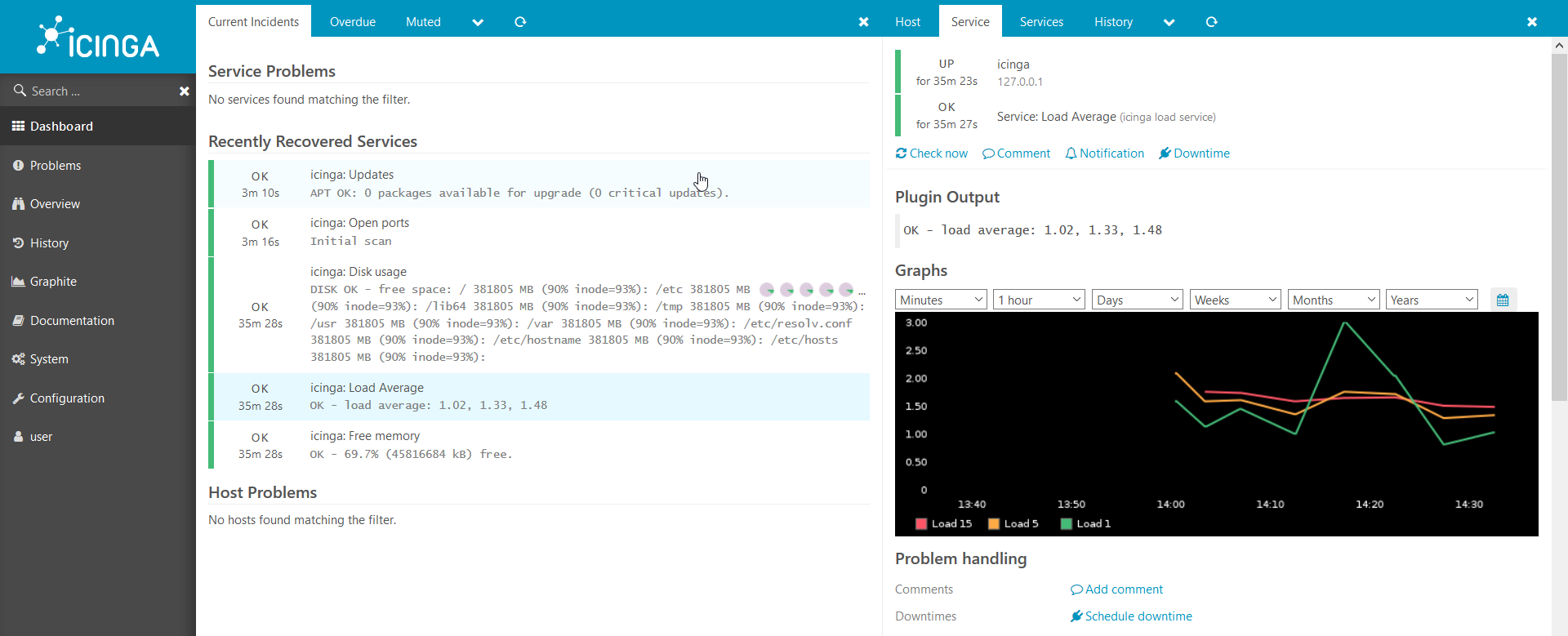

Après quelques minutes, nous voyons que toutes les vérifications ont fonctionné pour nous: Les graphiques fonctionnent également:

graphiques fonctionnent également: Nous avons un environnement Web fonctionnel pour Icinga2, mais il n'y a pas encore d'hôtes connectés à Icinga, connectons notre premier hôte.

Nous avons un environnement Web fonctionnel pour Icinga2, mais il n'y a pas encore d'hôtes connectés à Icinga, connectons notre premier hôte.2. Connectez le nouvel hôte au système de surveillance

Nous avons maintenant un seul hôte connecté à icinga2 - Icinga lui-même. Connectons un autre.Je montre un exemple dans un docker, mais tout de même fonctionnera sur du métal nu:vous devez d'abord préparer un modèle et donner quelques informations sur l'hôte pour la marionnette:

. hostname , : docker run --hostname example.com --rm -t --link puppet:puppet --net puppeticinga2howto_default -i phusion/baseimage:latest /sbin/my_init -- bash -l

puppet : apt-get update && apt-get install -y ruby make gcc perl-modules && gem install --no-ri --no-rdoc puppet

puppet: puppet agent --server puppet --waitforcert 60 --test

icinga2 puppetDB. , puppet icinga2: docker-compose exec icinga puppet agent --server puppet --waitforcert 60 --test

Nous regardons à travers le navigateur ce que nous avons obtenu: des chèques ont été ajoutés et sont en attente d'achèvement.Après 5 minutes: de

chèques ont été ajoutés et sont en attente d'achèvement.Après 5 minutes: de la même manière, tous les autres hôtes sont ajoutés au système. Je veux attirer votre attention sur le fait que ce guide est une preuve de concept et ne peut pas être utilisé dans un environnement de production sans aucune modification.Si l'article semble intéressant, la prochaine fois je montrerai comment vous pouvez ajouter toutes sortes de vérifications personnalisées intéressantes, partager des secrets et parler de toutes sortes de subtilités. De plus, s'il y a un désir, je dirai plus en détail comment tout cela fonctionne de l'intérieur.Merci de votre attention!

la même manière, tous les autres hôtes sont ajoutés au système. Je veux attirer votre attention sur le fait que ce guide est une preuve de concept et ne peut pas être utilisé dans un environnement de production sans aucune modification.Si l'article semble intéressant, la prochaine fois je montrerai comment vous pouvez ajouter toutes sortes de vérifications personnalisées intéressantes, partager des secrets et parler de toutes sortes de subtilités. De plus, s'il y a un désir, je dirai plus en détail comment tout cela fonctionne de l'intérieur.Merci de votre attention!

Confluence:/ ./docs.comgress64.com/...:https://github.com/Icinga/puppet-icinga2https://forge.puppet.com/icinga/icingaweb2https://docs.docker.com/https://docs.puppet.com/https://docs.puppet.com/hiera/