Il y a quelques mois, alors qu'ils travaillaient sur le prochain projet, les gars de notre laboratoire de recherche ont étudié les disques NVMe et les solutions logicielles afin de trouver la meilleure option pour assembler une matrice logicielle.

Les résultats des tests étaient alors étonnamment décourageants - l'énorme potentiel de vitesse des disques NVMe n'était pas du tout en corrélation avec les performances démontrées des produits logiciels existants.

Nos développeurs ne l'ont pas aimé. Et ils ont décidé d'écrire leur produit ... Un produit que les spécialistes du marketing ont ensuite joyeusement proposé avec le nom RAIDIX ERA.

Aujourd'hui, plus d'une douzaine d'entreprises produisent des serveurs adaptés à l'utilisation des disques NVMe. Le marché des produits qui soutiennent et développent cette technologie a un énorme potentiel. Dans le rapport analytique G2M, des chiffres assez convaincants sont présentés, convaincant que ce protocole de transfert de données dominera dans un avenir proche.

Graphique du rapport G2M

Graphique du rapport G2MActuellement, Intel est l'un des leaders de la production de composants NVMe. C'est sur leur équipement que nous avons effectué des tests pour évaluer les capacités des logiciels existants à gérer un matériel aussi «innovant».

En collaboration avec notre partenaire Promobit (fabricant de serveurs et de systèmes de stockage de données sous la marque BITBLAZE), nous avons organisé des tests des disques NVMe d'Intel et des logiciels courants pour la gestion de ces appareils. Les tests ont été effectués selon la méthode SNIA.

Dans cet article, nous partagerons les chiffres obtenus lors des tests du système matériel Intel NVMe, des baies logicielles de MDRAID, Zvol sur ZFS RAIDZ2 et, en fait, de notre nouveau développement.

Configuration matérielle

Pour la base de la plateforme de test, nous avons pris le système serveur Intel Server System R2224WFTZS. Il dispose de 2 sockets pour l'installation de processeurs évolutifs Intel Xeon et de 12 canaux de mémoire (24 DIMM au total) DDR 4 avec une fréquence allant jusqu'à 2666 MHz.

Vous trouverez plus d'informations sur la plate-forme serveur

sur le site Web du fabricant .

Tous les disques NVMe connectés via 3

backplanes F2U8X25S3PHS .

Au total, nous avons obtenu 12 disques NVMe INTEL SSDPD2MD800G4 avec le firmware CVEK6256004E1P0BGN dans le système.

La plate-forme serveur était équipée de deux processeurs Intel® Xeon® Gold 6130 à 2,10 GHz avec Hyper-Threading activé, permettant de lancer deux threads à partir de chaque cœur. Ainsi, en sortie, nous avons reçu 64 threads de calcul.

Préparation au test

Tous les tests de cet article ont été effectués conformément aux spécifications de la méthodologie SNIA SSS PTSe v 1.1. Y compris, une préparation préliminaire du stockage a été effectuée afin d'obtenir un résultat stable et honnête.

SNIA permet à l'utilisateur de définir les paramètres du nombre de threads et de la profondeur de file d'attente, nous avons donc défini 64/32, avec 64 threads de calcul sur 32 cœurs.

Chaque test a été effectué en 16 cycles pour amener le système à un niveau stable d'indicateurs et exclure les valeurs aléatoires.

Avant de commencer les tests, nous avons effectué une préparation préalable du système:

- Installation de la version 4.11 du noyau sur CentOS 7.4.

- Désactivez C-STATES et P-STATES.

- Exécutez l'utilitaire tuned-adm et définissez le profil de performances de latence.

Les tests de chaque produit et article ont été effectués selon les étapes suivantes:

Préparation des appareils selon la spécification SNIA (dépendante et indépendante du type de charge).

- Test IOps en blocs de 4k, 8k, 16k, 32k, 64k, 128k, 1m avec des variations de combinaisons de lecture / écriture 0/100, 5/95, 35/65, 50/50, 65/35, 95/5, 100/0 .

- Tests de latence avec des blocs 4k, 8k, 16k avec des variations de combinaisons de lecture / écriture 0/100, 65/35 et 100/0. Le nombre de threads et la profondeur de file d'attente est de 1-1. Les résultats sont enregistrés en tant que retards moyens et maximaux.

- Test de rendement avec blocs de 128k et 1M, en 64 lignes de 8 équipes.

Nous avons commencé par tester les performances, la latence et le débit de la plate-forme matérielle. Cela nous a permis d'évaluer le potentiel de l'équipement proposé et de comparer avec les capacités des solutions logicielles appliquées.

Test 1. Test matériel

Pour commencer, nous avons décidé de voir de quoi un disque Intel DCM D3700 NVMe est capable.

Dans la spécification, le fabricant déclare les paramètres de performances suivants:

Lecture aléatoire (100%) 450 000 IOPS

Écriture aléatoire (100%) 88000 IOPS

Test 1.1 Un lecteur NVMe. Test IOPS

Résultat de performance (IOps) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 84017.8 | 91393.8 | 117271.6 | 133059.4 | 175086.8 | 281131.2 | 390969.2 |

| 8k | 42602.6 | 45735.8 | 58980.2 | 67321.4 | 101357.2 | 171316.8 | 216551.4 |

| 16k | 21618.8 | 22834.8 | 29703.6 | 33821.2 | 52552,6 | 89731.2 | 108347 |

| 32k | 10929.4 | 11322 | 14787 | 16811 | 26577,6 | 47185.2 | 50670.8 |

| 64k | 5494,4 | 5671,6 | 7342,6 | 8285.8 | 13130.2 | 23884 | 27249.2 |

| 128k | 2748,4 | 2805.2 | 3617,8 | 4295.2 | 6506,6 | 11997,6 | 13631 |

| 1m | 351,6 | 354,8 | 451,2 | 684,8 | 830.2 | 1574,4 | 1702.8 |

Résultat de performance (IOps) sous forme graphique. Lecture / écriture Mix%.

A ce stade, nous avons obtenu des résultats qui n'atteignent pas tout à fait ceux de l'usine. Très probablement, NUMA (le schéma d'implémentation de la mémoire informatique utilisé dans les systèmes multiprocesseurs, lorsque le temps d'accès à la mémoire est déterminé par son emplacement par rapport au processeur) a joué son rôle, mais pour l'instant nous n'y prêterons pas attention.

Testez 1.2 Un lecteur NVMe. Tests de retard

Temps de réponse moyen (ms) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,02719 | 0,072134 | 0,099402 |

| 8k | 0,029864 | 0,093092 | 0,121582 |

| 16k | 0,046726 | 0,137016 | 0,16405 |

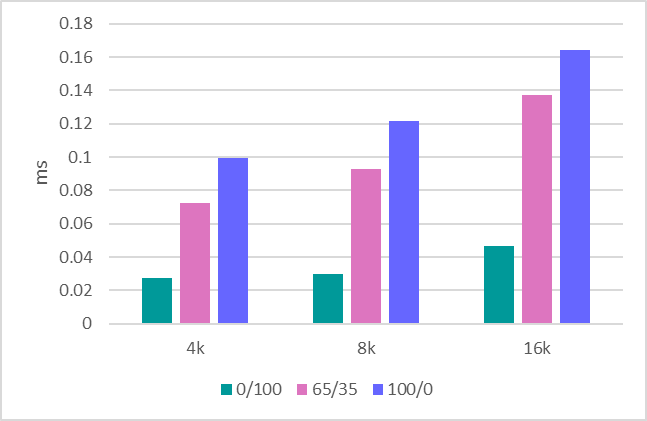

Temps de réponse moyen (ms) sous forme graphique. Lecture / écriture Mix%.

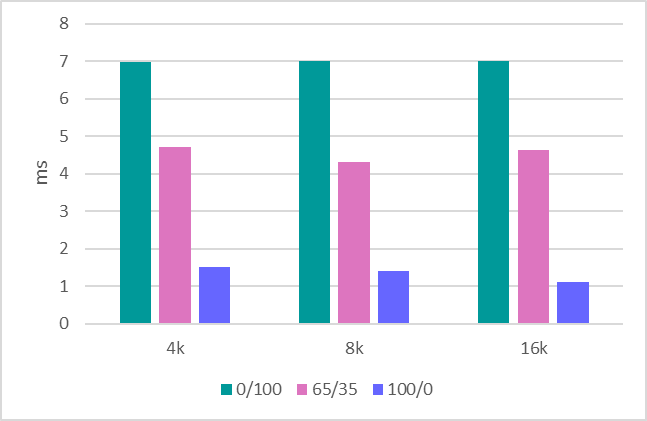

Temps de réponse maximum

Temps de réponse maximum (ms) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6,9856 | 4.7147 | 1.5098 |

| 8k | 7.0004 | 4.3118 | 1,4086 |

| 16k | 7.0068 | 4.6445 | 1.1064 |

Temps de réponse maximum (ms) sous forme graphique. Lecture / écriture Mix%.

Test 1.3 Débit

La dernière étape consiste à évaluer le débit. Voici les indicateurs suivants:

Enregistrement séquentiel de 1 Mo - 634 Mo / s.

Lecture séquentielle 1 Mo - 1707 Mo / s.

Enregistrement séquentiel de 128 Ko - 620 Mo / s.

Lecture séquentielle de 128 Ko - 1704 Mo / s.

Après avoir traité un lecteur, nous procédons à l'évaluation de la plate-forme entière, qui se compose de 12 lecteurs.

Test 1.4 Système sur 12 disques. Test IOPS

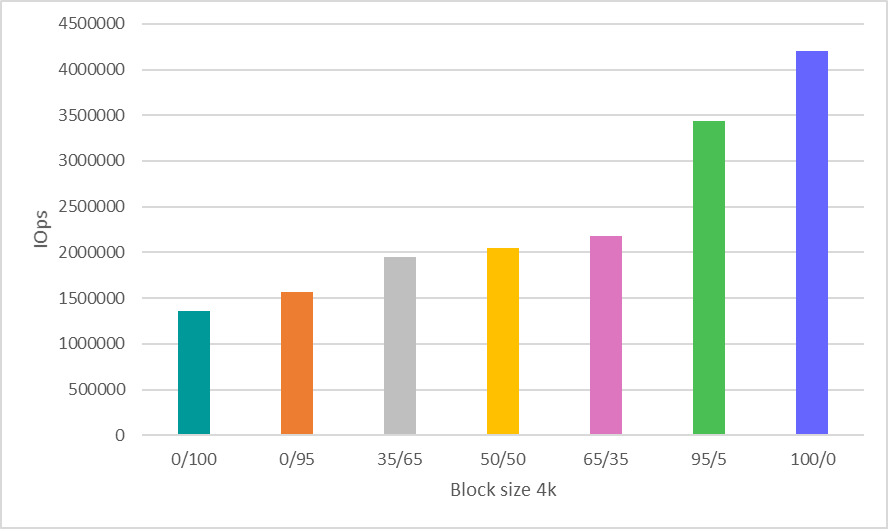

Ici, une décision volontaire a été prise pour gagner du temps et afficher les résultats uniquement pour travailler avec le bloc 4k, qui est de loin le scénario le plus courant et indicatif pour évaluer les performances.

Résultat de performance (IOps) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 1363078.6 | 1562345 | 1944105 | 2047612 | 2176476 | 3441311 | 4202364 |

Résultat de performance (IOps) sous forme graphique. Lecture / écriture Mix%.

Test 1.5 Système sur 12 disques. Tests de bande passante

Enregistrement séquentiel de 1 Mo - 8612 Mbps.

Lecture séquentielle 1 Mo - 20481 Mbps.

Enregistrement séquentiel de 128 Ko - 7500 Mbps.

Lecture séquentielle de 128 Ko - 20 400 Mo / s.

Nous examinerons à nouveau les indicateurs de performances matérielles obtenus à la fin de l'article, en les comparant avec les numéros des logiciels testés dessus.

Test 2: Test de MDRAID

Lorsque nous parlons d'un ensemble de logiciels, MDRAID vient à l'esprit en premier. Rappelons qu'il s'agit du logiciel RAID de base pour Linux, qui est distribué gratuitement.

Voyons comment MDRAID gère le système à 12 disques proposé avec un niveau de matrice RAID 0. Nous comprenons tous que la construction de RAID 0 sur 12 disques nécessite un courage particulier, mais maintenant nous avons besoin de ce niveau de matrice pour démontrer les capacités maximales de cette solution.

Test 2.1 MDRAID. RAID 0. Test IOPS

Résultat de performance (IOps) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 1010396 | 1049306.6 | 1312401.4 | 1459698.6 | 1932776.8 | 2692752.8 | 2963943.6 |

| 8k | 513627.8 | 527230.4 | 678140 | 771887.8 | 1146340.6 | 1894547.8 | 2526853.2 |

| 16k | 261087.4 | 263638.8 | 343679.2 | 392655.2 | 613912.8 | 1034843.2 | 1288299.6 |

| 32k | 131198.6 | 130947.4 | 170846.6 | 216039.4 | 309028.2 | 527920.6 | 644774.6 |

| 64k | 65083.4 | 65099.2 | 85257.2 | 131005.6 | 154839.8 | 268425 | 322739 |

| 128k | 32550.2 | 32718.2 | 43378,6 | 66999.8 | 78935.8 | 136869.8 | 161015.4 |

| 1m | 3802 | 3718,4 | 3233.4 | 3467,2 | 3546 | 6150.8 | 8193.2 |

Résultat de performance (IOps) sous forme graphique. Lecture / écriture Mix%.

Test 2.2 MDRAID. RAID 0. Tests de délai

Temps de réponse moyen (ms) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,03015 | 0,067541 | 0,102942 |

| 8k | 0,03281 | 0,082132 | 0.126008 |

| 16k | 0,050058 | 0,114278 | 0,170798 |

Temps de réponse moyen (ms) sous forme graphique. Lecture / écriture Mix%.

Temps de réponse maximum

Temps de réponse maximum (ms) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6.7042 | 3.7257 | 0,8568 |

| 8k | 6.5918 | 2.2601 | 0,9004 |

| 16k | 6.3466 | 2,77741 | 2,5678 |

Temps de réponse maximum (ms) sous forme graphique. Lecture / écriture Mix%.

Test 2.3 MDRAID. RAID 0. Tests de bande passante

Écriture séquentielle de 1 Mo - 7820 MBPS.

Lecture séquentielle de 1 Mo - 20418 MBPS.

Écriture séquentielle de 128 Ko - 7622 Mo / s.

Lecture séquentielle de 128 Ko - 20 380 Mo / s.

Test 2.4 MDRAID. RAID 6. Test IOPS

Voyons maintenant ce que ce système a au niveau RAID 6.

Options de création de tableaux

mdadm --create --verbose --chunk 16K / dev / md0 --level = 6 --raid-devices = 12 / dev / nvme0n1 / dev / nvme1n1 / dev / nvme2n1 / dev / nvme3n1 / dev / nvme4n1 / dev / nvme5n1 / dev / nvme8n1 / dev / nvme9n1 / dev / nvme10n1 / dev / nvme11n1 / dev / nvme6n1 / dev / nvme7n1

Le volume total de la matrice était de

7450,87 Gio .

Nous commençons le test après l'initialisation préliminaire de la matrice RAID.

Résultat de performance (IOps) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 39907.6 | 42849 | 61609.8 | 78167.6 | 108594.6 | 641950.4 | 1902561.6 |

| 8k | 19474.4 | 20701.6 | 30316.4 | 39737.8 | 57051.6 | 394072.2 | 1875791.4 |

| 16k | 10371.4 | 10979.2 | 16022 | 20992.8 | 29955,6 | 225157.4 | 1267495.6 |

| 32k | 8505.6 | 8824.8 | 12896 | 16657.8 | 23823 | 173261.8 | 596857.8 |

| 64k | 5679,4 | 5931 | 8576.2 | 11137.2 | 15906.4 | 109469.6 | 320874.6 |

| 128k | 3976,8 | 4170.2 | 5974.2 | 7716,6 | 10996 | 68124.4 | 160453.2 |

| 1m | 768,8 | 811,2 | 1177,8 | 1515 | 2149,6 | 4880.4 | 5499 |

Résultat de performance (IOps) sous forme graphique. Lecture / écriture Mix%.

Test 2.5 MDRAID. RAID 6. Tests de délai

Temps de réponse moyen (ms) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,193702 | 0.145565 | 0,10558 |

| 8k | 0,266582 | 0,186618 | 0,127142 |

| 16k | 0,426294 | 0,281667 | 0,169504 |

Temps de réponse moyen (ms) sous forme graphique. Lecture / écriture Mix%.

Temps de réponse maximum

Temps de réponse maximum (ms) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6.1306 | 4.5416 | 4.2322 |

| 8k | 6.2474 | 4.5197 | 3,5898 |

| 16k | 5.4074 | 5.5861 | 4.1404 |

Temps de réponse maximum (ms) sous forme graphique. Lecture / écriture Mix%.

Il est à noter qu'ici MDRAID a montré un très bon niveau de retards.

Test 2.6 MDRAID. RAID 6. Tests de bande passante

Écriture séquentielle de 1 Mo - 890 Mo / s.

Lecture séquentielle de 1 Mo - 18800 MBPS.

Écriture séquentielle de 128 Ko - 870 Mo / s.

Lecture séquentielle de 128 Ko - 10400 MBPS.

Test 3. Zvol sur ZFS RAIDZ2

ZFS a une fonction de création RAID intégrée et un gestionnaire de volume intégré qui crée des périphériques de blocs virtuels, qui sont utilisés par de nombreux fabricants de stockage. Nous profiterons également de ces fonctionnalités en créant un pool avec protection RAIDZ2 (analogue à RAID 6) et un volume de bloc virtuel au-dessus.

La version 0.79 (ZFS) a été compilée. Options de création de baies et de volumes:

ashift = 12 / compression - off / dedup - off / recordsize = 1M / atime = off / cachefile = none / Type RAID = RAIDZ2

ZFS montre de très bons résultats avec le pool nouvellement créé. Cependant, avec un doublage répété, les performances sont considérablement réduites.

L'approche SNIA est bonne car elle vous permet de voir les résultats réels des tests de systèmes de fichiers similaires (celui basé sur ZFS) après des écrasements répétés sur eux.

Testez 3.1 ZVOL (ZFS). RAIDZ2. Test IOps

Résultat de performance (IOps) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 15719,6 | 15147.2 | 14190.2 | 15592,4 | 17965,6 | 44832.2 | 76314.8 |

| 8k | 15536.2 | 14929.4 | 15140.8 | 16551 | 17898.8 | 44553.4 | 76187.4 |

| 16k | 16696,6 | 15937.2 | 15982,6 | 17350 | 18546.2 | 44895.4 | 75549.4 |

| 32k | 11859,6 | 10915 | 9698.2 | 10235.4 | 11265 | 26741.8 | 38167.2 |

| 64k | 7444 | 6440.2 | 6313.2 | 6578.2 | 7465,6 | 14145.8 | 19099 |

| 128k | 4425,4 | 3785,6 | 4059,8 | 3859,4 | 4246.4 | 7143.4 | 10052,6 |

| 1m | 772 | 730,2 | 779,6 | 784 | 824,4 | 995,8 | 1514.2 |

Résultat de performance (IOps) sous forme graphique. Lecture / écriture Mix%.

Les chiffres de performance ne sont absolument pas impressionnants. Dans le même temps, le zvol pur (avant réécriture) donne des résultats nettement meilleurs (5 à 6 fois plus élevés). Ici, le test a montré qu'après le premier doublage, les performances chutaient.

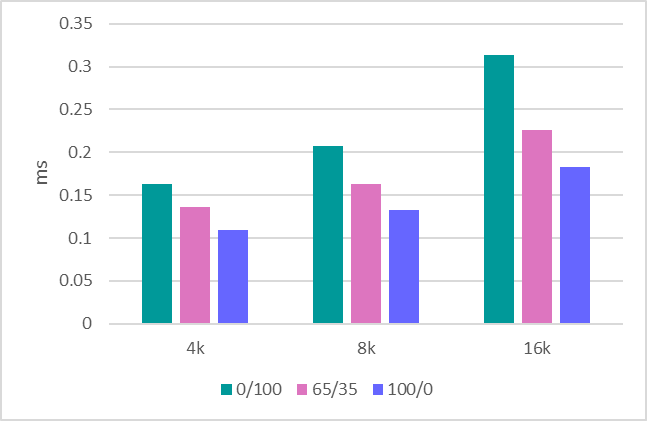

Testez 3.2 ZVOL (ZFS). RAIDZ2. Tests de retard

Temps de réponse moyen (ms) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,332824 | 0,2555225 | 0,218354 |

| 8k | 0,3299 | 0,259013 | 0,225514 |

| 16k | 0.139738 | 0,180467 | 0,233332 |

Temps de réponse moyen (ms) sous forme graphique. Lecture / écriture Mix%.

Temps de réponse maximum

Temps de réponse maximum (ms) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 90,55 | 69,9718 | 84.4018 |

| 8k | 91,6214 | 86.6109 | 104,7368 |

| 16k | 108.2192 | 86.2194 | 105,658 |

Temps de réponse maximum (ms) sous forme graphique. Lecture / écriture Mix%.

Test 3.3 ZVOL (ZFS). RAIDZ2. Tests de bande passante

Écriture séquentielle de 1 Mo - 1150 Mo / s.

Lecture séquentielle de 1 Mo - 5500 MBPS.

Écriture séquentielle de 128 Ko - 1100 Mo / s.

Lecture séquentielle de 128 Ko - 5300 Mo / s.

Test 4: RAIDIX ERA

Voyons maintenant les tests de notre nouveau produit - RAIDIX ERA.

Nous avons créé RAID6. Taille de la bande: 16 ko. Une fois l'initialisation terminée, exécutez le test.

Résultat de performance (IOps) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 354887 | 363830 | 486865.6 | 619349.4 | 921403.6 | 2202384.8 | 4073187.8 |

| 8k | 180914.8 | 185371 | 249927.2 | 320438.8 | 520188.4 | 1413096.4 | 2510729 |

| 16k | 92115.8 | 96327.2 | 130661.2 | 169247.4 | 275446.6 | 763307.4 | 1278465 |

| 32k | 59994.2 | 61765.2 | 83512.8 | 116562.2 | 167028.8 | 420216.4 | 640418.8 |

| 64k | 27660.4 | 28229.8 | 38687,6 | 56603.8 | 76976 | 214958.8 | 299137.8 |

| 128k | 14475,8 | 14730 | 20674.2 | 30358.8 | 40259 | 109258.2 | 160141.8 |

| 1m | 2892,8 | 3031.8 | 4032,8 | 6331,6 | 7514.8 | 15871 | 19078 |

Résultat de performance (IOps) sous forme graphique. Lecture / écriture Mix%.

Testez 4.2 RAIDIX ERA. RAID 6. Tests de délai

Temps de réponse moyen (ms) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,16334 | 0,136397 | 0,10958 |

| 8k | 0,207056 | 0,163325 | 0,132586 |

| 16k | 0,313774 | 0,225767 | 0,182928 |

Temps de réponse moyen (ms) sous forme graphique. Lecture / écriture Mix%.

Temps de réponse maximum

Temps de réponse maximum (ms) sous forme de tableau. Lecture / écriture Mix%.

| Taille de bloc | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 5.371 | 3.4244 | 3,5438 |

| 8k | 5.243 | 3,7415 | 3,5414 |

| 16k | 7.628 | 4.2891 | 4.0562 |

Temps de réponse maximum (ms) sous forme graphique. Lecture / écriture Mix%.

Les délais sont similaires à ce que MDRAID produit. Mais pour des conclusions plus précises, une estimation des retards sous une charge plus grave doit être effectuée.

Testez 4.3 RAIDIX ERA. RAID 6. Tests de bande passante

Écriture séquentielle de 1 Mo - 8160 Mo / s.

Lecture séquentielle 1 Mo - 19700 MBPS.

Écriture séquentielle de 128 Ko - 6 200 Mo / s.

Lecture séquentielle de 128 Ko - 19700 MBPS.

Conclusion

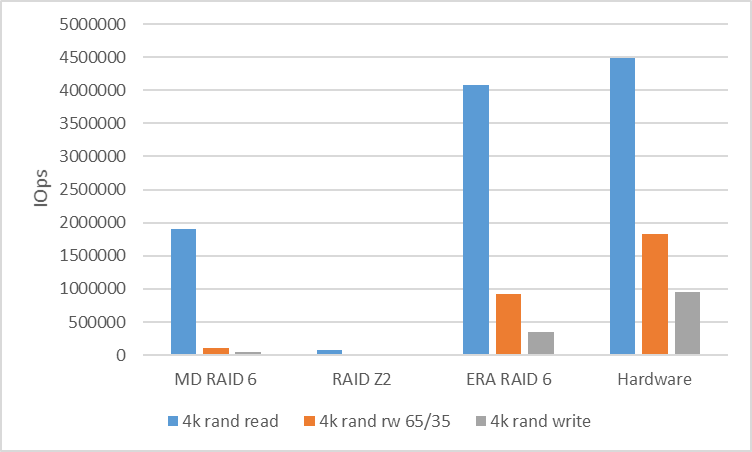

À la suite des tests, il vaut la peine de comparer les chiffres obtenus à partir des solutions logicielles avec ce que la plate-forme matérielle nous fournit.

Pour analyser les performances de la charge aléatoire, nous comparerons la vitesse de RAID 6 (RAIDZ2) lorsque vous travaillez avec un bloc en 4k.

| MD RAID 6 | RAIDZ2 | RAIDIX ERA RAID 6 | Matériel informatique |

|---|

| 4k R100% / W0% | 1902561 | 76314 | 4073187 | 4 494 142 |

| 4k R65% / W35% | 108594 | 17965 | 921403 | 1823432 |

| 4k R0% / W100% | 39907 | 15719 | 354887 | 958054 |

Pour analyser les performances de la charge série, nous allons regarder RAID 6 (RAIDZ2) avec un bloc de 128k. Entre les threads, nous avons utilisé un décalage de 10 Go pour éliminer le hit du cache et afficher les performances réelles.

| MD RAID 6 | RAIDZ2 | RAIDIX ERA RAID 6 | Matériel informatique |

|---|

| 128k seq lu | 10400 | 5300 | 19700 | 20 400 |

| 128k d'écriture séquentielle | 870 | 1100 | 6200 | 7500 |

Quel est le résultat?

Les matrices RAID logicielles populaires et abordables pour travailler avec des périphériques NVMe ne peuvent pas montrer les performances inhérentes au potentiel matériel.

Ici, il existe un besoin très évident d'un logiciel de contrôle capable d'agiter la situation et de montrer que la symbiose de contrôle de programme avec les disques NVMe peut être très productive et flexible.

Comprenant cette demande, notre société a créé un produit RAIDIX ERA, dont le développement s'est concentré sur la résolution des problèmes suivants:

- Performances de lecture et d'écriture élevées (plusieurs millions d'IOps) sur des baies avec Parité en mode mix.

- Performances de streaming à partir de 30 Go / s, y compris pendant le basculement et la récupération.

- Prise en charge des niveaux RAID 5, 6, 7.3.

- Initialisation et reconstruction du fond.

- Paramètres flexibles pour différents types de charge (côté utilisateur).

Aujourd'hui, nous pouvons dire que ces tâches sont terminées et que le produit est prêt à l'emploi.

Dans le même temps, comprenant l'intérêt de nombreuses parties intéressées pour de telles technologies, nous avons préparé pour la sortie non seulement une

licence payante, mais aussi une

licence gratuite , qui peut être pleinement utilisée pour résoudre les problèmes sur les disques NVMe et SSD.

En savoir plus sur RAIDIX ERA

sur notre site Web .

UPD Tests ZFS réduits avec taille d'enregistrement et taille de bloc 8k

Tableau des options ZFS

| NOM | PROPRIÉTÉ | VALEUR | SOURCE |

|---|

| réservoir | taille d'enregistrement | 8K | local |

| réservoir | compression | éteint | défaut |

| réservoir | dédoubler | éteint | défaut |

| réservoir | somme de contrôle | éteint | local |

| réservoir | volblocksize | - | - |

| tank / raid | taille d'enregistrement | - | - |

| tank / raid | compression | éteint | local |

| tank / raid | dédoubler | éteint | défaut |

| tank / raid | somme de contrôle | éteint | local |

| tank / raid | volblocksize | 8k | défaut |

L'enregistrement est devenu pire, la lecture est meilleure.

Mais tout de même, tous les résultats sont nettement pires que les autres solutions

| Taille de bloc | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 13703.8 | 14399.8 | 20903.8 | 25669 | 31610 | 66955.2 | 140849.8 |

| 8k | 15126 | 16227.2 | 22393,6 | 27720.2 | 34274.8 | 67008 | 139480.8 |

| 16k | 11111.2 | 11412.4 | 16980.8 | 20812.8 | 24680.2 | 48803.6 | 83710.4 |